Co psuje się, gdy zaczynasz sprzedawać do przedsiębiorstw

Sprzedaż do małych zespołów dotyczy głównie funkcji i szybkości. Sprzedaż do przedsiębiorstw zmienia definicję „dobrego”. Jedna awaria, jeden mylący błąd uprawnień albo brak śladu audytu mogą zniweczyć miesiące budowanego zaufania.

Niezawodność w prostych słowach to trzy rzeczy: aplikacja działa, dane są bezpieczne, a zachowanie jest przewidywalne. Ta ostatnia część jest ważniejsza, niż się wydaje. Użytkownicy enterprise planują pracę wokół twojego systemu. Oczekują takiego samego wyniku dziś, za tydzień i po kolejnym update’cie.

Co zwykle psuje się najpierw, to nie pojedynczy serwer. To luka między tym, co zbudowałeś dla garstki użytkowników, a tym, co duzi klienci zakładają, że już jest. Przynoszą większy ruch, więcej ról, więcej integracji i więcej kontroli ze strony bezpieczeństwa i zgodności.

Wczesne punkty napięcia są przewidywalne. Oczekiwania dotyczące dostępności skaczą z „w większości działa” do „musi być nudno stabilne”, z jasnym procesem obsługi incydentów. Bezpieczeństwo danych staje się sprawą na poziomie zarządu: kopie zapasowe, odzyskiwanie, logi dostępu i właścicielstwo. Uprawnienia szybko się komplikują: działy, kontraktorzy i zasada najmniejszych uprawnień. Zmiany stają się ryzykowne: wydania potrzebują rollbacku i sposobu na zapobieganie niespodziewanemu zachowaniu. Wsparcie przestaje być „pomocne” i staje się częścią produktu, z czasami reakcji i ścieżkami eskalacji.

Klient z startupu może zgodzić się na dwugodzinną przerwę i szybkie przeprosiny. Klient enterprise może wymagać podsumowania przyczyny źródłowej, dowodu, że się nie powtórzy, i planu zapobiegawczego.

Lista kontrolna gotowości enterprise to nie „idealne oprogramowanie”. Chodzi o skalowanie bez łamania zaufania, przez równoczesne podniesienie projektu produktu, nawyków zespołowych i codziennych operacji.

Diane Greene i podejście VMware w skrócie

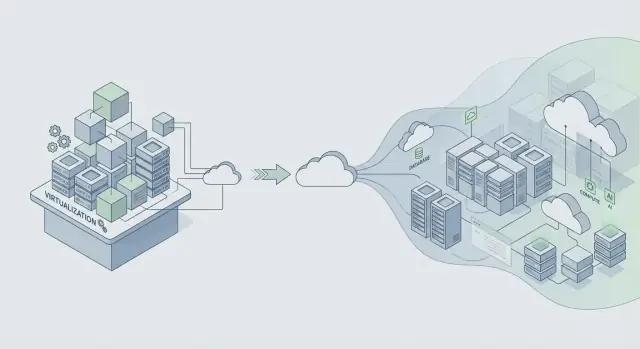

Diane Greene współzałożyła VMware w czasie, gdy IT przedsiębiorstw stawało przed bolesnym dylematem: działać szybko i ryzykować awarie, czy pozostać stabilnym i akceptować powolne zmiany. VMware miało znaczenie, bo sprawiło, że serwery zachowywały się jak niezawodne klocki budulcowe. To pozwoliło na konsolidację, bezpieczniejsze aktualizacje i szybsze odzyskiwanie, bez potrzeby przepisywania wszystkiego przez zespoły aplikacji.

Podstawowa obietnica dla przedsiębiorstw jest prosta: stabilność przed funkcjami. Firmy chcą nowych możliwości, ale chcą ich na systemie, który działa podczas patchowania, skalowania i rutynowych błędów. Gdy produkt staje się krytyczny biznesowo, „naprawimy to w przyszłym tygodniu” zamienia się w utracone przychody, nie dotrzymane terminy i problemy z zgodnością.

Wirtualizacja była praktycznym narzędziem niezawodności, nie tylko oszczędnością kosztów. Stworzyła granice izolacji. Jedne obciążenie mogło się zawiesić bez zniszczenia całej maszyny. Uczyniła też infrastrukturę bardziej powtarzalną: jeśli możesz zrobić snapshot, sklonować i przenieść obciążenie, możesz testować zmiany i szybciej odzyskiwać działanie, gdy coś pójdzie nie tak.

To podejście wciąż obowiązuje: projektuj pod zmiany bez przestojów. Zakładaj, że komponenty będą padać, wymagania będą się przesuwać, a aktualizacje będą zachodzić pod rzeczywistym obciążeniem. Potem buduj nawyki, które czynią zmiany bezpiecznymi.

W skrócie: izoluj awarie, żeby jeden problem nie rósł dalej; traktuj aktualizacje jak rutynę; spraw, by rollback był szybki; i preferuj przewidywalne zachowanie zamiast sprytnych sztuczek. Zaufanie buduje się przez nudną niezawodność, dzień po dniu.

Jeśli budujesz na nowoczesnych platformach (lub generujesz aplikacje narzędziami jak Koder.ai), lekcja pozostaje: wysyłaj funkcje tylko w sposób, który możesz wdrożyć, monitorować i cofnąć bez psucia operacji klienta.

Od VMware do chmury: co pozostało bez zmian

VMware dorastało w świecie pakowanego oprogramowania, gdzie „wydanie” było dużym wydarzeniem. Platformy chmurowe odwróciły rytm: mniejsze zmiany wydawane częściej. To może być bezpieczniejsze, ale tylko wtedy, gdy kontrolujesz zmianę.

Stała rzecz: zmiana to główne ryzyko dla niezawodności

Czy wydajesz instalator w pudełku, czy pushujesz deploy w chmurze, większość awarii zaczyna się tak samo: ląduje zmiana, pęka ukryte założenie, a promień zniszczeń jest większy, niż się spodziewasz. Szybsze wydania nie usuwają ryzyka. Mnożą je, gdy brak jest zabezpieczeń.

Zespoły, które skalują niezawodnie, zakładają, że każde wydanie może zawieść, i projektują system tak, by mógł się bezpiecznie zepsuć.

Prosty przykład: „niewinna” zmiana indeksu bazy danych wygląda dobrze na stagingu, ale w produkcji zwiększa opóźnienia zapisu, kolejkuje żądania i sprawia, że timeouty wyglądają jak losowe błędy sieci. Częstsze wydania dają więcej okazji do wprowadzenia tego typu niespodzianek.

Wspólna infrastruktura zmieniła tryby awarii

Aplikacje w erze chmury często obsługują wielu klientów na współdzielanych systemach. Multi-tenant wprowadza nowe problemy, które nadal sprowadzają się do tej samej zasady: izoluj błędy.

Problemy typu noisy neighbor (skok ruchu jednego klienta spowalnia innych) i awarie wspólne (zły deploy trafia wszystkich) to nowoczesna wersja „jeden błąd zabija klaster”. Kontrole są znane, tylko stosowane ciągle: stopniowe wdrożenia, kontrola per-tenant, granice zasobów (kwoty, limity szybkości, timeouty) i projekty, które radzą sobie z częściową awarią.

Obserwowalność to kolejna stała. Nie da się chronić niezawodności, jeśli nie widzisz, co się dzieje. Dobre logi, metryki i trace’y pomagają szybko wychwycić regresje, zwłaszcza podczas rolloutów.

Rollback też już nie jest rzadkim ruchem awaryjnym. To normalne narzędzie. Wiele zespołów paruje rollback z snapshotami i bezpieczniejszymi krokami wdrożenia. Platformy takie jak Koder.ai oferują migawki i rollback, co pomaga cofać ryzykowne zmiany szybko, ale ważniejsza jest kultura: rollback powinien być ćwiczony, nie improwizowany.

Ustal cele niezawodności zanim zaczniesz skalować

Jeśli poczekasz z definicją niezawodności do momentu, gdy pojawi się kontrakt enterprise, będziesz się spierać na odczucia: „wydaje się w porządku”. Duzi klienci chcą jasnych obietnic, które mogą powtórzyć wewnętrznie, np. „aplikacja działa” i „strony ładują się wystarczająco szybko w godzinach szczytu”.

Zacznij od niewielkiego zestawu celów napisanych prostym językiem. Dwa, na które wiele zespołów szybko się zgodzi, to dostępność (jak często usługa jest używalna) i czas odpowiedzi (jak szybko działania kluczowe czują się dla użytkownika). Trzymaj cele powiązane z tym, co robią użytkownicy, a nie z pojedynczym wskaźnikiem serwera.

Error budget sprawia, że cele stają się użyteczne na co dzień. To ilość awarii, którą możesz „wydać” w danym okresie, nie łamiąc obietnicy. Gdy jesteś w budżecie, możesz podejmować większe ryzyko dostarczania. Gdy go przepalisz, prace nad niezawodnością mają priorytet nad nowymi funkcjami.

Aby utrzymać cele realistyczne, śledź kilka sygnałów powiązanych z realnym wpływem: opóźnienia przy głównych akcjach, błędy (niepowodzone żądania, crash’e, zepsute ścieżki), nasycenie (CPU, pamięć, połączenia do bazy, kolejki) i dostępność na krytycznej ścieżce end-to-end.

Gdy cele są ustalone, powinny zmieniać decyzje. Jeśli wydanie podbija błędy — nie dyskutuj. Pauzuj, napraw lub cofnij.

Jeśli korzystasz z platformy przyspieszającej development jak Koder.ai, cele mają jeszcze większe znaczenie. Szybkość pomaga tylko wtedy, gdy jest ograniczona obietnicami niezawodności, które możesz utrzymać.

Nawyki architektoniczne, które chronią niezawodność w skali

Skok niezawodności z „działa dla naszego zespołu” do „działa dla firmy z listy Fortune 500” to głównie architektura. Kluczowa zmiana w myśleniu jest prosta: zakładaj, że części systemu będą padać w normalny dzień, nie tylko podczas dużej awarii.

Projektuj pod awarię, czyniąc zależności opcjonalnymi, gdy się da. Jeśli dostawca płatności, usługa email lub pipeline analityczny jest wolny, twoja podstawowa aplikacja powinna nadal się ładować, umożliwiać logowanie i pozwalać wykonywać główną pracę.

Granice izolacji to twój najlepszy przyjaciel. Oddziel krytyczną ścieżkę (logowanie, kluczowe workflowy, zapisy do głównej bazy) od funkcji „miłych do mieć” (rekomendacje, feed aktywności, eksporty). Gdy opcjonalne części zawodzą, powinny zamykać się bez pociągania rdzenia za sobą.

Kilka nawyków zapobiega wodospadowi awarii w praktyce:

- Stawiaj ostre timeouty na każdy wywołanie sieciowe.

- Retryuj tylko operacje, które są bezpieczne do powtórzenia, i dodawaj jitter, żeby uniknąć burz retry.

- Używaj circuit breakerów, aby jedna zawodna zależność nie pochłonęła wszystkich workerów czy połączeń do bazy.

- Kontroluj obciążenie przez kolejki i backpressure, by skoki ruchu zmieniały się w spowolnienia, nie w outage’y.

- Preferuj łagodne degradacje: zwracaj częściowe wyniki z jasnym komunikatem zamiast 500.

Bezpieczeństwo danych to miejsce, gdzie „naprawimy później” zamienia się w przestój. Planuj backupy, zmiany schematów i odzyskiwanie, jakbyś ich naprawdę potrzebował — bo będziesz. Ćwicz odzyskiwanie tak, jak robisz ćwiczenia przeciwpożarowe.

Przykład: zespół wysyła aplikację React z API w Go i PostgreSQL. Nowy klient enterprise importuje 5 milionów rekordów. Bez granic import konkuruje z normalnym ruchem i wszystko zwalnia. Z właściwymi zabezpieczeniami import idzie przez kolejkę, zapisuje w batchach, używa timeoutów i bezpiecznych retry, i można go wstrzymać bez wpływu na codziennych użytkowników. Jeśli budujesz na platformie takiej jak Koder.ai, traktuj generowany kod tak samo: dodaj te zabezpieczenia, zanim prawdziwi klienci zaczną polegać na nim.