07 cze 2025·8 min

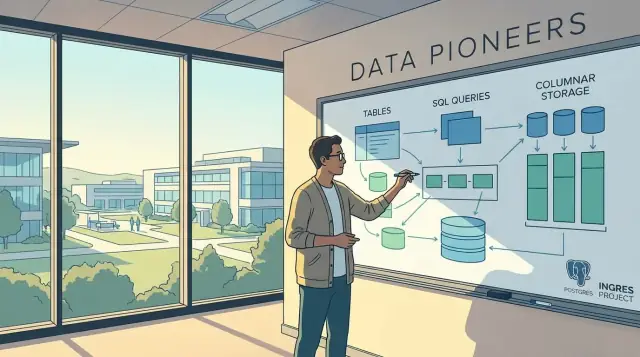

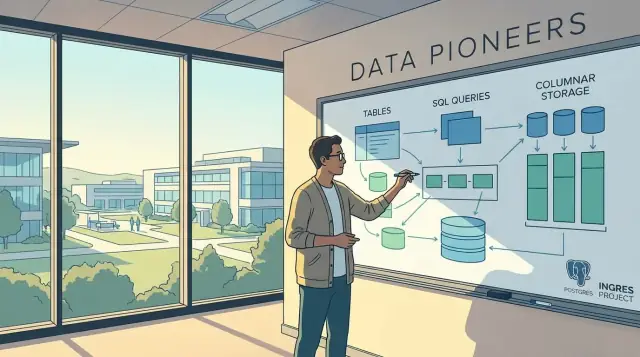

Michael Stonebraker i współczesne bazy danych: co zmienił

Poznaj kluczowe pomysły Michaela Stonebrakera stojące za Ingres, Postgres i Vertica — oraz jak ukształtowały bazy SQL, silniki analityczne i współczesne stosy danych.

Poznaj kluczowe pomysły Michaela Stonebrakera stojące za Ingres, Postgres i Vertica — oraz jak ukształtowały bazy SQL, silniki analityczne i współczesne stosy danych.

Michael Stonebraker to naukowiec komputerowy, którego projekty nie tylko wpłynęły na badania nad bazami danych — bezpośrednio ukształtowały produkty i wzorce projektowe, na których wiele zespołów polega każdego dnia. Jeśli używałeś bazy relacyjnej, hurtowni analitycznej lub systemu strumieniowego, skorzystałeś z pomysłów, które pomógł udowodnić, zbudować lub spopularyzować.

To nie biografia ani akademicki przegląd teorii baz danych. Zamiast tego łączy główne systemy Stonebrakera (jak Ingres, Postgres i Vertica) z wyborami, które widzisz we współczesnych stackach danych:

Nowoczesna baza danych to system, który potrafi niezawodnie:

Różne bazy optymalizują te cele inaczej — szczególnie gdy porównujesz aplikacje transakcyjne, pulpity BI i potoki czasu rzeczywistego.

Skupimy się na praktycznym wpływie: na pomysłach, które pojawiają się w dzisiejszym świecie „warehouse + lake + stream + microservices”, i na tym, jak wpływają one na to, co kupujesz, budujesz i eksploatujesz. Spodziewaj się jasnych wyjaśnień, kompromisów i praktycznych implikacji — nie głębokich dowodów czy szczegółów implementacyjnych.

Kariera Stonebrakera najłatwiej rozumieć jako sekwencję systemów budowanych do konkretnych zadań — a potem obserwowanie, jak najlepsze pomysły przenikają do produktów mainstreamowych.

Ingres zaczynał jako projekt akademicki, który pokazał, że bazy relacyjne mogą być szybkie i praktyczne, a nie tylko teorią. Pomógł spopularyzować zapytywanie w stylu SQL i myślenie o optymalizacji kosztowej, które później stały się normą w silnikach komercyjnych.

Postgres (system badawczy, który dał początek PostgreSQL) stawiał inaczej zakład: baza nie powinna być funkcjonalnie zamknięta. Powinieneś móc dodawać nowe typy danych, metody indeksowania i bogatsze zachowania bez przepisywania całego silnika.

Wiele „nowoczesnych” cech wywodzi się z tego okresu — rozszerzalne typy, funkcje definiowane przez użytkownika i baza, która może dostosować się do zmieniających się obciążeń.

W miarę wzrostu zapotrzebowania na analitykę, systemy zorientowane na wiersz miały problemy z dużymi skanami i agregacjami. Stonebraker promował przechowywanie kolumnowe i techniki wykonawcze, które czytają tylko potrzebne kolumny i dobrze je kompresują — pomysły dziś standardowe w bazach analitycznych i hurtowniach chmurowych.

Vertica przeniosła badawcze idee kolumnowe do komercyjnego, masowo równoległego (MPP) silnika SQL zaprojektowanego pod duże zapytania analityczne. Wzorzec powtarza się: prototyp badawczy weryfikuje koncept; produkt utwardza go pod kątem niezawodności, narzędzi i wymagań klientów.

Późniejsze prace rozwinęły obszar przetwarzania strumieniowego i silników specyficznych dla obciążeń — argumentując, że jeden ogólny silnik rzadko wygrywa we wszystkim.

Prototyp testuje hipotezę szybko; produkt musi priorytetowo traktować operacyjność: aktualizacje, monitoring, bezpieczeństwo, przewidywalną wydajność i wsparcie. Wpływ Stonebrakera widać, bo wiele pomysłów z prototypów „awansowało” do domyślnych możliwości baz komercyjnych, a nie pozostało niszowymi opcjami.

Ingres (skrót od INteractive Graphics REtrieval System) był wczesnym dowodem, że model relacyjny może być czymś więcej niż elegancką teorią. W tamtym czasie wiele systemów opierało się na niestandardowych metodach dostępu i ścieżkach specyficznych dla aplikacji.

Ingres rozwiązywał prosty, przyjazny biznesowi problem:

Jak pozwolić ludziom zadawać elastyczne pytania do danych bez przepisywania oprogramowania za każdym razem, gdy pytanie się zmienia?

Bazy relacyjne obiecywały, że możesz opisać co chcesz (np. „klienci w Kalifornii z zaległymi fakturami”), zamiast jak to krok po kroku pobrać. Aby ta obietnica była realna, potrzebny był system, który potrafi:

Ingres był dużym krokiem w stronę tej „praktycznej” wersji przetwarzania relacyjnego — takiej, która mogła działać na ówczesnym sprzęcie i nadal być responsywna.

Ingres spopularyzował ideę, że baza powinna robić ciężką pracę planowania zapytań. Zamiast ręcznego strojenia każdego dostępu do danych, system mógł wybierać strategie, np. którą tabelę czytać najpierw, których indeksów użyć i jak łączyć tabele.

To pomogło rozpowszechnić myślenie w stylu SQL: gdy możesz zapisać deklaratywne zapytanie, iterujesz szybciej i więcej osób może zadawać pytania bez czekania na raporty szyte na miarę.

Praktyczny wniosek to optymalizacja kosztowa: wybierz plan zapytania o najniższym oczekiwanym „koszcie” (zwykle mieszanką I/O, CPU i pamięci), bazując na statystykach o danych.

To ważne, bo zwykle oznacza:\n\n- Szybsze zapytania bez zmian w aplikacji\n- Mniej sprzętu potrzebnego, by osiągnąć tę samą wydajność\n- Bardziej przewidywalną wydajność wraz ze wzrostem zbiorów danych

Ingres nie wynalazł każdego elementu nowoczesnej optymalizacji, ale pomógł ustalić wzorzec: SQL + optymalizator to to, co pozwala systemom relacyjnym przejść od „fajnej idei” do codziennego narzędzia.

Wczesne bazy relacyjne zakładały stały zestaw typów danych (liczby, tekst, daty) i operacji (filtr, join, agregacja). To działało dobrze — dopóki zespoły nie zaczęły przechowywać nowych rodzajów informacji (geografia, logi, szeregi czasowe, identyfikatory specyficzne dla domeny) lub nie potrzebowały specjalnych funkcji wydajnościowych.

W sztywnej konstrukcji każde nowe wymaganie zamieniało się w złe opcje: wciskanie danych do tekstowych blobów, doklejanie osobnego systemu lub czekanie, aż vendor doda wsparcie.

Postgres postawił na inny pomysł: baza powinna być rozszerzalna — czyli możesz dodać nowe możliwości w kontrolowany sposób, bez łamania bezpieczeństwa i poprawności, których oczekujesz od SQL.

Prościej: rozszerzalność to jak dodawanie certyfikowanych przystawek do narzędzia zamiast przerabiania silnika. Możesz nauczyć bazę „nowych sztuczek”, zachowując transakcje, uprawnienia i optymalizację zapytań jako spójną całość.

To podejście widać dziś w ekosystemie PostgreSQL (i w wielu systemach inspirowanych Postgresem). Zamiast czekać na funkcję w jądrze, zespoły mogą przyjąć sprawdzone rozszerzenia, które integrują się z SQL i narzędziami operacyjnymi.

Typowe przykłady wysoko poziomowe:

Kluczowe jest to, że Postgres potraktował „zmianę możliwości bazy” jako cel projektowy — nie jako dodatek — i ta idea wciąż wpływa na ewolucję nowoczesnych platform danych.

Bazy danych to nie tylko przechowywanie informacji — chodzi też o to, by informacje pozostały poprawne, nawet gdy wiele rzeczy dzieje się jednocześnie. Do tego służą transakcje i kontrola współbieżności, i to główny powód, dla którego systemy SQL stały się zaufane w pracy biznesowej.

Transakcja to grupa zmian, które muszą zakończyć się powodzeniem lub porażką jako całość.

Gdy przelewasz pieniądze, składasz zamówienie czy aktualizujesz stan magazynowy, nie możesz pozwolić sobie na „półdokonane” rezultaty. Transakcja gwarantuje, że nie zostaniesz z zamówieniem, które pobrało pieniądze, ale nie zarezerwowało towaru — albo z pomniejszonym stanem bez zarejestrowanego zamówienia.

W praktyce transakcje dają:

Współbieżność znaczy, że wiele osób (i aplikacji) czyta i zmienia dane jednocześnie: zamówienia klientów, agenci wsparcia edytują konta, zadania tła aktualizują statusy, analitycy uruchamiają raporty.

Bez ostrożnych reguł pojawiają się problemy takie jak:

Jednym z wpływowych podejść jest MVCC (Multi-Version Concurrency Control). Koncepcyjnie MVCC przechowuje kilka wersji wiersza przez krótki czas, więc czytelnicy widzą stabilną migawkę, gdy piszący dokonują aktualizacji.

Duża zaleta to to, że odczyty rzadziej blokują zapisy, a zapisujący nie stoją stale w kolejce za długimi zapytaniami. Wciąż zachowujesz poprawność, ale przy mniejszym czekaniu.

Dziś bazy często obsługują mieszane obciążenia: intensywne zapisy aplikacyjne i częste odczyty dla dashboardów, widoków klientów i analityki operacyjnej. Nowoczesne systemy SQL opierają się na technikach jak MVCC, mądrzejsze blokowanie i poziomy izolacji, by równoważyć szybkość z poprawnością — dzięki temu możesz skalować aktywność bez utraty zaufania do danych.

Bazy wierszowe były zaprojektowane z myślą o przetwarzaniu transakcyjnym: wiele małych odczytów i zapisów, zwykle dotyczących jednego klienta, jednego zamówienia czy jednego konta. Taka konstrukcja jest świetna, gdy potrzebujesz szybko pobrać lub zaktualizować cały rekord.

Pomyśl o arkuszu kalkulacyjnym. Row store to jak segregowanie każdego wiersza w osobnym folderze: gdy potrzebujesz „wszystko o zamówieniu #123”, wyciągasz jeden folder i masz pełne dane. Column store to jak segregowanie według kolumn: jedna szuflada na „order_total”, inna na „order_date”, jeszcze inna na „customer_region”.

Dla analityki rzadko potrzebujesz całego folderu — zwykle pytasz „Jaki był przychód według regionu w ostatnim kwartale?” To zapytanie sięgnie po kilka pól w milionach rekordów.

Zapytania analityczne często:\n\n- skanują duże części tabeli\n- używają tylko garści kolumn\n- silnie agregują (SUM/AVG/COUNT) i filtrować

Z przechowywaniem kolumnowym silnik może czytać tylko kolumny użyte w zapytaniu, pomijając resztę. Mniej danych odczytanych z dysku (i mniej przesłanych przez pamięć) to często największy zysk wydajnościowy.

Kolumny mają zwykle powtarzalne wartości (regiony, statusy, kategorie). To sprawia, że są bardzo kompresowalne — a kompresja może przyspieszyć analitykę, bo silnik czyta mniej bajtów i czasem operuje bez dekompresji.

Magazyny kolumnowe zaznaczyły przesunięcie od baz OLTP ku silnikom nastawionym na analitykę, gdzie skanowanie, kompresja i szybkie agregaty stały się priorytetem projektowym, a nie dodatkiem.

Vertica jest jednym z najczystszych przykładów, jak pomysły Stonebrakera o bazach analitycznych przekształciły się w produkt, który zespoły mogą uruchomić w produkcji. Połączyła wnioski z przechowywania kolumnowego z rozproszonym projektem, ukierunkowanym na konkretny problem: szybkie odpowiadanie na duże zapytania SQL, nawet gdy objętości danych przekraczają pojedynczy serwer.

MPP to masowo równoległe przetwarzanie. Najprościej: wiele maszyn pracuje nad jednym zapytaniem SQL jednocześnie.

Zamiast jednej maszyny czytającej wszystkie dane i wykonującej grupowanie i sortowanie, dane są podzielone między węzły. Każdy węzeł przetwarza swoją część równolegle, a system łączy fragmenty wyników w odpowiedź końcową.

Dzięki temu zapytanie, które na jednej maszynie zajęłoby minuty, może spaść do sekund — pod warunkiem, że dane są dobrze rozdystrybuowane, a zapytanie da się zrównoleglić.

Systemy analityczne w stylu Vertica błyszczą, gdy masz dużo wierszy i chcesz je skanować, filtrować i agregować wydajnie. Typowe przypadki użycia:

Silniki MPP nie są zamiennikiem dla systemów transakcyjnych (OLTP). Są zoptymalizowane pod czytanie wielu wierszy i obliczanie podsumowań, a nie pod wiele małych aktualizacji.

Typowe kompromisy:\n\n- Świeżość: dane często pojawiają się partiami lub mikro-partiami, a nie w trybie wierszowym\n- Aktualizacje: częste aktualizacje/usuwania pojedynczych wierszy są wolniejsze lub bardziej złożone operacyjnie\n- Opóźnienia: świetne dla zapytań z latencją sekund–minut; nieidealne dla milisekundowych transakcji użytkownika

Klucz: koncentracja. Vertica i podobne systemy osiągają prędkość dzięki strojeniu przechowywania, kompresji i wykonania równoległego pod analitykę — i akceptują ograniczenia, które systemy transakcyjne omijają.

Baza może „przechowywać i zapytywać” dane i nadal być wolna dla analityki. Różnica często nie tkwi w samym SQL, który piszesz, ale w tym, jak silnik go wykonuje: jak czyta strony, przesuwa dane przez CPU, używa pamięci i minimalizuje niepotrzebną pracę.

Projekty Stonebrakera ukierunkowane na analitykę promowały myślenie, że wydajność zapytań to problem wykonania tak bardzo, jak problem przechowywania. To przesunięcie pomogło zespołom przestać optymalizować pojedyncze odczyty wierszy i zacząć optymalizować długie skany, joiny i agregacje na milionach (lub miliardach) wierszy.

Wiele starszych silników przetwarza zapytania „tuple-at-a-time” (wiersz po wierszu), co generuje dużo wywołań funkcji i narzutu. Wykonanie wektorowe odwraca ten model: silnik przetwarza partię (wektor) wartości w ciasnej pętli.

Prościej: to jak przewożenie zakupów w wózku zamiast po jednym przedmiocie na raz. Grupowanie zmniejsza narzut i pozwala nowoczesnym CPU robić to, co robią najlepiej: przewidywalne pętle, mniej rozgałęzień i lepsze użycie cache.

Szybkie silniki analityczne obsesyjnie dbają o efektywność CPU i cache. Innowacje wykonawcze koncentrują się często na:

Te pomysły mają znaczenie, bo zapytania analityczne często ogranicza przepustowość pamięci i błędy cache, a nie surowa prędkość dysku.

Nowoczesne hurtownie danych i silniki SQL — hurtownie chmurowe, systemy MPP i szybkie narzędzia analityczne in-process — często domyślnie używają wykonania wektorowego, operatorów świadomych kompresji i potoków przyjaznych cache.

Nawet gdy vendorzy mówią o „autoskalowaniu” czy „separacji storage/compute”, codzienna szybkość wciąż w dużej mierze zależy od tych wyborów wykonawczych.

Jeśli oceniasz platformy, pytaj nie tylko co przechowują, ale jak wykonują joiny i agregacje pod maską — i czy ich model wykonania jest zbudowany pod analitykę, a nie obciążenia transakcyjne.

Dane strumieniowe to po prostu dane, które przybywają ciągle jako sekwencja zdarzeń — pomyśl o „właśnie pojawiło się nowe zdarzenie”. Przesunięcie karty kredytowej, odczyt sensora, kliknięcie na stronie produktu, skan paczki, linia logu: każde z nich pojawia się w czasie rzeczywistym i napływa bez przerwy.

Tradycyjne bazy i potoki batchowe są świetne, gdy możesz poczekać: załaduj wczorajsze dane, uruchom raporty, opublikuj dashboardy. Ale potrzeby czasu rzeczywistego nie czekają na kolejne godzinne zadanie.

Jeśli przetwarzasz dane tylko partiami, często kończysz z:

Systemy strumieniowe są projektowane z założeniem, że obliczenia mogą działać ciągle w miarę napływu zdarzeń.

Zapytanie ciągłe to jak zapytanie SQL, które nigdy się nie „kończy”. Zamiast zwrócić wynik raz, aktualizuje wynik wraz z nadejściem nowych zdarzeń.

Ponieważ strumienie są nieograniczone (nie kończą się), systemy strumieniowe używają okien, by uczynić obliczenia wykonalnymi. Okno to wycinek czasu lub zdarzeń, np. „ostatnie 5 minut”, „każda minuta” lub „ostatnie 1000 zdarzeń”. Dzięki temu możesz liczyć przejeżdżające sumy, średnie czy top-N bez konieczności przeliczania wszystkiego od początku.

Streaming w czasie rzeczywistym ma największą wartość, gdy czas ma znaczenie:\n\n- Monitorowanie oszustw: wykryj nietypowe wydatki w ciągu sekund\n- Alerty operacyjne: wykryj skoki błędów, gdy się zaczynają\n- Żywe metryki produktu: zobacz rejestracje, konwersje i zmiany zapasów na bieżąco\n- Widoczność logistyczna: aktualizuj przewidywane czasy dostawy z ciągłych skanów

Stonebraker od dekad argumentuje, że bazy nie powinny być konstruowane jako ogólne „do wszystkiego” maszyny. Powód jest prosty: różne obciążenia premiują różne wybory projektowe. Jeśli mocno optymalizujesz pod jedno zadanie (np. drobne transakcyjne aktualizacje), zwykle spowolnisz inne (np. skanowanie miliardów wierszy dla raportu).

Większość współczesnych stacków używa więcej niż jednego systemu, bo biznes oczekuje różnych rodzajów odpowiedzi:\n\n- Baza OLTP (baza aplikacji): szybkie insert/ update, ścisła poprawność, wielu równoległych użytkowników\n- Hurtownia / baza analityczna: szybkie odczyty dużych zbiorów, ciężkie agregacje, długie skany\n- Cache / key-value store: ekstremalnie szybkie odczyty dla „gorących” danych (sesje, liczniki, feature flags)\n- Przetwarzanie strumieniowe + log: obsługa ciągłych zdarzeń (kliknięcia, płatności, IoT), niskolatencyjne potoki, metryki w czasie rzeczywistym

To w praktyce „one size doesn’t fit all”: wybierasz silniki dopasowane do kształtu pracy.

Użyj tego szybkiego filtru przy wyborze (lub uzasadnianiu) kolejnego systemu:\n\n- Jeśli potrzebujesz wielu małych odczytów/zapisów z transakcjami (zamówienia, profile użytkowników): zacznij od bazy OLTP.\n- Jeśli potrzebujesz dużych zapytań i agregacji (tygodniowe przychody, analiza kohort): dodaj hurtownię analityczną.\n- Jeśli potrzebujesz odpowiedzi poniżej sekundy przy powtarzających się odczytach: wprowadź cache.\n- Jeśli potrzebujesz reakcji w czasie rzeczywistym na zdarzenia (reguły antyfraudowe, żywe dashboardy): dodaj streaming.

Wiele systemów może być zdrowe, ale tylko wtedy, gdy każdy ma wyraźne obciążenie. Nowe narzędzie powinno zasłużyć na miejsce przez redukcję kosztów, latencji lub ryzyka — nie przez dodanie nowości.

Wol preferować mniej systemów z jasnym właścicielstwem operacyjnym i wycofywać komponenty, które nie mają precyzyjnego, mierzalnego celu.

Wątki badawcze Stonebrakera — fundamenty relacyjne, rozszerzalność, magazyny kolumnowe, wykonanie MPP i „właściwe narzędzie do zadania” — są widoczne w domyślnych kształtach nowoczesnych platform danych.

Hurtownia odzwierciedla dekady pracy nad optymalizacją SQL, przechowywaniem kolumnowym i wykonaniem równoległym. Gdy widzisz szybkie dashboardy na ogromnych tabelach, często stoją za tym formaty kolumnowe plus wykonanie wektorowe i skalowanie w stylu MPP.

Lakehouse zapożycza pomysły hurtowni (schematy, statystyki, cache, optymalizacja kosztowa), ale umieszcza je na otwartych formatach plików i storage obiektowym. Przesunięcie „tanie przechowywanie, elastyczny compute” jest nowe; myślenie o zapytaniach i transakcjach pod spodem nie jest.

Systemy MPP (klastry shared-nothing) są bezpośrednimi potomkami badań, które udowodniły, że można skalować SQL przez partycjonowanie danych, przenoszenie obliczeń do danych i ostrożne zarządzanie ruchem danych podczas joinów i agregacji.

SQL stał się wspólnym interfejsem w hurtowniach, silnikach MPP, a nawet warstwach zapytań nad jeziorem danych. Zespoły polegają na nim jako:\n\n- stabilnym kontrakcie dla narzędzi BI i analityków\n- warstwie przenośności przy zmianie silników\n- powierzchni governance (widoki, uprawnienia, audytowany dostęp)

Nawet gdy wykonanie odbywa się w różnych silnikach (batch, interaktywny, streaming), SQL często pozostaje językiem dla użytkownika.

Elastyczne przechowywanie nie likwiduje potrzeby struktury. Jasne schematy, udokumentowane znaczenie i kontrolowana ewolucja zmniejszają awarie downstream.

Dobra governance to mniej biurokracja, a bardziej sprawianie, że dane są niezawodne: spójne definicje, właścicielstwo, kontrole jakości i uprawnienia dostępu.

Przy ocenie platform pytaj:\n\n1. Dopasowanie obciążenia: Czy to głównie dashboardy BI, eksploracja ad-hoc, budowa cech do ML, czy obciążenia operacyjne?\n2. Wymagania latencji: Sekundy, minuty, czy godziny? Potrzebujesz świeżości strumieniowej?\n3. Kształt danych: Przeważnie szerokie logi zdarzeń (świetne dla kolumnowych) czy wiele punktowych odczytów (często lepiej gdzie indziej)?\n4. Współbieżność: Ilu użytkowników/zapytań jednocześnie i jak przewidywalne są te obciążenia?\n5. Wymagania spójności: Potrzebujesz silnych transakcji, czy akceptowalne jest spójność ostateczna?\n6. Rzeczywistość operacyjna: Kto to będzie obsługiwał, jakie umiejętności są dostępne i jaki jest tryb awarii o 2 w nocy?

Jeśli dostawca nie potrafi powiązać produktu z tymi podstawami prostym językiem, „innowacja” może być w dużej mierze opakowaniem.

Wątek przewodni Stonebrakera jest prosty: bazy działają najlepiej, gdy są projektowane do konkretnego zadania — i gdy potrafią ewoluować wraz z jego zmianami.

Zanim porównasz funkcje, zapisz, co naprawdę musisz robić:\n\n- Analityka: długie skany, duże agregacje, dużo odczytów\n- Transakcje: wiele małych aktualizacji, ścisła poprawność, szybkie czasy odpowiedzi\n- Mieszane obciążenia: oba przypadki, ale często kosztem uważnego strojenia i jasnych priorytetów\n- Kanały czasu rzeczywistego: ciągłe przyjmowanie danych i obliczenia przyrostowe

Użyteczna zasada: jeśli nie potrafisz opisać obciążenia w kilku zdaniach (wzorce zapytań, rozmiar danych, potrzeby latencji, współbieżność), skończysz kupować po buzzwordach.

Zespoły nie doceniają, jak często wymagania się zmieniają: nowe typy danych, nowe metryki, nowe regulacje, nowi konsumenci.

Faworyzuj platformy i modele danych, które czynią zmianę rutynową zamiast ryzykownej:\n\n- Jasne oddzielenie przechowywania, zapytania i punktów rozszerzeń\n- Bezpieczne sposoby ewolucji schematów i wdrażania nowej logiki\n- Mierzalna wydajność, która nie załamuje się przy organicznym wzroście

Szybkie odpowiedzi są wartościowe tylko wtedy, gdy są poprawne. Przy ocenie opcji pytaj, jak system radzi sobie z:\n\n- Współbieżnymi zapisami (co się dzieje, gdy dwie osoby/procesy aktualizują ten sam rekord?)\n- Izolacją i spójnością (jakie gwarancje dostajesz i co jesteś skłonny poświęcić?)\n- Trybami awaryjnymi operacji (restarty, częściowe awarie, backfille)

Uruchom mały „proof z twoimi danymi”, nie tylko demo:\n\n- Przetestuj 3–5 reprezentatywnych zapytań i zmierz czas oraz koszt.\n- Przetestuj szczytową współbieżność (np. poniedziałkowy spike).\n- Zweryfikuj świeżość danych, kroki odzyskiwania i kto może obsługiwać system na co dzień.

Wiele porad o bazach kończy się na „wybierz właściwy silnik”, ale zespoły muszą też dostarczać aplikacje i narzędzia wewnętrzne wokół tego silnika: panele admina, dashboardy metryk, serwisy ingestion i workflowy back-office.

Jeśli chcesz szybko prototypować bez wynajdywania całego pipeline'u, platforma vibe-coding taka jak Koder.ai może pomóc wystartować aplikacje webowe (React), serwisy backendowe (Go + PostgreSQL) i nawet klientów mobilnych (Flutter) z workflow opartym na czacie. To często przydatne przy iteracji nad projektem schematu, budowaniu małego wewnętrznego "produktu danych" lub weryfikacji rzeczywistego zachowania obciążenia przed podjęciem decyzji o infrastrukturze długoterminowej.

Jeśli chcesz zgłębić temat, sprawdź wyjaśnienia dotyczące przechowywania kolumnowego, MVCC, wykonania MPP i przetwarzania strumieniowego. Więcej materiałów znajdziesz w /blog.

Jest rzadkim przypadkiem, w którym systemy badawcze stały się zasadniczym DNA produktów. Pomysły udowodnione w Ingres (SQL + optymalizacja zapytań), Postgres (rozszerzalność + myślenie MVCC) i Vertica (kolumnowość + MPP dla analiz) pojawiają się dziś w tym, jak budowane i sprzedawane są hurtownie danych, bazy OLTP i platformy streamingowe.

SQL wygrał, bo pozwala opisać co chcesz uzyskać, podczas gdy baza decyduje jak to efektywnie wykonać. To rozdzielenie dało w praktyce:

Optymalizator kosztowy używa statystyk tabel, by porównać możliwe plany zapytań i wybrać ten o najniższym oczekiwanym koszcie (I/O, CPU, pamięć). W praktyce pomaga to:

MVCC (Multi-Version Concurrency Control) przechowuje wiele wersji wierszy, dzięki czemu czytelnicy widzą spójną migawkę podczas gdy zapisy są wykonywane. W codziennych słowach:

Rozszerzalność oznacza, że baza może bezpiecznie zyskać nowe możliwości — typy danych, funkcje, indeksy — bez konieczności forka czy przepisywania silnika. Przydaje się gdy chcesz:

Zasada operacyjna: traktuj rozszerzenia jak zależności — wersjonuj je, testuj aktualizacje i ogranicz, kto może je instalować.

Bazy wierszowe świetnie działają, gdy często odczytujesz lub zapisujesz całe rekordy (OLTP). Składowanie kolumnowe błyszczy, gdy skanujesz dużo wierszy, ale dotykasz tylko kilku pól (analityka).

Prosta heurystyka:

MPP (massively parallel processing) dzieli dane między węzły, tak że wiele maszyn wykonuje jedno zapytanie SQL równolegle. Dobrze sprawdza się przy:

Zwróć uwagę na kompromisy: wybory dystrybucji danych, koszty przesyłania danych podczas joinów i gorszą ergonomię dla częstych aktualizacji pojedynczych wierszy.

Wykonanie wektorowe przetwarza dane w partiach (wektorach) zamiast po jednym wierszu, zmniejszając narzut i lepiej wykorzystując pamięć podręczną CPU. Zazwyczaj zauważysz to jako:

Systemy batchowe uruchamiają zadania okresowo, więc dane mogą być nieaktualne. Systemy strumieniowe traktują zdarzenia jako ciągły napływ i obliczają wyniki przyrostowo.

Gdy warto streaming:

Aby obliczenia były ograniczone, streaming używa okien (np. ostatnie 5 minut) zamiast „całego czasu”.

Używaj kilku systemów, gdy każdy ma wyraźne granice obciążenia i mierzalne korzyści (koszt, opóźnienie, niezawodność). Aby uniknąć nadmiaru narzędzi:

Jeśli potrzebujesz ram wyboru, użyj checklisty opisanej w artykule i powiązanych wpisach w /blog.