Co oznacza „model oprogramowania PC” — i dlaczego miał znaczenie

„Model oprogramowania PC” nie był pojedynczym produktem ani sprytną sztuczką licencyjną. To była powtarzalna metoda działania całego rynku: jak deweloperzy budowali oprogramowanie, jak je dostarczali do użytkowników i jak na nim zarabiali.

Brzmi to prosto — dopóki nie przypomnisz sobie, jak nietypowa była sytuacja na początku ery komputerów osobistych. Wczesne komputery często sprzedawano jako zamknięte systemy z własnym sprzętem, specyficznym środowiskiem operacyjnym i niejasnymi ścieżkami dla deweloperów firm trzecich. Era PC to zmieniła, zamieniając oprogramowanie w coś, co mogło się skalować poza jedną maszynę — a nawet poza jedną firmę.

Definicja „modelu oprogramowania” po ludzku

W praktyce model oprogramowania to zestaw założeń odpowiadających na pytania:

- Na jaki cel buduję? (stabilna baza OS i sprzętu)

- Jak budować efektywnie? (narzędzia, języki, dokumentacja)

- Jak dotrzeć do klientów i otrzymywać płatności? (dystrybucja i warunki biznesowe)

Gdy te odpowiedzi są przewidywalne, deweloperzy inwestują. Gdy nie są — wahają się.

Trzy filary napędzające koło zamachowe

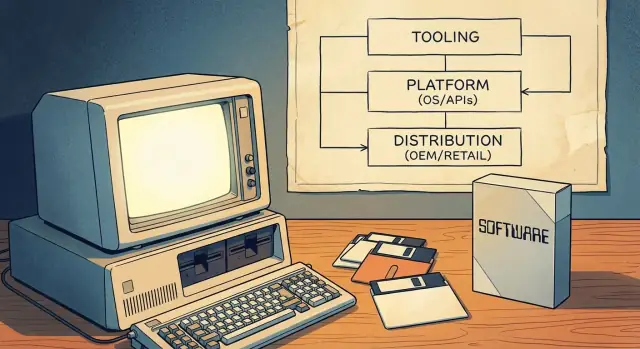

Model PC działał, bo powiązał trzy filary w samonapędzające się koło:

- Narzędzia developerskie: przystępne języki, kompilatory, IDE i przykłady, które obniżały koszt startu.

- Powierzchnia platformy: spójne API i SDK, które pozwalały oprogramowaniu stron trzecich integrować się z OS (i z innymi aplikacjami).

- Kanały wejścia na rynek: jasne sposoby dystrybucji — przez preinstalacje OEM, handel detaliczny i później shareware — dzięki czemu oprogramowanie mogło stać się biznesem.

Razem te elementy uczyniły PC pewnym „miejscem do budowania”. Ta przewidywalność przekształciła przetwarzanie osobiste w główny ekosystem deweloperski — nie tylko w scenę hobbystyczną.

Przed powszechnymi PC: rozdrobnione cele i ograniczony zasięg

Przed masową adopcją PC „informatyka” zwykle oznaczała mainframe’y i minikomputery należące do rządów, uczelni i dużych firm. Dostęp był ograniczony, drogi i często pośredniczony przez działy IT. Jako deweloper tworzyłeś oprogramowanie dla konkretnej organizacji — nie dla szerokiego rynku publicznego.

Wiele maszyn, wiele niezgodności

Wczesne systemy osobiste i hobbystyczne istniały, ale nie tworzyły jednej, niezawodnej masy rynkowej. Sprzęt był bardzo zróżnicowany (rodziny CPU, formaty dysków, grafika, peryferia), a systemy operacyjne były niekonsekwentne lub własnościowe. Program działający na jednej maszynie często wymagał przeróbki, żeby działać na innej.

Ta fragmentacja kształtowała ekonomię oprogramowania:

- Oprogramowanie często było dołączane do sprzętu albo dostarczane jako część większego zakupu.

- Wielu rozwiązań tworzono na zamówienie dla określonego klienta.

- Dostawcy wiązali aplikacje z własnym sprzętem, żeby chronić sprzedaż hardware'u.

Ograniczony zasięg oznaczał słabe bodźce

Ponieważ grupa docelowa dla pojedynczej konfiguracji była mała, niezależni deweloperzy mieli trudności z uzasadnieniem czasu i kosztów potrzebnych na stworzenie dopracowanych, szeroko wspieranych produktów. Dystrybucja też była ograniczona: wysyłało się taśmy lub dyskietki bezpośrednio do klienta, polegało na grupach użytkowników lub dzielono kod nieformalnie. Nic z tego nie wyglądało jak skalowalny biznes.

Co się zmieniło, gdy PC stały się powszechne

Gdy PC stały się produktami konsumenckimi i biurowymi, wartość przesunęła się z jednorazowych wdrożeń do powtarzalnej sprzedaży oprogramowania. Kluczową ideą był standardowy target: przewidywalna kombinacja oczekiwań sprzętowych, konwencji OS i ścieżek dystrybucji, na którą deweloperzy mogli postawić.

Gdy osiągnięto krytyczną masę nabywców i kompatybilnych maszyn, pisanie oprogramowania przestało być pytaniem „Czy to zadziała gdzie indziej?” a stało się „Jak szybko dotrzemy do wszystkich korzystających z tego standardu?”.

Najpierw narzędzia: języki jako bramka dla deweloperów

Zanim Microsoft stał się synonimem systemów operacyjnych, był mocno kojarzony z językami programowania — szczególnie z BASIC‑em. Ten wybór nie był przypadkowy. Jeśli chcesz ekosystemu, najpierw potrzebujesz ludzi, którzy potrafią budować, a języki to najniższy próg wejścia.

BASIC jako „zestaw startowy"

Wczesne mikrokomputery często miały BASIC w ROM‑ie, a wersje Microsoftu stały się rozpoznawalnym punktem wejścia na wielu maszynach. Dla ucznia, hobbysty czy małego przedsiębiorcy droga była prosta: włącz, dostaniesz prompt, wpisz kod, zobacz wynik. Ta natychmiastowość miała większe znaczenie niż elegancja. Sprawiła, że programowanie wyglądało jak normalne użycie komputera, a nie wyspecjalizowany zawód.

Dostępność poszerza pulę twórców

Skupiając się na przystępnych narzędziach, Microsoft pomógł poszerzyć lejek potencjalnych deweloperów. Więcej osób piszących małe programy oznaczało więcej eksperymentów, więcej lokalnych „aplikacji” i większy popyt na lepsze narzędzia. To wczesny przykład, jak udział deweloperów działa jak procent składany: pokolenie uczące się na twoim języku i narzędziach zwykle dalej w nim buduje i kupuje w tym samym ekosystemie.

Spójność między maszynami buduje zaufanie

Era mikrokomputerów była rozdrobniona, ale Microsoft przenosił spójne idee między platformami: podobna składnia, podobne oczekiwania co do narzędzi i rosnące poczucie, że „jeśli potrafisz programować tutaj, prawdopodobnie potrafisz tam też”. Ta przewidywalność zmniejszała postrzegane ryzyko nauki programowania.

Strategiczna lekcja jest prosta: platformy nie zaczynają od marketplace’ów czy monetyzacji. Zaczynają od narzędzi, które sprawiają, że tworzenie wydaje się możliwe — a potem zdobywają lojalność, czyniąc to doświadczenie powtarzalnym.

MS‑DOS i standaryzacja targetu PC

Duże odblokowanie we wczesnym przetwarzaniu osobistym to idea „wspólnej warstwy OS”: zamiast pisać osobną wersję aplikacji dla każdego kombinacji sprzętowej, możesz celować w jeden wspólny interfejs. Dla deweloperów oznaczało to mniej portów, mniej zgłoszeń serwisowych i jaśniejszą ścieżkę do wysłania czegoś, co zadziała u wielu klientów.

Jedno miejsce, na które celujesz

MS‑DOS stał między aplikacjami a chaotyczną różnorodnością sprzętu PC. Nadal istniały różne karty graficzne, drukarki, kontrolery dysków i konfiguracje pamięci — ale MS‑DOS dawał wspólną podstawę dla dostępu do plików, ładowania programów i podstawowej interakcji z urządzeniami. Ta wspólna warstwa uczyniła „PC” jednym adresowalnym rynkiem, a nie zbiorem blisko‑kompatybilnych maszyn.

Co w praktyce oznaczała kompatybilność

Dla klientów kompatybilność oznaczała pewność: jeśli program mówił, że działa na MS‑DOS (a w konsekwencji na kompatybilnych z IBM PC), był bardziej prawdopodobny, że zadziała na ich maszynie. Dla deweloperów kompatybilność oznaczała przewidywalne zachowanie — udokumentowane wywołania systemowe, stabilny model wykonania i konwencje instalacji i uruchamiania programów.

Ta przewidywalność uczyniła opłacalnym inwestowanie w dopracowanie, dokumentację i aktualizacje, ponieważ publiczność nie była ograniczona do użytkowników jednego dostawcy sprzętu.

Podstawowy kompromis: postęp kontra zachowanie kompatybilności

Standaryzacja wprowadza ograniczenie: priorytetem staje się utrzymanie działania starego oprogramowania. Presja kompatybilności wstecznej może spowolnić radykalne zmiany, bo łamanie popularnych programów podważa zaufanie do platformy. Pozytywem jest kumulatywna biblioteka oprogramowania; negatywem — węższy tor dla radykalnych innowacji na poziomie OS bez starannych planów przejściowych.

Windows nie tylko „leżał na” MS‑DOS — zmienił to, co deweloperzy mogli zakładać o maszynie. Zamiast każdej aplikacji wymyślającej własny sposób rysowania ekranów, obsługi wejścia i komunikacji z peryferiami, Windows oferował wspólny model UI i rosnący zestaw usług systemowych.

Co Windows dodał ponad DOS

Najważniejszą zmianą był interfejs graficzny: okna, menu, dialogi i fonty, które wyglądały i zachowywały się spójnie między aplikacjami. To obniżało koszt „wynajdywania podstaw na nowo”. Deweloperzy mogli poświęcić czas na funkcje ważne dla użytkowników, zamiast budować kolejny zestaw narzędzi UI.

Windows także rozszerzył wspólne usługi, które w erze DOS były uciążliwe:

- Standaryzowany sposób pracy z plikami i folderami

- Drukowanie przez wspólne sterowniki i okna dialogowe drukowania

- Obsługa sieci bez konieczności podejścia każego dostawcy osobno

Konwencje GUI i wspólne komponenty

Konwencje Windows — takie jak standardowe skróty klawiaturowe, układy dialogów i wspólne kontrolki (przyciski, listy, pola tekstowe) — zmniejszały wysiłek deweloperski i jednocześnie skracały czas szkolenia użytkowników. Wspólne komponenty oznaczały mniej rozwiązań na zamówienie i mniejsze niespodzianki kompatybilności przy zmianie sprzętu.

Wersje, kompatybilność i planowanie

W miarę ewolucji Windows deweloperzy musieli wybierać: wspierać starsze wersje dla zasięgu czy przyjąć nowsze API dla lepszych możliwości. To planowanie kształtowało roadmapy, testowanie i marketing.

Z czasem narzędzia, dokumentacja, biblioteki stron trzecich i oczekiwania użytkowników zaczęły koncentrować się na Windows jako domyślnym celu — nie tylko systemie operacyjnym, ale platformie z własnymi normami i impetem.

Doświadczenie dewelopera: IDE, kompilatory, dokumenty i przykłady

Platforma nie wydaje się „prawdziwa” dla deweloperów, dopóki łatwo na niej wysłać oprogramowanie. W erze PC tę łatwość kształtowało mniej marketing, a bardziej codzienne doświadczenie pisania, budowania, debugowania i pakowania programów.

Narzędzia jako mnożniki produktywności

Kompilatory, linkery, debugery i systemy budowania w cichy sposób ustalały tempo ekosystemu. Gdy czas kompilacji spada, komunikaty o błędach się poprawiają, a debugowanie staje się wiarygodne, deweloperzy iterują szybciej — a iteracja to to, co zamienia pomysł w produkt.

Zintegrowane środowiska (IDE) poszły dalej, łącząc edycję, budowanie, debugowanie i zarządzanie projektem w jednym przepływie pracy. Dobre IDE redukowało „pracę klejącą”, która inaczej zabierała godziny: ustawianie ścieżek include, zarządzanie bibliotekami, utrzymywanie spójności buildów i znajdowanie awarii w runtime.

Niższe ryzyko dla małych zespołów

Lepsze narzędzia to nie tylko „miłe dodatki” — zmieniają ekonomię dla małych zespołów. Jeśli jedna lub dwie osoby mogą budować i testować z pewnością, mogą podjąć projekty, które inaczej wymagałyby większego personelu. To obniża koszty, skraca harmonogramy i zmniejsza ryzyko dla małego ISV, który chciałby postawić na nowy produkt.

Dokumentacja i przykłady często mają większe znaczenie niż funkcje

Dokumentacja i przykładowe, działające kody pełnią rolę drugiego produktu: uczą modelu mentalnego, pokazują najlepsze praktyki i zapobiegają powszechnym błędom. Wielu deweloperów nie adoptuje API dlatego, że jest potężne — adoptują je, bo istnieje jasny przykład działający od pierwszego dnia.

Narzędzia kształtują to, co wydaje się „proste” (a więc „standardowe")

Dostawcy narzędzi wpływają na to, które modele programowania zwyciężają, ułatwiając pewne ścieżki. Jeśli szablony, kreatory, biblioteki i widoki debugowania wskazują daną drogę, staje się ona domyślna — nie dlatego, że jest lepsza teoretycznie, lecz dlatego, że szybciej się jej nauczysz i bezpieczniej wdrożysz.