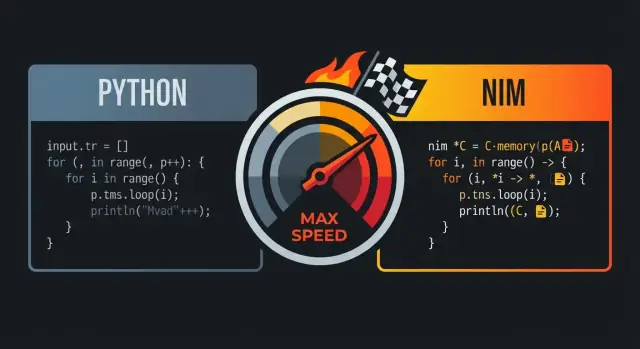

Dlaczego ludzie porównują Nima do Pythona i C

Nim bywa porównywany do Pythona i C, bo dąży do znalezienia słodkiego środka między nimi: kod, który czyta się jak wysokopoziomowy język skryptowy, ale kompiluje się do szybkich natywnych plików wykonywalnych.

Główna obietnica: czytelność i szybkość

Na pierwszy rzut oka Nim często sprawia wrażenie „pythonicznego”: przejrzyste wcięcia, prosty przepływ sterowania i ekspresywne elementy biblioteki standardowej, które ułatwiają czysty, zwarty kod. Kluczowa różnica pojawia się po zapisaniu kodu — Nim został zaprojektowany tak, by kompilować do wydajnego kodu maszynowego, zamiast działać na ciężkim środowisku uruchomieniowym.

Dla wielu zespołów to właśnie jest sens: możesz pisać kod przypominający prototypy z Pythona, a jednocześnie dostarczać pojedyncze natywne binarium.

Dla kogo to ma znaczenie

To porównanie najbardziej trafia do:

- programistów Pythona napotykających ograniczenia wydajności (zadania intensywne obliczeniowo, wąskie pętle, przetwarzanie danych)

- zespołów produktowych chcących szybkich iteracji bez rezygnacji z niskiego narzutu runtime

- inżynierów, którzy cenią szybkość C, lecz nie chcą niskopoziomowej ceremonii w codziennym kodzie

Co w praktyce oznacza „wydajność na poziomie C”

„Wydajność na poziomie C” nie oznacza, że każdy program w Nim automatycznie dorównuje ręcznie optymalizowanemu C. Oznacza, że Nim może wygenerować kod konkurencyjny względem C w wielu obciążeniach — zwłaszcza tam, gdzie koszt narzutu ma znaczenie: pętle numeryczne, parsowanie, algorytmy i serwisy wymagające przewidywalnej latencji.

Największe zyski zobaczysz zwykle po usunięciu narzutu interpretera, zminimalizowaniu alokacji i uproszczeniu gorących ścieżek kodu.

Oczekiwania: szybkość zależy od wyborów

Nim nie uratuje złego algorytmu — nadal możesz napisać wolny kod, jeśli nadmiernie alokujesz, kopiujesz duże struktury danych lub ignorujesz profilowanie. Obietnica polega na tym, że język daje drogę od czytelnego kodu do szybkiego kodu bez konieczności przepisywania wszystkiego w innym ekosystemie.

Efekt: język, który jest przyjazny jak Python, ale gotowy zejść „bliżej metalu”, gdy wydajność zaczyna mieć znaczenie.

Składnia podobna do Pythona: czytelny kod bez nadmiernego narzutu

Nim jest często opisywany jako „podobny do Pythona”, ponieważ kod wygląda i płynie w znajomy sposób: bloki definiowane przez wcięcia, minimalna interpunkcja i preferencja dla czytelnych, wysokopoziomowych konstrukcji. Różnica polega na tym, że Nim pozostaje językiem statycznie typowanym i kompilowanym — otrzymujesz tę czystą powierzchnię bez opłat za runtime.

Bloki oparte na wcięciach i przejrzysta struktura

Podobnie jak w Pythonie, Nim używa wcięć do definiowania bloków, co ułatwia szybkie przeglądanie przepływu sterowania w review i diffach. Nie potrzebujesz wszędzie nawiasów klamrowych i rzadko używasz nawiasów okrągłych, chyba że poprawiają czytelność.

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

Ta wizualna prostota ma znaczenie, gdy piszesz kod wrażliwy na wydajność: spędzasz mniej czasu walcząc ze składnią, a więcej na wyrażaniu intencji.

Znane konstrukcje: pętle, wycinki, stringi

Wiele codziennych konstrukcji odpowiada temu, czego oczekują użytkownicy Pythona.

- Pętle:

for po zakresach i kolekcjach działają naturalnie.

- Wycinki: sekwencje i stringi obsługują operacje w stylu wycinek.

- Stringi: obsługa stringów jest prosta, a biblioteka standardowa praktyczna.

let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

Kluczowa różnica względem Pythona to to, co dzieje się „pod maską”: te konstrukcje kompilują się do wydajnego kodu natywnego, zamiast być interpretowane przez VM.

Typowanie statyczne, które nie przeszkadza

Nim jest silnie statycznie typowany, ale opiera się mocno na wnioskowaniu typów, więc nie musisz pisać rozbudowanych adnotacji typów, by pracować sprawnie.

var total = 0 # wnioskuje int

let name = "Nim" # wnioskuje string

Gdy chcesz jawne typy (dla API, jasności lub granic krytycznych dla wydajności), Nim to obsłuży czysto — bez narzucania ich wszędzie.

Pomocne błędy i ostrzeżenia kompilatora

Dużą część „czytelnego kodu” tworzy możliwość bezpiecznego utrzymania. Kompilator Nima jest surowy w użyteczny sposób: wykrywa niezgodności typów, nieużywane zmienne i wątpliwe konwersje wcześnie, często z komunikatami sugerującymi działania. Ten szybki feedback pomaga utrzymać kod prosty jak w Pythonie, a jednocześnie korzystać z kontroli poprawności w czasie kompilacji.

Jeśli lubisz czytelność Pythona, składnia Nima będzie ci bliska. Różnica polega na tym, że kompilator Nim może zweryfikować założenia i wygenerować szybkie, przewidywalne natywne binaria — bez przemiany kodu w boilerplate.

Jak Nim kompiluje: od źródła do natywnego binarium

Nim to język kompilowany: piszesz pliki .nim, a kompilator zamienia je w natywne wykonywalne. Najczęściej używanym kanałem jest backend C (może też celować w C++ lub Objective-C), gdzie kod Nim jest tłumaczony na kod źródłowy backendu, a następnie kompilowany przez kompilator systemowy jak GCC lub Clang.

Co naprawdę oznacza „natywne binarium”?

Natywne binarium działa bez maszyny wirtualnej i bez interpretera wykonującego kod linia po linii. To ważna część powodu, dla którego Nim może czuć się wysokopoziomowo, a jednocześnie unikać wielu kosztów runtime związanych z VM czy interpreterem: czas uruchomienia jest zwykle krótki, wywołania funkcji są bezpośrednie, a gorące pętle mogą działać blisko sprzętu.

Możliwości optymalizacji całego programu

Ponieważ Nim kompiluje z wyprzedzeniem, toolchain może optymalizować cały program. W praktyce oznacza to lepsze inline’owanie, usuwanie martwego kodu i optymalizacje link-time (w zależności od flag i kompilatora C/C++). W efekcie często otrzymujesz mniejsze, szybsze wykonywalne — szczególnie w porównaniu z dystrybucją runtime plus źródła.

Typowy workflow: kompiluj, uruchamiaj, wysyłaj

W czasie rozwoju zwykle iterujesz przy pomocy poleceń takich jak nim c -r yourfile.nim (kompiluj i uruchom) lub używasz różnych trybów budowania dla debug vs release. Gdy przyjdzie czas na dystrybucję, rozprowadzasz wygenerowane wykonywalne (i ewentualne biblioteki dynamiczne, jeśli linkujesz). Nie ma osobnego kroku „wdrażaj interpreter” — wynik to program, który OS może uruchomić.

Moc w czasie kompilacji: robienie pracy przed uruchomieniem programu

Jedną z największych przewag Nima jest możliwość wykonania pewnych zadań w czasie kompilacji (CTFE). Prościej: zamiast obliczać coś przy każdym uruchomieniu programu, prosisz kompilator, żeby to obliczył raz podczas budowania i wstawił wynik do binarium.

Dlaczego praca w czasie kompilacji ma znaczenie

Wydajność w czasie działania często „zjadają” koszty przygotowania: budowanie tabel, parsowanie znanych formatów, sprawdzanie inwariantów czy preobliczanie wartości, które się nie zmieniają. Jeśli wyniki są deterministyczne na podstawie stałych, Nim może przenieść te koszty do kompilacji.

To oznacza:

- krótszy czas startu (brak etapu „rozgrzewki”)

- mniej alokacji i rozgałęzień podczas działania

- prostsze ścieżki runtime (łatwiejsze do optymalizacji)

Przykłady praktyczne

Generowanie tablic wyszukiwania. Jeśli potrzebujesz tablicy do szybkiego mapowania (np. klasy znaków ASCII lub mała tablica skrótów znanych stringów), możesz wygenerować ją w czasie kompilacji i zapisać jako stałą. Program potem robi O(1) odczyty bez przygotowania.

Wczesna walidacja stałych. Jeśli stała jest poza zakresem (numer portu, rozmiar bufora, wersja protokołu), możesz przerwać build zamiast wysyłać binarium, które odkryje problem dopiero w środowisku produkcyjnym.

Wstępne obliczanie pochodnych stałych. Maski, wzorce bitowe czy znormalizowane domyślne konfiguracje można policzyć raz i używać wszędzie.

Uwaga: zachowaj czytelność

Logika w czasie kompilacji jest potężna, ale to nadal kod, który ktoś musi zrozumieć. Preferuj małe, dobrze nazwane funkcje pomocnicze; dodaj komentarze wyjaśniające „dlaczego teraz” (czas kompilacji) vs „dlaczego później” (czas działania). Testuj też funkcje CTFE tak jak zwykłe funkcje — żeby optymalizacje nie zamieniły się w trudne do debugowania błędy budowania.

Makra w Nim to „kod, który pisze kod” podczas kompilacji. Zamiast wykonywać logiczną refleksję w runtime (co kosztuje przy każdym uruchomieniu), możesz wygenerować wyspecjalizowany, świadomy typów kod Nim raz, a potem dostarczyć szybkie binarium.

Usuwanie boilerplate (i runtime checks)

Częstym zastosowaniem jest zastępowanie powtarzalnych wzorców, które inaczej zapełniłyby bazę kodu albo dodawały narzut podczas wywołań. Na przykład możesz:

- wygenerować funkcje serializacji/deserializacji dla typu zamiast ręcznego pisania pól

- stworzyć kod walidacji na podstawie kompaktowego schematu zamiast rozsianych

ifów

- zbudować zoptymalizowany kod dispatchu bez tabel look-up w czasie działania

Ponieważ makro rozwija się do normalnego kodu Nim, kompilator dalej może inline’ować, optymalizować i usuwać martwe gałęzie — więc abstrakcja często „znika” w finalnym binarium.

Kontekstowo-specyficzna składnia bez własnego kompilatora

Makra pozwalają też na lekką, specyficzną dla domeny składnię. Zespoły używają tego, by wyrażać intencję wprost:

- szybkie parsery: napisz deklaratywny opis gramatyki, makro wyemituje szczelny kod parsujący

- serializery: określ tagi/pola, generuj kod pakujący/odpakowujący

- mini-DSL do routingu, budowania zapytań SQL lub mapowań konfiguracji

Dobrze zrobione, wywołanie wygląda jak czytelny Python, a kompiluje się do efektywnych pętli i operacji bezpiecznych wskaźnikowo.

Jak utrzymać makra

Metaprogramowanie może się skomplikować, jeśli stanie się ukrytym językiem w projekcie. Kilka zasad:

- dokumentuj, co makro generuje, i pokaż mały przykład wygenerowanego kodu

- trzymaj makra wąskie: rozwiązuj jedną, jasną rzecz

- preferuj zwykłe generiki/szablony, gdy wystarczą; sięgaj po makra, gdy naprawdę potrzebujesz transformacji AST

Zarządzanie pamięcią: ARC/ORC i przewidywalna wydajność

Domyślne zarządzanie pamięcią w Nim to duży powód, dla którego może się on wydawać „pythoniczny”, a jednocześnie zachowywać cechy języka systemowego. Zamiast klasycznego śledzącego GC, Nim zwykle korzysta z ARC (Automatic Reference Counting) lub ORC (Optimized Reference Counting).

ARC/ORC vs GC śledzący (na wysokim poziomie)

GC śledzący działa partiami: wstrzymuje pracę, przegląda obiekty i decyduje, co zwolnić. Model ten jest ergonomiczny, ale przerwy bywają trudne do przewidzenia.

Przy ARC/ORC większość pamięci zwalniana jest wtedy, gdy ostatnie odniesienie przestaje istnieć. W praktyce daje to bardziej spójną latencję i łatwiejsze rozumienie, kiedy zasoby są zwalniane (pamięć, deskryptory plików, sokety).

Dlaczego przewidywalność pomaga wydajności

Przewidywalne zachowanie pamięci zmniejsza „niespodziewane” spowolnienia. Gdy alokacje i zwolnienia dzieją się lokalnie i ciągłe — zamiast okazjonalnych globalnych cykli czyszczenia — czas działania programu jest łatwiejszy do kontrolowania. Ma to znaczenie w grach, serwerach, narzędziach CLI i wszędzie tam, gdzie responsywność jest istotna.

Pomaga też kompilatorowi w optymalizacjach: gdy lifetime'y są jaśniejsze, czasem można trzymać dane w rejestrach lub na stosie i unikać dodatkowych księgowań.

Stos vs sterta, lifetime'y oraz kopiowanie vs przenoszenie

W dużym uproszczeniu:

- wartości na stosie są krótkowieczne i tanie w tworzeniu; znikają po opuszczeniu zakresu

- wartości na stercie żyją dłużej i mogą być współdzielone, ale ich alokacja kosztuje

Nim pozwala pisać wysokopoziomowy kod, jednocześnie myśląc o lifetime'ach. Zwróć uwagę, czy kopiujesz duże struktury (duplikujesz dane), czy je przenosisz (przekazujesz własność bez kopiowania). Unikaj niezamierzonych kopii w gorących pętlach.

Praktyczne wskazówki, by unikać zbędnych alokacji

Jeżeli chcesz „szybkości jak w C”, najtańsza alokacja to ta, której nie wykonujesz:

- ponownie używaj buforów (dla stringów, sekwencji, IO) zamiast tworzyć je za każdym razem

- preferuj aktualizacje in-place w gorących ścieżkach

- buduj dane przyrostowo z prealokowaną pojemnością, gdy to możliwe

Te nawyki dobrze współgrają z ARC/ORC: mniej obiektów na stercie oznacza mniej ruchu liczników referencji i więcej czasu spędzonego na faktycznej pracy.

Struktury danych i układ w pamięci: szybkość z prostoty

Nim może wydawać się wysokopoziomowy, ale jego wydajność często sprowadza się do niskopoziomowego szczegółu: co jest alokowane, gdzie to leży i jak jest ułożone w pamięci. Przy wyborze odpowiednich kształtów danych często dostajesz szybkość „za darmo”, bez pisania nieczytelnego kodu.

Typy wartościowe vs ref: gdzie następuje alokacja

Większość typów w Nim to typy wartościowe domyślnie: int, float, bool, enum, a także proste wartościowe object. Typy wartościowe zwykle żyją inline (na stosie lub osadzone w innych strukturach), co utrzymuje dostęp pamięci zwięzły i przewidywalny.

Gdy używasz ref (np. ref object), dodajesz poziom pośrednictwa: wartość zwykle żyje na stercie i manipulujesz wskaźnikiem do niej. To bywa przydatne do danych współdzielonych, długowiecznych lub opcjonalnych, ale może dodać kosztu w gorących pętlach, bo CPU musi podążać za wskaźnikami.

Zasadniczo: preferuj zwykłe wartości object dla danych krytycznych wydajnościowo; sięgaj po ref, gdy naprawdę potrzebujesz semantyki referencji.

seq i string: wygodne, ale znaj koszty

seq[T] i string to dynamiczne, rozszerzalne kontenery. Są świetne do codziennego programowania, ale mogą alokować i realokować wraz ze wzrostem. Wzorce kosztów do obserwowania:

- dopisywanie czasem wywołuje resize (kopiowanie istniejących elementów)

- wiele małych

seq lub stringów tworzy dużo osobnych bloków na stercie

Jeśli znasz rozmiary z góry, prealokuj (newSeq, setLen) i ponownie używaj buforów, aby ograniczyć churn.

Dlaczego układ ma znaczenie: prosty model pamięci podręcznej CPU

CPU działa najszybciej, gdy czyta ciągłą pamięć. seq[MyObj], gdzie MyObj to zwykły typ wartościowy, jest zwykle przyjazny cache’owi: elementy leżą obok siebie.

Ale seq[ref MyObj] to lista wskaźników rozrzuconych po stercie; iteracja po niej oznacza skoki po pamięci, co jest wolniejsze.

Praktyczne rady dla gorących ścieżek

Dla ciasnych pętli i krytycznego kodu:

- preferuj

array (stały rozmiar) lub seq wartościowych obiektów

- trzymaj często używane pola blisko siebie w jednym

object

- unikaj „łańcuchów wskaźników” (

ref w ref), jeśli nie są konieczne

Takie wybory utrzymują dane kompaktowe i lokalne — dokładnie to, co lubią nowoczesne CPU.

Abstrakcje, które kompilują się do niewielkiego kosztu

Jednym z powodów, dla których Nim może być wysokopoziomowy bez dużego narzutu runtime, jest to, że wiele „miłych” cech języka ma być kompilowanych do prostego kodu maszynowego. Piszesz ekspresyjny kod; kompilator obniża go do szczupłych pętli i bezpośrednich wywołań.

Co znaczy „abstrakcja bez kosztu" w Nim

Abstrakcja bez kosztu to cecha, która upraszcza czytelność lub reużywalność kodu, ale nie dodaje dodatkowej pracy w czasie działania względem ręcznego niskopoziomowego odpowiednika.

Przykładem jest API iteratorów do filtrowania wartości, które i tak może skompilować się do prostej pętli w finalnym binarium.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

Choć openArray wygląda elastycznie i wysokopoziomowo, zwykle kompiluje się do podstawowego przejścia po indeksach w pamięci (bez narzutu obiektowego charakterystycznego dla Pythona).

Inline’owanie, generiki i specjalizacje (wersja po ludzku)

Nim chętnie inline’uje małe procedury, gdy to pomaga — wtedy wywołanie może zniknąć, a ciało zostaje wklejone w miejscu wywołania.

Dzięki generikom piszesz jedną funkcję działającą dla wielu typów. Kompilator specjalizuje ją: tworzy dopasowaną wersję dla każdego konkretnego typu, którego używasz. To często daje kod tak szybki jak ręcznie napisane, specyficzne wersje.

Przyjemne API, które wciąż staje się szczupłą pętlą

Wzorce jak małe pomocniki (mapIt, filterIt), typy distinct czy sprawdzenia zakresów mogą zostać zoptymalizowane, jeśli kompilator widzi przez nie. Wynikiem może być jedna pętla z minimalną ilością rozgałęzień.

Jedno duże zastrzeżenie: abstrakcje, które wymuszają alokacje

Abstrakcje przestają być „darmowe”, gdy tworzą na stercie obiekty lub ukryte kopie. Zwracanie nowych sekwencji wielokrotnie, budowanie tymczasowych stringów w pętlach wewnętrznych czy wychwytywanie dużych closure może wprowadzić narzut.

Zasada: jeśli abstrakcja alokuje per-iterację, może zdominować czas wykonania. Preferuj przyjazne stosowi dane, ponowne użycie buforów i obserwuj API, które ukrycie tworzy nowe seq lub string w gorących ścieżkach.

Interoperacyjność z C: ponowne użycie wydajności i ekosystemów

Praktycznym powodem, dla którego Nim może być wysokopoziomowy i wciąż szybki, jest możliwość wywoływania C bezpośrednio. Zamiast przepisywać sprawdzoną bibliotekę C, możesz zaimportować jej definicje nagłówkowe, podlinkować skompilowaną bibliotekę i wywoływać funkcje niemal jak natywne procedury Nim.

Jak wygląda FFI Nima (na wysokim poziomie)

FFI Nima polega na opisaniu funkcji i typów C, których chcesz używać. W praktyce:

- deklarujesz symbole C w Nim z

importc (dokładna nazwa C), lub

- używasz narzędzi generujących deklaracje Nim z nagłówków C

Następnie kompilator Nim linkuje wszystko w jedno natywne binarium, więc narzut wywołań jest minimalny.

Dlaczego to ma znaczenie: użycie bez przepisywania

Daje to natychmiastowy dostęp do dojrzałych ekosystemów: kompresja (zlib), kryptografia, kodeki obrazów/dźwięku, klienci baz danych, API systemowe i narzędzia krytyczne wydajnościowo. Zachowujesz czytelną, Pythonopodobną strukturę logiki aplikacji, polegając na sprawdzonym C do ciężkiej pracy.

Pułapki: własność i konwersje

Błędy FFI zwykle wynikają z niedopasowanych oczekiwań:

- Zasady własności: kto alokuje, kto zwalnia? Jeśli funkcja C zwraca wskaźnik, który trzeba zwolnić, musisz mieć jasną ścieżkę zwalniania w Nim. Jeśli C przechowuje wskaźnik do pamięci, którą przekazałeś, musisz zadbać, by ta pamięć pozostała żywa.

- Stringi i bufory: Nim stringi nie są stringami C. Konwersja do

cstring jest prosta, ale musisz zapewnić terminację null i lifetime. Dla danych binarnych preferuj jawne ptr uint8 + długość.

Opakuj API C bezpiecznie (i testowalnie)

Dobrym wzorcem jest mała warstwa wrapperów Nim, która:

- udostępnia idiomatyczne procs/typy Nim,

- centralizuje konwersje i obsługę błędów,

- ukrywa surowe wskaźniki za helperami RAII-owymi (

defer, destruktory) tam, gdzie to potrzebne.

To ułatwia testowanie jednostkowe i zmniejsza ryzyko wycieków niskopoziomowych szczegółów w reszcie kodu.