16 paź 2025·8 min

REST vs gRPC: jak wybrać styl API dla swojej aplikacji

Porównaj REST i gRPC dla prawdziwych projektów: wydajność, narzędzia, strumieniowanie, kompatybilność i dopasowanie zespołu. Użyj prostej checklisty, aby zdecydować pewnie.

Porównaj REST i gRPC dla prawdziwych projektów: wydajność, narzędzia, strumieniowanie, kompatybilność i dopasowanie zespołu. Użyj prostej checklisty, aby zdecydować pewnie.

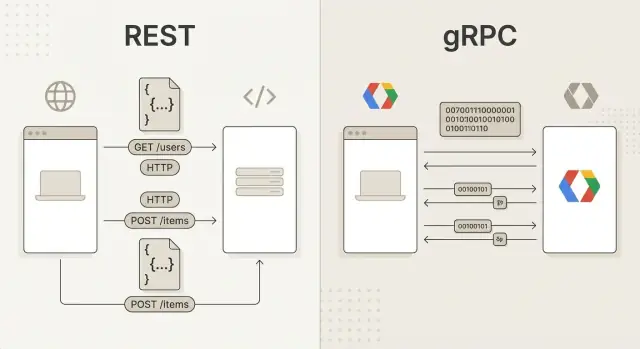

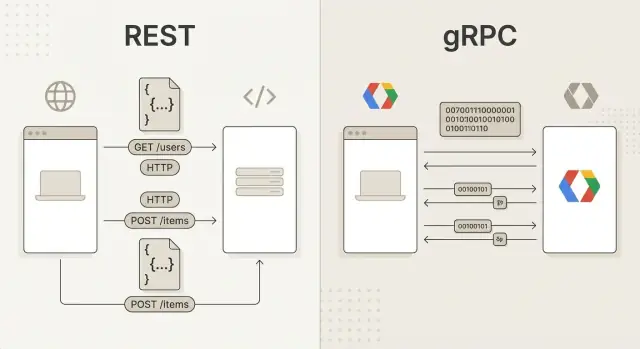

Kiedy ludzie porównują REST i gRPC, tak naprawdę zestawiają dwa różne sposoby, w jaki oprogramowanie „rozmawia” przez sieć.

REST to styl projektowania API oparty na zasobach — rzeczach, którymi zarządza Twoja aplikacja, jak użytkownicy, zamówienia czy faktury. Interakcje z tymi zasobami odbywają się za pomocą znajomych żądań HTTP:

GET /users/123)POST /orders)Odpowiedzi są zwykle w JSON, łatwym do odczytu i powszechnie wspieranym formacie. REST wydaje się intuicyjny, bo dobrze odwzorowuje sposób działania sieci i można go testować w przeglądarce lub prostymi narzędziami.

gRPC to framework do zdalnych wywołań procedur (RPC). Zamiast myśleć w kategoriach „zasobów”, myślisz o metodach, które chcesz uruchomić na innej usłudze, jak CreateOrder czy GetUser.

gRPC zazwyczaj używa pod spodem:

.proto), z którego można generować kod klienta i serweraEfekt często przypomina wywołanie lokalnej funkcji — z tą różnicą, że działa gdzie indziej.

Ten przewodnik pomoże Ci wybrać w oparciu o rzeczywiste ograniczenia: oczekiwaną wydajność, typy klientów (przeglądarka vs mobile vs usługi wewnętrzne), potrzeby w czasie rzeczywistym, sposób pracy zespołu i długoterminowe utrzymanie.

Nie ma uniwersalnej odpowiedzi. Wiele zespołów używa REST do publicznych API i gRPC do komunikacji między usługami wewnętrznymi, ale to Twoje ograniczenia i cele powinny decydować.

Zanim porównasz cechy, wyjaśnij, co optymalizujesz. REST i gRPC mogą działać dobrze, ale sprawdzają się w różnych scenariuszach.

Zacznij od klientów.

curl, REST zwykle jest bezpieczniejszym wyborem.W publicznym internecie ważne będą proxy, warstwy cache i kompatybilność z różnorodnymi narzędziami. REST nad HTTP jest szeroko wspierany i zwykle łatwiej przechodzi przez sieci korporacyjne.

W sieci prywatnej (lub między usługami na tej samej platformie) możesz skorzystać z mocniejszych cech gRPC — zwłaszcza gdy kontrolujesz obie strony.

Zastanów się, jak wygląda „normalny ruch”:

Jeśli potrzebujesz strumieniowania (zdarzeń, postępu, ciągłych feedów), uwzględnij to na wczesnym etapie. Można zbudować real-time wokół REST, ale model strumieniowania gRPC jest często bardziej naturalny, gdy obie strony to wspierają.

Wybierz to, co zespół potrafi wdrożyć i obsługiwać. Weź pod uwagę istniejące standardy API, nawyki debugowania, tempo wydań i to, jak szybko nowi deweloperzy staną się produktywni. „Najlepszy” protokół, który spowalnia dostawy lub zwiększa ryzyko operacyjne, nie jest najlepszy dla projektu.

Na poziomie protokołu REST i gRPC sprowadzają się do „klient wywołuje serwer”, ale opisują to inaczej: REST skupia się na zasobach i kodach statusu HTTP, gRPC na zdalnych metodach i ścisłym schemacie.

REST zwykle działa nad HTTP/1.1, coraz częściej też HTTP/2. Kształt wywołania REST określają:

/users/123)GET, POST, PUT, PATCH, DELETE200, 201, 400, 401, 404, 500 itd.Accept, Content-Type)Typowy wzorzec to request/response: klient wysyła żądanie HTTP, serwer zwraca odpowiedź ze statusem, nagłówkami i ciałem (zwykle JSON).

gRPC zawsze używa HTTP/2, ale nie eksponuje „zasobów + czasowników” jako głównego interfejsu. Definiujesz usługi z metodami (np. CreateUser, GetUser) i wywołujesz je jako zdalne procedury.

Obok payloadu gRPC wspiera:

REST pyta: „Na jakim zasobie operujesz i który czasownik HTTP pasuje?”

gRPC pyta: „Jaką metodę wywołujesz i jaki typowany komunikat ona przyjmuje/zwraća?”

Ta różnica wpływa na nazewnictwo, obsługę błędów (kody HTTP vs statusy gRPC) i sposób generowania klientów.

.proto jest kontraktem. Definiuje usługi, metody i silnie typowane komunikaty, co pozwala na generowanie kodu i jasne reguły kompatybilności przy ewolucji API.Wydajność to jeden z najczęściej wymienianych powodów wyboru gRPC — ale zysk nie jest automatyczny. Pytanie brzmi, jakiego rodzaju „wydajność” potrzebujesz: niższe opóźnienie na wywołanie, większa przepustowość, mniejsze zużycie pasma czy lepsza efektywność serwera.

Większość REST API używa JSON nad HTTP/1.1. JSON łatwo jest przeglądać, logować i debugować, co jest praktycznym rodzajem efektywności.

Kosztem jest to, że JSON jest obszerny i wymaga więcej CPU do parsowania i generowania, szczególnie przy dużych payloadach lub częstych wywołaniach. HTTP/1.1 może też dodawać narzut połączeń przy wielu równoległych żądaniach.

REST może też zwyciężać w architekturach nastawionych na odczyt: cache HTTP (ETag, Cache-Control) i CDN potrafią znacznie zredukować powtarzane żądania.

gRPC zwykle używa Protocol Buffers (binarnie) nad HTTP/2. To zwykle oznacza:

Korzyści widać najbardziej przy wywołaniach service-to-service o wysokim wolumenie lub przy dużej ilości przesyłanych danych wewnątrz systemu.

Na spokojnym systemie REST i gRPC mogą wyglądać podobnie szybko. Różnice stają się bardziej zauważalne przy rosnącej współbieżności.

Różnice wydajnościowe mają znaczenie, gdy masz częste wewnętrzne wywołania, duże payloady, ograniczenia pasma mobilnego lub ścisłe SLO.

Mniejsze znaczenie mają, gdy API jest zdominowane przez czas bazy danych, zewnętrzne wywołania lub użytkowników ludzkich (panele admina, typowe CRUDy). W takich przypadkach jasność, możliwość cache'owania i kompatybilność klientów mogą przewyższać surową wydajność protokołu.

Funkcje real-time — pulpity na żywo, czat, współpraca, telemetry — zależą od tego, jak API obsługuje „trwającą” komunikację, a nie tylko jednorazowe żądania.

REST jest z natury request/response: klient pyta, serwer odpowiada i połączenie się kończy. Można zbudować zachowania near-real-time, ale zwykle opierają się one na wzorcach współpracujących z REST:

(Dla real-time w przeglądarce zespoły często dokładają WebSockety lub SSE obok REST; to osobny kanał z własnym modelem operacyjnym.)

gRPC wspiera wiele typów wywołań nad HTTP/2, a strumieniowanie jest wbudowane:

To sprawia, że gRPC dobrze nadaje się do utrzymanych, niskoopóźnieniowych przepływów wiadomości bez ciągłego tworzenia nowych żądań HTTP.

Strumieniowanie sprawdza się dla:

Długotrwałe strumienie zmieniają sposób operowania systemami:

Jeśli „real-time” jest kluczowe dla produktu, model strumieniowy gRPC może uprościć implementację w porównaniu do warstwowania polling/webhooks (albo WebSocketów) nad REST.

Wybór między REST a gRPC to nie tylko szybkość — zespół będzie pracował z API codziennie. Narzędzia, onboardowanie i sposób bezpiecznego rozwijania interfejsu często mają większe znaczenie niż surowa przepustowość.

REST jest znajomy, bo działa na zwykłym HTTP i zwykle używa JSON. Toolbox jest uniwersalny: devtools przeglądarki, curl, Postman/Insomnia, proxy i czytelne logi.

Gdy coś się psuje, debugowanie jest często proste: odtwórz żądanie w terminalu, sprawdź nagłówki i porównaj odpowiedzi. Ta wygoda tłumaczy, dlaczego REST jest powszechny dla publicznych API i do pracy ad-hoc.

gRPC zwykle używa Protocol Buffers i generowania kodu. Zamiast ręcznie składać żądania, deweloperzy wywołują typowane metody w wybranym języku.

Zysk to bezpieczeństwo typów i jasny kontrakt: pola, enumy i struktury wiadomości są jawne. To może zmniejszyć błędy „stringly-typed” i niespójności między klientem a serwerem — szczególnie w komunikacji między usługami.

REST łatwiej przyswoić: „wyślij żądanie HTTP na ten URL.” gRPC wymaga zrozumienia plików .proto, generowania kodu i czasem innego workflow debugowania. Zespoły przyzwyczajone do silnego typowania i współdzielonych schematów adaptują się szybciej.

W REST/JSON zarządzanie zmianami często opiera się na konwencjach (dodawanie pól, deprecjacja endpointów, wersjonowane URL). W gRPC/Protobuf reguły kompatybilności są bardziej formalne: dodawanie pól jest zwykle bezpieczne, ale zmiana nazw/usunięcie czy zmiana typów może złamać klientów.

W obu stylach utrzymanie poprawia traktowanie API jak produktu: dokumentuj, automatyzuj testy kontraktowe i opublikuj jasną politykę deprecjacji.

Wybór często sprowadza się do tego, kto będzie wywoływał Twoje API i z jakiego środowiska.

REST nad HTTP z JSON jest szeroko wspierany: przeglądarki, aplikacje mobilne, narzędzia CLI, platformy low-code i systemy partnerskie. Jeśli tworzysz publiczne API lub spodziewasz się integracji zewnętrznych, REST minimalizuje tarcie — konsumenci zaczynają od prostych żądań, potem mogą przechodzić do lepszych narzędzi.

REST dobrze współgra z ograniczeniami webowymi: przeglądarki obsługują HTTP, cache i proxy je rozumieją, a debugowanie jest proste w standardowych narzędziach.

gRPC świeci, gdy kontrolujesz obie strony połączenia (własne usługi, wewnętrzne aplikacje). Korzysta z HTTP/2 i Protocol Buffers, co daje korzyści wydajnościowe i spójność — ale nie każde środowisko może to łatwo przyjąć.

Przeglądarki na przykład nie obsługują „pełnego” gRPC natywnie. Możesz użyć gRPC-Web, ale to dodaje komponenty i ograniczenia (proxy, konkretne typy treści, inne narzędzia). Dla zewnętrznych partnerów wymaganie gRPC może być barierą większą niż wystawienie RESTowego endpointu.

Popularny wzorzec to utrzymywanie gRPC wewnętrznie, a eksponowanie REST na zewnątrz przez bramkę/warstwę translacji. Pozwala to partnerom korzystać ze znanego HTTP/JSON, podczas gdy wewnętrzne systemy korzystają z silnie typowanego kontraktu.

Jeśli Twoi konsumenci to nieznane zewnętrzne podmioty, REST zwykle jest bezpieczniejszym domyślnym wyborem. Jeśli to głównie Twoje usługi, gRPC często będzie lepszy.

Bezpieczeństwo i operacyjność to miejsca, gdzie „ładnie w demo” staje się „trudne w produkcji”. REST i gRPC mogą być bezpieczne i obserwowalne, ale pasują do różnych wzorców infrastruktury.

REST zwykle działa przez HTTPS (TLS). Uwierzytelnianie jest przenoszone w standardowych nagłówkach HTTP:

Dzięki znajomym semantykom HTTP łatwo zintegrować WAFy, reverse proxy i bramki API, które rozumieją nagłówki, ścieżki i metody.

gRPC także używa TLS, ale uwierzytelnianie często przekazywane jest przez metadata (pary klucz/wartość podobne do nagłówków). Typowo dodaje się:

authorization: Bearer …)Dla REST wiele platform ma gotowe logi dostępu, kody statusu i czas żądań. Możesz osiągnąć dużo dzięki strukturalnym logom i standardowym metrykom: percentyle opóźnień, wskaźniki błędów i przepustowość.

Dla gRPC obserwowalność jest świetna po odpowiednim zainstrumentowaniu, ale może być mniej „automatyczna” w niektórych stosach, bo nie operujesz bezpośrednio na zwykłych URL-ach. Priorytety:

Typowe ustawienia REST umieszczają ingress lub API gateway na krawędzi, obsługując TLS termination, auth, rate limiting i routing.

gRPC też dobrze działa za ingress, ale często potrzebujesz komponentów w pełni wspierających HTTP/2 i funkcje gRPC. W mikrousługach service mesh może upraszczać mTLS, retry, timeouty i telemetry dla gRPC — szczególnie gdy wiele usług komunikuje się wewnętrznie.

Wniosek operacyjny: REST zwykle łatwiej integruje się ze „standardowymi” narzędziami webowymi, podczas gdy gRPC sprawdza się, gdy standardyzujesz deadline'y, tożsamość usług i spójną telemetrię w wewnętrznych wywołaniach.

Większość zespołów nie wybiera REST lub gRPC w abstrakcji — wybierają to, co pasuje do odbiorców, klientów i kształtu ruchu.

REST to często „bezpieczny” wybór, gdy API ma być szeroko konsumowalne i łatwe do eksploracji.

Użyj REST gdy budujesz:

curl, Postman, logi)REST sprawdza się na krawędziach systemu: jest czytelny, w wielu przypadkach cache-friendly i dobrze współpracuje z gatewayami i dokumentacją.

gRPC zwykle lepiej pasuje do komunikacji między usługami, gdzie liczy się efektywność i silne kontrakty.

Wybierz gRPC gdy masz:

W takich przypadkach binarne kodowanie i funkcje HTTP/2 (multiplexing) często obniżają narzut i stabilizują wydajność wraz ze wzrostem ruchu wewnętrznego.

Praktyczna architektura to:

Ten wzorzec ogranicza wymagania kompatybilności gRPC do kontrolowanego środowiska, jednocześnie dając korzyści z typowanych kontraktów i wydajności wewnątrz platformy.

Kilka decyzji, które często powodują problemy:

/doThing i utrata jasności projektowania zasobowego.Jeśli nie jesteś pewien, domyśl do REST dla zewnętrznych API i adoptuj gRPC tam, gdzie możesz udowodnić korzyści: wewnątrz platformy, na gorących ścieżkach lub tam, gdzie strumieniowanie i ścisłe kontrakty naprawdę się opłacają.

Wybór między REST i gRPC jest łatwiejszy, gdy zaczynasz od tego, kto będzie korzystał z API i co ma osiągnąć — nie od tego, co jest modne.

Zadaj pytania:

curl, generacja klientów, stabilna dokumentacja, SDK.Wybierz reprezentatywny endpoint (nie „Hello World”) i zbuduj go jako:

Zmierz:

Jeśli chcesz szybko zrobić pilotaż, workflow typu vibe-coding może pomóc: na Koder.ai możesz zeskafoldować małą aplikację i backend z prompta czatu, a następnie przetestować zarówno powierzchnię REST, jak i usługę gRPC wewnętrznie. Koder.ai generuje realne projekty (React dla webu, Go w backendzie z PostgreSQL, Flutter dla mobilnych), dzięki czemu łatwo zweryfikować nie tylko benchmarki protokołu, ale też doświadczenie deweloperskie — dokumentację, integrację klienta i wdrożenie. Funkcje takie jak tryb planowania, snapshoty i rollback też pomagają podczas iteracji nad kształtem API.

Udokumentuj wybór, założenia (klienci, ruch, strumieniowanie) i metryki, których użyłeś. Przejrzyj decyzję, gdy wymagania się zmienią (nowi zewnętrzni konsumenci, większy ruch, potrzeby real-time).

(Patrz sekcję FAQ poniżej — odpowiedzi znajdują się w tym dokumencie.)

REST zwykle jest domyślnym wyborem dla publicznych API, ponieważ niemal każdy klient może wywołać je przez zwykłe HTTP i JSON.

Wybierz REST jeśli spodziewasz się:

curl/PostmangRPC często lepiej się sprawdza, gdy kontrolujesz obie strony połączenia i chcesz silnie typowanego kontraktu.

To dobre rozwiązanie dla:

Nie zawsze. gRPC zazwyczaj wygrywa pod względem rozmiaru payloadu i efektywności połączeń (HTTP/2 multiplexing + Protobuf), ale wyniki end-to-end zależą od wąskich gardeł.

Benchmarkuj realistyczne scenariusze, bo wydajność może być zdominowana przez:

REST naturalnie wspiera cache'owanie HTTP za pomocą nagłówków takich jak Cache-Control i ETag, a także CDN-y i wspólne proxy.

gRPC zwykle nie jest tak przyjazny dla cachowania w standardowej infrastrukturze HTTP, ponieważ wywołania są zorientowane na metody i często traktowane jako nie-cache'owalne.

Jeśli cachowanie jest kluczowe, REST jest zwykle prostszą drogą.

Przeglądarki nie obsługują natywnego gRPC bezpośrednio z powodu braku niskopoziomowych funkcji HTTP/2, których gRPC oczekuje.

Opcje:

Dla klientów przeglądarkowych REST zwykle jest najprostszym wyborem.

gRPC jest projektowany wokół schematu .proto, który definiuje usługi, metody i typy wiadomości. Ten schemat umożliwia generowanie kodu i jasne reguły zgodności.

Technicznie można używać innych formatów, ale tracisz wiele korzyści (typowanie, kompaktowe wiadomości, ustandaryzowane narzędzia).

Jeśli chcesz głównych zalet gRPC, traktuj Protobuf jako część pakietu.

REST zwykle komunikuje wyniki przez kody statusu HTTP (np. 200, 404, 500) i ciała odpowiedzi.

gRPC zwraca kod statusu gRPC (np. OK, NOT_FOUND, UNAVAILABLE) oraz opcjonalne szczegóły błędu.

Praktyczna wskazówka: ustandaryzuj mapowanie błędów wcześnie (w tym błędy retryowalne vs nie), aby klienci zachowywali się spójnie w całym systemie.

Strumieniowanie jest natywną cechą gRPC, z wbudowanym wsparciem dla:

REST to głównie request/response; „real-time” zwykle wymaga dodatkowych wzorców jak polling, long polling, webhooks, WebSockety lub SSE.

Dla REST powszechne praktyki to:

/v1/... lub przez nagłówkiDla gRPC/Protobuf:

Tak — to powszechna i praktyczna architektura:

Bramka lub backend-for-frontend może tłumaczyć REST/JSON na gRPC/Protobuf. To ogranicza wymagania kompatybilności gRPC do kontrolowanego środowiska, przy jednoczesnym zachowaniu wygody dla zewnętrznych klientów.