Co powinno rozwiązywać scentralizowane raportowanie SLA

Scentralizowane raportowanie SLA jest potrzebne, ponieważ dowody SLA rzadko żyją w jednym miejscu. Uptime może być w narzędziu monitorującym, incydenty na stronie statusu, zgłoszenia w helpdesku, a notatki eskalacyjne w e-mailach lub czacie. Gdy każdy klient ma nieco inny stos technologiczny (albo inne konwencje nazewnictwa), miesięczne raportowanie zamienia się w pracę arkuszową — i pojawiają się spory o to, „co się naprawdę stało”.

Kto z tego korzysta (i czego potrzebuje)

Dobra aplikacja do raportowania SLA obsługuje kilka grup z różnymi celami:

- Account managerowie potrzebują szybkich, gotowych raportów dla klienta, którym można zaufać, oraz eksportów na QBR.

- Liderzy wsparcia i właściciele usług potrzebują możliwości zagłębienia się, by zweryfikować obliczenia i znaleźć przyczyny.

- Interesariusze klienta chcą czytelnych metryk z jednoznacznymi definicjami oraz sposobu na audyt, które incydenty i zgłoszenia zostały uwzględnione.

Aplikacja powinna przedstawiać tę samą prawdę na różnych poziomach szczegółu, zależnie od roli.

Główne cele do osiągnięcia

Scentralizowany pulpit SLA powinien dostarczać:

- Jedno źródło prawdy dla metryk SLA, incydentów i dowodów.

- Szybsze raportowanie (minuty, nie dni) dzięki spójnym obliczeniom i szablonom do ponownego użycia.

- Mniej sporów przez pokazanie dokładnie, jak obliczono każdą metrykę i które zdarzenia do tego się przyczyniły.

W praktyce każda liczba SLA powinna być możliwa do prześledzenia do surowych zdarzeń (alerty, zgłoszenia, oś czasu incydentu) z czasystami i właścicielstwem.

Ustal granice: co tu liczymy jako „SLA”

Zanim cokolwiek zbudujesz, określ, co jest w zakresie, a co poza. Na przykład:

- Czy „dostępność” wyklucza planowaną konserwację?

- Czy awarie stron trzecich są liczone czy raportowane osobno?

- Jaki jest oficjalny zegar: czas lokalny klienta, UTC czy strefa kontraktu?

Jasne granice zapobiegają późniejszym sporom i utrzymują spójność raportowania między klientami.

Główne przepływy pracy, które aplikacja musi wspierać

Co najmniej scentralizowane raportowanie SLA powinno wspierać pięć przepływów:

- Podgląd wydajności SLA klienta za wybrany okres.

- Filtrowanie po kliencie, usłudze, regionie, kontrakcie lub ciężkości.

- Eksport (PDF/CSV) do udostępniania i archiwizacji.

- Harmonogram automatycznych raportów do interesariuszy.

- Audyt każdej metryki do zdarzeń i reguł, które za nią stoją.

Projektuj z myślą o tych przepływach od pierwszego dnia — reszta systemu (model danych, integracje i UX) pozostanie zgodna z realnymi potrzebami raportowania.

Zdefiniuj metryki SLA, reguły i okresy raportowania

Zanim zbudujesz ekrany lub pipeline’y, zdecyduj, co Twoja aplikacja będzie mierzyć i jak te liczby należy interpretować. Cel to spójność: dwie osoby czytające ten sam raport powinny dojść do tych samych wniosków.

Wybierz metryki SLA, które będziesz wspierać

Zacznij od małego zestawu, który większość klientów zna:

- Uptime / dostępność (np. 99,9% w miesiącu)

- Czas odpowiedzi (czas do pierwszej odpowiedzi człowieka lub pierwszej znaczącej aktualizacji)

- Czas rozwiązania (czas do rozwiązania i potwierdzenia)

Bądź precyzyjny, co każda metryka mierzy i czego nie mierzy. Krótki panel definicji w UI (i odwołanie do /help/sla-definitions) zapobiegnie nieporozumieniom.

Zapisz reguły obliczeń prostym językiem

Reguły to miejsce, gdzie raportowanie SLA zwykle zawodzą. Udokumentuj je zdaniami, które klient może zweryfikować, a potem przełóż na logikę.

Pokryj podstawy:

- Godziny pracy vs 24/7: Kalendarz dla każdej usługi/klienta?

- Święta: Którego regionu dotyczą i jak będą utrzymywane?

- Wykluczenia: planowana konserwacja, opóźnienia spowodowane klientem, oczekiwanie na klienta, awarie stron trzecich

- Zdarzenia start/stop: który timestamp zaczyna zegar; które zdarzenie go zatrzymuje

Zdecyduj okresy raportowania i progi naruszeń

Wybierz domyślne okresy (miesięczne i kwartalne są powszechne) i czy wspierasz zakresy niestandardowe. Wyjaśnij używaną strefę czasową dla odcięć.

Dla naruszeń zdefiniuj:

- Progi per usługa (np. cel uptime różni się w zależności od tieru)

- Nadpisania per klient (kontrakty niestandardowe)

- Czy naruszenia wyzwalają się na pojedynczych incydentach, wynikach agregowanych, czy obu

Udokumentuj źródła danych per metryka

Dla każdej metryki wymień potrzebne wejścia (zdarzenia monitoringu, rekordy incydentów, znaczniki czasu zgłoszeń, okna konserwacji). To stanie się planem dla integracji i kontroli jakości danych.

Zmapuj źródła danych i opcje integracji

Zanim zaprojektujesz dashboardy i KPI, ustal, gdzie faktycznie znajdują się dowody SLA. Większość zespołów odkrywa, że „dane SLA” są rozproszone po narzędziach, należą do różnych grup i mają nieco odmienne znaczenia.

Typowe systemy źródłowe do inwentaryzacji

Zacznij od prostej listy per klient (i per usługę):

- Monitoring/observability (ping checks, synthetic monitors, APM): sygnały uptime i znaczniki czasu

- Zarządzanie incydentami (odpowiedniki PagerDuty/Opsgenie): lifecycle incydentu, severity, acknowledgements

- Ticketing/helpdesk (Jira Service Management, Zendesk, ServiceNow): czasy odpowiedzi/rozwiązania, pola wpływu na klienta

- Status pages (publiczne lub wewnętrzne): deklarowane incydenty i zaplanowane okna konserwacji

- Logi dostawcy/chmury (opcjonalnie): health load balancerów, ślady audytu awarii

Dla każdego systemu zanotuj właściciela, okres retencji, limity API, rozdzielczość czasu (sekundy vs minuty) i czy dane są scoped per klient czy współdzielone.

Wybierz metody integracji (i mieszaj je)

Większość aplikacji do raportowania SLA używa kombinacji:

- API pulls do historycznych backfilli i nocnych rekonsyliacji

- Webhooks/strumienie zdarzeń dla niemal rzeczywistych aktualizacji i szybszego wykrywania naruszeń

- Importy CSV dla mniejszych klientów, narzędzi legacy lub migracji jednorazowych

Praktyczna zasada: używaj webhooków tam, gdzie liczy się świeżość, i API pulls tam, gdzie liczy się kompletność.

Różne narzędzia opisują to samo w różny sposób. Normalizuj do małego zestawu eventów, na których aplikacja będzie polegać, np.:

incident_opened / incident_closeddowntime_started / downtime_endedticket_created / first_response / resolved

Dołącz spójne pola: client_id, service_id, source_system, external_id, severity i znaczniki czasu.

Strefy czasowe i brakujące pokrycie

Przechowuj wszystkie znaczniki czasu w UTC, a przy wyświetlaniu konwertuj według preferowanej strefy klienta (szczególnie dla odcięć miesięcznych).

Planuj też luki: niektórzy klienci nie będą mieli status page, niektóre usługi nie są monitorowane 24/7, a niektóre narzędzia mogą tracić zdarzenia. Pokaż „częściowe pokrycie” w raportach (np. „dane monitoringu niedostępne przez 3 godziny”), żeby wyniki SLA nie wprowadzały w błąd.

Zaprojektuj architekturę multi-klientową i multi-tenant

Jeżeli Twoja aplikacja raportuje SLA dla wielu klientów, decyzje architektoniczne zadecydują, czy będziesz w stanie skalować bez wycieków danych między klientami.

Zdefiniuj, co oznacza „klient” w systemie

Zacznij od nazw warstw, które musisz wspierać. „Klient” może oznaczać:

- Tenant (firma/konto): główna granica klienta

- Sub-konta: działy lub marki pod jednym tenantem

- Środowiska: prod/stage/regiony

- Usługi: API, aplikacja webowa, baza danych, kolejka wsparcia

Zapisz to wcześnie — wpłynie to na uprawnienia, filtry i sposób przechowywania konfiguracji.

Wybierz model multi-tenancy

Większość aplikacji raportujących SLA wybiera jeden z modeli:

- Wspólna baza + tenant_id: jeden zestaw tabel, każdy wiersz oznaczony

tenant_id. To ekonomiczne i prostsze w obsłudze, ale wymaga surowej dyscypliny zapytań.

- Osobne bazy per tenant: silniejsza izolacja i łatwiejsze polityki retencji per tenant, lecz większe obciążenie operacyjne (migracje, monitoring, backupy) i trudniejsze widoki administracyjne przekrojowo.

Często kompromis to współdzielona DB dla większości tenantów i dedykowane DB dla klientów „enterprise”.

Egzekwuj ścisłą izolację danych wszędzie

Izolacja musi obowiązywać w:

- Zapytaniach i dashboardach: zawsze scope’uj po tenant, nie tylko polegaj na filtrze w UI

- Eksportach i harmonogramach maili: zadania eksportowe muszą działać w kontekście tenant

- Zadaniach tła: retry i kolejki muszą przenosić

tenant_id, żeby wyniki nie trafiły do niewłaściwego klienta

Używaj zabezpieczeń jak row-level security, obowiązkowe scope’y zapytań i zautomatyzowane testy granic tenantów.

Obsługuj konfiguracje SLA specyficzne dla klienta

Różni klienci będą mieli inne cele i definicje. Zaplanuj ustawienia per-tenant, takie jak:

- Cele SLA (np. 99,9% uptime, 1-godzinna odpowiedź)

- Uwzględnione usługi i endpointy

- Godziny pracy, święta i strefy czasowe

- Mapowanie severity i reguły wykluczeń (okna konserwacji)

Bezpieczne przełączanie klienta dla użytkowników wewnętrznych

Użytkownicy wewnętrzni często muszą „udawać” podgląd klienta. Zaimplementuj świadome przełączanie (nie wolno udostępniać go jako swobodny filtr), wyraźnie pokazuj aktywnego tenanta, loguj przełączenia do audytu i blokuj linki, które mogłyby ominąć sprawdzenia tenantów.

Zbuduj model danych dla surowych zdarzeń i wyników SLA

Aplikacja do scentralizowanego raportowania SLA opiera się na modelu danych. Jeśli modelujesz tylko „% SLA na miesiąc”, trudno będzie wyjaśnić wyniki, obsłużyć spory czy zmienić obliczenia. Jeśli modelujesz tylko surowe zdarzenia, raportowanie będzie wolne i kosztowne. Cel: wspierać oba podejścia — dowody surowe i szybkie rollupy gotowe dla klienta.

Podstawowe encje do wymodelowania

Oddziel czysto kogo raportujesz, co mierzysz i jak to liczone:

- Client: organizacja otrzymująca raporty.

- Service: system lub komponent (API, strona, kolejka wsparcia).

- SLA definition: reguły jak cel uptime, cel czasu odpowiedzi, godziny pracy, wykluczenia i metoda pomiaru.

- Incident / ticket: ręcznie śledzone rekordy z ITSM, które mogą wyjaśniać downtime lub opóźnienia w odpowiedzi.

- Measurement / event: zdarzenia maszynowe (checki monitoringu, zmiany statusu, sygnały z logów).

Przechowuj surowe zdarzenia i pochodne wyniki

Zaprojektuj tabele (lub kolekcje) dla:

- Surowych zdarzeń: niezmienne rekordy ze źródeł (alerty monitoringowe, incydenty ze status page, przejścia statusów ticketów). Zachowaj oryginalne ID i snapshot payloadu gdy to możliwe.

- Znormalizowanych faktów: Twoja ustandaryzowana reprezentacja (np. „service_down started_at/ended_at”).

- Wyników SLA: wyliczone wyniki w różnych ziarnistościach — per incydent, dziennie, tygodniowo, miesięcznie.

- Rollupów: preagregowane dzienne/miesięczne sumy, by pulpit działał szybko (np. minuty downtime, ważne minuty, minuty wyłączone).

Wersjonuj obliczenia

Logika SLA się zmienia: godziny pracy, wykluczenia, reguły zaokrągleń. Dodaj calculation_version (i najlepiej referencję do zestawu reguł) do każdego wyniku. Dzięki temu stare raporty da się odtworzyć dokładnie po zmianach.

Dodaj pola audytowe dla zaufania i rozwiązywania problemów

Dołącz pola audytowe tam, gdzie mają znaczenie:

- source_system, source_record_id, import_job_id

- znaczniki czasu jak ingested_at, normalized_at, calculated_at

- created_by/updated_by dla edycji użytkownika (z logiem zmian dla ręcznych nadpisów)

Dowody i załączniki

Klienci często pytają „pokaż dlaczego”. Zaplanuj schemat dowodów:

- odnośniki do postmortem, stron statusu lub wątków ticketów

- metadane załączników (nazwa, typ, klucz przechowywania)

- mapowanie dowodów do incydentów i konkretnych okresów SLA

Taka struktura utrzymuje aplikację wyjaśnialną, odtwarzalną i szybką — bez utraty dowodów.

Stwórz niezawodny pipeline danych i warstwę normalizacji

Uczyń SLA operacyjnymi

Dodaj powiadomienia o zbliżających się i potwierdzonych naruszeniach oraz o błędach pipeline bez dodatkowego boilerplate.

Jeśli wejścia są chaotyczne, pulpit SLA też będzie. Niezawodny pipeline zamienia dane incydentów i zgłoszeń z wielu narzędzi w spójne, audytowalne wyniki SLA — bez podwójnego zliczania, luk czy cichych błędów.

Podziel pipeline na jasne etapy

Traktuj ingest, normalizację i rollupy jako odrębne etapy. Uruchamiaj je jako zadania tła, aby UI pozostało szybkie i można było bezpiecznie retryować.

- Zadania ingestujące pobierają surowe zdarzenia (ticket, incydenty, zmiany statusów) i zapisują je bez zmian.

- Zadania normalizujące standaryzują pola i mapują do języka gotowego dla SLA.

- Zadania rollupu obliczają metryki dzienne/tygodniowe/miesięczne i cachują wyniki dla dashboardów i eksportów.

To rozdzielenie pomaga też, gdy źródło jednego klienta padnie: ingest może zawieść bez zepsucia istniejących obliczeń.

Uczyń retry bezpiecznym przez idempotencję

API zewnętrzne timeoutują. Webhooki mogą przyjść dwukrotnie. Pipeline musi być idempotentny: przetworzenie tego samego inputu wielokrotnie nie powinno zmieniać wyniku.

Typowe podejścia:

- Użyj source event ID (lub hasha kluczowych pól) jako klucza unikalnego.

- Trzymaj ledger przetwarzania (event_id + client + source + timestamp) do wykrywania duplikatów.

- Projektuj rollupy tak, żeby można je było przeliczyć dla okna czasowego (np. „przelicz ostatnie 14 dni”) zamiast polegać na ślepym inkrementowaniu liczników.

Normalizuj nazwy, by metryki znaczyły to samo

Wśród klientów i narzędzi „P1”, „Critical” i „Urgent” mogą znaczyć to samo — albo nie. Zbuduj warstwę normalizacji, która ujednolica:

- Nazwy usług (np. „Payments API” vs „Payments”)

- Priorytety / severity

- Statusy ticketów (np. “Resolved” vs “Done” vs “Closed”)

Przechowuj zarówno wartość oryginalną, jak i znormalizowaną dla śledzenia źródła.

Waliduj wejścia i kwarantannuj podejrzane rekordy

Dodaj reguły walidacji (brakujące timestampy, ujemne trwania, niemożliwe przejścia statusów). Nie usuwaj złych danych cicho — kieruj je do kolejki kwarantanny z powodem i workflow „napraw lub zmapuj”.

Pokaż wskaźnik świeżości danych

Dla każdego klienta i źródła oblicz „ostatnia udana synchronizacja”, „najstarsze nieprzetworzone zdarzenie” i „rollup aktualny do”. Wyświetl to jako prosty wskaźnik świeżości danych, aby klienci ufali liczbom, a zespół widział problemy wcześnie.

Uwierzytelnianie, role i kontrola dostępu

Jeśli klienci korzystają z portalu do przeglądu wyników SLA, uwierzytelnianie i uprawnienia muszą być zaprojektowane równie starannie jak logika SLA. Cel: każdy użytkownik widzi tylko to, co powinien — i możesz to później udowodnić.

Role zgodne z rzeczywistymi przepływami pracy

Zacznij od małego, jasnego zestawu ról i rozszerzaj tylko przy mocnych powodach:

- Admin: zarządza tenantami/klientami, integracjami, użytkownikami i globalnymi ustawieniami.

- Analityk wewnętrzny: przegląda dane wszystkich klientów, bada incydenty, tworzy raporty, ale nie zmienia ustawień bezpieczeństwa.

- Viewer klienta: dostęp tylko do odczytu do ich dashboardów i eksportów.

- Editor klienta: może zarządzać użytkownikami organizacji, preferencjami powiadomień i (opcjonalnie) szablonami raportów.

Zachowaj zasadę najmniejszych uprawnień: nowe konta powinny domyślnie być w roli viewer, chyba że zostaną wyraźnie podniesione.

SSO w pierwszej kolejności, hasła jako alternatywa

Dla zespołów wewnętrznych SSO zmniejsza bałagan kont i ryzyko przy odejściu pracownika. Wspieraj OIDC (Google Workspace/Azure AD/Okta) oraz tam, gdzie wymagane, SAML.

Dla klientów oferuj SSO jako opcję upgrade’a, ale pozwól też na email/hasło z MFA dla mniejszych organizacji.

Izolacja per-klient i uprawnienia na poziomie usługi

Egzekwuj granice tenantów na każdym poziomie:

- Każde zapytanie i eksport musi być scope’owany po client ID.

- Dodaj uprawnienia na poziomie projektu/usługi, jeśli klient ma wiele jednostek biznesowych.

- Ogranicz dostęp do wrażliwych artefaktów (surowe ticket’y, notatki, załączniki) osobno od podsumowań SLA.

Logi audytowe i bezpieczne onboardowanie

Loguj dostęp do wrażliwych stron i pobrań: kto, kiedy i skąd. To pomaga w zgodności i buduje zaufanie klienta.

Zbuduj przepływ onboardowania, gdzie admini lub editorzy klienta mogą zapraszać użytkowników, ustawiać role, wymagać weryfikacji e-mail i natychmiast cofać dostęp, gdy ktoś odchodzi.

UX dashboardu: filtry, drill-down i jasne definicje

Obniż koszty budowy

Obniż koszty budowy — zdobądź kredyty za tworzenie treści o Koder.ai lub polecanie zespołu i klientów.

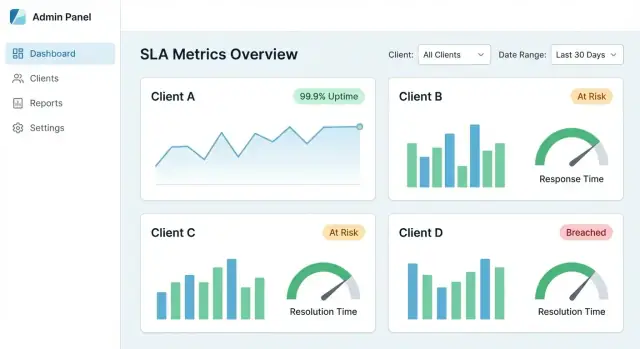

Scentralizowany pulpit SLA działa, gdy klient może odpowiedzieć na trzy pytania w mniej niż minutę: Spełniamy SLA? Co się zmieniło? Co spowodowało naruszenia? UX powinien prowadzić od widoku ogólnego do dowodów — bez wymuszania nauki wewnętrznego modelu danych.

„Główny widok”, który buduje zaufanie

Zacznij od niewielkiego zestawu kafelków i wykresów odpowiadających zwykłym rozmowom o SLA:

- Zgodność SLA (%) za wybrany okres (bieżący vs poprzedni)

- Linia trendu (dzienna/tygodniowa) pokazująca poprawę lub odchylenie

- Najważniejsze naruszenia uporządkowane według wpływu (minuty ponad SLO, kary, liczba użytkowników)

Spraw, by każdy kafelek był klikalny — drzwi do szczegółów, a nie martwy element.

Filtry, które działają przewidywalnie

Filtry powinny być spójne na wszystkich stronach i „przylegać” w nawigacji.

Zalecane domyślnie:

- Client → Service → Environment (prod/stage)

- Zakres dat z szybkimi wybierakami (Ostatnie 7/30/90 dni, Ten miesiąc)

- Severity / priorytet (przydatne przy mieszaniu incydentów i ticketów)

Pokaż aktywne filtry jako chipsy na górze, aby użytkownicy zawsze wiedzieli, co oglądają.

Drill-down z podsumowania do dowodów

Każda metryka powinna mieć drogę do „dlaczego”. Silny flow drill-down:

- Wykres zgodności → kliknij niski punkt

- Lista incydentów/zgłoszeń składających się na ten fragment

- Strona szczegółu pokazująca znaczniki czasu, zmiany statusów, odnośniki do oryginalnych rekordów i notatki

Jeśli liczba nie da się wyjaśnić dowodami, zostanie zakwestionowana — szczególnie podczas QBR.

Jasne definicje (bez dwuznaczności)

Dodaj tooltipy lub panel „info” dla każdego KPI: jak jest obliczany, wykluczenia, strefa czasowa i świeżość danych. Dołącz przykłady typu „Okna konserwacji wyłączone” lub „Dostępność mierzona przy bramie API”.

Udostępniane widoki ze stabilnymi linkami

Umożliwiaj udostępnianie przefiltrowanych widoków przez stabilne URL-e (np. /reports/sla?client=acme&service=api&range=30d). To zmienia pulpit SLA w portal gotowy dla klienta, wspierający cykliczne przeglądy i ścieżki audytu.

Zautomatyzowane raporty, eksporty i podsumowania dla klienta

Pulpit SLA jest przydatny na co dzień, ale klienci często chcą czegoś, co mogą dalej przekazać: PDF dla kierownictwa, CSV dla analityków i link do zapisanej perspektywy.

Wspieraj trzy wyjścia z tych samych wyników SLA:

- PDF: czyste, brandowane podsumowanie dla interesariuszy

- CSV: dane wierszowe (po usłudze, regionie lub umowie) do analizy

- Raporty jako linki na żywo: bezpieczny URL do tego samego widoku w portalu, zawsze aktualny

Dla raportów linkowanych wyraźnie pokaż filtry (zakres dat, usługa, severity), aby klient wiedział, co reprezentują liczby.

Harmonogramy wysyłki według klienta i częstotliwości

Dodaj harmonogram, żeby każdy klient mógł otrzymywać raporty automatycznie — tygodniowo, miesięcznie, kwartalnie — wysyłane na listę klienta lub wspólne skrzynki. Trzymaj harmonogramy scoped do tenanta i audytowalne (kto utworzył, ostatnie wysłanie, następny run).

Jeśli potrzebujesz prostego startu, wprowadź „miesięczne podsumowanie” i jedno kliknięcie do pobrania z /reports.

Szablony gotowe na QBR/MBR

Zbuduj szablony czytające się jak slajdy QBR/MBR w formie pisemnej:

- Najważniejsze (uptime, największe ulepszenia)

- Naruszenia (co się stało, czas trwania, wpływ)

- Notatki (zaplanowana konserwacja, follow-upy)

Adnotacje zgodności, wyjątki i zatwierdzenia

Rzeczywiste SLA zawierają wyjątki (okna konserwacji, awarie stron trzecich). Pozwól użytkownikom dołączać adnotacje zgodności i oznaczać wyjątki wymagające zatwierdzenia, z pełną ścieżką zatwierdzeń.

Izolacja tenantów i uprawnienia

Eksporty muszą respektować izolację tenantów i uprawnienia ról. Użytkownik powinien eksportować tylko te dane, które ma prawo widzieć — i eksport powinien dokładnie odpowiadać widokowi w portalu (bez dodatkowych kolumn wyciekających ukryte informacje).

Alerty i powiadomienia o naruszeniach SLA

Alerty zamieniają pulpit SLA z „interesującego dashboardu” w narzędzie operacyjne. Celem nie jest wysyłanie więcej wiadomości — tylko pomoc właściwym osobom reagować wcześnie, dokumentować, co się stało i informować klientów.

Wybierz typy alertów, które odpowiadają sposobowi, w jaki SLA zawodzą

Zacznij od trzech kategorii:

- Zbliżające się naruszenie: trend wskazuje, że cel zostanie nieosiągnięty (np. burn rate sugeruje spadek poniżej 99,9% do końca okresu lub budżet czasów odpowiedzi jest bliski wyczerpania).

- Potwierdzone naruszenie: SLA jest definitywnie nieosiągnięte za dany okres.

- Błąd pipeline danych: brak danych, opóźnione importy lub błędy integracji, które mogą unieważnić raportowanie.

Powiąż każdy alert z jasną definicją (metryka, okno czasowe, próg, zakres klienta), żeby odbiorcy mogli mu ufać.

Wybierz kanały — i działaj kontekstowo dla klienta

Oferuj różne kanały dostarczania, by zespoły mogły pracować tam, gdzie już działają:

- E-mail dla zarządu i zespołów obsługujących klienta

- Slack / MS Teams dla on-call i operacji

- Webhook do wyzwalania wewnętrznych systemów (PagerDuty, ServiceNow, własne narzędzia)

Dla raportów multi-klientowych kieruj powiadomienia według reguł tenantów (np. „Naruszenia Klienta A → Kanał A; wewnętrzne naruszenia → on-call”). Unikaj wysyłania szczegółów klienta do wspólnych kanałów.

Redukuj hałas: deduplikacja, quiet hours i eskalacja

Zmęczenie alertami zabije adopcję. Implementuj:

- Deduplikację (zbijaj powtarzające się wyzwalacze w jeden aktywny alert)

- Quiet hours (opóźniaj powiadomienia niekrytyczne poza godzinami pracy)

- Eskalację (jeśli brak ack w X minut, powiadom szerszą grupę)

Uczyń alerty akcyjnymi przez potwierdzenie i notatki

Każdy alert powinien wspierać:

- Potwierdzenie (kto jest właścicielem)

- Notatki o rozwiązaniu (co się stało, link do incydentu/ticketa, podsumowanie komunikacji do klienta)

To tworzy lekki ślad audytu, który można potem wykorzystać w raportach dla klienta.

Prosty edytor reguł per klient

Daj podstawowy edytor reguł do progów i routingu per klient (bez ujawniania złożonej logiki zapytań). Guardrail’e: domyślne ustawienia, walidacja i podgląd („ta reguła wywołałaby się 3 razy w zeszłym miesiącu”).

Podstawy wydajności, bezpieczeństwa i zgodności

Zdefiniuj SLA w trybie Planowania

Zarysuj tenantów, usługi, metryki i reguły zanim wygenerujesz kod.

Pulpit SLA szybko staje się krytyczny, bo klienci używają go do oceny jakości usług. To sprawia, że szybkość, bezpieczeństwo i dowód (dla audytów) są tak samo ważne jak wykresy.

Wydajność skalująca per tenant

Duzi klienci mogą generować miliony ticketów, incydentów i eventów. Aby strony były responsywne:

- Paginacja wszędzie (tabele, listy zdarzeń, drill-down). Unikaj ładowania wszystkich wyników domyślnie.

- Cache’uj typowe zapytania jak „ostatnie 30 dni uptime per usługa” lub „top breach reasons”. Cache czasowy (np. 5–15 minut) zachowa świeżość i obniży obciążenie DB.

- Preagreguj wyniki SLA dla ciężkich widoków (miesięczne podsumowania, uptime per service, liczba naruszeń). Obliczaj je harmonogramowo lub po ingest, żeby dashboardy nie przeliczały wszystkiego z surowych zdarzeń przy każdym zapytaniu.

Retencja danych i archiwizacja

Surowe zdarzenia są cenne do dochodzeń, ale trzymanie wszystkiego bez końca zwiększa koszty i ryzyko.

Ustal zasady:

- Przechowuj znormalizowane surowe zdarzenia krócej (np. 90–180 dni).

- Przechowuj wyniki SLA i podsumowania dłużej (np. 2–7 lat) dla trendów i kontraktów.

- Archwizuj stare surowe zdarzenia do tańszej pamięci (object storage lub cold tier) z udokumentowanym procesem odzyskiwania.

Podstawy bezpieczeństwa wymagane przez klientów

W portalu raportowym zakładaj wrażliwe treści: nazwy klientów, timestampy, notatki ticketów, czasem PII.

- Szyfruj dane w tranzycie (HTTPS/TLS) i w spoczynku (baza i backupy). Traktuj tokeny API i poświadczenia integracji jako sekrety, przechowywane w vault lub zarządzanym service secrets.

- Dodaj rate limiting i walidację wejścia na publicznych endpointach (logowanie, eksporty, API). Redukuje to nadużycia, przypadkowe przeciążenia i typowe ataki typu injection.

Zgodność i gotowość audytowa

Nawet jeśli nie idziesz natychmiast po certyfikację, solidne dowody operacyjne budują zaufanie.

Utrzymuj:

- Nieusuwalne logi audytu (logowania, eksporty, zmiany uprawnień, zmiany integracji).

- Backupy z testami restore (nie tylko „robimy kopie”). Harmonogram prób przywracania i zapis rezultatów.

- Podstawowe polityki dostępu do danych: kto może co zobaczyć, jak długo dane są przechowywane i jak obsługiwane są żądania usunięcia.

Plan uruchomienia, monitoring i roadmap iteracji

Wdrożenie aplikacji do raportowania SLA to bardziej podejście iteracyjne niż wielka premiera. Dobry plan startowy zmniejsza spory, czyniąc wyniki łatwymi do zweryfikowania i odtworzenia.

1) Zacznij od klienta pilota i waliduj dokładność

Wybierz jednego klienta z prostym zestawem usług i źródeł danych. Uruchom obliczenia swojego systemu równolegle z ich istniejącymi arkuszami, eksportami ticketów lub raportami dostawcy.

Skup się na typowych niezgodnościach:

- Granice stref czasowych i odcięcia okresów (koniec miesiąca)

- Co liczy się jako downtime vs degradacja

- Jak traktowane są okna konserwacji

Udokumentuj różnice i zdecyduj, czy aplikacja ma dopasować się do podejścia klienta, czy zastąpić je jasnym standardem.

2) Operacjonalizuj onboarding checklistą

Stwórz powtarzalną checklistę onboardingową, by każde wdrożenie klienta było przewidywalne:

- Dostęp do źródeł danych (klucze API, zakresy, allowlisty IP)

- Reguły mapowania (nazwy usług, kategorie ticketów, severity)

- Potwierdzenie definicji SLA (cele, wykluczenia, zaokrąglenia)

- Testowy przebieg + zatwierdzenie (okres przykładowy, znane incydenty)

- Przydział właściciela (kto może zatwierdzać zmiany)

Checklista pomaga też oszacować wysiłek i wspiera dyskusje o /pricing.

3) Dodaj monitoring dla zaufania i wsparcia

Dashboardy SLA są wiarygodne tylko wtedy, gdy są świeże i kompletne. Monitoruj:

- Porażki zadań harmonogramowych i retry

- Błędy limitów API i uwierzytelnień

- Stare dane (brak eventów przez X godzin)

- Niespodziewane spadki/wzrosty wolumenu incydentów

Wysyłaj najpierw powiadomienia wewnętrzne; gdy system jest stabilny, możesz udostępniać notatki statusowe klientom.

4) Iteruj w oparciu o jasność, nie tylko funkcje

Zbieraj feedback, gdzie powstają niejasności: definicje, spory („dlaczego to naruszenie?”) i „co się zmieniło” od ostatniego okresu. Priorytetyzuj małe usprawnienia UX jak tooltipy, logi zmian i wyraźne przypisy do wykluczeń.

5) Buduj szybciej z nowoczesnym workflow deweloperskim

Jeśli chcesz szybko wypuścić MVP (model tenantów, integracje, dashboardy, eksporty) bez tygodni na boilerplate, podejście vibe-coding może pomóc. Na przykład, Koder.ai pozwala zespołom szkicować i iterować aplikację multi-tenant przez chat — a potem eksportować kod i wdrażać. To praktyczne dla produktów SLA, gdzie główną złożonością są reguły domenowe i normalizacja danych, a nie jednorazowy scaffolding UI.

Możesz użyć trybu planowania w Koder.ai, aby opisać encje (tenants, services, SLA definitions, events, rollups), a potem wygenerować bazowy frontend w React i backend w Go/PostgreSQL, który rozbudujesz o konkretne integracje i logikę obliczeń.

6) Opublikuj krótką roadmapę

Prowadź żywy dokument z następnymi krokami: nowe integracje, formaty eksportów i ślady audytu. Linkuj do powiązanych poradników na /blog, aby klienci i współpracownicy mogli samodzielnie znaleźć szczegóły.