Cele, użytkownicy i definicje poziomów kont

Zanim zbudujesz dashboardy lub zinstrumentujesz zdarzenia, doprecyzuj, do czego ma służyć aplikacja, kto z niej korzysta i jak definiujesz poziomy kont. Większość projektów „śledzenia adopcji” kończy się niepowodzeniem, bo zaczynają od danych, a kończą na sporach.

Praktyczna zasada: jeśli dwa zespoły nie potrafią zdefiniować „adopcji” jednym zdaniem, później nie zaufają dashboardowi.

Kto będzie używać tej aplikacji?

Wymień główne grupy odbiorców i co każda musi zrobić dalej po przeczytaniu danych:

- Product: rozumieć, czy nowe funkcje są odkrywane, używane powtarzalnie i utrzymywane.

- Customer Success (CS): wykrywać luki w onboardingu, ryzyko adopcji i konta potrzebujące wsparcia.

- Sales / Account Management: identyfikować sygnały ekspansji (duże użycie, szerokie korzystanie z funkcji) i ryzyko odnowienia.

- Executives: śledzić ogólne zdrowie adopcji i czy inicjatywy strategiczne przynoszą efekt.

Przydatny test: każda grupa powinna odpowiedzieć „no i co?” w mniej niż minutę.

Zdefiniuj „adopcję” dla swojego produktu

Adopcja to nie jedna metryka. Spisz definicję, na której zespół się zgodzi — zwykle jako sekwencję:

- Aktywacja: pierwsze znaczące osiągnięcie (np. zaproszeni współpracownicy, utworzony pierwszy projekt, zakończona konfiguracja).

- Użycie funkcji: powtarzalne korzystanie z kluczowych funkcji korelujących z wartością (nie tylko kliknięcia dla pozoru).

- Retencja: użycie utrzymuje się tydzień po tygodniu/miesiąc po miesiącu.

Trzymaj to w kontekście wartości klienta: jakie akcje sygnalizują, że osiągają rezultaty, a nie tylko eksplorują.

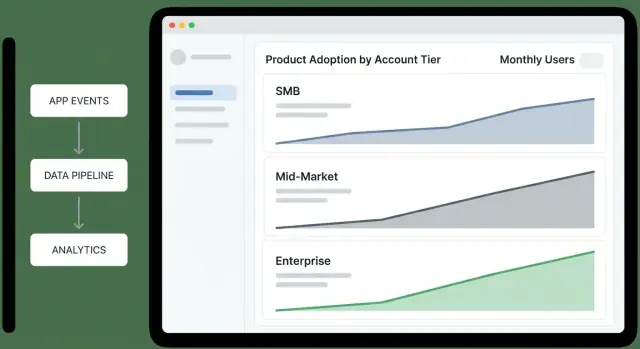

Poziomy kont i reguły przypisania

Wypisz swoje poziomy i spraw, by przypisanie było deterministyczne. Typowe poziomy to SMB / Mid-Market / Enterprise, Free / Trial / Paid lub Bronze / Silver / Gold.

Udokumentuj reguły prostym językiem (a później w kodzie):

- Które źródło prawdy decyduje o poziomie (system billingowy, CRM, wewnętrzna tabela)?

- Czy poziom opiera się na ARR, liczbie miejsc, planie, branży czy poziomie wsparcia?

- Co się dzieje, gdy dane się nie zgadzają (np. CRM mówi Enterprise, billing mówi Pro)?

- Kiedy zmiana poziomu zaczyna obowiązywać i czy potrzebujesz historii poziomów do raportowania?

Decyzje, które chcesz wspierać

Zapisz decyzje, które aplikacja musi umożliwić. Na przykład:

- Onboarding: kto nie aktywował się w ciągu 7 dni?

- Ryzyko: które konta o wysokiej wartości wykazują spadek użycia?

- Ekspansja: które konta osiągają limity lub przyjmują wiele zaawansowanych funkcji?

3–5 kluczowych pytań dashboardu

Użyj ich jako kryteriów akceptacji:

- Które poziomy poprawiają się lub pogarszają w adopcji w tym miesiącu?

- Dla każdego poziomu, jaki procent kont jest aktywowanych i jaki procent jest utrzymywany?

- Które funkcje najbardziej różnicują konta zdrowe od zagrożonych w podziale na poziomy?

- Które top konta w każdym poziomie potrzebują interwencji i dlaczego (lukę aktywacji, niska szerokość użycia, spadek częstotliwości)?

- Po wydaniu lub zmianie onboardingu, czy adopcja wzrosła dla docelowego poziomu?

Metryki adopcji sensowne według poziomu

Poziomy kont zachowują się różnie, więc pojedyncza metryka adopcji albo skrzywdzi małych klientów, albo ukryje ryzyko w większych. Zacznij od zdefiniowania sukcesu dla każdego poziomu, potem wybierz metryki oddające tę rzeczywistość.

1) Wybierz najważniejsze outcome’y (north-star) per poziom

Wybierz jedno główne outcome reprezentujące realną wartość:

- Starter/SMB: „Konta aktywowane” (szybkie dojście do pierwszej wartości).

- Mid-market: „Konta aktywne tygodniowo z użyciem kluczowych funkcji”.

- Enterprise: „Konta z adopcją wielozespołową” lub „konta realizujące kamienie rolloutu”.

Twój north-star powinien być policzalny, segmentowalny według poziomu i trudny do nadużycia.

2) Zdefiniuj etapy lejka z jasnymi kwalifikacjami

Zapisz lejek adopcji jako etapy z explicite regułami — tak, aby odpowiedź z dashboardu nie zależała od interpretacji.

Przykładowe etapy:

- Invited → Signed up: przynajmniej jeden użytkownik utworzony

- Activated: checklista konfiguracji ukończona i wykonana pierwsza kluczowa akcja

- Integrated: przynajmniej jedna kluczowa integracja podłączona

- Adopting: powtarzalne kluczowe akcje w wielu dniach/tygodniach

Różnice według poziomu mają znaczenie: „Activated” dla enterprise może wymagać akcji administratora i co najmniej jednej akcji użytkownika końcowego.

3) Wybierz wskaźniki wczesne vs. opóźnione

Używaj wskaźników wczesnych do wykrywania momentum:

- Ukończono konfigurację

- Podłączono kluczową integrację

- Opublikowano/podzielono pierwszy workflow

Używaj wskaźników opóźnionych do potwierdzenia trwałej adopcji:

- Retencja według poziomu (np. współczynnik aktywnych po 4 tygodniach)

- Głębokość użycia (akcje na aktywnego użytkownika, utworzone projekty, aktywne miejsca)

- Proksy odnowień (sygnały zdrowia kontraktu, zdarzenia ekspansji)

4) Ustal realistyczne cele per poziom

Cele powinny odzwierciedlać oczekiwany time-to-value i złożoność organizacyjną. Na przykład SMB może celować w aktywację w 7 dni; enterprise może celować w integrację w 30–60 dni.

Spisz cele, aby alerty i scorecardy były spójne między zespołami.

Model danych dla kont, użytkowników i historii poziomów

Jasny model danych zapobiega „tajemniczej matematyce” później. Chcesz móc odpowiadać prosto: kto co użył, w którym koncie, na jakim poziomie i w jakim czasie — bez zszywania ad-hoc logiki w każdym dashboardzie.

Podstawowe byty do modelowania

Zacznij od małego zestawu bytów odwzorowujących sposób, w jaki klienci kupują i używają produktu:

- Account: rekord klienta, któremu sprzedajesz (firma/organizacja). Przechowuj identyfikatory (

account_id), nazwę, status i pola lifecycle (created_at, churned_at).

- User: pojedyncza osoba. Dołącz

user_id, domenę email (pomocne do mapowania), created_at, last_seen_at.

- Workspace / Project (opcjonalnie): jeśli produkt ma wiele przestrzeni w ramach jednego konta, modeluj je jawnie z

workspace_id i kluczem obcym do account_id.

- Subscription: obiekt billingowy. Przechowuj plan, okres rozliczeniowy, liczbę miejsc, MRR i znaczniki czasu.

- Tier: znormalizowana tabela (np. Free, Team, Business, Enterprise), aby nazewnictwo było spójne.

Zdecyduj o ziarnie śledzenia

Bądź eksplicytny co do „granu” analitycznego:

- Zdarzenia na poziomie użytkownika odpowiadają: które persony przyjęły funkcję X?

- Agregaty na poziomie konta odpowiadają: czy ten klient jest zdrowy?

Praktyczny domyślny wybór to śledzić zdarzenia na poziomie użytkownika (z dołączonym account_id), a potem agregować do metryk kontowych. Unikaj zdarzeń tylko na poziomie konta, chyba że nie ma użytkownika (np. importy systemowe).

Modeluj czas: zdarzenia vs. snapshoty

Zdarzenia mówią, co się wydarzyło; snapshoty mówią, co było prawdą.

- Zachowaj tabelę zdarzeń jako źródło prawdy.

- Dodaj codzienne snapshoty kont (po jednym wierszu na konto na dzień) dla szybkich dashboardów: aktywni użytkownicy, liczniki kluczowych funkcji, wynik adopcji i poziom danego dnia.

Rejestr historii poziomów (tiers change)

Nie nadpisuj „aktualnego poziomu” i nie trać kontekstu. Stwórz tabelę account_tier_history:

account_id, tier_idvalid_from, valid_to (nullable dla aktualnego)source (billing, sales override)

Dzięki temu możesz liczyć adopcję gdy konto było Team, nawet jeśli później się zmieniło.

Dokumentuj definicje metryk

Zapisz definicje raz i traktuj je jako wymagania produktowe: co liczy się jako „aktywny użytkownik”, jak przypisujesz zdarzenia do kont i jak traktujesz zmiany poziomów w trakcie miesiąca. To zapobiega sytuacji, w której dwa dashboardy pokazują dwie różne prawdy.

Plan śledzenia zdarzeń i podstawy instrumentacji

Twoja analityka adopcji będzie tyle dobra, ile zdarzenia, które zbierasz. Zacznij od mapowania małego zestawu „krytycznych” akcji, które wskazują realny postęp dla każdego poziomu, a potem instrumentuj je spójnie na web, mobile i backendzie.

Krytyczne zdarzenia do śledzenia

Skup się na zdarzeniach, które reprezentują istotne kroki — nie każde kliknięcie. Praktyczny zestaw startowy:

signup_completed (konto utworzone)user_invited i invite_accepted (wzrost zespołu)first_value_received (Twoje „aha”; zdefiniuj to jasno)key_feature_used (powtarzalna akcja wartości; może być wiele eventów per funkcja)integration_connected (jeśli integracje zwiększają przyczepność)

Właściwości zdarzeń (takie, które można zapytać)

Każde zdarzenie powinno nieść kontekst umożliwiający krojenie po poziomie i roli:

account_id (wymagane)user_id (wymagane, gdy osoba jest zaangażowana)tier (zapisane w czasie zdarzenia)plan (billingowy plan/SKU jeśli istotne)role (np. owner/admin/member)- Opcjonalne, ale użyteczne:

workspace_id, feature_name, source (web/mobile/api), timestamp

Konwencje nazewnictwa, które możesz wymusić

Użyj przewidywalnego schematu, żeby dashboardy nie stały się słownikiem:

- Zdarzenia: małe litery

snake_case czasowniki, w czasie przeszłym (report_exported, dashboard_shared)

- Właściwości: spójne rzeczowniki (

account_id, nie acctId)

- Zdarzenia funkcji: albo dedykowane eventy (

invoice_sent), albo jedno zdarzenie z feature_name; wybierz podejście i trzymaj się go.

Tożsamość: cross-device i multi-workspace

Wspieraj zarówno anonimową jak i uwierzytelnioną aktywność:

- Przypisz

anonymous_id przy pierwszej wizycie, potem połącz z user_id przy logowaniu.

- W produktach z multi-workspace zawsze dołączaj

workspace_id i mapuj go do account_id po stronie serwera, aby uniknąć błędów klienta.

Zdarzenia po stronie serwera dla niezawodności

Instrumentuj akcje systemowe na backendzie, aby kluczowe metryki nie zależały od przeglądarek lub adblockerów. Przykłady: subscription_started, payment_failed, seat_limit_reached, audit_log_exported.

Te zdarzenia serwerowe są też idealnymi wyzwalaczami dla alertów i workflowów.

Ścieżka ingestii, przechowywania i agregacji

To etap, gdzie śledzenie staje się systemem: zdarzenia przychodzą z aplikacji, są oczyszczane, przechowywane bezpiecznie i przekształcane w metryki, które zespół naprawdę wykorzysta.

Wybierz ścieżkę ingestii pasującą do produktu

Większość zespołów korzysta z mieszanki:

- SDK (client/server): najlepsze dla spójnego, ustrukturyzowanego śledzenia zdarzeń produktowych.

- HTTP API: dobre dla usług backendowych, partnerów lub importu zdarzeń z innych systemów.

- Logi aplikacyjne: przydatne, jeśli masz bogate logi; wymaga parsowania i ścisłych schematów.

- Kolejka wiadomości (Kafka/SQS/PubSub): idealna przy dużej wolumenie lub gdy potrzebna jest odporność i replay.

Cokolwiek wybierzesz, traktuj ingest jako kontrakt: jeśli zdarzenie nie da się zinterpretować, powinno trafić do kwarantanny — nie być cicho akceptowane.

Normalizuj wcześnie: znaczniki czasu, ID i właściwości

W czasie ingestu standaryzuj kilka pól, które uczynią raportowanie wiarygodnym:

- Konwertuj wszystkie znaczniki czasu do UTC i przechowuj oryginalny timestamp źródłowy jeśli istotne.

- Mapuj identyfikatory do kanonicznych form:

account_id, user_id, oraz (jeśli potrzebne) workspace_id.

- Waliduj wymagane właściwości (np.

event_name, tier, plan, feature_key) i dodawaj domyślne wartości tylko gdy są jawne.

Przechowuj surowe zdarzenia oddzielnie od agregatów

Zdecyduj, gdzie trzymać surowe zdarzenia na podstawie kosztów i wzorców zapytań:

- Warehouse (Snowflake/BigQuery/Redshift): najprościej do analizy ad-hoc.

- Object storage (S3/GCS) + engine zapytań: najtańsze w skali, trochę więcej konfiguracji.

- Baza operacyjna: tylko przy mniejszych wolumenach; obserwuj wydajność.

Rollupy: zaplanowane zadania dopasowane do decyzji

Buduj agregacje dzienne/godzinne, które tworzą tabele takie jak:

- Aktywne konta dziennie według poziomu

- Liczby adopcji funkcji według poziomu

- Wejścia do scoringu adopcji na poziomie konta

Utrzymuj rollupy deterministyczne, żeby móc je ponownie uruchomić przy zmianach definicji poziomów lub backfillach.

Zasady retencji

Ustal jasne reguły retencji dla:

- Surowe zdarzenia: dłużej (np. 12–36 miesięcy) dla audytu i reprocessingu

- Agregaty: dłużej lub bezterminowo, bo są zwarte i napędzają dashboardy i alerty

Scoring adopcji i agregaty na poziomie poziomów

Przekształć metryki w workflowy

Ustaw alerty ryzyka i ekspansji uwzględniające poziomy, które CS i Sales mogą podjąć.

Wynik adopcji daje zajętym zespołom jedną liczbę do monitorowania, ale działa tylko wtedy, gdy jest prosty i wyjaśnialny. Celuj w wynik 0–100, który odzwierciedla znaczące zachowania (nie vanity) i można go rozłożyć na przyczyny zmiany.

Prosty, wytłumaczalny wynik 0–100

Zacznij od ważonej checklisty zachowań, z limitem do 100 punktów. Trzymaj wagi stabilne przez kwartał, aby trendy były porównywalne.

Przykładowe wagi (dostosuj do produktu):

- Aktywacja (40 pkt): ukończone kroki onboardingu, utworzony pierwszy projekt, zaproszony współpracownik.

- Core usage (40 pkt): użycie głównej funkcji w 3+ odrębnych dniach w ciągu ostatnich 14 dni.

- Ekspansja (20 pkt): przyjęcie jednej drugorzędnej funkcji (np. integracje, eksporty, zatwierdzenia).

Każde zachowanie powinno mapować się na jasną regułę zdarzeń (np. „użycie core” = core_action w 3 odrębnych dniach). Gdy wynik się zmienia, zapisuj czynniki składowe, aby móc powiedzieć: „+15 z powodu zaproszenia 2 użytkowników” lub „-10, bo core usage spadło poniżej 3 dni”.

Rollupy per konto i per poziom

Obliczaj wynik per konto (codzienny lub tygodniowy snapshot), potem agreguj po poziomach używając rozkładów, nie tylko średnich:

- Mediana wyniku per poziom

- 25./75. percentyl (opcjonalnie 10./90.)

- % kont powyżej progów (np. 60+ = „zdrowa adopcja”)

Trendy bez mylących porównań

Śledź zmianę tygodniową i 30-dniową per poziom, ale unikaj mieszania rozmiarów poziomów:

- Pokaż liczby (np. 38 kont poprawiło się) obok procentów (np. 12% poprawy).

To pozwala odczytać małe poziomy bez dominacji dużych poziomów w narracji.

Dashboardy: przegląd poziomów i podsumowanie dla zarządu

Dashboard przeglądu poziomów ma pozwolić execowi odpowiedzieć w mniej niż minutę: „Które poziomy się poprawiają, które pogarszają i dlaczego?”. Traktuj go jako ekran decyzyjny, nie scrapbook raportowy.

Co pokazywać (i jakie pytanie odpowiada każdy wykres)

Lejek poziomów (Awareness → Activation → Habit): „Na którym etapie konta utknęły według poziomu?” Utrzymuj kroki spójne z produktem (np. „Zaproszeni użytkownicy” → „Wykonano pierwszą kluczową akcję” → „Weekly active”).

Współczynnik aktywacji per poziom: „Czy nowe lub reaktywowane konta osiągają pierwszą wartość?” Pokaż wskaźnik wraz z mianownikiem (konta uprawnione), aby liderzy widzieli, czy sygnał to szum próbek.

Retencja per poziom (np. 7/28/90 dni): „Czy konta utrzymują użycie po pierwszym sukcesie?” Pokaż prostą linię per poziom; unikaj nadmiernego segmentowania na poziomie overview.

Głębokość użycia (breadth funkcji): „Czy przyjmują wiele obszarów produktu czy pozostają płytkie?” Stosowany wykres słupkowy per poziom działa dobrze: % używających 1 obszar, 2–3 obszary, 4+ obszary.

Porównania, które generują działania

Dodaj dwa porównania wszędzie:

- Ten tydzień vs poprzedni tydzień (albo ostatnie 7 vs poprzednie 7) dla szybkiego feedbacku.

- Poziom vs poziom by wykryć niespójności (np. SMB lepsze od Enterprise w aktywacji).

Używaj spójnych delt (punkty procentowe) żeby execy mogły szybko przeskanować.

Filtry, które nie łamią historii

Ogranicz filtry, spraw, by były globalne i utrwalone:

- Zakres czasu (presety + custom)

- Obszar produktu (dla kontekstu głębokości użycia)

- Region (dla efektów rolloutu/rynku)

- Właściciel konta (dla odpowiedzialności GTM)

Jeśli filtr zmieni definicje metryk, nie dawaj go tutaj — przenieś do widoków drill-down.

„Top drivers” per poziom

Dołącz mały panel dla każdego poziomu: „Co najbardziej wiąże się z wyższą adopcją w tym okresie?” Przykłady:

- Top 3 funkcje/zdarzenia skorelowane z wysokim wynikiem adopcji

- Największy krok odpływu w lejku

- Konta z największą zmianą tydzień do tygodnia (pozytywne i negatywne)

Utrzymuj to wytłumaczalne: wol preferuj stwierdzenia typu „Konta, które skonfigurowały X w pierwszych 3 dniach, mają o 18 pp lepszą retencję” zamiast nieprzezroczystych outputów modelu.

Przydatny układ

Umieść Karty KPI per poziom u góry (aktywacja, retencja, głębokość), jeden ekran wykresów trendów w środku i driverów + następnych działań na dole. Każdy widget powinien odpowiadać na jedno pytanie — jeśli nie, nie ma tu miejsca.

Widoki drill-down: od poziomu do pojedynczego konta

Dashboard poziomu pomaga priorytetyzować, ale prawdziwa praca zaczyna się, gdy możesz kliknąć i dowiedzieć się dlaczego poziom się zmienił i kto wymaga uwagi. Projektuj widoki drill-down jako ścieżkę: poziom → segment → konto → użytkownik.

Poziom → Segment: zawęż pytanie

Zacznij od tabeli przeglądu poziomu, potem pozwól użytkownikowi pokroić to na znaczące segmenty bez tworzenia raportu od zera. Typowe filtry:

- Status onboardingu (nie rozpoczęty / w toku / zakończony)

- Branża, plan, region, etap lifecycle

- „W zagrożeniu” vs „zdrowe” na podstawie wyniku adopcji

Każda strona segmentu powinna odpowiadać: „Które konta napędzają wynik tego poziomu w górę lub w dół?” Dołącz ranking kont z zmianą wyniku w czasie i top przyczynami.

Widok profilu konta: oś czasu, wynik, kamienie milowe

Profil konta powinien przypominać aktę sprawy:

- Oś czasu użycia (ostatnie 30/90 dni): kluczowe zdarzenia, dni aktywne, główne interakcje z funkcjami

- Wynik adopcji z prostym rozbiciem (np. aktywacja, szerokość, głębokość)

- Kamienie milowe: pierwsza kluczowa akcja, przyjęcie funkcji X, zaproszenie współpracowników, osiągnięcie progu Y

Trzymaj to czytelne: pokaż delty („+12 w tym tygodniu”) i oznacz skoki opisem zdarzenia, które je spowodowało.

Drill-down na użytkownika i widoki kohortowe

Z poziomu konta wypisz użytkowników według ostatniej aktywności i roli. Kliknięcie użytkownika pokaże ich użycie funkcji i ostatni kontekst logowania.

Dodaj widoki kohortowe, aby wyjaśniać wzory: miesiąc rejestracji, program onboardingu i poziom przy rejestracji. To pomaga CS porównywać „jak za jakimś” zamiast mieszać nowe konta z dojrzałymi.

Adopcja funkcji według poziomu + eksporty dla workflowów

Dołącz widok „Kto używa czego” per poziom: wskaźnik adopcji, częstotliwość i trendy funkcji, z listą kont używających (lub nie używających) każdej funkcji.

Dla CS i Sales dodaj opcje eksportu/udostępniania: eksport CSV, zapisane widoki i udostępnialne wewnętrzne linki (np. /accounts/{id}) otwierające się z zastosowanymi filtrami.

Alerty i akcjonowalne workflowy per poziom

Uruchom narzędzie wewnętrzne

Wdróż i hostuj wewnętrzną aplikację adopcji, z własnymi domenami gdy będziesz gotowy.

Dashboardy dobrze informują, ale zespoły działają, gdy są powiadomione we właściwym momencie. Alerty powinny być powiązane z poziomem konta, aby CS i Sales nie dostawały fal niskowartościowego szumu — albo, co gorsza, żeby przegapić krytyczne problemy w kontach o wysokiej wartości.

Zdefiniuj sygnały ryzyka specyficzne dla poziomu

Zacznij od kilku sygnałów „coś jest nie tak”:

- Spadek użycia: znaczący spadek tygodniowych aktywnych użytkowników, kluczowych zdarzeń lub sesji vs. baseline konta.

- Zawieszony onboarding: brak postępów poza etapem aktywacji (np. brak utworzonego projektu, brak integracji) w oczekiwanym oknie.

- Niska aktywacja: konto nie osiąga minimalnego progu „aha” po rejestracji lub zakupie.

Uczyń sygnały świadome poziomu. Na przykład Enterprise może alertować przy 15% spadku tygodniowym w kluczowym workflow, podczas gdy SMB może wymagać 40% spadku, aby uniknąć szumu z powodu nieregularnego użycia.

Zdefiniuj sygnały ekspansji per poziom

Alerty ekspansji powinny wyróżniać konta rosnące w wartość:

- Pojawiają się power userzy: wielu użytkowników powtarzalnie wykonuje wysokowartościowe workflowy.

- Szerokość funkcji: adopcja kilku kluczowych funkcji (nie tylko jednej).

- Wzrost: rosnąca liczba miejsc, wysyłane zaproszenia, stały wzrost aktywnych użytkowników.

Progi różnią się według poziomu: pojedynczy power user może mieć znaczenie dla SMB, podczas gdy Enterprise wymaga adopcji wielozespołowej.

Powiadomienia, które popychają do działania

Kieruj alerty tam, gdzie praca się wykonuje:

- Slack/email dla sygnałów w czasie rzeczywistym (np. zatrzymany onboarding dla topowego konta).

- Cotygodniowy digest dla niższego priorytetu (np. konta rosnące w szerokość funkcji).

Trzymaj payload akcyjny: nazwa konta, poziom, co się zmieniło, okno porównania i link do drill-down (np. /accounts/{account_id}).

Playbooki: co robić po wyzwoleniu alertu

Każdy alert potrzebuje właściciela i krótkiego playbooka: kto odpowiada, pierwsze 2–3 kontrole (świeżość danych, ostatnie wydania, zmiany admina) oraz rekomendowane działania kontaktowe lub wskazówki w aplikacji.

Udokumentuj playbooki obok definicji metryk, aby reakcje były spójne, a alerty — wiarygodne.

Jakość danych, monitoring i governance metryk

Jeśli metryki adopcji podejmują decyzje specyficzne dla poziomów (akcje CS, rozmowy o cenach, wybory roadmapowe), dane je zasilające muszą mieć zabezpieczenia. Mały zestaw kontroli i nawyków governance zapobiegnie „tajemniczym spadkom” na dashboardach i utrzyma interesariuszy w zgodzie co do znaczenia liczb.

Walidacja na brzegu

Waliduj zdarzenia jak najwcześniej (SDK klienta, bramka API lub worker ingest). Odrzucaj lub kładź do kwarantanny zdarzenia, których nie można zaufać.

Wdroż kontrole takie jak:

- Brak

account_id lub user_id (lub wartości, które nie istnieją w tabeli kont)

- Nieprawidłowe wartości

tier (poza zatwierdzonym enumem)

- Niemożliwe znaczniki czasu (przyszłe/przeszłe) i brak wymaganych właściwości dla kluczowych zdarzeń

Trzymaj tabelę kwarantanny, aby móc zbadać złe zdarzenia bez zanieczyszczania analityki.

Monitoruj wolumen i świeżość

Śledzenie adopcji jest czasoczułe; opóźnione zdarzenia zniekształcają tygodniowe aktywne i rollupy poziomów. Monitoruj:

- Wolumen zdarzeń według typu i poziomu (nagłe skoki/spadki)

- Świeżość i rozkłady opóźnień (np. p95 opóźnienia ingestu)

- Zdrowie pipeline'u (błędy zadań, backfille, zależności)

Kieruj monitory do kanału on-call, nie do wszystkich.

Duplikaty, retry i idempotencja

Retry się zdarzają (sieć mobilna, ponowne wysyłki webhooków, replay batchów). Spraw, aby ingest był idempotentny używając idempotency_key lub stabilnego event_id, i deduplikuj w oknie czasowym.

Twoje agregacje powinny być bezpieczne do ponownego uruchomienia bez podwójnego zliczania.

Governance metryk: jedno znaczenie, jeden właściciel

Stwórz glosariusz definiujący każdą metrykę (wejścia, filtry, okno czasu, reguły atrybucji poziomu) i traktuj go jako pojedyncze źródło prawdy. Linkuj dashboardy i dokumenty do tego glosariusza (np. /docs/metrics).

Dodaj logi audytu dla zmian definicji metryk i reguł scoringu — kto, kiedy i dlaczego zmienił — aby przesunięcia trendów dało się szybko wyjaśnić.

Prywatność, bezpieczeństwo i kontrola dostępu

Wydłuż budżet budowy

Oszczędź budżet, dzieląc się zbudowanymi rzeczami lub polecając zespół do Koder.ai.

Analityka adopcji jest użyteczna tylko wtedy, gdy jej się ufa. Najbezpieczniej jest projektować śledzenie tak, aby odpowiadało na pytania o adopcję, jednocześnie zbierając jak najmniej wrażliwych danych, i traktować „kto co widzi” jako priorytet.

Minimalizuj dane osobowe (by design)

Zacznij od identyfikatorów wystarczających do insightów: account_id, user_id (lub pseudonim), znacznik czasu, funkcja i mały zestaw właściwości behawioralnych (plan, poziom, platforma). Unikaj przechwytywania imion, adresów email, pól tekstowych lub czegokolwiek, co może zawierać sekrety.

Jeśli potrzebujesz analizy na poziomie użytkownika, trzymaj identyfikatory użytkowników oddzielnie od PII i łącz tylko gdy jest to konieczne. Traktuj IP i identyfikatory urządzeń jako wrażliwe; jeśli nie są potrzebne do scoringu, nie przechowuj ich.

Role, uprawnienia i bezpieczne ustawienia domyślne

Zdefiniuj jasne role dostępu:

- Exec/Leadership: agregaty kontowe i poziomowe tylko

- CS/Sales: szczegóły konta; ograniczone widoki użytkowników jeśli potrzebne

- Product/Analytics: głębsze eksploracje na poziomie użytkownika z logami audytu

- Admin: konfiguracja, retencja i kontrola usuwania

Domyślnie pokazuj widoki agregowane. Drill-down do poziomu użytkownika niech będzie wyraźnym uprawnieniem, a pola wrażliwe (email, pełne imiona, zewnętrzne id) ukryte, jeśli rola tego nie wymaga.

Retencja, usuwanie i zgoda

Wspieraj żądania usunięcia przez możliwość usunięcia historii zdarzeń użytkownika (lub jej anonimizacji) i usuwania danych konta po zakończeniu kontraktu.

Zaimplementuj reguły retencji (np. surowe zdarzenia przez N dni, agregaty dłużej) i udokumentuj je w polityce. Rejestruj zgodę i obowiązki przetwarzania tam, gdzie to stosowne.

Wybory architektoniczne i praktyczny plan budowy

Najszybsza droga do wartości to wybór architektury pasującej do miejsca, w którym już żyją Twoje dane. Można ją potem rozwijać — ważne, by szybko dostarczyć wiarygodne, poziomowe insighty interesariuszom.

Dwa popularne podejścia budowy

Warehouse-first analytics: zdarzenia płyną do warehouse (np. BigQuery/Snowflake/Postgres), potem obliczasz metryki adopcji i podajesz je do lekkiej aplikacji webowej. Idealne, jeśli już używasz SQL, masz analityków lub chcesz jeden źródło prawdy współdzielone z innymi raportami.

App-first analytics: aplikacja zapisuje zdarzenia do swojej bazy i oblicza metryki wewnątrz aplikacji. Szybsze na start dla małego produktu, ale łatwo przerosnąć je przy wzroście wolumenu i potrzebie historycznego reprocessingu.

Praktyczny domyśl dla większości SaaS to warehouse-first z małą bazą operacyjną na konfigurację (poziomy, definicje metryk, reguły alertów).

Podstawowe komponenty (trzymaj to proste)

- Web UI: przegląd poziomów + widoki drill-down.

- API: serwujące preagregowane metryki, listy kont i filtry.

- Warehouse / DB analityczny: surowe zdarzenia + modelowane tabele dla dziennych metryk adopcji.

- Job runner: zaplanowane transformacje (codziennie/godzinowo), backfille i scoring.

Kupować czy budować — decyzje oszczędzające tygodnie

- Wykresy: zacznij od sprawdzonej biblioteki wykresów (lub osadź narzędzie BI) zamiast budować od zera.

- Auth: użyj sprawdzonego providera (SSO, role), aby uniknąć problemów z bezpieczeństwem.

- Zbieranie zdarzeń: użyj SDK lub zaufanej bramki; buduj custom collector tylko gdy masz bardzo specyficzne wymagania.

Plan MVP (2–4 tygodnie)

Wypuść pierwszą wersję z:

-

3–5 metryk (np. aktywne konta, użycie kluczowych funkcji, wynik adopcji, tygodniowa retencja, time-to-first-value).

-

Jedną stroną przeglądu poziomów: wynik adopcji per poziom + trend w czasie.

-

Jednym widokiem konta: aktualny poziom, ostatnia aktywność, top używane funkcje i proste „dlaczego wynik jest taki, jaki jest.”

Plan iteracji bez utraty zaufania

Dodaj mechanizmy feedbacku wcześnie: pozwól Sales/CS oznaczać „to wygląda źle” bezpośrednio z dashboardu. Wersjonuj definicje metryk, żeby móc zmieniać formuły bez cichego przepisywania historii.

Wdrażaj stopniowo (jeden zespół → cała organizacja) i trzymaj changelog zmian metryk w aplikacji (np. /docs/metrics), aby interesariusze wiedzieli, co oglądają.

Gdzie pasuje Koder.ai (szybkie prototypowanie bez lock-in)

Jeśli chcesz przejść od specyfikacji do działającego wewnętrznego narzędzia szybko, podejście vibe-coding może pomóc — szczególnie na etapie MVP, gdzie walidujesz definicje, a nie doskonalisz infrastrukturę.

Z Koder.ai zespoły mogą prototypować aplikację adopcji przez interfejs czatu, generując jednocześnie realny, edytowalny kod. To dobre dopasowanie, bo zakres jest przekrojowy (UI w React, warstwa API, model Postgres i zaplanowane rollupy) i szybko ewoluuje, gdy interesariusze dochodzą do porozumienia.

Typowy workflow:

- Użyj Planning Mode, aby zamapować model poziomów, schemat zdarzeń i pytania dashboardowe na plan implementacji.

- Wygeneruj React dashboard plus backend w Go z PostgreSQL dla tabel konfiguracyjnych (poziomy, definicje metryk, reguły alertów).

- Eksportuj kod źródłowy, gdy będziesz gotowy przekazać go inżynierii, i korzystaj z snapshotów/rollbacków, aby bezpiecznie iterować przy zmianach definicji metryk.

Ponieważ Koder.ai wspiera wdrożenie/hosting, własne domeny i eksport kodu, może to być praktyczny sposób na szybkie zdobycie wiarygodnego MVP wewnętrznego przy jednoczesnym zachowaniu elastyczności architektury na przyszłość.