Co wyjaśnia ta historia (i dlaczego ma to znaczenie)

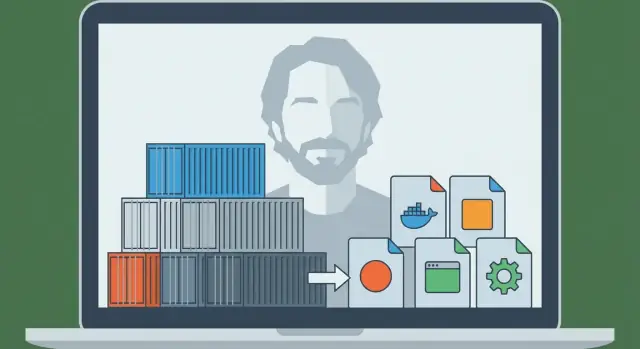

Solomon Hykes to inżynier, który pomógł przekształcić długo istniejący pomysł — izolowanie oprogramowania tak, by działało tak samo wszędzie — w narzędzie, którego zespoły mogły używać na co dzień. W 2013 roku projekt, który przedstawił światu, stał się Dockerem i szybko zmienił sposób, w jaki firmy wypuszczają aplikacje.

Wtedy problem był prosty i znajomy: aplikacja działała na laptopie dewelopera, potem inaczej na maszynie kolegi, a potem psuła się w stagingu lub produkcji. Te „niespójne środowiska” nie były tylko irytujące — spowalniały wydania, utrudniały odtwarzanie błędów i generowały niekończące się przekazy między zespołem deweloperskim a operacjami.

Problem, który rozwiązał Docker (prostym językiem)

Docker dał zespołom powtarzalny sposób na zapakowanie aplikacji razem z zależnościami, których oczekuje — tak by aplikacja mogła działać tak samo na laptopie, serwerze testowym czy w chmurze.

Dlatego mówi się, że kontenery stały się „domyślną jednostką pakowania i wdrażania”. Mówiąc prosto:

- Jednostka pakowania: rzecz, którą budujesz i przechowujesz (obraz kontenera)

- Jednostka wdrożeniowa: rzecz, którą uruchamiasz w środowisku (kontener)

Zamiast wdrażać „ZIP i stronę wiki z krokami konfiguracji”, wiele zespołów wdraża obraz, który już zawiera to, czego aplikacja potrzebuje. Efekt to mniej niespodzianek i szybsze, bardziej przewidywalne wydania.

Co zyskasz dzięki tej historii

Ten artykuł łączy historię z praktycznymi koncepcjami. Dowiesz się, kim w tym kontekście jest Solomon Hykes, co Docker wprowadził w odpowiednim momencie i jakie są podstawowe mechaniki — bez zakładania głębokiej wiedzy infrastrukturalnej.

Zobaczysz też, gdzie kontenery pasują dziś: jak łączą się z CI/CD i praktykami DevOps, dlaczego narzędzia orkiestracyjne jak Kubernetes stały się ważne później oraz czego kontenery nie naprawiają automatycznie (szczególnie w kwestii bezpieczeństwa i zaufania).

Na koniec będziesz w stanie jasno i pewnie wyjaśnić, dlaczego „wysyłaj to jako kontener” stało się domyślnym założeniem dla nowoczesnego wdrażania aplikacji.

Przed Dockerem: dlaczego wysyłanie aplikacji było takie trudne

Zanim kontenery stały się powszechne, przeniesienie aplikacji z laptopa dewelopera na serwer było często bardziej bolesne niż samo napisanie aplikacji. Zespołom nie brakowało talentu — brakowało niezawodnego sposobu na przenoszenie „rzeczy, która działa” między środowiskami.

"U mnie działa" było realnym problemem

Deweloper mógł uruchomić aplikację idealnie na swoim komputerze, a potem oglądać, jak zawodzi w stagingu lub produkcji. Nie dlatego, że kod się zmienił, ale dlatego, że środowisko się zmieniło. Różne wersje systemu operacyjnego, brakujące biblioteki, nieznacznie inne pliki konfiguracyjne czy baza danych z innymi domyślnymi ustawieniami mogły zepsuć ten sam build.

Konflikty zależności i długie instrukcje setupu

Wiele projektów polegało na długich, kruchych instrukcjach instalacji:

- zainstaluj ten runtime języka

- skompiluj ten pakiet systemowy

- przypnij konkretną wersję biblioteki

- ustaw zmienne środowiskowe w odpowiednim miejscu

Nawet dobrze napisane przewodniki szybko się starzały. Jeden kolega aktualizujący zależność mógł przypadkowo zepsuć onboarding dla wszystkich innych.

Gorzej: dwie aplikacje na tym samym serwerze mogły wymagać niekompatybilnych wersji tego samego runtime’u lub biblioteki, zmuszając zespoły do niezręcznych obejść lub oddzielnych maszyn.

Pakowanie i wdrażanie były oddzielne — i się nie dopasowywały

„Pakowanie” często oznaczało produkcję ZIP-a, tarballa lub instalatora. „Wdrożenie” to inny zestaw skryptów i kroków serwerowych: przygotuj maszynę, skonfiguruj ją, skopiuj pliki, zrestartuj usługi i miej nadzieję, że nic innego na serwerze nie zostanie naruszone.

Te dwie troski rzadko się ze sobą zgadzały. Pakiet nie opisywał w pełni wymaganego środowiska, a proces wdrożenia silnie zależał od tego, że serwer docelowy jest przygotowany „dokładnie tak”.

Brakujący element: przenośna jednostka

Zespoły potrzebowały jednej, przenośnej jednostki, która zabierałaby ze sobą zależności i działała konsekwentnie na laptopach, serwerach testowych i produkcji. To napięcie — powtarzalna konfiguracja, mniej konfliktów i przewidywalne wdrożenia — przygotowało grunt pod to, by kontenery stały się domyślnym sposobem dostarczania aplikacji.

Solomon Hykes i narodziny Dockera (zarys wydarzeń)

Docker nie zaczął się jako wielki plan „zmienić oprogramowanie na zawsze”. Wyrosło to z praktycznej pracy inżynieryjnej prowadzonej przez Solomona Hykesa przy budowie produktu platform-as-a-service. Zespół potrzebował powtarzalnego sposobu pakowania i uruchamiania aplikacji na różnych maszynach bez typowych niespodzianek „u mnie działa”.

Zanim Docker stał się nazwą powszechną, potrzeba była prosta: wysyłaj aplikację z zależnościami, uruchamiaj ją niezawodnie i rób to wielokrotnie dla wielu klientów.

Projekt, który stał się Dockerem, wyłonił się jako wewnętrzne rozwiązanie — coś, co uczyniło wdrożenia przewidywalnymi i środowiska spójnymi. Gdy zespół zdał sobie sprawę, że mechanizm pakowania i uruchamiania ma szerokie zastosowanie poza ich produktem, opublikował go publicznie.

To wydanie miało znaczenie, bo przemieniło prywatną technikę wdrożeniową w narzędzie i łańcuch narzędzi, które cała branża mogła przyjąć, udoskonalać i wokół którego standaryzować.

„Docker” vs. „kontenery”: to nie to samo

Łatwo je zlać w jedno, ale to różne rzeczy:

- Kontenery to koncepcja: izolowane procesy wykorzystujące funkcje systemu operacyjnego (np. namespaces i cgroups na Linuksie) do uruchamiania aplikacji z ich zależnościami.

- Docker (projekt, a później firma) to spakowane doświadczenie, które uczyniło kontenery przystępnymi dla codziennych deweloperów.

Kontenery istniały w różnych formach przed Dockerem. Zmiana polegała na tym, że Docker zapakował workflow w przyjazny dla dewelopera zestaw poleceń i konwencji — zbuduj obraz, uruchom kontener, udostępnij go innym.

Kamienie milowe, które zmieniły codzienną pracę deweloperów

Kilka dobrze znanych kroków przesunęło Dockera z „interesującego” do „domyślnego”:

- Prosty format budowy (Dockerfile) sprawił, że pakowanie aplikacji zaczęło przypominać pisanie przepisu zamiast utrzymywania kruchych instrukcji.\n- Standardowy artefakt (obraz) pozwolił traktować środowiska jako wersjonowane dostawy.\n- Łatwe udostępnianie przez rejestry umożliwiło workflow „pull i run” na laptopach, w CI i w produkcji.\n- Ekosystem i wysiłki standaryzacyjne sprawiły, że obrazy kontenerów i środowiska uruchomieniowe stały się mniej zależne od jednego dostawcy i bardziej jak wspólny interfejs branżowy.

Praktyczny rezultat: deweloperzy przestali debatować, jak replikować środowiska, i zaczęli wysyłać tę samą uruchamialną jednostkę wszędzie.

Kontenery 101: czym są (a czym nie są)

Kontenery to sposób pakowania i uruchamiania aplikacji, tak by zachowywała się tak samo na twoim laptopie, na maszynie współpracownika i w produkcji. Kluczowa idea to izolacja bez pełnej, nowej maszyny.

Kontenery vs maszyny wirtualne (prosty model)

Maszyna wirtualna (VM) jest jak wynajęcie całego mieszkania: masz własne drzwi, własne media i własną kopię systemu operacyjnego. Dlatego VM-y mogą uruchamiać różne typy systemów obok siebie, ale są cięższe i zwykle wolniej się uruchamiają.

Kontener to jak wynajęcie zamkniętego pokoju w dzielonym budynku: przynosisz swój sprzęt (kod aplikacji + biblioteki), ale media budynku (jądro systemu operacyjnego hosta) są współdzielone. Nadal masz separację od innych pokoi, ale nie uruchamiasz całego systemu operacyjnego za każdym razem.

Jak kontenery izolują aplikacje (w ujęciu ogólnym)

Na Linuksie kontenery korzystają z wbudowanych funkcji izolacji, które:

- dają procesom „własny” widok systemu (aby aplikacja A nie widziała plików i procesów aplikacji B)

- ograniczają i rozliczają zasoby jak CPU i pamięć (żeby jedna głośna aplikacja nie zagłodziła innych)

Nie musisz znać szczegółów jądra, żeby używać kontenerów, ale warto wiedzieć, że korzystają z funkcji OS — to nie magia.

Dlaczego ludzie je polubili

Kontenery zyskały popularność, ponieważ są:

- Lekkie: mniejsze niż obrazy VM, bo nie pakują całego systemu operacyjnego

- Szybkie w uruchamianiu: często sekundy (lub mniej), co jest świetne dla skalowania i testów

- Spójne: to samo zapakowane środowisko zmniejsza problemy „u mnie działa”

Czym kontenery nie są

Kontenery domyślnie nie są granicą bezpieczeństwa. Ponieważ kontenery współdzielą jądro hosta, luka na poziomie jądra może potencjalnie wpłynąć na wiele kontenerów. Oznacza to też, że nie można uruchomić kontenera Windows na jądrze Linuksa (i odwrotnie) bez dodatkowej wirtualizacji.

Podsumowując: kontenery poprawiają pakowanie i spójność — ale nadal potrzebujesz rozsądnych praktyk bezpieczeństwa, łatania i konfiguracji.

Model Dockera: Dockerfile, obraz, kontener

Docker osiągnął sukces częściowo dlatego, że dał zespołom prosty model mentalny z jasnymi „częściami”: Dockerfile (instrukcje), image (zbudowany artefakt) i container (uruchomiona instancja). Gdy zrozumiesz ten łańcuch, reszta ekosystemu Dockera zaczyna mieć sens.

Dockerfile: powtarzalny przepis

Dockerfile to plik tekstowy, który opisuje jak zbudować środowisko aplikacji krok po kroku. Pomyśl o nim jak o przepisie kulinarnym: sam przepis nikogo nie nakarmi, ale mówi dokładnie, jak przygotować tę samą potrawę za każdym razem.

Typowe kroki Dockerfile to: wybór bazy (np. runtime języka), skopiowanie kodu aplikacji, instalacja zależności i zadeklarowanie polecenia startowego.

Obraz a kontener: plan a uruchomiona aplikacja

Image to rezultat zbudowania Dockerfile. To zapakowany snapshot wszystkiego, co potrzebne do uruchomienia: twój kod, zależności i domyślne ustawienia. To nie jest „żywe” — to jak zapieczętowane pudełko, które można wysyłać.

Container to to, co dostajesz, gdy uruchamiasz obraz. To aktywny proces z własnym, odizolowanym systemem plików i ustawieniami. Możesz go startować, zatrzymywać, restartować i tworzyć wiele kontenerów z tego samego obrazu.

Warstwy i cache: dlaczego budowy mogą być szybkie

Obrazy są budowane w warstwach. Każda instrukcja w Dockerfile zwykle tworzy nową warstwę, a Docker stara się ponownie użyć („cache”) warstw, które się nie zmieniły.

Prosto mówiąc: jeśli zmieniasz tylko kod aplikacji, Docker może często ponownie użyć warstw, które instalowały pakiety systemowe i zależności, co przyspiesza przebudowy. To także zachęca do współdzielenia — wiele obrazów używa wspólnych warstw bazowych.

Krótki przepływ end-to-end

Oto jak wygląda przepływ „przepis → artefakt → uruchomiona instancja":

FROM node:20-alpine

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

CMD ["node", "server.js"]

- Dockerfile: powyższe instrukcje

- Zbuduj image:

docker build -t myapp:1.0 .

- Uruchom container:

docker run --rm -p 3000:3000 myapp:1.0

To jest podstawowa obietnica, którą Docker spopularyzował: jeśli potrafisz zbudować obraz, możesz uruchomić to samo niezawodnie — na laptopie, w CI czy na serwerze — bez przepisywania kroków instalacyjnych za każdym razem.

Z laptopa do zespołu: rejestry i udostępnianie obrazów

Od specyfikacji do Fluttera

Zaprojektuj prototyp mobilny we Flutterze na podstawie prostego specyfikacji i wyeksportuj kod źródłowy.

Uruchamianie kontenera na własnym laptopie jest użyteczne — ale to nie jest przełom. Prawdziwa zmiana nastąpiła, gdy zespoły mogły udostępniać dokładnie ten sam build i uruchamiać go wszędzie, bez wymówek „u mnie działa”.

Docker uczynił udostępnianie tak samo naturalnym jak dzielenie się kodem.

Czym jest rejestr (prostym językiem)

Rejestr kontenerów to magazyn obrazów kontenerów. Jeśli obraz jest zapakowaną aplikacją, rejestr to miejsce, gdzie przechowujesz wersje, aby inni mogli je pobrać.

Rejestry wspierają prosty workflow:

- Push: wgraj zbudowany obraz

- Pull: pobierz obraz zbudowany przez kogoś innego

- Wersjonuj: przechowuj wiele nazwanych wydań, by móc iść do przodu lub się cofnąć

Rejestry publiczne (np. Docker Hub) ułatwiły start. Jednak większość zespołów szybko potrzebowała rejestru dopasowanego do polityk dostępu i wymagań zgodności.

Tagi: mały nawyk, który zapobiega dużym problemom

Obrazy zwykle identyfikuje się jako name:tag — np. myapp:1.4.2. Tag to więcej niż etykietka: to sposób, w jaki ludzie i automaty zgadzają się, który build uruchomić.

Częsty błąd to poleganie na latest. Brzmi wygodnie, ale jest niejednoznaczny: „latest” może się zmienić bez ostrzeżenia i spowodować, że środowiska będą się różnić. Jedno wdrożenie może pobrać nowszy build niż poprzednie — nawet jeśli nikt nie planował aktualizacji.

Lepsze praktyki:

- Używaj jawnych tagów wersji (np.

1.4.2) dla wydań

- Rozważ też tagowanie commit SHA dla śledzenia

- Traktuj tagi jako część procesu wydawniczego, nie jako dodatek

Dlaczego prywatne rejestry mają znaczenie dla realnych zespołów

Gdy zaczynasz udostępniać usługi wewnętrzne, płatne zależności lub kod firmy, zwykle chcesz prywatnego rejestru. Pozwala on kontrolować, kto może pobierać i wysyłać obrazy, integrować się z SSO i trzymać własne oprogramowanie poza indeksami publicznymi.

To jest skok „z laptopa do zespołu”: gdy obrazy trafiają do rejestru, twój system CI, współpracownicy i serwery produkcyjne mogą pobierać ten sam artefakt — a wdrożenie staje się powtarzalne, a nie improwizowane.

Dlaczego kontenery pasują do CI/CD

CI/CD działa najlepiej, gdy traktuje aplikację jako jedną, powtarzalną „rzecz”, która przesuwa się przez etapy. Kontenery dają dokładnie to: jeden zapakowany artefakt (obraz), który można zbudować raz i uruchomić wiele razy, z znacznie mniejszą liczbą niespodzianek.

Ujednolicone środowisko lokalnego developmentu

Przed kontenerami zespoły często próbowały dopasować środowiska za pomocą długich instrukcji instalacji i wspólnych skryptów. Docker zmienił domyślny workflow: sklonuj repo, zbuduj obraz, uruchom aplikację. Te same polecenia zwykle działają na macOS, Windows i Linuxie, bo aplikacja działa wewnątrz kontenera.

Ta standaryzacja przyspiesza onboarding. Nowi członkowie zespołu spędzają mniej czasu na instalowaniu zależności, a więcej na rozumieniu produktu.

"Zbuduj raz, uruchom wszędzie" w praktyce

Silne ustawienie CI/CD dąży do jednego wyniku pipeline’u. W przypadku kontenerów wynikiem jest obraz otagowany wersją (często powiązaną z SHA commita). Ten sam obraz jest promowany z dev → test → staging → produkcja.

Zamiast przebudowywać aplikację inaczej dla każdego środowiska, zmieniasz konfigurację (np. zmienne środowiskowe), zachowując artefakt identycznym. To redukuje dryf środowisk i ułatwia debugowanie wydań.

Naturalne dopasowanie do pipeline’ów CI

Kontenery ładnie odwzorowują kroki pipeline’u:

- Build: stwórz obraz z Dockerfile

- Test: uruchom testy jednostkowe/integracyjne wewnątrz kontenera

- Scan: sprawdź obraz pod kątem znanych podatności i niebezpiecznych pakietów

- Deploy: wypchnij do rejestru, potem pobierz i uruchom w kolejnym środowisku

Ponieważ każdy etap działa na tym samym zapakowanym artefakcie, błędy są bardziej znaczące: testy, które przeszły w CI, mają większe szanse zachować się tak samo po wdrożeniu.

Jeśli usprawniasz proces, warto też ustawić proste reguły (konwencje tagowania, podpisywanie obrazów, podstawowe skanowanie), żeby pipeline był przewidywalny. Możesz rozbudować to wraz ze wzrostem zespołu.

Gdzie to łączy się z nowoczesnymi workflowami przyspieszonego tworzenia kodu: platformy takie jak Koder.ai mogą generować i iterować pełne aplikacje (React na frontend, Go + PostgreSQL na backend, Flutter na mobilne) przez interfejs czatu — ale nadal potrzebujesz niezawodnej jednostki pakowania, by przejść od „działa” do „wdrożone”. Traktowanie każdego builda jako wersjonowanego obrazu kontenera utrzymuje nawet rozwój wspierany przez AI zgodny z oczekiwaniami CI/CD: powtarzalne buildy, przewidywalne wdrożenia i wydania gotowe do rollbacku.

Uruchamianie na dużą skalę: dlaczego pojawił się Kubernetes

Zaplanuj przepływ dostaw z wyprzedzeniem

Użyj trybu Planowania, aby nakreślić usługi, środowiska i wydania zanim wygenerujesz kod.

Docker uczynił praktycznym pakowanie aplikacji raz i uruchamianie jej wszędzie. Kolejne wyzwanie pojawiło się szybko: zespoły nie uruchamiały jednego kontenera na jednym laptopie — uruchamiały dziesiątki (potem setki) kontenerów na wielu maszynach, a wersje zmieniały się stale.

W tym momencie „uruchomienie kontenera” przestaje być trudne. Trudność staje się zarządzanie flotą: decydowanie, gdzie każdy kontener powinien działać, utrzymywanie odpowiedniej liczby kopii online i automatyczne odzyskiwanie po awariach.

Dlaczego pojawiły się orkiestratory

Gdy masz wiele kontenerów na wielu serwerach, potrzebujesz systemu, który je skoordynuje. To robią orkiestratory: traktują infrastrukturę jako pulę zasobów i stale dążą do utrzymania pożądanego stanu aplikacji.

Kubernetes stał się najczęstszą odpowiedzią na tę potrzebę (choć nie jedyną). Dostarcza wspólny zestaw koncepcji i API, na które ustandaryzowały się wiele zespołów i platform.

Docker vs. orkiestracja: różne zadania

Warto oddzielić odpowiedzialności:

- Docker (i podobne narzędzia) skupia się na budowaniu obrazów i uruchamianiu kontenerów na pojedynczej maszynie.

- Kubernetes skupia się na uruchamianiu kontenerów w skali: na wielu maszynach, w strefach dostępności, podczas aktualizacji typu rolling.

Kluczowe funkcje, które wprowadził Kubernetes

Kubernetes wprowadził (i spopularyzował) kilka praktycznych możliwości potrzebnych, gdy kontenery wyszły poza pojedynczy host:

- Harmonogram: umieszczanie kontenerów na odpowiednich maszynach na podstawie CPU/pamięci i ograniczeń.\n- Skalowanie: zwiększanie lub zmniejszanie liczby kopii zgodnie z popytem.\n- Odkrywanie usług i load balancing: dawanie kontenerom stabilnych sposobów odnajdywania się nawzajem mimo zmieniających się IP i instancji.\n- Samonaprawianie: restartowanie zawieszonych kontenerów, zastępowanie niezdrowych instancji i przeszeregowanie pracy, gdy maszyna padnie.

Krótko: Docker uczynił jednostkę przenośną; Kubernetes pomógł uczynić ją operacyjną — przewidywalnie i ciągle — gdy jednostek jest wiele w ruchu.

Jak kontenery zmieniły architekturę aplikacji

Kontenery nie tylko zmieniły sposób wdrażania oprogramowania — skłoniły zespoły do projektowania oprogramowania w inny sposób.

„Mikrousługi łatwiejsze do wypuszczenia” (bez zakazu monolitów)

Przed kontenerami rozbijanie aplikacji na wiele małych usług często oznaczało pomnożenie bólu operacyjnego: różne runtime’y, konflikty zależności i skomplikowane skrypty wdrożeniowe. Kontenery zredukowały to tarcie. Jeśli każda usługa wysyła się jako obraz i działa tak samo, stworzenie nowej usługi wydaje się mniej ryzykowne.

Jednak kontenery sprawdzają się też świetnie w przypadku monolitów. Monolit w kontenerze może być prostszy niż niedokończona migracja do mikrousług: jedna jednostka wdrożeniowa, jeden zestaw logów, jedna dźwignia skalowania. Kontenery nie narzucają stylu — ułatwiają zarządzanie różnymi stylami.

Standardowe interfejsy stały się normą

Platformy kontenerowe skłaniały aplikacje do zachowywania się jak dobrze zdefiniowane „czarne skrzynki” z przewidywalnymi wejściami i wyjściami. Typowe konwencje obejmują:

- Porty: aplikacja nasłuchuje na znanym porcie, a platforma kieruje ruch.\n- Zmienne środowiskowe: konfiguracja jest wstrzykiwana w czasie działania, nie wgrywana na stałe do kodu.\n- Volume'y: dane trwałe montuje się jako wolumeny, dzięki czemu kontener jest łatwiejszy do zamiany.

Te interfejsy ułatwiły podmianę wersji, cofanie i uruchamianie tej samej aplikacji na laptopach, w CI i w produkcji.

Nowe wzorce (i nowe pokusy)

Kontenery spopularyzowały powtarzalne bloki, takie jak sidecary (pomocniczy kontener obok głównej aplikacji do logowania, proxy czy certyfikatów). Umocniły też wytyczną „jeden proces na kontener” — nie jest to twarda zasada, ale dobry domyślny wybór dla przejrzystości, skalowania i debugowania.

Główna pułapka to nadmierne dzielenie. Tylko dlatego, że możesz rozbić wszystko na usługi, nie znaczy, że powinieneś. Jeśli „mikrousługa” dodaje więcej koordynacji, opóźnień i obciążenia wdrożeniowego niż usuwa, trzymaj to razem dopóki nie pojawią się wyraźne granice — np. różne potrzeby skalowania, odpowiedzialność czy izolacja awarii.

Bezpieczeństwo i zaufanie: czego kontenery nie rozwiązują automatycznie

Kontenery ułatwiają wysyłkę oprogramowania, ale nie czynią go automatycznie bezpiecznym. Kontener to wciąż kod plus zależności i może być źle skonfigurowany, przestarzały lub wręcz złośliwy — szczególnie gdy obrazy pobiera się z internetu bez dokładnej kontroli.

Zaufanie zaczyna się od pochodzenia obrazu

Jeśli nie potrafisz odpowiedzieć na pytanie „Skąd pochodzi ten obraz?”, już podejmujesz ryzyko. Zespoły często przechodzą do jasnego łańcucha opieki: buduj obrazy w kontrolowanym CI, podpisuj lub poświadczaj to, co zostało zbudowane, i zapisuj, co weszło w skład obrazu (zależności, wersja obrazu bazowego, kroki budowy).

Tu pomagają też SBOMy (Software Bill of Materials): sprawiają, że zawartość kontenera jest widoczna i audytowalna.

Skanowanie to kolejny praktyczny krok. Regularnie skanuj obrazy pod kątem znanych podatności, ale traktuj wyniki jako dane do decyzji — nie jako gwarancję bezpieczeństwa.

Zasada najmniejszych uprawnień i sekrety: częste pułapki

Częsty błąd to uruchamianie kontenerów z nadmiernymi uprawnieniami — jako root domyślnie, z dodatkowymi capability, z siecią hosta lub w trybie privileged „bo działa”. Każde z tych ustawień zwiększa zasięg szkody w razie problemów.

Sekrety to kolejna pułapka. Zmienne środowiskowe, wbudowane pliki konfiguracyjne czy skomitowane .env mogą przeciekać poświadczenia. Wol preferować skarbce sekretów lub mechanizmy orkiestratora i rotować je tak, jakby wyciek był nieunikniony.

Ryzyka w czasie działania, które się pomija

Nawet „czyste” obrazy mogą być niebezpieczne w czasie działania. Zwracaj uwagę na odsłonięte gniazda Dockera, zbyt luźne mounty wolumenów i kontenery, które mają dostęp do wewnętrznych usług, których nie potrzebują.

Pamiętaj też: łatanie hosta i jądra dalej ma znaczenie — kontenery współdzielą jądro.

Myśl w czterech fazach:

- Build: kontrolowane buildy, SBOMy, skanowanie, minimalizowanie obrazów bazowych

- Store: prywatne rejestry, kontrola dostępu, polityki niemutowalności

- Run: najmniejsze uprawnienia, limity sieciowe, limity zasobów, brak rozprzestrzeniania sekretów

- Monitor: logi, alerty, wykrywanie anomalii, szybkie przebudowy i redeploye

Kontenery redukują tarcie — ale zaufanie nadal trzeba zdobyć, weryfikować i utrzymywać nieustannie.

Typowe błędy i jak ich unikać

Wystartuj na własnej domenie

Podłącz własną domenę, gdy będziesz gotów udostępnić aplikację poza testami lokalnymi.

Docker sprawia, że pakowanie jest przewidywalne, ale tylko jeśli używasz go z dyscypliną. Wiele zespołów wpada na te same dziury — a potem obwinia „kontenery” za problemy, które są naprawdę problemami workflowu.

Antywzorce, które spowalniają wszystkich

Klasyczny błąd to budowanie olbrzymich obrazów: używanie pełnych obrazów OS, instalowanie narzędzi buildujących, których nie potrzebujesz w runtime, oraz kopiowanie całego repo (wraz z testami, dokumentacją i node_modules). Efekt to wolne pobieranie, wolne CI i większa powierzchnia ataku.

Inny częsty problem to wolne buildy niszczące cache. Jeśli kopiujesz całe drzewo źródłowe przed instalacją zależności, każda drobna zmiana kodu wymusza pełną reinstalację zależności.

Wreszcie zespoły często używają niejasnych lub pływających tagów jak latest lub prod. To utrudnia rollback i zamienia wdrożenia w zgadywankę.

„Działa lokalnie, ale nie w prod”: prawdziwe przyczyny

Zwykle sprowadza się to do różnic w konfiguracji (brakujące zmienne środowiskowe lub sekrety), sieci (różne hosty, porty, proxy, DNS) lub przechowywaniu (dane zapisywane w systemie plików kontenera zamiast w wolumenie, albo różne uprawnienia plików).

Praktyczne poprawki, które możesz zastosować dziś

Używaj odchudzonych obrazów bazowych, gdy to możliwe (lub distroless, jeśli zespół jest gotowy). Przypinaj wersje obrazów bazowych i kluczowych zależności, żeby buildy były powtarzalne.

Przyjmij multi-stage builds, by trzymać kompilatory i narzędzia buildowe poza finalnym obrazem:

FROM node:20 AS build

WORKDIR /app

COPY package*.json ./

RUN npm ci

COPY . .

RUN npm run build

FROM node:20-slim

WORKDIR /app

COPY --from=build /app/dist ./dist

CMD ["node","dist/server.js"]

Otaguj obrazy czymś śledzonym, jak git SHA (i opcjonalnie przyjazny dla ludzi tag wydania).

Kiedy nie konteneryzować

Jeśli aplikacja jest naprawdę prosta (pojedynczy binarny plik statyczny, uruchamiany rzadko, bez potrzeb skalowania), kontenery mogą dodać narzut. Systemy legacy mocno związane z konkretnym OS lub specjalistycznymi sterownikami sprzętowymi też mogą gorzej pasować — czasem VM lub managed service jest czystszym wyborem.

Co dziś znaczy „domyślna jednostka” — i co robić dalej

Kontenery stały się domyślną jednostką, ponieważ rozwiązały bardzo konkretne, powtarzalne cierpienie: sprawienie, by ta sama aplikacja działała tak samo na laptopach, serwerach testowych i produkcji. Zapakowanie aplikacji i jej zależności razem przyspieszyło wdrożenia, uczyniło rollbacki bezpieczniejszymi i zmniejszyło kruche przekazy między zespołami.

Równie ważne, kontenery ustandaryzowały workflow: zbuduj raz, wyślij, uruchom.

Co oznacza „domyślne” w praktyce

„Domyślne” nie oznacza, że wszystko wszędzie działa w Dockerze. Oznacza, że większość nowoczesnych pipeline’ów traktuje obraz kontenera jako główny artefakt — bardziej niż ZIP, snapshot VM czy zestaw ręcznych kroków instalacyjnych.

To domyślne zwykle obejmuje trzy współpracujące elementy:

- Obrazy: niemutowalne wyniki buildów otagowane wersjami (i najlepiej SHA commitów).\n- Rejestry: wspólne miejsce do przechowywania i pobierania obrazów (prywatne lub publiczne), umożliwiające używanie tego samego artefaktu w różnych środowiskach.\n- Orkiestracja: scheduler (często Kubernetes), który uruchamia kontenery niezawodnie, zastępuje awaryjne instancje i skaluje.

Kroki, które możesz podjąć w tym tygodniu

Zacznij od małych rzeczy i skup się na powtarzalności.

- Poznaj podstawy Dockerfile: utrzymuj obrazy minimalne, przypinaj wersje baz, strukturyzuj warstwy, by rebuildy były szybkie. Dodaj

.dockerignore wcześnie.\n2. Używaj rejestru świadomie: publikuj obrazy z sensownymi tagami (np. 1.4.2, main, sha-…) i określ, kto może pushować a kto pullować.\n3. Przyjmij reguły buildów w CI: buduj obrazy w CI, uruchamiaj testy w kontekście kontenera i promuj ten sam obraz przez staging do produkcji (bez przebudowy w każdym środowisku).

Jeśli eksperymentujesz z szybszymi sposobami budowania oprogramowania (w tym podejściami wspieranymi przez AI), zachowaj tę samą dyscyplinę: wersjonuj obraz, przechowuj go w rejestrze i sprawiaj, by wdrożenia promowały ten pojedynczy artefakt naprzód. To jeden z powodów, dla których zespoły korzystające z Koder.ai nadal czerpią korzyści z dostarczania zorientowanego na kontenery — szybkie iteracje są świetne, ale powtarzalność i możliwość rollbacku to to, co czyni to bezpiecznym.

Zachowaj wyważone spojrzenie

Kontenery redukują problemy „u mnie działa”, ale nie zastępują dobrych praktyk operacyjnych. Nadal potrzebujesz monitoringu, reagowania na incydenty, zarządzania sekretami, łatania, kontroli dostępu i jasnego przydziału odpowiedzialności.

Traktuj kontenery jako potężny standard pakowania — nie jako skrót od dyscypliny inżynieryjnej.