Czym są środowiska uruchomieniowe JavaScript i dlaczego mają znaczenie

JavaScript to język. Środowisko uruchomieniowe JavaScript to otoczenie, które sprawia, że język jest użyteczny poza przeglądarką: osadza silnik JavaScript (np. V8) i dostarcza systemowe funkcje potrzebne w prawdziwych aplikacjach — dostęp do plików, sieć, timery, zarządzanie procesami oraz API do kryptografii, strumieni i innych.

Jeśli silnik jest „mózgiem”, który rozumie JavaScript, to runtime jest całym „ciałem”, które potrafi rozmawiać z systemem operacyjnym i internetem.

Gdzie pojawiają się runtime’y

Nowoczesne runtime’y to nie tylko serwery webowe. Napędzają one:

- Serwery i API (tradycyjne backendy)

- Narzędzia CLI (formatery, toolchainy, skrypty automatyzacji)

- Funkcje edge (kod uruchamiany blisko użytkowników, często z ostrzejszymi limitami)

- Aplikacje desktopowe (często przez frameworki, które pakują runtime)

Ten sam język może działać we wszystkich tych miejscach, ale każde środowisko ma inne ograniczenia — czas uruchomienia, limity pamięci, granice bezpieczeństwa i dostępne API.

Dlaczego istnieje wiele runtime’ów (i dlaczego ciągle się zmieniają)

Runtime’y ewoluują, bo deweloperzy oczekują różnych kompromisów. Jedne stawiają na maksymalną zgodność z ekosystemem Node.js. Inne dążą do bezpieczniejszych domyślnych ustawień, lepszej ergonomii TypeScript lub szybszego cold startu dla narzędzi.

Nawet jeśli dwa runtime’y korzystają z tego samego silnika, mogą znacznie się różnić w:

- Wbudowanych API i wsparciu standardów

- Podejściu do zarządzania pakietami

- Modelu uprawnień i sandboxingu

- Doświadczeniu narzędziowym (testowanie, formatowanie, bundling)

Co oznacza „konkurencja” w praktyce

Konkurencja to nie tylko prędkość. Runtime’y rywalizują o adopcję (społeczność i świadomość), zgodność (ile istniejącego kodu „po prostu działa”) i zaufanie (postawa bezpieczeństwa, stabilność, długoterminowe wsparcie). Te czynniki decydują, czy runtime stanie się wyborem domyślnym, czy narzędziem niszowym używanym tylko w określonych projektach.

Krótkie wprowadzenie do popularnych runtime’ów

Kiedy mówimy „środowisko uruchomieniowe JavaScript”, mamy na myśli „otoczenie wykonujące JS poza (lub wewnątrz) przeglądarki oraz API, których używasz do budowy rzeczy”. Wybór runtime’a kształtuje sposób czytania plików, uruchamiania serwerów, instalowania pakietów, zarządzania uprawnieniami i debugowania produkcji.

Przykłady, o których usłyszysz

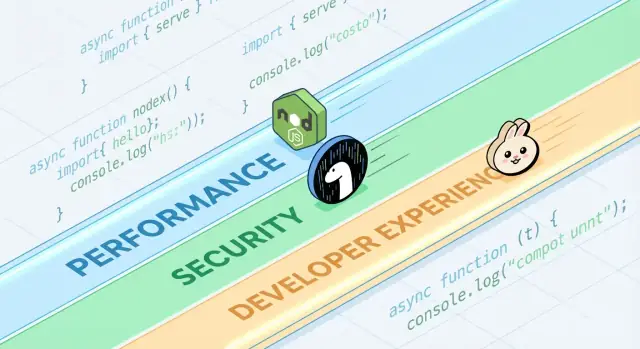

Node.js to długoletni domyślny wybór dla JavaScript po stronie serwera. Ma najszerszy ekosystem, dojrzałe narzędzia i ogromny impet społeczności.

Deno zaprojektowano z nowoczesnymi domyślnymi ustawieniami: natywne wsparcie TypeScript, domyślnie silniejszy model bezpieczeństwa oraz bardziej „baterie w zestawie” podejście do standardowej biblioteki.

Bun koncentruje się na prędkości i wygodzie dewelopera, łącząc szybki runtime z zintegrowanym toolchainem (instalacja pakietów, testy), by zmniejszyć nakład konfiguracji.

Runtime’y przeglądarkowe (Chrome, Firefox, Safari) nadal są najpowszechniejszymi środowiskami JS. Są zoptymalizowane pod interfejsy użytkownika i udostępniają Web API jak DOM, fetch czy storage — ale nie dają bezpośredniego dostępu do systemu plików tak jak runtime’y serwerowe.

Co jest wspólne między runtime’ami

Większość runtime’ów łączy silnik JavaScript (często V8) z pętlą zdarzeń i zestawem API do sieci, timerów, strumieni i innych. Silnik wykonuje kod; pętla koordynuje pracę asynchroniczną; API to to, czego używasz na co dzień.

Co się różni (i dlaczego to ma znaczenie na co dzień)

Różnice pojawiają się w wbudowanych funkcjach (np. obsługa TypeScript), domyślnych narzędziach (formatter, linter, runner testów), zgodności z API Node’a i modelach bezpieczeństwa (np. czy dostęp do plików/sieci jest nieograniczony czy zależny od uprawnień). Wybór runtime’a wpływa na to, jak szybko zaczniesz projekt, jak bezpiecznie uruchomisz skrypty i jak bolesne będzie wdrożenie oraz debugowanie.

Wydajność: metryki, o które rywalizują runtime’y

„Szybko” to nie jedna liczba. Runtime’y JavaScript mogą błyszczeć na jednym wykresie i wypadać przeciętnie na innym, bo optymalizują różne definicje szybkości.

Opóźnienie vs przepustowość

Opóźnienie to czas zakończenia pojedynczego żądania; przepustowość to liczba żądań na sekundę, które możesz obsłużyć. Runtime zoptymalizowany pod szybki start i niskie opóźnienia może poświęcić maksymalną przepustowość przy wysokiej współbieżności, i na odwrót.

Na przykład API zwracające profile użytkowników będzie dbać o ogony opóźnień (p95/p99). Zadanie wsadowe przetwarzające tysiące zdarzeń na sekundę będzie zwracać uwagę na przepustowość i efektywność w stanie ustalonym.

Cold start (serverless i CLI)

Cold start to czas od „nic nie działa” do „gotowy do pracy”. Ma ogromne znaczenie dla funkcji serverless, które skalują do zera, oraz dla narzędzi CLI uruchamianych często.

Na cold start wpływa ładowanie modułów, ewentualna transpilacja TypeScript, inicjalizacja wbudowanych API oraz ilość pracy, którą runtime wykonuje zanim wykona twój kod. Runtime może być bardzo szybki gdy jest „rozgrzany”, a mimo to sprawiać wrażenie wolnego, jeśli jego rozruch trwa długo.

Wydajność I/O: sieć, system plików, strumienie

Większość serwerowego JavaScriptu jest ograniczona przez I/O: żądania HTTP, wywołania do bazy danych, czytanie plików, streaming danych. Tu wydajność zależy od efektywności pętli zdarzeń, jakości powiązań asynchronicznych I/O, implementacji strumieni i obsługi backpressure.

Małe różnice — jak szybko runtime parsuje nagłówki, planuje timery czy flushuje zapisy — mogą przynieść realne korzyści w serwerach webowych i proxy.

Praca obciążająca CPU: moc i ograniczenia silnika

Zadania obciążające CPU (parsowanie, kompresja, obróbka obrazów, kryptografia, analityka) obciążają silnik JavaScript i kompilator JIT. Silniki mogą optymalizować gorące ścieżki kodu, ale JavaScript ma swoje ograniczenia przy długotrwałych, numerycznych obliczeniach.

Gdy dominuje praca CPU-bound, „najszybszy runtime” to często ten, który najprościej pozwala przenieść gorące pętle do kodu natywnego lub użyć workerów bez nadmiernej złożoności.

Rzeczywistość benchmarków (i typowe pułapki)

Benchmarki mogą być przydatne, ale łatwo je źle zinterpretować — szczególnie gdy traktuje się je jak uniwersalne rankingi. Runtime, który „wygrywa” wykres, może wciąż być wolniejszy dla twojego API, pipeline’u budowania czy zadania przetwarzania danych.

Mikrobenchmarks vs rzeczywiste aplikacje

Mikrobenchmarks zwykle mierzą drobną operację (parsowanie JSON, regex, hashing) w ciasnej pętli. To pomocne do oceny pojedynczego składnika, nie całego dania.

Rzeczywiste aplikacje spędzają czas na rzeczach, które mikrobenchmarki ignorują: oczekiwania sieciowe, wywołania do baz danych, I/O plików, narzut frameworka, logowanie i presja pamięci. Jeśli twój workload jest głównie I/O-bound, o 20% szybsza pętla CPU może wcale nie przesunąć twojego end-to-end latency.

Wyniki zmieniają się z obciążeniem, OS i wersjami

Drobne różnice środowiska mogą odwrócić wyniki:

- Kształt obciążenia: wiele małych żądań kontra kilka dużych; streaming kontra buforowanie.

- OS i sprzęt: Linux kontra macOS; różne CPU; limity w kontenerach.

- Wersje runtime i zależności: aktualizacje silnika, różnice w libc i zmiany w bibliotekach mogą przeważyć.

Gdy widzisz zrzut benchmarku, zapytaj, jakie wersje i flagi użyto — i czy pokrywają się z twoim środowiskiem produkcyjnym.

Warm-up (JIT) i efekty cache

Silniki JavaScript używają JIT: kod może działać wolniej na początku, a potem przyspieszyć, gdy silnik „nauczy się” gorących ścieżek. Jeśli benchmark mierzy tylko pierwsze sekundy, może nagradzać złe zachowania.

Cache też ma znaczenie: cache dysku, DNS, keep-alive HTTP i cache aplikacyjne mogą sprawić, że kolejne uruchomienia wyglądają znacznie lepiej. To może być realistyczne, ale trzeba to kontrolować.

Projektowanie uczciwych, powtarzalnych testów

Celuj w benchmarki, które odpowiadają na twoje pytanie, nie czyjeś inne:

- Mierz end-to-end: uwzględnij framework, typowe middleware i realistyczne rozmiary payloadów.

- Oddziel cold i warm: zapisuj rozruch, pierwsze żądanie i stan ustalony.

- Uruchamiaj wiele prób: raportuj medianę i wariancję, nie tylko najlepszy wynik.

- Zamknij środowisko: przypnij wersje, izoluj CPU i udokumentuj polecenia.

Jeśli potrzebujesz praktycznego szablonu, umieść harness testowy w repo i udokumentuj go w wewnętrznych materiałach (albo w tekście "/blog/runtime-benchmarking-notes"), by wyniki można było odtworzyć później.

Pod maską: silniki, API i modele wykonania

Zwaliduj runtime w wdrożeniu

Wdróż usługę pilotażową i zobacz, jak wybór runtime wpływa na rzeczywiste workflowy wydawnicze.

Gdy porównuje się Node.js, Deno i Bun, ludzie mówią o funkcjach i benchmarkach. Pod spodem „odczucie” runtime’u kształtują cztery główne elementy: silnik JavaScript, wbudowane API, model wykonania (pętla zdarzeń + schedulery) oraz sposób, w jaki kod natywny jest powiązany.

Silniki: V8, JavaScriptCore i dlaczego mają znaczenie

Silnik to część, która parsuje i uruchamia JavaScript. V8 (używany przez Node.js i Deno) oraz JavaScriptCore (używany przez Bun) stosują zaawansowane optymalizacje jak JIT i GC.

W praktyce wybór silnika może wpłynąć na:

- Czas startu i zachowanie pamięci (jak szybko proces staje się użyteczny)

- Wydajność „gorącego” kodu po optymalizacjach

- Które niskopoziomowe funkcje pojawiają się wcześniej (niektóre silniki wprowadzają nowe możliwości JS szybciej)

Wbudowane API: więcej niż „czy mogę fetchować?”

Nowoczesne runtime’y konkurują tym, jak kompletna jest ich standardowa biblioteka. Wbudowane fetch, Web Streams, narzędzia URL, API plików i crypto mogą zmniejszyć eksplozję zależności i uczynić kod bardziej przenośnym między serwerem a przeglądarką.

Uwaga: ta sama nazwa API nie zawsze oznacza identyczne zachowanie. Różnice w implementacji strumieni, timeoutach czy obserwacji plików mogą wpływać na aplikacje bardziej niż surowa prędkość.

Modele wykonania: pętle zdarzeń, schedulery i powiązania natywne

JavaScript jest jednordzeniowy na poziomie głównym, ale runtime’y koordynują pracę w tle (sieć, I/O plików, timery) przez pętlę zdarzeń i wewnętrzne schedulery. Niektóre runtime’y mocno polegają na powiązaniach natywnych (kod skompilowany) dla I/O i zadań krytycznych dla wydajności, inne stawiają na webowe, standardowe interfejsy.

WebAssembly: kiedy pomaga

WebAssembly (Wasm) przydaje się, gdy potrzebujesz szybkich, przewidywalnych obliczeń (parsowanie, obróbka obrazów, kompresja) lub chcesz reuse’ować kod z Rust/C/C++. Nie przyspieszy magicznie typowego serwera I/O-heavy, ale może być świetnym narzędziem dla modułów CPU-bound.

Bezpieczeństwo: domyślne ustawienia, uprawnienia i rzeczywistość łańcucha dostaw

„Bezpieczne domyślnie” w runtime’ie JavaScript zwykle oznacza, że runtime traktuje kod jako nieufny, dopóki nie przydzielisz mu jawnie dostępu. To przewraca tradycyjny model serwerowy (gdzie skrypty często mają domyślny dostęp do plików, sieci i env) w bardziej ostrożne podejście.

Jednocześnie wiele realnych incydentów zaczyna się zanim twój kod zostanie uruchomiony — w zależnościach lub procesie instalacji — więc bezpieczeństwo na poziomie runtime’u to tylko jedna warstwa, nie cała strategia.

Prompt uprawnień i allowlisty

Niektóre runtime’y mogą ograniczać wrażliwe możliwości za pomocą uprawnień. Praktyczny model to allowlista:

- System plików: zezwól na odczyt/zapis tylko do konkretnych ścieżek (np. katalog konfiguracyjny)

- Sieć: zezwól na żądania wychodzące tylko do zatwierdzonych hostów/portów

- Zmienna środowiskowa: wystaw tylko konkretne klucze zamiast całego process.env

To może zmniejszyć przypadkowe wycieki danych (np. wysłanie sekretów do nieoczekiwanego endpointu) i ograniczyć zasięg szkód przy uruchamianiu kodu stron trzecich — szczególnie w CLI, narzędziach build i automatyzacji.

Sandboxing ma ograniczenia

Uprawnienia nie są magiczną tarczą. Jeśli przyznasz dostęp sieciowy do „api.mycompany.com”, przejęta zależność wciąż może wyekfiltrować dane na ten sam host. A jeśli pozwolisz na czytanie katalogu, to ufasz wszystkiemu, co w nim jest. Model pomaga wyrazić intencję, ale nadal potrzebujesz weryfikacji zależności, lockfile’ów i ostrożnego przeglądu tego, co zezwalasz.

Bezpieczne domyślne ustawienia w typowych API

Bezpieczeństwo żyje też w drobnych domyślnych zachowaniach:

- TLS/HTTPS: sensowna walidacja certyfikatów i nowoczesne ustawienia protokołu domyślnie

- HTTP: bezpieczne zachowanie przekierowań i jasna kontrola nad nagłówkami/ciasteczkami

- API kryptograficzne: nowoczesne prymitywy z interfejsami trudnymi do błędnego użycia

Kosztem są tarcia: ostrzejsze domyślne ustawienia mogą łamać stare skrypty lub dodawać flagi, które trzeba utrzymywać. Najlepszy wybór zależy od tego, czy cenisz wygodę dla zaufanych usług, czy też barierki ochronne przy uruchamianiu kodu o mieszanym stopniu zaufania.

Ryzyka łańcucha dostaw, których nie da się zignorować

Ataki na łańcuch dostaw często wykorzystują sposób, w jaki pakiety są odkrywane i instalowane:

- Typosquatting: złośliwy pakiet nazwany jedną literą różnicy od popularnego (np.

expresss).

- Dependency confusion: publiczny pakiet o tej samej nazwie co wewnętrzny, mylący instalatory.

- Przejęcie maintainerów: atak na konto, który wprowadza złośliwe zmiany.

Te ryzyka dotyczą każdego runtime’u, który pobiera pakiety z publicznych rejestrów — więc higiena jest równie ważna jak funkcje runtime’u.

Lockfile’y, sumy integralności i pochodzenie (provenance)

Lockfile’e przypinają dokładne wersje (wraz z zależnościami tranzytywnymi), czyniąc instalacje odtwarzalnymi i zmniejszając niespodziewane aktualizacje. Sumy integralności (hashy zapisane w lockfile’u lub metadanych) pomagają wykryć manipulacje podczas pobierania.

Pochodzenie (provenance) to kolejny krok: umiejętność odpowiedzenia na pytanie „kto zbudował ten artefakt, z jakiego źródła i jakiego workflowu?”. Nawet jeśli nie przyjmujesz pełnego toolingu provenance od razu, możesz przybliżyć to praktykami:

- faworyzując dobrze utrzymane pakiety z przejrzystą praktyką wydawniczą,

- unikając nieprzypiętych zależności z Git w buildach produkcyjnych,

- wymagając tagów/wydań zamiast losowych commitów.

Workflowy audytowe i aktualizacyjne, które działają

Traktuj pracę z zależnościami jak rutynową konserwację:

- uruchamiaj automatyczne audyty w CI przy każdym PR,

- planuj regularne okna aktualizacji (tygodniowe/2-tygodniowe), aby unikać dużych przeskoków,

- czytaj changelogi dla większych skoków i wydań związanych z bezpieczeństwem.

Polityki zespołowe, które nie spowalniają dostarczania

Lekka polityka wiele daje:

- blokuj nowe zależności, jeśli nie mają wyznaczonego właściciela i uzasadnienia,

- ograniczaj skrypty instalacyjne tam, gdzie to możliwe (są częstą ścieżką wykonania),

- używaj prywatnego rejestru lub scope’owanych pakietów dla nazw wewnętrznych, by zmniejszyć zamieszanie.

Dobra higiena to mniej o perfekcji, a więcej o konsekwentnych, nudnych nawykach.

Zgodność i ekosystem jako przewagi konkurencyjne

Nagłówki mówią o wydajności i bezpieczeństwie, ale to zgodność i ekosystem często decydują, co faktycznie trafia do produkcji. Runtime, który uruchomi twój istniejący kod, wspiera twoje zależności i zachowuje się przewidywalnie między środowiskami, zmniejsza ryzyko bardziej niż pojedyncza funkcja.

Zgodność wpływa na bezpieczeństwo i utrzymanie

Zgodność to nie tylko wygoda. Mniej refaktorów oznacza mniej okazji do wprowadzenia subtelnych bugów i mniej jednorazowych poprawek, o których zapomnisz. Dojrzałe ekosystemy mają też lepiej znane tryby awaryjne: popularne biblioteki były audytowane więcej razy, problemy są udokumentowane, a środki zaradcze łatwiej znaleźć.

Z drugiej strony, „zgodność za wszelką cenę” może utrzymać przestarzałe wzorce (np. zbyt szeroki dostęp do plików/sieci), więc zespoły nadal potrzebują jasnych granic i dobrej higieny zależności.

Warstwy zgodności Node vs webowe API

Runtime’y dążące do drop-in zgodności z Node.js pozwalają uruchomić większość serwerowego JavaScript niemal od razu, co jest ogromną praktyczną zaletą. Warstwy kompatybilności mogą wygładzić różnice, ale też ukrywać specyficzne zachowania runtime’u — szczególnie wokół systemu plików, sieci i rozwiązywania modułów — utrudniając debugowanie, gdy coś zachowuje się inaczej w produkcji.

Webowe API (jak fetch, URL i Web Streams) kierują kod ku przenośności między runtime’ami i środowiskami edge. Kompromis: niektóre paczki Node zakładają wewnętrzne mechanizmy Node i nie zadziałają bez shimów.

Ekosystem NPM: mocne strony i kompromisy

Największa siła NPM jest prosta: ma prawie wszystko. Ta szerokość przyspiesza dostarczanie, ale też zwiększa ekspozycję na ryzyka łańcucha dostaw i nadmierne zależności. Nawet gdy pakiet jest „popularny”, jego zależności tranzytywne mogą cię zaskoczyć.

Kiedy „działa wszędzie” przebija nowe funkcje

Jeśli twoim priorytetem są przewidywalne wdrożenia, łatwość zatrudnienia i mniej niespodzianek integracyjnych, „działa wszędzie” często wygrywa. Nowe możliwości runtime są ekscytujące — ale przenośność i sprawdzony ekosystem mogą zaoszczędzić tygodnie w czasie życia projektu.

Doświadczenie programisty: narzędzia, typy i debugowanie

Uczyń checklistę wykonalną

Zamień checklistę decyzji runtime w konkretny projekt pilotażowy, który możesz uruchomić.

Doświadczenie programisty (DX) to pole, gdzie runtime’y cicho wygrywają lub przegrywają. Dwa runtime’y mogą uruchamiać ten sam kod, a mimo to zupełnie inaczej wyglądać przy konfiguracji projektu, ściganiu błędów czy szybkim wdrożeniu małej usługi.

Wsparcie TypeScript: wbudowane kontra "przynieś własne"

TypeScript to dobry litmus test DX. Niektóre runtime’y traktują go jako pierwszy obywatel (można uruchamiać .ts bez ceremonii), inne oczekują tradycyjnego toolchainu (tsc, bundler lub loader) do skonfigurowania.

Żadne podejście nie jest uniwersalnie lepsze:

- Wbudowane wsparcie redukuje konfigurację i może ujednolicić domyślne ustawienia w zespole.

- Narzędzia konfigurowane dają większą kontrolę nad tsconfig, celami kompilacji i outputem — przydatne w bibliotekach i dużych monorepo.

Kluczowe jest, czy historia TypeScript w runtime’ie pasuje do sposobu, w jaki zespół naprawdę dostarcza kod: bezpośrednie uruchamianie w dev, skompilowane buildy w CI, lub oba scenariusze.

Domyślne ustawienia bundlingu, transpilingu i testów

Nowoczesne runtime’y coraz częściej wypuszczają opiniotwórcze narzędzia: bundlery, transpilery, linters i test runnery działające od razu. To może wyeliminować „podatek wyboru stosu” w mniejszych projektach.

Jednak domyślne ustawienia są pozytywne dla DX tylko wtedy, gdy są przewidywalne:

- Czy łatwo zmienić formaty wyjściowe (ESM/CJS), cele i zależności zewnętrzne?

- Czy runner testów integruje się z coverage i CI?

- Czy konfiguracja jest minimalna i stabilna między wersjami?

Jeśli często zaczynasz nowe serwisy, runtime z solidnymi wbudowanymi narzędziami i dobrą dokumentacją może oszczędzić wiele godzin na projekt.

Debugowanie: stack trace’y, sourcemapy i inspektory

Debugowanie to miejsce, gdzie dopracowanie runtime’u jest oczywiste. Kwalit

y stack trace’ów, poprawna obsługa sourcemapów i inspektor, który „po prostu działa”, decydują, jak szybko zrozumiesz błędy.

Szukaj:

- Jasnych błędów wskazujących na twój kod (nie wygenerowany)

- Wiarygodnych async stack trace’ów

- Dobrej integracji z edytorami i inspektorami w stylu Chrome DevTools

Szablony i scaffoldy redukujące tarcie

Generatorzy projektów bywają niedoceniani: czysty szablon API, CLI czy workera często wyznacza ton repozytorium. Wybieraj scaffoldy, które tworzą minimalną, produkcyjnie ukształtowaną strukturę (logowanie, obsługa env, testy), bez przywiązywania do ciężkiego frameworka.

Jeśli szukasz inspiracji, zobacz pokrewne przewodniki w tekście "/blog".

Praktycznym workflowem jest prototypowanie małej usługi lub CLI w Koder.ai w różnych „stylach runtime” (Node-first kontra web-standard APIs), a potem eksport wygenerowanego kodu do prawdziwych pomiarów. To nie zastąpi testów produkcyjnych, ale skróci drogę od pomysłu do porównania uruchomionego kodu.

Wybory zarządzania pakietami kształtują DX

Zarządzanie pakietami to miejsce, gdzie „doświadczenie programisty” staje się namacalne: prędkość instalacji, zachowanie lockfile’a, wsparcie workspaces i to, jak powtarzalnie CI odtwarza build. Runtime’y coraz częściej traktują to jako cechę pierwszorzędną.

Natywne menedżery pakietów i cele wydajnościowe

Node.js historycznie polegał na zewnętrznych narzędziach (npm, Yarn, pnpm), co jest siłą (wybór) i źródłem niezgodności w zespołach. Nowe runtime’y oferują opinie: Deno integruje zarządzanie zależnościami przez deno.json (i wspiera pakiety npm), a Bun dołącza szybki instalator i lockfile.

Natywne narzędzia runtime’ów optymalizują często mniejszą liczbę round-tripów sieciowych, agresywne cache’owanie i ścisłą integrację z loaderem modułów — co pomaga przy cold startach w CI i przy onboardowaniu nowych osób.

Monorepo, workspace’y i podstawy cache’owania

Większość zespołów potrzebuje w końcu workspace’ów: współdzielone pakiety wewnętrzne, spójne wersje zależności i przewidywalne reguły hoistingu. npm, Yarn i pnpm wspierają workspace’y, ale różnią się zużyciem miejsca na dysku, układem node_modules i deduplikacją. To wpływa na czas instalacji, rozpoznawanie przez edytory i „działa na mojej maszynie” błędy.

Cache ma równie duże znaczenie. Dobry punkt wyjścia to cache’owanie store’a menedżera pakietów (lub cache pobrań) oraz kroków instalacyjnych opartych na lockfile’u, a potem trzymanie skryptów deterministycznymi. Jeśli potrzebujesz prostego startu, udokumentuj to obok kroków builda w "/docs".

Publikowanie i konsumpcja: co zespoły muszą wiedzieć

Publikowanie wewnętrznych pakietów (lub korzystanie z prywatnych rejestrów) wymusza standaryzację auth, adresów rejestrów i zasad wersjonowania. Upewnij się, że runtime/narzędzia wspierają te same konwencje .npmrc, sumy integralności i oczekiwania co do pochodzenia.

Obawy migracyjne: zmiany lockfile’ów i dostosowania CI

Zmiana menedżera pakietów lub przyjęcie instalatora dołączonego do runtime’a zwykle zmienia lockfile’e i komendy instalacyjne. Zaplanuj zamieszanie w PR, zaktualizuj obrazy CI i uzgodnij jeden „źródło prawdy” lockfile — inaczej będziesz debugować dryf zależności zamiast dostarczać funkcje.

Wybór runtime’u wg przypadku użycia (nie hype’u)

Eksperymentuj z łatwym rollbackiem

Iteruj nad prototypem bezpiecznie za pomocą snapshotów i rollbacku, gdy eksperymenty idą nie tak.

Wybór środowiska uruchomieniowego JavaScript to mniej kwestia „kto wygrywa na wykresie”, a bardziej kształt twojej pracy: jak wdrażasz, z czym musisz się integrować i ile ryzyka może przyjąć zespół. Dobry wybór to ten, który redukuje tarcie dopasowane do twoich ograniczeń.

Serverless i edge

Tu cold-start i zachowanie przy współbieżności liczą się tak samo jak surowa przepustowość. Szukaj:

- Czasu startu (jak szybko funkcja zaczyna obsługiwać żądania)

- Modelu izolacji (procesy kontra isolates/wątki)

- Dostępności API (Web API, fetch, streams, crypto) na docelowej platformie

Node.js jest szeroko wspierany przez providerów; webowe API Deno i model uprawnień mogą kusić, jeśli są dostępne; Bun oferuje szybkość, ale potwierdź wsparcie platformy i kompatybilność edge zanim się zwiążesz.

Narzędzia CLI i automatyzacja

Dla narzędzi CLI dystrybucja może dominować decyzję. Priorytetyzuj:

- Buildy single-binary i przewidywalne instalacje

- Zachowanie cross-platformowe (macOS, Windows, Linux)

- Szybki start i ergonomię dewelopera

Deno z wbudowanymi narzędziami i prostą dystrybucją jest mocny dla CLI. Node.js sprawdza się, gdy potrzebujesz szerokości npm. Bun może być świetny do szybkich skryptów, ale przetestuj pakowanie i wsparcie Windows dla twojej publiczności.

Kontenery i usługi długotrwałe

W kontenerach stabilność, zachowanie pamięci i obserwowalność często przewyższają nagłówkowe benchmarki. Oceń zużycie pamięci w stanie ustalonym, zachowanie GC pod obciążeniem i dojrzałość narzędzi debugujących/profilujących. Node.js zwykle jest „bezpiecznym domyślnym” wyborem dla usług długotrwałych ze względu na dojrzały ekosystem i operacyjną znajomość.

Ograniczenia zespołu przebijają nowości

Wybierz runtime pasujący do umiejętności zespołu, bibliotek i operacji (CI, monitoring, incident response). Jeśli runtime wymusza rewrite’y, nowe workflowy debugowania lub niejasne praktyki zależności, każda wygrana wydajnościowa może zostać zniwelowana przez ryzyko dostarczenia.

Jeśli celem jest szybkie dostarczanie funkcji (nie debatowanie o runtime’ach), rozważ gdzie JavaScript faktycznie ma znaczenie w stosie. Na przykład Koder.ai koncentruje się na budowie kompletnych aplikacji przez chat — fronty w React, backendy w Go z PostgreSQL i mobilne w Flutterze — więc zespoły często rezerwują decyzje runtime’owe tam, gdzie Node/Deno/Bun naprawdę mają znaczenie (narzędzia, skrypty edge, istniejące usługi JS), jednocześnie szybko przesuwając się z produkcyjnie ukształtowanym baseline’em.

Lista kontrolna decyzji i kolejne kroki

Wybór runtime’u to mniej wybór „zwycięzcy”, a bardziej redukcja ryzyka przy jednoczesnym poprawianiu wyników dla zespołu i produktu.

Krótka lista kontrolna

- Testy wydajności: Czy znasz swoje 3 główne wąskie gardła (czas startu, przepustowość żądań, praca CPU-heavy, opóźnienia I/O)? Czy możesz je odtworzyć lokalnie i w CI?

- Potrzeby bezpieczeństwa: Czy potrzebujesz modelu uprawnień (dostęp do plików/sieci/env), silniejszego sandboxingu lub kontroli zgodności?

- Priorytety DX: Które tarcie kosztuje cię najwięcej dziś — konfiguracja TypeScript, debugowanie, hot reload, narzędzia testowe czy pakowanie do wdrożenia?

Pytania przed zmianą runtime’u

- Jaki problem rozwiązujemy: koszty, opóźnienia, tempo pracy deweloperów czy bezpieczeństwo?

- Które części systemu są wrażliwe na runtime (funkcje edge, CLI, API, zadania tła)?

- Czy jesteśmy związani ze specyficznym zachowaniem ekosystemu pakietów (addony natywne, skrypty postinstall, oczekiwania CommonJS/ESM)?

- Jaki jest plan rollbacku, jeśli zależność lub integracja platformy zachowuje się inaczej?

- Kto będzie odpowiadać za aktualizacje runtime’u i śledzenie breaking change’ów?

Praktyczny plan pilotażowy

Zacznij od małego i mierzalnego:

- Wybierz jedną usługę lub narzędzie wewnętrzne z jasnymi wejściami/wyjściami (np. handler webhooków, CLI, mały worker).

- Zdefiniuj metryki sukcesu: p95 latency, pamięć, CPU, czas budowania, cold start i czas dewelopera do naprawy.

- Uruchom pilota w dwóch środowiskach: staging i produkcja-canary (jeśli możliwe).

- Porównaj wyniki, udokumentuj niespodzianki, potem iteruj (dostrój konfiguracje, wybory zależności) zanim rozważysz szerszą migrację.

Jeśli chcesz przyspieszyć sprzężenie zwrotne, możesz szybciej zbudować usługę pilotażową i harness benchmarkowy w Koder.ai, użyć trybu Planowania, aby opisać eksperyment (metryki, endpointy, payloady), a potem wyeksportować kod, aby pomiary wykonywały się w kontrolowanym środowisku.

Gdzie dalej się uczyć

Korzystaj ze źródeł pierwotnych i obserwuj sygnały:

- Oficjalna dokumentacja i notatki o zgodności dla Node.js, Deno i Bun

- Notes wydawnicze i changelogi (śledź poprawki bezpieczeństwa i breaking changes)

- Advisories bezpieczeństwa i feedy CVE istotne dla twoich zależności

- Issue trackery społeczności, by wychwycić realne edge case’y

Jeśli chcesz głębszego przewodnika, jak mierzyć runtime’y uczciwie, zobacz tekst "/blog/benchmarking-javascript-runtimes".