Dlaczego Ullman ma znaczenie dla współczesnych danych

Większość osób piszących SQL, tworzących pulpity czy strojących wolne zapytanie skorzystała z prac Jeffreya Ullmana — nawet jeśli nigdy nie słyszeli jego nazwiska. Ullman to informatyk i pedagog, którego badania i podręczniki pomogły zdefiniować, jak bazy danych opisują dane, rozumieją zapytania i wykonują je wydajnie.

Cicha inspiracja stojąca za narzędziami codziennego użytku

Gdy silnik bazy danych zamienia twój SQL w coś, co może wykonać szybko, opiera się na pomysłach, które muszą być jednocześnie precyzyjne i elastyczne. Ullman pomógł sformalizować znaczenie zapytań (tak aby system mógł je bezpiecznie przepisywać) i połączyć myślenie o bazach z myśleniem o kompilatorach (tak aby zapytanie można było sparsować, zoptymalizować i przetłumaczyć na kroki wykonawcze).

Ten wpływ jest cichy, bo nie pokazuje się jako przycisk w narzędziu BI ani jako widoczna funkcja w konsoli chmurowej. Objawia się jako:

- zapytania, które działają szybko po dodaniu indeksu lub przepisaniu

JOIN\n- optymalizatory wybierające inne plany w miarę wzrostu danych\n- systemy, które skalują się bez zmiany wyniku twojego zapytania

Czego nauczysz się w tym artykule (bez nadmiaru matematyki)

Ten artykuł wykorzystuje kluczowe idee Ullmana jako przewodnik po wnętrzu baz danych, które są najważniejsze w praktyce: jak algebra relacyjna leży pod SQL, jak przepisywanie zapytań zachowuje znaczenie, dlaczego optymalizatory oparte na kosztach podejmują takie decyzje, i jak algorytmy łączeń często decydują, czy zadanie kończy się w sekundach czy godzinach.

Dorzucimy też kilka pojęć podobnych do kompilatora — parsowanie, przepisywanie i planowanie — bo silniki baz danych zachowują się bardziej jak zaawansowane kompilatory, niż wiele osób przypuszcza.

Krótka obietnica: zachowamy dokładność dyskusji, ale unikniemy ciężkich dowodów matematycznych. Celem są modele umysłowe, które możesz zastosować przy pracy, gdy pojawią się problemy z wydajnością, skalowaniem lub dziwnym zachowaniem zapytań.

Podstawy baz danych, które Ullman pomógł utrwalić

Jeśli kiedykolwiek napisałeś zapytanie SQL i oczekiwałeś, że „po prostu znaczy to samo”, opierasz się na ideach, które Jeffrey Ullman pomógł upowszechnić i sformalizować: przejrzysty model danych plus precyzyjne sposoby opisania, o co pyta zapytanie.

Model relacyjny prostym językiem

W istocie model relacyjny traktuje dane jako tabele (relacje). Każda tabela ma wiersze (krotki) i kolumny (atrybuty). To brzmi dziś oczywiście, ale ważna jest dyscyplina, którą tworzy:

- Klucze identyfikują wiersze. Klucz główny to „identyfikator” każdego rekordu.\n- Relacje łączą tabele przez klucze obce, dzięki czemu fakty można przechowywać w jednym miejscu i odwoływać się do nich gdzie indziej.

To ramowanie umożliwia rozumowanie o poprawności i wydajności bez mówienia ogólnikami. Gdy wiesz, co reprezentuje tabela i jak identyfikowane są wiersze, możesz przewidzieć, co zrobią łączenia, co znaczą duplikaty i dlaczego pewne filtry zmieniają wyniki.

Algebra relacyjna: kalkulator zapytań

Nauczanie Ullmana często korzysta z algebry relacyjnej jako swego rodzaju kalkulatora zapytań: mały zestaw operacji (select, project, join, union, difference), które można łączyć, by wyrazić, czego się chce.

Dlaczego to ważne w pracy z SQL: bazy tłumaczą SQL na formę algebraiczną, a potem przepisują ją na inną równoważną formę. Dwa zapytania, które wyglądają inaczej, mogą być algebraicznie takie same — to pozwala optymalizatorom zmieniać kolejność łączy, przepychać filtry niżej lub usuwać nadmiarową pracę, zachowując znaczenie.

Algebra vs. rachunek (na wysokim poziomie)

- Algebra relacyjna to bardziej „jak”: sekwencja operacji do obliczenia wyniku.\n- Rachunek relacyjny to bardziej „co”: opis wyniku, którego chcesz.

SQL jest w dużej mierze „co”, ale silniki często optymalizują, używając algebraicznego „jak”.

Fundament zamiast zapamiętywania dialektu

Dialekty SQL się różnią (Postgres vs. Snowflake vs. MySQL), ale podstawy są niezmienne. Zrozumienie kluczy, relacji i równoważności algebraicznej pomaga dostrzec, kiedy zapytanie jest logicznie błędne, kiedy tylko wolne, i które zmiany zachowują znaczenie między platformami.

Algebra relacyjna: ukryty język pod SQL

Algebra relacyjna to „matematyka pod spodem” SQL: mały zestaw operatorów, które opisują wynik, którego chcesz. Prace Ullmana pomogły uczynić ten widok operatorowy jasnym i uczącym się, i to nadal jest model umysłowy, którego używają optymalizatory.

Główne operatory (i co one znaczą)

Zapytanie można wyrazić jako potok kilku bloków konstrukcyjnych:

- Select (σ): filtrowanie wierszy (odpowiednik

WHERE w SQL)\n- Project (π): wybór konkretnych kolumn (odpowiednik SELECT col1, col2)\n- Join (⋈): łączenie tabel na podstawie warunku (JOIN ... ON ...)\n- Union (∪): doklejanie wyników o tym samym kształcie (UNION)\n- Difference (−): wiersze w A, ale nie w B (jak EXCEPT w wielu dialektach SQL)

Ponieważ zbiór jest mały, łatwiej rozumieć poprawność: jeśli dwa wyrażenia algebraiczne są równoważne, zwracają tę samą tabelę dla każdego poprawnego stanu bazy.

Jak SQL mapuje się na algebrę (koncepcyjnie)

Weź znajome zapytanie:

SELECT c.name

FROM customers c

JOIN orders o ON o.customer_id = c.id

WHERE o.total \u003e 100;

Koncepcyjnie to:

- zacznij od join customers i orders:

customers ⋈ orders\n

- select tylko zamówienia powyżej 100:

σ(o.total \u003e 100)(...)\n

- project jedną kolumnę, której chcesz:

π(c.name)(...)

To nie jest dokładna wewnętrzna notacja używana przez każdy silnik, ale to właściwy pomysł: SQL staje się drzewem operatorów.

Równoważność: drzwi do optymalizacji

Wiele różnych drzew może znaczyć to samo. Na przykład filtry często można przepchnąć wcześniej (zastosować σ przed dużym joinem), a projekcje mogą szybciej odciąć nieużywane kolumny (zastosować π wcześniej).

To właśnie reguły równoważności pozwalają bazie przepisać zapytanie w tańszy plan bez zmiany znaczenia. Gdy zobaczysz zapytania jako algebrę, „optymalizacja” przestaje być magią, a staje się bezpiecznym, prowadzonym regułami przekształcaniem.

Od SQL do planów zapytań: przepisy, które zachowują znaczenie

Gdy piszesz SQL, baza danych nie wykonuje go „tak, jak napisałeś”. Tłumaczy twoje polecenie na plan zapytania: uporządkowaną reprezentację pracy do wykonania.

Dobry model umysłowy to drzewo operatorów. Liście czytają tabele lub indeksy; węzły wewnętrzne transformują i łączą wiersze. Typowe operatory to scan, filter (selection), project (wybór kolumn), join, group/aggregate i sort.

Plan logiczny vs. plan fizyczny (co vs. jak)

Bazy zwykle dzielą planowanie na dwie warstwy:

- Plan logiczny: co obliczyć, wyrażone za pomocą abstrakcyjnych operatorów (filter, join, aggregate) i ich zależności.\n- Plan fizyczny: jak to wykonać na rzeczywistym magazynie i sprzęcie (skan indeksu vs. pełny skan, hash join vs. nested-loop, równoległość vs. pojedyncze wątki).

Wpływ Ullmana objawia się w nacisku na przekształcenia zachowujące znaczenie: zmieniaj plan logiczny na wiele sposobów bez zmiany odpowiedzi, a potem wybierz wydajną strategię fizyczną.

Reguły przepisów, które zmniejszają pracę

Zanim wybierze się ostateczne podejście wykonawcze, optymalizatory stosują algebraiczne „porządki”. Te przepisy nie zmieniają wyników; redukują niepotrzebną pracę.

Typowe przykłady:

- Selection pushdown: stosuj filtry jak najwcześniej, żeby do późniejszych kroków trafiało mniej wierszy.\n- Projection pruning: zachowuj tylko potrzebne kolumny, zmniejszając I/O i pamięć.\n- Join reordering: łącz mniejsze/węższe wyniki najpierw (gdy to bezpieczne), zamiast polegać na kolejności w SQL.

Prosty przykład przepisu

Załóżmy, że chcesz zamówienia użytkowników z jednego kraju:

SELECT o.order_id, o.total

FROM users u

JOIN orders o ON o.user_id = u.id

WHERE u.country = 'CA';

Naiwne wykonanie mogłoby połączyć wszystkich użytkowników z wszystkimi zamówieniami, a potem przefiltrować do Kanady. Przepis zachowujący znaczenie przepycha filtr tak, by join dotyczył mniejszej liczby wierszy:

- Przefiltruj users do

country = 'CA'\n- Potem połącz tych użytkowników z orders\n- Potem rzutuj jedynie order_id i total

W terminach planu, optymalizator próbuje zmienić:

Join(Users, Orders) → Filter(country='CA') → Project(order_id,total)

w coś bliższego:

Filter(country='CA') on Users → Join(with Orders) → Project(order_id,total)

Ta sama odpowiedź, mniejsza praca.

Te przepisy bywają łatwe do przeoczenia, bo nigdy ich nie wpisujesz — a jednak są głównym powodem, dla którego ten sam SQL może działać szybko na jednej bazie, a wolno na innej.

Optymalizacja oparta na kosztach bez żargonu

Gdy uruchamiasz zapytanie SQL, baza rozważa kilka prawidłowych sposobów uzyskania tego samego wyniku, a potem wybiera ten, który uważa za najtańszy. Ten proces nazywa się optymalizacją opartą na kosztach — i to jedno z najbardziej praktycznych miejsc, gdzie teoretyczne podejście Ullmana pojawia się w codziennej wydajności.

Czym naprawdę jest "model kosztu"

Model kosztu to system punktowania, którego optymalizator używa, by porównać alternatywne plany. Większość silników szacuje koszt, biorąc pod uwagę kilka podstawowych zasobów:

- Przetworzone wiersze (praca zwykle rośnie proporcjonalnie do tego, ile danych przepływa przez każdy krok)\n- I/O (odczyty stron z dysku lub SSD oraz efekty cache)\n- CPU (filtrowanie, hashowanie, sortowanie, agregowanie)\n- Pamięć (czy operacja mieści się w RAM czy musi zapisywać na dysk)

Model nie musi być perfekcyjny; musi wystarczająco często wybierać dobre plany.

Estymacja kardynalności, prostym językiem

Zanim oceni plany, optymalizator zadaje pytanie w każdym kroku: ile wierszy to wyprodukuje? To jest estymacja kardynalności.

Jeśli filtrujesz WHERE country = 'CA', silnik oszacowuje, jaki odsetek tabeli pasuje. Jeśli łączysz klientów z zamówieniami, szacuje, ile par będzie pasować po kluczu łączenia. Te zgadywanki decydują o tym, czy woli skan indeksu zamiast pełnego skanu, hash join zamiast nested loop, czy sort będzie mały czy ogromny.

Dlaczego statystyki są ważne (i co się psuje bez nich)

Szacunki optymalizatora opierają się na statystykach: liczbach, rozkładach wartości, odsetkach nulli i czasem korelacjach między kolumnami.

Gdy statystyki są nieaktualne lub brakujące, silnik może błędnie oszacować liczbę wierszy o rzędy wielkości. Plan, który na papierze wygląda tanio, w praktyce może być bardzo drogi — typowe objawy to nagłe spowolnienia po wzroście danych, „losowe” zmiany planów czy łączenia, które niespodziewanie zapisują na dysk.

Nieunikniony kompromis: dokładność vs. czas planowania

Lepsze estymaty często wymagają dodatkowej pracy: dokładniejszych statystyk, próbkowania czy rozważenia większej liczby kandydatów planów. Planowanie samo w sobie kosztuje czas, szczególnie dla złożonych zapytań.

Dlatego optymalizatory równoważą dwa cele:

- Planować wystarczająco szybko dla interaktywnych obciążeń\n- Planować na tyle mądrze, by unikać katastrofalnych wyborów

Zrozumienie tego kompromisu pomaga interpretować wynik EXPLAIN: optymalizator nie próbuje być sprytny — próbuje być przewidywalnie poprawny przy ograniczonych informacjach.

Algorytmy łączeń i serce wydajności zapytań

Ullman pomógł spopularyzować prostą, ale potężną ideę: SQL nie jest tyle „wykonywany”, co tłumaczony na plan wykonania. Nigdzie jest to bardziej widoczne niż przy łączeniach. Dwa zapytania zwracające te same wiersze mogą różnić się drastycznie czasem wykonania w zależności od wybranego algorytmu łączenia i kolejności łączeń.

Nested loop, hash join, merge join — kiedy każdy ma sens

Nested loop join jest koncepcyjnie prosty: dla każdego wiersza z lewej strony znajdź pasujące wiersze z prawej. Może być szybki, gdy lewa strona jest mała, a prawa ma przydatny indeks.

Hash join buduje tablicę haszującą z jednego wejścia (często z mniejszego) i sprawdza ją przy drugim wejściu. Świetnie sprawdza się dla dużych, nieposortowanych wejść z warunkami równości (np. A.id = B.id), ale potrzebuje pamięci; zapisy na dysk mogą zniweczyć przewagę.

Merge join przechodzi po dwóch wejściach w kolejności posortowanej. Dobrze pasuje, gdy obie strony są już uporządkowane (lub łatwo je posortować), na przykład gdy indeksy zwracają wiersze w porządku po kluczu łączenia.

Dlaczego kolejność łączeń może dominować wydajność

Dla trzech i więcej tabel liczba możliwych kolejności łączeń eksploduje. Połączenie dwóch dużych tabel najpierw może stworzyć ogromny wynik pośredni, który spowolni wszystko inne. Lepsza kolejność zwykle zaczyna się od najbardziej selektywnego filtra (najmniej wierszy) i łączy na zewnątrz, utrzymując pośrednie wyniki małe.

Indeksy zmieniają ofertę dobrych planów

Indeksy nie tylko przyspieszają wyszukiwania — sprawiają, że niektóre strategie łączeń stają się wykonalne. Indeks po kluczu łączenia może zmienić kosztowny nested loop w szybkie „seek per row”. Brak lub nieużywalność indeksów może z kolei skłonić silnik do hash joinów lub dużych sortów potrzebnych przy merge joinach.

Praktyczna lista kontrolna: objawy złego planu łączeń

- Czas wykonania rośnie dramatycznie przy nieznacznym wzroście danych (kolejność łączeń najpewniej powiększa pośrednie wyniki).\n- Plan pokazuje ogromne różnice "szacowane vs. rzeczywiste wiersze" (złe szacunki kardynalności prowadzą do złego wyboru łączenia).\n- Widać duże sorty lub zapisy hash na dysk (presja pamięci lub brak wsparcia indeksów).\n- Mała przefiltrowana tabela jest łączona dopiero późno zamiast na początku (filtry nie są stosowane wystarczająco wcześnie).\n- Predykat łączenia nie jest prostą równością na kompatybilnych typach (uniemożliwia efektywne użycie hash/merge).

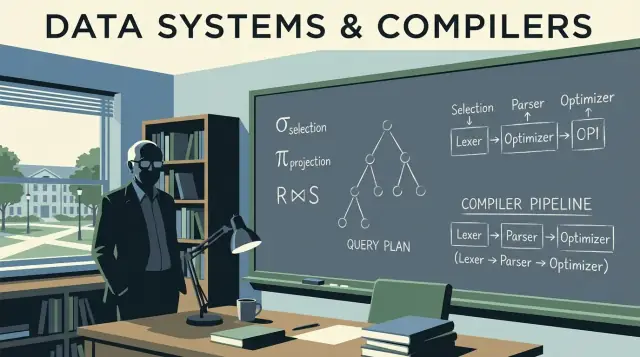

Pomysły z kompilatorów w silnikach baz danych

Bazy danych nie tylko „uruchamiają SQL”. One go kompilują. Wpływ Ullmana rozciąga się zarówno na teorię baz, jak i myślenie o kompilatorach — i to połączenie tłumaczy, dlaczego silniki zapytań przypominają potoki narzędzi języków programowania: tłumaczą, przepisują i optymalizują, zanim wykonają jakąkolwiek pracę.

Parsowanie i drzewa składniowe: jak SQL jest czytany

Gdy wysyłasz zapytanie, pierwszy krok przypomina front-end kompilatora. Silnik tokenizuje słowa kluczowe i identyfikatory, sprawdza składnię i buduje drzewo parsingu (często upraszczane do abstrakcyjnego drzewa składniowego). Tu łapane są podstawowe błędy: brakujące przecinki, niejednoznaczne nazwy kolumn, niepoprawne reguły grupowania.

Pomocny model: SQL to język programowania, którego „program” opisuje relacje danych zamiast pętli.

Od drzewa składniowego do operatorów logicznych

Kompilatory konwertują składnię do reprezentacji pośredniej (IR). Bazy robią podobnie: tłumaczą SQL na logiczne operatory takie jak:

- Selection (filtrowanie wierszy)\n- Projection (wybór kolumn)\n- Join (łączenie tabel)\n- Aggregacja (

GROUP BY)

Ta logiczna forma jest bliższa algebrze relacyjnej niż tekstowi SQL, co ułatwia rozumienie znaczenia i równoważności.

Dlaczego optymalizatory przypominają optymalizacje kompilatorów

Optymalizacje kompilatora zachowują wynik programu, jednocześnie czyniąc jego wykonanie tańszym. Optymalizatory baz danych robią to samo, używając systemów reguł takich jak:

- przepychanie filtrów wcześniej (mniej pracy wcześniej)\n- zmiana kolejności łączeń (ten sam wynik, inny koszt)\n- usuwanie zbędnych obliczeń

To jest baza danych w wersji "eliminacji martwego kodu": nie identyczne techniki, ale ta sama filozofia — zachowaj semantykę, zmniejsz koszt.

Debugowanie: czytaj plany jak skompilowany kod

Jeśli twoje zapytanie jest wolne, nie patrz tylko na SQL. Sprawdź plan zapytania tak, jakbyś analizował wynik kompilacji. Plan pokaże, co silnik faktycznie wybrał: kolejność łączeń, użycie indeksów i miejsca, gdzie spędza się czas.

Praktyczny wniosek: naucz się czytać EXPLAIN jak listing asemblera wydajności. To zamienia strojenie z zgadywania na debugowanie oparte na dowodach. Więcej o tym, jak wyrobić ten nawyk, zobacz wpis Practical Query Optimization Habits.

Teoria projektowania schematu, która wpływa na rzeczywistą wydajność

Dobra wydajność zapytań często zaczyna się zanim napiszesz SQL. Teoria projektowania schematu Ullmana (szczególnie normalizacja) dotyczy strukturyzowania danych tak, by baza mogła utrzymywać ich poprawność, przewidywalność i wydajność w miarę wzrostu.

Cele normalizacji (dlaczego istnieje)

Normalizacja ma na celu:\n

- Zmniejszyć anomalie (np. aktualizowanie adresu klienta w pięciu miejscach i przeoczenie jednego)\n- Poprawić spójność przez umieszczenie każdego faktu w jednym „miejscu”\n- Umożliwić wyrażanie ograniczeń (klucze, klucze obce), żeby silnik mógł wymuszać reguły zamiast polegać na kodzie aplikacji

Te korzyści z poprawności przekładają się na zyski wydajnościowe później: mniej zduplikowanych pól, mniejsze indeksy i mniej kosztownych aktualizacji.

Nie musisz uczyć się dowodów, by korzystać z idei:

- 1NF: przechowuj wartości w atomowych kolumnach (bez list oddzielonych przecinkami). Ułatwia to filtrowanie i indeksowanie.\n- 2NF: w tabelach z kluczem złożonym każda kolumna niekluczowa powinna zależeć od całego klucza (nie tylko od jego części). Zapobiega powtarzaniu atrybutów.\n- 3NF: kolumny niekluczowe powinny zależeć tylko od klucza, nie od innych kolumn niekluczowych. Zapobiega ukrytej duplikacji.\n- BCNF: ostrzejsza wersja 3NF, gdzie każdy wyznacznik jest kandydatem na klucz — przydatna, gdy „prawie unikalne” kolumny tworzą subtelne duplikaty.

Kiedy denormalizacja ma sens

Denormalizacja może być rozsądna, gdy:\n

- budujesz tabele analityczne (szerokie tabele faktów, raportowanie)\n- łączenia stają się wąskim gardłem i możesz zaakceptować kontrolowaną redundancję\n- optymalizujesz pod szybkie odczyty przy jasnych zasadach odświeżania (np. przebudowa nocna)

Kluczem jest świadome denormalizowanie z procesem utrzymania spójności duplikatów.

Jak wybory schematu wpływają na optymalizator i skalowanie

Projekt schematu kształtuje możliwości optymalizatora. Jasne klucze i klucze obce umożliwiają lepsze strategie łączeń, bezpieczniejsze przekształcenia i dokładniejsze estymaty kardynalności. Nadmierna redundancja może zaś zwiększyć indeksy i spowolnić zapisy, a kolumny wielowartościowe blokują efektywne predykaty. W miarę wzrostu wolumenów danych, te wczesne decyzje modelowe często mają większe znaczenie niż mikrooptymalizacje pojedynczego zapytania.

Jak teoria objawia się, gdy systemy skalują

Gdy system "skalował się", rzadko chodzi tylko o dodanie większych maszyn. Częściej trudność polega na tym, że to samo znaczenie zapytania trzeba zachować, podczas gdy silnik wybiera zupełnie inną strategię fizyczną, żeby utrzymać przewidywalne czasy wykonania. Nacisk Ullmana na formalne równoważności jest dokładnie tym, co pozwala na takie zmiany strategii bez zmiany wyników.

Skalowanie to często układ fizyczny + wybór planu

Przy małych rozmiarach wiele planów "działa". Przy skali różnica między skanowaniem tabeli, użyciem indeksu czy wykorzystaniem prekomputowanego wyniku może oznaczać różnicę między sekundami a godzinami. Strona teoretyczna ma znaczenie, bo optymalizator potrzebuje bezpiecznego zestawu reguł przepisywania (np. przepychanie filtrów wcześniej, zmiana kolejności łączeń), które nie zmienią odpowiedzi — nawet jeśli radykalnie zmienią wykonywaną pracę.

Partycjonowanie zmienia zapytanie, nawet jeśli SQL wygląda tak samo

Partycjonowanie (po dacie, kliencie, regionie itp.) dzieli jedną logiczną tabelę na wiele fizycznych części. To wpływa na planowanie:\n

- które partycje można pominąć (pruning)\n- czy łączenia dzieją się w obrębie partycji czy wymagają przesyłu danych między węzłami\n- czy grupowanie można wykonać lokalnie przed połączeniem wyników

Tekst SQL może być niezmieniony, ale najlepszy plan zależy teraz od rozmieszczenia wierszy.

Materializowane widoki: prekomputacja jako algebraiczne skróty

Materializowane widoki to w zasadzie „zapisane podwyrażenia”. Jeśli silnik może udowodnić, że twoje zapytanie pasuje do przechowanego wyniku (lub można je do niego przepisać), może zastąpić kosztowną pracę — np. powtarzające się łączenia i agregacje — szybkim odczytem. To myślenie algebry relacyjnej w praktyce: rozpoznaj równoważność, a potem ponownie użyj wyniku.

Cache: pomocny, ale nie naprawi złego kształtu pracy

Cache przyspiesza powtarzalne odczyty, ale nie uratuje zapytania, które musi zeskanować za dużo danych, przetworzyć ogromne pośrednie wyniki lub wykonać gigantyczne łączenie. Gdy pojawiają się problemy skali, naprawa często polega na: zmniejszeniu ilości dotykanych danych (układ/partycjonowanie), ograniczeniu powtarzanych obliczeń (materializowane widoki) lub zmianie planu — a nie tylko "dodaniu cache".

Praktyczne nawyki optymalizacyjne inspirowane Ullmanem

Wpływ Ullmana ujawnia się w prostym nastawieniu: traktuj wolne zapytanie jako zamiar, który baza może przepisać, a potem zweryfikuj, co naprawdę zrobiła. Nie musisz być teoretykiem, by skorzystać — wystarczy powtarzalna rutyna.

1) Czytaj plan EXPLAIN: na co patrzeć najpierw

Zacznij od części, które zwykle dominują czas wykonania:\n

- Metoda dostępu: czy silnik skanuje całą tabelę, gdy oczekiwałeś skoku po indeksie?\n- Szacunki vs. rzeczywistość (jeśli baza pokazuje oba): duże rozbieżności często wyjaśniają dziwne spowolnienia.\n- Kolejność łączeń: która tabela napędza łączenie i czy zaczyna od najbardziej selektywnego filtra?\n- Kosztowne operatory: sorty, budowy hash, duże zagnieżdżone pętle — to często mówią, gdzie leży cały ciężar.

Jeśli zrobisz tylko jedną rzecz, zidentyfikuj pierwszy operator, gdzie liczba wierszy wybucha. To zwykle źródło problemu.

2) Typowe antywzorce, które oszukują optymalizatory

Łatwe do napisania i zaskakująco kosztowne:

- Funkcje na kolumnach indeksowanych:

WHERE LOWER(email) = ... może uniemożliwić użycie indeksu (użyj znormalizowanej kolumny lub indeksu funkcyjnego, jeśli jest wspierany).\n- Brak predykatów: zapomniany zakres dat czy filtr najemcy zamienia celowane zapytanie w szeroki skan.\n- Przypadkowe cross joiny: brak warunku łączenia może pomnożyć wiersze i wymusić ogromne wyniki pośrednie.

Algebra relacyjna sugeruje dwie praktyczne rzeczy:\n

- Przepchnij filtry wcześniej: stosuj

WHERE przed łączeniami, gdy to możliwe, by zmniejszyć wejścia.\n- Ogranicz kolumny wcześnie: wybieraj tylko potrzebne kolumny (zwłaszcza przed łączeniami), by oszczędzić pamięć i I/O.

Dobra hipoteza brzmi: „To łączenie jest kosztowne, bo łączymy za dużo wierszy; jeśli przefiltrujemy orders do ostatnich 30 dni najpierw, wejście do łączenia się zmniejszy.”

4) Indeks, przepisać czy zmienić schemat?

Prosta reguła decyzyjna:\n

- Dodaj indeks, gdy zapytanie jest poprawne, selektywne i wykonywane wielokrotnie.\n- Przepisz zapytanie, gdy

EXPLAIN pokazuje uniknionalną pracę (zbędne łączenia, późne filtrowanie, predykaty nieużywające indeksu).\n- Zmień schemat, gdy wzorzec obciążenia jest stabilny i ciągle walczysz z tym samym wąskim gardłem (np. prekomputowane agregaty, denormalizowane pola wyszukiwań, partycjonowanie według czasu/tenantów).

Celem nie jest "sprytny SQL", lecz przewidywalne, mniejsze wyniki pośrednie — dokładnie tego typu ulepszeń, które ułatwiają dostrzec pomysły Ullmana.

Zastosowanie tych idei przy budowaniu realnych produktów

Te koncepcje nie są tylko dla administratorów baz. Jeśli wypuszczasz aplikację, podejmujesz decyzje dotyczące bazy i planowania zapytań, nawet jeśli o tym nie wiesz: kształt schematu, wybór kluczy, wzorce zapytań i warstwa dostępu do danych wpływają na to, co optymalizator może zrobić.

Jeśli korzystasz z workflowu typu vibe-coding (np. generowania aplikacji React + Go + PostgreSQL z interfejsu czatowego w Koder.ai), modele umysłowe Ullmana są praktyczną siatką bezpieczeństwa: możesz przejrzeć wygenerowany schemat pod kątem czystych kluczy i relacji, sprawdzić zapytania, na których opiera się aplikacja, i zweryfikować wydajność za pomocą EXPLAIN zanim problemy pojawią się w produkcji. Im szybciej iterujesz nad "intencja zapytania → plan → poprawka", tym więcej korzyści z przyspieszonego rozwoju.

Gdzie się uczyć więcej i jak to stosować w pracy

Nie musisz traktować teorii jako osobnego hobby. Najszybszy sposób, by skorzystać z fundamentów Ullmana, to nauczyć się tyle, by pewnie czytać plany zapytań — a potem ćwiczyć na własnej bazie.

Przyjazne dla początkujących materiały do wyszukania

Szukaj tych książek i tematów wykładów (brak afiliacji — po prostu często cytowane punkty startowe):

- "A First Course in Database Systems" (Ullman & Widom) — przystępne podstawy baz danych z praktycznym kontekstem.\n- "Principles of Database and Knowledge-Base Systems" (Ullman) — głębsza teoria, jeśli chcesz większej rygorystyczności.\n- "Compilers: Principles, Techniques, and Tools" (Aho, Lam, Sethi, Ullman) — żeby zrozumieć, dlaczego optymalizatory przypominają kompilatory.

Tematy wykładów do wyszukania: algebra relacyjna, przepisywanie zapytań, kolejność łączy, optymalizacja oparta na kosztach, indeksy i selektywność, parsowanie i języki zapytań.

Lekkie ścieżki nauki

Zacznij małymi krokami i trzymaj każdy etap przy czymś, co możesz zaobserwować:

- Algebra relacyjna: naucz się selekcji, projekcji, łączenia i reguł równoważności.\n2. Plany: ucz się czytać węzły planu (typy skanów, filtry, łączenia, sorty, agregaty).\n3. Łączenia: zrozum różnice między nested loop, hash join i merge join i kiedy który wygrywa.\n4. Modele kosztów: poznaj kilka wejść, które decydują (liczba wierszy, selektywność, I/O vs CPU).

Małe ćwiczenia, które dużo dają

Wybierz 2–3 prawdziwe zapytania i iteruj:\n

- Przepisz: zmień

IN na EXISTS, przepchnij predykaty wcześniej, usuń niepotrzebne kolumny, porównaj wyniki.\n- Porównaj plany: zapisz plany "przed/po" i zanotuj, co się zmieniło (kolejność łączeń, typ łączenia, typ skanu).\n- Modyfikuj indeksy: dodawaj/usuwaj pojedyncze indeksy i obserwuj estymaty vs. rzeczywiste liczby wierszy.

Komunikowanie ustaleń zespołowi

Używaj jasnego, opartego na planie języka:\n

- „Plan zmienił się z sekwencyjnego skanu na skan indeksu, bo filtr stał się selektywny.”\n- „Szacunki wierszy były 100× złe, więc optymalizator wybrał złą kolejność łączeń.”\n- „To przepisanie jest równoważne (ten sam wynik), ale umożliwia przepchnięcie predykatu i mniej wierszy do łączenia.”

To praktyczny zysk z fundamentów Ullmana: wspólne słownictwo do wyjaśniania wydajności — bez zgadywania.