Dlaczego Shannon wciąż ma znaczenie dla codziennej technologii

Korzystasz z idei Claude’a Shannona za każdym razem, gdy wysyłasz SMS, oglądasz wideo lub łączysz się z Wi‑Fi. Nie dlatego, że twój telefon „zna Shannona”, ale dlatego, że współczesne systemy cyfrowe opierają się na prostej obietnicy: możemy zamienić chaotyczne, realne wiadomości na bity, przesłać te bity przez niedoskonałe kanały i mimo to z dużą pewnością odtworzyć oryginalną treść.

Teoria informacji to matematyka wiadomości: ile wyboru (niepewności) zawiera komunikat, jak efektywnie można go przedstawić i jak niezawodnie można go przesłać, gdy w grę wchodzi szum, zakłócenia i przeciążenia.

Jest za tym matematyka, ale nie musisz być matematykiem, żeby złapać praktyczną intuicję. Użyjemy codziennych przykładów — jak to, dlaczego niektóre zdjęcia kompresują się lepiej od innych, albo dlaczego rozmowa może brzmieć dobrze nawet przy słabym sygnale — aby wyjaśnić idee bez ciężkich wzorów.

Cztery filary, które zobaczysz wszędzie

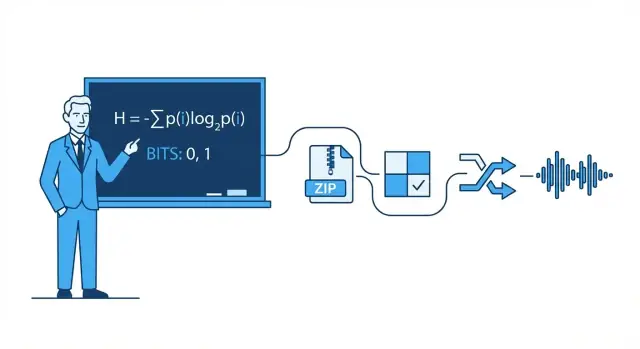

Ten tekst skupia się na czterech filarach inspirowanych Shannonem, które pojawiają się w nowoczesnej technologii:

- Kompresja: zmniejszanie danych (audio, wideo, pliki) bez utraty tego, co ważne.

- Korekcja błędów: dodawanie dokładnie tyle dodatkowych bitów, by wykryć i naprawić pomyłki.

- Niezawodność sieci: radzenie sobie z zgubionymi pakietami za pomocą retransmisji, porządkowania i kompromisów przepustowości.

- Komunikacja cyfrowa end-to-end: spojrzenie na cały łańcuch od źródła (twoja wiadomość) przez kanał (Wi‑Fi, komórkowa, światłowód) i z powrotem.

O czym będziesz umiał potem rozmawiać

Na koniec powinieneś umieć jasno rozważać realne kompromisy: dlaczego wyższa jakość wideo wymaga więcej przepustowości, dlaczego „więcej kresek” nie zawsze oznacza szybszy internet, dlaczego niektóre aplikacje wydają się natychmiastowe, a inne buforują, oraz dlaczego każdy system trafia na ograniczenia — szczególnie na słynną granicę Shannona w kwestii tego, ile niezawodnych danych można przepuścić przez kanał.

Claude Shannon na jednej stronie: główna myśl

W 1948 roku matematyk i inżynier Claude Shannon opublikował artykuł o niepozornym tytule A Mathematical Theory of Communication, który cicho przeorganizował sposób myślenia o przesyłaniu danych. Zamiast traktować komunikację jako sztukę, potraktował ją jako problem inżynieryjny: źródło produkuje wiadomości, kanał je przenosi, szum je zniekształca, a odbiorca stara się odtworzyć to, co wysłano.

Kluczowy ruch Shannona polegał na zdefiniowaniu informacji w sposób mierzalny i użyteczny dla maszyn. W jego ujęciu informacja nie dotyczy tego, jak ważna wydaje się wiadomość, co znaczy ani czy jest prawdziwa. Chodzi o to, jak zaskakująca jest — ile niepewności zostaje usunięte, gdy poznasz wynik.

Jeśli już wiesz, co się wydarzy, wiadomość niesie prawie żadnej informacji. Jeśli jesteś naprawdę niepewny, poznanie wyniku niesie więcej informacji.

Bit: najprostsza jednostka, którą da się policzyć

Aby mierzyć informację, Shannon spopularyzował bit (skrót od binary digit). Bit to ilość informacji potrzebna do rozstrzygnięcia prostej niepewności tak/nie.

Przykład: Jeśli pytam „Czy światło jest włączone?”, a nie masz żadnego pojęcia wcześniej, odpowiedź (tak lub nie) można uznać za dostarczającą 1 bita informacji. Wiele realnych wiadomości da się rozłożyć na długie sekwencje takich binarnych wyborów, dlatego wszystko — od tekstu, przez zdjęcia, po audio — można przechowywać i przesyłać jako bity.

Co ten tekst zrobi (i czego nie zrobi)

Ten artykuł koncentruje się na praktycznej intuicji stojącej za ideami Shannona i dlaczego pojawiają się one wszędzie: kompresja (zmniejszanie plików), korekcja błędów (naprawa zniekształceń), niezawodność sieci (retransmisje i przepustowość) oraz pojemność kanału (jak szybko można wysyłać dane przez zaszumiony łącze).

Nie przejdziemy przez ciężkie dowody. Nie potrzebujesz zaawansowanej matematyki, żeby złapać puentę: gdy potrafisz mierzyć informację, możesz projektować systemy zbliżające się do najlepszej możliwej wydajności — często zaskakująco blisko teoretycznych granic Shannona.

Bity, symbole i kody: praktyczne słownictwo

Zanim porozmawiamy o entropii, kompresji czy korekcji błędów, pomocne jest ustalenie kilku codziennych terminów. Idee Shannona są łatwiejsze, gdy potrafisz nazwać elementy.

Symbole, alfabet i wiadomości

Symbol to jeden „token” z ustalonego zbioru. Ten zbiór to alfabet. W tekście angielskim alfabet może być literami (plus spacja i interpunkcja). W pliku komputerowym alfabetem mogą być wartości bajtów 0–255.

Wiadomość to ciąg symboli z tego alfabetu: słowo, zdanie, plik zdjęcia lub strumień próbek audio.

Aby być konkretnym, wyobraź sobie maleńki alfabet: {A, B, C}. Wiadomość może wyglądać tak:

A A B C A B A ...

Bity i kody

Bit to cyfra binarna: 0 albo 1. Komputery przechowują i przesyłają bity, bo sprzęt potrafi niezawodnie rozróżnić dwa stany.

Kod to reguła reprezentowania symboli za pomocą bitów (lub innych symboli). Dla naszego alfabetu {A, B, C} jednym z możliwych kodów binarnych jest:

Teraz każdą wiadomość złożoną z A/B/C można zamienić na strumień bitów.

Kodowanie vs. kompresja vs. szyfrowanie

Te terminy bywają mieszane:

- Kodowanie: tłumaczenie danych na wybrany format, aby można je było przechowywać/przesyłać/przetwarzać (np. mapowanie A/B/C na bity albo konwersja tekstu do UTF‑8).

- Kompresja: kodowanie, które używa mniejszej średniej liczby bitów, wykorzystując wzorce i nierównomierne częstotliwości.

- Szyfrowanie: zaszyfrowanie danych kluczem, aby osoby z zewnątrz nie mogły ich odczytać; chodzi o poufność, nie o rozmiar.

Krótka intuicja prawdopodobieństwa

Rzeczywiste wiadomości nie są losowe: niektóre symbole pojawiają się częściej niż inne. Załóżmy, że A występuje 70% czasu, B 20%, C 10%. Dobry schemat kompresji da krótsze wzorce bitowe symbolom, które są częste (A) i dłuższe tym rzadkim (C). Ta „nierównomierność” to coś, co później opiszemy entropią.

Entropia: mierzenie zaskoczenia (i dlaczego przewiduje kompresowalność)

Najbardziej znana idea Shannona to entropia: sposób mierzenia, ile „zaskoczenia” ma źródło informacji. Nie chodzi o emocjonalne zaskoczenie — o nieprzewidywalność. Im mniej przewidywalny jest następny symbol, tym więcej informacji niesie, gdy się pojawi.

Entropia jako „średnie zaskoczenie”

Wyobraź sobie serię rzutów monetą.

- Uczciwa moneta (50/50): Każdy rzut jest trudny do przewidzenia. Orzeł jest równie prawdopodobny jak reszka, więc regularnie jesteś „zaskoczony” każdym wynikiem. To wysoka nieprzewidywalność i wysoka entropia.

- Obciążona moneta (np. 95% orzeł, 5% reszka): Większość rzutów to orzeł. Po kilku rzutach spodziewasz się orła, więc orzeł niesie mało nowej informacji. Tylko rzadka reszka jest zaskakująca. Średnio sekwencja ma niższą entropię.

To ujęcie „średniego zaskoczenia” pasuje do codziennych wzorców: plik tekstowy z powtarzającymi się spacjami i popularnymi słowami jest łatwiejszy do przewidzenia niż plik losowych znaków.

Dlaczego przewidywalność oznacza możliwość kompresji

Kompresja działa, przypisując krótsze kody częstym symbolom i dłuższe rzadkim. Jeśli źródło jest przewidywalne (niska entropia), możesz używać krótkich kodów najczęściej i oszczędzać miejsce. Jeśli źródło jest bliskie losowości (wysoka entropia), jest mniej miejsca na kurczenie, bo nic nie pojawia się wystarczająco często, by to wykorzystać.

Entropia i najlepsza możliwa średnia długość kodu

Shannon pokazał, że entropia ustala pojęciowy benchmark: to najlepszy dolny limit średniej liczby bitów na symbol, jaką możesz osiągnąć kodując dane z danego źródła.

Ważne: entropia nie jest algorytmem kompresji. Nie mówi dokładnie, jak skompresować plik. Mówi, co teoretycznie jest możliwe — i kiedy jesteś już blisko tej granicy.

Kompresja: przekształcanie entropii w mniejsze pliki

Kompresja występuje, gdy weźmiesz wiadomość, którą da się opisać mniejszą liczbą bitów, i rzeczywiście to zrobisz. Kluczowa obserwacja Shannona to fakt, że dane o niższej entropii (większa przewidywalność) mają „miejsce”, by się skurczyć, podczas gdy dane o wysokiej entropii (bliskie losowości) tego miejsca nie mają.

Dlaczego wzorce i nierównomierne częstotliwości dobrze się kompresują

Powtarzające się wzorce to oczywiste źródło oszczędności: jeśli plik zawiera te same sekwencje wielokrotnie, możesz przechować sekwencję raz i odnosić się do niej wiele razy. Nawet bez wyraźnych powtórzeń nierównomierne częstotliwości symboli pomagają.

Jeśli w tekście litera „e” występuje znacznie częściej niż „z”, albo w logu powtarzają się te same znaczniki czasu i słowa kluczowe, nie musisz poświęcać tej samej liczby bitów na każdy znak. Im bardziej nierównomierne częstotliwości, tym bardziej przewidywalne źródło i tym bardziej kompresowalne.

Kodowanie o zmiennej długości (główna intuicja)

Praktyczny sposób wykorzystania nierównomiernych częstotliwości to kodowanie o zmiennej długości:

- Częste symbole dostają krótkie kody

- Rzadkie symbole dostają długie kody

Wykonane ostrożnie, redukuje to średnią liczbę bitów na symbol bez utraty informacji.

Rzeczywiste bezstratne kompresory często łączą kilka pomysłów, ale zwykle spotkasz rodziny metod:

- Kodowanie Huffmana: buduje efektywny słownik „krótko-dla-częstych”.

- Kodowanie arytmetyczne: pakuje symbole w zakres ułamkowy, często dociskając bliżej granicy entropii.

- Metody LZ (Lempel–Ziv): znajdują powtarzające się podciągi i zastępują je referencjami (używane w formatach ZIP i podobnych).

Bezstratne vs. stratne (ZIP vs. JPEG/MP3)

Kompresja bezstratna odtwarza oryginał perfekcyjnie (np. ZIP, PNG). Jest niezbędna dla oprogramowania, dokumentów i wszystkiego, gdzie choćby jeden błędny bit ma znaczenie.

Kompresja stratna świadomie odrzuca informacje, które ludzie zwykle nie zauważają (np. zdjęcia JPEG, audio MP3/AAC). Cel przesuwa się z „te same bity z powrotem” na „to samo doznanie”, osiągając często znacznie mniejsze rozmiary przez usunięcie perceptualnie mało istotnych szczegółów.

Błędy się zdarzają: dlaczego redundancja jest użyteczna

Weryfikuj w produkcji

Wdróż i hostuj swój build, aby zobaczyć, jak zachowuje się w prawdziwych sieciach.

Każdy system cyfrowy opiera się na kruchej założeniu: 0 zostaje 0, a 1 zostaje 1. W rzeczywistości bity mogą się przepiąć.

Skąd biorą się błędy

W transmisji zakłócenia elektryczne, słaby sygnał Wi‑Fi czy szum radiowy mogą przesunąć sygnał za próg i odbiornik błędnie zinterpretuje bit. W pamięci drobne efekty fizyczne — zużycie pamięci flash, zarysowania na nośnikach optycznych, a nawet promieniowanie — mogą zmienić przechowywany ładunek lub stan magnetyczny.

Ponieważ błędy są nieuniknione, inżynierowie celowo dodają redundancję: dodatkowe bity, które nie niosą „nowej” informacji, ale pomagają wykryć lub naprawić uszkodzenia.

Prosta redundancja, której już używałeś

Bit parzystości (szybkie wykrywanie). Dodaj jeden bit tak, aby suma jedynek była parzysta (parzystość parzysta) lub nieparzysta. Jeśli jeden bit się zmieni, kontrola parzystości zawiedzie.

- Siła: tani i szybki.

- Ograniczenie: zwykle nie mówi który bit jest błędny; dwa przestawienia mogą się znosić i wyglądać na poprawne.

Suma kontrolna (lepsze wykrywanie dla bloków). Zamiast jednego bitu oblicz małą wartość podsumowującą pakiet lub plik (np. suma, CRC). Odbiorca przelicza i porównuje.

- Siła: wykrywa wiele błędów wielobitowych w bloku.

- Ograniczenie: nadal tylko wykrywanie; gdy zawiedzie, zwykle potrzebna jest retransmisja lub kopia zapasowa.

Kod powtarzania (prosta korekcja). Wyślij każdy bit trzy razy: 0 → 000, 1 → 111. Odbiorca stosuje głosowanie większościowe.

- Siła: potrafi skorygować pojedynczy przepięty bit w każdej grupie trzech.

- Ograniczenie: ekstremalnie nieefektywny — potraja ilość danych.

Wykrywanie vs. korekcja (kiedy używać którego)

Wykrywanie błędów odpowiada: „Czy coś poszło nie tak?” Jest powszechne, gdy retransmisje są tanie — jak w przypadku pakietów sieciowych, które można ponowić.

Korekcja błędów odpowiada: „Jakie były oryginalne bity?” Używa się jej, gdy retransmisje są drogie lub niemożliwe — np. streaming audio przez hałaśliwe łącze, komunikacja dalekiego zasięgu czy odczyt danych z nośnika, gdzie ponowny odczyt może nadal dawać błędy.

Redundancja może wydawać się marnotrawstwem, ale to dzięki niej współczesne systemy są szybkie i godne zaufania pomimo niedoskonałego sprzętu i zaszumionych kanałów.

Pojemność kanału i granica Shannona (bez ciężkiej matematyki)

Gdy wysyłasz dane przez rzeczywisty kanał — Wi‑Fi, sieć komórkową, kabel USB, a nawet dysk twardy — szum i zakłócenia mogą przepinać bity lub zamazywać symbole. Wielka obietnica Shannona była zaskakująca: możliwa jest niezawodna komunikacja, nawet przez zaszumione kanały, pod warunkiem że nie próbujesz przepchnąć przez nie zbyt dużo informacji.

Pojemność kanału prosto mówiąc

Pojemność kanału to „limit prędkości” kanału: maksymalna szybkość (bity na sekundę), z jaką możesz przesyłać, z błędami dążącymi niemal do zera, biorąc pod uwagę poziom szumu i ograniczenia jak pasmo czy moc.

To nie to samo co surowa szybkość symboli (jak szybko przełączasz sygnał). To raczej ile sensownej informacji przetrwa po zaszumieniu — po zastosowaniu inteligentnego kodowania, redundancji i dekodowania.

Granica Shannona: granica, za którą inżynierzy gonią

Granica Shannona to praktyczna nazwa tej granicy: poniżej niej teoretycznie można sprawić, że komunikacja będzie dowolnie niezawodna; powyżej niej nie można — błędy będą zawsze.

Inżynierowie wkładają wiele pracy, by zbliżyć się do tej granicy lepszą modulacją i kodami korekcyjnymi. Nowoczesne systemy jak LTE/5G i Wi‑Fi używają zaawansowanych kodów, by działać blisko tej granicy, zamiast marnować moc sygnału czy pasmo.

Kluczowy kompromis (szybkość vs. prawdopodobieństwo błędu)

Wyobraź to sobie jak pakowanie przedmiotów do jadącej ciężarówki po wyboistej drodze:

- Jeśli zapakujesz zbyt ciasno (prędkość ponad pojemność), niektóre przedmioty zawsze się stłuką (istnieje niezerowa stopa błędów).

- Jeśli zapakujesz z miejscem i wyściółką (prędkość poniżej pojemności), możesz sprawić, że uszkodzenia będą bardzo rzadkie — kosztem mniejszej przepustowości lub większej redundancji.

Shannon nie dał jednego „najlepszego kodu”, ale dowiódł, że granica istnieje — i warto dążyć do jej osiągnięcia.

Kody korekcyjne w realnych systemach

Szybko zbuduj prototyp

Przekuj te kompromisy Shannona w działającą aplikację, budując ją ze specyfikacji w rozmowie na Koder.ai.

Twierdzenie Shannona o kanale z szumem często streszcza się jako obietnicę: jeśli wysyłasz poniżej pojemności kanału, istnieją kody, które czynią błędy dowolnie rzadkimi. Inżynieria polega na przekształceniu tego „dowodu istnienia” w praktyczne schematy mieszczące się w układach, bateriach i terminach.

Praktyczne narzędzia: bloki, interleaving i lepsze odgadywanie

Większość rzeczywistych systemów używa kodów blokowych (chronią porcję bitów naraz) lub kodów strumieniowych (chronią bieżący strumień).

W kodach blokowych dodajesz starannie zaprojektowaną redundancję do każdego bloku, aby odbiorca mógł wykryć i skorygować błędy. Dzięki interleavingowi przetasowujesz kolejność bitów/symboli, by wybuchowy hałas (wiele błędów z rzędu) został rozproszony na mniejsze, możliwe do naprawienia błędy w wielu blokach — kluczowe w transmisjach bezprzewodowych i przechowywaniu.

Duży podział to sposób, w jaki odbiorca „decyduje”, co usłyszał:

- Decyzje twarde: każdy odebrany sygnał od razu staje się 0 albo 1.

- Decyzje miękkie: odbiorca zachowuje też pewność (np. „to prawdopodobnie 1, ale nie jestem pewien`).

Decyzje miękkie dostarczają dekoderowi więcej informacji i znacznie poprawiają niezawodność, zwłaszcza w Wi‑Fi i sieciach komórkowych.

Kody, których już używałeś

- Kody Reed–Solomon: działają na symbolach (nie na pojedynczych bitach) i świetnie radzą sobie z błędami skupionymi. Używane w kodach QR, CD/DVD oraz w niektórych systemach nadawczych i pamięci.

- Kody splotowe (convolutional): klasyczny wybór dla strumieni ciągłych; historycznie powszechne w łączach satelitarnych.

- Kody Turbo: duży skok w latach 90., szeroko stosowane w 3G/4G.

- LDPC (Low-Density Parity-Check): wysoce wydajne współczesne kody blokowe używane w Wi‑Fi, 5G i wielu systemach o dużej przepustowości.

Gdzie mają znaczenie

Od komunikacji międzyplanetarnej (gdzie retransmisja jest kosztowna lub niemożliwa), przez satellity, Wi‑Fi i 5G, kody korekcyjne są praktycznym mostem między teorią Shannona a realiami zaszumionych łączy — wymieniają dodatkowe bity i obliczenia na mniej zerwanych połączeń, szybsze pobieranie i bardziej niezawodne łącza.

Niezawodność sieci: pakiety, retransmisje i przepustowość

Internet działa, mimo że poszczególne łącza są niedoskonałe. Wi‑Fi zanika, sygnał komórkowy bywa blokowany, a miedź i światłowód też cierpią od szumu, zakłóceń i okazjonalnych usterek. Główne przesłanie Shannona — szum jest nieunikniony, ale niezawodność jest osiągalna — pojawia się w sieciach jako staranne połączenie wykrywania/korekcji błędów i retransmisji.

Pakiety: małe zakłady zamiast jednego wielkiego

Dane dzielone są na pakiety, aby sieć mogła ominąć problemy i odzyskać utraty bez ponownego wysyłania wszystkiego. Każdy pakiet niesie dodatkowe bity (nagłówki i sumy kontrolne), które pomagają odbiorcy zdecydować, czy to, co dotarło, jest godne zaufania.

Typowy wzorzec to ARQ (Automatic Repeat reQuest):

- Odbiorca sprawdza pakiet (zwykle sumą kontrolną/CRC).

- Jeśli wygląda dobrze, wysyła potwierdzenie (ACK).

- Jeśli go brakuje lub jest uszkodzony, nadawca retransmituje po upływie timeoutu (lub po otrzymaniu NAK).

Korekta vs. retransmisja: kompromis opóźnienia

Gdy pakiet jest błędny, masz dwie główne opcje:

- Skoryguj go teraz za pomocą korekcji w przód (FEC): dodaj wystarczającą redundancję, aby odbiorca mógł naprawić pewne błędy bez ponawiania wysyłki.

- Retransmituj używając ARQ: wysyłaj mniej redundancji z przodu, ale płać dodatkowym czasem, gdy coś pójdzie nie tak.

FEC może zmniejszyć opóźnienia na łączach, gdzie retransmisje są kosztowne (duże opóźnienie, sporadyczne zaniki). ARQ może być efektywny, gdy utraty są rzadkie, bo nie „obciążasz” każdego pakietu ciężką redundancją.

Przepustowość, przeciążenia i dlaczego niezawodność nie jest darmowa

Mechanizmy zapewniające niezawodność zużywają pojemność: dodatkowe bity, dodatkowe pakiety i dodatkowe czekanie. Retransmisje zwiększają obciążenie, co może pogorszyć przeciążenie; przeciążenie z kolei zwiększa opóźnienia i straty, wywołując jeszcze więcej powtórek.

Dobre projektowanie sieci to znalezienie równowagi: wystarczająco niezawodne dostarczenie poprawnych danych, przy niskim narzucie, aby sieć mogła utrzymać zdrową przepustowość przy zmieniających się warunkach.

Komunikacja cyfrowa end-to-end: od źródła do kanału

Użyteczny sposób rozumienia współczesnych systemów cyfrowych to potraktowanie ich jako pipeline z dwoma zadaniami: zmniejszyć wiadomość i sprawić, by wiadomość przetrwała podróż. Kluczowa idea Shannona jest taka, że często można myśleć o tych zadaniach jako o oddzielnych warstwach — choć realne produkty czasem je łączą.

Krok 1: kodowanie źródła (kompresja)

Zaczynasz od „źródła”: tekstu, audio, wideo, odczytów sensorów. Kodowanie źródła usuwa przewidywalną strukturę, aby nie marnować bitów. To może być ZIP dla plików, AAC/Opus dla audio albo H.264/AV1 dla wideo.

Kompresja to praktyczne pojawienie się entropii: im bardziej przewidywalna zawartość, tym mniej bitów potrzebujesz średnio.

Krok 2: kodowanie kanału (korekcja błędów)

Następnie skompresowane bity muszą pokonać zaszumiony kanał: Wi‑Fi, sieć komórkową, światłowód, kabel USB. Kodowanie kanału dodaje starannie zaprojektowaną redundancję, aby odbiorca mógł wykrywać i naprawiać błędy. To świat CRC, Reed–Solomon, LDPC i innych metod FEC.

Idea separacji Shannona (pomocny model myślowy)

Shannon pokazał, że teoretycznie można zaprojektować kodowanie źródła, aby zbliżyć się do najlepszej możliwej kompresji, i kodowanie kanału, aby zbliżyć się do najlepszej niezawodności do pojemności kanału — niezależnie.

W praktyce separacja ta nadal pomaga w debugowaniu systemów: jeśli wydajność jest słaba, możesz zapytać, czy tracisz efektywność w kompresji (kodowanie źródła), tracisz niezawodność na łączu (kodowanie kanału), czy płacisz za dużo opóźnień przez retransmisje i buforowanie.

Konkretny przykład: streaming wideo przez Wi‑Fi

Gdy strumieniujesz wideo, aplikacja używa kodeka do skompresowania klatek. Przez Wi‑Fi pakiety mogą być zgubione lub uszkodzone, więc system dodaje wykrywanie błędów, czasem FEC, a potem używa retransmisji (ARQ) gdy trzeba. Jeśli połączenie się pogarsza, odtwarzacz może przełączyć się na niższy bitrate.

Rzeczywiste systemy zacierają separację, bo czas ma znaczenie: czekanie na retransmisje powoduje buforowanie, a warunki radiowe mogą szybko się zmieniać. Dlatego stosy strumieniowe łączą wybory kompresji, redundancji i adaptacji razem — nie idealnie rozdzielone, ale wciąż prowadzone przez model Shannona.

Powszechne nieporozumienia i praktyczne kompromisy

Zarządzaj kodem źródłowym

Eksportuj źródła, gdy chcesz mieć pełną kontrolę nad kodekami, protokołami lub infrastrukturą.

Teoria informacji jest często cytowana, a niektóre idee bywają uproszczone. Oto popularne nieporozumienia — i rzeczywiste kompromisy, które inżynierowie podejmują przy budowie systemów kompresji, przechowywania i sieci.

Nieporozumienie 1: „Entropia oznacza losowość”

W mowie potocznej „losowy” może znaczyć „chaotyczny” lub „nieprzewidywalny”. Entropia Shannona jest węższa: mierzy zaskoczenie względem modelu prawdopodobieństwa.

- Perfekcyjnie przewidywalny strumień (np. same zera) ma niską entropię.

- Strumień trudny do przewidzenia biorąc pod uwagę to, co wiesz ma wyższą entropię.

Entropia to nie nastrój; to liczba związana z założeniami o zachowaniu źródła.

Nieporozumienie 2: „Większa kompresja zawsze lepsza”

Kompresja usuwa redundancję. Korekcja błędów często dodaje redundancję celowo, by odbiorca mógł naprawić uszkodzenia.

To tworzy praktyczne napięcie:

- Jeśli mocno skompresujesz, a potem wyślesz dane przez zaszumiony kanał, możesz mieć mniej „marginesu” do odzyskania uszkodzeń.

- Dobrze zaprojektowane systemy zwykle najpierw kompresują (usuwają przewidywalne wzorce), potem dodają uporządkowaną redundancję (kody korekcyjne) dla kanału.

Nieporozumienie 3: „Możemy być perfekcyjnie niezawodni przy dowolnej prędkości”

Pojemność kanału Shannona mówi, że każdy kanał ma maksymalną niezawodną przepustowość przy danym poziomie szumu. Poniżej tego limitu można uczynić stopę błędów ekstremalnie małą odpowiednimi kodami; powyżej niego błędy są nieuniknione bez względu na spryt.

Dlatego „perfekcyjna niezawodność przy dowolnej prędkości” nie jest możliwa: zwiększanie prędkości zwykle oznacza zgodę na większe prawdopodobieństwo błędu, większe opóźnienia (więcej retransmisji) lub większy narzut (mocniejsze kodowanie).

Prosta lista kontrolna dla realnych systemów

Gdy oceniasz produkt lub architekturę, zapytaj:

- Statystyki źródła: Czy dane są przewidywalne (tekst, logi) czy już bliskie losowości (zaszyfrowane, skompresowane)?

- Szum: Co może je uszkodzić — zakłócenia bezprzewodowe, degradacja pamięci, utrata pakietów?

- Budżet opóźnienia: Czy możesz pozwolić sobie na retransmisje i buforowanie, czy musi być w czasie rzeczywistym?

- Wybór narzutu: Czy wydajesz bity na oszczędności kompresji, korekcję błędów, retransmisje, czy jakąś mieszankę?

Dopasowanie tych czterech kwestii jest ważniejsze niż zapamiętywanie wzorów.

Najważniejsze wnioski i gdzie iść dalej

Główne przesłanie Shannona jest takie, że informację można mierzyć, przesyłać, chronić i kompresować za pomocą niewielkiego zestawu idei.

- Bit to wspólna waluta pozwalająca traktować tekst, audio, wideo i dane sensorów jednakowo po zakodowaniu.

- Entropia mierzy, jak nieprzewidywalne jest źródło i ta nieprzewidywalność przewiduje, jak dobrze dane można skompresować.

- Szum i straty są nieuniknione, więc systemy dodają redundancję przez wykrywanie błędów i kody korekcyjne.

- Pojemność kanału ustanawia realny sufit: powyżej pewnej szybkości nie można być niezawodnym — trzeba obniżyć prędkość, poprawić kanał lub zmienić kodowanie.

Współczesne sieci i systemy pamięci to nieustanne kompromisy między przepustowością, niezawodnością, opóźnieniem i mocą obliczeniową.

Praktyczna uwaga dla twórców

Jeśli budujesz rzeczywiste produkty — API, funkcje streamingu, aplikacje mobilne, pipeline’y telemetryczne — ramy Shannona to przydatna lista kontrolna projektowa: kompresuj to, co możesz, chroń to, co musisz, i bądź jawny co do budżetu opóźnień/przepustowości. Jedno miejsce, gdzie zobaczysz to od razu, to prototypowanie end-to-end i szybkie iteracje: na platformie vibe-coding takiej jak Koder.ai, zespoły mogą postawić aplikację React, backend w Go z PostgreSQL i nawet klienta Flutter ze specyfikacji prowadzonej rozmową, a następnie wcześnie testować rzeczywiste kompromisy (rozmiar ładunku, retransmisje, zachowanie buforowania). Funkcje takie jak tryb planowania, snapshoty i rollback ułatwiają eksperymenty z „silniejszą niezawodnością vs. niższy narzut” bez utraty impetu.

Kto powinien zgłębiać dalej

Głębsza lektura się opłaca dla:

- Studentów, którzy chcą czystego modelu łączącego prawdopodobieństwo z kompresją i kodowaniem

- Product managerów, podejmujących decyzje między jakością, opóźnieniami, przepustowością i kosztami

- Inżynierów pracujących nad sieciami, kodekami multimedialnymi, pamięcią, telemetryką lub pipeline’ami danych dla ML

Aby iść dalej, przeglądaj powiązane wyjaśnienia w /blog, potem sprawdź /docs, aby zobaczyć, jak nasz produkt udostępnia ustawienia i API związane z komunikacją i kompresją. Jeśli porównujesz plany lub limity przepustowości, /pricing jest kolejnym krokiem.