04 lis 2025·8 min

Vint Cerf, TCP/IP i wybory, które zbudowały Internet

Poznaj, jak decyzje Vinta Cerfa dotyczące TCP/IP umożliwiły interoperacyjne sieci, a później globalne platformy programowe — od e‑maila i WWW po aplikacje chmurowe.

Poznaj, jak decyzje Vinta Cerfa dotyczące TCP/IP umożliwiły interoperacyjne sieci, a później globalne platformy programowe — od e‑maila i WWW po aplikacje chmurowe.

Większość ludzi doświadcza Internetu poprzez produkty: stronę, która ładuje się błyskawicznie, rozmowę wideo, która (przeważnie) działa, płatność, która rozlicza się w kilka sekund. Pod tymi doświadczeniami kryją się protokoły — wspólne reguły, które pozwalają różnym systemom wymieniać komunikaty wystarczająco niezawodnie, by były użyteczne.

Protokół to jak uzgodnienie wspólnego języka i etykiety komunikacji: jak wygląda wiadomość, jak zaczynasz i kończysz rozmowę, co robisz, gdy czegoś brakuje, i jak wiesz, do kogo wiadomość jest skierowana. Bez wspólnych reguł każde połączenie staje się indywidualnymi negocjacjami, a sieci nie skalują się poza małe grupy.

Vint Cerf bywa nazywany „ojcem Internetu”, ale dokładniejsze (i bardziej przydatne) jest postrzeganie jego roli jako część zespołu, który dokonywał pragmatycznych wyborów — zwłaszcza wokół TCP/IP — które przemieniły „sieci” w internetwork. Te wybory nie były oczywiste ani nieuniknione. Odrzwierciedlały kompromisy: prostota kontra funkcje, elastyczność kontra kontrola oraz szybkość adopcji kontra idealne gwarancje.

Dzisiejsze globalne platformy — aplikacje webowe, usługi mobilne, infrastruktura w chmurze i API między firmami — wciąż żyją lub giną przez tę samą ideę: jeśli ustandaryzujesz właściwe granice, możesz pozwolić milionom niezależnych podmiotów budować nad nimi bez pytania o pozwolenie. Twój telefon może rozmawiać z serwerami na innych kontynentach nie tylko dlatego, że sprzęt stał się szybszy, ale dlatego, że zasady ruchu pozostały wystarczająco stabilne, by innowacja mogła się nakładać.

To podejście ma znaczenie nawet gdy „tylko budujesz oprogramowanie”. Na przykład platformy do szybkiego tworzenia, takie jak Koder.ai, odnoszą sukces, gdy oferują mały zestaw stabilnych prymitywów (projekty, wdrożenia, środowiska, integracje), pozwalając zespołom szybko iterować na krawędziach — czy to generując frontend w React, backend w Go + PostgreSQL, czy aplikację mobilną we Flutterze.

Skrótowo omówimy historię, ale skupimy się na decyzjach projektowych i ich konsekwencjach: jak warstwowanie umożliwiło wzrost, gdzie „wystarczająco dobre” dostarczanie otworzyło nowe zastosowania i jakie wczesne założenia błędnie oceniły przeciążenie i bezpieczeństwo. Cel jest praktyczny: weź myślenie protokołowe — jasne interfejsy, interoperacyjność i jawne kompromisy — i zastosuj je do współczesnego projektowania platform.

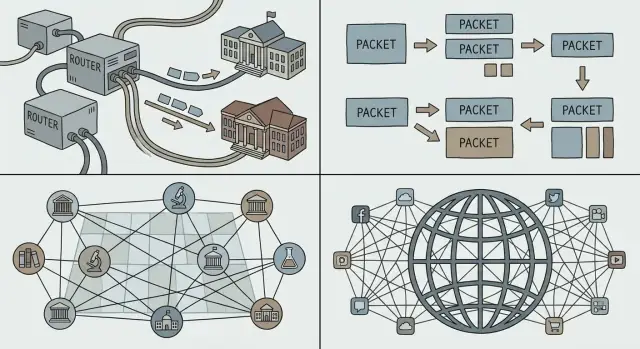

Zanim „Internet” stał się powszechny, istniało wiele sieci — ale nie jedna, z której wszyscy mogli korzystać. Uniwersytety, laboratoria rządowe i firmy budowały własne systemy, żeby rozwiązać lokalne potrzeby. Każda sieć działała, ale rzadko współpracowała z innymi.

Rozróżnienie sieci wynikało z praktycznych powodów, a nie z miłości do fragmentacji. Operatorzy mieli różne cele (badania, niezawodność wojskowa, usługi komercyjne), różne budżety i ograniczenia techniczne. Producenci sprzętu sprzedawali niekompatybilne systemy. Jedne sieci były zoptymalizowane pod łącza dalekiego zasięgu, inne pod środowiska kampusowe, jeszcze inne pod usługi specjalistyczne.

W rezultacie powstało wiele „wysp” łączności.

Jeśli chciałeś, aby dwie sieci ze sobą rozmawiały, brutalną opcją było przebudowanie jednej strony tak, by pasowała do drugiej. To rzadko się zdarza: jest kosztowne, powolne i politycznie skomplikowane.

Potrzebne było wspólne spoiwo — sposób, by niezależne sieci mogły się połączyć, zachowując swoje wewnętrzne wybory. To oznaczało:

To wyzwanie przygotowało grunt pod idee internetworkingu, które promowali Cerf i inni: łączyć sieci na wspólnej warstwie, by innowacja mogła dziać się powyżej niej, a różnorodność — poniżej.

Jeśli kiedykolwiek rozmawiałeś przez telefon, doświadczyłeś intuicji stojącej za przełączaniem obwodów: dedykowane „łącze” jest rezerwowane end-to-end na czas połączenia. Działa to dobrze dla stałego, czasu rzeczywistego głosu, ale jest marnotrawne, gdy rozmowa jest przerywana ciszą.

Przełączanie pakietów odwraca ten model. Analogią jest usługa pocztowa: zamiast rezerwować prywatną autostradę od twojego domu do przyjaciela, wkładasz wiadomość do kopert. Każda koperta (pakiet) jest oznaczona, kierowana przez współdzielone drogi i składana ponownie u odbiorcy.

Większość ruchu komputerowego jest wybuchowa. E‑mail, pobieranie pliku czy strona WWW to nie ciągły strumień, a szybkie wybuchy danych. Przełączanie pakietów pozwala wielu osobom efektywnie współdzielić te same łącza, ponieważ sieć przesyła pakiety tych, którzy mają coś do wysłania w danym momencie.

To kluczowy powód, dla którego Internet mógł wspierać nowe aplikacje bez renegocjacji działania warstwy sieciowej: możesz wysłać malutką wiadomość lub ogromne wideo tą samą metodą — podzielić na pakiety i wysłać.

Pakiety skalują się też społecznie, nie tylko technicznie. Różne sieci (uczelniane, firmowe, rządowe) mogą się łączyć, jeśli zgadzają się, jak przekazywać pakiety. Żaden pojedynczy operator nie musi „posiadać” całej ścieżki — każdy domena może przenieść ruch do następnej.

Ponieważ pakiety współdzielą łącza, mogą pojawić się opóźnienia kolejkowania, jitter lub nawet utrata pakietów, gdy sieci są zajęte. Te wady wymusiły mechanizmy kontroli — retransmisje, ustawianie kolejności i kontrolę przeciążeń — aby przełączanie pakietów pozostało szybkie i sprawiedliwe nawet przy dużym obciążeniu.

Cel, do którego dążyli Cerf i współpracownicy, nie brzmiał „zbuduj jedną sieć”. Chodziło o połączenie wielu sieci — uniwersyteckich, rządowych, komercyjnych — przy jednoczesnym zachowaniu ich technologii, operatorów i zasad.

TCP/IP często opisuje się jako „zestaw protokołów”, ale kluczowym ruchem projektowym było rozdzielenie odpowiedzialności:

Ten podział pozwolił „internetowi” działać jako wspólne podłoże dostawcze, podczas gdy niezawodność stała się opcjonalną usługą nakładaną ponad nim.

Warstwowanie ułatwia ewolucję systemów, bo możesz zaktualizować jedną warstwę bez renegocjowania wszystkiego powyżej. Nowe łącza fizyczne (światłowód, Wi‑Fi, sieci komórkowe), strategie routingu i mechanizmy bezpieczeństwa mogły pojawiać się z czasem — a aplikacje nadal mówiły TCP/IP i działały.

To ten sam wzorzec, na którym polegają zespoły platformowe: stabilne interfejsy, wymienne wnętrza.

IP nie obiecuje doskonałości; daje proste, uniwersalne prymitywy: „oto pakiet” i „oto adres”. Ta powściągliwość pozwoliła rozkwitnąć nieprzewidzianym zastosowaniom — e‑mailowi, WWW, streamingu, czatom w czasie rzeczywistym — ponieważ innowatorzy mogli budować to, czego potrzebowali na krawędziach, bez proszenia sieci o pozwolenie.

Jeśli projektujesz platformę, to użyteczny test: czy oferujesz kilka niezawodnych klocków konstrukcyjnych, czy nadmiernie dopasowujesz system do ulubionego przypadku użycia z dziś?

„Best-effort” to prosta idea: IP będzie próbować przemieścić twoje pakiety do celu, ale nie obiecuje, że dotrą, że będą w kolejności czy na czas. Pakiety mogą być odrzucone, opóźnione lub poprowadzone różnymi trasami.

Ta prostota była funkcją, nie wadą. Różne organizacje mogły łączyć bardzo różne sieci — drogie, wysokiej jakości łącza w niektórych miejscach i hałaśliwe, niskopasmowe połączenia w innych — bez wymogu ujednolicenia do tej samej premium infrastruktury.

Best‑effort IP obniżył „cenę wejścia” do uczestnictwa. Uniwersytety, rządy, startupy, a w końcu gospodarstwa domowe mogły dołączyć, korzystając z dostępnej im łączności. Gdyby protokół bazowy wymagał ścisłych gwarancji od każdej sieci na ścieżce, adopcja utknęłaby: najsłabsze ogniwo blokowałoby cały łańcuch.

Zamiast budować idealnie niezawodne jądro, Internet przesunął odpowiedzialność za niezawodność do hostów (urządzeń na końcach). Jeśli aplikacja potrzebuje poprawności — jak transfer plików, płatności czy załadowanie strony — może użyć protokołów i logiki na krawędziach, by wykrywać utratę i odzyskiwać:

TCP jest klasycznym przykładem: przemienia zawodną usługę pakietową w niezawodny strumień, wykonując ciężką pracę na końcach.

Dla zespołów platformowych best‑effort IP stworzył przewidywalne fundamenty: wszędzie na świecie możesz założyć tę samą podstawową usługę — wysyłasz pakiety na adres i zwykle dochodzą. Ta spójność umożliwiła budowę globalnych platform programowych, które zachowują się podobnie w różnych krajach, sieciach i na różnych urządzeniach.

Zasada end-to-end to pozornie prosta idea: utrzymuj „rdzeń” sieci jak najprostszym i przenieś inteligencję na krawędzie — do urządzeń i aplikacji.

Dla twórców oprogramowania to rozdzielenie było prezentem. Jeśli sieć nie musi rozumieć twojej aplikacji, możesz wypuścić nowe pomysły bez negocjowania zmian z każdym operatorem sieci.

Ta elastyczność jest dużym powodem, dla którego globalne platformy mogły szybko iterować: e‑mail, WWW, głos/wideo, a potem aplikacje mobilne — wszystko działało na tej samej infrastrukturze.

Prosty rdzeń oznacza też, że rdzeń domyślnie nie chroni. Jeśli sieć tylko przekazuje pakiety, łatwiej jest atakującym i nadużywającym wykorzystać tę samą otwartość do spamu, skanowania, ataków DDoS i oszustw.

Jakość usługi to kolejna napięta kwestia. Użytkownicy oczekują płynnych rozmów wideo i natychmiastowych reakcji, ale best‑effort może dawać jitter, przeciążenia i niejednolite działanie. Podejście end‑to‑end przenosi wiele poprawek w górę: logika ponawiania, buforowanie, adaptacja bitrate'u i priorytetyzacja na poziomie aplikacji.

Wielu elementów, które dziś uważamy za „Internet”, nie zrobiono w rdzeniu, lecz warstwując je:

Nawet funkcje przypominające „sieć” — ochrona przed botami, łagodzenie DDoS czy przyspieszanie wydajności — często są dostarczane jako usługi platformowe na krawędzi, a nie w samym IP.

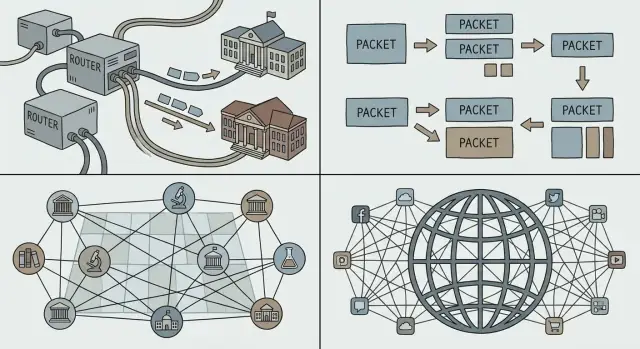

Sieć może stać się „globalna” wtedy, gdy każde urządzenie może być osiągnięte w wystarczająco niezawodny sposób, bez wymagania, żeby każdy uczestnik znał wszystkich innych. To zadanie adresowania, trasowania i DNS: trzy idee, które zamieniają zbiór połączonych sieci w coś, z czego ludzie (i oprogramowanie) mogą realnie korzystać.

Adres to identyfikator mówiący sieci, gdzie coś się znajduje. W IP „gdzie” wyrażone jest w ustrukturyzowanej, numerycznej formie.

Trasowanie to proces wybierania, jak przesunąć pakiet w stronę tego adresu. Routery nie potrzebują pełnej mapy wszystkich maszyn świata; potrzebują wystarczająco informacji, by przekazywać ruch krok po kroku we właściwym kierunku.

Kluczowe jest to, że decyzje przekazywania mogą być lokalne i szybkie, a efekt globalny nadal wygląda jak osiągalność wszędzie.

Gdyby każdy adres urządzenia musiał być wymieniony wszędzie, Internet załamałby się pod własną księgowością. Hierarchiczne adresowanie pozwala grupować adresy (np. według sieci lub dostawcy), dzięki czemu routery mogą trzymać agregowane trasy — jedno wpisy, który reprezentuje wiele miejsc.

To nieefektowna, lecz kluczowa tajemnica wzrostu: mniejsze tablice routingu, mniej aktualizacji i prostsza koordynacja między organizacjami. Agregacja to też powód, dla którego polityki przydziału adresów IP mają znaczenie dla operatorów: wpływają bezpośrednio na koszty utrzymania globalnej spójności.

Ludzie nie chcą wpisywać liczb, a usługi nie chcą być trwale przypisane do jednej maszyny. DNS (Domain Name System) to warstwa nazw, która mapuje czytelne nazwy (jak api.example.com) na adresy IP.

Dla zespołów platformowych DNS to więcej niż wygoda:

Innymi słowy: adresowanie i trasowanie czynią Internet osiągalnym; DNS czyni go użytecznym i operacyjnie elastycznym na poziomie platform.

Protokół staje się „Internetem”, gdy wiele niezależnych sieci i produktów może go używać bez pytania o zgodę. Jednym z najmądrzejszych wyborów wokół TCP/IP nie była tylko technika — była społeczna: publikuj specyfikacje, zapraszaj krytykę i pozwól każdemu je implementować.

Seria Request for Comments (RFC) zamieniła pomysły sieciowe w wspólne, cytowalne dokumenty. Zamiast standardu‑czarnej skrzynki kontrolowanej przez jednego dostawcę, RFC uczyniły reguły widocznymi: co oznacza każde pole, co robić w skrajnych przypadkach i jak zachować kompatybilność.

Ta otwartość zrobiła dwie rzeczy. Po pierwsze — zmniejszyła ryzyko dla adopcji: uczelnie, rządy i firmy mogły ocenić projekt i zaimplementować go. Po drugie — stworzyła wspólny punkt odniesienia, więc spory można było rozstrzygać poprzez aktualizacje tekstu, a nie prywatne negocjacje.

Interoperacyjność to to, co sprawia, że „wielodostawczy” model działa. Gdy różne routery, systemy operacyjne i aplikacje wymieniają ruch przewidywalnie, klienci nie są więzieni. Konkurencja przesuwa się z pytania „do której sieci możesz dołączyć?” na „czyj produkt jest lepszy?” — co przyspiesza ulepszenia i obniża koszty.

Zgodność tworzy też efekty sieciowe: każda nowa implementacja TCP/IP zwiększa wartość całej sieci, bo może rozmawiać ze wszystkimi innymi. Więcej użytkowników przyciąga więcej usług; więcej usług przyciąga więcej użytkowników.

Otwarte standardy nie likwidują tarcia — przekształcają je. RFC to debata, koordynacja i czasem powolna zmiana, szczególnie gdy miliardy urządzeń zależą od obecnego zachowania. Zaletą jest to, że zmiana, gdy nastąpi, jest czytelna i szeroko wykonalna — zachowując główną korzyść: wszyscy nadal mogą się łączyć.

Mówiąc „platforma”, zwykle mamy na myśli produkt, na którym inni budują: aplikacje zewnętrzne, integracje i usługi działające na wspólnych szynach. W Internecie tymi szynami nie była prywatna sieć jednej firmy, lecz powszechne protokoły, które każdy mógł zaimplementować.

TCP/IP nie stworzył samego WWW, chmury ani sklepów z aplikacjami — ale dał stabilne, uniwersalne podłoże, na którym te rzeczy mogły się rozprzestrzenić.

Gdy sieci mogły się łączyć przez IP, a aplikacje polegać na TCP dla dostawy, stało się praktyczne standaryzowanie wyższych klocków konstrukcyjnych:

Podarunkiem TCP/IP dla ekonomii platform była przewidywalność: zbuduj raz, osiągnij wiele sieci, krajów i typów urządzeń bez negocjowania niestandardowych połączeń za każdym razem.

Platforma rośnie szybciej, gdy użytkownicy i deweloperzy czują, że mogą odejść — albo przynajmniej nie są uwięzieni. Otwarte, szeroko wdrożone protokoły redukują koszty zmiany, bo:

Ta „bez‑pozwolenia” interoperacyjność pozwoliła rynkom oprogramowania globalnego rozwijać się wokół wspólnych standardów, a nie jednego właściciela sieci.

Leżą one powyżej TCP/IP, ale zależą od tej samej idei: jeśli reguły są stabilne i publiczne, platformy konkurują produktem — nie łamiąc przy tym zdolności do łączenia się.

Magia Internetu polega na tym, że działa przez oceany, sieci mobilne, hotspoty Wi‑Fi i przeciążone routery biurowe. Mniej magiczna prawda: zawsze działa w warunkach ograniczeń. Pasmo jest ograniczone, opóźnienie się zmienia, pakiety giną lub są przearanżowane, a przeciążenie może pojawić się nagle, gdy wiele osób dzieli tę samą ścieżkę.

Nawet jeśli twoja usługa jest „w chmurze”, użytkownicy doświadczają jej przez najwęższe miejsce na trasie do nich. Rozmowa wideo przez światłowód i ta sama rozmowa w zatłoczonym pociągu to różne produkty, bo opóźnienie, jitter i utrata kształtują odbiór użytkownika.

Gdy za dużo ruchu uderza w te same łącza, tworzą się kolejki i pakiety odpadają. Jeśli każdy nadawca reaguje, wysyłając jeszcze więcej (lub retryuje zbyt agresywnie), sieć może wpadać w kolaps przeciążeniowy — dużo ruchu, mało skutecznej dostawy.

Kontrola przeciążenia to zachowania, które utrzymują współdzielenie uczciwym i stabilnym: sondowanie dostępnej przepustowości, zwalnianie przy sygnałach przeciążenia (utrata/opóźnienie), a potem ostrożne przyspieszanie. TCP spopularyzował rytm „odstąp, potem odzyskaj”, by sieć mogła pozostać prostą, podczas gdy końcówki się adaptują.

Ponieważ sieci są niedoskonałe, udane aplikacje wykonują dodatkową pracę:

Projektuj, jakby sieć miała zawodzić krótko i często:

Odporność to nie dodatek — to cena operowania w skali Internetu.

TCP/IP odniósł sukces, bo ułatwił każdej sieci połączenie z dowolną inną. Ukrytym kosztem tej otwartości jest to, że każdy także może wysyłać do ciebie ruch — dobry lub zły.

Wczesny projekt internetu zakładał stosunkowo małą, badawczą społeczność. Gdy sieć stała się publiczna, ta sama filozofia „po prostu przekazuj pakiety” umożliwiła spam, oszustwa, malware, ataki DDoS i podszywanie się. IP nie weryfikuje tożsamości. E‑mail (SMTP) nie wymagał dowodu, że jesteś właścicielem adresu w polu "From". Routery nie były projektowane do oceniania intencji.

Gdy internet stał się infrastrukturą krytyczną, bezpieczeństwo przestało być funkcją do doklejenia i stało się wymogiem konstrukcyjnym: tożsamość, poufność, integralność i dostępność potrzebowały jawnych mechanizmów. Sieć pozostała w większości best‑effort i neutralna, ale aplikacje i platformy musiały zakładać, że kabel jest niezaufany.

Nie „naprawiliśmy” IP, czyniąc go policjantem pakietów. Zamiast tego nowoczesne bezpieczeństwo jest warstwowane nad nim:

Traktuj sieć jako wrogą domyślnie. Stosuj zasadę najmniejszych uprawnień: wąskie zakresy, krótkotrwałe poświadczenia i bezpieczne domyślne ustawienia. Weryfikuj tożsamości i dane na każdym styku, szyfruj w tranzycie i projektuj na przypadki nadużyć, nie tylko na ścieżki szczęścia.

Internet „wygrał” nie dlatego, że wszystkie sieci zgodziły się na ten sam sprzęt, dostawcę czy idealny zestaw funkcji. Przetrwał, ponieważ kluczowe wybory protokołowe ułatwiły niezależnym systemom łączenie się, rozwijanie i dalsze działanie nawet przy awariach części.

Warstwowanie z jasnymi szwami. TCP/IP oddzieliło „przesyłanie pakietów” od „czynić aplikacje niezawodnymi.” Ta granica pozwoliła sieci pozostać ogólnego przeznaczenia, podczas gdy aplikacje szybko ewoluowały.

Prostota w rdzeniu. Best‑effort oznaczał, że sieć nie musiała rozumieć każdej potrzeby aplikacji. Innowacja działo się na krawędziach, gdzie nowe produkty mogły być wypuszczane bez negocjacji z centralnym autorytetem.

Interoperacyjność jako priorytet. Otwarte specyfikacje i przewidywalne zachowanie sprawiły, że różne organizacje mogły budować kompatybilne implementacje — co stworzyło narastającą pętlę adopcji.

Jeśli budujesz platformę, traktuj współdziałanie jako funkcję, a nie efekt uboczny. Preferuj mały zestaw prymitywów, które wiele zespołów może komponować, zamiast dużej liczby „inteligentnych” funkcji, które wiążą użytkowników jedną ścieżką.

Projektuj na ewolucję: zakładaj, że klienci będą starzy, serwery nowe, a niektóre zależności częściowo niedostępne. Twoja platforma powinna gracefully degrade i nadal być użyteczna.

Jeśli używasz środowiska szybkiego budowania jak Koder.ai, te same zasady manifestują się jako możliwości produktu: jasny etap planowania (żeby interfejsy były jawne), bezpieczne iteracje przez snapshoty/rollback oraz przewidywalne zachowanie wdrożeń, które pozwala wielu zespołom działać szybko bez łamania konsumentów.

Protokół to wspólny zestaw reguł określających, jak systemy formatują wiadomości, rozpoczynają i kończą wymiany, radzą sobie z brakującymi danymi i jak identyfikować odbiorcę. Platformy polegają na protokołach, ponieważ sprawiają, że interoperacyjność jest przewidywalna — dzięki temu niezależne zespoły i dostawcy mogą integrować się bez indywidualnych, jednorazowych uzgodnień.

Internetworking polega na łączeniu wielu niezależnych sieci tak, aby pakiety mogły przechodzić przez nie jako jedna podróż od początku do końca. Kluczowym problemem było osiągnięcie tego bez zmuszania którejkolwiek sieci do przepisania swoich wewnętrznych rozwiązań, dlatego wspólna warstwa (IP) stała się tak istotna.

Przełączanie pakietów dzieli dane na pakiety, które współdzielą łącza sieciowe z innym ruchem — jest to efektywne dla przerywanego, „wybuchowego” ruchu komputerowego. Przełączanie obwodów (circuit switching) rezerwuje dedykowaną ścieżkę na czas połączenia, co może marnować zasoby, gdy ruch jest przerywany (jak większość ruchu webowego i aplikacyjnego).

IP zajmuje się adresowaniem i trasowaniem (przesyłaniem pakietów krok po kroku). TCP działa nad IP i zapewnia niezawodność tam, gdzie jest potrzebna (kolejność, retransmisje, mechanizmy sterowania przepływem). To rozdzielenie pozwala sieci pozostać ogólnego przeznaczenia, a aplikacjom wybierać wymagane gwarancje dostawy.

„Best-effort” oznacza, że IP próbuje dostarczyć pakiety, ale nie gwarantuje ich dotarcia, kolejności ani czasu dostawy. Ta prostota obniżyła próg wejścia dla sieci, ponieważ nie wymagała od wszystkich fragmentów ścieżki zapewniania rygorystycznych gwarancji — to przyspieszyło adopcję i uczyniło globalne połączenia wykonalnymi nawet przy niedoskonałej infrastrukturze.

Zasada end-to-end mówi, by rdzeń sieci pozostał jak najprostszy, a inteligencję przenieść do końców — urządzeń i aplikacji. Korzyścią jest szybsza innowacja na krawędzi; kosztem jest to, że aplikacje muszą wprost obsługiwać błędy, nadużycia i zmienność warunków sieciowych.

Adresy identyfikują miejsce przeznaczenia; trasowanie decyduje, który następny skok przybliża pakiet do celu. Hierarchiczne adresowanie umożliwia agregację tras, co utrzymuje tablice routingu na rozsądnym rozmiarze i sprawia, że skala działania jest praktyczna. Słaba agregacja zwiększa złożoność operacyjną i obciążenie systemu routingu.

DNS mapuje przyjazne nazwy (np. api.example.com) na adresy IP i może zmieniać te mapowania bez potrzeby zmiany konfiguracji klientów. Platformy używają DNS do kierowania ruchu, wdrożeń wieloregionowych i strategii awaryjnego przełączenia — nazwa pozostaje stabilna, podczas gdy infrastruktura pod spodem się zmienia.

RFC publikują zachowanie protokołów otwarcie, dzięki czemu każdy może je zaimplementować i testować zgodność. Ta otwartość zmniejsza zależność od jednego dostawcy, zwiększa interoperacyjność między producentami i tworzy efekty sieciowe: każda kompatybilna implementacja zwiększa wartość całego ekosystemu.

Projektuj tak, jakby sieć miała zawodzić:

Te praktyki wynikają bezpośrednio z doświadczeń protokołowych i są podstawą odporności i bezpieczeństwa platform.