Jak wygląda „czystsza architektura” przy pracy wspomaganej AI

„Czystsza architektura” w tym wpisie nie oznacza konkretnego frameworka ani idealnego diagramu. Chodzi o to, żebyś potrafił prosto wyjaśnić system, zmieniać go bez łamania niezwiązanych fragmentów oraz weryfikować zachowanie bez heroicznych testów.

Praktyczna definicja: jasność, modularność, testowalność

Jasność oznacza, że cel i kształt systemu są oczywiste z krótkiego opisu: co robi, kto go używa, jakimi danymi operuje i czego absolutnie nie powinien robić. W pracy wspomaganej AI jasność to także zdolność modelu do przeformułowania wymagań w sposób, który mógłbyś zatwierdzić.

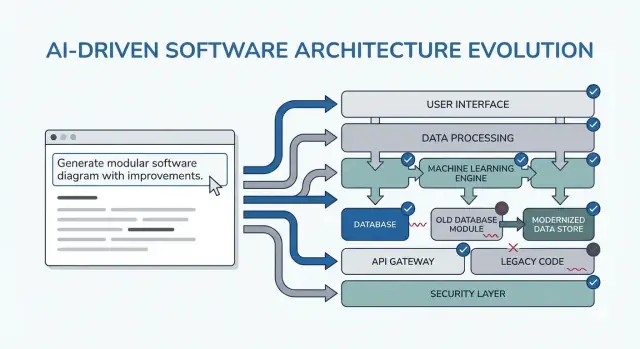

Modularność oznacza, że odpowiedzialności mają wyraźne granice. Każdy moduł ma zadanie, wejścia/wyjścia i minimalną wiedzę o wnętrzu innych modułów. Kiedy AI generuje kod, modularność zatrzymuje rozprzestrzenianie się reguł biznesowych po kontrolerach, UI i dostępie do danych.

Testowalność oznacza, że architektura sprawia, iż „udowodnij, że działa” jest tanie. Reguły biznesowe można testować bez uruchamiania całego systemu, a testy integracyjne skupiają się na kilku kontraktach zamiast na każdej ścieżce kodu.

Dlaczego dochodzi do przepisów (i jak AI może to wzmocnić)

Przepisywania rzadko wynikają z samego „złego kodu” — zazwyczaj są efektem braku ograniczeń, niejasnego zakresu i ukrytych założeń. Przykłady:

- Funkcja została zbudowana dla jednego typu użytkownika, a potem odkryto trzy role z różnymi uprawnieniami.

- Wymagania dotyczące wydajności, logowania audytu lub retencji danych pojawiają się późno.

- Zewnętrzne API zachowuje się inaczej niż oczekiwano, co wymusza zmiany wszędzie.

AI może przyspieszyć ten tryb porażki, generując przekonujące wyniki szybko — łatwo wtedy zbudować na chwiejnych podstawach.

Czego możesz oczekiwać od wzorców w tym przewodniku

Przedstawione wzorce to szablony do adaptacji, a nie magiczne prompty. Ich prawdziwy cel to wywołanie właściwych rozmów wcześnie: doprecyzować ograniczenia, porównać opcje, udokumentować założenia i zdefiniować kontrakty. Jeżeli pominiesz to myślenie, model z chęcią wypełni luki — a później zapłacisz za to przebudowami.

Gdzie te wzorce pasują w Twoim workflow

Będziesz ich używać w całym cyklu dostarczania:

- Planowanie: doprecyzowanie wymagań i kryteriów sukcesu

- Projektowanie: wybór granic, przepływów danych i kontraktów

- Kodowanie: utrzymanie separacji odpowiedzialności w miarę rozwoju implementacji

- Przegląd: wykrywanie ryzyk i niezgodności zanim staną się przepisami

Jeśli korzystasz z workflow opartego na vibe-coding (gdzie system generuje i iteruje się przez chat), te checkpointy są jeszcze ważniejsze. Na przykład w Koder.ai możesz uruchomić tryb „planning mode”, aby zamknąć wymagania i kontrakty przed wygenerowaniem kodu React/Go/PostgreSQL, a potem użyć snapshotów/rollbacku, by bezpiecznie iterować, gdy założenia się zmieniają — bez przekształcania każdej zmiany w przepisywanie.

Jak używać wzorców promptów, by nie tworzyć dodatkowej pracy

Wzorce promptów są najbardziej wartościowe, gdy zmniejszają liczbę decyzji do podjęcia. Sztuczka to wykorzystywać je jako krótkie, powtarzalne checkpointy — przed kodowaniem, podczas projektowania i w trakcie przeglądu — tak, żeby AI produkowało artefakty, które można ponownie użyć, a nie dodatkowy tekst do przesiać.

Kiedy używać wzorców

Przed kodowaniem: przeprowadź jedną pętlę „alignment”, aby potwierdzić cele, użytkowników, ograniczenia i metryki sukcesu.

W trakcie projektowania: stosuj wzorce wymuszające jawne kompromisy (np. alternatywy, ryzyka, granice danych) zanim zaczniesz implementować.

Podczas przeglądu: użyj promptu w formie checklisty, aby wychwycić luki (przypadki brzegowe, monitoring, bezpieczeństwo, wydajność) póki zmiany są tanie.

Najpierw zbierz dane wejściowe (utrzymaj to lekkie)

Uzyskasz lepsze wyniki z małym, spójnym pakietem wejściowym:

- Cele: co oznacza „gotowe” (cele latencji, wyniki UX, limity kosztów)

- Użytkownicy: role, kluczowe ścieżki i główne bolączki

- Ograniczenia: stos technologiczny, terminy, wymagania zgodności/bezpieczeństwa

- Dane i integracje: źródła, właściciele, API, zależności zewnętrzne

Jeśli czegoś nie wiesz, powiedz to jawnie i poproś AI o wylistowanie założeń.

Zamiast „wyjaśnij projekt”, poproś o artefakty, które możesz wkleić do dokumentów lub ticketów:

- dziennik decyzji (opcje → plusy/minusy → wybór → dlaczego)

- tabela komponentów z odpowiedzialnościami i granicami

- checklista dla niezawodności i testowania

- prosty opis diagramu (np. tekst Mermaid), który można później wyrenderować

Iteruj w krótkich pętlach z kryteriami akceptacji

Rób 10–15 minutowe pętle: prompt → przejrzenie → doprecyzowanie. Zawsze dołącz kryteria akceptacji (co musi być prawdą, żeby projekt był akceptowalny), a potem poproś AI, by samooceniło wynik względem nich. To zapobiega niekończącym się redesignom i sprawia, że wzorce z kolejnych sekcji są szybkie do zastosowania.

Wzorzec 1: Doprecyzuj wymagania przed jakimkolwiek projektem

Większość „przebudów architektury” nie wynika z błędnych diagramów — wynika z budowania właściwej rzeczy dla niewłaściwego (lub niepełnego) problemu. Gdy używasz LLM na wczesnym etapie, nie proś od razu o architekturę. Poproś, żeby ujawnił niejasności.

Ruch w promptowaniu: zamień niepewność w checklistę

Użyj modelu jako ankietera wymagań. Twoim celem jest krótka, priorytetyzowana specyfikacja, którą możesz potwierdzić zanim ktokolwiek zaprojektuje komponenty, wybierze bazy danych czy zatwierdzi API.

Poniżej szablon do kopiowania:

You are my requirements analyst. Before proposing any architecture, do this:

1) Ask 10–15 clarifying questions about missing requirements and assumptions.

- Group questions by: users, workflows, data, integrations, security/compliance, scale, operations.

2) Produce a prioritized scope list:

- Must-have

- Nice-to-have

- Explicitly out-of-scope

3) List constraints I must confirm:

- Performance (latency/throughput targets)

- Cost limits

- Security/privacy

- Compliance (e.g., SOC2, HIPAA, GDPR)

- Timeline and team size

4) End with: “Restate the final spec in exactly 10 bullets for confirmation.”

Context:

- Product idea:

- Target users:

- Success metrics:

- Existing systems (if any):

Na co zwracać uwagę w outputcie

Chcesz pytań, które wymuszają decyzje (nie ogólnego „powiedz więcej”), oraz listy must-have, którą da się faktycznie zrealizować w wyznaczonym czasie. Traktuj 10-punktowe podsumowanie jako kontrakt: wklej je do ticketu/PRD, zdobądź szybkie tak/nie od interesariuszy i dopiero wtedy przejdź do architektury. Ten jeden krok zapobiega najczęstszej przyczynie późnych refaktoringów: budowaniu funkcji, które nigdy nie były naprawdę wymagane.

Wzorzec 2: Najpierw ścieżki użytkownika, potem wybory techniczne

Kiedy zaczynasz od narzędzi („Czy użyć event sourcingu?”) często projektujesz dla architektury zamiast dla użytkownika. Szybszą drogą do czystej struktury jest poprosić AI o opisanie ścieżek użytkownika w prostym języku, a dopiero potem przetłumaczyć je na komponenty, dane i API.

Prost y szablon promptu skoncentrowany na podróży użytkownika

Użyj tego jako punktu wyjścia do kopiowania:

- Role: user / admin / system

- Kluczowe akcje: co każda rola chce osiągnąć

- Przypadki brzegowe: co może pójść nie tak (błędne dane, brak uprawnień, częściowe zakończenie)

Następnie poproś:

-

„Opisz krok po kroku przepływ dla każdej akcji w prostym języku.”

-

„Podaj prosty diagram stanów lub listę stanów (np. Draft → Submitted → Approved → Archived).”

-

„Wymień scenariusze poza happy-path: timeouts, retries, duplicate requests, cancellations i invalid inputs.”

Przekładanie ścieżek na decyzje (bez przedwczesnego skakania)

Gdy przepływy są jasne, poproś AI o mapowanie ich na wybory techniczne:

- Gdzie potrzebujemy walidacji, a gdzie reguł biznesowych?\n- Które kroki wymagają idempotencji (bezpieczne retrysy)?\n- Jakie dane trzeba przechowywać, co można wyprowadzić, a co wymaga śladu audytu?\n

Dopiero potem poproś o szkic architektury (usługi/moduły, granice i odpowiedzialności) powiązany bezpośrednio z krokami przepływu.

Zamień przepływy na testowalne kryteria akceptacji

Na koniec poproś AI, aby przekształciło każdą podróż w kryteria akceptacji, które możesz przetestować:

- „Given/When/Then dla każdego kroku i przypadku błędu.”\n- „Co system powinien zwrócić lub wyświetlić?”\n- „Co powinno być logowane, a co powinno wywoływać retry vs błąd widoczny dla użytkownika?”\n

Ten wzorzec zmniejsza przepisywania, bo architektura rośnie z zachowań użytkowników — nie z założeń o technologii.

Wzorzec 3: Dziennik założeń, żeby unikać zaskakujących przepisań

Większość przebudów architektury nie wynika z „złego projektu”, lecz z ukrytych założeń, które okazują się fałszywe. Kiedy prosisz LLM o architekturę, często uzupełni luki prawdopodobnymi domysłami. Dziennik założeń odsłania te domysły wcześnie, gdy zmiany są tanie.

Co poprosić model, żeby zrobił

Celem jest wymusić jasny podział między faktami, które podałeś, a założeniami, które model wymyślił.

Użyj tego szablonu promptu:

Template prompt\n> "Before proposing any solution: list your assumptions. Mark each as validated (explicitly stated by me) or unknown (you inferred it). For each unknown assumption, propose a fast way to validate it (question to ask, metric to check, or quick experiment). Then design based only on validated assumptions, and call out where unknowns could change the design."

Trzymaj go krótko, żeby ludzie go używali:

- Assumption: …\n- Status: validated / unknown\n- Why it matters: jaki wpływ na decyzję ma to założenie\n- How to validate: pytanie, check lub spike\n- If wrong, likely change: co byś przeprojektował

Pytania „co by zmieniło twoją odpowiedź?”

Dodaj jedną linię, która zmusi model do określenia punktów przełomowych:

- „List 5 triggerów: co by zmieniło twoją odpowiedź? (np. wolumen użytkowników, cele latencji, potrzeby zgodności, zasady retencji).”

Ten wzorzec zmienia architekturę w zbiór decyzji warunkowych. Nie dostajesz tylko diagramu — otrzymujesz mapę tego, co trzeba potwierdzić, zanim się zobowiążesz.

Wzorzec 4: Porównaj kilka architektur zanim wybierzesz jedną

Ship an MVP slice fast

Build a small end to end MVP slice in chat and iterate without turning changes into rewrites.

Narzędzia AI świetnie generują pojedynczy „najlepszy” projekt — ale to często tylko pierwsza sensowna opcja. Czystsza architektura zwykle pojawia się, gdy wymusisz porównanie wcześnie, gdy zmiany są tanie.

Podstawowy szablon promptu

Użyj promptu, który wymaga wielu architektur i ustrukturyzowanej tabeli kompromisów:

Propose 2–3 viable architectures for this project.

Compare them in a table with criteria: complexity, reliability, time-to-ship, scalability, cost.

Then recommend one option for our constraints and explain why it wins.

Finally, list “what we are NOT building” in this iteration to keep scope stable.

Context:

- Users and key journeys:

- Constraints (team size, deadlines, budget, compliance):

- Expected load and growth:

- Current systems we must integrate with:

Dlaczego to redukuje przepisywania

Porównanie zmusza model (i Ciebie) do ujawnienia ukrytych założeń: gdzie przechowywany jest stan, jak usługi komunikują się ze sobą, co musi być synchroniczne, a co może być opóźnione.

Tabela kryteriów ma znaczenie, bo zatrzymuje dyskusje typu „microservices vs monolith” przed staniem się debatą opartą na opiniach. Anchoring decyzji do tego, co naprawdę Cię obchodzi — szybkie wypuszczenie, obniżenie kosztu operacyjnego czy poprawa niezawodności — pomaga uniknąć nieuzasadnionych zmian.

Wymagaj rekomendacji i granicy

Nie akceptuj „to zależy”. Poproś o jasną rekomendację i konkretne ograniczenia, które ona optymalizuje.

Również nalegaj na listę „co w tej iteracji nie budujemy”. Przykłady: „Brak failover multi-region”, „Brak systemu wtyczek”, „Brak powiadomień w czasie rzeczywistym”. To utrzymuje architekturę od rozrastania się o funkcje, na które nie przeznaczyliście zasobów — i zapobiega niespodziewanym przepisaniom, gdy zakres się zmieni.

Wzorzec 5: Granice modułów i odpowiedzialności

Większość przebudów następuje, bo granice były niejasne: wszystko „dotyka wszystkiego”, a mała zmiana rozlewa się po całej bazie kodu. Ten wzorzec używa promptów, które wymuszają jasne właśności modułów zanim ktoś zacznie debatować o frameworkach czy diagramach klas.

Główna idea

Poproś AI o zdefiniowanie modułów i odpowiedzialności, oraz czego wyraźnie nie powinny robić. Następnie poproś o interfejsy (wejścia/wyjścia) i reguły zależności, nie o plan budowy czy szczegóły implementacyjne.

Szablon do kopiowania

Użyj tego, gdy szkicujesz nową funkcję lub refaktoryzujesz zagraconą część:

- Kontekst: <jedno zdanie o produkcie/funkcji>

- Cel: Zaproponuj modularną architekturę z 4–8 modułami.

-

Wypisz moduły z:

- Cel (1 zdanie)

- Odpowiedzialności (3–5 punktów)

- Co nie należy do zakresu („NIE obsługuje…”) (2–3 punkty)

-

Dla każdego modułu zdefiniuj tylko interfejsy:

- Wejścia (zdarzenia/żądania/dane)

- Wyjścia (odpowiedzi/zdarzenia/efekty uboczne)

- Publiczny surface API (nazwy funkcji lub endpoints OK; bez wewnętrznych klas)

-

Reguły zależności:

- Dozwolone zależności (A → B)

- Zabronione zależności (A ↛ C) z uzasadnieniem

- Gdzie żyją typy współdzielone (i czego nigdy nie wolno współdzielić)

-

Test przyszłych zmian: Dla tych prawdopodobnych zmian: <wypisz 3>, pokaż, który pojedynczy moduł powinien przejąć każdą zmianę i dlaczego.

Jak wygląda „dobry” output

Celujesz w moduły, które potrafisz opisać współpracownikowi w mniej niż minutę. Jeśli AI proponuje moduł „Utils” albo wkłada reguły biznesowe do kontrolerów, naciskaj: „Przenieś podejmowanie decyzji do modułu domenowego i utrzymaj adaptery cienkie.”

Po wykonaniu masz granice, które przetrwają nowe wymagania — bo zmiany mają jasne miejsce, a reguły zależności zapobiegają przypadkowemu sprzęganiu.

Wzorzec 6: Dane i kontrakty API najpierw (unikaj przebudów integracji)

Prace integracyjne często nie wynikają z „złego kodu” — wynikają z niejasnych kontraktów. Jeśli model kształt danych i API decydujecie późno, każdy zespół wypełnia luki inaczej i spędzacie kolejny sprint na godzeniu niezgodnych założeń.

Zacznij od promptu o kontraktach zanim porozmawiasz o frameworkach, bazach danych czy mikroserwisach. Jasny kontrakt staje się wspólnym odniesieniem, które trzyma UI, backend i pipeline danych w zgodzie.

Prompt kontraktowy (contract-first)

Użyj tego wczesnego promptu z asystentem AI:

- Szablon: „Opisz model danych, właścicielstwo i lifecycle dla każdej encji”

Następnie natychmiast poproś o:

- kontrakty API z przykładami (requests, responses, error shapes)\n- wersjonowanie i oczekiwania kompatybilności wstecz\n- reguły walidacji i przypadki brzegowe dla każdego pola

Jak wygląda „dobry” output

Chcesz konkretne artefakty, nie tylko prozę. Na przykład:

- Encja:

Subscription\n - Właściciel: Billing service\n - Lifecycle: created on checkout → active → past_due → canceled (soft-delete after 90 days)\n - Source of truth: billing DB; other services cache read-only copies

A szkic API:

POST /v1/subscriptions

{

"customer_id": "cus_123",

"plan_id": "pro_monthly",

"start_date": "2026-01-01"

}

201 Created

{

"id": "sub_456",

"status": "active",

"current_period_end": "2026-02-01"

}

422 Unprocessable Entity

{

"error": {

"code": "VALIDATION_ERROR",

"message": "start_date must be today or later",

"fields": {"start_date": "in_past"}

}

}

Zasady wersjonowania i kompatybilności

Niech AI sformułuje reguły typu: „Pola addytywne są dozwolone bez bumpa wersji; zmiany nazw wymagają /v2; klienci powinni ignorować nieznane pola.” Ten pojedynczy krok zapobiega cichym breaking changes — i powstałym potem przepisaniom.

Wzorzec 7: Tryby awarii i checklista niezawodności

Set clean boundaries

Define 4 to 8 modules with clear boundaries so business rules do not leak everywhere.

Architektury bywają przepisywane, gdy projekty dla „happy path” spotykają rzeczywisty ruch, zawodzące zależności i nieoczekiwane zachowania użytkowników. Ten wzorzec sprawia, że niezawodność staje się jawnym outputem projektowym, a nie paniką po uruchomieniu.

Szablon do kopiowania

Użyj tego z opisem wybranej architektury:

List failure modes; propose mitigations; define observability signals.\n> \n> For each failure mode:\n> - What triggers it?\n> - User impact (what the user experiences)\n> - Mitigation (design + operational)\n> - Retries, idempotency, rate limits, timeouts considerations\n> - Observability: logs/metrics/traces + alert thresholds

Co poproś model, żeby uwzględnił (non-negotiables)

Skoncentruj odpowiedź, wymieniając interfejsy, które mogą zawieść: zewnętrzne API, baza danych, kolejki, provider auth i background jobs. Następnie wymagaj konkretnych decyzji:

- Retries: kiedy retryować, ile razy, strategia backoff i które błędy są retryowalne.\n- Idempotency: klucze idempotencji, okna deduplikacji i jakie stany można bezpiecznie replayować.\n- Rate limits: limity per user/IP/service, komunikaty dla klientów i zabezpieczenia po stronie serwera.\n- Timeouts: dla poszczególnych zależności, ogólny budżet żądania i propagacja anulowania.

Checklista niezawodności

Zakończ prompt: „Zwróć prostą checklistę, którą można przejrzeć w 2 minuty.” Dobra checklista zawiera elementy typu: ustawione timeouty zależności, ograniczone retrysy, idempotencja dla akcji create/charge, obecność backpressure/rate limiting, zdefiniowana ścieżka degradacji.

Obserwowalność powiązana z akcjami użytkownika

Poproś o zdarzenia wokół momentów użytkownika (nie tylko wewnętrzne metryki): „user_signed_up”, „checkout_submitted”, „payment_confirmed”, „report_generated”. Dla każdego wymagaj:

- Pola logów (user_id, request_id, idempotency_key)\n- Metryki (wskaźnik sukcesu, latencja p95/p99, liczba retry)\n- Traces (spany dla wywołań zależności)

To zamienia niezawodność w artefakt projektowy, który możesz zweryfikować zanim powstanie kod.

Wzorzec 8: Planowanie kawałka MVP, by unikać nadbudowywania

Częstym sposobem, w jaki projekt wspomagany AI powoduje przepisywania, jest zachęcanie do „kompletnej” architektury zbyt wcześnie. Naprawa jest prosta: zmusz plan, by zacząć od najmniejszego użytecznego kawałka — takiego, który dostarcza wartość, sprawdza projekt i pozostawia opcje otwarte.

Szablon promptu

Użyj tego, gdy rozwiązanie rozrasta się szybciej niż wymagania:

Template: „Propose the smallest usable slice; define success metrics; list follow-ups.”

Poproś model o odpowiedź zawierającą:

- MVP slice: co jest potrzebne, żeby wysłać coś realnego\n- Success metrics: jak sprawdzisz, że zadziałało (metryki użytkownika + techniczne)\n- Follow-ups: co można odłożyć bez blokowania uczenia się

Wymagaj roadmapy fazowej (MVP → v1 → v2)

Dodaj instrukcję: „Daj fazową roadmapę: MVP → v1 → v2 i wyjaśnij, jakie ryzyko redukuje każda faza.” To trzyma późniejsze pomysły widocznymi, ale nie zmusza do ich wdrożenia w pierwszym release.

Przykładowe rezultaty, których oczekujesz:

- MVP waliduje podstawowy workflow i cienką ścieżkę end-to-end.\n- v1 wzmacnia niezawodność, dodaje brakujące "must-have" użyteczności.\n- v2 rozszerza zakres (więcej integracji, zaawansowane role, optymalizacje).

Wymuś wyraźne wyłączenia, by zapobiec rozszerzaniu zakresu

Najbardziej efektywny wiersz to: „Wypisz, co jest wyraźnie poza zakresem MVP.” Wyłączenia chronią decyzje architektoniczne przed przedwczesną komplikacją.

Dobre wyłączenia wyglądają tak:

- „Brak failover multi-region w MVP (loguj incydenty; planuj na v2).”\n- „Brak systemu wtyczek na razie (utrzymaj czyste granice, ale wyślij stałe moduły).”\n- „Tylko jeden provider płatności; abstrakcję dodamy później.”

Zamień plan na tickety z zależnościami

Na koniec: „Przekonwertuj MVP na tickety, każdy z kryteriami akceptacji i zależnościami.” To wymusza jasność i ujawnia ukryte sprzężenia.

Solidny breakdown tiketa zwykle zawiera:

- cienką end-to-end „happy path”\n2) minimalny model danych + kontrakt API\n3) podstawowe obsługi błędów i logowanie\n4) jeden punkt integracji (jeśli potrzeba) ze stubem fallbackowym

Jeśli chcesz, poproś model, by output był w formacie twojego zespołu (np. pola w stylu Jira) i trzymaj późniejsze fazy jako oddzielny backlog.

Wzorzec 9: Prompty test-first, które kształtują lepsze projekty

Create a full stack app

Generate a React web app with a Go backend and PostgreSQL from a single chat flow.

Prosty sposób, by zatrzymać dryf architektury, to wymusić jasność przez testy zanim poprosisz o projekt. Gdy promptujesz LLM, żeby najpierw napisał testy akceptacyjne, musi nazwać zachowania, wejścia, wyjścia i przypadki brzegowe. To naturalnie ujawnia brakujące wymagania i popycha implementację w stronę czystych granic modułów.

Szablon do kopiowania

Użyj tego jako "bramki" za każdym razem, gdy zamierzasz zaprojektować komponent:

- Template: „Write acceptance tests first; then propose implementation. You must: (1) list assumptions, (2) name unit vs integration tests, (3) define test data and mocks vs real dependencies, (4) include a definition of done.”

Proś o granice testów, które odpowiadają modułom

Dopowiedz: „Pogrupuj testy według odpowiedzialności modułów (warstwa API, logika domenowa, persistence, integracje zewnętrzne). Dla każdej grupy sprecyzuj, co jest mockowane, a co realne.”

To odsuwa LLM od splątanych projektów, gdzie wszystko dotyka wszystkiego. Jeśli nie potrafi wyjaśnić, gdzie zaczynają się testy integracyjne, architektura prawdopodobnie nie jest jeszcze jasna.

Strategia danych testowych: unikaj kruchego zestawu testów

Poproś: „Zaproponuj plan danych testowych: fixtures vs factories, jak generować przypadki brzegowe i jak utrzymać deterministyczność testów. Wymień zależności, które można zastąpić fałszywkami w pamięci i które wymagają realnych usług w CI.”

Często odkryjesz, że „prosta” funkcja potrzebuje kontraktu, danych startowych lub stabilnych ID — lepiej znaleźć to teraz niż w trakcie przepisywania.

Definicja done (żeby projekt wyszedł)

Zakończ lekką checklistą:

- Testy przechodzą (unit + integration) i sensowne pokrycie przypadków błędnych\n- Minimalna dokumentacja: użycie, konfiguracja i krótkie notatki troubleshootingowe\n- Monitoring/alerty dla kluczowych trybów awarii\n- Plan rollout (feature flag, kroki migracji, rollback)

Wzorzec 10: Prompty do przeglądu projektu, aby wykryć problemy wcześnie

Przeglądy projektu nie powinny zdarzać się dopiero po napisaniu kodu. Z AI możesz przeprowadzić „pre-mortem review” twojego szkicu architektury (nawet jeśli to tylko kilka akapitów i opis diagramu) i otrzymać konkretną listę słabości zanim staną się przepisań.

Główny szablon przeglądu

Zacznij od stanowiska surowego recenzenta i wymagaj konkretów:

Prompt: „Act as a reviewer; list risks, inconsistencies, and missing details in this design. Be concrete. If you can’t evaluate something, say what information is missing.”

Wklej swój skrót projektu, ograniczenia (budżet, harmonogram, umiejętności zespołu) oraz wymagania niefunkcjonalne (latencja, dostępność, zgodność).

Zamień feedback w wykonalną listę zadań

Przeglądy zawodzą, gdy feedback jest niejasny. Poproś o uszeregowaną listę poprawek:

Prompt: „Give me a prioritized punch list. For each item: severity (Blocker/High/Medium/Low), why it matters, suggested fix, and the smallest validation step.”

To generuje zestaw zadań gotowych do decyzji, zamiast debaty.

Sklasyfikuj ryzyko przepisania

Przydatnym wymuszeniem jest prosty wynik:

Prompt: „Assign a rewrite risk score from 1–10. Explain the top 3 drivers. What would reduce the score by 2 points with minimal effort?”

Nie chodzi o precyzję, tylko o ujawnienie najbardziej podatnych na przepisanie założeń.

Zakończ planem „diff”

Na koniec zapobiegaj rozszerzaniu zakresu przeglądu:

Prompt: „Provide a diff plan: minimal changes needed to reach the target design. List what stays the same, what changes, and any breaking impacts.”

Gdy powtarzasz ten wzorzec przy każdej iteracji, architektura ewoluuje przez małe, odwracalne kroki — a poważne problemy są wychwytywane wcześnie.

Pakiet promptów do kopiowania i prosty workflow

Użyj tego pakietu jako lekkiego workflow, który możesz powtarzać przy każdej funkcji. Pomysł to połączenie promptów tak, by każdy krok produkował artefakt, który następny krok może ponownie wykorzystać — zmniejszając "zgubiony kontekst" i niespodziewane przepisywania.

6-etapowy workflow (połącz te wzorce)

- Wymagania (doprecyzuj + ograniczenia)\n2) Opcje architektury (porównaj 2–3 podejścia)\n3) Granice (moduły + odpowiedzialności)\n4) Kontrakty (dane + API)\n5) Testy (test-first acceptance + kluczowe testy jednostkowe)\n6) Przegląd (tryby awarii + checklista przeglądu projektu)

W praktyce zespoły często implementują ten łańcuch jako powtarzalną „receptę na funkcję”. Jeśli budujesz z Koder.ai, ta sama struktura mapuje się naturalnie na chat-driven build: zapisz artefakty w jednym miejscu, wygeneruj pierwszą działającą część, a potem iteruj ze snapshotami, żeby eksperymenty były odwracalne. Gdy MVP będzie gotowe, możesz eksportować kod źródłowy lub wdrożyć/hostować z własną domeną — przydatne, jeśli chcesz szybkość dostarczania AI bez uzależniania się od jednego środowiska.

Pakiet promptów do kopiowania (z zabezpieczeniami)

SYSTEM (optional)

You are a software architecture assistant. Be practical and concise.

Guardrail: When you make a recommendation, cite the specific lines from *my input* you relied on by quoting them verbatim under “Input citations”. Do not cite external sources or general industry claims.

If something is unknown, ask targeted questions.

1) REQUIREMENTS CLARIFIER

Context: <product/system overview>

Feature: <feature name>

My notes: <paste bullets, tickets, constraints>

Task:

- Produce: (a) clarified requirements, (b) non-goals, (c) constraints, (d) open questions.

- Include “Input citations” quoting the exact parts of my notes you used.

2) ARCHITECTURE OPTIONS

Using the clarified requirements above, propose 3 architecture options.

For each: tradeoffs, complexity, risks, and when to choose it.

End with a recommendation + “Input citations”.

3) MODULAR BOUNDARIES

Chosen option: <option name>

Define modules/components and their responsibilities.

- What each module owns (and does NOT own)

- Key interfaces between modules

- “Input citations”

4) DATA & API CONTRACTS

For each interface, define a contract:

- Request/response schema (or events)

- Validation rules

- Versioning strategy

- Error shapes

- “Input citations”

5) TEST-FIRST ACCEPTANCE

Write:

- Acceptance criteria (Given/When/Then)

- 5–10 critical tests (unit/integration)

- What to mock vs not mock

- “Input citations”

6) RELIABILITY + DESIGN REVIEW

Create:

- Failure modes list (timeouts, partial failure, bad data, retries)

- Observability plan (logs/metrics/traces)

- Review checklist tailored to this feature

- “Input citations”

Jeśli chcesz głębszego opracowania, zobacz /blog/prompting-for-code-reviews. Jeśli oceniasz narzędzia lub wdrożenie zespołowe, /pricing jest praktycznym następnym krokiem.