Zdefiniuj zadanie asystenta i zakres MVP

„Aplikacja osobistego asystenta” może oznaczać wszystko: od rozszerzonej listy rzeczy do zrobienia po narzędzie, które negocjuje konflikty w kalendarzu i szkicuje e-maile. Jeśli nie zdefiniujesz zadania precyzyjnie, zbudujesz demo czatu, które robi wrażenie, ale nie pomaga w poniedziałkowy poranek.

Zacznij od nazwania swojej grupy docelowej i ich powtarzającego się bólu. Założyciel może chcieć szybkich przygotowań do spotkań i follow-upów; student planów nauki i przechwytywania notatek; kierownik operacyjny triage zadań i codziennych podsumowań. Im jaśniejsza publiczność, tym łatwiej zdecydować, jakich narzędzi asystent potrzebuje — i których absolutnie nie.

Wybierz 1–2 ścieżki, które udowodnią wartość

Twoje MVP powinno dawać użyteczny rezultat w jednej krótkiej sesji. Praktyczna zasada: użytkownik otrzymuje wartość w ciągu 60–120 sekund od otwarcia aplikacji.

Dwie solidne pierwsze ścieżki to:

- Przechwyć → uporządkuj: Dodaj zadanie/notatkę z kontekstem, potwierdź poprawny zapis, a potem zobacz ją na prostej liście.

- Podsumuj → zdecyduj: Wygeneruj plan/dzienne podsumowanie z zapisanych pozycji, a następnie pozwól użytkownikowi zaakceptować, edytować lub przełożyć.

Zauważ, czego tu brakuje: długie onboardingi, skomplikowane ustawienia czy głębokie integracje. Możesz zasymulować „doświadczenie asystenta”, sprawiając, że interakcja będzie konwersacyjna, jednocześnie zachowując deterministyczne działania w tle.

Ustal non-goals (i zapisz je)

Wiele aplikacji asystentów upada, próbując zrobić wszystko od dnia pierwszego: głos, pełna synchronizacja e-maili, zapisy w kalendarzu, autonomiczne wieloetapowe akcje i złożone konfiguracje agentów. Zrób jawne non-goals dla MVP — brak wejścia głosowego, brak dwukierunkowej integracji e-maili, brak autonomicznego działania w tle i brak synchronizacji między urządzeniami poza podstawowymi kontami. To utrzymuje produkt uczciwym i zmniejsza ryzyko bezpieczeństwa i prywatności na wczesnym etapie.

Wybierz metryki sukcesu odpowiadające zadaniu

Nie mierz MVP liczbą czatów. Mierz wynikami:

- Czas do pierwszego użytecznego rezultatu: jak szybko użytkownicy otrzymują zapisane zadanie lub użyteczne podsumowanie.

- Jakość: jak często wyekstrahowane zadania/dat są poprawne i jak często użytkownicy je edytują.

- Retencja: czy użytkownicy wracają następnego dnia, by przechwytywać lub przeglądać.

Jeśli vibe-codingujesz na platformie takiej jak Koder.ai, jasne ścieżki i metryki sprawiają, że prędkość budowy staje się realna: możesz zaplanować pierwsze ekrany React/Flutter i endpointy Go/PostgreSQL wokół dwóch głównych pętli, a potem iterować za pomocą snapshotów i rollbacku, gdy zmiany nie poprawiają wyników.

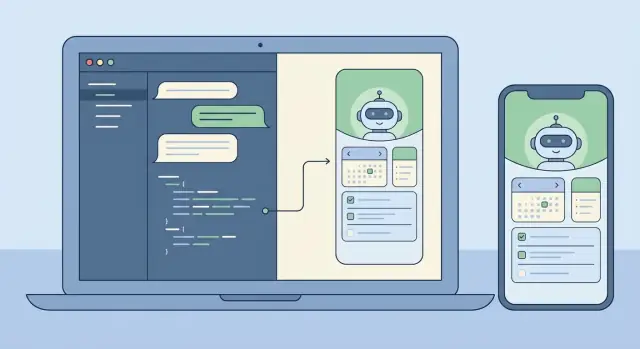

Projekt produktu: przepływy UX, które przypominają asystenta

Aplikacja osobistego asystenta zwycięża lub przegrywa w odczuciu interakcji. Użytkownicy powinni czuć, że aplikacja rozumie intencję, proponuje kolejny pomocny krok i nie przeszkadza, gdy chcą szybkiej odpowiedzi.

Zacznij od codziennych działań asystenta

Większość asystentów zdobywa zaufanie, wykonując konsekwentnie kilka podstawowych zadań: rozumienie żądań, przechowywanie „pamięci” (preferencje i lekkie fakty profilowe), zarządzanie zadaniami i przypomnieniami oraz generowanie szybkich podsumowań (notatki, spotkania lub dłuższe wiadomości). Projekt produktu polega na uczynieniu tych możliwości oczywistymi, bez zamieniania aplikacji w labirynt.

Użyteczna zasada: każda zdolność asystenta powinna mieć (1) ścieżkę konwersacyjną (np. „przypomnij mi jutro o 9”) i (2) widoczny interfejs do przeglądu i edycji (lista przypomnień, którą można zeskanować).

Wybierz styl interakcji: czat-first vs UI-first

Czat-first sprawdza się najlepiej, gdy twoi użytkownicy cenią szybkość i elastyczność: pole do komponowania, historia wiadomości i kilka inteligentnych skrótów.

UI-first z czatem jako pomocnikiem działa lepiej, gdy użytkownicy zarządzają wieloma elementami i potrzebują struktury. W tym modelu aplikacja otwiera się na widoku „Zadania” lub „Dzisiaj”, a czat jest kontekstowym narzędziem do zmian (np. „przesuń wszystko, co ma termin dzisiaj, na jutro”).

Nie musisz wybierać na zawsze, ale powinieneś wcześnie ustalić domyślny ekran startowy i model mentalny.

Zaprojektuj bezpieczeństwo w przepływie (potwierdź + cofnij)

Asystenci często wykonują akcje, które wydają się nieodwracalne: usuwanie notatki, wysyłanie wiadomości, anulowanie czegoś lub edycja wielu zadań naraz. Traktuj je jako ryzykowne. UX powinien stosować wyraźny krok potwierdzenia z prostym podsumowaniem tego, co się stanie, oraz natychmiastową opcją cofnięcia po wykonaniu.

Silny wzorzec to: podgląd → potwierdź → wykonaj → cofnij. W podglądzie użytkownicy wychwytują błędy („Wysłać do Alexa?” „Usunąć 12 zadań?”).

Naszkicuj minimalny zestaw ekranów

Utrzymaj pierwszą wersję małą i spójną. Praktyczne minimum to: onboarding (co potrafi + uprawnienia), czat, zadania/przypomnienia, pamięć (co wie, z możliwością edycji/usunięcia), ustawienia (powiadomienia, ton, prywatność) oraz lekki widok historii/audytu.

Jeśli vibe-codingujesz to (np. w Koder.ai), te ekrany mapują się czytelnie na MVP, które możesz szybko wygenerować, a potem dopracować, testując rzeczywiste przepływy jak „przechwyć zadanie”, „ustaw przypomnienie” i „cofnij błąd”.

Projekt zachowania i promptowania (bez nadmiernego komplikowania)

Dobry asystent wydaje się spójny, przewidywalny i bezpieczny — bardziej jak pomocny współpracownik niż losowy generator tekstu. Możesz to osiągnąć szybciej, utrzymując promptowanie proste, warstwowe i testowalne.

Użyj jasnej hierarchii wiadomości

Traktuj swoje prompt jako trzy warstwy, każda z innym celem:

- Instrukcje systemowe definiują tożsamość i nienegocjowalne zasady (ton, bezpieczeństwo, stanowisko wobec prywatności, jak radzić sobie z niepewnością).

- Zasady deweloperskie definiują zachowanie produktu (obsługiwane funkcje, reguły użycia narzędzi, kontrakty formatu wyjścia, co logować).

- Wiadomości użytkownika to zmieniające się żądania.

To rozdzielenie zapobiega sytuacji, w której prośba użytkownika („ignoruj poprzednie instrukcje”) przypadkowo nadpisze sposób, w jaki asystent musi się zachowywać.

Zdefiniuj granice narzędzi (i uprawnienia)

Asystent będzie bardziej godny zaufania, jeśli wie dokładnie, kiedy może działać, a kiedy musi zapytać. Zdecyduj, które operacje są tylko do odczytu (bezpieczne do automatycznego wykonywania, np. przeszukiwanie notatek), które są akcjami zapisu (tworzenie/aktualizacja zadań, harmonogramowanie przypomnień) i które są nieodwracalne lub kosztowne (usuwanie danych, kontakt z usługami zewnętrznymi, udostępnianie informacji).

Dla akcji zapisu i nieodwracalnych wymógaj potwierdzenie: model proponuje plan działania, a następnie czeka na wyraźną zgodę.

Preferuj ustrukturyzowane wyniki dla akcji

Kiedy model ma stworzyć zadanie lub przypomnienie, zwykły tekst jest kruchy. Użyj obiektów akcji w JSON i waliduj je przed wykonaniem. Wymagaj pól takich jak action, title, due_at, priority i timezone, i odrzucaj lub dopytuj, gdy czegoś brakuje. To utrzymuje backend deterministycznym, nawet gdy sformułowania modelu są zmienne.

Dodaj lekkie zabezpieczenia

Guardrails nie muszą być skomplikowane. Dodaj krótką politykę dla wrażliwych zapytań (samookaleczenia, działalność nielegalna, dostęp do prywatnych danych) i zdefiniuj wzorce odmowy, które nadal brzmią pomocnie: uznać, odmówić i zaproponować bezpieczne alternatywy. Poleć też modelowi, by mówił „nie wiem”, gdy brak mu informacji, i zadawał jedno pytanie uściślające zamiast zgadywać.

Zbuduj małą bibliotekę promptów

Zamiast jednego ogromnego promptu, trzymaj mały zestaw wielokrotnego użytku zachowań, które asystent może „wywoływać” wewnętrznie: podsumowywanie rozmowy na następne kroki, tworzenie planu z założeniami i otwartymi pytaniami, sprawdzanie żądania pod kątem brakujących danych, przepisanie wiadomości w konkretnym tonie oraz ekstrakcja zadań/wydarzeń do JSON. To złoty środek: spójne zachowanie, łatwe testowanie i brak spaghetti z promptów.

LLM + narzędzia + agenci: praktyczna architektura

Asystent wydaje się „inteligentny”, gdy potrafi dwie rzeczy dobrze: rozmawiać naturalnie i wykonywać niezawodne akcje. Najszybsza droga to oddzielenie rozmowy (rozumowanie LLM) od wykonania (narzędzia wywołujące rzeczywiste systemy).

Dwa praktyczne wzorce

Dla MVP zacznij od wzorca jeden LLM + narzędzia: jeden model otrzymuje wiadomość użytkownika, decyduje, czy odpowiedzieć tekstem, czy wywołać narzędzie, a potem zwraca wynik. To prostsze do debugowania i często wystarczające do przechwytywania zadań, wyszukiwania notatek i przypomnień.

W miarę rozwoju przydatny staje się wzorzec koordynator + wyspecjalizowani agenci. Koordynator interpretuje żądanie i deleguje do specjalistów (np. agent Tasks vs agent Notes), każdy z węższymi instrukcjami i mniejszą liczbą narzędzi. To zmniejsza przypadkowe użycie narzędzi i poprawia spójność wraz z dodawaniem integracji.

Narzędzia: ręce asystenta

Narzędzia to małe, deterministyczne API, które asystent może wywołać. Trzymaj wejścia narzędzi ścisłe, a wyjścia ustrukturyzowane, żeby móc je walidować i logować, co się stało.

Typowe narzędzia to: create/update/complete zadania, wyszukiwanie notatek (słowo kluczowe + filtr czasowy), harmonogramowanie przypomnień (czas, kanał, cykliczność), pobieranie preferencji (strefa czasowa, godziny pracy), opcjonalne odczyty agendy (jeśli masz integrację kalendarza) oraz zapisy zdarzeń audytowych.

Tryb planowania przed wykonaniem

Przed wykonaniem dodaj jawny krok planowania: model pisze krótki plan, a potem wybiera narzędzia do realizacji. Planowanie pomaga przy wieloetapowych żądaniach, np. „Przesuń zadania projektu na przyszły tydzień i przypomnij mi w poniedziałek”, gdzie asystent powinien potwierdzić założenia (strefa czasowa, co oznacza „zadania projektu”) przed działaniem.

Zatwierdzanie akcji, by zapobiegać niespodziankom

Każde narzędzie powodujące skutki uboczne (tworzenie zadań, wysyłanie przypomnień, zmiana danych) powinno przechodzić przez bramkę zatwierdzającą. W praktyce model proponuje szkic akcji (nazwa narzędzia + parametry + oczekiwany rezultat), a aplikacja prosi użytkownika o potwierdzenie lub edycję. Ten pojedynczy punkt kontrolny znacząco redukuje niezamierzone zmiany i zwiększa zaufanie.

Jeśli używasz platformy vibe-codingowej jak Koder.ai, możesz szybko zaimplementować tę architekturę, generując interfejsy narzędzi, logikę koordynatora i UI zatwierdzeń jako oddzielne, testowalne komponenty — potem iterując przez snapshoty i rollback podczas dopracowywania zachowania.

Pamięć i kontekst: co zapisywać, co pobierać

Asystent wydaje się „mądry”, gdy pamięta właściwe rzeczy i zapomina resztę. Sztuka polega na oddzieleniu tego, czego model potrzebuje do spójności, od tego, co przechowujesz dla użytkownika. Jeśli zapiszesz wszystko, zwiększasz ryzyko prywatności i szum przy wyszukiwaniu. Jeśli nic nie zapiszesz, asystent stanie się powtarzalny i kruchy.

Pamięć krótkoterminowa vs długoterminowa

Traktuj niedawną rozmowę jako pamięć krótkoterminową: przesuwane okno ostatnich kilku tur plus bieżący cel. Trzymaj je ciasno — agresywnie podsumowuj — żeby nie ponosić niepotrzebnych kosztów tokenów ani nie wzmacniać wcześniejszych błędów.

Pamięć długoterminowa służy rzeczom, które powinny przetrwać sesje: preferencje, stabilne dane profilowe, zadania i notatki, które użytkownik oczekuje odnaleźć. Przechowuj je najpierw jako dane strukturalne (tabele, pola, znaczniki czasu) i używaj fragmentów tekstu tylko wtedy, gdy nie da się tego sensownie zreprezentować strukturalnie.

Co warto zapisywać

Praktyczny punkt startowy to zapisywanie informacji autorskich lub zatwierdzonych przez użytkownika: profil i preferencje (strefa czasowa, godziny pracy, ton, domyślne przypomnienia), zadania i projekty (status, terminy, cykliczność, priorytet), notatki i wyróżnienia (decyzje, zobowiązania, kluczowy kontekst) oraz wyniki narzędzi wraz ze śladem audytu.

Ważniejsze od pełnych transkryptów są wyróżnienia rozmów. Zamiast przechowywać wszystko, zapisuj trwałe fakty, np.: „Użytkownik preferuje zwięzłe podsumowania”, „Lot do NYC jest w piątek”, „Limit budżetu to 2 000 $”.

Pobieranie, które wydaje się natychmiastowe (i przewidywalne)

Planuj pobieranie według sposobu, w jaki ludzie szukają rzeczy: słowa kluczowe, zakresy czasowe, tagi i „ostatnio zmienione”. Najpierw używaj deterministycznych filtrów (daty, status, tagi), potem dodaj wyszukiwanie semantyczne w treściach notatek, gdy zapytanie jest nieostre.

Aby uniknąć halucynacji, asystent powinien polegać wyłącznie na tym, co faktycznie pobrał (identyfikatory rekordów, znaczniki czasu) i zadać pytanie uściślające, gdy nic istotnego nie znaleziono.

Kontrole użytkownika i zaufanie

Uczyń pamięć przejrzystą. Użytkownicy powinni móc przeglądać, edytować, eksportować i usuwać to, co jest zapisane — zwłaszcza fakty długoterminowe. Jeśli budujesz z workflow vibe-codingowym jak Koder.ai, wczesne uczynienie „Ustawień pamięci” ekranem pierwszorzędnym kształtuje zarówno UX, jak i model danych.

Frontend: Web (React) i Mobile (Flutter)

Iteruj z migawkami

Zapisz działający stan przed dużymi zmianami promptów, narzędzi lub UI.

Aplikacja asystenta żyje lub umiera przez interfejs. Wybierz stack na podstawie tego, gdzie ludzie będą z niego rzeczywiście korzystać: web często jest najszybszą drogą do „codziennego użycia”, podczas gdy mobilność się opłaca, gdy powiadomienia, wejście głosowe i przechwytywanie w ruchu mają znaczenie.

Praktyczne podejście: zacznij z React na web UI (szybkie iteracje, łatwe wdrażanie), potem odwzoruj ten sam model interakcji we Flutter, gdy podstawowa pętla asystenta zadziała.

UI czatu, które zachowuje się jak produkt (nie demo)

Traktuj czat jako ustrukturyzowaną rozmowę, nie tylko bąbelki tekstu. Obsłuż różne kształty wiadomości, żeby użytkownicy rozumieli, co się dzieje i czego oczekujesz: wiadomości użytkownika, odpowiedzi asystenta (w tym przesyłany tekst), akcje narzędzi ("Tworzę zadanie…"), potwierdzenia (zatwierdź/odrzuć), błędy (z opcjami ponowienia) i powiadomienia systemowe (offline, limity, obniżona zdolność).

W React streaming odpowiedzi może sprawić, że asystent wyda się responsywny, ale utrzymuj wydajność renderowania: dołączaj delty, unikaj przepisywania całej transkrypcji i dbaj o zachowanie scrolla dla osób czytających starsze wiadomości.

Stany „myślenia” bez ujawniania szczegółów wewnętrznych

Użytkownicy potrzebują informacji zwrotnej, nie Twoich wewnętrznych promptów czy szczegółów łańcucha narzędzi. Używaj neutralnych wskaźników jak „Pracuję nad tym” lub „Sprawdzam Twoje notatki” i pokazuj tylko bezpieczne dla użytkownika kamienie milowe (rozpoczęto, czeka na potwierdzenie, ukończono). To jeszcze ważniejsze przy rozszerzaniu do wieloagentowych przepływów.

Ustawienia, które dają kontrolę nad zachowaniem

Dodaj ekran ustawień wcześnie, nawet prosty. Pozwól kontrolować ton (profesjonalny vs swobodny), obszerność (zwięźle vs szczegółowo) i opcje prywatności (czy przechowywać historię czatów, czas retencji, czy funkcje pamięci są włączone). Te kontrolki redukują niespodzianki i pomagają w spełnianiu wymogów zgodności.

Jeśli vibe-codingujesz z Koder.ai, możesz wygenerować zarówno UI web w React, jak i ekrany Flutter z tego samego opisu produktu, a potem szybko iterować nad komponentami rozmowy, streamingiem i ustawieniami bez ugrzęźnięcia w pracach nad infrastrukturą UI.

Backend: API, uwierzytelnianie i deterministyczne wykonanie

Asystent wydaje się magiczny w UI, ale staje się godny zaufania w backendzie. Cel: uczynić zachowanie napędzane czatem przewidywalnym: model może sugerować akcje, ale to serwer decyduje, co faktycznie się wydarzy.

API, które mapują do intencji użytkownika

Przetłumacz zachowania asystenta na mały zestaw stabilnych endpointów. Trzymaj czat jako punkt wejścia, potem wystaw explicite zasoby dla wszystkiego, czym asystent może zarządzać. Na przykład asystent może sporządzić szkic zadania, ale ostateczne wywołanie create-task powinno być zwykłym żądaniem API ze ścisłym schematem.

Kompaktowy interfejs, który dobrze się skaluje, obejmuje: chat (wysyłanie/odbieranie + opcjonalne żądania narzędzi), wykonanie narzędzi (uruchamiaj zatwierdzone narzędzia i zwracaj ustrukturyzowane wyniki), CRUD zadań (z walidacją po stronie serwera), preferencje oraz job/status dla długotrwałych prac.

Uwierzytelnianie i sesje: decyzja wcześnie

Uwierzytelnianie najłatwiej dodać wcześnie i najtrudniej dobudować później. Zdefiniuj, jak reprezentowana jest sesja użytkownika (tokeny lub sesje serwerowe) i jak żądania są zakresowane (user ID, org ID dla zespołów). Zdecyduj, co asystent może robić „cicho”, a co wymaga ponownej autoryzacji lub potwierdzenia.

Jeśli planujesz plany (free/pro/business/enterprise), egzekwuj uprawnienia na warstwie API od pierwszego dnia (limity, dostępność narzędzi, uprawnienia do eksportu), a nie wewnątrz promptów.

Długotrwałe zadania: kolejkuj, nie blokuj

Podsumowania dużych treści, importy lub wieloetapowe workflowy agentów powinny działać asynchronicznie. Zwracaj szybko z ID zadania i dostarczaj aktualizacje postępu (queued → running → partial results → completed/failed). To utrzymuje czat responsywny i unika timeoutów.

Deterministyczne wykonanie: modele proponują, serwery decydują

Traktuj wyjścia modelu jako niezweryfikowane wejście. Waliduj i sanityzuj wszystko: ścisłe schematy JSON dla wywołań narzędzi, odrzucanie nieznanych pól, wymuszanie typów/zakresów, normalizacja dat/stref czasowych po stronie serwera oraz logowanie żądań/wyników narzędzi dla audytu.

Platformy takie jak Koder.ai przyspieszają szkielety (Go API, PostgreSQL w tle, snapshoty/rollback), ale zasada jest ta sama: asystent może być kreatywny w rozmowie, a backend powinien być nudny, ścisły i niezawodny.

Model danych w PostgreSQL: zadania, notatki i audytowalność

Zaprojektuj podstawowe tabele

Zacznij od zadań, notatek i dzienników audytu z wyraźnymi polami pochodzenia.

Asystent wydaje się „mądry”, gdy potrafi niezawodnie pamiętać, wyjaśnić, co zrobił, i cofnąć błędy. Twój schemat PostgreSQL powinien to wspierać od pierwszego dnia: jasne encje rdzeniowe, eksplicytne pochodzenie (skąd pochodzi każdy element) i znaczniki czasu przyjazne audytowi.

Podstawowe encje do zamodelowania (i dlaczego)

Zacznij od małego zestawu tabel, które odpowiadają oczekiwaniom użytkownika: users, conversations/messages, tasks/reminders, notes oraz (opcjonalnie) embeddings, jeśli robisz retrieval w skali. Trzymaj tasks/notes oddzielnie od messages: wiadomości to surowa transkrypcja; tasks/notes to ustrukturyzowane rezultaty.

Pochodzenie: „Która wiadomość to utworzyła?”

Traktuj provenance jako cechę pierwszorzędną. Gdy LLM przekształci żądanie w zadanie, zapisz source_message_id w tasks/notes, śledź kto to stworzył (user, assistant lub system) i dołącz tool_run_id jeśli używasz narzędzi/agentów. To sprawia, że zachowanie jest wytłumaczalne („Utworzone z Twojej wiadomości we wtorek o 10:14”) i przyspiesza debugowanie.

Pola przyjazne audytowi i miękkie usuwanie

Używaj spójnych kolumn w tabelach: created_at, updated_at i często deleted_at dla miękkiego usuwania. Miękkie usuwanie jest szczególnie przydatne w aplikacjach asystentów, bo użytkownicy często chcą cofnąć, a Ty możesz potrzebować zachować rekordy dla zgodności lub debugowania.

Rozważ niezmienne identyfikatory (uuid) i tabelę audytu append-only dla kluczowych zdarzeń (task created, due date changed, reminder fired). To prostsze niż próba odtworzenia historii z aktualizowanych wierszy.

Migracje i ewolucja schematu

Zachowanie asystenta zmienia się szybko. Plan migracje: wersjonuj schemat, unikaj destrukcyjnych zmian i preferuj kroki addytywne (nowe kolumny, nowe tabele). Jeśli vibe-codingujesz z Koder.ai, łącz snapshoty/rollback z dyscypliną migracji bazy danych, żeby iterować bez utraty integralności danych.

CREATE TABLE tasks (

id uuid PRIMARY KEY,

user_id uuid NOT NULL,

title text NOT NULL,

status text NOT NULL,

due_at timestamptz,

source_message_id uuid,

created_by text NOT NULL,

created_at timestamptz NOT NULL DEFAULT now(),

updated_at timestamptz NOT NULL DEFAULT now(),

deleted_at timestamptz

);

Testowanie i ewaluacja: uczynić to niezawodnym

Niezawodność to różnica między fajnym demem a asystentem, któremu użytkownicy powierzają prawdziwą pracę. Trudność polega na tym, że żądania użytkowników rzadko są uporządkowane: ludzie bywają zwięźli, emocjonalni, niespójni i często pomijają kluczowe szczegóły. Twoja strategia testowa powinna to odzwierciedlać.

Zbuduj zestaw testowy przypominający prawdziwe życie

Zbierz (lub napisz) niewielki, ale reprezentatywny zestaw żądań: krótkie wiadomości, nieprecyzyjne instrukcje, literówki, sprzeczne ograniczenia i zmiany w ostatniej chwili. Uwzględnij ścieżki pozytywne (tworzenie zadania, przechwytywanie notatki) i ścieżki brzegowe (brak dat, niejednoznaczne zaimki, kilka osób o tym samym imieniu, żądania wymagające uprawnień).

Trzymaj te przykłady jako swój golden set. Uruchamiaj go za każdym razem, gdy zmieniasz prompt, narzędzia lub logikę agentów.

Zdefiniuj, co znaczy „dobrze” (poza poprawnymi odpowiedziami)

Dla aplikacji asystenta poprawność to nie tylko tekst końcowy. Oceń, czy podjęto właściwą akcję, czy poproszono o potwierdzenie, gdy trzeba, i czy uniknięto wymyślania wyników narzędzi.

Praktyczna rubryka sprawdza: poprawność zadań, zachowanie potwierdzeń (szczególnie przed usunięciami/wysłaniami/wydatkami), halucynacje akcji (twierdzenia o wykonaniu bez wywołania narzędzia), dyscyplinę narzędzi (używa narzędzi, gdy to wymagane; unika niepotrzebnych wywołań) oraz odzyskiwanie (jasne obsłużenie błędów i retry).

Kontrole regresji dla promptów i narzędzi

Każda poprawka promptu może przesunąć zachowanie w nieoczekiwany sposób. Traktuj prompty jak kod: wersjonuj je, uruchamiaj golden set i porównuj wyniki. Jeśli używasz wielu agentów (planner/executor), testuj każdy etap — wiele błędów zaczyna się od złego planowania, które się kaskaduje.

Przy dodawaniu nowego narzędzia lub zmianie schematu narzędzia dodaj celowane przypadki regresji (np. „utwórz zadanie na następny piątek” powinno nadal rozwiązywać daty konsekwentnie). Jeśli Twój workflow wspiera snapshoty i rollback, używaj ich do szybkiego cofania, gdy oceny spadają.

Instrumentacja bez wycieków sekretów

Loguj wywołania narzędzi, zredagowane argumenty, czasy i przyczyny błędów, by móc odpowiedzieć na pytania: „Co model próbował zrobić?” i „Dlaczego to zawiodło?”. Redaguj tokeny, dane osobowe i treść wiadomości domyślnie, i przechowuj tylko to, co potrzebne do debugowania — często wystarcza zahashowane ID użytkownika, nazwa narzędzia, wysokopoziomowa intencja i klasa błędu.

Dobrze zrobione testowanie zmienia iterację w kontrolowaną pętlę: możesz poruszać się szybciej, nie łamiąc zaufania.

Bezpieczeństwo, prywatność i zgodność

Aplikacja osobistego asystenta szybko staje się pojemnikiem na wrażliwe materiały: kalendarze, lokalizacje, wiadomości, dokumenty i przypadkowe notatki użytkowników. Traktuj prywatność jako cechę produktu, a nie checkbox. Minimalizuj to, co zbierasz i co wysyłasz do LLM. Jeśli funkcja nie wymaga pełnej historii wiadomości, nie przechowuj jej; jeśli zapytanie można obsłużyć krótkim podsumowaniem, wysyłaj tylko podsumowanie.

Minimalizacja danych, retencja i kontrola użytkownika

Zdefiniuj retencję od początku: co zapisujesz (zadania, notatki, preferencje), dlaczego to przechowujesz i jak długo. Uczyń usuwanie realnym i weryfikowalnym: użytkownicy powinni móc usunąć pojedynczą notatkę, całe workspace i wszystkie przesłane pliki. Rozważ tryb „forgetful” dla wrażliwych rozmów, gdzie nie zachowujesz treści wcale — tylko minimalne metadane do rozliczeń i zapobiegania nadużyć.

Sekrety, tokeny i szyfrowanie

Nigdy nie wysyłaj kluczy API do klienta. Trzymaj klucze providerów i poświadczenia narzędzi na serwerze, rotuj je i nadawaj zakresy per środowisko. Szyfruj dane w tranzycie (TLS) i w miejscu przechowywania (baza i backupy). Dla tokenów sesji stosuj krótkie czasy życia i mechanizmy odświeżania; przechowuj hashe tam, gdzie to możliwe i unikaj logowania surowych promptów lub wyników narzędzi domyślnie.

Hosting geograficzny i zgodność

Niektórzy użytkownicy będą wymagać rezydencji danych (konkretne kraje/regiony), szczególnie dla asystentów korporacyjnych. Planuj wdrożenia zgodne z regionem od wcześnie: trzymaj dane użytkowników w bazie zgodnej z regionem i unikaj cross-region pipeline’ów, które cicho kopiują treści gdzie indziej. Koder.ai działa na AWS globalnie i może hostować aplikacje w konkretnych krajach, co może uprościć wymagania dotyczące rezydencji i transferów między krajami, gdy będą potrzebne.

Ochrona przed nadużyciami i obrona przed prompt-injection

Asystenci przyciągają nadużycia: scraping, credential stuffing i ataki „zmusić model do ujawnienia sekretów”. Praktyczna baza to limity i kwoty, wykrywanie podejrzanej aktywności, ścisłe uprawnienia narzędzi (allow-list + walidacja po stronie serwera), higiena przed prompt-injection (traktuj zewnętrzny tekst jako nieufny; izoluj go od reguł systemowych) i logi audytu dla wykonania narzędzi i dostępu do danych.

Cel to przewidywalne zachowanie: model może sugerować akcje, ale backend decyduje, co jest dozwolone.

Wdrożenie, monitorowanie i bezpieczna iteracja

Wygeneruj interfejs czatu

Stwórz w React interfejs zorientowany na czat, który szybko przetestujesz i dopracujesz.

Wypuszczenie aplikacji asystenta to nie pojedyncze wydarzenie. To cykl: wydawaj mało, obserwuj realne użycie, dopracuj zachowanie i powtarzaj — bez łamania zaufania. Ponieważ asystenci mogą zmieniać zachowanie przy poprawce promptu lub integracji narzędzia, potrzebujesz dyscypliny wdrożeniowej, traktując konfigurację i prompty jak kod produkcyjny.

Wysyłaj stopniowo z flagami funkcji

Zakładaj, że każda nowa funkcja może zawieść w niespodziewany sposób: bugi stref czasowych, pamięć zapisująca złe informacje lub model robiący się zbyt kreatywny. Flagi funkcji pozwalają wystawić nowe narzędzia i zachowania pamięci tylko niewielkiej grupie użytkowników (lub kontom wewnętrznym) przed szerokim wdrożeniem.

Prosta strategia: odgatinguj każdą integrację narzędzia, oddzielnie gatinguj zapisy pamięci od odczytów, włącz tryb planowania tylko dla testerów, dodaj „safe mode” wyłączający wywołania narzędzi (tylko do odczytu) i używaj rolloutów procentowych dla ryzykownych zmian.

Rollback nie jest opcjonalny: snapshoty promptów i konfiguracji

Tradycyjne aplikacje cofają binaria; aplikacje asystentowe muszą też cofać zachowanie. Traktuj system prompts, schematy narzędzi, reguły routingu, polityki bezpieczeństwa i filtry pamięci jako wersjonowane artefakty. Trzymaj snapshoty, żeby szybko przywrócić ostatnie znane dobre zachowanie.

To szczególnie ważne przy szybkim iterowaniu z vibe coding: Koder.ai wspiera snapshoty i rollback, co pasuje do asystentów, gdzie małe edycje tekstu mogą mieć duży wpływ na produkt.

Strategia wdrożenia i domeny niestandardowe

Jeśli oferujesz white-label asystenta (dla zespołów lub klientów), planuj domeny niestandardowe wcześnie. To wpływa na callbacki auth, ustawienia ciasteczek/sesji, limity na tenant i separację logów/danych. Nawet dla produktu jednej marki zdefiniuj środowiska (dev/staging/prod), żeby testować uprawnienia narzędzi i ustawienia modeli bezpiecznie.

Monitoruj to, co ważne: niezawodność, szybkość i koszt

Monitorowanie asystenta to część analityki produktowej i operacji. Śledź opóźnienia i błędy, ale też sygnały behawioralne jak koszt na konwersację, częstotliwość wywołań narzędzi i współczynnik błędów narzędzi. Paruj metryki z losowo próbkowanymi audytami konwersacji, żeby zobaczyć, czy zmiany poprawiły wyniki — nie tylko przepustowość.

Budowanie szybciej z Vibe Coding (przykład workflow: Koder.ai)

Vibe coding jest najbardziej wartościowy, gdy potrzebujesz prawdziwego prototypu — nie tylko slajdów. Dla aplikacji asystenta zwykle oznacza to UI czatu, kilka podstawowych akcji (przechwyć zadanie, zapisz notatkę, zaplanuj przypomnienie) i backend, który pozostaje deterministyczny, nawet gdy LLM jest kreatywny. Platforma vibe-codingowa skraca czas do pierwszej działającej wersji, zamieniając opis produktu w działające ekrany, ścieżki i serwisy, które można uruchomić i udoskonalać.

Praktyczny workflow w stylu Koder.ai

Zacznij od opisania asystenta prostym językiem w czacie: dla kogo jest, co potrafi i jak wygląda „skończone” MVP. Iteruj małymi krokami.

Wygeneruj najpierw interfejs web w React (widok rozmowy, komponowanie wiadomości, lekka sekcja „użyte narzędzia” i prosty ekran ustawień), potem dodaj wersję mobilną we Flutter, gdy przepływy zaczną działać.

Następnie wygeneruj backend w Go z PostgreSQL: uwierzytelnianie, minimalne API rozmów i endpointy narzędzi (create task, list tasks, update task). Trzymaj zachowanie LLM jako cienką warstwę: instrukcje systemowe, schemat narzędzi i guardrails. Stamtąd iteruj prompt i UI razem: kiedy asystent robi złe założenie, dostosuj tekst zachowania i dodaj krok potwierdzania w UX.

Funkcje, które się liczą przy szybkiej iteracji

Priorytetyzuj akceleratory workflow, które utrzymują eksperymenty bezpieczne: tryb planowania (proponuj przed zastosowaniem), snapshoty i rollback (szybkie odzyskiwanie po złych iteracjach), wdrożenie i hosting z domenami niestandardowymi (szybki dostęp dla interesariuszy) oraz eksport kodu źródłowego (żeby zachować pełne prawa i przenieść się do dłuższego pipeline’u później).

Lista kontrolna na następne kroki

Zanim rozrośniesz się poza MVP, dopnij:

- Jednostronicowe specyfikacje MVP (3–5 zadań użytkownika, non-goals, kryteria sukcesu)

- Listę narzędzi (co asystent może robić przez API)

- Mały zestaw ewaluacyjny (20–50 scenariuszy + oczekiwane wyniki)

- Plan wdrożenia (środowiska, sekrety, strategia rollback, monitoring)

Z tą strukturą Koder.ai (koder.ai) może być praktycznym sposobem przejścia od koncepcji do działającego asystenta React/Go/PostgreSQL (a później Flutter) szybko, przy zachowaniu testowalności i możliwości przywracania zachowania.