10 lis 2025·8 min

Zmiany schematów i migracje w systemach tworzonych przez AI: przewodnik

Dowiedz się, jak systemy tworzone przez AI bezpiecznie obsługują zmiany schematów: wersjonowanie, zgodne wstecz wdrażanie, migracje danych, testowanie, obserwowalność i strategie cofania.

Co oznacza „schemat” w systemach tworzonych przez AI

„Schemat” to po prostu wspólne porozumienie dotyczące kształtu danych i znaczenia każdego pola. W systemach tworzonych z udziałem AI to porozumienie pojawia się w więcej miejsc niż tylko tabele bazy danych — i zmienia się częściej, niż zespoły się spodziewają.

Schemat to nie tylko baza danych

Schematy spotkasz przynajmniej na czterech typowych warstwach:

- Bazy danych: nazwy tabel/kolumn, typy danych, ograniczenia, indeksy i relacje.

- API: kształt JSON w żądaniach/odpowiedziach, pola wymagane vs opcjonalne, enumy, formaty błędów, konwencje paginacji.

- Zdarzenia i komunikaty: ładunki wysyłane przez strumienie, kolejki i webhooki (często wersjonowane niejawnie przez konsumentów).

- Konfiguracje i kontrakty: flagi funkcji, zmienne środowiskowe, konfiguracje YAML/JSON i „ukryte kontrakty” jak formaty plików czy konwencje nazewnictwa.

Jeśli dwie części systemu wymieniają dane, istnieje schemat — nawet jeśli nikt go nie zapisał.

Dlaczego w systemach tworzonych przez AI zmiany schematów występują częściej

Kod generowany przez AI może znacznie przyspieszyć rozwój, ale też zwiększa fluktuacje:

- Generowany kod odzwierciedla aktualny prompt i kontekst, więc drobne zmiany w promptach mogą zmienić nazwy pól, zagnieżdżenie, wartości domyślne lub walidacje.

- Wymagania ewoluują szybciej, gdy tanio jest wypuścić nowy endpoint lub krok w potoku.

- Niespójne konwencje (snake_case vs camelCase,

idvsuserId) pojawiają się, gdy wiele generacji lub refaktoryzacji wykonuje różnych autorów.

W efekcie częściej pojawia się „dryft kontraktu” między producentami a konsumentami.

Jeśli korzystasz z workflowu opartego na szybkim generowaniu (np. generowanie handlerów, warstw dostępu do bazy i integracji przez czat), warto od początku wbudować dyscyplinę pracy ze schematami. Platformy takie jak Koder.ai pomagają zespołom szybko tworzyć aplikacje React/Go/PostgreSQL i Flutter z interfejsu czatu — ale im szybciej możesz wypuszczać zmiany, tym ważniejsze staje się wersjonowanie interfejsów, walidacja ładunków i celowe wprowadzanie zmian.

Cel tego przewodnika

Ten artykuł koncentruje się na praktycznych sposobach utrzymania stabilności produkcji przy jednoczesnym szybkim iterowaniu: zachowaniu zgodności wstecznej, bezpiecznym wdrażaniu zmian i migracji danych bez niespodzianek.

Czego nie omówimy

Nie będziemy zagłębiać się w teoretycznie ciężkie modelowanie, metody formalne ani funkcje specyficzne dla dostawców. Nacisk jest na wzorce, które można zastosować w różnych stosach technologicznych — niezależnie od tego, czy system jest ręcznie napisany, wspomagany przez AI, czy w większości wygenerowany przez AI.

Dlaczego zmiany schematów występują częściej przy kodzie generowanym przez AI

Kod generowany przez AI sprawia, że zmiany schematów wydają się „normalne” — nie dlatego, że zespoły są niedbałe, lecz dlatego, że wejścia do systemu zmieniają się częściej. Gdy zachowanie aplikacji jest w części oparte na promptach, wersjach modeli i generowanym kodzie łączącym, kształt danych ma większą tendencję do dryftu w czasie.

Typowe wyzwalacze, które zobaczysz w praktyce

Kilka wzorców regularnie powoduje churn schematu:

- Nowe funkcje produktu: dodanie nowego pola (np.

risk_score,explanation,source_url) lub rozbicie jednego pojęcia na wiele (np.addressnastreet,city,postal_code). - Zmiany w wyjściu modelu: nowszy model może generować bardziej szczegółowe struktury, inne wartości enumów lub nieco inną nazwę pól („confidence” vs „score”).

- Aktualizacje promptów: poprawki promptów mające poprawić jakość mogą niezamierzenie zmienić formatowanie, pola wymagane lub zagnieżdżenie.

Ryzykowne wzorce, które czynią systemy AI kruche

Kod generowany przez AI często „działa” szybko, ale może zakodować delikatne założenia:

- Ukryte założenia: kod bierze za pewnik, że pole zawsze istnieje, zawsze jest liczbowe lub zawsze mieści się w określonym zakresie.

- Ukryte sprzężenia: jedna usługa polega na wewnętrznych nazwach pól lub kolejności innej usługi zamiast na zdefiniowanym interfejsie.

- Nieudokumentowane pola: model zaczyna emitować nowe właściwości, a kod downstream zaczyna na nich polegać, bez jasnego porozumienia, że to część kontraktu.

Dlaczego AI wzmacnia częstotliwość zmian

Generowanie kodu sprzyja szybkim iteracjom: regenerujesz handlery, parsery i warstwy dostępu do bazy, gdy wymagania się zmieniają. Ta szybkość jest użyteczna, ale ułatwia też wypuszczanie drobnych zmian interfejsu wielokrotnie — czasem bez zauważenia.

Bezpieczniejsze podejście to traktować każdy schemat jak kontrakt: tabele bazy danych, ładunki API, zdarzenia, a nawet strukturalne odpowiedzi LLM. Jeśli ktoś na tym polega, wersjonuj to, waliduj i zmieniaj świadomie.

Rodzaje zmian schematu: dodatnie vs. łamiące

Zmiany schematu nie są sobie równe. Najprostszym i najważniejszym pytaniem jest: czy istniejący konsumenci będą działać bez zmian? Jeśli tak, zwykle jest to zmiana dodatnia. Jeśli nie — to zmiana łamiąca i wymaga skoordynowanego planu wdrożenia.

Zmiany dodatnie (zwykle bezpieczne)

Zmiany dodatnie rozszerzają to, co już istnieje, bez zmiany dotychczasowego znaczenia.

Typowe przykłady w bazie danych:

- Dodanie kolumny z wartością domyślną lub zezwoleniem na NULL (np.

preferred_language). - Dodanie nowej tabeli lub indeksu.

- Dodanie opcjonalnego pola do JSON-a przechowywanego w kolumnie.

Przykłady poza bazą danych:

- Dodanie nowej właściwości do odpowiedzi API (klienci ignorujący nieznane pola nadal działają).

- Dodanie nowego pola zdarzenia w strumieniu/kolejce.

- Dodanie wartości do flagi funkcji, przy zachowaniu dotychczasowego zachowania jako domyślnego.

Dodatnie jest „bezpieczne” tylko wtedy, gdy starsi konsumenci są tolerancyjni: muszą ignorować nieznane pola i nie wymagać nowych.

Zmiany łamiące (ryzykowne)

Zmiany łamiące modyfikują lub usuwają coś, na czym konsumenci już polegają.

Typowe łamiące zmiany w bazie danych:

- Zmiana typu kolumny (string → integer, zmiana precyzji znacznika czasu).

- Zmienienie nazwy pola/kolumny (wszystko, co czyta starą nazwę, przestaje działać).

- Usunięcie kolumny/tabeli, która jest nadal zapytana.

Poza bazą danych łamiące zmiany to np.:

- Zmiana/usuńcie pól JSON w żądaniach/odpowiedziach.

- Zmiana semantyki zdarzenia (ta sama nazwa pola, inne znaczenie).

- Modyfikacja struktury webhooka bez podbicia wersji.

Zawsze zapisz wpływ na konsumentów

Zanim scalisz zmianę, udokumentuj krótko:

- Kto konsumuje (usługi, dashboardy, potoki danych, partnerzy).

- Zgodność (wstecz/naprzód i na jak długo).

- Tryb awarii (błędy parsowania, cicha korupcja danych, błędna logika biznesowa).

Ta krótka „notatka o wpływie” wymusza jasność — zwłaszcza gdy kod generowany przez AI wprowadza zmiany schematu niejawnie.

Strategie wersjonowania schematów i interfejsów

Wersjonowanie to sposób komunikowania innym systemom (i przyszłemu sobie): „to się zmieniło i tak wygląda ryzyko”. Cel to nie papierkowa robota — to zapobieganie cichej awarii, gdy klienci, usługi lub potoki danych aktualizują się w różnym tempie.

Prosty semantyczny mindset wersjonowania

Myśl w kategoriach major / minor / patch, nawet jeśli nie publikujesz dosłownie 1.2.3:

- Major: zmiana łamiąca. Starsi konsumenci mogą przestać działać lub działać niepoprawnie bez zmian.

- Minor: bezpieczne rozszerzenie. Starsi konsumenci nadal działają; nowi konsumenci mogą korzystać z nowych możliwości.

- Patch: poprawka błędu lub wyjaśnienie, które nie zmienia znaczenia.

Prosta zasada oszczędzająca zespoły: nigdy nie zmieniaj cichej semantyki istniejącego pola. Jeśli status="active" oznaczało „płacący klient”, nie używaj tego samego pola do oznaczania „konto istnieje”. Dodaj nowe pole lub nową wersję.

Wersjonowane endpointy vs. wersjonowane pola

Masz zwykle dwie praktyczne opcje:

1) Wersjonowane endpointy (np. /api/v1/orders i /api/v2/orders):

Dobre, gdy zmiany są naprawdę łamiące lub szeroko zakrojone. Jest to jasne, ale może tworzyć duplikację i długotrwałe utrzymanie, jeśli utrzymujesz wiele wersji.

2) Wersjonowane pola / ewolucja addytywna (np. dodaj new_field, zachowaj old_field):

Dobre, gdy można wprowadzić zmiany addytywnie. Starsi klienci ignorują to, czego nie rozumieją; nowsi czytają nowe pole. Z czasem zdeprecjonuj i usuń stare pole z jasnym planem.

Schematy zdarzeń i rejestry

Dla strumieni, kolejek i webhooków konsumenci są często poza Twoją kontrolą wdrożeniową. Rejestr schematów (lub dowolny scentralizowany katalog schematów z kontrolą kompatybilności) pomaga egzekwować reguły typu „tylko zmiany addytywne” i jasno pokazuje, którzy producenci i konsumenci polegają na jakich wersjach.

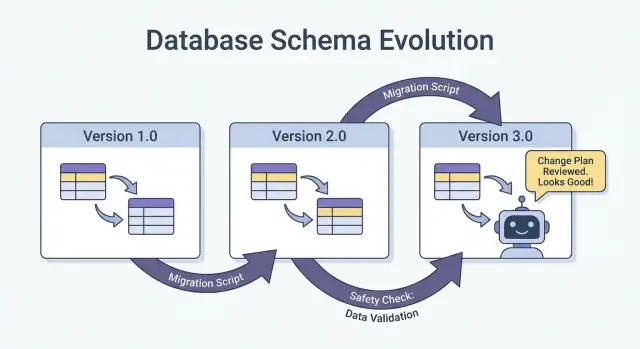

Bezpieczne wdrożenia: Expand/Contract (najbardziej niezawodny wzorzec)

Najbezpieczniejszy sposób wypuszczania zmian schematu — zwłaszcza przy wielu usługach, zadaniach i komponentach generowanych przez AI — to wzorzec expand → backfill → switch → contract. Minimalizuje przestoje i unika wdrożeń typu „wszystko albo nic”, gdzie jeden opóźniony konsument psuje produkcję.

Cztery kroki (i dlaczego działają)

1) Expand: Wprowadź nowy schemat w sposób zgodny wstecz. Istniejący czytelnicy i pisarze powinni działać bez zmian.

2) Backfill: Wypełnij nowe pola dla danych historycznych (lub przetwórz wiadomości ponownie), aby system stał się spójny.

3) Switch: Zaktualizuj pisarzy i czytelników, by używali nowego pola/formatu. Można to robić stopniowo (canary, rollout procentowy), ponieważ schemat obsługuje oba formaty.

4) Contract: Usuń stare pole/format dopiero, gdy będziesz pewien, że nikt już na nim nie polega.

Dwuetapowe (expand → switch) i trzyetapowe (expand → backfill → switch) wdrożenia zmniejszają przestoje, bo unikają silnego sprzężenia: pisarze mogą przejść jako pierwsi, czytelnicy później i odwrotnie.

Przykład: dodaj kolumnę, backfill, a potem ustaw ją jako wymaganą

Załóżmy, że chcesz dodać customer_tier.

- Expand: Dodaj

customer_tierjako nullable z domyślną wartością NULL. - Backfill: Uruchom zadanie, które obliczy tier dla istniejących wierszy.

- Switch: Zaktualizuj aplikację i potoki, aby zawsze zapisywały

customer_tier, i zaktualizuj czytelników, aby go preferowali. - Contract: Po monitoringu ustaw pole jako NOT NULL (i opcjonalnie usuń logikę legacy).

Koordynacja: pisarze i czytelnicy muszą się zgadzać

Traktuj każdy schemat jak kontrakt między producentami (pisarzami) a konsumentami (czytelnikami). W systemach tworzonych przez AI łatwo to przeoczyć, bo szybko pojawiają się nowe ścieżki kodu. Uczyń wdrożenia jawne: dokumentuj, która wersja zapisuje co, które usługi potrafią czytać oba formaty i dokładną „datę kontraktu”, kiedy stare pola można usunąć.

Migracje baz danych: jak zmieniać dane bez łamania produkcji

Keep full code ownership

Export source code to review migrations, validations, and contract changes in your repo.

Migracje bazy danych to „instrukcja obsługi” przenoszenia struktury i danych produkcyjnych ze stanu bezpiecznego do następnego. W systemach tworzonych przez AI mają one większe znaczenie, bo generowany kod może przypadkowo założyć istnienie kolumny, niekonsekwentnie zmienić nazwy lub zmodyfikować ograniczenia bez uwzględnienia istniejących wierszy.

Pliki migracji vs. auto-migracje

Pliki migracji (wpisane do kontroli źródła) to jawne kroki jak „dodaj kolumnę X”, „stwórz indeks Y” czy „skopiuj dane z A do B”. Są audytowalne, podlegają przeglądowi i można je odtworzyć w środowiskach testowych i produkcyjnych.

Auto-migracje (generowane przez ORM/ramy) są wygodne w wczesnym rozwoju i prototypowaniu, ale mogą wygenerować ryzykowne operacje (usuwanie kolumn, przebudowę tabel) lub zmienić kolejność zmian w sposób niezamierzony.

Praktyczna zasada: używaj auto-migracji do szkicowania zmian, a do wszystkiego, co trafia na produkcję, konwertuj je do przeglądanych plików migracji.

Idempotentność i kolejność

Spraw, by migracje były idempotentne tam, gdzie to możliwe: ponowne uruchomienie nie powinno uszkodzić danych ani kończyć się błędem w połowie. Preferuj „create if not exists”, dodawaj nowe kolumny jako najpierw nullable i zabezpieczaj transformacje danych warunkami.

Miej też jasną kolejność. Każde środowisko (lokalne, CI, staging, prod) powinno stosować te same migracje w tej samej sekwencji. Nie „naprawiaj” produkcji ręcznym SQL-em bez zapisania tej poprawki w migracji po fakcie.

Długotrwałe migracje bez blokowania tabeli

Niektóre zmiany mogą blokować zapisy (a nawet odczyty) przy dużych tabelach. Wysokopoziomowe sposoby na zmniejszenie ryzyka:

- Używaj operacji online/minimalizujących blokady, jeśli są wspierane przez bazę (np. budowa indeksów równoległych).

- Podziel zmiany na kroki: najpierw dodaj nowe struktury, potem backfill w partiach, a na końcu przełącz aplikację.

- Planuj ciężkie operacje w oknach niskiego ruchu, z limitami czasu i monitoringiem.

Multi-tenant i sharded konfiguracje

Dla multi-tenant uruchamiaj migracje w kontrolowanej pętli dla każdego tenant-a, z śledzeniem postępu i bezpiecznymi retry. Dla shardów traktuj każdy shard jak oddzielny system produkcyjny: wdrażaj migracje po kolei, weryfikuj zdrowie, a potem kontynuuj. To ogranicza blast radius i ułatwia rollback.

Backfille i ponowne przetwarzanie: aktualizacja istniejących danych

Backfill to wypełnienie nowo dodanych pól (lub skorygowanych wartości) dla istniejących rekordów. Reprocessing to przepuszczenie historycznych danych ponownie przez potok — zwykle dlatego, że reguły biznesowe się zmieniły, naprawiono błąd lub zaktualizowano format wyjścia modelu.

Oba elementy pojawiają się często po zmianach schematu: łatwo jest zacząć zapisywać nowy kształt dla „nowych danych”, ale systemy produkcyjne również polegają na danych z wczoraj, które powinny być spójne.

Typowe podejścia

Online backfill (w produkcji, stopniowo). Uruchamiasz kontrolowane zadanie, które aktualizuje rekordy małymi partiami, podczas gdy system działa. Bezpieczniejsze dla krytycznych usług, bo możesz kontrolować obciążenie, wstrzymać i wznowić.

Batch backfill (offline lub zaplanowane zadania). Przetwarzasz duże porcje w oknach niskiego ruchu. Prostsze operacyjnie, ale może powodować skoki obciążenia bazy i trudniej cofnąć błędy.

Lazy backfill przy odczycie. Gdy stary rekord jest czytany, aplikacja oblicza/wypełnia brakujące pola i zapisuje je z powrotem. Rozkłada to koszt w czasie i unika dużego zadania, ale powoduje, że pierwszy odczyt jest wolniejszy i może pozostawić „stare” dane nieprzekonwertowane przez dłuższy czas.

W praktyce zespoły często łączą podejścia: lazy backfill dla długiego ogona rekordów oraz online job dla najczęściej używanych danych.

Jak walidować backfill

Walidacja powinna być jawna i mierzalna:

- Liczby: ile wierszy/zdarzeń powinno zostać zaktualizowanych vs ile zostało zaktualizowanych.

- Sumy kontrolne/agregaty: porównaj sumy (np. suma kwot, distinct ID) przed/po.

- Próbkowanie: ręczna kontrola statystycznie znaczącej próbki, w tym przypadków brzegowych.

Waliduj też efekty downstream: dashboardy, indeksy wyszukiwania, cache i eksporty, które polegają na zaktualizowanych polach.

Koszt, czas i kryteria akceptacji

Backfille bilansują szybkość (skończyć szybko) z ryzykiem i kosztem (obciążenie, moc obliczeniowa i nakład operacyjny). Ustal kryteria akceptacji z góry: co oznacza „zrobione”, oczekiwany czas działania, maksymalny dopuszczalny współczynnik błędów i co zrobisz, gdy walidacja zawiedzie (pauza, retry lub rollback).

Ewolucja schematów zdarzeń i komunikatów (strumienie, kolejki, webhooki)

Plan your next schema change

Use planning mode to map expand-backfill-switch-contract before you generate code.

Schematy nie żyją tylko w bazach. Za każdym razem, gdy jeden system wysyła dane do innego — Kafka, SQS/RabbitMQ, webhooki, a nawet „zdarzenia” zapisywane w object storage — tworzysz kontrakt. Producenci i konsumenci poruszają się niezależnie, więc te kontrakty psują się częściej niż wewnętrzne tabele aplikacji.

Najbezpieczniejszy domyślny wybór: ewolucja zdarzeń zgodna wstecz

Dla strumieni zdarzeń i payloadów webhooków preferuj zmiany, które starsi konsumenci mogą zignorować, a nowe konsumenci przyjąć.

Praktyczna zasada: dodawaj pola, nie usuwaj ani nie zmieniaj nazw. Jeśli musisz zdeprecjonować coś, nadal to wysyłaj przez pewien czas i oznacz jako przestarzałe.

Przykład: rozszerz zdarzenie OrderCreated o pola opcjonalne.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Starsze konsumenty czytają order_id i created_at i ignorują resztę.

Kontrakty napędzane przez konsumentów (wersja w prostym języku)

Zamiast producenta zgadującego, co może złamać innych, konsumenci publikują, na co polegają (pola, typy, reguły wymagane/opcjonalne). Producent waliduje zmiany względem tych oczekiwań przed wypuszczeniem. To szczególnie przydatne w bazach kodu generowanych przez AI, gdzie model może „pomóc” zmieniając nazwę pola lub typ.

Bezpieczne obsługiwanie „nieznanych pól”

Uczyń parsery tolerancyjnymi:

- Ignoruj nieznane pola domyślnie (nie przerywaj, tylko dlatego, że pojawił się nowy klucz).

- Traktuj nowe pola jako opcjonalne, dopóki naprawdę ich nie potrzebujesz.

- Loguj nieoczekiwane pola na niskim poziomie, aby zauważyć adopcję bez pagerowania.

Gdy potrzebna jest zmiana łamiąca, użyj nowego typu zdarzenia lub wersjonowanej nazwy (np. OrderCreated.v2) i puszczaj obie wersje równolegle, aż wszyscy konsumenci się przeniosą.

Wyjścia AI jako schemat: prompt, modele i strukturalne odpowiedzi

Gdy do systemu dodasz LLM, jego wyjścia szybko stają się de facto schematem — nawet jeśli nikt nie napisał formalnej specyfikacji. Kod downstream zaczyna zakładać „będzie pole summary”, „pierwsza linia to tytuł” lub „punktory są oddzielone myślnikami”. Te założenia twardnieją, a drobne przesunięcie w zachowaniu modelu może je złamać tak samo jak zmiana kolumny w bazie.

Preferuj jawne struktury (i je waliduj)

Zamiast parsować „ładny tekst”, proś o strukturalne wyjścia (najczęściej JSON) i waliduj je, zanim trafią do reszty systemu. Traktuj to jak przejście od „najlepszej próby” do kontraktu.

Praktyczne podejście:

- Zdefiniuj JSON Schema (lub typowany interfejs) dla odpowiedzi modelu.

- Odrzucaj lub kwarantannuj nieprawidłowe odpowiedzi (nie ciche konwertowanie).

- Loguj błędy walidacji, by widzieć, co się zmienia.

To szczególnie ważne, gdy odpowiedzi LLM zasilały potoki danych, automatyzację lub treści widoczne dla użytkownika.

Planuj dryft modelu

Nawet z tym samym promptem, odpowiedzi mogą się zmieniać w czasie: pola mogą być pomijane, pojawiać się dodatkowe klucze, a typy mogą się zmieniać ("42" vs 42, tablice vs łańcuchy). Traktuj to jak wydarzenia ewolucji schematu.

Skuteczne łagodzenia:

- Uczyń pola opcjonalnymi tam, gdzie to rozsądne, i ustawiaj jawne wartości domyślne.

- Pozwól na nieznane klucze, ale ignoruj je bezpiecznie (chyba że wymagasz ścisłości ze względów zgodności).

- Dodaj „strażniki” (np. pola wymagane, maksymalne długości, wartości enum).

Traktuj zmiany promptów jak zmiany API

Prompt to interfejs. Jeśli go edytujesz, wersjonuj go. Trzymaj prompt_v1, prompt_v2 i wdrażaj stopniowo (feature flagi, canary lub przełączniki per-tenant). Testuj na ustalonym zbiorze ewaluacyjnym przed promocją zmian i utrzymuj starsze wersje działające, dopóki konsumenci downstream się nie dostosują. Dla więcej informacji o mechanice bezpiecznych rolloutów, połącz swoje podejście z tekstem "/blog/safe-rollouts-expand-contract".

Testowanie i walidacja zmian schematu

Zmiany schematów zwykle zawodzą w nudny, kosztowny sposób: nowa kolumna brakuje w jednym środowisku, konsument nadal oczekuje starego pola, albo migracja działała na pustych danych, ale kończyła się timeoutem w produkcji. Testy zamieniają te „niespodzianki” w przewidywalne, naprawialne zadania.

Trzy poziomy testów (i co wykrywają)

Testy jednostkowe chronią lokalną logikę: funkcje mapujące, serializatory/deserializatory, walidatory i buildery zapytań. Jeśli pole zostanie przemianowane lub typ się zmieni, testy jednostkowe powinny polec w pobliżu kodu wymagającego aktualizacji.

Testy integracyjne upewniają, że aplikacja działa z rzeczywistymi zależnościami: prawdziwym silnikiem bazy, narzędziem migracji i prawdziwymi formatami wiadomości. Tutaj wykrywamy problemy typu „model ORM zmienił się, ale migracja nie” lub „nowa nazwa indeksu koliduje”.

Testy end-to-end symulują ścieżki użytkownika lub workflowy między usługami: twórz dane, migruj je, odczytaj z API i zweryfikuj, czy konsumenci downstream wciąż zachowują się poprawnie.

Testy kontraktowe dla producentów i konsumentów

Ewolucja schematu często psuje się na granicach: API między usługami, strumienie, kolejki i webhooki. Dodaj testy kontraktowe uruchamiane po obu stronach:

- Producenci dowodzą, że potrafią emitować zdarzenia/odpowiedzi zgodne z umówionym kontraktem.

- Konsumenci dowodzą, że potrafią sparsować zarówno starą, jak i nową wersję podczas rolloutu.

Testowanie migracji: apply i rollback na świeżych środowiskach

Testuj migracje tak, jak je wdrażasz:

- Zacznij od czystego snapshotu bazy.

- Zastosuj wszystkie migracje w kolejności.

- Zweryfikuj, że aplikacja może czytać/zapisywać.

- Uruchom rollback (jeśli wspierany) lub migrację „down” i potwierdź, że wraca do działającego stanu.

Fixtures dla starych i nowych wersji schematu

Zachowaj niewielki zestaw fixture’ów reprezentujących:

- Dane zapisane pod poprzednim schematem (legacy rows/events).

- Dane zapisane pod nowym schematem.

Te fixtures ujawniają regresje, szczególnie gdy kod generowany przez AI subtelnie zmienia nazwy pól, ich opcjonalność lub formatowanie.

Obserwowalność: wczesne wykrywanie awarii

Build and get rewarded

Share what you built with Koder.ai or invite a teammate and earn credits.

Zmiany schematu rzadko kończą się głośną awarią w chwili wdrożenia. Częściej pęknięcia objawiają się powolnym wzrostem błędów parsowania, ostrzeżeń o „nieznanych polach”, brakującymi danymi lub zaległościami w zadaniach background. Dobra obserwowalność zamienia te słabe sygnały w działające alerty, gdy jeszcze możesz zatrzymać rollout.

Co monitorować podczas rolloutu

Zacznij od podstaw (zdrowie aplikacji), potem dodaj sygnały specyficzne dla schematu:

- Błędy: skoki 4xx/5xx, ale też „miękkie” błędy jak nieudane parsowanie JSON, błędy deserializacji i retry.

- Opóźnienia: p95/p99 czasów odpowiedzi i czas przetwarzania kolejek. Zmiany schematu mogą dodać joiny, większe ładunki lub dodatkową walidację.

- Sygnały jakości danych: wzrost udziału null w ważnych kolumnach, nagły spadek ilości zdarzeń, zbyt częste pojawianie się wartości domyślnych lub rozbieżności między starymi a nowymi reprezentacjami.

- Opóźnienie potoków: lag konsumentów w strumieniach/kolejkach, backlog dostaw webhooków i przepustowość zadań migracyjnych.

Kluczowe jest porównywanie przed vs. po i krojenie według wersji klienta, wersji schematu i segmentu ruchu (canary vs. stable).

Dashboardy, które naprawdę pomagają

Stwórz dwa widoki dashboardów:

-

Dashboard zachowania aplikacji

- Ruch żądań, wskaźnik błędów, opóźnienia (RED)

- Najważniejsze wyjątki (grupowane po komunikacie)

- Liczba i odsetek błędów walidacji/parsingowych

- Rozkład rozmiaru ładunku (by wykryć nieoczekiwanie duże wiadomości)

-

Dashboard migracji i zadań background

- Postęp joba migracyjnego (% ukończone), wiersze przetwarzane/s, ETA

- Wskaźnik błędów i liczba retry

- Głębokość kolejki / lag konsumenta

- Wolumen dead-letter queue (jeśli dotyczy)

Jeśli prowadzisz rollout expand/contract, dodaj panel pokazujący odczyty/zapisy podzielone na stary vs. nowy schemat, żeby wiedzieć, kiedy można bezpiecznie przejść do następnego etapu.

Alerty dla problemów ze schematem

Pageruj (page) przy problemach wskazujących na utratę lub błędne odczyty danych:

- Wskaźnik błędów walidacji schematu powyżej niskiego progu (często <0.1% już jest znaczące)

- Błędy parsowania/deserializacji (zwłaszcza skoncentrowane u jednego producenta/konsumenta)

- Nieoczekiwane pole / brakujące pole wymagane rosnące w trendzie

- Job migracyjny zatrzymany (brak postępu przez N minut) lub lag rośnie szybciej niż przepustowość

Unikaj hałasu z surowych 500 bez kontekstu; powiąż alerty z rolloutem schematu przy pomocy tagów takich jak wersja schematu i endpoint.

Loguj wersję, by szybko debugować

Podczas przejścia loguj i dołączaj:

- Wersję schematu (np. nagłówek

X-Schema-Version, pole metadanych wiadomości) - Wersję aplikacji producenta i konsumenta

- Wersję modelu / wersję promptu, gdy wyjścia AI zasilają strukturalne dane

To jedno ułatwia odpowiedź na pytanie „dlaczego ten ładunek nie przeszedł?” w minutach, nie w dniach — zwłaszcza gdy różne usługi (lub różne wersje modelu) działają jednocześnie.

Rollback, odzyskiwanie i zarządzanie zmianą

Zmiany schematów zawodzą na dwa sposoby: sama zmiana jest błędna, albo otoczenie zachowuje się inaczej niż oczekiwano (szczególnie gdy generowany kod AI wprowadza subtelne założenia). W każdym przypadku każda migracja potrzebuje historii rollbacku zanim zostanie wysłana — nawet jeśli ta historia brzmi „brak rollbacku”.

Wybranie „braku rollbacku” może być uzasadnione, gdy zmiana jest nieodwracalna (np. usuwanie kolumn, przepisywanie identyfikatorów, deduplikacja destrukcyjna). Ale „brak rollbacku” to nie brak planu; to decyzja przesuwająca plan na poprawki do przodu, przywracanie i ograniczanie szkód.

Praktyczne opcje rollbacku, które naprawdę działają

Flagii funkcji / bramki konfiguracyjne: Opakuj nowych czytelników, pisarzy i pola API za flagą, żebyś mógł wyłączyć nowe zachowanie bez redeployu. Szczególnie przydatne, gdy kod generowany przez AI jest poprawny składniowo, ale błędny semantycznie.

Wyłącz dual-write: Jeśli zapisujesz jednocześnie do starego i nowego schematu podczas expand/contract, miej wyłącznik. Wyłączenie nowej ścieżki zapisu zatrzyma dalsze rozjeżdżanie się danych, podczas gdy badacie problem.

Przywróć czytelników (nie tylko pisarzy): Wiele incydentów zdarza się, bo konsumenci zaczynają czytać nowe pola lub tabele za wcześnie. Ułatw skierowanie usług z powrotem do poprzedniej wersji schematu lub zignorowanie nowych pól.

Znaj swoje granice odwracalności

Niektóre migracje nie dają się ładnie cofnąć:

- Transformacje destrukcyjne (np. haszowanie, normalizacja z utratą informacji).

- Usunięcia/zmiany nazw bez zachowanej kopii.

- Backfille, które nadpisują „źródło prawdy”.

Dla nich zaplanuj przywrócenie z backupu, odtworzenie z wydarzeń lub przeliczenie z surowych wejść — i upewnij się, że te wejścia wciąż masz.

Lista kontrolna przed wysłaniem (pre-flight)

- Decyzja o rollbacku udokumentowana („revert”, „forward fix” lub „no rollback + restore path”).

- Jasny przycisk STOP: flagi i/lub wyłącznik dual-write.

- Backupy/snapshoty zweryfikowane; przywrócenie przetestowane przynajmniej raz.

- Migracja idempotentna; ponowne uruchomienia nie uszkodzą danych.

- Monitoring i alerty dla wskaźników błędów, walidacji schematu i lagu.

- Własność: kto zatwierdza, kto uruchamia, kto jest on-call podczas rolloutu.

Dobre zarządzanie zmianą sprawia, że rollbacki są rzadkie — a jeśli się zdarzą, odzyskiwanie jest nudne.

Jeśli Twój zespół iteruje szybko z pomocą AI, warto łączyć te praktyki z narzędziami wspierającymi bezpieczne eksperymenty. Na przykład Koder.ai oferuje planning mode do projektowania zmian z wyprzedzeniem oraz snapshots/rollback do szybkiego odzyskiwania, gdy wygenerowana zmiana przypadkowo przesunie kontrakt. Użyte razem, szybkie generowanie kodu i zdyscyplinowana ewolucja schematów pozwalają poruszać się szybciej bez traktowania produkcji jak środowiska testowego.