Vad “iteration” betyder — och var AI passar in

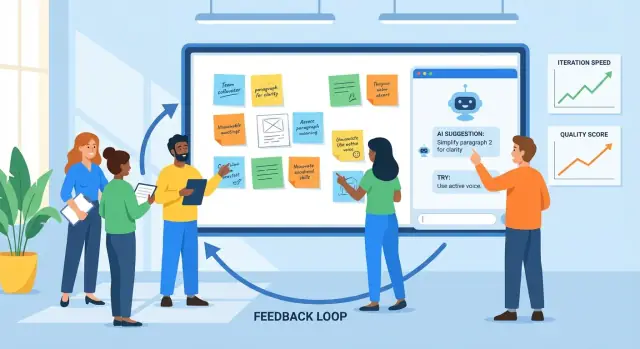

Iteration är praktiken att skapa något, få återkoppling, förbättra det och upprepa cykeln. Du ser det inom produktdesign (släpp en funktion, följ användning, förfina), marknadsföring (testa ett budskap, lär dig, skriv om) och skrivande (utkast, granskning, redigering).

Återkoppling är alla signaler som berättar vad som fungerar och vad som inte gör det: användarkommentarer, supportärenden, bugg‑rapporter, enkätsvar, prestationsmått, intressenters anteckningar — till och med din egen magkänsla efter att ha använt saken själv. Förbättring är vad du ändrar baserat på de signalerna, från små justeringar till större redesign.

Varför kortare cykler spelar roll

Kortare återkopplingscykler leder oftast till bättre resultat av två skäl:

- Kvaliteten förbättras snabbare: Du fångar missförstånd och fel tidigt, innan de sprider sig över fler sidor, skärmar eller releaser.

- Hastighet ökar utan gissningar: Du spenderar mindre tid på abstrakta debatter och mer tid på att lära av verklig evidens.

En bra iterationsrytm är inte “rör dig snabbt och bryt saker”. Den är “rör dig i små steg och lär dig snabbt.”

Var AI hjälper (och var den inte gör det)

AI är användbart i loopen när det finns mycket information och du behöver hjälp att bearbeta den. Det kan:

- sammanfatta återkoppling från många källor till teman

- upptäcka återkommande klagomål, förvirrande formuleringar eller saknade detaljer

- föreslå alternativa versioner (text, layouter, uppgiftsformuleringar) att överväga

- agera som ett andra par ögon för tydlighet, ton och konsekvens

Men AI kan inte ersätta de centrala besluten. Den känner inte till dina affärsmål, juridiska begränsningar eller vad “bra” betyder för dina användare om du inte definierar det. Den kan med tilltro föreslå ändringar som är off‑brand, riskfyllda eller baserade på felaktiga antaganden.

Sätt förväntningar tydligt: AI stöder omdöme. Ditt team väljer fortfarande vad som ska prioriteras, vad som ska ändras, vad framgång betyder — och validerar förbättringar med riktiga användare och verklig data.

Den grundläggande återkopplingsloopen: en praktisk modell

Iteration blir lättare när alla följer samma loop och vet vad “klart” betyder. En praktisk modell är:

utkast → återkoppling → revidera → kontrollera → släpp

Team fastnar ofta för att ett steg är långsamt (granskningar), rörigt (återkoppling spridd över verktyg) eller otydligt (vad exakt ska ändras?). Använd medvetet kan AI minska friktionen i varje punkt.

Steg 1: Utkast (kom till något som går att granska)

Målet är inte perfektion; det är en stabil första version som andra kan reagera på. En AI‑assistent kan hjälpa dig att skapa en struktur, generera alternativ eller fylla luckor så att du snabbare når “granskningsbart”.

Där det hjälper mest: omvandla en grov brief till ett strukturerat utkast och producera flera alternativ (t.ex. tre rubriker, två onboarding‑flöden) att jämföra.

Steg 2: Återkoppling (fånga och kondensera)

Återkoppling kommer oftast som långa kommentarer, chattrådar, anteckningar från samtal och supportärenden. AI är användbart för att:

- sammanfatta återkommande teman (vad folk hela tiden nämner)

- gruppera återkoppling efter ämne (pris, onboarding, ton, buggar)

- extrahera frågor och “måste‑fixa” kontra “bra‑att‑ha”

Flaskhalsen du tar bort: långsam läsning och inkonsekvent tolkning av vad granskaren menade.

Steg 3: Revidera (gör reaktioner till förändringar)

Här förlorar team tid på omskrivningar: otydlig återkoppling leder till ändringar som inte tillfredsställer granskaren, och loopen upprepas. AI kan föreslå konkreta ändringar, presentera reviderad text eller generera en andra version som tydligt adresserar de viktigaste feedback‑teman.

Steg 4: Kontrollera (kvalitet innan du släpper)

Innan release, använd AI som ett andra par ögon: introducerar den nya versionen motsägelser, saknade steg, brutna krav eller tonavvikelser? Målet är inte att “godkänna” arbetet; det är att fånga upp uppenbara problem tidigt.

Steg 5: Släpp med en enda sanningskälla

Iteration går snabbare när ändringar finns på en plats: en ticket, ett dokument eller en PR‑beskrivning som dokumenterar (1) sammanfattningen av återkoppling, (2) besluten och (3) vad som ändrades.

AI kan hjälpa till att upprätthålla den “en enda sanningskällan” genom att utarbeta uppdateringsanteckningar och hålla acceptanskriterier i linje med de senaste besluten. I team som bygger och levererar mjukvara direkt (inte bara dokument) kan plattformar som Koder.ai också förkorta detta steg genom att hålla planering, implementering och distribution tätt kopplade — så att berättelsen “vad som ändrades” förblir nära den faktiska releasen.

Samla in återkoppling: vad AI kan bearbeta väl

AI kan bara förbättra det du matar den med. Den goda nyheten är att de flesta team redan har gott om återkoppling — bara utspridd över olika platser och skriven i olika stilar. Din uppgift är att samla den konsekvent så att AI kan sammanfatta, upptäcka mönster och hjälpa dig bestämma vad som ska ändras härnäst.

AI är stark med röriga, texttunga indata, inklusive:

- användarkommentarer (i appen, community‑inlägg, chat)

- supportärenden och chatttranskript

- enkätsvar (öppna frågor)

- app‑store och marknadsplatsomdömen

- säljsupport‑anteckningar och mötessammanfattningar

- buggrapporter och funktionsförfrågningar från interna team

Du behöver inte perfekt formatering. Det som är viktigt är att fånga de ursprungliga orden och en liten mängd metadata (datum, produktområde, plan osv.).

Från “en hög med citat” till teman och smärtpunkter

När det är samlat kan AI klustra återkoppling till teman — fakturaförvirring, onboarding‑friktion, saknade integrationer, låg prestanda — och visa vad som upprepas oftast. Det spelar roll eftersom den högsta rösten inte alltid är det vanligaste problemet.

En praktisk approach är att be AI om:

- en temalista med korta etiketter

- representativa citat per tema (så att du kan sanity‑checka)

- frekvenssignaler (t.ex. “nämnt i 18 tickets denna vecka”)

- effekthints (vem det påverkar och vad det blockerar)

Behåll kontext så att insikterna förblir relevanta

Återkoppling utan kontext kan leda till generiska slutsatser. Bifoga lättviktig kontext till varje objekt, såsom:

- persona eller kundtyp (ny användare, admin, avancerad användare)

- användarens mål ("exportera en rapport", "bjuda in kollegor")

- begränsningar (enhet, region, plan‑nivå, compliance‑behov)

Även några konsekventa fält gör AI:s gruppering och sammanfattningar mycket mer handlingsbara.

Integritets‑ och datahanteringsgrunder

Innan analys, ta bort känslig information: namn, e‑post, telefonnummer, adresser, betalningsuppgifter och allt konfidentiellt i samtalsanteckningar. Föredra dataminimering — dela bara det som behövs för uppgiften — och lagra råexporter säkert. Om du använder tredjepartsverktyg, bekräfta ditt teams policy för retention och träning, och begränsa åtkomst till datasetet.

Att göra rå återkoppling till tydliga, handlingsbara insikter

Rå återkoppling är oftast en hög av osorterade indata: supportärenden, app‑recensioner, enkätkommentarer, säljsupport‑anteckningar och Slack‑trådar. AI är användbart här eftersom det kan läsa “rörigt” språk i skala och hjälpa dig omvandla det till en kort lista med teman ni faktiskt kan arbeta med.

1) Från spridda kommentarer till kategorier

Börja med att mata AI en batch av återkoppling (efter att du tagit bort känslig data) och be den gruppera poster i konsekventa kategorier som onboarding, prestanda, pris, UI‑förvirring, buggar och funktionsönskemål. Målet är inte perfekt taxonomi — det är en gemensam karta teamet kan använda.

En praktisk output kan se ut så här:

- Kategori: Onboarding‑förvirring

- Vad användare försöker göra: Koppla konto, importera data

- Observerade hinder: “Hittade inte importknappen”, “Var inte säker på om det fungerade”

2) Lägg till prioriteringar med ett enkelt ramverk

När återkopplingen är grupperad, be AI föreslå en prioritetspoäng med hjälp av ett rubric du kan granska:

- Impact: Hur mycket påverkar detta användarsuccé eller intäkter?

- Frequency: Hur ofta dyker det upp över källor?

- Effort: Hur svårt är det att fixa (tid, beroenden)?

- Risk: Hur stor är chansen att det bryter något eller orsakar compliance/support‑problem?

Håll det enkelt (Hög/Med/Låg) eller numeriskt (1–5). Nyckeln är att AI gör första utkastet och människor bekräftar antagandena.

3) Summera utan att tappa nyans (behåll kvittona)

Summeringar blir farliga när de suddar ut “varför”. Ett användbart mönster är: temasammanfattning + 2–4 representativa citat. Till exempel:

“Jag kopplade Stripe men inget hände — synkade det?”

“Installationsguiden hoppade över ett steg och jag visste inte vad jag skulle göra härnäst.”

Citat bevarar känsloton och kontext — och hindrar teamet från att behandla varje ärende som identiskt.

4) Håll utkik efter bias: högljudd betyder inte alltid vanlig

AI kan överskatta dramatisk ton eller upprepade kommentatorer om du inte styr den. Be den separera:

- Volym‑signaler (hur många unika användare nämner det)

- Allvarlighets‑signaler (hur illa är det när det inträffar)

Sen jämför mot användardata och segmentering. Ett klagomål från avancerade användare kan vara viktigt — eller så speglar det en nischad arbetsflödesfråga. AI kan hjälpa dig se mönster, men kan inte avgöra vad som ”representerar dina användare” utan din kontext.

Använd AI för att generera varianter, inte bara “svaret”

Gör iteration till en vana

Arbeta snabbare som ett team genom att hålla beslut, bygg och releaser på samma plats.

Tänk på AI‑verktyget som en variantgenerator. Istället för att be om ett enda “bästa” svar, be om flera rimliga utkast du kan jämföra, blanda och förfina. Den inställningen håller dig i kontroll och gör iterationen snabbare.

Detta är särskilt kraftfullt när du itererar på produktytor (onboarding‑flöden, UI‑text, funktionsspecifikationer). Till exempel, om du bygger ett internt verktyg eller en enkel kundapp i Koder.ai, kan du använda samma “generera flera versioner”‑tänk för att utforska olika skärmar, flöden och krav i Planning Mode innan du bestämmer dig — och sedan förlita dig på snapshots och rollback för att hålla snabba ändringar säkra.

Ge begränsningar så att varianterna går att jämföra

Om du ber “skriv åt mig” får du ofta generiskt innehåll. Bättre: definiera ramar så AI kan utforska alternativ inom dem.

Pröva att specificera:

- Målgrupp + avsikt: “Nya användare som funderar på att registrera sig” vs. “Befintliga kunder som behöver lugnas.”

- Ton: vänlig, direkt, formell, lekfull (välj en).

- Längd: t.ex. “120–150 ord” eller “max 3 punkter”.

- Format: e‑post, landningssidans hero, FAQ, release‑note.

- Måste‑behåll‑fakta: priser, datum, garantier, produktbegränsningar.

- Måste‑undvikas: förbjudna påståenden, känslig formulering, konkurrensomnämnanden.

Med begränsningar kan du generera “Version A: kort”, “Version B: mer empatisk”, “Version C: mer specifik” utan att tappa exakthet.

Generera flera alternativ, välj (eller kombinera)

Be om 3–5 alternativ på en gång och gör skillnaderna tydliga: “Varje version ska använda en annan struktur och öppningsrad.” Det skapar verklig kontrast, vilket hjälper dig se vad som saknas och vad som träffar rätt.

En praktisk arbetsflöde:

- Generera 3–5 versioner.

- Välj de starkaste delarna (öppning från A, proof points från C, CTA från B).

- Be AI slå ihop dem till ett utkast, med dina måste‑behåll‑fakta intakta.

Snabbchecklista: vad ett “bra utkast” innehåller

Innan du skickar ett utkast för granskning eller test, kontrollera att det har:

- ett tydligt mål (vad läsaren ska göra/förstå)

- viktiga fakta bevarade och konsekventa

- en specifik, trovärdig anledning att bry sig (fördel + bevis)

- en primär uppmaning till handling

- enkelt språk med minimal jargong

- inga obefogade löften eller vaga superlativer

Använt så här ersätter inte AI omdömet — det snabbar upp sökandet efter en bättre version.

AI som granskare: fånga problem tidigt

Innan du släpper ett utkast — vare sig det är en funktionsspecifikation, release‑note, hjälpartikel eller marknadssida — kan ett AI‑verktyg agera som en snabb “första granskare.” Målet är inte att ersätta mänskligt omdöme; det är att lyfta upp uppenbara problem tidigt så att ditt team ägnar tid åt de svåra besluten, inte grundläggande städning.

Vad AI‑assisterade granskningar gör bra

AI‑granskningar är särskilt användbara för:

- Tydlighet: hitta långa meningar, oklara termer eller saknad kontext för en ny läsare.

- Konsekvens: kontrollera namn (funktionsetiketter, versalisering), upprepade påståenden och motsägelser mellan sektioner.

- Ton: anpassa rösten till din målgrupp (vänlig, direkt, formell) och flagga formuleringar som kan låta defensiva eller vaga.

- Fullständighet: peka ut saknade steg, edge cases, förutsättningar eller “vad händer härnäst”‑luckor.

Praktiska granskpromptar du kan återanvända

Klistra in ditt utkast och be om en specifik typ av kritik. Exempel:

- “Granska efter luckor: vilka frågor skulle en förstagångsanvändare fortfarande ha?”

- “Flagga antaganden: vad antar jag är sant om produkten, användaren eller arbetsflödet?”

- “Förenkla: skriv om varje mening över 25 ord och behåll betydelsen.”

- “Kontrollera inkonsekvenser: lista termer som används på flera olika sätt.”

Roll‑baserade kritik för bredare perspektiv

Ett snabbt sätt att bredda perspektivet är att be modellen granska utifrån olika roller:

- “Som en kund, vad känns förvirrande eller riskabelt?”

- “Som support, vilka tickets kan detta generera?”

- “Som PM, vilka acceptanskriterier saknas?”

- “Som legal/compliance, vilka påståenden behöver skärpas?”

Säkerhetskontroll: verifiera fakta

AI kan självsäkert kritisera formuleringar samtidigt som den har fel om produktdetaljer. Behandla faktiska punkter — priser, funktionsstatus, säkerhetspåståenden, tidslinjer — som “behöver verifiering.” Habitera att märka påståenden med källor (dokument, tickets eller beslut) så slutversionen speglar verkligheten, inte en trovärdig gissning.

Konvertera återkoppling till ändringar, uppgifter och acceptanskriterier

Rå återkoppling är sällan färdig att implementera. Den tenderar att vara känslomässig (“det känns fel”), blandad (“jag gillar det men…”) eller underdetaljerad (“gör det tydligare”). AI kan hjälpa till att översätta det till arbetsuppgifter ditt team faktiskt kan leverera — samtidigt som originalkommentaren behålls så att ni kan motivera beslut senare.

En enkel mall AI kan fylla i

Be ditt AI‑verktyg skriva om varje återkopplingspunkt med denna struktur:

Problem → Bevis → Föreslagen ändring → Succesmått

- Problem: Vad fungerar inte?

- Bevis: Vad sa/gjorde användaren? Inkludera citat, skärmbildsreferens eller tidsstämpel från samtal.

- Föreslagen ändring: Vad ska ändras (en ändring per punkt).

- Succesmått: Hur vet ni att det blivit bättre (kvalitativt eller kvantitativt).

Det här tvingar fram tydlighet utan att “hitta på” nya krav.

Göra otydliga anteckningar till avgränsade uppgifter

Exempel indata:

“Kassan är förvirrande och tar för lång tid.”

AI‑assisterad output (redigerad av dig):

- Problem: Användare har svårt att förstå stegen och lämnar kassan.

- Bevis: 6/20 intervjuade frågade “vad händer nu?”; analytics visar 38% tapp mellan Shipping → Payment (10–20 dec).

- Föreslagen ändring: Lägg till en 3‑stegs progressindikator och byt huvudknappen från “Continue” till “Continue to Payment.”

- Succesmått: Minska tappet Shipping → Payment från 38% till ≤30% över 2 veckor.

Konvertera sedan till en task med tydliga gränser:

Uppgift: Lägg till progressindikator + uppdatera knappetikett på kassasidan.

Utanför scope: Byta betalningsleverantör, redesigna hela kassan, skriva om all produkttext.

Acceptanskriterier (gör dem testbara)

Be AI utarbeta acceptanskriterier, och skärpa dem sedan:

- Progressindikator visas på mobil och desktop.

- Stegen speglar aktuell status (Shipping, Payment, Review).

- Knappetikett uppdateras på både Shipping och Payment‑skärmar.

- Ingen förändring av pris, skatt eller betalningshantering.

Behåll spårbarheten i återkopplingen

Spara alltid:

- originalåterkopplingen (citat/skärmdump/ticket)

- AI‑omvandlad uppgift

- slutligt beslut och motivering

Den spårbarheten skyddar ansvarstagande, förhindrar “AI sa så”‑beslut, och gör framtida iterationer snabbare eftersom du kan se vad som ändrades — och varför.

Testa förbättringar: experiment AI kan snabba upp

Iterera säkert

Släpp en liten version idag och fortsätt förbättra den med snapshots och rollback.

Iteration blir verklig när du testar en förändring mot ett mätbart resultat. AI kan hjälpa dig designa små, snabba experiment — utan att varje förbättring blir ett veckolångt projekt.

En praktisk mall är:

- Hypotes: Om vi ändrar X så förbättras Y eftersom Z.

- Varianter: Version A (nuvarande) vs. Version B (en avsiktlig förändring).

- Succesmät: Den ena siffra du använder för beslut (open rate, aktiveringsgrad, konverteringsgrad, tid‑till‑första‑värde).

- Publik + duration: Vem ser det och hur länge.

Be AI föreslå 3–5 kandidat‑hypoteser baserat på feedback‑teman (t.ex. “användare säger setup känns förvirrande”) och skriv om dem till testbara uttalanden med tydliga mätvärden.

Snabba exempel AI kan generera (som du kan testa)

Ämnesrader för e‑post (mått: öppningsfrekvens):

- A: “Din veckorapport är klar”

- B: “3 insikter från din vecka (2 minuter att läsa)”

Onboarding‑meddelande (mått: fullföljandegrad av steg 1):

- A: “Välkommen! Låt oss ställa in ditt konto.”

- B: “Välkommen — lägg till ditt första projekt för att se resultat på under 5 minuter.”

UI‑mikrotext på en knapp (mått: klickfrekvens):

- A: “Submit”

- B: “Spara och fortsätt”

AI är användbar eftersom det snabbt kan producera flera plausibla varianter — olika ton, längd och värde‑påstående — så att du kan välja en tydlig förändring att testa.

Skyddsräcken: gör testet tolkbart

Snabbhet är bra, men håll experiment läsbara:

- Ändra en variabel i taget när det är möjligt. Om du skriver om rubriken och knappen och layouten kommer du inte kunna veta vad som fungerade.

- Behåll en kontroll. Spara alltid Version A.

- Definiera måttet innan du tittar. Annars hittar du “vinster” av en slump.

Mät resultat, inte känslor

AI kan säga vad som “låter bättre”, men det är dina användare som bestämmer. Använd AI för att:

- föreslå trösklar för framgång (t.ex. “vi deployar B om CTR förbättras med 5%+”)

- utarbeta en mall för resultatsammanfattning

- översätta insikter till nästa hypotes

Så lär varje test dig något — även när den nya versionen förlorar.

Mäta resultat och lära av varje cykel

Iteration fungerar bara när du kan avgöra om den senaste förändringen faktiskt hjälpte. AI kan snabba upp steget från mätning till lärande, men kan inte ersätta disciplin: tydliga mätvärden, rena jämförelser och skriftliga beslut.

Välj mätetal som matchar målet

Välj en liten uppsättning siffror du kontrollerar varje cykel, grupperade efter vad du vill förbättra:

- Konvertering: registreringar, trial‑start, kassa‑slutförande, klickfrekvens på nyckel‑CTA

- Retention: 7/30‑dagars återkomst, churn, återköp, funktionsåteranvändning

- Tid‑till‑klar: onboarding‑tid, tid till första värde, support‑lösningstid

- Felrate / kvalitet: misslyckade skick, buggrapporter, återbetalningar, QA‑buggar

- Nöjdhet: CSAT, NPS, app‑betyg, sentiment i supportärenden

Nyckeln är konsekvens: ändrar du definitionerna varje sprint lär siffrorna dig inget.

Låt AI sammanfatta resultat — och peka på vad som ändrats

När du har experimentutläsningar, dashboards eller exporterade CSV:er är AI användbar för att göra dem till en berättelse:

- sammanfatta vad som rört sig (och vad som inte gjorde det) i enkelt språk

- lyfta fram anmärkningsvärda segment: nya vs. återkommande användare, enhetstyp, trafikkanal, region, plan‑nivå, power users vs. casual users

- uppmärksamma överraskande korrelationer värda djupare analys (t.ex. konvertering upp totalt men ner på mobil Safari)

En praktisk prompt: klistra in din resultattabell och be assistenten producera (1) en paragrafssammanfattning, (2) de största segmentskillnaderna, och (3) följdfrågor att validera.

Undvik falsk säkerhet

AI kan få resultat att låta definitiva även när de inte är det. Du behöver fortfarande sanity‑checka:

- Stickprovsstorlek: Små ändringar på små stickprov är ofta brus.

- Säsongseffekter och externa händelser: Helger, kampanjer, driftstörningar, publicitet.

- Flera förändringar samtidigt: Om tre saker ändrades vet du kanske inte vilken som orsakade effekten.

Håll en lättviktig lärlogg

Efter varje cykel, skriv en kort post:

- Vad ändrades (länk till ticket eller doc)

- Vad hände (mätvärden + anmärkningsvärda segment)

- Vad vi tror det betyder (er bästa förklaring)

- Vad vi provar nästa (en konkret uppföljning)

AI kan utarbeta posten, men teamet bör godkänna slutsatsen. Med tiden blir denna logg ert minne — så ni slutar upprepa samma experiment och börjar bygga kumulativa vinster.

Göra processen upprepbar: arbetsflöden som skalar

Gör rollback enkelt

Spara en stabil version innan stora ändringar så du kan jämföra och snabbt återställa.

Hastighet är trevligt, men konsekvens gör iteration exponentiell. Målet är att förvandla “vi bör förbättra detta” till en rutin teamet kan köra utan hjältedåd.

Lättviktiga arbetsmönster

En skalbar loop behöver ingen tung process. Några små vanor slår ett komplicerat system:

- Veckogenomgång (30–60 minuter): Välj 1–3 saker att förbättra, gå igenom förra veckans förändringar och bestäm vad som testas nästa. Ta med AI‑förberedda sammanfattningar (teman, toppklagomål, framväxande risker) så mötet håller fokus.

- Change log: Ha en löpande notering av vad som ändrats, varför och vad ni förväntar er. Ett vanligt dokument räcker; nyckeln är konsekvens.

- Beslutsanteckningar: För betydande ändringar fånga beslutet i fem rader: kontext, alternativ som övervägts, beslut, ansvarig, datum. AI kan utarbeta dessa från mötesanteckningar, men ni bekräftar alltid formuleringen.

Promptmallar + återanvändbara checklistor

Behandla prompts som tillgångar. Spara dem i en delad mapp och versionera dem som annat arbete.

Behåll en liten bibliotek:

- Promptmallar för återkommande uppgifter (sammanfatta återkoppling, föreslå varianter, skriv om för ton, skapa acceptanskriterier).

- Återanvändbara checklistor för kvalitet (tydlighet, fullständighet, compliance, varumärkesröst, tillgänglighet). Be AI köra checklistan och markera luckor, sen verifierar en människa.

En enkel konvention hjälper: “Uppgift + Målgrupp + Begränsningar” (t.ex. “Release notes — icke‑teknisk — 120 ord — inkludera risker”).

Lägg till en mänsklig godkännandesteg för känsligt innehåll

För allt som påverkar förtroende eller ansvar — prissättning, juridisk text, medicinsk eller finansiell vägledning — använd AI för att utarbeta och flagga risker, men kräva en namngiven godkännare innan publicering. Gör det steget explicit så det inte hoppas över under tidspress.

Versionsnamngivning som förebygger förvirring

Snabb iteration skapar röriga filer om du inte märker dem tydligt. Använd ett förutsägbart mönster som:

FeatureOrDoc_Scope_V#_YYYY-MM-DD_Owner

Exempel: OnboardingEmail_NewTrial_V3_2025-12-26_JP.

När AI genererar alternativ, håll dem grupperade under samma version (V3A, V3B) så alla vet vad som jämfördes och vad som faktiskt levererades.

Vanliga fallgropar, säkerhetskontroller och ansvarsfull användning

AI kan snabba upp iteration — men den kan också snabba upp misstag. Behandla den som en kraftfull kollega: hjälpsam, snabb, och ibland självsäker men felaktig.

Vanliga felkällor (och hur du undviker dem)

Att lita för mycket på AI‑utdata. Modeller kan producera trovärdig text, sammanfattningar eller ”insikter” som inte stämmer med verkligheten. Bygg vanor att kontrollera allt som kan påverka kunder, budgetar eller beslut.

Vaga prompts ger vagt arbete. Om din input är “gör det bättre” får du generiska ändringar. Specificera målgrupp, mål, begränsningar och vad “bättre” betyder (kortare, tydligare, on‑brand, färre supportärenden, högre konvertering).

Inga mätetal, inget lärande. Iteration utan mätning är bara förändring. Bestäm i förväg vad ni ska spåra (aktiveringsgrad, tid‑till‑första‑värde, churn, NPS‑teman, felrate) och jämför före/efter.

Datahantering: skydda användare och företaget

Klistra inte in personlig, kund‑ eller konfidentiell information i verktyg om inte din organisation uttryckligen tillåter det och du förstår retention/träningspolicyer.

Praktisk regel: dela minimalt.

- Ta bort namn, e‑post, telefonnummer, adresser, order‑ID:n och fritekstanteckningar som kan innehålla känsliga detaljer.

- Sammanfatta internt och be modellen arbeta från sammanfattningen.

- Om du behöver analysera riktig återkoppling, redigera först och lagra originaldata i ert godkända system.

Hallucinationer: verifiera fakta och källor

AI kan hitta på siffror, referenser, funktionsdetaljer eller användarcitat. När noggrannhet är viktig:

- Be om antaganden och osäkerhet (“Vad är du osäker på?”).

- Begär källhänvisningar bara när du själv kan verifiera dem.

- Korsa‑kolla mot era dokument, analytics, changelog eller supportsystem.

“Innan du släpper”‑checklista

Innan du publicerar en AI‑assisterad ändring, gör en snabb genomgång:

- Mål & mått definierade (vad framgång ser ut som).

- PII/konfidentiell data raderad från prompts och loggar.

- Fakta verifierade (påståenden, siffror, policyer, citat).

- Edge cases granskade (tillgänglighet, ton, juridiska anteckningar).

- Mänskligt godkännande från rätt ägare (PM, support, legal, varumärke).

- Rollback‑plan om förändringen presterar sämre.

Använt så här förblir AI en multiplikator för gott omdöme — inte en ersättning för det.