Varför AI-genererad kod och autogenererade tester hör ihop

AI-skriven applikationslogik betyder att de “fungerande” delarna av din kodbas utarbetas med hjälp av en assistent: nya funktioner, små features, refaktorer, hantering av kantfall och till och med omskrivningar av befintliga moduler. Du bestämmer fortfarande vad som ska byggas, men den första versionen av implementationen kommer ofta snabbare—och ibland med antaganden du inte märker förrän senare.

Automatisk testgenerering är den matchande förmågan på verifieringssidan. Istället för att skriva varje test för hand kan verktyg föreslå testfall och assertioner baserat på din kod, en specifikation eller mönster inlärda från tidigare buggar. I praktiken kan det se ut som:

- “Givet den här funktionssignaturen och grenarna, här är tester som täcker typiska inputs, gränsvärden och felvägar.”

- “Här är regressionstester som reproducerar kraschen vi såg i produktion.”

Huvudförväntningen: genererade tester är inte automatiskt “bra”

Ett genererat test kan vara missvisande: det kan assertera det nuvarande beteendet även om beteendet är fel, eller det kan missa produktregler som lever i människors huvuden och i ticket-kommentarer. Därför är mänsklig granskning viktig. Någon måste bekräfta att testets namn, setup och assertioner speglar verklig avsikt—inte bara vad koden råkar göra idag.

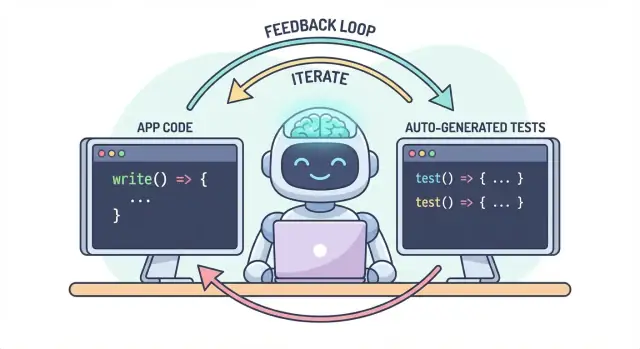

Ett arbetsflöde, två output

Kärn idén är enkel: kod och tester bör utvecklas tillsammans i ett arbetsflöde. Om AI hjälper dig att snabbt ändra logik hjälper automatisk testgenerering dig att lika snabbt låsa fast avsikten—så nästa förändring (mänsklig eller AI) har en tydlig, exekverbar definition av “fortfarande korrekt.”

I praktiken är detta “parad output”-sätt enklare att underhålla när ditt utvecklingsflöde redan är chattdrivet. Till exempel i Koder.ai (en vibe-coding-plattform för att bygga web, backend och mobilappar via chatt) är det naturligt att behandla “funktion + tester” som en enda leverans: du beskriver beteendet, generar implementationen, och generar och granskar tester i samma samtalsloop före deployment.

Problemet: snabbare kod kan betyda snabbare buggar

AI-skriven kod kan kännas som en superkraft: features dyker upp snabbt, boilerplate försvinner och refaktorer som brukade ta timmar kan ske innan kaffet svalnat. Men farten förändrar riskens natur. När kod blir enklare att producera blir den också enklare att släppa med misstag—ibland subtila.

Vanliga felmönster i AI-skriven logik

AI-assistenter är bra på att generera “rimliga” implementationer, men rimligt är inte samma sak som korrekt för din specifika domän.

Kantfall blir ofta första offret. AI-genererad logik hanterar ofta happy path väl, men snubblar på gränsförhållanden: tomma inputs, tidszonskonsekvenser, avrundning, null-värden, retry-beteenden eller “detta borde aldrig hända”-tillstånd som händer i produktion.

Felaktiga antaganden är ett annat vanligt problem. En assistent kan anta krav som inte uttryckts (“användare är alltid autentiserade”, “ID är numeriska”, “detta fält finns alltid”), eller implementera ett bekant mönster som inte matchar ditt systems regler.

Tysta regressioner är ofta de dyraste. Du ber om en liten ändring, assistenten skriver om en bit logik, och något icke-relaterat går sönder—utan uppenbara fel. Koden kompilerar fortfarande, UI laddas, men en prisregel, behörighetskontroll eller datakonvertering är nu något felaktig.

Varför manuell testning inte skalar med snabbare kod

När kodändringar accelererar blir manuell testning en flaskhals och ett lotteri. Antingen spenderar du mer tid på att klicka runt (som saktar leverans) eller så testar du mindre (vilket ökar risken att buggar når användare). Även disciplinerade QA-team kan inte manuellt täcka varje variant när ändringar är frekventa och omfattande.

Ännu värre: manuella kontroller är svåra att upprepa konsekvent. De lever i någons minne eller en checklista, och är lätta att hoppa över när deadlines stramar—precis när risken är som störst.

Tester som ett säkerhetsnät och kommunikationsmedel

Automatiska tester skapar ett hållbart säkerhetsnät: de gör förväntningar exekverbara. Ett bra test säger: “Givet dessa inputs och detta kontext, är detta utfallet vi förlitar oss på.” Det är inte bara verifiering; det är kommunikation för framtida du, teammedlemmar och till och med AI-assistenten.

När tester finns blir förändringar mindre skrämmande eftersom feedback är omedelbar. Istället för att upptäcka problem under kodgranskning, i staging eller från kunder hittar du dem minuter efter ändringen.

Fånga problem tidigt för att minska omarbete

Ju tidigare en bugg fångas, desto billigare är det att fixa. Tester förkortar feedback-loopen: de lyfter felaktiga antaganden och missade kantfall medan avsikten fortfarande är färsk. Det minskar omarbete, undviker “fix-forward”-patcher och hindrar AI-hastighet från att bli AI-driven churn.

Hur tester skapar en feedback-loop för AI-skriven logik

AI-skriven kod är snabbast när du behandlar den som en konversation, inte en engångsleverans. Tester gör den konversationen mätbar.

Loop: “spec → kod → tester” (i klartext)

-

Spec: Du beskriver vad som ska hända (inputs, outputs, kantfall).

-

Kod: AI skriver implementationen som påstår sig matcha den beskrivningen.

-

Tester: Du (eller AI) genererar kontroller som bevisar att beteendet faktiskt är sant.

Upprepa den här loopen så producerar du inte bara mer kod—du skärper kontinuerligt definitionen av “klart.”

Tester tvingar tydligare krav och gränssnitt

Ett vagt krav som “hantera ogiltiga användare smidigt” är lätt att förbise i koden. Ett test kan inte vara vagt. Det tvingar fram specifika saker:

- Vad räknas som “ogiltig”? Saknat ID, avstängd status, felaktig e‑post?

- Vad betyder “smidigt”? Felmeddelande, statuskod, fallback-värde?

- Vad är gränssnittet? Funktionssignatur, returform, undantag?

Så fort du försöker uttrycka de detaljerna i ett test dyker oklarheter upp direkt. Den klarheten förbättrar prompten du ger AI och leder ofta till enklare, stabilare gränssnitt.

Genererade tester validerar vad koden påstår

AI-kod kan se korrekt ut samtidigt som den döljer antaganden. Genererade tester är ett praktiskt sätt att verifiera de påståenden koden gör:

- “Denna funktion är ren” → testa att inga externa sidoeffekter sker.

- “Hanterar kantfall” → testa null, tomma listor, gränsvärden.

- “Bakåtkompatibel” → testa gamla inputs och förväntade outputs.

Målet är inte att lita blint på genererade tester—det är att använda dem som strukturerad skepticism.

Felande tester blir nästa prompt

Ett felande test är handlingsbar feedback: det pekar på en specifik avvikelse mellan specifikation och implementation. Istället för att be AI “fixa det” kan du klistra in felet och säga: “Uppdatera koden så det här testet passerar utan att ändra det publika API:et.” Det förvandlar debuggarbetet till en fokuserad iteration istället för ett gissningsspel.

Var automatisk testgenerering passar i din testpyramid

Automatisk testgenerering är mest användbar när den stödjer din befintliga teststrategi—särskilt den klassiska “testpyramiden.” Pyramiden är inte en regel för dess egen skull; den hjälper till att hålla feedback snabb och trovärdig samtidigt som verkliga fel fångas.

AI kan hjälpa dig skapa tester på varje lager, men du får bäst resultat när du generar fler av de billiga testerna (pyramidens botten) och färre av de dyra (toppen). Den balansen håller din CI-pipeline snabb samtidigt som användarupplevelsen skyddas.

Enhetstester: snabba, fokuserade och mycket genererbara

Enhetstester är små kontroller för enskilda funktioner, metoder eller moduler. De körs snabbt, behöver inga externa system och är idealiska för AI-genererad täckning av kantfall.

Bra användning av automatisk testgenerering här är att:

- Trigga inputvalidering och “konstiga” gränsvärden

- Validera affärsregler (rabatter, behörigheter, tillståndsövergångar)

- Låsa bugfixar med regressionstester som är lätta att glömma

Eftersom enhetstester är snävt avgränsade är de enklare att granska och mindre benägna att bli flakiga.

Integrationstester: färre men högt värde

Integrationstester validerar hur bitar fungerar ihop: din API mot databasen, en tjänst som anropar en annan, köhantering, autentisering med mera.

AI-genererade integrationstester kan vara värdefulla, men de kräver mer disciplin:

- Tydlig setup/teardown så tester inte läcker data

- Stabil testmiljö (containers, testdatabaser, mockar där lämpligt)

- Assertioner som fokuserar på utfall, inte interna implementationer

Tänk på dessa som “kontraktskontroller” som bevisar att sömmarna mellan komponenter fortfarande håller.

End-to-end-tester: generera sparsamt

E2E-tester validerar viktiga användarflöden. De är också de mest kostsamma: långsammare att köra, mer sköra och svårare att felsöka.

Automatisk testgenerering kan hjälpa till att skissa E2E-scenarier, men kureras aggressivt. Behåll en liten uppsättning kritiska vägar (registrering, checkout, kärnflöde) och undvik att generera E2E-tester för varje feature.

Praktisk rekommendation: generera en balanserad mix

Försök inte generera allt. Istället:

- Generera många enhetstester för att hålla AI-skriven logik ärlig på funktionsnivå

- Lägg till målinriktade integrationstester för att skydda de mest riskfyllda gränserna (DB, auth, betalningar)

- Behåll en minimal E2E-svit för de användarresor du inte har råd att bryta

Detta håller pyramiden intakt—och gör automatisk testgenerering till en kraftförstärkare snarare än en källa till brus.

Vad som kan genereras: från kod, specifikationer och verkliga buggar

Automatisk testgenerering är inte begränsad till “skriv enhetstester för den här funktionen.” De mest användbara generatorerna drar från tre källor: koden du har, avsikten bakom den och de fel som redan inträffat.

1) Från kodstruktur: testa beteende, inte bara rader

Givet en funktion eller modul kan verktyg härleda testfall från inputs/outputs, grenar och exceptions-vägar. Det betyder typiskt:

- “Happy path” inputs som ska ge känt resultat

- Gränsvärden (tomma strängar, noll, maxlängd)

- Grentäckning (if/else-vägar)

- Felhantering (ogiltiga inputs, saknade fält, timeouts)

Denna stil är bra för att snabbt omge AI-skriven logik med kontroller som bekräftar vad den faktiskt gör idag.

2) Från krav: gör avsikten till exekverbara exempel

Om du har acceptanskriterier, user stories eller exempel-tabeller kan generatorer konvertera dem till tester som läser som specifikationen. Detta är ofta mer värdefullt än kodbaserade tester eftersom det låser fast “vad som ska hända”, inte “vad som händer nu.”

Ett praktiskt mönster: ge ett par konkreta exempel (inputs + förväntade utfall) och be generatorn lägga till kantfall som är konsekventa med dessa regler.

3) Från bugg-rapporter: reproducera först, förebygg sedan

Buggbaserad generering är snabbaste sättet att bygga en meningsfull regressionssvit. Mata in stegen för att reproducera (eller loggar och en minimal payload) och generera:

- ett test som misslyckas mot nuvarande buggiga beteende, sedan

- samma test som passerar när det är fixat—för evigt skydd mot att återintroducera det.

Snapshot/golden-tester: hjälpsamt, med en varning

Snapshot-tester kan vara effektiva för stabila outputs (renderad UI, serialiserade svar). Använd dem med försiktighet: stora snapshots kan “godkänna” subtila misstag. Föredra små, fokuserade snapshots och kombinera dem med assertioner på nyckelfält som måste vara korrekta.

Vad man ska testa först (utan att koka havet)

Automatisk testgenerering är mest effektiv när du ger den tydliga prioriteringar. Om du pekar den mot en hel kodbas och ber om “alla tester” kommer du få brus: många lågvärdes-kontroller, duplicerad täckning och sköra tester som saktar ned leveransen.

Starta där affären skulle känna smärta

Börja med de flöden som skulle vara dyrast att bryta—antingen finansiellt, juridiskt eller reputationsmässigt. Ett enkelt riskbaserat filter håller omfånget realistiskt samtidigt som kvalitén förbättras snabbt.

Fokusera först på:

- Affärskritiska flöden (signup, checkout, kärnarbetsflöden) och områden som ändras ofta (aktiva features, refaktorer, nya integrationer).

- Högriskdomäner: betalningar, autentisering, dataintegritet, behörigheter/roller, och allt som påverkar vad användare kan se eller göra.

För varje valt flöde, generera tester i lager: ett par snabba enhetstester för den knepiga logiken, plus en eller två integrationstester som bekräftar att hela vägen fungerar.

“Happy path + top edge cases” slår uttömmande kombinationer

Be om täckning som matchar verkliga fel, inte teoretiska permutationer. En bra startuppsättning är:

- Ett happy path-test som bevisar förväntat beteende.

- De toppkantfall du faktiskt oroar dig över: saknad/ogiltig input, utgångna tokens, otillräckliga behörigheter, samtidighetskonflikter och “tomt” data.

Du kan alltid utvidga senare baserat på buggar, incidentrapporter eller användarfeedback.

Definiera “klart” så det förblir klart

Gör regeln explicit: en feature är inte klar förrän tester finns. Den definitionen av gjort spelar ännu större roll med AI-skriven kod, eftersom den förhindrar att “snabb leverans” tyst blir “snabba regressioner.”

Om du vill att detta ska hålla, koppla det till ditt arbetsflöde (till exempel kräva relevanta tester innan merge i CI) och hänvisa till förväntningen i teamets dokumentation (t.ex. teamets definition of done).

Promptningsmönster som ger bättre tester

AI kan generera tester snabbt, men kvaliteten beror starkt på hur du ber om det. Målet är att styra modellen mot tester som skyddar beteende—inte tester som bara kör koden.

Sätt kodstandarden direkt i prompten

Börja med att pinna ner testernas “form” så utdata matchar ditt repo.

Inkludera:

- Språk + testramverk (t.ex. TypeScript + Jest, Python + pytest)

- Namnregler (t.ex.

should_<beteende>_when_<villkor>)

- Filplats och struktur (t.ex.

src/ och tests/, eller __tests__/)

- Eventuella konventioner (fixtures, factory-helpers, mocking-bibliotek)

Detta hindrar modellen från att uppfinna mönster som ditt team inte använder.

Ge 1–2 verkliga testexempel att kopiera

Klistra in en befintlig testfil (eller ett kort utdrag) och säg uttryckligen: “Matcha den här stilen.” Detta anknyter beslut som hur du arrangerar testdata, hur du namnger variabler och om du föredrar tabell-drivna tester.

Om ditt projekt har hjälpare (t.ex. buildUser() eller makeRequest()), inkludera de kodsnuttarna också så de genererade testerna återanvänder dem istället för att återimplementera.

Be om meningsfulla assertioner (inte bara “den körs”)

Var explicit om vad som är “bra”:

- Assertera outputs och tillståndsändringar

- Verifiera sidoeffekter (t.ex. databas-skrivningar, utsända events)

- Assertera feltyper/meldanden när det är lämpligt

En användbar prompt-rad: “Varje test måste innehålla minst en assertion om affärsbeteende (inte bara ‘inga undantag kastades’).”

Kräv negativa och gränsfallstester

Majoriteten av AI-genererade sviter lutar mot “happy path.” Motverka det genom att begära:

- Ogiltiga inputs och förväntade fel

- Gränsvärden (tomma strängar, noll, maxlängd)

- Behörighetsfel

- Saknade beroenden (t.ex. null-responser, timeouts)

Ett praktiskt prompttemplate

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Mänsklig granskning: se till att genererade tester faktiskt hjälper

AI kan utforma många tester snabbt, men det kan inte vara slutligt omdöme om testerna representerar din avsikt. En mänsklig genomgång är vad som förvandlar “tester som körs” till “tester som skyddar oss.” Målet är inte att övergranska stil—utan att bekräfta att testsviten kommer fånga meningsfulla regressioner utan att bli en underhållskostnad.

Granska för korrekthet och relevans

Börja med att ställa två frågor:

- Asserar testet beteende som produkten faktiskt behöver?

- Skulle du vara nöjd om detta test misslyckades vid en framtida ändring—eftersom det flaggade ett verkligt problem?

Genererade tester låser ibland in avsiktligt råkade beteenden (nuvarande implementation) istället för den avsedda regeln. Om ett test läser som en kopia av koden snarare än en beskrivning av förväntat utfall, tryck det mot högre nivå-assertioner.

Se upp för skörhet (den tysta produktivitetstjuven)

Vanliga källor till flakighet är övermockning, hårdkodade tidsstämplar och slumpmässiga värden. Föredra deterministiska inputs och stabila assertioner (t.ex. assertera på ett parsad datum eller ett intervall snarare än rå Date.now()). Om ett test kräver överdriven mockning för att passera kanske det testar wiring snarare än beteende.

Säkerställ att fel händer av rätt anledning

Ett “passande” test kan ändå vara värdelöst om det skulle passera även när funktionen är bruten (falsk positiv). Leta efter svaga assertioner som “kastar inte” eller bara kontrollerar att en funktion anropades. Stärk dem genom att assertera outputs, tillståndsändringar, returnerade fel eller persistenta data.

Använd en lättviktig code review-checklista

En enkel checklista håller granskningar konsekventa:

- Läsbarhet: tydliga namn, minimal setup, uppenbar avsikt

- Täcker avsikten: viktiga kantfall och felvägar inkluderade

- Underhållbarhet: undvik att specificera intern implementation; minimal mockning

- Signalkvalitet: skulle misslyckas vid verklig regression, inte vid harmlösa refaktorer

Behandla genererade tester som vilken annan kod som helst: merge bara det du skulle vilja äga om sex månader.

Få det att hålla: CI-kontroller som håller AI-kod ärlig

AI kan hjälpa dig skriva kod snabbt, men den verkliga vinsten är att hålla den koden korrekt över tid. Det enklaste sättet att “låsa in” kvalitet är att köra tester och kontroller automatiskt på varje ändring—så regressioner fångas innan de skickas.

Ett praktiskt flöde som fungerar

Ett lättviktigt arbetsflöde många team använder ser ut så här:

- Generera eller redigera feature-koden (AI-assisterat eller inte).

- Generera tester för det nya beteendet (och för buggen du nyss fixade).

- Kör allt lokalt för att bekräfta att du är grön.

- Commit:a kod + tester tillsammans.

Det sista steget är viktigt: AI-skriven logik utan medföljande tester tenderar att drifta. Med tester registrerar du avsikten på ett sätt CI kan genomdriva.

CI som det icke-negotiabla säkerhetsnätet

Konfigurera din CI-pipeline att köra på varje pull request (och helst på merges till main). Minst bör den:

- Installera beroenden i en ren miljö

- Köra enhets-/integrationstester

- Misslyckas bygget vid testfel

Detta förhindrar “det fungerade på min maskin”-överraskningar och fångar oavsiktliga brutna ändringar när en kollega (eller en senare AI-prompt) ändrar kod någon annanstans.

Lägg till några kvalitetsgrindar (håll dem lätta)

Tester är väsentliga, men de fångar inte allt. Lägg till små, snabba grindar som kompletterar testgenereringen:

- Linting (stil + vanliga misstag)

- Typkontroller (där tillämpligt)

- Formateringskontroller (så diffs förblir läsbara)

Håll dessa kontroller snabba—om CI känns långsamt eller bullrigt letar folk efter sätt att kringgå det.

Kost- och kapacitetsplanering

Om du utökar CI-körningar eftersom du generar fler tester, se till att budgeten matchar den nya takten. Om du spårar CI-minuter är det värt att granska begränsningar och alternativ; kontrollera din prissättning och kapacitet.

Använd felande tester för att styra nästa AI-iteration

Ett överraskande effektivt sätt att arbeta med AI-skriven kod är att behandla felande tester som din “nästa prompt.” Istället för att be modellen “förbättra funktionen” ger du den en konkret failure och låter det felet avgränsa ändringen.

Arbetsflödet: failure → prompt → fix → repeat

- Kör sviten (eller CI) och fånga ett fel. Kopiera det felande testets namn och relevant assertionsmeddelande/stacktrace.

- Be AI ta itu med bara det felet. Ge minimal kodkontext (det felande testet och funktionen/modulen under test), plus eventuell affärsregel som kan överträdas.

- Kräv ett regressionstest först. Om felet kommer från en buggrapport, prompta AI att lägga till eller justera ett test som reproducerar buggen innan implementationen ändras.

- Applicera minsta möjliga ändring som får testet att passera. Kör tester omedelbart.

- Gå vidare till nästa felande test. Ett fel i taget håller iterationen tight och begriplig.

Promptningsmönster: håll det litet och verifierbart

Istället för:

- “Fix login-logiken och uppdatera tester.”

Använd:

- “Detta test misslyckas:

shouldRejectExpiredToken. Här är felutdata och relevant kod. Uppdatera implementationen så detta test passerar utan att ändra orelaterat beteende. Om nödvändigt, lägg till ett regressionstest som fångar buggen.”

Varför detta minskar fram-och-tillbaka

Felande tester eliminerar gissningar. De definierar vad “korrekt” betyder i exekverbar form, så du förhandlar inte krav i chatten. Du undviker också omfattande ändringar: varje prompt omfattas av ett mätbart utfall, vilket gör mänsklig granskning snabbare och gör det lättare att se när AI “fixade” symptomet men bröt något annat.

Detta är också där en agent-stil arbetsflöde kan löna sig: en agent fokuserar på minimal kodändring, en annan föreslår minsta testjustering, och du granskar diffen. Plattformar som Koder.ai är byggda kring den typen av iterativt, chatt-först utvecklingsflöde—vilket gör “tester som nästa prompt” till ett standardläge snarare än en specialteknik.

Mäta framgång utan att jaga fåfänga-mått

Automatisk testgenerering kan göra din testsvit större över en natt—men “större” är inte samma sak som “bättre.” Målet är förtroende: fånga regressioner tidigt, minska produktionsfel och hålla teamet i rörelse.

Mätvärden som verkligen speglar kvalitet

Börja med signaler som kopplar till utfall du bryr dig om:

- Build pass rate (på main): Om merges ofta bryter kan genererade tester vara för sköra eller dina prompts ge felaktiga antaganden.

- Flaky test rate: Spåra hur ofta tester misslyckas och passerar vid omkörning. En stigande flakig-frekvens är en skatt på utvecklarnas förtroende.

- Tid-till-upptäckt av regressioner: Mät tiden från att en bugg introduceras till att CI fångar den. Genererade tester bör förkorta detta fönster.

Behandla täckning som en ledtråd, inte ett mål

Täckning kan vara en användbar rökdetektor—särskilt för att hitta otäckta kritiska vägar—men den är lätt att manipulera. Genererade tester kan blåsa upp täckningen samtidigt som de asserterar väldigt lite. Föredra indikatorer som:

- Assertioner per test (en snabb kontroll, inte KPI)

- Mutationstestningsresultat (om ni använder det)

- Om testerna misslyckas när du medvetet bryter beteende

Fokusera på “buggar fångade innan release”

Om du bara spårar testantal eller täckning kommer du optimera för volym. Spåra buggar fångade innan release: fel som hittats i CI, QA eller staging som annars skulle nå användare. När automatisk testgenerering fungerar ökar det antalet fel som fångas innan release samtidigt som produktionsincidenter sjunker.

Schemalägg upprensning för att behålla vinsterna

Genererade sviter behöver underhåll. Sätt ett återkommande uppdrag på kalendern för att:

- Ta bort redundanta tester som inte ger unikt skydd

- Stabiliserar eller radera flakiga tester

- Konsolidera överlappande fall till tydligare, avsiktsbeskrivande tester

Framgång är en lugnare CI, snabbare feedback och färre överraskningar—inte en dashboard som ser imponerande ut.

Vanliga fallgropar och en praktisk rollout-plan

Automatisk testgenerering kan höja kvalitet snabbt—men bara om du behandlar den som en hjälpare, inte en auktoritet. De största misslyckandena ser likadana ut över team, och de är undvikbara.

Vanliga fallgropar att vakta mot

Överberoende är klassisk fälla: genererade tester kan skapa illusionen av säkerhet medan de missar verkliga risker. Om folk slutar tänka kritiskt (“verktyget skrev tester, så vi är täckta”) kommer du släppa buggar snabbare—bara med fler gröna kryss.

Ett annat vanligt problem är att testa implementationens detaljer istället för beteende. AI-verktyg hakar ofta upp sig på aktuella metodnamn, interna hjälpare eller exakta felmeddelanden. Sådana tester blir sköra: refaktorer bryter dem även när funktionen fortfarande fungerar. Föredra tester som beskriver vad som ska hända, inte hur det görs.

Säkerhet och sekretess: läck inte det du inte borde dela

Testgenerering involverar ofta att kopiera kod, stacktraces, loggar eller specifikationer in i en prompt. Det kan exponera hemligheter (API-nycklar), kunddata eller proprietär logik.

Håll prompts och test-fixtures fria från känslig information:

- Redigera bort tokens, credentials och interna URL:er.

- Undvik att klistra in produktionsloggar som kan innehålla personuppgifter.

- Använd syntetiska exempel (fejkade konton, fejkade ID:n) för testdata.

- Om du måste dela verkliga fall, minimera och anonymisera dem.

Applicera samma disciplin om du använder en hostad AI-utvecklingsplattform. Behandla alltid prompts och fixtures som en del av din säkerhetspolicy.

En praktisk rollout-plan (som team faktiskt följer)

Starta litet och gör det rutin:

- Välj en tjänst eller modul med frekventa ändringar.

- Generera enhetstester för de högst riskfyllda vägarna (pengaröverföring, behörigheter, datatransformering).

- Lägg till en enkel CI-regel: nya AI-skrivna features måste inkludera tester (se blogginlägg om CI-kontroller för AI-kod).

- Kräv en snabb mänsklig granskning enligt checklistan: “Asserterar detta test beteende? Skulle det misslyckas för rätt anledning?”

- Spåra förhindrade regressioner (inte bara täckning), och expandera sedan till integrationstester när enhetstester känns stabila.

Målet är inte maximala tester—det är pålitlig feedback som håller AI-skriven logik ärlig.