Vad “PC‑programvarumodellen” betyder — och varför den spelade roll

"PC‑programvarumodellen" var inte en enda produkt eller en fiffig licenslösning. Det var ett upprepbart sätt för en hel marknad att fungera: hur utvecklare byggde programvara, hur de levererade den till användare och hur de tjänade pengar på den.

Det låter grundläggande — tills du minns hur ovanligt det var i början av persondatorernas era. Tidiga datorer såldes ofta som slutna system med proprietär hårdvara, en‑offs‑operativmiljöer och oklara vägar för tredjepartsutvecklare. PC‑eran förändrade det genom att göra programvara till något som kunde skala bortom en maskin — eller ett företag.

En enkel definition av “programvarumodellen”

I praktiska termer är en programvarumodell uppsättningen antaganden som svarar på:

- Vilket mål bygger jag för? (en stabil OS‑ och hårdvarubas)

- Hur bygger jag det effektivt? (verktyg, språk, dokumentation)

- Hur når jag kunder och får betalt? (distribution och affärsvillkor)

När de svaren är förutsägbara investerar utvecklare. När de inte är det tvekar de.

De tre pelare som förstärkte varandra

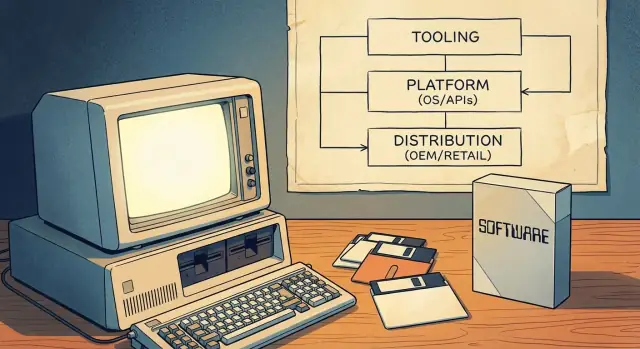

PC‑programvarumodellen fungerade eftersom den kopplade ihop tre pelare till ett svänghjul:

- Utvecklingsverktyg: tillgängliga språk, kompilatorer, IDE:er och exempel som minskade tröskeln för att komma igång.

- Plattformsytan: konsekventa API:er och SDK:er som lät tredjepartsprogram integrera med OS (och andra appar).

- Go‑to‑market‑kanaler: tydliga sätt att distribuera — via OEM‑förinstallationer, detaljhandel och senare shareware — så mjukvara faktiskt kunde bli en affär.

Tillsammans gjorde detta PC:n till en pålitlig "plats att bygga på." Den pålitligheten förvandlade persondatoranvändning från en hobbyistscen till ett mainstream utvecklarekosystem.

Före mainstream‑PC:er: fragmenterade mål och begränsad räckvidd

Före massmarknads‑PC:erna betydde "databehandling" oftast stordatorer och minidatorer ägda av myndigheter, universitet och stora företag. Tillgången var sällsynt, dyr och ofta via IT‑avdelningar. Som utvecklare skrev du program för en specifik organisation — inte för en bred publik.

Många maskiner, många inkompatibiliteter

Tidiga person‑ och hobbydatorer fanns, men de bildade inte en enhetlig, pålitlig marknad. Hårdvaran varierade kraftigt (CPU‑familjer, diskformat, grafik, kringutrustning) och operativsystem var inkonsekventa eller proprietära. Ett program som kördes på en maskin krävde ofta omskrivning för att köra på en annan.

Denna fragmentering formade programvarekonomin:

- Programvara var ofta bundlad med hårdvara eller levererad som del av ett större köp.

- Mycket var skräddarsytt för en kunds arbetsflöde.

- Leverantörer kopplade hårt sina appar till egna maskiner för att skydda hårdvaruförsäljningen.

Begränsad räckvidd gav begränsade incitament

Eftersom den adresserbara publiken för en enskild konfiguration var liten hade oberoende utvecklare svårt att motivera tiden och kostnaden att bygga polerade, brett stödda produkter. Distribution var också begränsad: man kunde skicka band eller disketter direkt till en kund, förlita sig på användargrupper eller dela kod informellt. Inget av detta såg ut som en skalbar affär.

Vad som förändrades när PC:er blev mainstream

När PC:er blev vanliga konsument‑ och kontorsprodukter flyttade värdet från engångsinstallationer till upprepade mjukvaruförsäljningar. Nyckelidén var ett standardmål: en förutsägbar kombination av hårdvaruförväntningar, operativsystemkonventioner och distributionsvägar som utvecklare kunde satsa på.

När ett kritiskt massaflöde av köpare och kompatibla maskiner fanns blev det mindre fråga om "Kommer det att köras någon annanstans?" och mer om "Hur snabbt når vi alla som använder den här standarden?"

Verktyg först: språk som inkörsport för utvecklare

Innan Microsoft blev synonymt med operativsystem associerades företaget starkt med programspråk — särskilt BASIC. Det valet var inte en slump. Vill du ha ett ekosystem behöver du först människor som kan bygga saker, och språk är den lägst hängande inkörsporten.

BASIC som "startpaket"

Tidiga mikrodatorer levererades ofta med BASIC i ROM, och Microsofts versioner blev en välkänd ingång över många maskiner. För en student, hobbyist eller småföretagare var vägen enkel: slå på maskinen, få en prompt, skriv kod, se resultat. Denna omedelbarhet betydde mer än elegans. Den fick programmering att kännas som ett normalt användningsområde, inte ett specialyrke.

Tillgänglighet breddar skaparpubliken

Genom att satsa på lättillgängliga verktyg hjälpte Microsoft till att vidga tratten av potentiella utvecklare. Fler människor som skrev små program innebar fler experiment, fler lokala "appar" och större efterfrågan på bättre verktyg. Detta är ett tidigt exempel på hur utvecklarmindshare fungerar som ränta på ränta: när en generation lär sig på ditt språk och dina verktyg fortsätter de ofta bygga — och köpa — inom samma krets.

Konsistens över maskiner bygger förtroende

Mikrodatoreran var fragmenterad, men Microsoft förde med sig konsekventa idéer från plattform till plattform: liknande språk‑syntax, liknande verktygsförväntningar och en växande känsla av att "om du kan programmera här kan du troligen programmera där också." Den förutsägbarheten minskade den upplevda risken att lära sig programmera.

Den strategiska lärdomen är enkel: plattformar börjar inte med marknadsplatser eller intäktsmodeller. De börjar med verktyg som gör skapande möjligt — och tjänar sedan lojalitet genom att göra den upplevelsen upprepbar.

MS‑DOS och standardiseringen av PC‑målet

Ett stort genombrott i tidig persondatoranvändning var idén om ett "standardiserat OS‑lager": istället för att skriva en separat version av din app för varje hårdvarukombination kunde du rikta dig mot ett gemensamt gränssnitt. För utvecklare innebar det färre portar, färre supportärenden och en tydligare väg till att leverera något som fungerade för många kunder.

Ett ställe att sikta sin programvara mot

MS‑DOS lade sig mellan applikationer och den röriga mångfalden av PC‑hårdvara. Du hade fortfarande olika grafikkort, skrivare, disk‑kontroller och minneskonfigurationer — men MS‑DOS gav en gemensam baslinje för filåtkomst, programinläsning och grundläggande enhetshantering. Det gemensamma lagret gjorde "PC:n" till en enda adresserbar marknad snarare än en samling nästintill kompatibla maskiner.

Vad "kompatibilitet" betydde i praktiken

För kunder betydde kompatibilitet förtroende: om ett program angav att det kördes på MS‑DOS (och därigenom IBM‑kompatibla PC:er) var det mer sannolikt att det kördes på deras maskin också. För utvecklare betydde kompatibilitet förutsägbart beteende — dokumenterade systemanrop, en stabil exekveringsmodell och konventioner för hur program installerades och startades.

Denna förutsägbarhet gjorde det rationellt att investera i polish, dokumentation och löpande uppdateringar, eftersom publiken inte begränsades till en hårdvaruleverantörs användare.

Kärnavvägningen: framsteg kontra bevarande

Standardisering skapade också en begränsning: att hålla gammal programvara fungerande blev en prioritet. Trycket för bakåtkompatibilitet kan bromsa stora förändringar, eftersom att bryta populära program bryter förtroendet för plattformen. Fördelen är ett växande bibliotek av mjukvara; nackdelen är ett smalare utrymme för radikal OS‑innovation utan noggrant planerade övergångar.

Iterera med självförtroende

Experimentera tryggt med snapshots och rollback när krav ändras.

Windows satt inte bara "ovanpå" MS‑DOS — det förändrade vad utvecklare kunde anta om maskinen. Istället för att varje program uppfann sitt eget sätt att rita skärmar, hantera inmatning och prata med kringutrustning erbjöd Windows en gemensam UI‑modell plus en växande uppsättning systemtjänster.

Vad Windows lade till utöver DOS

Huvudförändringen var det grafiska användargränssnittet: fönster, menyer, dialoger och typsnitt som såg ut och uppträdde konsekvent över appar. Det sänkte kostnaden för att "uppfinna grunderna på nytt". Utvecklare kunde lägga tiden på funktioner användare brydde sig om, inte på att bygga ytterligare ett UI‑verktyg.

Windows utökade också gemensamma tjänster som var besvärliga i DOS‑eran:

- Ett standardiserat sätt att arbeta med filer och mappar

- Utskrift genom delade drivrutiner och utskriftsdialoger

- Nätverksstöd som inte krävde varje leverantørs skräddarsydda metod

GUI‑konventioner och delade komponenter

Windows‑konventioner — som standardgenvägar, dialoglayouter och vanliga kontroller (knappar, listor, textrutor) — minskade både utvecklingsinsats och användarträning. Delade komponenter innebar färre skräddarsydda lösningar och färre kompatibilitetssurpriser när hårdvaran förändrades.

Versioner, kompatibilitet och planering

När Windows utvecklades tvingades utvecklare välja: stödja äldre versioner för räckvidd eller anta nyare API:er för bättre möjligheter. Den planeringen formade produktvägar, testning och marknadsföring.

Med tiden centrerades verktyg, dokumentation, tredjepartsbibliotek och användarförväntningar kring Windows som standardmål — inte bara ett operativsystem, utan en plattform med normer och momentum.

Utvecklarupplevelse: IDE:er, kompilatorer, docs och exempel

En plattform känns inte "verklig" för utvecklare förrän det är enkelt att leverera programvara på den. Under PC‑eran formades den enkelheten mindre av marknadsföring och mer av den dagliga upplevelsen av att skriva, bygga, debugga och paketera program.

Verktyg är produktivitetsmultiplikatorer

Kompilatorer, linkers, debuggers och byggsystem sätter tyst tempot för ett ekosystem. När kompileringstider sjunker, felmeddelanden förbättras och debugging blir pålitligt kan utvecklare iterera snabbare — och iteration är vad som förvandlar en halvfärdig idé till en produkt.

Integrerade utvecklingsmiljöer (IDE:er) tog detta längre genom att paketera redigering, bygg, debugging och projektledning i ett arbetsflöde. En bra IDE minskade det "limarbete" som annars åt timmar: att sätta include‑sökvägar, hantera bibliotek, hålla byggen konsekventa och spåra runtime‑krascher.

Lägre risk för små team

Bättre verktyg är inte bara "trevligt att ha" — de förändrar ekonomin för små team. Om en eller två utvecklare kan bygga och testa med förtroende kan de ta projekt som annars skulle kräva större personal. Det minskar kostnad, kortar scheman och gör det mindre riskfyllt för en liten ISV att satsa på en ny produkt.

Docs och exempel slår ofta funktioner

Dokumentation och körbara exempel fungerar som en andra produkt: de lär ut mentalmodellen, visar bästa praxis och förhindrar vanliga misstag. Många utvecklare adopterar inte ett API för att det är kraftfullt — de adopterar det för att det finns ett tydligt exempel som fungerar dag ett.

Verktygsleverantörer påverkar vilka programmeringsmodeller som vinner genom att göra vissa vägar friktionsfria. Om mallar, guider, bibliotek och debugging‑vyer pekar mot en viss metod blir den metoden standard — inte för att den är teoretiskt överlägsen, utan för att den är snabbare att lära och säkrare att leverera med.

API:er och SDK:er: göra tredjepartsprogram möjligt i skala

Ett operativsystem blir inte automatiskt en "plattform." Det blir det när externa utvecklare förutsägbart kan bygga ovanpå det. Därför var API:er och SDK:er viktiga under PC‑eran.

API:er som "menyn av funktioner"

Ett API är i grunden en meny av funktioner en app kan använda: rita ett fönster, skriva ut ett dokument, spara en fil, prata med hårdvara, spela upp ljud. Istället för att varje utvecklare uppfinner sitt eget sätt erbjuder plattformen delade byggstenar.

Ett SDK (software development kit) är paketet som gör dessa byggstenar användbara: bibliotek, headers, verktyg, dokumentation och exempel som visar hur man beställer från menyn.

Stabilitet är vad som gör intresse till investering

Utvecklare tar på sig verkliga kostnader när de bygger programvara: tid, rekrytering, support, marknadsföring och löpande uppdateringar. Stabilitet i API:er minskar risken att en uppdatering plötsligt bryter kärnfunktionalitet.

När reglerna förblir konsekventa — filrutor beter sig likadant, utskrift fungerar likadant, fönsterkontroller följer samma mönster — kan tredjepartsföretag planera fleråriga produktplaner. Den förutsägbarheten är en stor anledning till att Windows‑modellen attraherade seriösa ISV:er, inte bara hobbyister.

Utvecklarprogram skapar ett feedback‑loop

Plattformsteam publicerar inte bara API:er; de odlar adoption. Utvecklarprogram, tidig dokumentation, betaversioner och förhandsvisningar låter mjukvarutillverkare testa kompatibilitet före full lansering.

Det skapar en loop: utvecklare hittar edge‑fall, plattformen fixar dem, och nästa våg av appar levereras med färre överraskningar. Över tid förbättrar detta kvaliteten för användare och minskar supportkostnader för alla.

Riskerna: brytning, blandade signaler, fragmentering

API:er kan också bli en belastning. Brytande förändringar tvingar fram kostsamma omskrivningar. Inkonsistenta riktlinjer (olika UI‑konventioner i systemappar) gör tredjepartsappar "fel" även när de fungerar. Och fragmentering — flera överlappande API:er för samma uppgift — splittrar fokus och bromsar ekosystemets momentum.

I större skala är den bästa plattformsstrategin ofta tråkig: tydliga löften, noggrann avskrivning och dokumentation som hålls aktuell.

Distributionskanaler: OEM‑avtal, detaljhandel och shareware

Skala på dina villkor

Börja gratis, väx sedan när ditt projekt behöver mer kapacitet.

En plattform är inte bara API:er och verktyg — det är också hur programvaran når folk. Under PC‑eran avgjorde distribution vilka produkter som blev "standard", vilka som hittade en publik och vilka som tyst försvann.

OEM‑avtal: kraften i att redan vara där

När PC‑tillverkare förinstallerade programvara (eller bundlade den i kartongen) formade de användarförväntningar. Om ett kalkylblad, ordbehandlare eller runtime följde med maskinen blev det inte bara bekvämt — det blev startpunkten. OEM‑partnerskap reducerade också friktion för köpare: inget extra butiksköp, ingen kompatibilitetsgissning.

För utvecklare erbjöd OEM‑relationer något ännu mer värdefullt än marknadsföring: förutsägbar volym. Att följa med en populär hårdvarulinje kunde innebära stadiga, prognostiserbara intäkter — särskilt viktigt för team som behövde finansiera support, uppdateringar och dokumentation.

Detaljhandel och kataloger: synlighet som funktion

Detaljhandelsförpackningar, postorderkataloger och senare stora butikskedjor skapade en "kamp om hyllplatsen." Förpackning, varumärkeskännedom och distributionsbudgetar spelade roll. En bättre produkt kunde förlora mot en mer synlig.

Denna synlighet drev ett feedback‑loop: stark försäljning motiverade mer hyllplats, vilket drev mer försäljning. Utvecklare lärde sig att kanalen inte var neutral — den belönade produkter som kunde skala marknadsföring och support.

Shareware: en gräsrotsmotor för distribution

Shareware (ofta spridd på disketter via användargrupper, tidningar och BBS‑nätverk) sänkte tröskeln för nya aktörer. Användare kunde prova innan de betalade, och små utvecklare nådde nischpubliker utan detaljhandelsavtal.

Den gemensamma nämnaren över kanalerna var räckvidd och förutsägbarhet. När utvecklare kan räkna med hur kunder upptäcker, provar och köper programvara kan de planera bemanning, prissättning, uppdateringar och långsiktiga produktval.

Ekonomin som lockade mainstream‑utvecklare och ISV:er

En stor anledning till att PC‑eran drog in mainstream‑utvecklare var inte bara teknisk möjlighet — det var förutsägbar ekonomi. "PC‑programvarumodellen" gjorde det enklare att prognostisera intäkter, finansiera löpande förbättringar och bygga företag kring programvara snarare än tjänster.

Prissättning, licenser och uppgraderingscykler

Förpackad programvaruprissättning (och senare per‑sits‑licenser) skapade tydliga intäktsförväntningar: sälj en kopia, tjäna marginal, upprepa. Periodiska betalda uppgraderingar var viktiga eftersom de omvandlade "underhåll" till en affärsmodell — utvecklare kunde planera nya versioner var 12–24:e månad, aligna marknadsföring med releaser och motivera investering i support och dokumentation.

För små team var detta enormt: du behövde inte ett skräddarsytt avtal för varje kund. En produkt kunde skala.

När en plattform nådde en stor installerad bas ändrade det vilka appar som var värda att göra. Nischad "vertikal" programvara (bokföring för tandläkare, inventarie för bilverkstäder), små verktyg och spel blev livskraftiga eftersom en liten procentandel av en stor marknad fortfarande kunde vara en affär.

Utvecklare började också optimera för distributionsvänliga produkter: saker som demoade väl, fick plats i en butikshylla och löste ett specifikt problem snabbt.

Småföretagsköpare värderade stabilitet över nyhet. Kompatibilitet med befintliga filer, skrivare och arbetsflöden minskade supportärenden — ofta den största dolda kostnaden för PC‑programvaruleverantörer. Plattformar som höll äldre appar igång minskade risken för både kunder och utvecklare.

Vad det innebar att vara en ISV

En ISV var ett företag vars produkt berodde på någon annans plattform. Avvägningen var enkel: du fick räckvidd och distributionskraft, men levde under plattformens regler, versionsändringar och supportförväntningar.

Nätverkseffekter och adoptionens feedback‑loop

Planera som en ISV

Kartlägg funktioner, versioner och beroenden innan du genererar kod.

Nätverkseffekter är enkla: när en plattform har fler användare är det lättare för utvecklare att motivera att bygga för den. Och när den har fler appar blir den mer värdefull för användare. Den loopen är hur "tillräckligt bra" plattformar blir default.

Varför defaults uppstår (även med alternativ)

Under PC‑eran handlade valet av utvecklingsmål inte bara om teknisk elegans. Det handlade om att nå den största adresserbara marknaden med minst friktion. När MS‑DOS och senare Windows blev det vanliga målet kunde utvecklare leverera en produkt och förvänta sig att den fungerade för en stor andel kunder.

Användare följde mjukvaran de ville ha — kalkylblad, ordbehandlare, spel — och företag följde talangpoolen. Över tid kändes den plattform med djupast katalog säkrare: bättre rekrytering, mer utbildningsmaterial, fler tredjepartsintegrationer och färre "kommer det att fungera?"‑överraskningar.

Standarder som förstärkte cykeln

Nätverkseffekter handlade inte bara om antalet appar. Standarder stärkte loopen:

- Filformat som lät människor dela dokument utan konverteringsproblem.

- Perifera enheter och drivrutiner som "bara fungerade" över många maskiner.

- Gemensamma API:er som minskade kostnaden för att stödja skrivare, grafik och nätverk.

Varje standard minskade växlingskostnaderna för användare — och minskade supportkostnader för utvecklare — vilket gjorde default‑valet ännu mer segt.

Var modellen kan misslyckas

Svänghjulet bryts när utvecklare inte kan lyckas:

- Dåliga verktyg, otydlig dokumentation eller instabila API:er.

- Svag distribution (kunder hittar inte eller kan inte installera appar enkelt).

- Fragmentering som tvingar flera byggen för liknande enheter.

En plattform kan ha användare, men utan en pålitlig väg för utvecklare att bygga, leverera och få betalt stannar app‑ekosystemet — och loopen vänder.

PC‑programvarumodellen skapade stor uppsida för den som satte standarden — men det betydde aldrig total kontroll. Microsofts uppgång skedde i en konkurrenspräglad, ibland instabil marknad där andra företag kunde (och gjorde) ändra spelreglerna.

Konkurrens som höll fältet i rörelse

Apple erbjöd ett tätt integrerat alternativ: färre hårdvarukombinationer, en mer kontrollerad användarupplevelse och en annan utvecklarberättelse. I andra änden var det "IBM‑kompatibla" ekosystemet mer en vidsträckt koalition av klontillverkare, chipleverantörer och programförläggare — var och en kunde flytta standarder eller förhandlingsstyrka.

Även inom IBM‑banan var plattformsriktningen omstridd. OS/2 var ett seriöst försök att definiera nästa mainstream‑PC‑operativmiljö, och dess öde visade hur svårt det är att migrera utvecklare när det befintliga målet (MS‑DOS, senare Windows) redan har momentum.

Senare introducerade browsereran ett nytt potentiellt plattforms‑lager ovanpå OS:et, och tävlade om defaults, distribution och vilken runtime utvecklare kunde räkna med.

Antitrust‑granskning — utan att gå in på rättsliga utfall — belyser en återkommande plattformsspänning: samma åtgärder som förenklar för användare (bundlade funktioner, förinstallerad mjukvara, standardinställningar) kan minska verkliga val för utvecklare och konkurrenter.

När en bundlad komponent blir standard följer utvecklare ofta den installerade basen snarare än det "bästa" alternativet. Det kan snabba på standardisering, men också stänga ute alternativ och minska experimentlusta.

En balanserad slutsats

Tillväxtstrategier för plattformar skapar också ansvar för ekosystemet. Om du tjänar på att vara default formar du marknadens möjligheter — vem når användare, vad får finansiering och hur lätt är det att bygga något nytt. Ju sundare plattformens regler och transparens är, desto mer hållbart blir utvecklarnas förtroende som i slutändan upprätthåller den.