Vad buggtriage är och varför loopen spelar roll

Buggar känns slumpmässiga när varje rapport blir ett enstaka mysterium. Du petar i koden, provar några idéer och hoppas att problemet försvinner. Ibland gör det det, men du lär dig inte mycket och samma problem dyker upp igen i en annan form.

Buggtriage är motsatsen. Det är ett snabbt sätt att minska osäkerhet. Målet är inte att fixa allt omedelbart. Målet är att omvandla ett vagt klagomål till ett tydligt, testbart påstående och sedan göra den minsta förändringen som bevisar att påståendet är falskt.

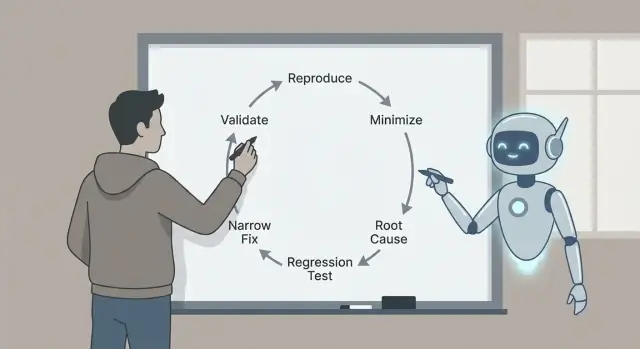

Därför spelar loopen roll: reproducera, minimera, identifiera troliga orsaker med evidens, lägg till ett regressionstest, implementera en snäv fix och validera. Varje steg tar bort en specifik typ av gissning. Hoppa över steg och du betalar ofta för det senare med större fixes, sidoeffekter eller “fixade” buggar som aldrig egentligen var fixade.

Här är ett realistiskt exempel. En användare säger: “Spara-knappen gör ibland ingenting.” Utan en loop kanske du rotar i UI-koden och ändrar timing, state eller nätverksanrop. Med en loop gör du först “ibland” till “varje gång, under dessa exakta förhållanden”, till exempel: “Efter att ha redigerat en titel och sedan snabbt bytt flik förblir Spara inaktiverad.” Den meningen är redan framsteg.

Claude Code kan påskynda tankearbetet: att omvandla rapporter till precisa hypoteser, föreslå var man ska titta och föreslå ett minimalt test som bör misslyckas. Det är särskilt hjälpsamt för att skanna kod, loggar och senaste diffs för att snabbt generera plausibla förklaringar.

Du måste fortfarande verifiera vad som betyder något. Bekräfta att buggen är verklig i din miljö. Föredra bevis (loggar, traces, fallande tester) framför en välformulerad berättelse. Håll fixen så liten som möjligt, bevisa den med ett regressionstest och validera med tydliga kontroller så att du inte byter ut en bugg mot en annan.

Vinsten är en liten, säker fix du kan förklara, försvara och hålla fri från regression.

Sätt upp triage-arbetsytan (innan du rör koden)

Bra fixes börjar med en ren arbetsyta och ett enda, klart problemformulär. Innan du frågar Claude något, plocka en rapport och skriv om den som:

”När jag gör X förväntar jag mig Y, men jag får Z.”

Om du inte kan skriva den meningen har du ännu ingen bugg. Du har ett mysterium.

Samla det grundläggande direkt så du inte behöver loopa tillbaka. Dessa detaljer gör förslag testbara istället för vaga: appversion eller commit (och om det är lokalt, staging eller produktion), miljödetaljer (OS, webbläsare/enhet, feature-flaggor, region), exakta inputs (formfält, API-payload, användaråtgärder), vem som ser det (alla, en roll, ett konto/tenant) och vad “förväntat” betyder (text, UI-tillstånd, statuskod, affärsregel).

Bevara sedan bevisen medan de är färska. En enda tidsstämpel kan spara timmar. Fånga loggar kring händelsen (klient och server om möjligt), en skärmdump eller kort inspelning, request- eller trace-ID:n, exakta tidsstämplar (med tidszon) och det minsta datautdrag som triggar problemet.

Exempel: en Koder.ai-genererad React-app visar “Payment succeeded” men ordern förblir “Pending.” Notera användarroll, exakt order-ID, API-svars-body och serverloggar för det request-ID:t. Nu kan du be Claude att fokusera på ett flöde istället för vagt prat.

Sätt slutligen en stoppregel. Bestäm vad som räknas som åtgärdat innan du börjar koda: ett specifikt test som passerar, ett UI-tillstånd som ändras, ett fel som inte längre syns i loggarna, plus en kort valideringschecklista du kör varje gång. Det hindrar dig från att “fixa” symptomet och släppa ut en ny bugg.

Omvandla buggrapporten till en precis fråga för Claude

En rörig buggrapport blandar ofta fakta, gissningar och frustration. Innan du ber om hjälp, konvertera den till en knivskarp fråga Claude kan svara på med evidens.

Börja med en enradig sammanfattning som namnger funktionen och felet. Bra: “Att spara ett utkast tar ibland bort titeln på mobil.” Inte bra: “Utkast är trasiga.” Den meningen blir ankaret för hela triagetråden.

Separera sedan vad du såg från vad du förväntade dig. Håll det tråkigt och konkret: exakta knappar du klickade på, meddelandet på skärmen, loggrad, tidsstämpel, enhet, webbläsare, branch, commit. Om du inte har dem än, skriv det.

En enkel struktur du kan klistra in:

- Sammanfattning (en mening)

- Observerat beteende (vad som hände, inklusive eventuell feltext)

- Förväntat beteende (vad som borde hända)

- Repro-steg (numrerade, minsta uppsättning du vet)

- Miljö (appversion, enhet, OS, webbläsare, config-flaggor)

Om detaljer saknas, fråga dem som ja/nej-frågor så folk kan svara snabbt: Händer det på ett färskt konto? Bara på mobil? Endast efter en refresh? Började det efter senaste releasen? Kan du reproducera i inkognito?

Claude är också användbar som en “rapportsanering.” Klistra in originalrapporten (inklusive text kopierad från skärmdumpar, loggar och chattutdrag) och be:

”Skriv om detta som en strukturerad checklista. Flagga motsägelser. Lista de fem viktigaste saknade fakta som ja/nej-frågor. Gissa inte orsaker ännu.”

Om en kollega säger “Det fallerar slumpmässigt”, tryck vidare mot något testbart: “Faller 2/10 gånger på iPhone 14, iOS 17.2, när man trycker Spara två gånger snabbt.” Nu kan du reproducera det med avsikt.

Steg 1 - Reproducera buggen pålitligt

Om du inte kan få buggen att hända på begäran är varje nästa steg gissning.

Börja med att reproducera i den minsta miljön som fortfarande visar problemet: en lokal dev-build, en minimal branch, ett litet dataset och så få tjänster igång som möjligt.

Skriv ner exakta steg så någon annan kan följa dem utan att fråga. Gör det copy-paste-vänligt: kommandon, ID:n och exempelpayloads ska inkluderas exakt som använd.

Ett enkelt fångsttemplate:

- Setup: branch/commit, config-flaggor, databasstatus (tom, seedad, produktionskopia)

- Steg: numrerade åtgärder med exakta inputs

- Förväntat vs faktiskt: vad du trodde skulle hända, vad som hände istället

- Bevis: feltext, skärmdumpar, tidsstämplar, request-ID:n

- Frekvens: alltid, ibland, första körningen bara, endast efter refresh

Frekvens ändrar din strategi. “Alltid”-buggar är utmärkta för snabb iteration. “Ibland”-buggar pekar ofta på timing, caching, race conditions eller dold state.

När du har reproduktionsanteckningar, be Claude om snabba sonder som minskar osäkerhet utan att skriva om appen. Bra sonder är små: en riktad loggrad runt felgränsen (inputs, outputs, nyckelstate), en debug-flagga för en komponent, ett sätt att tvinga deterministiskt beteende (fixad seed, fixad tid, en worker), ett litet seed-dataset som triggar problemet, eller en enstaka request/response att spela upp.

Exempel: ett signup-flöde fallerar “ibland.” Claude kan föreslå att logga genererat user ID, e-postnormaliseringsresultat och unique constraint-fel, och sedan köra samma payload 10 gånger. Om felet bara händer vid första körningen efter deploy är det en stark ledtråd att kolla migrationer, cache-warmup eller saknad seed-data.

Steg 2 - Minimera till ett litet, repeterbart testfall

Skapa en repro-redo app

Starta en React-app och iterera på felande scenarier utan tung setup.

En bra reproduktion är användbar. En minimal reproduktion är kraftfull. Den gör buggen snabbare att förstå, enklare att debugga och mindre benägen att “fixas” av misstag.

Strippa bort allt som inte krävs. Om buggen dyker upp efter ett långt UI-flöde, hitta den kortaste vägen som fortfarande triggar den. Ta bort valfria skärmar, feature-flaggor och irrelevanta integrationer tills buggen antingen försvinner (du tog bort något väsentligt) eller består (du hittade brus).

Krymp sedan datan. Om buggen kräver en stor payload, prova den minsta payload som fortfarande bryter. Om den kräver en lista på 500 objekt, se om 5 fallerar, sedan 2, sedan 1. Ta bort fält ett i taget. Målet är så få rörliga delar som möjligt som fortfarande reproducerar buggen.

En praktisk metod är “ta bort hälften och testa igen”:

- Dela stegen i hälften och kontrollera om buggen fortfarande händer.

- Om ja, behåll den halvan och dela igen.

- Om nej, återställ halva det du tog bort och dela annorlunda.

- Upprepa tills du inte kan ta bort något utan att tappa buggen.

Exempel: en checkout-sida kraschar “ibland” när en kupong appliceras. Du upptäcker att det bara händer när kundvagnen har minst en rabatterad vara, kupongen innehåller gemener och leverans är satt till “upphämtning.” Det är ditt minimala fall: en rabatterad vara, en gemen kupong, en upphämtningsmetod.

När minimalfallet är klart, be Claude om att göra det till ett litet reproduktionsstomme: ett minimalt test som anropar den felande funktionen med minsta inputs, ett kort skript som träffar ett endpoint med reducerad payload, eller ett litet UI-test som besöker en rutt och gör en åtgärd.

Steg 3 - Identifiera troliga rotorsaker (med evidens)

När du kan reproducera problemet och har ett litet testcase, sluta gissa. Målet är att landa på en kort lista av plausibla orsaker och sedan bevisa eller förkasta var och en.

En användbar regel är att hålla det till tre hypoteser. Om du har fler är ditt testcase troligen fortfarande för stort eller dina observationer för vaga.

Kartlägg symptom till komponenter

Översätt vad du ser till var det kan hända. Ett UI-symptom är inte alltid ett UI-fel.

Exempel: en React-sida visar en “Saved”-toast men posten saknas senare. Det kan peka på (1) UI-state, (2) API-beteende eller (3) databas-skrivvägen.

Bygg evidens för varje hypotes

Be Claude förklara troliga felmodi på enkel svenska, och fråga sedan vilken bevisning som skulle bekräfta varje en. Målet är att förvandla “kanske” till “kolla detta exakta.”

Tre vanliga hypoteser och vad som bevisar dem:

- UI/state mismatch: klienten uppdaterar lokal state innan servern bekräftar. Bevis: ta en state-snapshot före och efter åtgärden och jämför med det faktiska API-svaret.

- API-kantfall: handlern returnerar 200 men droppar tyst arbete (validering, ID-parsing, feature-flag). Bevis: lägg till request/response-loggar med korrelations-ID och verifiera att handlern når skrivsteget med förväntade inputs.

- Databas eller timing: en transaktion rollas tillbaka, en konflikt uppstår eller “read after write” serveras från en cache/replica. Bevis: inspektera DB-queryn, rader påverkade och felkoder; logga transaktionsgränser och retry-beteende.

Håll dina anteckningar tighta: symptom, hypotes, evidens, dom. När en hypotes matchar fakta kan du låsa in ett regressionstest och endast fixa vad som är nödvändigt.

Steg 4 - Lägg till ett regressionstest som fallerar av rätt anledning

Ett bra regressionstest är din säkerhetssele. Det bevisar att buggen finns och berättar när du verkligen fixat den.

Börja med att välja det minsta testet som matchar det verkliga felet. Om buggen bara uppstår när flera delar samverkar kan ett enhetstest missa det.

Välj testnivån som matchar buggen

Använd unit-test när en enskild funktion returnerar fel. Använd integrationstest när gränssnittet mellan delar är problemet (API-handler plus DB, eller UI plus state). Använd end-to-end endast när buggen beror på hela användarflödet.

Innan du ber Claude skriva något, formulera det minimerade fallet som ett strikt förväntat beteende. Exempel: “När användaren sparar en tom titel ska API:t returnera 400 med meddelandet ‘title required’.” Nu har testet ett tydligt mål.

Be sedan Claude utforma ett fallande test först. Håll setup minimal och kopiera bara den data som triggar buggen. Namnge testet efter vad användaren upplever, inte den interna funktionen.

Verifiera utkastet (lita inte blint)

Gör en snabb granskning själv:

- Bekräfta att det fallerar i nuvarande kod av den avsedda anledningen (inte på grund av saknad fixture eller fel import).

- Kontrollera att assertioner är specifika (exakt statuskod, meddelande, renderad text).

- Säkerställ att testet täcker en bugg, inte en bunt beteenden.

- Håll namnet användarfokuserat, som “avvisar tom titel vid sparande” snarare än “hanterar validering.”

När testet fallerar av rätt anledning är du redo att implementera en snäv fix med förtroende.

Steg 5 - Implementera en snäv fix

Testa server-side fixes

Prototypa Go + PostgreSQL-flöden och återskapa API-kantfall med mindre friction.

När du har ett litet repro och ett fallande regressionstest, stå emot frestelsen att “städa upp.” Målet är att stoppa buggen med minsta ändring som får testet att passera av rätt anledning.

En bra snäv fix ändrar så liten yta som möjligt. Om felet finns i en funktion, fixa den funktionen, inte hela modulen. Om en gränskontroll saknas, lägg kontrollen vid gränsen, inte i hela kedjan.

Om du använder Claude för hjälp, be om två fixalternativ och jämför dem för omfattning och risk. Exempel: om ett React-form kraschar när ett fält är tomt kan du få:

- Alternativ A: Lägg till en gard i submit-handlern som blockerar tom input och visar ett fel.

- Alternativ B: Refaktorera state-hanteringen så fältet aldrig kan bli tomt.

Alternativ A är oftast triagevalet: mindre, lättare att granska och mindre risk att något annat bryts.

För att hålla fixen snäv, rör så få filer som möjligt, föredra lokala fixes framför refaktorer, lägg till guards/valideringar där det dåliga värdet kommer in och gör beteendeförändringen explicit med ett klart före/efter. Lämna kommentarer bara när anledningen inte är uppenbar.

Konrekt exempel: ett Go-API endpoint panikar när en valfri query-param saknas. Den snäva fixen är att hantera tom sträng vid handler-gränsen (parse med default eller returnera 400 med tydligt meddelande). Undvik att ändra delad parsing-utility om inte regressionstestet bevisar att felet ligger i den delade koden.

Efter ändringen, kör det fallande testet och ett par intilliggande tester. Om din fix kräver att många orelaterade tester uppdateras är det en signal att ändringen är för bred.

Steg 6 - Validera fixen med tydliga kontroller

Validering fångar små, lätta att missa problem: en fix som passerar ett test men bryter en närliggande väg, ändrar ett felmeddelande eller lägger till en långsam query.

Kör först det regressionsprov du lade till. Om det passerar, kör närmaste grannar: tester i samma fil, samma modul och allt som täcker samma inputs. Buggar gömmer sig ofta i delade helpers, parsing, gränskontroller eller caching, så relevanta fel brukar visa sig nära.

Gör sedan en snabb manuell kontroll med ursprungliga repro-steg. Håll det kort och specifikt: samma miljö, samma data, samma klick- eller API-sekvens. Om rapporten var vag, testa det exakta scenario du använde för att reproducera.

En enkel valideringschecklista

- Regressionstest passerar, plus närliggande tester i samma område.

- Manuella repro-steg triggar inte längre buggen.

- Felhantering är fortfarande rimlig (meddelanden, statuskoder, retries).

- Kantfall beter sig fortfarande (tom input, maxstorlekar, udda tecken).

- Ingen uppenbar prestandapåverkan (extra loopar, extra anrop, långsamma queries).

Om du vill ha hjälp att hålla fokus, be Claude om en kort valideringsplan baserad på din ändring och det fallande scenariot. Dela vilken fil du ändrade, vilket beteende du avsåg och vad som plausibelt kan påverkas. De bästa planerna är korta och genomförbara: 5–8 kontroller du kan göra på några minuter, var och en med klart pass/fail.

Slutligen, dokumentera vad du validerade i PR:en eller i anteckningar: vilka tester du körde, vilka manuella steg du provade och eventuella begränsningar (t.ex. “testade inte mobil”). Det gör fixen enklare att lita på och enklare att återbesöka senare.

Vanliga misstag och fallgropar (och hur du undviker dem)

Sänk dina byggkostnader

Få krediter genom att dela det du bygger med Koder.ai eller genom att rekommendera kollegor.

Det snabbaste sättet att slösa tid är att acceptera en “fix” innan du kan reproducera problemet på begäran. Om du inte kan få det att falla på begäran vet du inte vad som faktiskt förbättrats.

En praktisk regel: be inte om fixes förrän du kan beskriva en repeterbar setup (exakta steg, inputs, miljö och vad som är “fel”). Om rapporten är vag, spendera de första minuterna på att omvandla den till en checklista du kan köra två gånger och få samma resultat.

Fallgropar som fördröjer

Fixar utan reproducerbart fall. Kräv ett minimalt “faller varje gång”-skript eller uppsättning steg. Om det bara fallerar “ibland”, samla timing, datastorlek, flaggor och loggar tills det slutar vara slumpmässigt.

Minimera för tidigt. Om du strimlar fallet innan du bekräftat originalfelet kan signalen försvinna. Lås först baseline-repro, krymp sedan en ändring i taget.

Låta Claude gissa. Claude kan föreslå sannolika orsaker, men du behöver fortfarande evidens. Be om 2–3 hypoteser och exakt vilka observationer som skulle bekräfta eller avfärda var och en (en loggrad, ett breakpoint, ett query-resultat).

Regressionstester som passerar av fel anledning. Ett test kan “passera” eftersom det aldrig når den felande vägen. Se till att det fallerar före fixen och att det fallerar med väntat meddelande eller assertion.

Behandla symptom istället för triggern. Om du lägger till en null-check men verkliga problemet är “det här värdet ska aldrig vara null” kan du dölja en djupare bugg. Föredra att fixa villkoret som skapar det dåliga state:t.

En snabb sundhetskontroll innan du avslutar

Kör nya regressionstestet och ursprungliga repro-steg före och efter din ändring. Om en checkout-bugg bara händer när en kampanjkod appliceras efter ändrad leveransmetod, behåll den fulla sekvensen som din “sanning”, även om ditt minimerade test är mindre.

Om din validering bygger på “det ser bra ut nu”, lägg till en konkret kontroll (en loggrad, en metric eller ett specifikt output) så nästa person snabbt kan verifiera det.

En snabb checklista, prompt-mallar och nästa steg

När tiden är knapp slår en liten, repeterbar loop heroisk debugging.

En-sidigt triage-checklista

- Reproducera: få ett pålitligt repro och notera exakta inputs, miljö och förväntat vs faktiskt.

- Minimera: reducera till minsta steg eller test som fortfarande fallerar.

- Förklara: lista 2–3 troliga rotorsaker och bevis för varje.

- Lås in: lägg till ett regressionstest som fallerar av rätt anledning.

- Fix + validera: gör den snävaste ändringen, kör sedan en kort valideringschecklista.

Skriv slutgiltigt beslut i några rader så nästa person (ofta framtida du) kan lita på det. Ett användbart format är: “Rotorsak: X. Trigger: Y. Fix: Z. Varför säker: W. Vad vi inte ändrade: Q.”

Prompt-mallar du kan klistra in

- “Given this bug report and logs, ask me only the missing questions needed to reproduce it reliably.”

- “Help me minimize: propose a smaller test case and tell me what to remove first, one change at a time.”

- “Rank likely root causes and cite the exact files, functions, or conditions that support each claim.”

- “Write a regression test that fails only because of this bug. Explain why it fails for the right reason.”

- “Suggest the narrowest fix, plus a validation checklist (unit, integration, and manual checks) that proves we didn’t break nearby behavior.”

Nästa steg: automatisera det du kan (ett sparat repro-skript, ett standardtestkommando, en mall för rotorsaksanteckningar).

Om du bygger appar med Koder.ai (koder.ai), kan Planning Mode hjälpa dig att skissera ändringen innan du rör koden, och snapshots/rollback gör det enklare att experimentera säkert medan du jobbar igenom en knepig repro. När fixen är validerad kan du exportera källkoden eller distribuera och hosta den uppdaterade appen, även med en anpassad domän om det behövs.