29 apr. 2025·8 min

Hur du bygger en webbapp för prisexperiment

Planera, designa och leverera en webapp för att hantera prisexperiment: varianter, trafiksplitt, tilldelning, metrik, instrumentpaneler och säkra rullout-skydd.

Planera, designa och leverera en webapp för att hantera prisexperiment: varianter, trafiksplitt, tilldelning, metrik, instrumentpaneler och säkra rullout-skydd.

Prisexperiment är strukturerade tester där du visar olika priser (eller paketeringar) för olika kundgrupper och mäter vad som förändras—konvertering, uppgraderingar, churn, intäkt per besökare med mera. Det är prisets variant av ett A/B-test, men med extra risk: ett misstag kan förvirra kunder, skapa supportärenden eller till och med bryta mot interna policys.

En hanterare för prisexperiment är systemet som håller dessa tester kontrollerade, observerbara och reversibla.

Kontroll: Team behöver ett enda ställe för att definiera vad som testas, var och för vem. "Vi ändrade priset" är ingen plan—ett experiment behöver en tydlig hypotes, datum, targetingregler och en kill-switch.

Spårning: Utan konsekventa identifierare (experiment-nyckel, variant-nyckel, tilldelnings-tidsstämpel) blir analys gissningsarbete. Hanteraren bör säkerställa att varje exponering och köp kan attribueras till rätt test.

Konsekvens: Kunder ska inte se ett pris på prissidan och ett annat i kassan. Hanteraren bör koordinera hur varianter appliceras över ytor så upplevelsen blir sammanhängande.

Säkerhet: Prisfel kostar. Du behöver skyddsåtgärder som trafikbegränsningar, behörighetsregler (t.ex. endast nya kunder), godkännandesteg och möjlighet till revision.

Det här inlägget fokuserar på en intern webbapp som hanterar experiment: skapa dem, tilldela varianter, samla händelser och rapportera resultat.

Det är inte en fullfjädrad prishanterare (skatteberäkning, fakturering, multivalutakataloger, proration osv.). Istället är det kontrollpanelen och spårningslagret som gör prisprovning tillräckligt säker för att köra regelbundet.

En hanterare för prisexperiment är bara användbar om det är klart vad den kommer—och inte kommer—att göra. Ett snävt omfång håller produkten enkel att använda och säkrare att leverera, särskilt när verkliga intäkter står på spel.

Minst bör din webbapp låta en icke-teknisk operatör köra ett experiment från början till slut:

Om du inte bygger något annat, bygg dessa väl—with tydliga standardvärden och skydd.

Bestäm tidigt vilka experimentformat du kommer stödja så UI, datamodell och tilldelningslogik håller sig konsekvent:

Var tydlig för att förhindra "scope creep" som förvandlar ett experimentverktyg till ett skört affärskritiskt system:

Definiera framgång i operativa termer, inte bara statistiska:

En prisexperiment-app lever eller dör av sin datamodell. Om du inte kan svara "vilket pris såg den här kunden, och när?", blir dina metrikdata brusiga och teamet tappar förtroende.

Börja med ett litet set av kärnobjekt som speglar hur prissättning faktiskt fungerar i din produkt:

Använd stabila identifierare över system (product_id, plan_id, customer_id). Undvik "fina namn" som nycklar—de ändras.

Tidsfält är minst lika viktiga:

Överväg också effective_from / effective_to på Pris-poster så du kan rekonstruera prisning vid en punkt i tiden.

Definiera relationer explicit:

Praktiskt innebär det att en Händelse bör bära (eller kunna joinas till) customer_id, experiment_id och variant_id. Om du bara lagrar customer_id och "letar upp tilldelningen senare" riskerar du felaktiga joins när tilldelningar ändras.

Prisexperiment behöver en audit-vänlig historik. Gör nyckelposter append-only:

Detta gör din rapportering konsekvent och underlättar styrningsfunktioner som revisionsloggar senare.

En hanterare för prisexperiment behöver en tydlig livscykel så alla förstår vad som går att redigera, vad som är låst och vad som händer med kunder när experimentet ändrar status.

Draft → Scheduled → Running → Stopped → Analyzed → Archived

För att minska riskfyllda lanseringar, tvinga fram obligatoriska fält när experimentet går vidare:

För prisändringar, lägg till valfria gates för Finans och Legal/Compliance. Endast godkännare kan flytta Scheduled → Running. Om du stödjer overrides (t.ex. brådskande rollback), logga vem som överstyrde, varför och när i en revisionslogg.

När ett experiment är Stopped, definiera två tydliga beteenden:

Gör detta till ett obligatoriskt val vid stopp så teamet inte kan stoppa utan att besluta om kundpåverkan.

Att få tilldelningen rätt är skillnaden mellan ett trovärdigt pristest och förvirrande brus. Din app bör göra det enkelt att definiera vem som får ett pris, och säkerställa att de fortsätter se det konsekvent.

En kund bör se samma variant över sessioner, enheter (när möjligt) och uppdateringar. Det innebär att tilldelning måste vara deterministisk: med samma tilldelningsnyckel och experiment blir resultatet alltid samma.

Vanliga tillvägagångssätt:

(experiment_id + assignment_key) och mappa den till en variant.Många team använder hash-baserad tilldelning som standard och sparar tilldelningar endast när det krävs (för supportärenden eller styrning).

Din app bör stödja flera nycklar, eftersom prissättning kan vara användar- eller konto-baserad:

user_id efter signup/login.Den uppgraderingsvägen är viktig: om någon surfar anonymt och senare skapar ett konto bör du avgöra om de behåller sin ursprungliga variant (kontinuitet) eller om de tilldelas om (renare identitetsregler). Gör det till en tydlig, uttrycklig inställning.

Stöd flexibla allokeringar:

När du rullar upp, behåll tilldelningar sticky: ökande trafik ska lägga till nya användare i experimentet, inte omfördela befintliga.

Samtidiga tester kan krocka. Bygg skydd för:

En tydlig "Assignment preview"-skärm (givet en provanvändare/konto) hjälper icke-tekniska team att verifiera reglerna innan lansering.

Prisexperiment misslyckas oftast i integrationslagret—inte för att experimentlogiken är fel, utan för att produkten visar ett pris och debiterar ett annat. Din webbapp bör göra "vad priset är" och "hur produkten använder det" mycket explicit.

Behandla prisdefinition som sanningskällan (variantens prisregler, giltighetsdatum, valuta, skattehantering osv.). Behandla prisleverans som en enkel mekanism för att hämta den valda variantens pris via ett API-endpoint eller SDK.

Denna separation håller experimenthanteringsverktyget rent: icke-tekniska team redigerar definitioner, medan ingenjörer integrerar ett stabilt leveranskontrakt som GET /pricing?sku=....

Det finns två vanliga mönster:

Ett praktiskt tillvägagångssätt är "visa på klienten, verifiera och beräkna på servern", med samma experimenttilldelning.

Varianter måste följa samma regler för:

Lagra dessa regler tillsammans med priset så varje variant blir jämförbar och finansvänlig.

Om experimenttjänsten är långsam eller nere bör din produkt returnera ett säkert standardpris (vanligtvis nuvarande baseline). Definiera timeouts, caching och en tydlig "fail closed"-policy så inte checkout bryts—och logga fallbacks så du kan kvantifiera påverkan.

Prisexperiment lever eller dör på mätning. Din webbapp bör göra det svårt att "skjuta och hoppas" genom att kräva tydliga beslutsmetrik, rena händelser och en konsekvent attributionsmetod innan ett experiment får starta.

Börja med en eller två metrik som du använder för att avgöra vinnaren. Vanliga prisval:

En bra regel: om teamen bråkar om resultatet efter testet, definierade ni troligen inte beslutmetriken tillräckligt tydligt.

Skyddsmetrik fångar skada som ett högre pris kan orsaka även om kortsiktig intäkt ser bra ut:

Din app kan genomdriva guardrails genom att kräva trösklar (t.ex. “återbetalningar får inte öka med mer än 0.3%”) och visa överträdelser tydligt på experimentsidan.

Minst måste din spårning inkludera stabila identifierare för experiment och variant på varje relevant händelse.

{

"event": "purchase_completed",

"timestamp": "2025-01-15T12:34:56Z",

"user_id": "u_123",

"experiment_id": "exp_earlybird_2025_01",

"variant_id": "v_price_29",

"currency": "USD",

"amount": 29.00

}

Gör dessa egenskaper obligatoriska vid ingestion, inte "best effort". Om en händelse anländer utan experiment_id/variant_id, routa den till en "unattributed"-korg och flagga data-kvalitetsproblem.

Prisutfall är ofta fördröjda (förnyelser, uppgraderingar, churn). Definiera:

Detta håller teamen överens om när ett resultat är trovärdigt—och förhindrar förhastade beslut.

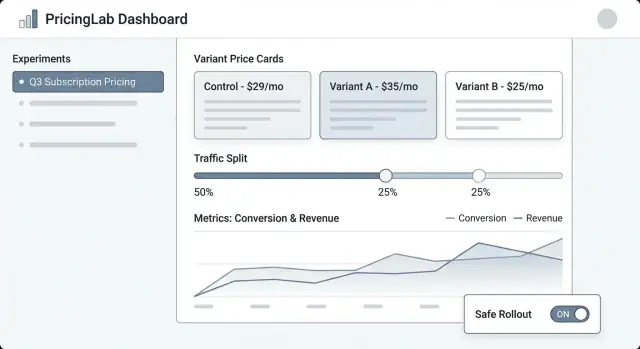

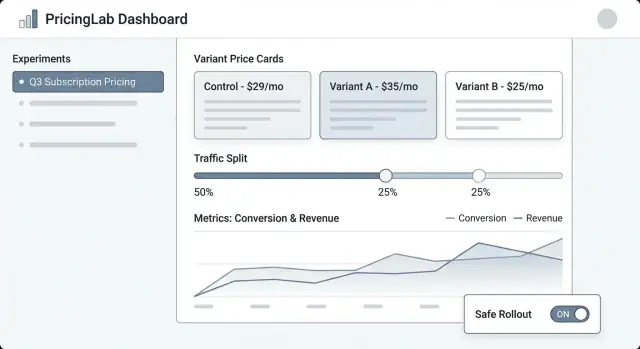

Ett prisexperimentverktyg fungerar bara om produktchefer, marknad och finans kan köra det utan att behöva en ingenjör för varje klick. UI:t bör svara snabbt på tre frågor: Vad körs? Vad kommer att ändras för kunder? Vad hände och varför?

Experimentlista bör kännas som en operationsdashboard. Visa: namn, status (Draft/Scheduled/Running/Paused/Ended), start/slut-datum, trafiksplitt, primär metrik och owner. Lägg till en synlig "last updated by" och tidsstämpel så folk litar på vad de ser.

Experimentsdetalj är hemvyn. Placera en kompakt sammanfattning högst upp (status, datum, målgrupp, split, primär metrik). Under det, använd flikar som Varianter, Targeting, Metrik, Ändringslogg och Resultat.

Variantredigeraren behöver vara enkel och opinionated. Varje variantrad bör inkludera pris (eller prisregel), valuta, faktureringsperiod och en lättförståelig beskrivning ("Årsprenumeration: $120 → $108"). Gör det svårt att av misstag redigera en live-variant genom att kräva bekräftelse.

Resultatvyn bör leda med beslutet, inte bara diagram: "Variant B ökade checkout-konverteringen med 2.1% (95% CI …)." Ge sedan stödjande drill-downs och filter.

Använd konsekventa status-badgar och visa en tidslinje över nyckeldatum. Visa trafiksplitt som både procent och en liten stapel. Inkludera en "Vem ändrade vad"-panel (eller flik) som listar ändringar i varianter, targeting och metrik.

Innan du tillåter Start, kräva: minst en primär metrik vald, minst två varianter med giltiga priser, en definierad ramp-plan (valfri men rekommenderad) och en rollback-plan eller fallback-pris. Om något saknas, visa åtgärdbara felmeddelanden ("Lägg till en primär metrik för att aktivera resultat").

Ge säkra, framträdande åtgärder: Pausa, Stoppa, Ramp up (t.ex. 10% → 25% → 50%), och Duplicera (kopiera inställningar till ett nytt Draft). För riskfyllda åtgärder, använd bekräftelser som sammanfattar påverkan ("Pausa fryser tilldelningar och stoppar exponering").

Om du vill validera arbetsflöden (Draft → Scheduled → Running) innan du investerar i en full byggnad kan en vibe-coding-plattform som Koder.ai hjälpa dig spinna upp en intern webbapp från en chattbaserad specifikation—sen iterera snabbt med rollbaserade skärmar, revisionsloggar och enkla dashboards. Det är särskilt användbart för tidiga prototyper där du vill ha en fungerande React-UI och en Go/PostgreSQL-backend som du senare kan exportera och hårdna.

En prisexperiment-instrumentpanel ska svara en fråga snabbt: "Ska vi behålla det här priset, rulla tillbaka eller fortsätta lära?" Den bästa rapporteringen är inte den mest avancerade—den är den lättaste att lita på och förklara.

Börja med ett fåtal trender som uppdateras automatiskt:

Under diagrammen, inkludera en variantjämförelsetabell: Variantnamn, trafiksandel, besökare, köp, konverteringsgrad, intäkt per besökare och delta vs kontroll.

För konfidensindikatorer, undvik akademisk vokabulär. Använd enkla etiketter som:

En kort tooltip kan förklara att konfidens ökar med stickprovets storlek och tid.

Pris "vinner" ofta totalt men misslyckas för viktiga grupper. Gör segmentflikar enkla att växla:

Behåll samma metrik överallt så jämförelser känns konsekventa.

Lägg till lättviktiga larm direkt i dashboarden:

När ett larm visas, visa misstänkt fönster och en genväg till råa händelsestatus.

Gör rapportering portabel: en CSV-download för aktuell vy (inklusive segment) och en delbar intern länk till experimentrapporten. Om det är hjälpsamt, hänvisa till en kort förklaring som /blog/metric-guide så intressenter förstår vad de ser utan att behöva ett extra möte.

Prisexperiment rör intäkter, kundförtroende och ofta reglerad rapportering. En enkel behörighetsmodell och ett tydligt revisionsspår minskar oavsiktliga lanseringar, tysta "vem ändrade detta?"-konflikter och hjälper dig leverera snabbare med färre omtag.

Håll roller lätta att förklara och svåra att missbruka:

Om du har flera produkter eller regioner, scopea roller per workspace (t.ex. “EU Pricing”) så en editor i ett område inte kan påverka ett annat.

Din app bör logga varje ändring med vem, vad, när, helst med "före/efter"-diffar. Minst följande händelser bör fångas:

Gör loggar sökbara och exporterbara (CSV/JSON), och länka dem direkt från experimentsidan så granskare inte behöver leta. En dedikerad /audit-log-vy hjälper compliance-team.

Behandla kundidentifierare och intäkter som känsligt per default:

Lägg till lätta anteckningar på varje experiment: hypotes, förväntad påverkan, godkännande-rational och en "varför vi stoppade"-sammanfattning. Sex månader senare förhindrar dessa anteckningar att samma dåliga idé körs igen—och gör rapporteringen mer trovärdig.

Prisexperiment misslyckas på subtila sätt: en 50/50-splitt drar sig till 62/38, en kohort ser fel valuta, eller händelser når aldrig rapporter. Innan riktiga kunder ser ett nytt pris, behandla experimentsystemet som en betalningsfunktion—validera beteende, data och felscenar.

Börja med deterministiska testfall så du kan bevisa att tilldelningslogiken är stabil över tjänster och releaser. Använd fasta inputs (kund-ID, experimentnyckel, salt) och assert:a att samma variant returneras varje gång.

customer_id=123, experiment=pro_annual_price_v2 -> variant=B

customer_id=124, experiment=pro_annual_price_v2 -> variant=A

Testa sedan distribution i skala: generera t.ex. 1M syntetiska kund-ID:n och kontrollera att observerad split ligger inom en snäv tolerans (t.ex. 50% ± 0.5%). Verifiera också kantfall som trafikgränser (endast 10% enrolled) och "holdout"-grupper.

Sluta inte vid "händelsen skickades". Lägg till ett automatiserat flöde som skapar en testtilldelning, triggar ett köp- eller checkout-händelse och verifierar:

Kör detta i staging och i produktion med ett testexperiment begränsat till interna användare.

Ge QA och PMs ett enkelt "preview"-verktyg: mata in ett kund-ID (eller session-ID) och se den tilldelade varianten och exakt pris som skulle renderas. Detta fångar fel i avrundning, valuta, skattedisplay och "fel plan" innan lansering.

Överväg en säker intern route som /experiments/preview som aldrig ändrar riktiga tilldelningar.

Öva på de värsta scenarierna:

Om du inte tryggt kan svara "vad händer när X går sönder?", är du inte redo att skicka.

Att lansera en prisexperiment-hanterare handlar mindre om "att släppa en skärm" och mer om att kunna kontrollera spridning, observera beteende snabbt och återställa säkert.

Starta med en lanseringsväg som matchar din tilltro och produktbegränsningar:

Behandla övervakning som ett deploy-krav, inte en "trevlig att ha". Sätt larm för:

Skriv en runbook för operation och on-call:

När kärnflödet är stabilt, prioritera förbättringar som ger bättre beslut: targeting-regler (geo, plan, kundtyp), starkare statistik och guardrails, och integrationer (data warehouse, billing, CRM). Om du erbjuder tiers eller paketering, överväg att exponera experimentfunktionalitet på /pricing så team förstår vad som stöds.

Det är en intern kontrollpanel och ett spårningslager för pristester. Den hjälper team att definiera experiment (hypotes, målgrupp, varianter), leverera ett konsekvent pris över ytor, samla attributionsklara händelser och säkert starta/pausa/stoppa med revisionsspårning.

Den är avsiktligt inte en fullständig fakturerings- eller skatteplattform; den orkestrerar experiment runt din befintliga pris-/fakturastack.

Ett praktiskt MVP bör innehålla:

Om dessa fungerar tillförlitligt kan du iterera mot rikare targeting och rapportering senare.

Modellera de centrala objekten som låter dig svara: “Vilket pris såg den här kunden, och när?” Vanligtvis:

Undvik muterbara ändringar i nyckelhistorik: versionera priser och append:a nya tilldelningsposter istället för att skriva över.

Använd en livscykel som minskar risk, t.ex. Draft → Scheduled → Running → Stopped → Analyzed → Archived.

Lås riskabla fält när experimentet är "Running" (varianter, targeting, split) och kräva validering innan övergångar (valda metric(s), spårning bekräftad, rollback-plan). Detta förhindrar mitt-i-test-ändringar som gör resultaten opålitliga och skapar kundinkonsekvens.

Använd sticky assignment så att samma kund får samma variant över sessioner/enheter när det är möjligt.

Vanliga mönster:

(experiment_id + assignment_key) till en variantbucketMånga team använder hash-först och sparar tilldelningar bara när det behövs för styrning eller support.

Välj en nyckel som matchar hur kunder upplever prissättning:

Om du börjar anonymt, besluta en tydlig "identity upgrade"-regel vid signup/login (behåll originalvariant för kontinuitet vs. tilldela om för renare identitetshantering).

Behandla “Stop” som två separata beslut:

Gör servingpolicyn till ett obligatoriskt val vid stopp så teamet inte stoppar ett test utan att erkänna kundpåverkan.

Säkerställ att samma variant styr både visning och fakturering:

Definiera också en säker fallback om tjänsten är långsam/otillgänglig (vanligtvis baseline-pris) och logga varje fallback för synlighet.

Kräv ett litet, konsekvent event-schema där varje relevant händelse inkluderar experiment_id och variant_id.

Definiera vanligtvis:

Om en händelse anländer utan experiment/variant-fält, routa den till en "unattributed"-korg och flagga data-kvalitetsproblem.

Använd en enkel rollmodell och ett komplett revisionsspår:

Detta minskar oavsiktliga lanseringar och gör finans-/compliance-granskningar — och efterhandsgranskningar — mycket enklare.