19 okt. 2025·8 min

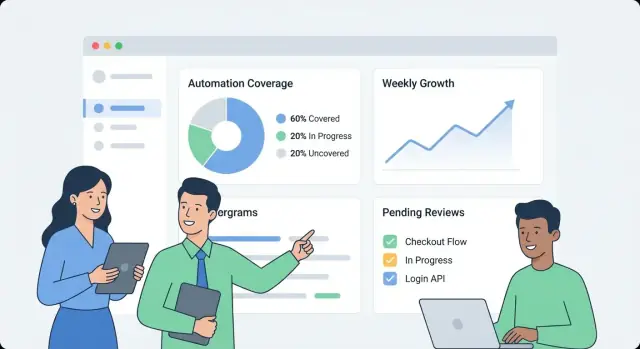

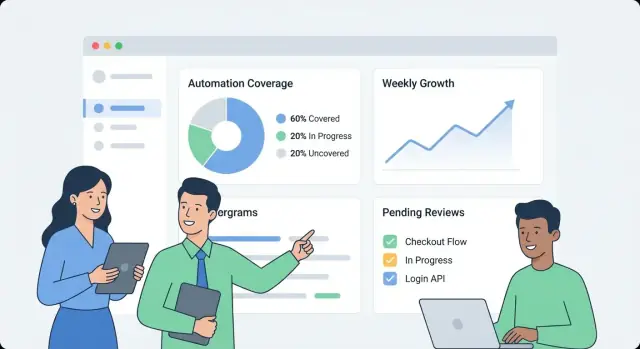

Hur du bygger en webbapp för att övervaka intern automationstäckning

Lär dig hur du designar och bygger en webbapp som spårar automationstäckning internt: mått, datamodell, integrationer, dashboard‑UX och larm.

Lär dig hur du designar och bygger en webbapp som spårar automationstäckning internt: mått, datamodell, integrationer, dashboard‑UX och larm.

Innan ni bygger något, skriv ner vad “automationstäckning” innebär i er organisation. Annars blir dashboarden en salig blandning av orelaterade siffror som olika team tolkar olika.

Börja med att välja de enheter ni mäter. Vanliga alternativ är:

Välj en primär definition för v1 och notera sekundära typer att lägga till senare. Var tydlig med kantfall, som “delvis automatiserade” steg som fortfarande kräver godkännanden.

Olika målgrupper ställer olika frågor:

Skriv 5–10 “topfrågor” och behandla dem som produktkrav.

Definiera de primära målen: synlighet (vad som finns), prioritering (vad att automatisera härnäst), ansvar (vem äger det) och trendspårning (blir det bättre?).

Sätt tydliga gränser för v1. Exempel: “Vi poängsätter inte kvalitet än”, “Vi mäter inte sparad tid”, eller “Vi inkluderar bara CI‑baserade tester, inte lokala skript.”

Bestäm slutligen vad framgång ser ut som: konsekvent adoption (veckovisa aktiva användare), hög datafärskhet (t.ex. uppdateringar inom 24 timmar), färre blinda fläckar (täckning kartlagd för alla kritiska system) och mätbar uppföljning (ägare utsedda och luckor minskar månad för månad).

Innan ni kan mäta automationstäckning måste ni veta var “beviset för automation” faktiskt finns. I de flesta organisationer är automation utspridd över verktyg som införts vid olika tidpunkter av olika team.

Börja med en pragmatisk inventering som svarar på: Vilka signaler bevisar att en aktivitet är automatiserad, och var kan vi hämta dem?

Typiska källor inkluderar CI‑pipelines (build/test‑jobb), testframework (unit/integration/E2E‑resultat), arbetsflödesverktyg (godkännanden, deployment, ticket‑övergångar), runbooks (skript och dokumenterade procedurer) och RPA‑plattformar. För varje källa fånga identifieraren ni kan koppla på senare (repo, tjänstenamn, miljö, team) och det “bevis” ni kommer lagra (jobbkörning, testrapport, automationregel, skriptexekvering).

Lista därefter era system of record som definierar vad som “borde finnas”: repo‑hosting, ärendehanterare och en CMDB/tjänstekatalog. Dessa källor ger vanligtvis den auktoritativa listan över tjänster, ägare och kritikalitet—nödvändigt för att räkna täckning snarare än bara aktivitet.

Matcha varje källa till den minst bräckliga ingestmetoden:

Notera rate limits, autentiseringsmetoder (PAT, OAuth, servicekonton), retention‑fönster och kända datakvalitetsproblem (omdöpta tjänster, inkonsekvent namngivning, saknade ägare).

Planera slutligen en källas tillförlitlighetspoäng per connector (och eventuellt per metrik) så användare kan se om en siffra är “högt förtroende” eller “bedöms med bästa ansträngning”. Detta förhindrar falsk precision och hjälper till att prioritera förbättringar av connectors senare.

En användbar täckningsdashboard börjar med en datamodell som separerar vad ni avsiktligen vill automatisera från vad som faktiskt körts nyligen. Om ni blandar ihop dem kan era siffror se bra ut även när automationen är föråldrad.

Börja med dessa byggstenar:

Välj en primär rapporteringsnivå och håll fast vid den:

Ni kan stödja flera vyer senare, men er första version bör ha en “single source of truth”‑nivå.

Använd ID:n som överlever refaktorer:

Behandla visningsnamn som redigerbara, inte som identifierare.

En praktisk struktur:

Detta låter er svara: “Vad borde vara täckt?”, “Vad påstår sig täcka det?” och “Vad kördes faktiskt?”

Spara:

last_seen_at (asset finns fortfarande)last_run_at, last_failure_atlast_reviewed_at (någon bekräftade påståendet)Färskhetsfält gör det enkelt att markera “täckta men föråldrade” items utan debatt.

Om er täckningsmetrik är diffus blir varje diagram en diskussionspunkt. Börja med att välja en primär metrik för ledningssammanfattningar, och lägg sedan till stödjande uppdelningar för teamen.

De flesta organisationer väljer en av dessa:

Visningen kan fortfarande visa alla tre, men var tydlig med vilken som är “huvudnumret”.

Skriv uttryckliga regler så team poängsätter konsekvent:

Håll reglerna mätbara. Om två personer inte kan poängsätta samma item lika, förfina definitionen.

Använd små heltalsintervall (1–5) för input som risk, affärspåverkan, körfrekvens och tidsbesparing. Exempel: weight = risk + impact + frequency.

Räkna inte ett item som “automatiserat” om det saknar bevis, till exempel:

Detta gör täckning till en observerbar signal istället för ett självrapporterat påstående.

Lägg poängreglerna och exempel på en gemensam sida (länka till den från dashboarden). Konsekvent tolkning är vad som gör trender trovärdiga.

En intern automationstäckningsapp bör vara “tråkig på bästa sätt”: lätt att drifta, lätt att ändra och tydlig kring var siffrorna kommer ifrån. En enkel “API + databas + dashboard”‑arkitektur slår ofta ett distribuerat system tills ni verkligen behöver det.

Välj en stack ert team redan stödjer. En vanlig baseline är:

Om ni vill komma snabbare till en första intern version kan ett vibe‑coding‑sätt fungera: till exempel kan Koder.ai hjälpa till att generera en React‑dashboard plus en Go + PostgreSQL‑backend från en strukturerad spec, och låta ert team iterera via chatt samtidigt som ni behåller full källexport och konventionell distribution.

Även i ett “enkelt” system, separera ansvar:

Använd relationsdatabaser för kanoniska entiteter (team, tjänster, automationer, bevis, ägare). För trender (körningar över tid, täckning veckovis) behåll antingen:

Om flera team delar appen, lägg till explicita org_id/team_id‑fält tidigt. Det möjliggör behörigheter och undviker smärtsamma migreringar senare när ledningen vill ha “en dashboard, men segmenterad”.

Kör dev/staging/prod och definiera hur data flyttas:

För mer om att göra UI lättnavigerat, se /blog/design-dashboard-ux.

En täckningsdashboard blir snabbt en sanningskälla, så åtkomstkontroll och datahantering är lika viktiga som diagrammen. Börja enkelt, men designa så att säkerheten kan skärpas utan större omskrivningar.

Om företaget redan har SSO, integrera det från dag ett (OIDC är ofta enklast; SAML vanligt i större organisationer). För en snabb intern lansering kan ni börja bakom en intern auth‑proxy som injicerar identitetshuvuden och byta till inbyggd SSO senare.

Normalisera identitet till en stabil användarnyckel (email kan ändras). Persist en minimal användarprofil och hämta grupp/teamanhörighet vid behov.

Definiera en liten uppsättning roller och håll auktorisationen konsekvent över UI och API:

Föredra scope‑baserade behörigheter (per team/tjänst) framför “super‑users”. Det minskar risk och flaskhalsar.

Bevis kan innehålla länkar till CI‑loggar, incident‑ticketar eller interna dokument. Begränsa åtkomst till dessa URL:er och eventuella råloggar. Spara bara vad som behövs för verifiering (t.ex. ett build‑ID, tidsstämpel och en kort status‑summering) istället för att kopiera hela loggar till databasen.

Varje manuell ändring av coverage‑claims eller metadata ska skapa en revisionspost: vem ändrade vad, när och varför (fritekst). Sätt också en retention‑policy för körhistorik och bevis—definiera hur länge ni behåller data och implementera säkra rensningsrutiner så gamla poster kan tas bort utan att bryta nuvarande täckningsberäkningar.

En täckningsdashboard lyckas när någon kan svara tre frågor under en minut: Hur ligger vi till? Vad förändras? Vad bör vi åtgärda härnäst? Designa UX runt beslut, inte runt datakällor.

Gör första skärmen till en enkel översikt:

Håll etiketter i vanligt tal (“Automatiserat nyligen” är bättre än “Bevisfärskhet”) och undvik att tvinga läsaren tolka tekniska statusar.

Från varje översikt ska användaren kunna klicka in på en tjänst/process‑sida som svarar “vad” och “med vad”:

Designa varje rad/kort så att det inkluderar “varför‑bakom‑siffran”: bevislänk, ägare, sista körstatus och en tydlig nästa åtgärd (“Kör om jobbet”, “Tilldela ägare”, “Lägg till saknat bevis”).

Erbjuda filter som mappar till hur organisationen arbetar:

Håll filterstatus synliga och delbara (URL‑parametrar), så någon kan skicka en länk som “Prod + Tier‑1 + senaste 14 dagarna” till en intressent.

Använd inline‑definitioner, inte luddig dokumentation:

Integrationer gör er coverage‑app verklig. Målet är inte att spegla alla funktioner i era CI‑ eller testverktyg—målet är att extrahera en konsekvent uppsättning fakta: vad kördes, när det kördes, vad det täcker och vem som äger det.

Börja med systemen som redan producerar automation‑signaler: CI (GitHub Actions, GitLab CI, Jenkins), testrunnerar (JUnit, pytest) och kvalitetsverktyg (coverage‑rapporter, linters, säkerhetsscans).

En connector bör hämta (eller ta emot via webhook) minimalt payload:

Håll connectors idempotenta: upprepade pulls ska inte skapa dubbletter.

Vissa täckningsluckor är avsiktliga (legacy‑system, tredjepartsbegränsningar, pausade initiativ). Förse en lättviktig “undantags”‑post som kräver:

Detta förhindrar permanenta blinda fläckar och håller ledningsvyer ärliga.

Olika källor håller sällan med om identifierare: ett system säger “payments-service”, ett annat “payments” och ett tredje använder en repo‑slug.

Skapa normaliseringsregler för:

Gör detta tidigt; varje downstream‑metrik beror på det.

Inför alias‑tabeller (t.ex. service_aliases, repo_aliases) som mappar många externa namn till en kanonisk entitet. När ny data kommer, matcha mot kanoniska ID först, sedan alias.

Om ett nytt namn inte matchar, generera sammanslagningsförslag (t.ex. “payments‑api” liknar “payments‑service”) för en admin att godkänna.

Schemalägg ett återkommande jobb som kollar senaste körnings‑timestamp per källa och flaggar allt som föråldrat (t.ex. inga CI‑körningar på 7 dagar). Exponera detta i UI så att låg täckning inte förväxlas med saknad data.

En dashboard är användbar, men larm och lätta arbetsflöden är vad som omvandlar intressant data till stadig förbättring. Målet är enkelt: notifiera rätt personer vid rätt tid, med tillräcklig kontext för att agera.

Börja med ett litet antal hög‑signal‑larm:

Varje larm bör länka direkt till relevant drill‑down‑vy så att folk inte behöver leta (t.ex. tjänstevyer eller teamvyer).

Undvik en‑storlek‑passar‑alla‑trösklar. Låt team sätta regler som:

Detta håller signalerna meningsfulla och minskar larmtrötthet.

Skicka larm till befintliga kanaler (email och Slack) och inkludera: vad förändrades, varför det spelar roll och vem som är ägare. Parallellt med realtidslarm, lägg till en veckosammanfattning som täcker:

Behandla larm som uppgifter: tillåt acknowledgement, assignment och status (open/triaged/resolved). En kort kommentarstråd (“fixat i PR #1234”) gör rapporteringen trovärdig och förhindrar att samma problem tyst återkommer.

En monitoreringsdashboard känns snabb när API:et svarar på de frågor UI faktiskt ställer—utan att tvinga webbläsaren att slå ihop dussintals anrop. Börja med ett minimalt, dashboard‑fokuserat API‑ytan och lägg sedan till bakgrundsjobb för att förberäkna allt tungt.

Håll första versionen fokuserad på kärnskärmarna:

GET /api/services (filter som team, språk, tier)GET /api/services/{id}/coverage (övergripande score + nyckeluppdelningar)GET /api/services/{id}/evidence?status=passed&since=...PATCH /api/services/{id}Designa svaren så dashboarden kan rendera omedelbart: inkludera tjänstnamn, ägare, senaste bevis‑tid och aktuell score i en payload istället för att kräva extra lookup:ar.

Listor och drill‑down‑tabeller bör alltid vara paginerade (limit + cursor). För frekvent träffade endpoints, lägg till caching i API‑lagret (eller en delad cache) keyed av filter och anroparens access‑scope.

För allt som kräver scanning av mycket bevis (t.ex. “täckning per team”), förberäkna rollups i ett nattjobb. Spara rollups i en separat tabell (eller materialized view) så läsningar blir enkla och förutsägbara.

Trender är enklast om ni sparar dagliga snapshots:

GET /api/services/{id}/trend?days=90.Snapshots undviker att historiska mått räknas om vid varje sidladdning och gör “färskhet” lätt att rita.

Bulk‑onboarding blir smidigare med:

POST /api/import/services (CSV‑uppladdning)GET /api/export/services.csvTvinga valideringsregler vid skrivning: required owner, tillåtna statusvärden och rimliga tidsstämplar (inga “framtida” bevis). Avvisa dåliga data tidigt förhindrar långsamma, förvirrande fixar senare—särskilt när rollups bygger på konsekventa inputs.

En täckningsdashboard är bara användbar om folk litar på den. Behandla distribution och drift som en del av produkten: förutsägbara releaser, tydliga hälsosignaler och enkla återställningsrutiner när något går fel.

För en intern app, optimera för låg overhead och snabb iteration.

Om ni använder en plattform som Koder.ai för att snabba upp utveckling, ta vara på källexport och deployment‑arbetsflöden tidigt så er interna app ändå följer standard för promotion, review och rollback.

Ni behöver ingen komplex stack för pålitliga signaler.

Sätt upp automatiska databasbackups och en retention‑policy som matchar era behov.

Dokumentera runbooks för:

En liten mängd operativ disciplin hindrar att “täckning” blir gissningsarbete.

En monitoreringsapp hjälper bara om team litar på och använder den. Behandla utrullningen som en produktlansering: börja smått, definiera tydligt ägarskap och baka in en förutsägbar rytm för uppdateringar.

Håll onboarding lätt och upprepbar:

Ett bra mål är “första dashboard‑vy på 30 minuter”, inte ett veckolångt konfigurationsprojekt.

Etablera två rytmer:

Täckningspoäng kan bli politiska om regler ändras oväntat. Definiera en liten styrgrupp (ofta Eng Productivity + Security/Quality) som kan:

Publicera ändringar i en enkel changelog‑sida som /docs/scoring-changelog.

Följ adoption med några enkla mått: aktiva användare, antal spårade tjänster och färskhets‑efterlevnad (hur många tjänster har uppdaterat bevis). Använd dessa för att styra iteration: bättre viktning, rikare bevis‑typer och fler connectors—prioritera alltid förbättringar som minskar manuellt arbete för teamen.

Om ni bestämmer er för att dela era interna lärdomar publikt, överväg att standardisera era bygganteckningar och mallar: team som använder Koder.ai kan också tjäna krediter genom att skapa innehåll om sitt utvecklingsarbetsflöde eller genom att hänvisa andra användare, vilket kan hjälpa finansiera fortsatt iteration av interna verktyg.

Automationstäckning är vad er organisation väljer att mäta som “arbete som hanteras automatiskt” kontra manuellt. För att undvika förvirring: välj en primär enhet för v1 (t.ex. processer, krav/kontroller, testsuiter eller runbooks) och skriv tydliga regler för kantfall som “delvis automatiserat” steg som fortfarande kräver godkännanden.

En bra definition är en där två personer skulle bedöma samma objekt på samma sätt.

Börja med att skriva 5–10 “topfragen” som era användare behöver svar på och behandla dem som produktkrav. Vanliga exempel:

Olika målgrupper (QA, drift, ledning) behöver olika vyer — bestäm vems behov v1 optimerar för.

Gör en inventering av var “bevis” för automation finns och var den auktoritativa listan över vad som borde finnas bor.

Utan ett system of record kan du räkna aktivitet, men du kan inte på ett pålitligt sätt beräkna täckning (eftersom du inte känner till hela mängden mål).

Välj den minst bräckliga metoden per källa:

Dokumentera även connector‑begränsningar (rate limits, auth, retention) så att användare förstår datans färskhet och förtroende.

Separera avsikt, krav och bevis så att måtten inte ser “gröna” ut samtidigt som automationen är föråldrad.

En praktisk modell:

Använd färskhetsfält och bevisregler.

Vanliga fält:

last_seen_at (asset finns fortfarande)last_run_at, last_failure_atlast_reviewed_at (någon bekräftade att påståendet fortfarande gäller)Inför sedan en regel som “räknas som automatiserat bara om det finns N framgångsrika körningar under de senaste 30 dagarna.” Detta skiljer på “finns” och “funkar nyligen.”

Välj en huvudmetrik och gör poängreglerna uttryckliga.

Typiska huvudval:

Håll vikter enkla (t.ex. 1–5) och dokumentera vad “automatiserat / delvis automatiserat / manuellt” innebär med konkreta exempel.

Normalisera identifierare tidigt och hantera omnamn uttryckligen.

Praktiska steg:

service_aliases, repo_aliases) för att mappa externa namn till kanoniska ID.Detta förhindrar dubbletter och håller historiska trender intakta när team reorganiserar eller byter namn.

Börja med SSO (OIDC/SAML) om möjligt, eller använd tillfälligt en intern auth‑proxy som injicerar identitetshuvuden. Definiera en liten rolluppsättning och håll behörigheter konsekventa i UI och API:

Spara minimal känslig bevisdata: föredra build‑ID:n, tidsstämplar och korta sammanfattningar istället för att kopiera hela loggar. Logga manuella ändringar (vem/vad/när/varför) och definiera retention för körhistorik.

Gör larm actionabla och undvik globalt brus.

Hög‑signal larmtyper:

Låt team ställa in trösklar per team/tjänst (olika “stale‑windows” och sidningsregler). Inkludera direkta länkar till drill‑down‑sidor (t.ex. tjänstevyer och teamvyer) och stöd för acknowledgement/assignment/status så att problem kan stängas ordentligt.

Lägg till ägarskap (team/person) och stabila identifierare så att omnamn inte bryter historiken.