06 nov. 2025·8 min

Hur man bygger en webbapp för incidenthantering och efteranalyser

En praktisk plan för att designa, bygga och lansera en webbapp för incidenthantering och efteranalyser — från arbetsflöden till datamodellering och UX.

En praktisk plan för att designa, bygga och lansera en webbapp för incidenthantering och efteranalyser — från arbetsflöden till datamodellering och UX.

Innan du skissar skärmar eller väljer databas, enas om vad ditt team menar med en webbapp för incidenthantering—och vad “hantering av efteranalyser” ska åstadkomma. Team använder ofta samma ord olika: för en grupp är en incident alla kundrapporterade problem; för en annan är det bara ett Sev-1-avbrott med on-call-eskalering.

Skriv en kort definition som svarar på:

Den här definitionen styr ditt incidenthanteringsflöde och förhindrar att appen blir antingen för rigid (ingen använder den) eller för lös (inkonsekvent data).

Bestäm vad en efteranalys är i din organisation: en lättviktssammanfattning för varje incident, eller en full RCA bara för högallvarliga händelser. Gör det tydligt om målet är lärande, efterlevnad, att minska återkommande incidenter, eller allt ovan.

En användbar regel: om du förväntar dig att en efteranalys ska leda till förändring, måste verktyget stödja spårning av åtgärdspunkter, inte bara dokumentlagring.

De flesta team bygger den här typen av app för att åtgärda ett litet antal återkommande smärtpunkter:

Håll listan snäv. Varje funktion du lägger till ska kopplas till minst ett av dessa problem.

Välj några mätvärden du kan mäta automatiskt från appens datamodell:

Dessa blir dina operativa mått och er “definition of done” för första releasen.

Samma app tjänar olika roller i on-call-operations:

Om du designar för alla samtidigt kommer du bygga ett rörigt UI. Välj istället en primär användare för v1—och säkerställ att alla andra senare kan få vad de behöver via skräddarsydda vyer, dashboards och behörigheter.

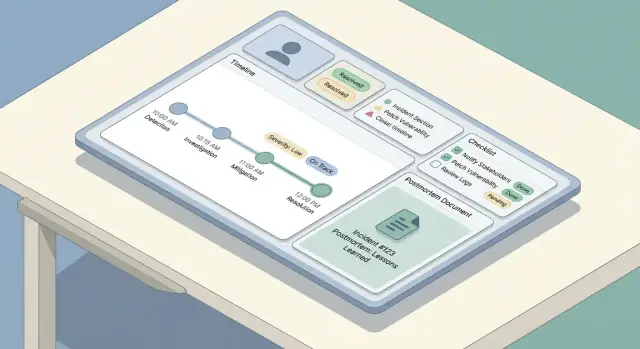

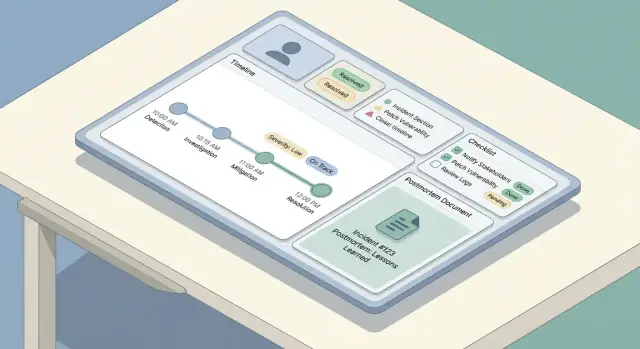

Ett tydligt arbetsflöde förhindrar två vanliga fel: incidenter som stannar av för att ingen vet “vad som kommer härnäst”, och incidenter som ser “klara” ut men aldrig leder till lärande. Börja med att kartlägga livet från början till slut och koppla sedan roller och behörigheter till varje steg.

De flesta team följer en enkel båge: upptäckt → triage → mildra → lös → lär. Appen bör spegla detta med ett litet antal förutsägbara steg, inte en ändlös meny med alternativ.

Definiera vad “klart” betyder för varje steg. Till exempel kan mildring betyda att kundpåverkan är stoppad, även om rotorsaken fortfarande är okänd.

Håll roller explicita så att människor kan agera utan att vänta på möten:

UI:t bör göra “nuvarande ägare” synlig, och arbetsflödet bör stödja delegation (omfördela, lägga till responders, rotera commander).

Välj obligatoriska tillstånd och tillåtna övergångar, såsom Investigating → Mitigated → Resolved. Lägg in skyddsåtgärder:

Separera interna uppdateringar (snabba, taktiska, kan vara röriga) från intressentuppdateringar (tydliga, tidsstämplade, kurerade). Bygg två uppdateringsströmmar med olika mallar, synlighet och godkännanderegler—oftast är det commander som ensam publicerar mot intressenter.

Ett bra incidentverktyg känns “enkelt” i UI eftersom datamodellen under ytan är konsekvent. Innan du bygger skärmar, bestäm vilka objekt som finns, hur de relaterar och vad som måste vara historiskt korrekt.

Börja med ett litet antal first-class-objekt:

De flesta relationer är en-till-många:

Använd stabila identifierare (UUIDs) för incidenter och händelser. Människor behöver fortfarande en vänlig nyckel som INC-2025-0042, vilken kan genereras som en sekvens.

Modellera dessa tidigt så du kan filtrera, söka och rapportera:

Incidentdata är känslig och granskas ofta i efterhand. Behandla redigeringar som data—inte överskrivningar:

Denna struktur gör senare funktioner—sök, mätvärden och behörigheter—mycket enklare att implementera utan att behöva göra om designen.

När något går fel är appens uppgift att minska skrivandet och öka tydligheten. Detta avsnitt täcker "skrivvägen": hur folk skapar en incident, håller den uppdaterad och rekonstruerar vad som hände senare.

Håll intagsformuläret kort nog för att bli klart medan du felsöker. Ett bra standardset av obligatoriska fält är:

Allt annat bör vara valfritt vid skapande (påverkan, kundärenden, misstänkt orsak). Använd smarta standarder: sätt starttid till “nu”, förval användarens on-call-team, och erbjud en ett-klicks “Skapa & öppna incidentrum”-åtgärd.

Ditt uppdaterings-UI bör optimeras för upprepade, små redigeringar. Erbjud en kompakt uppdateringspanel med:

Gör uppdateringar append-vänliga: varje uppdatering blir en tidsstämplad post, inte en överskrivning av tidigare text.

Bygg en tidslinje som blandar:

Detta skapar en tillförlitlig berättelse utan att tvinga folk att komma ihåg att logga varje klick.

Under ett avbrott sker många uppdateringar från telefon. Prioritera en snabb, lågfriktionsskärm: stora tryckyta, en enda scrollbar sida, offline-vänliga utkast och ett-klicksåtgärder som “Publicera uppdatering” och “Kopiera incidentlänk”.

Allvarlighetsgrad är incidenthanteringens “snabbval”: den berättar hur brådskande man ska agera, hur brett man ska kommunicera och vilka kompromisser som är acceptabla.

Undvik vaga etiketter som “hög/medium/låg.” Låt varje nivå kartlägga till tydliga operativa förväntningar—särskilt svarstid och kommunikationsfrekvens.

Till exempel:

Visa dessa regler i UI där allvarlighetsgrad väljs så responders slipper bläddra i dokumentation.

Checklists minskar kognitiv belastning när folk är stressade. Håll dem korta, handlingsbara och rollkopplade.

Ett användbart mönster är några sektioner:

Gör checklistpunkter tidsstämplade och attribuerbara så de blir en del av incidentjournalen.

Incidenter lever sällan i ett verktyg. Appen bör låta responders bifoga länkar till:

Föredra “typade” länkar (t.ex. Runbook, Ticket) så de kan filtreras senare.

Om organisationen spårar pålitlighetsmål, lägg till lätta fält som SLO påverkad (ja/nej), uppskattad error budget-burn och kund-SLA-risk. Håll dem valfria—men lätta att fylla i under eller direkt efter incidenten när detaljer är färska.

En bra efteranalys är enkel att starta, svår att glömma och konsekvent över team. Det enklaste sättet att uppnå detta är att erbjuda en standardmall (med minimalt antal obligatoriska fält) och autofylla den från incidentposten så folk spenderar tid på analys, inte omskrivning.

Din inbyggda mall bör balansera struktur och flexibilitet:

Gör “Rotorsak” valfri tidigt för snabbare publicering, men kräv den innan slutgiltigt godkännande.

Efteranalysen ska inte vara ett separat dokument som flyter omkring. När en efteranalys skapas, bifoga automatiskt:

Använd dessa för att förifylla efteranalysens sektioner. Till exempel kan “Påverkan” börja med incidentens start-/sluttider och nuvarande allvarlighetsgrad, medan “Vad vi gjorde” kan hämta från tidslinjeinlägg.

Lägg till ett lättviktsarbetsflöde så efteranalyser inte fastnar:

Vid varje steg fånga beslutsanteckningar: vad som ändrades, varför och vem godkände. Detta undviker “tysta redigeringar” och underlättar framtida revisioner eller läranderecensioner.

Om du vill hålla UI enkelt, behandla granskningar som kommentarer med explicita utfall (Godkänn / Begär ändringar) och spara slutligt godkännande som ett oföränderligt register.

För team som behöver det, koppla “Publicerad” till ert statusuppdateringsflöde (se /blog/integrations-status-updates) utan att kopiera innehåll för hand.

Efteranalyser minskar bara framtida incidenter om uppföljningsarbetet verkligen blir gjort. Behandla åtgärdspunkter som first-class-objekt i appen—inte en paragraf i slutet av ett dokument.

Varje åtgärdspunkt bör ha konsekventa fält så den kan spåras och mätas:

Lägg till användbar metadata: taggar (t.ex. “övervakning”, “docs”), komponent/tjänst och “skapad från” (incident-ID och postmortem-ID).

Fånga inte åtgärdspunkter inne i en enda efteranalys-sida. Erbjud:

Detta gör uppföljning till en operativ kö istället för spridda anteckningar.

Vissa uppgifter återkommer (kvartalsvisa spelövningar, runbook-granskningar). Stöd en återkommande mall som genererar nya poster enligt schema, samtidigt som varje förekomst är spårbar.

Om team redan använder en annan tracker, tillåt att en åtgärdspunkt innehåller en extern referenslänk och extern ID, samtidigt som din app förblir källan för incidentkoppling och verifiering.

Bygg lätta nudges: avisera ägare när förfallodatum närmar sig, flagga överskridna uppgifter för teamlead och visa mönster av kroniskt överskridna uppgifter i rapporter. Håll regler konfigurerbara så team kan matcha sina on-call-operations och arbetsbelastning.

Incidenter och efteranalyser innehåller ofta känsliga detaljer—kundidentifierare, interna IP:er, säkerhetsfynd eller leverantörsproblem. Tydliga åtkomstregler gör verktyget användbart för samarbete utan att det blir en dataläcka.

Börja med ett litet, begripligt set roller:

Om ni har flera team, överväg att skopiera roller per tjänst/team (t.ex. “Payments Editors”) istället för bred global åtkomst.

Klassificera innehåll tidigt, innan folk skapar vanor:

Ett praktiskt mönster är att markera sektioner som Internt eller Delbart och upprätthålla detta vid export och status-sidor. Säkerhetsincidenter kan kräva en separat incidenttyp med strängare standarder.

För varje ändring i incidenter och efteranalyser, spela in: vem ändrade, vad som ändrades och när. Inkludera redigeringar av allvarlighetsgrad, tidsstämplar, påverkan och slutgiltiga godkännanden. Gör auditloggar sökbara och oredigerbara.

Stöd stark autentisering direkt: e-post + MFA eller magic link, och lägg till SSO (SAML/OIDC) om era användare förväntar sig det. Använd kortlivade sessioner, säkra cookies, CSRF-skydd och automatisk session-revokation vid rolländringar. För fler rullout-överväganden, se /blog/testing-rollout-continuous-improvement.

När en incident är aktiv skannar folk—de läser inte. UX:t bör göra aktuellt läge uppenbart på sekunder, samtidigt som responders kan borra ner i detaljer utan att gå vilse.

Börja med tre skärmar som täcker de flesta arbetsflöden:

En enkel regel: incidentdetalj-sidan bör svara “Vad händer just nu?” högst upp, och “Hur kom vi hit?” nedanför.

Incidenter samlas snabbt, så gör upptäckt snabb och förlåtande:

Erbjud sparade vyer som Mina öppna incidenter eller Sev-1 denna vecka så on-call-ingenjörer slipper återskapa filter varje skift.

Använd konsekventa, färg-säkra badges i hela appen (undvik subtila nyanser som missas i stress). Behåll samma statusvokabulär överallt: lista, detaljhuvud och tidslinjehändelser.

Vid en snabb blick ska responders se:

Prioritera skannbarhet:

Designa för det värsta ögonblicket: om någon är sömndrucken och får sidopaging på telefon, ska UI:t fortfarande guida dem till rätt åtgärd snabbt.

Integrationer förvandlar en incidenttracker från “en plats att skriva anteckningar” till systemet teamet faktiskt kör incidenter i. Börja med att lista system ni måste koppla: övervakning/observability (PagerDuty/Opsgenie, Datadog, CloudWatch), chat (Slack/Teams), e-post, ticketing (Jira/ServiceNow) och en status-sida.

De flesta team får en mix:

Alerts är bullriga, retries förekommer och de kommer ofta ur ordning. Definiera en stabil idempotensnyckel per provider-händelse (till exempel: provider + alert_id + occurrence_id), och spara den med en unik constraint. För deduplikeringsregler, bestäm tillvägagångssätt som “samma tjänst + samma signatur inom 15 minuter” ska appendas till en befintlig incident istället för att skapa en ny.

Var tydlig om vad appen äger kontra vad som ligger kvar i källverktyget:

När en integration fallerar, degradera graciöst: köa retries, visa en varning på incidenten (“Slack-postning försenad”) och tillåt operatörer att fortsätta manuellt.

Behandla statusuppdateringar som ett förstaklassigt utdata: en strukturerad “Update”-åtgärd i UI:t ska kunna publicera till chat, lägga till i incidenttidslinjen och valfritt synka till status-sidan—utan att be respondern skriva samma meddelande tre gånger.

Ditt incidentverktyg används under avbrott, så prioritera enkelhet och tillförlitlighet framför nyskapande. Den bästa stacken är oftast den ert team kan bygga, debugga och driva vid 02:00 med förtroende.

Börja med det era ingenjörer redan sätter i produktion. Ett mainstream webbframework (Rails, Django, Laravel, Spring, Express/Nest, ASP.NET) är oftast säkrare än ett helt nytt ramverk som bara en person förstår.

För datalagring passar en relationsdatabas (PostgreSQL/MySQL) bra för incidentposter: incidenter, uppdateringar, deltagare, åtgärdspunkter och postmortems gynnas av transaktioner och tydliga relationer. Lägg till Redis bara om du verkligen behöver caching, köer eller kortlivade lås.

Hosting kan vara så enkelt som en managed-plattform (Render/Fly/Heroku-liknande) eller er befintliga molnmiljö (AWS/GCP/Azure). Föredra managed-databaser och autom-backuper när möjligt.

Aktiva incidenter känns bättre med realtidsuppdateringar, men du behöver inte alltid websockets från dag ett.

Ett praktiskt angreppssätt: designa API/ev-fi så att du kan börja med polling och uppgradera till websockets senare utan att göra om UI:t.

Om den här appen fallerar under en incident blir den en del av incidenten. Lägg till:

Behandla detta som ett produktionssystem:

Vill ni validera flöde och skärmar innan full byggnad? En vibe-coding-approach funkar bra: använd ett verktyg som Koder.ai för att generera en fungerande prototyp från en detaljerad chatspecifikation, iterera med responders under tabletop-övningar. Eftersom Koder.ai kan producera riktiga React-frontends med en Go + PostgreSQL-backend (och stödjer export av källkod), kan ni se tidiga versioner som "throwaway-prototyper" eller som en utgångspunkt att hårdifiera—utan att förlora lärdomarna från verkliga incidentövningar.

Att släppa ett incidentverktyg utan repetition är en risk. De bästa teamen behandlar verktyget som vilket annat operativt system som helst: testa kritiska vägar, kör realistiska övningar, rulla ut gradvis och fortsätt finjustera baserat på faktisk användning.

Fokusera först på de flöden folk förlitar sig på under hög stress:

Lägg till regressions-tester som validerar vad som inte får gå sönder: tidsstämplar, tidszoner och händelseordning. Incidenter är narrativ—om tidslinjen är fel förloras förtroendet.

Behörighetsbuggar är både operativa och säkerhetsrisker. Skriv tester som bevisar:

Testa även “nära missar”, som användare som förlorar åtkomst mitt i en incident eller organisationsändringar som påverkar gruppmedlemskap.

Innan bred utrullning, kör bordsscenarier där appen är enda sanningskällan. Välj scenarier organisationen känner igen (t.ex. partiellt avbrott, datadelays, tredjepartsfel). Observera friktion: förvirrande fält, saknad kontext, för många klick, otydligt ägarskap.

Samla in feedback direkt och gör små, snabba förbättringar.

Börja med ett pilotteam och några förbyggda mallar (incidenttyper, checklistor, efteranalysscheman). Ge kort träning och en enkelsidig “hur vi kör incidenter”-guide länkad i appen (t.ex. /docs/incident-process).

Spåra adoptionsmått och iterera på friktionspunkter: tid-till-skapande, % incidenter med uppdateringar, efteranalysfärdighetsgrad, och tid-till-stängning för åtgärdspunkter. Behandla dessa som produktmått—inte bara compliance—och förbättra kontinuerligt.

Börja med att skriva en konkret definition som organisationen är överens om:

Den definitionen ska kopplas direkt till era arbetsflödessteg och obligatoriska fält så att data hålls konsekvent utan att bli betungande.

Behandla efteranalyser som ett arbetsflöde, inte bara ett dokument:

Om du förväntar dig förändring behöver du spårning av åtgärdspunkter och påminnelser — inte bara arkivering.

Ett praktiskt v1-paket är:

Hoppa över avancerad automation tills dessa flöden fungerar smidigt under stress.

Använd ett litet antal förutsägbara steg som speglar hur team faktiskt arbetar:

Definiera vad som är “klart” för varje steg och lägg till skyddsåtgärder:

Detta förhindrar att incidenter fastnar och förbättrar kvaliteten på efteranalysen.

Modellera några tydliga roller och koppla dem till behörigheter:

Gör den nuvarande ägaren/commander tydlig i UI och stöd delegation (omfördela, rotera commander).

Håll datamodellen liten men strukturerad:

Använd stabila identifierare (UUIDs) plus en människovänlig nyckel (t.ex. INC-2025-0042). Behandla redigeringar som historik med created_at/created_by och en revisionslogg för ändringar.

Separera flöden och tillämpa olika regler:

Implementera olika mallar/visibilitet och lagra båda i incidentposten så att ni kan rekonstruera beslut senare utan att läcka känsliga detaljer.

Definiera allvarlighetsnivåer med tydliga förväntningar (svarstid och kommunikationsfrekvens). Exempel:

Visa reglerna i UI där allvarlighetsgrad väljs så responders inte behöver leta i extern dokumentation under en incident.

Behandla åtgärdspunkter som strukturerade poster, inte fritext:

Ge sedan globala vyer (överskridna, förfaller snart, per ägare/tjänst) och lätta påminnelser/escalationer så att uppföljningar inte försvinner efter granskningen.

Använd provider-specifika idempotensnycklar och dedup-regler:

provider + alert_id + occurrence_idTillåt alltid manuell länkning som fallback när API:er eller integrationer fallerar.