14 nov. 2025·8 min

Craig McLuckie och cloud-native: När plattformstänkande vinner

En praktisk genomgång av Craig McLuckies roll i cloud-native-adoptionen och hur plattformstänkande hjälpte containrar att bli tillförlitlig produktionsinfrastruktur.

En praktisk genomgång av Craig McLuckies roll i cloud-native-adoptionen och hur plattformstänkande hjälpte containrar att bli tillförlitlig produktionsinfrastruktur.

Team kämpar inte för att de inte kan starta en container. De kämpar för att de måste köra hundratals av dem säkert, uppdatera utan driftstopp, återhämta sig när något går sönder och ändå leverera funktioner enligt schema.

Craig McLuckies "cloud-native"-historia spelar roll eftersom det inte är en självgod hyllning med blanka demoexempel. Det är en redogörelse för hur containrar blev operabla i verkliga miljöer—där incidenter händer, efterlevnad krävs och företaget behöver förutsägbar leverans.

"Cloud-native" är inte bara att "köra i molnet". Det är ett sätt att bygga och drifta mjukvara så att den kan distribueras ofta, skalas när efterfrågan ändras och repareras snabbt när delar fallerar.

I praktiken betyder det ofta:

Tidiga adoptioner av containrar såg ofta ut som en verktygslåda: team tog Docker, satte ihop skript och hoppades att drift skulle hålla jämna steg. Plattformstänkande vänder på det. Istället för att varje team uppfinner sin egen väg till produktion bygger ni delade "paved roads"—en plattform som gör det säkra, efterlevnadsanpassade och observerbara sättet också till det enkla sättet.

Den förändringen är bron från "vi kan köra containrar" till "vi kan driva en affär på dem".

Det här är för dem som ansvarar för resultat, inte bara arkitekturritningar:

Om ditt mål är pålitlig leverans i skala har den här historien praktiska lärdomar.

Craig McLuckie är ett av de mest kända namnen kopplade till den tidiga cloud-native-rörelsen. Du ser honom ofta nämnd i samtal om Kubernetes, Cloud Native Computing Foundation (CNCF) och idén att infrastruktur bör behandlas som en produkt—inte en hög med tickets och tribal kunskap.

Det är värt att vara precis. McLuckie uppfann inte cloud-native ensam, och Kubernetes var aldrig ett enmansprojekt. Kubernetes skapades av ett team på Google, och McLuckie var en del av den tidiga insatsen.

Vad folk ofta krediterar honom för är att hjälpa till att förvandla ett ingenjörskoncept till något som hela branschen faktiskt kunde anta: starkare community-byggande, tydligare paket och en push mot repeterbara driftpraxis.

Genom Kubernetes- och CNCF-eran har McLuckies budskap handlat mindre om trendiga arkitekturer och mer om att göra produktion förutsägbar. Det innebär:

Om du hört termer som "paved roads", "golden paths" eller "platform as a product" kretsar du runt samma idé: minska den kognitiva belastningen för team genom att göra rätt sak till den enkla saken.

Det här inlägget är ingen biografi. McLuckie är en användbar referenspunkt eftersom hans arbete sitter i skärningspunkten av tre krafter som förändrade leverans av mjukvara: containrar, orkestrering och ekosystembyggande. Lärdomarna här handlar inte om personlighet—de handlar om varför plattformstänkande blev nyckeln till att köra containrar i verklig produktion.

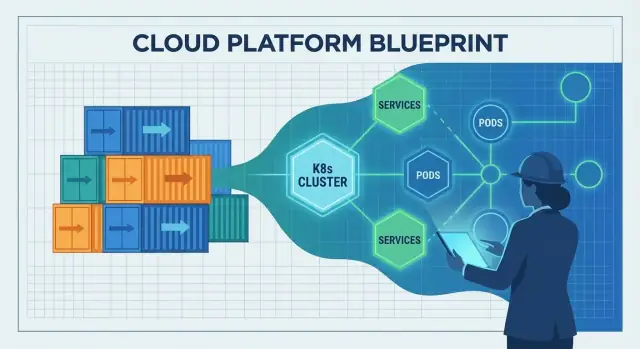

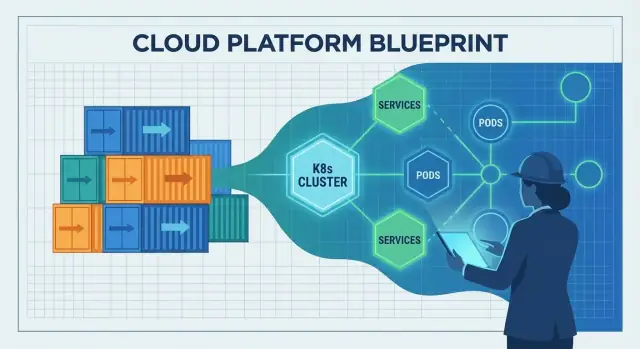

Containrar var en spännande idé långt innan "cloud-native" blev ett vanligt begrepp. I vardagliga termer är en container ett sätt att paketera en applikation tillsammans med filer och bibliotek den behöver så att den kan köras likadant på olika maskiner—som att skicka en produkt i en förseglad låda med alla delar inkluderade.

Tidigt använde många team containrar för sidoprojekt, demoexempel och utvecklarflöden. De var utmärkta för att testa nya tjänster snabbt, starta upp testmiljöer och undvika "det funkar på min laptop"-överraskningar vid överlämning.

Men att gå från ett fåtal containrar till ett produktionssystem som körs dygnet runt är en annan uppgift. Verktygen fanns, men den operativa historien var ofullständig.

Vanliga problem dök snabbt upp:

Containrar gjorde mjukvara portabel, men portabilitet garanterade inte tillförlitlighet. Team behövde fortfarande konsekventa distributionsrutiner, tydligt ägarskap och operativa skyddsräcken—så att containeriserade appar inte bara kördes en gång, utan kördes förutsägbart varje dag.

Plattformstänkande är ögonblicket när ett företag slutar se infrastruktur som ett engångsprojekt och börjar behandla det som en intern produkt. "Kunderna" är era utvecklare, datateam och alla som levererar mjukvara. Produktmålet är inte fler servrar eller mer YAML—det är en smidigare väg från idé till produktion.

En riktig plattform har ett tydligt löfte: "Om du bygger och distribuerar med dessa vägar får du tillförlitlighet, säkerhet och förutsägbar leverans." Det löftet kräver produktvanor—dokumentation, support, versionering och feedbackloopar. Det kräver också en genomtänkt användarupplevelse: vettiga standardinställningar, paved roads och en nödlösning när team verkligen behöver den.

Standardisering tar bort beslutströtthet och förhindrar oavsiktlig komplexitet. När team delar samma distributionsmönster, loggning och åtkomstkontroller blir problem repeterbara—och därmed lösbara. On-call-rotationer förbättras eftersom incidenter ser bekanta ut. Säkerhetsgranskningar går snabbare eftersom plattformen redan har inbyggda skyddsräcken i stället för att förlita sig på att varje team uppfinner dem.

Det handlar inte om att tvinga alla in i samma box. Det handlar om att enas om de 80% som borde vara tråkiga, så team kan lägga energi på de 20% som skiljer affären åt.

Innan plattformsmetoderna slog igenom berodde infrastrukturen ofta på speciell kunskap: några få visste vilka servrar som var patchade, vilka inställningar som var säkra och vilka skript som var "de bra". Plattformstänkande ersätter det med repeterbara mönster: mallar, automatiserad provisionering och konsekventa miljöer från dev till produktion.

Gjort rätt skapar plattformar bättre styrning med mindre pappersarbete. Policys blir automatiska kontroller, godkännanden blir revisionsbara flöden och efterlevnadsbevis genereras när team distribuerar—så organisationen får kontroll utan att bromsa alla.

Containrar gjorde det enkelt att paketera och leverera en app. Den svåra delen var vad som hände efter att du levererat den: välja var den ska köras, hålla den frisk och anpassa när trafik eller infrastruktur förändras.

Det är gapet Kubernetes fyllde. Det förvandlade "en hög av containrar" till något du kan drifta dag efter dag, även när servrar fallerar, releaser sker och efterfrågan ökar.

Kubernetes beskrivs ofta som "containerorkestrering", men de praktiska problemen är mer specifika:

Utan en orkestrator slutar team med att skripta dessa beteenden och hantera undantag för hand—tills skripten inte längre speglar verkligheten.

Kubernetes populariserade idén om ett delat control plane: en plats där du deklarerar vad du vill ("kör 3 kopior av den här tjänsten") och plattformen kontinuerligt arbetar för att få den verkliga världen att matcha den avsikten.

Det är ett stort ansvarsskifte:

Kubernetes dök inte upp för att containrar var trendiga. Det växte fram ur lärdomar från att drifta stora flotta: betrakta infrastruktur som ett system med återkopplingsslingor, inte som en uppsättning enstaka serveruppgifter. Denna operativa inställning är varför det blev bron från "vi kan köra containrar" till "vi kan köra dem pålitligt i produktion".

Cloud-native introducerade inte bara nya verktyg—det förändrade rytmen i att skicka mjukvara. Team gick från "handbyggda servrar och manuella runbooks" till system designade för att drivas via API:er, automation och deklarativ konfiguration.

En cloud-native-setup förutsätter att infrastruktur är programmerbar. Behöver du en databas, en load balancer eller en ny miljö? I stället för att vänta på manuell setup beskriver team vad de vill ha och låter automation skapa det.

Den avgörande förändringen är deklarativ konfiguration: du definierar önskat tillstånd ("kör 3 kopior av denna tjänst, exponera den på denna port, begränsa minne till X") och plattformen arbetar kontinuerligt för att matcha det tillståndet. Det gör ändringar granskbara, repeterbara och enklare att rulla tillbaka.

Traditionell leverans involverade ofta patchning av live-servrar. Med tiden blev varje maskin lite annorlunda—konfigurationsdrift som bara visar sig under en incident.

Cloud-native-leverans pressade team mot immutabla distributioner: bygg en artefakt en gång (ofta en containerimage), distribuera den, och om du behöver en ändring deployar du en ny version i stället för att modifiera det som redan körs. Kombinerat med automatiserade rollouter och health checks tenderar detta att minska "mystiska driftstopp" orsakade av ad-hoc-ändringar.

Containrar gjorde det enklare att paketera och köra många små tjänster konsekvent, vilket uppmuntrade mikrotjänstarkitekturer. Mikrotjänster ökade i sin tur behovet av konsekvent distribution, skalning och service discovery—områden där containerorkestrering utmärker sig.

Kompromissen: fler tjänster betyder mer driftarbete (övervakning, nätverk, versionering, incidenthantering). Cloud-native hjälper till att hantera den komplexiteten, men tar inte bort den.

Portabiliteten förbättrades eftersom team standardiserade på gemensamma distributionsprimitiver och API:er. Fortfarande kräver "kör varsomhelst" oftast arbete—skillnader i säkerhet, lagring, nätverk och managed services spelar roll. Cloud-native är bäst förstått som att minska låsning och friktion, inte att eliminera dem.

Kubernetes spreds inte bara för att det var kraftfullt. Det spreds därför att det fick ett neutralt hem, tydlig styrning och en plats där konkurrerande företag kunde samarbeta utan att en leverantör "ägde" reglerna.

Cloud Native Computing Foundation (CNCF) skapade delad styrning: öppet beslutsfattande, förutsägbara projektprocesser och offentliga roadmappar. Det spelar roll för team som satsar på kärninfrastruktur. När reglerna är transparenta och inte knutna till en enskild företags affärsmodell känns adoption mindre riskfylld—och bidrag blir mer attraktiva.

Genom att hosta Kubernetes och relaterade projekt hjälpte CNCF att förvandla "ett populärt open source-verktyg" till en långsiktig plattform med institutionellt stöd. Den gav:

Med många bidragsgivare (molnleverantörer, startups, företag och oberoende ingenjörer) utvecklades Kubernetes snabbare och i mer verkliga riktningar: nätverk, lagring, säkerhet och day-2-operationer. Öppna API:er och standarder gjorde det enklare för verktyg att integrera, vilket minskade låsning och ökade förtroendet för produktionsanvändning.

CNCF accelererade också en explosion av ekosystemet: service meshes, ingress-kontrollers, CI/CD-verktyg, policymotorer, observability-stacks med mera. Denna överflöd är en styrka—men skapar också överlapp.

För de flesta team kommer framgång från att välja en liten uppsättning välunderstödda komponenter, favorisera interoperabilitet och vara tydlig med ägarskap. Ett "bäst av allt"-angreppssätt leder ofta till underhållsbyrda snarare än bättre leverans.

Containrar och Kubernetes löste en stor del av frågan "hur ska vi köra mjukvara?". De löste inte automatiskt den svårare frågan: "hur håller vi den igång när riktiga användare dyker upp?" Det saknade lagret är operativ tillförlitlighet—tydliga förväntningar, delade praxis och ett system som gör rätt beteenden till standard.

Ett team kan leverera snabbt och ändå vara ett dåligt deploy från kaos om produktionsbaslinjen är odefinierad. Minst behöver du:

Utan denna baslinje hittar varje tjänst på sina egna regler och tillförlitlighet blir en fråga om tur.

DevOps och SRE introducerade viktiga vanor: ägarskap, automation, mätbar tillförlitlighet och lärande från incidenter. Men vanor skalas inte över dussintals team och hundratals tjänster.

Plattformar gör dessa praxis repeterbara. SRE sätter mål (som SLOs) och feedbackloopar; plattformen erbjuder paved roads för att nå dem.

Pålitlig leverans kräver oftast en konsekvent uppsättning kapabiliteter:

En bra plattform bakar in dessa standarder i mallar, pipelines och runtime-policys: standard dashboards, gemensamma larmregler, distributionsskydd och rollback-mekanismer. Så börjar tillförlitlighet vara ett förutsägbart utfall av att skicka mjukvara.

Cloud-native-verktyg kan vara kraftfulla och ändå kännas som "för mycket" för de flesta produktteam. Plattformengineering finns för att stänga det gapet. Uppdraget är enkelt: minska kognitiv belastning för applikationsteam så att de kan leverera funktioner utan att bli deltidsinfrastrukturexperter.

Ett bra plattformsteam behandlar intern infrastruktur som en produkt. Det betyder tydliga användare (utvecklare), tydliga resultat (säker, repeterbar leverans) och en feedbackloop. I stället för att lämna över en hög Kubernetes-primitiver erbjuder plattformen åsiktsstyrda sätt att bygga, distribuera och drifta tjänster.

En praktisk fråga att ställa är: "Kan en utvecklare gå från idé till en körande tjänst utan att öppna ett dussin tickets?" Verktyg som komprimerar det arbetsflödet—samtidigt som de bevarar skyddsräcken—är i linje med cloud-native plattformsmålet.

De flesta plattformar är en uppsättning återanvändbara "paved roads" som team kan välja som standard:

Målet är inte att dölja Kubernetes—utan att paketera det i rimliga standarder som förhindrar oavsiktlig komplexitet.

I den anda kan Koder.ai användas som ett "DX-accelerator"-lager för team som vill spawna interna verktyg eller produktfunktioner snabbt via chat, och sedan exportera källkod när det är dags att integrera med en mer formell plattform. För plattformsteam kan dess planning mode och inbyggda snapshots/rollback också spegla samma tillförlitlighetsprioriterade hållning du vill ha i produktionsarbetsflöden.

Varje paved road är en avvägning: mer konsekvens och säkrare drift, men färre enstaka alternativ. Plattformsteam gör bäst när de erbjuder:

Du ser plattformsframgång i mätbara termer: snabbare onboardning för nya ingenjörer, färre specialskripta distributionsskript, färre "snowflake"-kluster och tydligare ägarskap vid incidenter. Om team kan svara på "vem äger den här tjänsten och hur deployar vi?" utan ett möte, gör plattformen sitt jobb.

Cloud-native kan göra leverans snabbare och drift lugnare—men bara när team är tydliga med vad de försöker förbättra. Många fördröjningar sker när Kubernetes och dess ekosystem behandlas som målet, inte medlet.

Ett vanligt misstag är att adoptera Kubernetes eftersom det är "vad moderna team gör", utan ett konkret mål som kortare lead time, färre incidenter eller bättre miljökonsistens. Resultatet blir mycket migrationsarbete utan synlig nytta.

Om framgångskriterier inte definieras i förväg blir varje beslut subjektivt: vilket verktyg att välja, hur mycket att standardisera och när plattformen är "klar".

Kubernetes är en grund, inte en full plattform. Team lägger ofta snabbt till tillägg—service mesh, flera ingress-kontrollers, custom operators, policymotorer—utan tydliga gränser eller ägarskap.

Överanpassning är en annan fälla: skräddarsydda YAML-mönster, hemmagjorda mallar och engångsundantag som bara ursprungsförfattarna förstår. Komplexiteten stiger, onboardingen saktar och uppgraderingar blir riskfyllda.

Cloud-native gör det lätt att skapa resurser—och lätt att glömma dem. Kluster-spridning, oanvända namespaces och överallokerade arbetslaster driver tyst upp kostnader.

Säkerhetsfällor är lika vanliga:

Starta litet med en eller två väldefinierade tjänster. Definiera standarder tidigt (golden paths, godkända basimages, uppgraderingsregler) och håll plattformens yta medvetet begränsad.

Mät utfall som distributionsfrekvens, MTTR och utvecklarnas tid till första deploy—och betrakta allt som inte flyttar dessa siffror som valfritt.

Du "adopterar inte cloud-native" i ett enda steg. De team som lyckas följer samma centrala idé som associeras med McLuckies era: bygg en plattform som gör rätt väg till den enkla vägen.

Börja litet, kodifiera det som fungerar.

Om ni experimenterar med nya arbetsflöden är ett användbart mönster att prototypa hela "golden path"-upplevelsen innan ni standardiserar den. Till exempel kan team använda Koder.ai för att snabbt generera en fungerande webapp (React), backend (Go) och databas (PostgreSQL) via chat, och sedan använda den resulterande kodbasen som utgångspunkt för plattformens mallar och CI/CD-konventioner.

Innan ni lägger till verktyg, fråga:

Mät utfall, inte verktygsanvändning:

Om du vill ha exempel på vad bra "plattform-MVP"-paket kan se ut, se /blog. För budgetering och utrullningsplanering kan du också referera till /pricing.

Den stora lärdomen från det senaste decenniet är enkel: containrar "vann" inte för att de var smart paketering. De vann för att plattformstänkande gjorde dem pålitliga—repeterbara distributioner, säkra rollouter, konsekventa säkerhetskontroller och förutsägbara driftmönster.

Nästa kapitel handlar inte om ett enda genombrottsverktyg. Det handlar om att göra cloud-native tråkigt på bästa sätt: färre överraskningar, färre ad-hoc-fixar och en smidigare väg från kod till produktion.

Policy-as-code blir standard. I stället för att granska varje distribution manuellt kodifierar team regler för säkerhet, nätverk och efterlevnad så att skyddsräcken blir automatiska och revisionsbara.

Utvecklarupplevelse (DX) behandlas som en produkt. Räkna med mer fokus på paved roads: mallar, självservice-miljöer och tydliga golden paths som minskar kognitiv belastning utan att begränsa autonomi.

Enklare drift, inte fler dashboards. De bästa plattformarna gömmer komplexitet: åsiktsstyrda standarder, färre rörliga delar och inbyggda tillförlitlighetsmönster i stället för eftermonterade lösningar.

Cloud-native-framsteg bromsas när team jagar funktioner i stället för resultat. Om du inte kan förklara hur ett nytt verktyg minskar lead time, sänker incidentfrekvensen eller förbättrar säkerhet, är det troligen inte prioritet.

Utvärdera era nuvarande leveranssmärtpunkter och mappa dem till plattformsbehov:

Behandla svaren som er plattformsbacklogg—och mät framgång på de förbättringar era team känner varje vecka.

Cloud-native är ett sätt att bygga och drifta mjukvara så att du kan distribuera ofta, skala när efterfrågan förändras och återhämta dig snabbt från fel.

I praktiken inkluderar det ofta containrar, automation, mindre tjänster och standardiserade sätt att observera, säkra och styra det som körs.

En container hjälper dig att skicka mjukvara konsekvent, men löser inte alla svåra produktionsproblem av sig själv—som säkra uppgraderingar, service discovery, säkerhetskontroller och beständig observabilitet.

Klyftan syns när du går från ett fåtal containrar till hundratals som körs dygnet runt.

“Plattformstänkande” innebär att behandla intern infrastruktur som en intern produkt med tydliga användare (utvecklare) och ett tydligt löfte (säker, repeterbar leverans).

Istället för att varje team sätter ihop sin egen väg till produktion bygger organisationen delade paved roads (golden paths) med rimliga standardval och support.

Kubernetes tillhandahåller det operativa lagret som gör att “en hög av containrar” blir ett system du kan driva dag efter dag:

Det introducerar också ett delat där du deklarerar önskat tillstånd och systemet arbetar för att uppfylla det.

Deklarativ konfiguration betyder att du beskriver vad du vill ha (önskat tillstånd) i stället för att skriva steg-för-steg-instruktioner.

Praktiska fördelar:

Immutabla distributioner innebär att du inte patchar live-servrar på plats. Du bygger en artefakt en gång (ofta en containerimage) och distribuerar just den artefakten.

För att ändra något skickar du en ny version i stället för att modifiera det som redan körs. Det minskar konfigurationsdrift och gör incidenter lättare att reproducera och återställa.

CNCF gav Kubernetes och närliggande projekt ett neutralt styrt hem, vilket minskade risken att satsa på kärninfrastruktur.

Det hjälpte med:

En produktionsbaslinje är minimisatsen av kapabiliteter och rutiner som gör tillförlitlighet förutsägbar, till exempel:

Utan detta hittar varje tjänst på sina egna regler och tillförlitlighet blir en fråga om tur.

Plattformengineering syftar till att minska utvecklarnas kognitiva belastning genom att paketera cloud-native-primitiver till opinionsstyrda standarder:

Målet är inte att gömma Kubernetes—utan att göra den säkra vägen till den enklaste vägen.

Vanliga fallgropar är:

Hur man undviker dem: