26 aug. 2025·8 min

Guillermo Rauch, Vercel & Next.js: Göra distribution enkel

Utforska hur Guillermo Rauch, Vercel och Next.js gjorde distribution, SSR och frontend-infrastruktur enklare produkter för mainstream-byggare.

Utforska hur Guillermo Rauch, Vercel och Next.js gjorde distribution, SSR och frontend-infrastruktur enklare produkter för mainstream-byggare.

Inte så länge sedan innebar att skicka ut en webbapp oftast: bygg den, hitta ett host, koppla ihop allt och håll det igång. Även om koden var enkel tvingade publicering ofta beslut om servrar, caching, byggpipelines, TLS-certifikat och övervakning. Inget av det var glamoröst, men det var oundvikligt—och det drog rutinmässigt team bort från produkten de försökte leverera.

Det stora skiftet är att distribution slutade vara ett engångs tekniskt projekt och blev ett arbetsflöde du upprepar varje dag. Team ville ha förhandsvisnings-URL:er för varje pull request, återställningar som inte kräver detektivarbete och en pålitlig väg från lokal kod till produktion.

När dessa behov blev vanliga bland startups, byråer och företag började distribution se mindre ut som skräddarsydd engineering och mer som något som kunde paketera: en produkt med klara standardinställningar, ett UI, vettig automation och förutsägbara resultat.

Server-side rendering (SSR) la till ytterligare ett lager av komplexitet. Det är inte bara “servera filer”; det är “köra kod på servern för att generera HTML, cacha det säkert och uppdatera utan att störa användare.” Att göra SSR bra innebar att förstå:

Detta var hanterbart för specialister, men lätt att felkonfigurera—och svårt att underhålla när ett projekt växte.

Så vad betyder det att produktifiera frontend-infrastruktur?

Det betyder att förvandla de stökiga, felbenägna delarna av att skicka en frontend—builds, deploys, förhandsvisningar, SSR/SSG-hantering, caching och edge-leverans—till ett standardiserat, i stort sett automatiskt system som fungerar likadant över projekt.

I följande avsnitt är målet praktiskt: förstå vad som förenklas, vad du vinner och vilka avvägningar du accepterar—utan att behöva bli en ops-expert.

Guillermo Rauch är idag mest känd som VD för Vercel och som en ledande röst bakom Next.js. Hans inflytande handlar mindre om en enskild uppfinning och mer om en konsekvent besatthet: att få webbutveckling att kännas “självklar” för dem som bygger produkter.

Rauch har ägnat mycket av sin karriär åt att leverera utvecklarverktyg i det offentliga rummet. Innan Vercel byggde och underhöll han populära open source-projekt (särskilt Socket.IO) och hjälpte till att odla en kultur där dokumentation, exempel och vettiga standardinställningar behandlas som en del av produkten—inte som eftertankar.

Han grundade senare ZEIT (numera Vercel), ett företag som fokuserade på att göra distribution till ett strömlinjeformat arbetsflöde. Next.js, som ursprungligen utvecklades i det ekosystemet, blev ramverket som parade en modern frontend-upplevelse med produktionsvänliga funktioner.

Ett användbart sätt att förstå Rauchs påverkan är genom de val som upprepade sig:

Det fokuset formade både ramverket och plattformen: Next.js uppmuntrade team att anta server-side rendering och statisk generering utan att behöva lära sig ett helt nytt operativt playbook, medan Vercel drev distribution mot ett förutsägbart, upprepat default.

Det är lätt att göra den här historien till en enskild persons narrative. En mer korrekt tolkning är att Rauch hjälpte till att anpassa ett bredare skifte som redan var på gång: frontend-team ville ha snabbare iteration, färre handoffs och infrastruktur som inte krävde en dedikerad ops-specialist för varje ändring.

Vercel och Next.js fungerar som en fallstudie i produkt tänkande eftersom de paketerade de önskemålen till standarder som mainstream-team faktiskt kunde använda.

Next.js är ett React-ramverk som ger dig ett “fullt webbapp-starterkit” ovanpå React. Du bygger fortfarande komponenter på samma sätt, men Next.js lägger till de saknade bitarna som de flesta team ändå sätter ihop: sidor, routing, sätt att hämta data och produktionsvänliga prestanda-standarder.

Routing och sidor: I en vanlig React-app lägger man oftast till ett router-bibliotek, bestämmer URL-konventioner och kopplar ihop allt. Next.js gör URL:er och sidor till en förstklassig funktion, så din projektsstruktur mappar naturligt till rutter.

Dataladdning: Riktiga appar behöver data—produktlistor, användarkonton, CMS-innehåll. Next.js erbjuder vanliga mönster för att ladda data på servern, vid build-tid eller i webbläsaren, utan att tvinga varje team att uppfinna en egen setup.

Prestanda-standarder: Next.js bakar in praktiska optimeringar—code splitting, smartare hantering av assets och renderingsval—så du får bra hastighet utan att jaga en lång lista plugins.

En vanlig React-app är ofta “React + en massa beslut”: routing-bibliotek, byggkonfiguration, SSR/SSG-verktyg (om det behövs) och konventioner som bara finns i ditt repo.

Next.js är mer opinionated: det standardiserar de vanliga besluten så nya utvecklare snabbare förstår projektet, och team spenderar mindre tid på att underhålla röran under ytan.

Next.js kan vara överkurs om du bygger en liten, mestadels statisk sajt med några få sidor, eller ett enkelt internt verktyg där SEO och första laddningsprestanda inte är viktiga.

Om du inte behöver flera renderingsalternativ, strukturerad routing eller server-side dataladdning kan en lättare React-setup (eller ingen React alls) vara enklare och billigare.

Moderna webbappar kan kännas mystiska eftersom “var sidan byggs” ändras beroende på angreppssätt. Ett enkelt sätt att tänka på SSR, SSG och klient-side rendering (CSR) är: när och var genereras HTML?

Med SSR genererar servern HTML för varje förfrågan (eller för många förfrågningar om caching används). Det kan hjälpa med SEO och göra första vyn snabb—särskilt på långsammare enheter—eftersom webbläsaren får verkligt innehåll tidigt.

En vanlig missuppfattning: SSR är inte automatiskt snabbare. Om varje förfrågan triggar långsamma databasanrop kan SSR kännas segt. Den verkliga farten kommer ofta från caching (på servern, CDN eller edge) så återkommande besök inte gör om arbetet.

Med SSG förbyggs sidor i förväg (under en build-step) och serveras som statiska filer. Detta är utmärkt för tillförlitlighet och kostnad, och levererar ofta utmärkt laddtid eftersom sidan redan är “färdig” innan användaren kommer.

SSG passar marknadsföringssidor, dokumentation och innehåll som inte förändras varje sekund. Nackdelen är färskhet: uppdateringar kan kräva en ny build eller en inkrementell uppdateringsstrategi.

Med CSR laddar webbläsaren JavaScript och bygger UI på användarens enhet. Detta funkar bra för mycket interaktiva, personaliserade delar av en app (dashboards, editorn), men kan fördröja första meningsfulla vy och komplicera SEO om innehållet inte finns som HTML direkt.

De flesta verkliga produkter kombinerar lägen: SSG för landningssidor (SEO och hastighet), SSR för dynamiska sidor som ändå behöver indexerbart innehåll (produktlistor) och CSR för inloggade upplevelser.

Att välja rätt påverkar direkt resultat: SEO (upptäckbarhet), hastighet (konvertering) och tillförlitlighet (färre incidenter, stabilare intäkter).

Innan plattformar gjorde distribution till en knappklicksupplevelse innebar publicering ofta att du monterade ihop ett eget litet “infrastrukturprojekt.” Även en enkel marknadssajt med ett dynamiskt kontaktformulär kunde förvandlas till en kedja av servrar, skript och tjänster som måste hållas i perfekt synk.

En vanlig setup såg ut så här: du provisionerade en eller flera servrar (eller en VM), installerade en webbserver och kopplade upp en CI-pipeline som byggde din app och kopierade artefakter över SSH.

Ovanpå det kunde du konfigurera en reverse proxy (som Nginx) för att routa förfrågningar, terminera TLS och hantera komprimering. Sedan kom caching: kanske en HTTP-cache, en CDN-konfiguration och regler om vilka sidor som var säkra att cacha och hur länge.

Behövde du SSR drev du nu en Node-process som måste startas, övervakas, återstartas och skalas.

Problemen var inte teoretiska—de dök upp vid varje release:

Lokal utveckling döljer de stökiga bitarna: du har en varm cache, en annan Node-version, andra env-vars och ingen riktig trafik. När du väl deployar dyker de skillnaderna upp direkt—ofta som subtila SSR-mismatchningar, saknade hemligheter eller routingregler som beter sig annorlunda bakom en proxy.

Avancerade setups (SSR, multi-region prestanda, säkra preview-miljöer) var möjliga, men krävde driftstid. För många små team betydde det att de nöjde sig med enklare arkitektur—not för att det var bäst, utan för att distributionskostnaden var för hög.

Vercel automatiserade inte bara distribution—it paketerade det som ett standardarbetsflöde som känns som en del av kodskrivandet. Produktidén är enkel: distribution ska inte vara en separat “ops-uppgift” du schemalägger; det ska vara det normala resultatet av vardagligt utvecklingsarbete.

“Git push to deploy” beskrivs ofta som ett snyggt skript. Vercel behandlar det mer som ett löfte: om din kod finns i Git är den deploybar—konsekvent, upprepbart och utan en checklista av manuella steg.

Den skillnaden spelar roll eftersom den förändrar vem som vågar skicka. Du behöver inte en specialist som tolkar serverinställningar, cache-regler eller build-steg varje gång. Plattformen gör de besluten till standarder och skyddsräcken.

Förhandsvisnings-deploys är en stor anledning till att detta känns mer som ett arbetsflöde än ett verktyg. Varje pull request kan generera en delbar URL som ligger nära produktionsbeteendet.

Designers kan granska spacing och interaktioner i en riktig miljö. QA kan testa exakt den build som skulle skickas. PM kan klicka igenom funktionen och lämna konkreta kommentarer—utan att vänta på en “staging-push” eller be någon köra branchen lokalt.

När distribution blir frekvent blir säkerhet en daglig nödvändighet. Snabba rollbackar betyder att en dålig release är ett irritationsmoment, inte en incident.

Miljöparitet—att hålla previews, staging och produktion lika—minskar ”det funkar på min maskin”-problemet som bromsar team.

Föreställ dig att du deployar en ny pris-sida plus en liten förändring i signup-flödet. Med preview-deploys granskar marknadssidan, QA testar flödet och teamet mergar med förtroende.

Om analys visar ett problem efter lansering kan du rulla tillbaka på minuter medan du fixar—utan att frysa allt annat arbete.

Ett CDN (Content Delivery Network) är en uppsättning servrar runt om i världen som lagrar (och levererar) kopior av din sites filer—bilder, CSS, JavaScript och ibland HTML—så användare laddar ner dem från en närliggande plats.

Caching är regelverket för hur länge dessa kopior kan återanvändas. Bra caching betyder snabbare sidor och färre träffar mot din ursprungstjänst. Dålig caching betyder att användare ser gammalt innehåll—eller att teamet vågar cacha väldigt lite.

Edge är nästa steg: istället för att bara leverera filer från globala platser kan du köra små kodstycken nära användaren, i förfrågningsögonblicket.

Detta är där “frontend-infrastruktur utan ops-team” blir verkligt: många team får global distribution och smart request-hantering utan att drifta servrar i flera regioner.

Edge-funktioner skiner när du behöver snabba beslut innan en sida levereras:

Om din sajt mest består av statiska sidor, har låg trafik eller om du har strikta krav på exakt var kod får köras (juridik/databoende) kan edge addera komplexitet utan tydlig vinst.

Att köra kod över många platser kan göra observability och felsökning svårare: loggar och spår är mer distribuerade, och att återskapa ”det kraschar bara i en region” kan ta tid.

Det finns också leverantörsspecifika beteenden (API:er, gränser, runtime-differenser) som påverkar portabiliteten.

Om de används genomtänkt ger edge-team global prestanda och kontroll—utan att anställa ett ops-team för att sy ihop det.

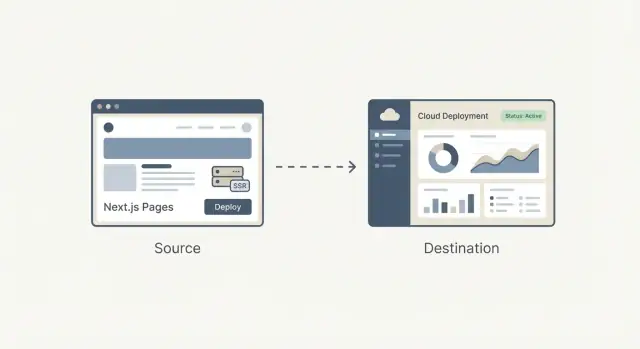

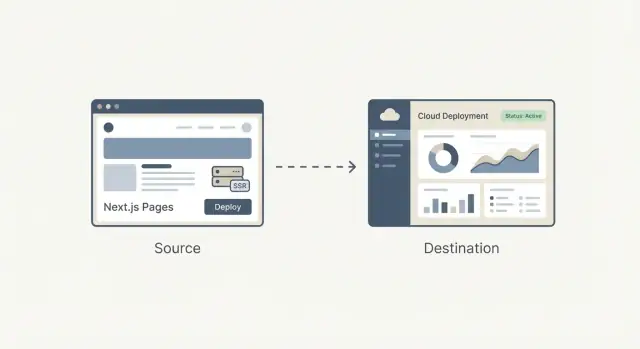

Ett framework och en hostingplattform “passar ihop” när plattformen förstår vad frameworket producerar vid build-tid—och vad det behöver vid förfrågan.

Det betyder att hosten kan tolka build-output (statiska filer vs. serverfunktioner), applicera rätt routingregler (dynamiska rutter, rewrites) och ställa in vettig caching (vad som kan cachas i edge, vad som måste vara färskt).

När plattformen känner till frameworkets konventioner försvinner mycket arbete:

Nettofördelen är färre skräddarsydda skript och färre “fungerar på min maskin”-överraskningar.

Nackdelen är bekvämlighetsdriven lock-in. Om din app förlitar sig på plattformsspecifika funktioner (edge-API:er, proprietära cachingregler, build-plugins) kan flytt innebära omskrivning av routing, middleware eller deploymentspipelines.

För att behålla portabilitet: separera ansvar, håll affärslogik framework-native, dokumentera host-specifika beteenden och föredra standarder där möjligt (HTTP-headers, redirects, miljövariabler).

Anta inte att det finns ett enda bästa val. Jämför plattformar efter: deploymentsflöde, stödda renderingslägen, cachekontroll, edge-stöd, observability, prissäkerhet och hur lätt det är att lämna.

Ett litet proof-of-concept—deploya samma repo till två leverantörer—avslöjar ofta verkliga skillnader snabbare än dokumentation.

Prestanda handlar inte bara om att glänsa i ett speedtest. Det är en produktfunktion: snabbare sidor minskar bounce och förbättrar konverteringar, och snabbare builds låter team leverera oftare utan att vänta.

För användare betyder “snabbt” att sidan blir användbar snabbt—särskilt på medelklass-telefoner och långsammare nätverk. För team betyder “snabbt” att deployer slutförs på minuter (eller sekunder) så ändringar kan gå live med förtroende.

Vercel populariserade tanken att du kan optimera båda samtidigt genom att göra prestanda till en del av standardarbetsflödet snarare än ett särskilt projekt.

En traditionell build bygger ofta om allt, även om du ändrat en rad på en sida. Inkrementella builds försöker bygga om bara det som ändrats—som att trycka om ett kapitel i en bok istället för hela boken.

Caching hjälper genom att återanvända tidigare beräknade resultat:

I Next.js passar mönster som incremental static regeneration (ISR) in i detta: servera en snabb förbyggd sida, och uppdatera den i bakgrunden när innehåll ändras.

En prestandabudget är en enkel gräns ni enas om—som “hålla startsidan under 200 KB JavaScript” eller “Largest Contentful Paint under 2.5s på typisk mobil.” Poängen är inte perfektion; det är att förhindra att sidor blir långsamma i smyg.

Håll det lätt och konsekvent:

När snabbhet behandlas som en funktion får ni både bättre användarupplevelse och snabbare team-cadence—utan att varje release blir en prestandabrasa.

De flesta verktyg blir inte mainstream för att de är mest flexibla—de vinner för att en ny användare kan lyckas snabbt.

Mainstream-byggare (små team, byråer, produktutvecklare utan djup infra-expertis) brukar utvärdera plattformar med enkla frågor:

Här spelar mallar, tydlig dokumentation och “happy path”-arbetsflöden roll. En mall som deployar på några minuter och demonstrerar routing, datainhämtning och autentisering är ofta mer övertygande än en features-matris.

Dokumentation som visar en rekommenderad väg (och förklarar när man bör avvika) minskar tiden som går åt till att gissa.

En lång lista reglage kan kännas kraftfull, men tvingar varje team att bli expert bara för att fatta grundläggande beslut. Vettiga standarder minskar kognitiv belastning:

När default är rätt kan team lägga tiden på produkt i stället för konfiguration.

Verkliga byggare börjar ofta med välbekanta mönster:

De bästa mallarna ser inte bara bra ut—de kodar in beprövad struktur.

Två misstag återkommer ofta:

En bra inlärningskurva puttar team i riktning mot en tydlig startpunkt—och gör avancerade val till medvetna uppgraderingar, inte obligatorisk hemläxa.

Distributionplattformar produktifierade vägen från Git till produktion. En parallell trend dyker upp tidigare i flödet: produktifiera vägen från idé till fungerande kodbas.

Koder.ai är ett exempel på denna “vibe-coding”-riktning: du beskriver vad du vill i en chattgränssnitt och plattformen använder agentbaserade LLM-workflows för att generera och iterera på en riktig applikation. Den är designad för webben, server och mobil (React på frontend, Go + PostgreSQL på backend, Flutter för mobil), med praktiska leveransfunktioner som export av källkod, distribution/hosting, anpassade domäner, snapshots och rollback.

I praktiken parar detta sig naturligt med arbetsflödet i den här artikeln: strama åt loopen från avsikt → implementation → förhandsvisning → produktion, samtidigt som en flyktväg (exporterbar kod) finns om du växer ur standarderna.

Att välja en frontend-plattform är inte bara att välja “var man hostar.” Det är att välja det standardarbetsflöde ditt team ska leva i: hur kod blir en URL, hur ändringar granskas och hur driftstörningar hanteras.

De flesta plattformar ser lika ut på startsidan, men skiljer sig i faktureringen. Jämför enheter som speglar din verkliga användning:

Ett praktiskt tips: uppskatta kostnader för en normalmånad och för en “lanseringsvecka”. Om du inte kan simulera båda blir överraskningen värst i fel ögonblick.

Du behöver inte vara infra-expert, men ställ några direkta frågor:

Om dina kunder är globala kan regionscoverage och cache-beteende spela lika stor roll som rå prestanda.

Sök efter vardagliga skydd, inte vaga löften:

Använd detta som ett snabbt filter innan djupare utvärdering:

Välj plattformen som minskar antalet ”deploy-beslut” ert team måste fatta varje vecka—men som ändå lämnar kontroll när det behövs.

Produktifiering förvandlar “deploy- och renderingsbeslut” från skräddarsydd engineering till upprepbara standarder. Det minskar friktionen på två ställen som ofta bromsar team: få ändringar live och hålla prestanda förutsägbar.

När vägen från commit → preview → produktion standardiseras ökar iterationstakten eftersom färre releaser kräver en specialist (eller en lyckad eftermiddag med felsökning).

Börja med den minsta ytan som ger feedback:

När det fungerar, expandera gradvis:

Vill du fördjupa dig utan att gå vilse—bläddra i mönster och fallstudier på /blog, och sanity-checka kostnader och begränsningar på /pricing.

Om du även experimenterar med snabbare sätt att gå från krav till fungerande baseline (särskilt för små team) kan Koder.ai vara ett användbart komplement: generera en första version via chatt, iterera snabbt med intressenter och behåll samma produktifierade väg till förhandsvisningar, rollback och produktion.

Det betyder att paketera de stökiga delarna av att publicera en frontend—builds, deploys, förhandsvisningar, hantering av SSR/SSG, caching och global leverans—till ett upprepat arbetsflöde med rimliga standardinställningar.

Praktiskt sett minskar det antalet egna skript och den ”tribala kunskap” som krävs för att gå från en commit till en pålitlig produktions-URL.

Därför att distribution blev ett dagligt arbetsflöde, inte ett tillfälligt projekt. Team behövde:

När dessa behov blev vanliga kunde de standardiseras till en produktupplevelse istället för att uppfinnas för varje team.

SSR är inte bara att leverera filer; det är att köra serverkod för att generera HTML, och sedan göra det snabbt och säkert med caching och routing.

Vanliga komplexitetskällor inkluderar runtime-setup (Node/serverless), cache-invalidiering, cold starts, headers/rewrites och att se till att produktionsbeteendet matchar lokal utveckling.

Tänk i termer av när HTML skapas:

Många appar blandar dem: SSG för marknadsföringssidor/dokumentation, SSR för indexerbara dynamiska sidor, och CSR för mycket interaktiva inloggningsområden.

En vanlig React-app blir ofta “React + en hög av beslut” (routing, build-konfiguration, renderingsstrategi, konventioner). Next.js standardiserar vanliga behov:

Det är mest värdefullt när du behöver SEO, flera renderingslägen eller en konsekvent full-appstruktur.

Om du bygger en liten, mestadels statisk sajt, ett enkelt internt verktyg, eller något där SEO och första laddningen inte är viktiga, kan Next.js vara överdriven.

I sådana fall kan en lättviktig statisk setup (eller en enklare SPA) vara billigare att drifta och lättare att förstå.

Förhandsvisningar skapar en delbar URL för varje pull request som ligger nära produktionsbeteendet.

Det förbättrar samarbetet eftersom:

Det minskar också sista-minuten-överraskningar som bara dyker upp i staging.

Inte nödvändigtvis. SSR kan vara långsamt om varje förfrågan triggar dyra operationer (databas, externa API:er).

SSR känns snabb när det kombineras med smart caching:

Hastighetsvinsten kommer ofta från cachingstrategin, inte bara SSR i sig.

Edge kör små kodstycken nära användaren, vilket är användbart för:

Det kan vara överdrivet när din sajt mest består av statiska sidor, trafiken är låg, eller du har strikta krav på var kod får köras (juridik/databoende). Förvänta dig också svårare felsökning: loggar och fel kan vara spridda över regioner.

Integration förenklar saker som routing, förhandsvisningar och caching eftersom hosten förstår vad frameworket genererar. Nackdelen är lock-in som kommer med bekvämligheten.

För att behålla en utgångsväg:

Ett praktiskt test är att deploya samma repo till två leverantörer och jämföra friction.