09 juli 2025·8 min

Hur AI gör idéexperiment billiga, snabba och med låg risk

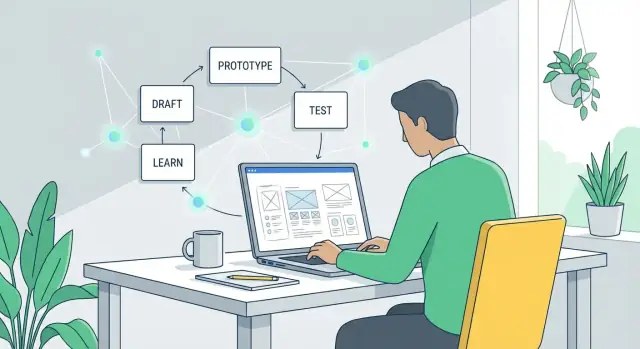

AI-verktyg låter dig testa idéer på timmar istället för veckor — genom att generera utkast, prototyper och analyser så att du lär dig snabbt, spenderar mindre och minskar risken.

Vad “billig och snabb experimentering” egentligen betyder

”Experimentera med idéer” betyder att köra ett litet, lågbindande test innan du satsar stort. Istället för att debattera om ett koncept är bra, gör du en snabb kontroll för att lära dig vad folk faktiskt gör: klickar, registrerar sig, svarar eller ignorerar.

Experimentera med idéer, på enkelt språk

Ett idéexperiment är en mini-version av det verkliga—precis tillräckligt för att besvara en fråga.

Till exempel:

- Om du är osäker på din kommunikation, testa två rubriker och se vilken som ger flest registreringar.

- Om du är osäker på funktionsuppsättningen, visa en enkel demo och fråga användare vad de förväntade sig skulle hända.

- Om du är osäker på om någon vill ha det, kör en “snart kommer”-sida och mät intresset.

Målet är inte att bygga; det är att minska osäkerhet.

Varför experiment brukade vara dyra

Traditionellt krävde även små tester koordinering mellan flera roller och verktyg:

- Tid: skriva copy, designa skärmar, bygga sidor, sätta upp analytics, planera intervjuer.

- Personer: marknadsförare, designers, utvecklare och forskare.

- Överhead: verktyg för landningssidor, enkätverktyg, annonskostnader, prototypmjukvara, plus revisioner och synkronisering.

Den kostnaden driver team mot ”stora satsningar”: bygg först, lär senare.

Hur “billigt och snabbt” ser ut med AI

AI minskar ansträngningen att producera testmaterial—utkast, varianter, manus, sammanfattningar—så att du kan köra fler experiment med mindre friktion.

- Billigt betyder ofta att validera ett antagande utan att involvera flera roller i flera dagar.

- Snabbt betyder att gå från fråga → testmaterial → första signal på timmar, inte veckor.

Sätt förväntningarna: snabbare lärande, inte garanterade vinster

AI gör inte idéer automatiskt bra, och det kan inte ersätta verkligt användarbeteende. Vad det kan göra bra är att hjälpa dig:

- generera alternativ snabbt (meddelanden, flöden, frågor)

- skärpa experimentdesignen (tydlig hypotes, tydlig framgångsmetrik)

- analysera feedback snabbare (teman, invändningar, förvirrande punkter)

Du måste fortfarande välja rätt fråga, samla ärliga signaler och fatta beslut baserade på bevis—inte på hur polerat experimentet ser ut.

Varför traditionell idétestning är långsam och kostsam

Traditionell idétestning misslyckas sällan för att team inte bryr sig. Den misslyckas för att det ”enkla testet” egentligen är en kedja av arbete över flera roller—var och en med verkliga kostnader och kalenderkrav.

Den verkliga kostnadsstacken (även för ett litet experiment)

En grundläggande valideringssprint brukar inkludera:

- Forskning: konkurrenter, kunduttalanden, hypoteser, rekrytering.

- Skrivande: landningssidans copy, värdeförslag, outreach, intervjumanus, enkätfrågor.

- Design: wireframes, kreativa element, layouter, prototyper.

- Kodning: en testsida, analytics-händelser, experimentflaggor, formulär.

- Analys: rensa resultat, syntetisera anteckningar, enas om vad “framgång” betyder.

Även om varje del är “lättviktig”, adderar den kombinerade ansträngningen—särskilt med revisionscykler.

Förseningar multiplicerar kostnad mer än arbete gör

Den största dolda kostnaden är väntan:

- Väntan på överlämningar mellan produkt, design, teknik, marknad och juridik

- Väntan på möten för att enas om vad som ska testas

- Väntan på granskningar, godkännanden och fler redigeringar

Dessa förseningar sträcker ut ett 2-dagars test till en 2–3 veckors cykel. När feedback kommer sent, startar team ofta om eftersom antaganden har skiftat.

Alternativkostnaden: gissa längre

När testning är långsam kompenserar team genom att debattera och fatta beslut baserade på ofullständiga bevis. Du fortsätter bygga, kommunicera eller sälja kring en otestad idé längre än du borde—låser beslut som är svårare (och dyrare) att vrida tillbaka.

Traditionell testning är inte ”för dyrt” i isolation; det är dyrt eftersom det bromsar lärandet.

Hur AI förändrar ekonomin i att pröva idéer

AI gör inte bara team “snabbare.” Det förändrar vad experimentkostnader innebär—särskilt kostnaden att producera en trovärdig första version av något.

Kärnförskjutningen: första versioner blir billiga

Traditionellt är det dyraste i idévalidering att göra något tillräckligt verkligt för att testa: en landningssida, ett säljmail, ett demoskript, en klickbar prototyp, en enkät eller till och med ett tydligt positioneringsuttalande.

AI-verktyg reducerar dramatiskt tiden (och specialistinsatsen) som krävs för att skapa dessa tidiga artefakter. När uppstartskostnaden sjunker kan du ha råd att:

- testa fler idéer innan du satsar

- utforska fler varianter (målgrupper, prisnivåer, budskap)

- involvera intressenter tidigare (eftersom det finns något konkret att reagera på)

Resultatet är fler “skott på mål” utan att anställa fler eller vänta veckor.

Komprimerade cykler: utkast → feedback → revidera

AI komprimerar loopen mellan att tänka och lära:

- Utkast: generera flera alternativ (copy, flöden, funktionsbeskrivningar, FAQ, värdeargument).

- Feedback: dela med användare/prospekter/kollegor, eller kör strukturerade granskningar med en checklista.

- Revidera: iterera omedelbart medan invändningar och frågor är färska.

När denna loop går på timmar istället för veckor spenderar team mindre tid på att försvara halvfärdiga lösningar och mer tid på att reagera på bevis.

Snabbhet är inte samma sak som bättre beslut

Utmatningshastighet kan skapa en falsk känsla av framsteg. AI gör det enkelt att producera plausibla material, men plausibilitet är inte validering.

Beslutskvalitet beror fortfarande på:

- att ställa rätt frågor (vilken risk minskar du?)

- att testa med rätt personer

- att mäta signaler som förutsäger utfall (inte bara “ser bra ut” feedback)

Använt väl minskar AI kostnaden för lärande. Använt vårdslöst minskar det bara kostnaden för att göra fler gissningar snabbare.

Snabba innehållsutkast: testa budskap på minuter

När du validerar en idé behöver du inte perfekt text—du behöver trovärdiga alternativ som du snabbt kan visa för folk. Generativ AI är bra på att producera första utkast som är tillräckligt bra för att testa och sedan förfina baserat på vad du lär dig.

Vad du ska utforma snabbt (och varför det spelar roll)

Du kan snurra upp budskapsmaterial på minuter som normalt tar dagar:

- Rubriker och underrubriker för olika värdeförslag

- Landningssida-text (hero, fördelar, invändningar, call-to-action)

- E-postsekvenser (välkomst, uppföljning, påminnelse)

- FAQ som bemöter invändningar och minskar friction

Målet är hastighet: få flera plausibla versioner live och låt verkligt beteende (klick, svar, registreringar) avgöra vad som resonerar.

Generera flera vinklar utan att börja om

Be AI om tydligt olika angreppssätt för samma erbjudande:

- Fördel-ledd: “Få X resultat utan Y-besvär.”

- Problem-ledd: “Fortfarande bekymrad över X? Här är ett enklare sätt.”

- Berättelse-ledd: en kort berättelse som visar före/efter.

Eftersom varje vinkel är snabb att ta fram kan du tidigt testa budskapsbredd—innan du satsar på design, produkt eller lång copywriting.

Matcha ton mot olika målgrupper

Du kan anpassa samma kärnidé för olika läsare (grundare vs. operations-team) genom att specificera ton och kontext: “självsäker och koncis”, “vänlig och lättförståelig” eller “formell och compliance-medveten.” Det möjliggör riktade experiment utan att skriva om från början.

Tips: behåll ett “en källa till sanning” -meddelande

Hastighet kan skapa inkonsekvens. Ha ett kort meddelandedokument (1–2 stycken): vem det är för, huvudlöftet, viktiga bevispunkter och vad som inte ingår. Använd det som input för varje AI-utkast så variationerna håller sig i linje—och du testar vinklar, inte motstridiga påståenden.

Prototyper utan tungt designarbete

Du behöver inte en hel designspurt för att se om en idé “klickar”. Med AI kan du skapa en trovärdig prototyp som är tillräckligt bra för att få reaktion—utan veckor av mockups, granskningsloopar och pixeldebatter.

Börja med ett prototypkit, inte en tom duk

Ge AI ett kort produktbrief och be om byggstenar:

- En funktionslista (måste-ha vs. trevligt-att-ha)

- Ett enkelt användarflöde (vad händer först, nästa och sist)

- Föreslagna skärmar (hem, onboarding, inställningar, kassa, osv.)

- UI-text för knappar, verktygstips, tomma tillstånd och felmeddelanden

Därifrån kan du omvandla flödet till snabba wireframes med enkla verktyg (Figma, Framer eller till och med slides). AI-genererad text hjälper skärmarna att kännas verkliga, vilket gör feedback mycket mer specifik än “ser bra ut.”

Skapa klickbara prototyper på timmar

När du har skärmarna, länka ihop dem till en klickbar demo och testa kärnhandlingen: registrera sig, söka, boka, betala eller dela.

AI kan också generera realistiskt platshållarinnehåll—exempelvis listor, meddelanden, produktbeskrivningar—så testpersoner inte förvirras av “Lorem ipsum.”

Producera variationer för olika användare

Istället för en prototyp, skapa 2–3 versioner:

- Nya användare: mer vägledning, färre val, tydligare etiketter

- Power users: genvägar, bulkåtgärder, avancerade filter

Det hjälper dig validera om din idé behöver olika vägar, inte bara olika ord.

Snabba tillgänglighets- och tydlighetskontroller

AI kan skanna UI-text för förvirrande jargong, inkonsekventa etiketter, saknade tomma-tillstånds-anvisningar och för långa meningar. Den kan också flagga vanliga tillgänglighetsproblem att granska (kontrast, oklara länktexter, otydliga felmeddelanden) så du fångar undvikbar friction innan du visar något för användare.

Snabba MVP: från koncept till demo snabbt

Skicka en lärande MVP

Skapa en tunn MVP fokuserad på en job-to-be-done, och iterera sedan utifrån feedback.

En snabb MVP är inte en mindre version av slutprodukten—det är en demo som bevisar (eller motbevisar) ett nyckelantagande. Med AI kan du nå den demoversionen på dagar (eller till och med timmar) genom att skippa “perfekt” och fokusera på en sak: visa kärnvärdet tillräckligt tydligt för att någon ska reagera.

Vad AI accelererar

AI är användbart när MVP:n behöver bara tillräcklig struktur för att kännas verklig:

- Enkla manus och pseudo-kod för att omvandla ett koncept till ett klickbart eller fungerande flöde.

- API-exempel för att fejka “integration” (även om den riktiga backend inte finns än).

- Scaffolding för små verktyg som kalkylatorer, estimators, onboarding-wizards, interna dashboards eller en lätt Chrome-extension.

Till exempel, om din idé är “en kontroll för återbetalningsberättigande”, kan MVP:n vara en enda sida med ett par frågor och ett genererat resultat—inga konton, ingen fakturering, inget bortfallshanterande.

# pseudo-code for a quick eligibility checker

answers = collect_form_inputs()

score = rules_engine(answers)

result = generate_explanation(score, answers)

return result

Om du vill gå bortom en klickbar mock och demonstrera något som känns som en riktig app, kan en vibe-coding-plattform som Koder.ai vara ett praktiskt genväg: du beskriver flödet i chatten, genererar en fungerande webapp (ofta React i frontend med en Go + PostgreSQL-backend) och itererar snabbt—med möjlighet att exportera källkoden senare om experimentet går vidare till produkt.

Håll scopet säkert: prototypkvalitet vs produktionskvalitet

AI kan generera fungerande kod snabbt, men den hastigheten kan sudda ut gränsen mellan en prototyp och något du frestas att skicka till kunder. Sätt förväntningar upp-front:

- Prototypkvalitet: bevisar desirability, användbarhet och grundläggande genomförbarhet.

- Produktionskvalitet: hanterar skalning, säkerhet, övervakning, edge-cases, compliance och långsiktigt underhåll.

En bra regel: om demon främst är för lärande kan den ta genvägar—så länge dessa genvägar inte skapar risk.

Hoppa inte över granskning: säkerhet, integritet, tillförlitlighet

Även MVP-demonstrationer behöver en snabb sanity check. Innan du visar användare eller kopplar riktiga data:

- Säkerhet: inga exponerade nycklar, osäkra beroenden eller öppna admin-endpoints.

- Integritet: undvik personuppgifter om det inte är absolut nödvändigt; anonymisera och minimera.

- Tillförlitlighet: hantera uppenbara fel (tomma inputs, API-timeouts) så testet mäter idén—inte en trasig demo.

Görs rätt förvandlar AI “koncept till demo” till en återupprepbar vana: bygg, visa, lär, iterera—utan att överinvestera tidigt.

Billigare användarforskning med bättre förberedelse

Användarforskning blir dyrt när du “improviserar”: oklara mål, svag rekrytering och röriga anteckningar som tar timmar att tolka. AI kan sänka kostnaden genom att hjälpa dig göra förberedelserna bra—innan du ens schemalägger ett samtal.

Skapa solida material på en gång

Börja med att låta AI utforma din intervjuguide, och förfina den sedan med ditt specifika mål (vilket beslut ska denna forskning informera?). Du kan också generera:

- Screeningfrågor för att hitta rätt deltagare (och utesluta fel personer)

- Outreach-meddelanden för e-post, LinkedIn eller inprodukt-promptar

- Ett kort forskningsbrief du kan dela med kollegor så alla vet vad som testas

Det här krymper setup-tiden från dagar till en timme, vilket gör små, frekventa studier mer realistiska.

Mer konsekventa anteckningar och snabbare syntes

Efter intervjuer, klistra in samtalsanteckningar (eller ett transkript) i ditt AI-verktyg och be om en strukturerad sammanfattning: huvudsmärtor, nuvarande alternativ, moments of delight och direkta citat.

Du kan också be det tagga feedback efter tema så varje intervju bearbetas likadant—oavsett vem som höll samtalet.

Be sedan AI föreslå hypoteser baserade på vad det hörde, tydligt märkta som hypoteser (inte fakta). Exempel: “Hypotes: användare churnar för att onboarding inte visar värde i första sessionen.”

Håll forskningen ärlig (undvik ledande frågor)

Be AI granska dina frågor för bias. Byt ut prompts som “Skulle du använda detta snabbare arbetsflöde?” mot neutrala som “Hur gör du detta idag?” och “Vad skulle få dig att byta?”

Om du vill ha en snabb checklista för detta steg, behåll den i ert team-wiki (t.ex. /blog/user-interview-questions).

Snabba experiment: enkäter, A/B-tester och smoke tests

Ta med andra i loopen

Ta med andra i loopen—bjud in kollegor eller vänner till Koder.ai och samarbeta kring snabbare idétester.

Snabba experiment hjälper dig avgöra riktningen för ett beslut utan att binda dig till en fullständig build. AI hjälper dig att ställa upp dem snabbare—särskilt när du behöver flera varianter och konsekventa material.

Enkäter: snabb feedback, bättre frågor

AI är bra på att utforma enkäter, men verklig vinst är att förbättra frågekvaliteten. Be det skapa neutral formulering (inga ledande formuleringar), tydliga svarsalternativ och en logisk flöde.

En enkel prompt som “Omarbeta dessa frågor för att vara opartiska och lägg till svarsalternativ som inte snedvrider resultatet” kan ta bort oavsiktlig påverkan.

Innan du skickar något, definiera vad du ska göra med resultaten: “Om färre än 20% väljer alternativ A, kommer vi inte driva denna positionering vidare.”

A/B-tester: generera varianter utan att bränna tid

För A/B-test kan AI snabbt generera flera varianter—rubriker, hero-sektioner, e-postämnen, prissides-texter och call-to-actions.

Håll disciplin: ändra bara en komponent åt gången så du vet vad som orsakade skillnaden.

Planera framgångsmetrik i förväg: klickfrekvens, registreringar, demo-förfrågningar eller “prissida → checkout”-konvertering. Knyt metrisen till beslutet du behöver fatta.

Smoke tests: validera efterfrågan innan bygg

Ett smoke test är ett lättviktigt “låtsas-det-finns”-experiment: en landningssida, en checkout-knapp eller ett väntelistformulär. AI kan skriva sidans copy, FAQ och alternativa värdeförslag så du kan testa vad som resonerar.

Skydd mot falsk självförtroende

Små prover kan ljuga. AI kan hjälpa dig tolka resultat, men kan inte rätta till svaga data. Behandla tidiga resultat som signaler, inte bevis, och se upp för:

- Små stickprov (lätt att överreagera)

- Partiska trafik-källor (vänner, interna team)

- Metriker som inte motsvarar verklig intent (klick vs. registreringar)

Använd snabba experiment för att snäva in alternativ—bekräfta sedan med ett starkare test.

Snabbare analys och tydligare beslut

Att experimentera snabbt hjälper bara om du kan förvandla röriga inputs till ett beslut du litar på. AI är användbart här eftersom det kan sammanfatta, jämföra och lyfta fram mönster över anteckningar, feedback och resultat—utan timmar i kalkylblad.

Förvandla råa anteckningar till ett beslutsmemo

Efter ett samtal, en enkät eller ett litet test, klistra in grova anteckningar och be AI producera ett en-sidig “beslutsmemo”:

- Vad vi testade (hypotes, målgrupp, kanal)

- Vad som hände (topp-signal, anmärkningsvärda citat, siffror)

- Vad vi tror det betyder (tolkning + förtroende)

- Rekommenderat nästa steg (fortsätt, ändra eller stoppa)

Detta förhindrar att insikter lever i någons huvud eller begravs i ett dokument ingen öppnar igen.

Jämför alternativ med för- och nackdelar samt antaganden

När du har flera riktningar, be AI om en sida-vid-sida-jämförelse:

- Alternativ A vs B: fördelar, nackdelar, risker

- Antaganden som måste vara sanna

- Billigaste experimentet för att testa varje antagande

Du ber inte AI att “välj vinnaren.” Du använder det för att göra resonemang tydligt och lättare att utmana.

Definiera “vad skulle få mig att ändra mig” kriterier

Innan nästa experiment, skriv beslutsregler. Exempel: “Om färre än 5% av besökare klickar ‘Request access’ stoppar vi detta budskap.” AI kan hjälpa formulera kriterier som är mätbara och kopplade till hypotesen.

Håll en lätt experimentlogg

En enkel logg (datum, hypotes, metod, resultat, beslut, länk till memo) förhindrar upprepat arbete och gör lärande kumulativt.

Ha den där ditt team redan kollar (delat dokument, intern wiki eller en mapp med länkar).

Risker och skydd: håll dig korrekt och etisk

Att röra sig snabbt med AI är en superkraft—men kan också förstärka misstag. När du kan generera tio koncept på tio minuter är det lätt att förväxla ”mycket output” med ”goda bevis”.

Var saker går fel

Hallucinationer är den uppenbara risken: en AI kan självsäkert hitta på “fakta”, citat eller marknadssiffror. I snabb experimentering kan uppdiktade detaljer tyst bli grunden för en MVP eller pitch.

En annan fälla är överanpassning till AI-förslag. Om du hela tiden frågar modellen efter “bästa idén” kan du driva mot det som låter trovärdigt i text snarare än vad kunder faktiskt vill ha. Modellen optimerar för sammanhang, inte sanning.

Slutligen gör AI det lätt att omedvetet kopiera konkurrenter. När du promptar med “exempel från marknaden” kan du driva mot nära-kloner av befintlig positionering eller funktioner—riskfyllt för differentiering och potentiellt för IP.

Enkla skydd som håller dig ärlig

Be AI visa osäkerhet:

- “Lista antagandena du gör och bedöm förtroende (låg/medel/hög).”

- “Vad skulle ändra ditt svar? Vilken data behöver du?”

För alla påståenden som påverkar pengar, säkerhet eller rykte, verifiera kritiska punkter. Behandla AI-utdata som ett utkast till forskningsbrief, inte forskningen själv.

Om modellen refererar statistik, kräva spårbara källor (och kontrollera dem): “Ge källor och citat från originalkällan.”

Kontrollera också input för att minska bias: återanvänd en konsekvent promptmall, behåll en versionerad “fakta vi tror på”-dokument och kör små experiment med varierade antaganden så inte en prompt dikterar utfallet.

Integritets- och etikgrunder

Klistra inte in känsliga data (kundinfo, intern omsättning, proprietär kod, juridiska dokument) i oauktoriserade verktyg. Använd redigerade exempel, syntetiska data eller säkra företagsupplägg.

Om du testar budskap, berätta om AI-användning när det är lämpligt och undvik att fabricera vittnesmål eller användarcitat.

Ett praktiskt arbetsflöde för snabb iteration

Gå från prompt till prototyp

Beskriv ditt flöde i chatten och få en React-webbapp du snabbt kan visa för användare.

Hastighet är inte bara “arbeta snabbare”—det är att köra en uppreparebar loop som förhindrar att du polerar fel sak.

Ett enkelt arbetsflöde är:

Hypotes → Bygg → Testa → Lär → Iterera

1) Börja med en tydlig hypotes

Skriv den i en mening:

“Vi tror att [målgrupp] kommer att göra [åtgärd] eftersom [orsak]. Vi vet att vi har rätt om [metrik] når [tröskel].”

AI kan hjälpa dig göra vaga idéer till testbara uttalanden och föreslå mätbara framgångskriterier.

2) Definiera “tillräckligt bra för test”

Innan du skapar något, sätt en minsta kvalitetsnivå:

- Tydligt löfte (en mening)

- En primär call-to-action

- Ett realistiskt användarscenario

- Inga märkesprefekta visuals krävs

Om det möter baren, skicka det till test. Om inte, fixa bara det som hindrar förståelse.

3) Kör tidbegränsade cykler (välj en)

2-timmarscykel: Skriv landningssidetekst + 2 annonsvarianter, lansera en liten spend eller dela med en liten publik, samla klick + svar.

1-dagscykel: Skapa en klickbar prototyp (grovt UI räcker), kör 5 korta användarsamtal, fånga var folk tvekar och vad de förväntar sig härnäst.

1-veckacykel: Bygg en tunn MVP-demo (eller concierge-version), rekrytera 15–30 mål användare, mät aktivering och vilja att fortsätta.

4) Tilldela roller—även om det är en person

- Grundare: väljer hypotesen och beslutet att skicka.

- Marknadsförare: definierar målgrupp, kanaler och framgångsmetrik.

- Designer: säkerställer att flödet är begripligt (inte vackert).

- Analytiker: sätter upp spårning, loggar resultat, sammanfattar lärdomar.

5) Stäng loopen med ett beslut

Efter varje test, skriv ett en- stycke “lärdomsmemo”: vad hände, varför och vad du förändrar härnäst. Bestäm sedan: iterera, pivotera hypotesen eller stoppa.

Att behålla dessa memo i ett dokument gör framsteg synligt—och upprepbart.

Mäta påverkan: lär ni er verkligen snabbare?

Hastighet är bara användbar om den ger tydligare beslut. AI kan hjälpa dig köra fler experiment, men du behöver fortfarande ett enkelt poängkort för att avgöra om ni lär er snabbare—eller bara producerar mer aktivitet.

Kärnmetrik att följa

Börja med ett litet set mått du kan jämföra över experiment:

- Time-to-first-test: dagar (eller timmar) från idé till något verkligt framför användare.

- Kostnad per lärdom: total spend (verktyg, annonser, incitament, tid) delat med antalet beslutsmässiga insikter.

- Konverteringslyft: förbättring jämfört med baseline (t.ex. landningssida sign-up rate från 2,0% → 2,6%).

- Retention-signaler: tidiga indikatorer som återbesök, upprepad användning eller “skulle bli besviken om detta försvann”-svar.

Ledande indikatorer vs. lärandekvalitet

AI gör det lätt att jaga klick och registreringar. Den verkliga frågan är om varje test avslutas med ett klart utfall:

- Bekräftade eller avvisade ni ett specifikt antagande?

- Kan ni uttrycka resultatet i en mening (t.ex. “Pris $19 konverterade 30% bättre än $29 för frilansare”)?

- Vet ni vad ni gör härnäst—bygga, ändra eller stoppa?

Om resultaten är oklara, skärp experimentdesignen: tydligare hypoteser, tydligare framgångskriterier eller en bättre publik.

Stop-regler: bestäm innan du kör testet

Förplikt dig i förväg till vad som händer när data kommer:

- Döda om nyckelmetrik är under en minimal tröskel (t.ex. <1% sign-up efter 500 kvalificerade besök).

- Pivotera om intresse finns men budskap, publik eller användningsfall skiljer sig från antagandet.

- Satsa mer om du når tröskeln och kan förklara varför det fungerade.

Nästa steg

Välj en idé och planera ett första litet test idag: definiera ett antagande, en metrisk, en publik och en stop-regel.

Sikta sedan på att halvera din time-to-first-test vid nästa experiment.

Vanliga frågor

Vad betyder “billig och snabb experimentering” i praktiken?

Det är att köra ett litet, lågbindande test för att besvara en fråga innan du investerar mycket.

Ett bra idéexperiment är:

- Mini: precis tillräckligt för att lära sig

- Fokuserat: en hypotes, en metrisk

- Beteendebaserat: klick, registreringar, svar, uppgiftsgenomförande — inte bara åsikter

Hur väljer jag rätt typ av experiment för min idé?

Börja med den största osäkerheten och välj det lättaste testet som ger ett verkligt signalvärde.

Vanliga alternativ:

- Meddelandesrisk → rubrik- eller landningssidatest (A/B)

- Efterfrågerisk → väntelista eller “snart kommer” smoke test

- Användbarhetsrisk → klickbar prototyp + 5 korta användarsessioner

Vilka delar av experimenteringen gör AI faktiskt billigare och snabbare?

AI är mest användbart för första utkast och varianter som normalt skulle kräva flera roller och mycket fram- och tillbaka.

Det kan snabbt generera:

- Landningssidans text, e-post, annonsvarianter

- Intervjuguider och enkätfrågor

- UI-text för prototyper (tomma tillstånd, felmeddelanden, verktygstips)

- Strukturerade sammanfattningar av anteckningar och feedback

Du behöver fortfarande och för validering.

Hur skriver jag en tydlig hypotes och framgångsmetrik?

Använd en enkel mening och förbind dig till ett mätbart utfall:

“Vi tror att [målgrupp] kommer att göra [åtgärd] eftersom [orsak]. Vi vet att vi har rätt om [metrik] når [tröskel] inom [tid].”

Exempel:

- “Vi tror att driftchefer kommer att begära en demo eftersom verktyget minskar tid för fakturareconciliation. Vi vet om ≥5% av kvalificerade besökare klickar ‘Request demo’ denna vecka.”

Vad är ett smoke test, och hur ska jag köra ett ansvarsfullt?

Ett smoke test är ett “låtsas att det finns”-experiment för att mäta intent innan du bygger.

Typisk uppsättning:

- En landningssida som beskriver erbjudandet

- En tydlig CTA (väntelista, begär åtkomst, förbeställ)

- Spårning för nyckelåtgärden

Håll det ärligt: implicera inte att produkten finns tillgänglig om den inte gör det, och följ upp snabbt med vad som är verkligt.

Hur undviker jag att förväxla en snabb AI-assisterad prototyp med produktionsarbete?

Behandla prototyper som verktyg för lärande, inte färdiga produkter.

Praktiska riktlinjer:

- Märk det tydligt: “prototype” eller “demo”

- Undvik verkliga kunddata; använd syntetiska platshållare

- Spåra bara det som behövs (minimal analytics)

- Gör en snabb kontroll för uppenbara säkerhets-/integritetsproblem (nycklar, öppna endpoints, PII)

Om du frestas att skicka ut det, pausa och definiera vad “produktionskvalitet” kräver (övervakning, edge-cases, efterlevnad, underhåll).

Hur kan AI minska kostnaden för användarforskning utan att göra den slarvig?

Förberedelse är där AI sparar mest tid—utan att sänka forskningskvaliteten.

Använd AI för att:

- Skapa ett screeningsformulär (inklusion/exklusion)

- Ta fram en neutral intervjuguide (ta bort ledande frågor)

- Skriva outreach-meddelanden för e-post/LinkedIn

- Förvandla transkript/anteckningar till konsekventa sammanfattningar (smärtpunkter, alternativ, citat)

Om du vill ha en checklista för neutral formulering, behåll en gemensam referens (t.ex. /blog/user-interview-questions).

Räcker enkäter och A/B-tester för att validera en idé?

De är användbara, men lätta att misstolka om ditt experiment är dåligt utformat.

För att göra snabba tester mer tillförlitliga:

- Ändra en variabel åt gången (t.ex. rubrik, inte rubrik + pris)

- Använd en metrisk kopplad till intent (registrering > klick)

- Se upp för partiskt trafik (vänner, interna team)

- Behandla tidiga resultat som signal, inte bevis

När du ser lovande tecken, följ upp med ett starkare verifieringstest.

Vilka är huvudriskerna med att använda AI för experiment, och hur mildrar jag dem?

Använd AI som en utkastassistans, inte som en källa till sanning.

Bra skydd:

- Acceptera inte statistik eller “fakta” utan spårbara källor

- Be om antaganden och konfidensnivåer (låg/medel/hög)

- Fabricera aldrig vittnesmål eller användarcitat

- Klistra inte in känsliga data i oauktoriserade verktyg; redigera eller använd syntetisk data

Om påståendet påverkar pengar, säkerhet eller rykte, verifiera det oberoende.

Hur spårar jag lärdomar och vet om vi faktiskt lär oss snabbare?

Snabbhet spelar bara roll om den leder till ett beslut.

Två lätta vanor:

- Beslutsmemo efter varje test: vad vi testade, vad som hände, vad det betyder, nästa steg

- Experimentlogg: datum, hypotes, metod, resultat, beslut, länk till memot

För att mäta om ni förbättras, följ: