Vad “kostnad, tid och friktion” betyder i mjukvaruarbete

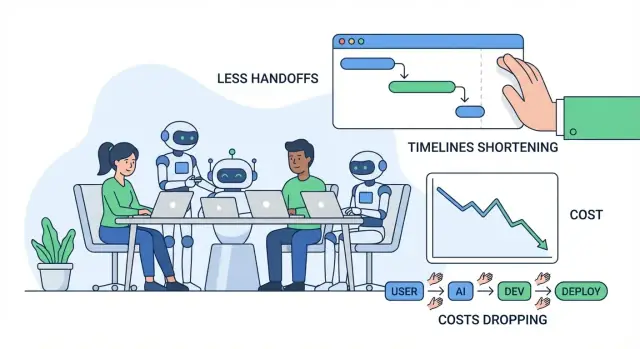

När folk pratar om att förbättra mjukvaruleverans menar de vanligtvis tre saker: kostnad, tid och friktion. De hör ihop men är inte samma sak — och det hjälper att definiera dem enkelt innan vi pratar om AI.

Kostnad: vad du betalar för resultat

Kostnad är den totala utgiften för att leverera och underhålla en funktion: löner och konsulthonorar, molnkostnader, verktyg, och de "dolda" kostnaderna för möten, samordning och att rätta fel. En funktion som tar två extra veckor kostar inte bara mer ingenjörstid — den kan också fördröja intäkter, öka supportbördan eller tvinga er att behålla äldre system längre.

Tid: hur lång tid det tar från idé till levererat värde

Tid är kalenderperioden från "vi borde bygga detta" till "kunder kan använda det pålitligt." Det inkluderar utveckling, men också beslut, godkännanden, väntan på granskningar, väntan på miljöer, väntan på QA-resultat och väntan på någon med rätt kontext för att svara på en fråga.

Friktion: ansträngningen som går förlorad till drag, förvirring och avbrott

Friktion är vardagligt motstånd som gör att arbetet känns långsammare än det borde: otydliga krav, fram-och-tillbaka-clarifieringar, kontextväxling, duplicerat arbete eller långa överlämningar mellan roller eller team.

Det mesta av slöseriet i mjukvaruprojekt visar sig som överlämningar, omarbete och väntan. Ett litet missförstånd tidigt kan bli redesign, buggrensning eller upprepade möten senare. En långsam granskningskö eller saknad dokumentation kan stoppa framsteg även när alla är "upptagna."

Vad “AI-verktyg” betyder (och inte betyder)

I den här artikeln inkluderar AI-verktyg kodnings-copiloter, chattassistenter för research och förklaringar, automatisk analys för krav och tickets, testgenererare och workflow-automation i QA/DevOps.

AI kan minska arbete och snabba upp cykler — men det tar inte bort ansvar. Team behöver fortfarande tydligt ägarskap, gott omdöme, säkerhetskontroller och mänsklig godkännande innan något skickas ut.

Var mjukvaruprojekt vanligtvis förlorar tid och pengar

De flesta budgetöverskridanden kommer inte från "svår kodning." De kommer från vardagliga flaskhalsar som förstärks: otydliga krav, ständig kontextväxling, långsamma granskningsloopar och manuell testning som sker för sent.

Vanliga flaskhalsar (och varför de är dyra)

Otydliga krav skapar störst kostnad längre fram. Ett litet missförstånd tidigt kan bli en veckas omarbete senare — särskilt när olika personer tolkar samma funktion olika.

Kontextväxling är den tysta produktivitetsmördaren. Ingenjörer hoppar mellan tickets, chattfrågor, möten och produktionsproblem. Varje byte har en restartkostnad: ladda om kodbasen, beslutshistoriken och "varför."

Långsamma granskningar fördröjer inte bara merges — de fördröjer lärande. Om feedback kommer dagar senare har författaren redan gått vidare, och fixen tar längre tid.

Manuell testning och sen QA betyder ofta att problem upptäcks när de är som dyrast att åtgärda: efter att flera funktioner lagts till eller precis innan release.

De dolda kostnaderna folk inte budgeterar för

De uppenbara kostnaderna är löner och leverantörsavgifter. De dolda brukar slå hårdare:

- Omarbete: skriva om kod och redesigna flöden för att krav ändrats eller missförståtts.

- Förseningar: väntan på beslut, godkännanden, testmiljöer eller "en nyckelperson" som måste svara.

- Samordningskostnad: synk mellan produkt, design, engineering, QA, säkerhet och intressenter.

En enkel idé → release-workflow (med smärtpunkter)

Idé → krav → design → bygg → granskning → test → release → övervaka

Typiska smärtpunkter: krav (tvetydighet), bygg (avbrott), granskning (kötid), test (manuell insats), release (överlämningar), övervakning (långsam felsökning).

Snabbdiagnos: friktionskarta

Testa en "friktionskarta" i en 30-minuterssession: lista varje steg, markera (1) var arbete väntar, (2) var beslut stannar av, och (3) var omarbete händer. De markerade områdena är där AI-verktyg ofta skapar snabbast besparingar — genom att minska missförstånd, snabba upp feedback och ta bort repetitivt manuellt arbete.

AI-assisterad discovery och krav: färre missförstånd

Discovery är där många projekt tyst driver fel: anteckningar ligger utspridda, feedback motsäger varandra och beslut bor i människors huvuden. AI kan inte ersätta att prata med användare, men det kan minska "översättningsförlusten" mellan samtal, dokument och vad ingenjörer faktiskt bygger.

Team samlar ofta en hög med forskningsanteckningar — intervjutranskript, supporttickets, säljklipp och enkätsvar — och har svårt att snabbt hitta mönster. AI-verktyg kan snabba upp detta genom att:

- Sammanfatta långa forskningsanteckningar till konsekventa slutsatser (smärtpunkter, mål, invändningar)

- Klustra feedback i teman (t.ex. onboardingförvirring vs saknade integrationer)

- Skriva initiala user stories och jobs-to-be-done-utkast från råa inputs

Detta skapar inte sanning automatiskt, men ger en tydlig startpunkt som är lättare att kritisera, förfina och enas om.

Definiera scope och acceptanskriterier tidigare

Missförstånd visar sig ofta senare som "det här var inte vad jag menade"-omarbete. AI hjälper genom att snabbt producera första utkast till:

- Scope-gränser (vad som ingår vs inte för den här releasen)

- Kantfall och "vad händer om..."-scenarier baserat på liknande mönster

- Acceptanskriterier som är specifika nog att testa

Till exempel: om ett krav säger "användare kan exportera rapporter" kan AI få teamet att förtydliga: format (CSV/PDF), behörigheter, datumintervall, tidszonsbeteende och om export skickas på e-post eller laddas ner. Att få dessa svar tidigt minskar churn under utveckling och QA.

Konsekvent dokumentation som faktiskt används

När krav lever i docs, chattrådar och tickets betalar team en ständig "kontextväxlingsskatt." AI kan hjälpa hålla en enda, läsbar berättelse genom att skriva och underhålla:

- Mötesanteckningar med beslut och öppna frågor

- Kravsidor och ticketbeskrivningar i en konsekvent mall

- Glossar för domäntermer (så att "account", "workspace" och "org" inte blandas ihop)

Vinsten är färre avbrott ("vad bestämde vi?") och smidigare överlämningar mellan produkt, design, engineering och QA.

Styrning: validera antaganden, outsourca dem inte

AI-utdata bör behandlas som hypoteser, inte krav. Använd enkla styrregler:

- Granska alltid sammanfattningar mot originalkällor (särskilt citat och siffror)

- Markera osäkra punkter som frågor och bekräfta med användare och intressenter

- Behåll beslutets ägarskap hos teamet: AI utkastar, människor godkänner

Använt så här minskar AI-assisterad discovery missförstånd utan att urholka ansvar — vilket minskar kostnad, tid och friktion innan en enda kodrad skrivits.

Snabbare prototyper och designiterationer med AI

Prototyping är där många team antingen sparar veckor — eller bränner dem. AI gör det billigare att utforska idéer snabbt, så ni kan validera vad användare faktiskt vill ha innan ni satsar engineering-tid på en fullständig implementation.

Snabba "första utkast" för skärmar och flöden

Istället för att börja från ett tomt papper kan du använda AI för att generera:

- UI-texter för knappar, felmeddelanden, onboardingsteg och tomma tillstånd (med tonval som "vänlig" vs "formell")

- Wireframe-idéer uttryckta som enkla skärmbeskrivningar (vad finns på sidan, vad är primärt vs sekundärt)

- Exempel på användarresor: "ny användare registrerar sig → importerar data → sätter ett mål → får en påminnelse"

Dessa utkast är inte slutgiltig design, men ger teamet något konkret att reagera på. Det minskar fram‑och‑tillbaka som "jag trodde du menade X" eller "vi är fortfarande inte överens om flödet."

Snabba demoappar och proof-of-concepts

För många produktbeslut behöver du inte produktionskvalitetskod för att lära dig. AI kan hjälpa sätta ihop en grundläggande demoapp eller POC som visar:

- Den kärninteraktion som användaren gör (vad klickas, vad visas därefter)

- Exempeldata och realistiska kantfall

- En enkel "happy path" som räcker för intern granskning eller användartester

Om du vill gå längre än statiska mockups kan plattformar som Koder.ai vara användbara för snabba iterationer: du beskriver funktionen i en chatt, genererar ett fungerande webb- eller mobilapputkast (vanligtvis React på webben och Flutter på mobilen), och förfinar det sedan med intressenter innan du går vidare till full engineering.

Varifrån tidsbesparingarna kommer

De största besparingarna ligger ofta inte i "designtiden". De kommer från att undvika att bygga fel sak fullt ut. När en prototyp avslöjar förvirring, saknade steg eller otydligt värde kan ni ändra riktning medan förändringar fortfarande är billiga.

En viktig varning: skicka inte prototypkod av misstag

AI-genererade prototyper hoppar ofta över viktig efterbearbetning: säkerhetskontroller, tillgänglighet, prestanda, korrekt felhantering och hållbar struktur. Behandla prototypkod som förbrukningsvara om ni inte uttryckligen hårdnar den — annars riskerar ni att en snabb experimentkod blir långsiktigt underhållsarbete.

Om ni konverterar prototyper till verkliga funktioner, leta efter arbetsflöden som gör övergången tydlig (t.ex. planeringsläge, snapshots och rollback). Det hjälper team hålla farten utan att tappa spårbarhet.

Snabbare kodning med AI-assistenter (och var de hjälper mest)

Kom till en live-miljö

Distribuera och hosta din app när du är redo att dela den för verklig feedback.

AI-kodassistenter är mest värdefulla i de osexiga delarna av utveckling: att ta sig från "inget" till en fungerande startpunkt, och att rensa bort repetitivt arbete som bromsar team. De ersätter inte ingenjörsbedömning — men de kan krympa tiden mellan idé och en granskbar pull request.

Hur de minskar "tomt papper"-tiden

När du startar en ny endpoint, jobb eller UI-flöde går ofta första timmen åt till wiring, namngivning och att kopiera mönster från äldre kod. Assistenter kan snabbt skissa den initiala strukturen: mappar, grundläggande funktioner, felhantering, loggning och platshållartester. Då lägger ingenjörer mer tid på produktlogik och kantfall, och mindre på boilerplate.

För team som vill gå utöver "assist i editorn" paketerar plattformar som Koder.ai detta i ett fullständigt arbetsflöde: från en specifikation i chatten till en körbar app med backenddelar (ofta Go + PostgreSQL), plus alternativ som export av källkod och deployment/hosting. Den praktiska vinsten är att minska koordineringskostnaden för att "komma till något ni kan granska."

Uppgifter där de passar bäst

De presterar bäst på avgränsat, mönsterbaserat arbete, särskilt när kodbasen redan har tydliga konventioner:

- Scaffolding: nya routes/controllers, CRUD-skärmar, CLI-kommandon, background jobs, SDK-wrappar.

- Refaktorer: byta namn och omorganisera moduler, extrahera funktioner, konsekvent felhantering, uppdatera deprecated API:er.

- Översättningar: portning av små komponenter mellan språk/ramverk (t.ex. Python till TypeScript) med tester för att bekräfta beteende.

- Små funktioner: välavgränsade tillägg som en filterfunktion, export, webhook-handler eller valideringsregel.

- Interna verktyg: admin-sidor, skript, datafixar, rapportgeneratorer — hög nytta, låg UX-polish.

Promptmönster som ger användbar kod

Bra prompts liknar mer en mini-spec än "skriv funktion X". Inkludera:

- Kontext: vad modulen gör, var den ligger och omgivande API:er.

- Begränsningar: bibliotek, stilregler, prestandakrav, säkerhetskrav.

- Exempel: befintliga liknande filer eller ett in-/ut-exempel.

- Acceptanstester: kantfall och "klart betyder..."-kontroller (även i vanlig engelska).

Add a /v1/invoices/export endpoint.

Context: Node/Express, uses InvoiceService.list(), auth middleware already exists.

Constraints: stream CSV, max 50k rows, no PII fields, follow existing error format.

Example: match style of routes/v1/customers/export.ts.

Acceptance: returns 401 if unauthenticated; CSV has headers A,B,C; handles empty results.

Granskning är obligatoriskt

AI-genererad kod behöver fortfarande samma standarder: kodgranskning, säkerhetsgranskning och tester. Utvecklare ansvarar fortsatt för korrekthet, datahantering och efterlevnad — behandla assistenten som ett snabbt utkast, inte en auktoritet.

Minska granskningscykler och omarbete med AI

Kodgranskning är där mycket av den "dolda kostnaden" ackumuleras: väntan på feedback, upprepade förklaringar av avsikten och åtgärdande av samma typer av problem om och om igen. AI kan inte ersätta granskarens omdöme, men det kan minska tiden som läggs på mekaniska kontroller och missförstånd.

Hur AI hjälper i kodgranskning

Ett bra AI-arbetsflöde hjälper granskare innan de ens öppnar PR:n:

- Sammanfatta ändringar: Generera en kort, begriplig summering av vad PR:n gör, vilka filer som ändrats och avsedd funktionalitet. Det hjälper granskare att fokusera snabbare och minskar kommentaren "vad tittar jag på?".

- Flagga riskfaktorer: Peka ut vanliga bugkällor — saknade null-kontroller, osäker strängparsing, tidbaserad logik som kan flakka, ohandterade fel eller misstänkta rättighetsändringar.

- Föreslå tester: Ge konkreta testfall baserat på diffen ("lägg till test för ogiltig input", "assert access control för roll X", "täck nytt kantfall i paginering").

Färre fram-och‑tillbaka‑loopar

AI kan också öka tydlighet och konsekvens, vilket ofta driver pingpong i granskningar:

- Formulera bättre PR-beskrivningar (motivering, tillvägagångssätt, trade-offs).

- Driva namn- och formatteringskonsekvens för att undvika subjektiva debatter.

- Föreslå små refaktorer som gör koden lättare att läsa, så att granskare inte begär stora omskrivningar senare.

Praktiska regler som håller det säkert

Använd AI för att snabba upp granskning utan att sänka standarden:

- Mänskligt godkännande är obligatoriskt för varje PR.

- Anpassa AI-förslag till er stilguide och lint-regler.

- Håll PR:er små och fokuserade så både människor och AI kan resonera om dem.

Där AI fortfarande har svårt

AI är svagast på domänlogik och arkitektur: affärsregler, kantfall knutna till verkliga användare och systemomfattande avvägningar kräver fortfarande erfarna bedömningar. Behandla AI som granskarens assistent — inte som granskaren.

AI i testning och QA: fånga problem tidigare med mindre manuellt arbete

Prova en låg-risk pilot

Kör ett litet AI-workflow-pilotprojekt med gratisnivån och mät cykeltid.

Testning är där små missförstånd blir dyra överraskningar. AI kan inte garantera kvalitet, men den kan ta bort mycket repetitivt arbete — så människor kan lägga mer tid på svåra fall som faktiskt bryter produkter.

Automatisk testgenerering: börja från verkliga kodvägar

AI-verktyg kan föreslå enhetstester genom att läsa befintlig kod och identifiera vanliga exekveringsvägar ("happy path"), plus grenar som lätt glöms bort (felhantering, null/empty-input, retries, timeouts). När du dessutom ger en kort specifikation eller acceptanskriterier kan AI föreslå kantfall direkt från kraven — till exempel gränsvärden, ogiltiga format, behörighetskontroller och "vad händer om upstream-tjänsten är nere?".

Bäst användning är acceleration: få ett första utkast till tester snabbt, sedan justerar ingenjörer assertioner för att spegla verkliga affärsregler.

Snabbare testdata, mocks och fixtures

En överraskande tidsförlust i QA är att skapa realistisk testdata och koppla mocks. AI kan hjälpa genom att:

- Generera representativa exempelposter (inklusive "konstiga" fall) som matchar valideringsregler

- Skriva mocks/stubs för externa tjänster med förutsägbara svar

- Skapa återanvändbara fixtures som gör tester kortare och lättare att läsa

Detta snabbar upp både utvecklarens enhetstester och integrationstester, särskilt när många API:er är inblandade.

Bättre felrapporter: tydligare, snabbare åtgärder

När problem når QA eller produktion kan AI förbättra felrapporter genom att göra röriga anteckningar till strukturerade reproduktionssteg och tydligt skilja förväntat från faktiskt beteende. Med loggar eller konsolutdata kan AI sammanfatta mönster (vad som gick fel först, vad upprepades, vad korrelerar med felet) så ingenjörer slipper spendera den första timmen bara på att förstå rapporten.

Kvalitetskontroller (icke-förhandlingsbara)

AI-genererade tester måste fortfarande vara:

- Meningsfulla: assertioner kopplade till verkliga krav, inte bara "det kör utan krascher"

- Deterministiska: inga flakiga tidsberoenden, slumpfrön eller ostabila externa beroenden

- Underhållna: behandlade som produktionskod — granskade, välnamnade och uppdaterade när beteendet ändras

Använt så här minskar AI manuellt arbete samtidigt som team fångar problem tidigare — när åtgärder är billigast.

Release och drift: mindre väntan, snabbare felsökning

Releasearbete är där "små förseningar" ansamlas: en flakig pipeline, ett otydligt fel, en saknad konfigurationsvärde eller en långsam överlämning mellan dev och ops. AI-verktyg hjälper genom att krympa tiden mellan "något gick sönder" och "vi vet vad vi ska göra härnäst."

AI för CI/CD och DevOps

Moderna CI/CD-system levererar många signaler (buildlogs, testoutput, deploy-händelser). AI kan sammanfatta det brusiga till en kort, handlingsbar vy: vad som misslyckades, var det först dök upp och vad som ändrats nyligen.

Det kan också föreslå troliga åtgärder i kontext — som att peka ut versionskrock i en Docker-image, ett felaktigt ordnat steg i ett workflow eller en saknad miljövariabel — utan att du manuellt skummar hundratals rader.

Om ni använder en end-to-end-plattform som Koder.ai för att bygga och hosta kan operationella funktioner som snapshots och rollback också minska release-risk: team kan experimentera, distribuera och ångra snabbt när verkligheten avviker från planen.

Incidentstöd: snabbare hypoteser och checklistor

Under incidenter spelar de första 15–30 minuterna störst roll. AI kan:

- Skissa root-cause-hypoteser baserat på loggar, alerts och senaste deploys

- Generera en remediation-checklista (rollback, feature-flagga av, skala upp, rensa kö, validera DB-anslutningar)

- Föreslå riktade kommandon och frågor för att bekräfta eller utesluta varje hypotes

Detta minskar on-call‑bördan genom att snabba upp triage — inte genom att ersätta de människor som äger tjänsten. Ägarskap, omdöme och ansvar stannar hos teamet.

Säkerhetsnoteringar (hoppa inte över dessa)

AI är bara användbart om det används säkert:

- Klistra inte in hemligheter (API-nycklar, tokens, kunddata) i prompts — använd redigering och minst privilegier.

- Behandla AI-output som förslag, inte ändringar. Kodgranskning, godkännanden och ändringshantering gäller fortfarande.

- Föredra verktyg som kan arbeta mot sanerade loggar och använder audit-spår för efterlevnad.

Dokumentation och kunskapsdelning: färre avbrott och överlämningar

Behåll ägandeskapet över koden

Exportera källkoden så ditt team behåller full kontroll när projektet växer.

Bra dokumentation är ett av de billigaste sätten att minska engineering-friktion — ändå är det ofta det första som faller bort när tidsplaner blir tajta. AI-verktyg hjälper genom att göra dokumentation till en lätt, återupprepbar del av vardagsarbetet.

Vad AI kan snabba upp (utan att ersätta ägarskap)

Team ser ofta snabba vinster i dokumentation som följer tydliga mönster:

- API-docs: generera endpointbeskrivningar, request/response-exempel och feltabeller från specs eller kodkommentarer.

- Runbooks: skissa steg-för-steg-incidentplaybooks ("Om X-alert triggas, kolla Y, gör sedan Z") från tidigare tickets och postmortems.

- Changelogs och releasenoter: sammanfatta mergade PR:er till kundvänliga och interna versioner.

- Onboarding-guider: skapa "första veckan"-checklistor, serviceöversikter och glossar från repo-struktur och befintliga docs.

Nyckeln är att AI levererar ett starkt första utkast; människor bekräftar vad som är sant, vad som är säkert att dela och vad som är viktigt.

Färre avbrott, färre flaskhalsar

När docs är sökbara och aktuella behöver teamet inte svara upprepade frågor som "Var ligger config?" eller "Hur kör jag detta lokalt?" Det minskar kontextväxling, skyddar fokus och hindrar kunskap från att sitta hos en ensam "go-to"-person.

Väl underhållen dokumentation minskar också överlämningar: nya medarbetare, QA, support och icke-tekniska intressenter kan hitta svar själva istället för att vänta på en ingenjör.

Ett praktiskt arbetsmönster som håller

Ett enkelt mönster funkar för många team:

- Generera doc-uppdateringar från PR:er (sammanfattning + vad ändrats + hur man testar)

- Mänsklig redigering och verifiering (korrekthet, säkerhet, målgrupp)

- Versionera docs i repo tillsammans med koden, så ändringar granskas och släpps ihop

Tillgänglighet för icke-tekniska läsare

AI kan skriva om täta anteckningar till tydligare språk, lägga till konsekventa rubriker och standardisera struktur över sidor. Det gör dokumentationen användbar bortom engineering — utan att kräva att ingenjörer blir professionella skribenter.

Mäta ROI: hur kvantifiera besparingar utan gissningar

ROI blir luddigt om du bara frågar "levererade vi snabbare?" Ett renare angreppssätt är att prissätta de specifika kostdrivarna AI rör vid, och jämföra en baseline med en "med-AI"-körning för samma arbetsflöde.

Kartlägg dina verkliga kostdrivare

Börja med att lista de poster som faktiskt rör på sig för ditt team:

- Ingenjörstimmar: bygg, granskning, test, fix, omarbete.

- Molnkostnader: miljöer som står på, långsamma pipelines, upprepade testruns.

- Verktygsabonnemang: AI-platser, testverktyg, övervakning, designverktyg.

- Supportbörda: incidenthantering, bug-triage, kundtickets.

- Förseningskostnad: förlorade intäkter, avtalsstraff, förlorade möjligheter.

En enkel baseline vs med-AI-uppskattning

Välj en funktion eller sprint och bryt ner tiden i faser. Mät sedan två siffror per fas: genomsnittliga timmar utan AI vs med AI, plus ny verktygskostnad.

En lätt formel:

\nSavings = (Hours_saved × Blended_hourly_rate) + Cloud_savings + Support_savings − Tool_cost\nROI % = Savings / Tool_cost × 100\n

Du behöver inte perfekt spårning — använd tidsloggar, PR-cyceltid, antal granskningsrundor, testflakfrekvens och ledtid till deploy som proxyer.

Glöm inte "riskkostnad"

AI kan också introducera kostnader om det inte hanteras: säkerhetsexponering, licens/IP-frågor, efterlevnadsgap eller sämre kodkvalitet. Prissätt dessa som förväntad kostnad:

- Riskkostnad = Sannolikhet × Påverkan (t.ex. omarbete efter en säkerhetsfunn, tid för audit-åtgärder).

Börja smått, skala sedan

Starta med ett arbetsflöde (t.ex. testgenerering eller kravförtydligande). Kör det 2–4 veckor, logga före/efter-mått, och expandera först när du ser upprepbara vinster. Det förvandlar AI-adoption till en mätbar förbättringscykel, inte ett trobaserat köp.

Risker och styrregler: säkerhet, kvalitet och efterlevnad

AI kan ta bort mycket monotont arbete, men det introducerar också nya felsätt. Behandla AI-output som en kraftfull autocomplete: användbar för hastighet, inte en källa till sanning.

Viktiga risker att planera för

För det första, felaktiga eller ofullständiga output. Modeller kan låta rätt men missa kantfall, hitta på API:er eller producera kod som klarar glada-path-tester men fallerar i produktion.

För det andra, säkerhetsläckor. Att klistra in hemligheter, kunddata, incidentloggar eller proprietär kod i icke-godkända verktyg kan skapa oavsiktlig exponering. Det finns också risk att AI föreslår osäkra kodmönster (svag auth, osäker deserialisering, injektionskänsliga queries).

För det tredje, licens/IP-frågor. Genererad kod kan likna upphovsrättsskyddade utdrag eller introducera beroenden med inkompatibla licenser om utvecklare kopierar blint.

För det fjärde, partiskhet eller inkonsekventa beslut. AI kan påverka prioritering, formulering eller utvärdering på sätt som oavsiktligt exkluderar användare eller bryter interna policys.

Praktiska skydd som håller farten

Använd mänsklig granskning som regel, inte förslag: kräva kodgranskning för AI-genererade ändringar och be granskare kontrollera säkerhet, felhantering och tester — inte bara stil.

Lägg till lättviktig policy och åtkomstkontroll: godkända verktyg, SSO, rollbaserade rättigheter och tydliga regler för vilken data som får delas.

Behåll audit‑spår: logga prompts och output i godkända miljöer när det går, och dokumentera när AI användes för krav, kod eller testgenerering.

Grundläggande datahantering

Undvik att skicka känslig data (PII, credentials, produktionsloggar, kundkontrakt) till generella AI-verktyg. Föredra godkända miljöer, redigering och syntetiska exempel.

Slutsatsen

AI-output är förslag, inte garantier. Med styrregler — granskning, policy, åtkomstkontroll och spårbarhet — kan ni behålla hastighet utan att ge upp säkerhet, kvalitet eller efterlevnad.

En praktisk adoption-roadmap för team i alla storlekar

Att ta i bruk AI-verktyg funkar bäst om ni behandlar det som en vanlig processförändring: börja smått, standardisera det som fungerar och expandera med tydliga styrregler. Målet är inte "använd AI överallt" — utan att ta bort onödigt fram-och-tillbaka, omarbete och väntan.

Fas 1: Pilot (1–2 veckor)

Välj ett team och ett arbetsflöde där misstag är låg-risk men tidsbesparingarna syns (t.ex. skriva user stories, generera testfall, refaktorisera en liten modul). Håll scope snävt och jämför mot er normala baseline.

Fas 2: Standarder (lättviktiga, inte byråkratiska)

Skriv ner vad "bra AI-användning" ser ut som för ert team.

- Prompt-mallar: korta, återanvändbara prompts för vanliga uppgifter (kravs‑förtydliganden, kodgranskningsanteckningar, testplanutkast).

- Granskningschecklista: vad människor måste verifiera (korrekthet, säkerhet, kantfall, alignment med krav).

- Gör/Inte gör-lista:\n - Gör: ge kontext, begränsningar, acceptanskriterier och exempel.\n - Gör inte: klistra in hemligheter, produktionsuppgifter eller proprietär data ni inte får dela.

Fas 3: Träning (2–4 korta sessioner)

Lär folk att ställa bättre frågor och validera output. Fokusera på praktiska scenarion: "förvandla ett vagt krav till testbara acceptanskriterier" eller "generera en migreringsplan och kontrollera risker."

Fas 4: Automatisering (där repetition skadar)

När teamet litar på arbetsflödet, automatisera de repetitiva delarna: PR-beskrivningsutkast, testscaffolding, releasenoter och ticket-triage. Ha kvar ett mänskligt godkännande för allt som skickas ut.

Om ni utvärderar plattformar, överväg om de stödjer säkra iterationsfunktioner (t.ex. planeringsläge, snapshots, rollback) och praktiska adoptionsvägar (som export av källkod). Detta är ett område där Koder.ai är designat att passa in i befintliga engineering‑förväntningar: rör på snabbhet, men behåll kontroll.

Fas 5: Kontinuerlig förbättring

Gå igenom mallar och regler månatligen. Fasa ut prompts som inte hjälper och utöka standarder bara när ni ser återkommande felmönster.

Metriker att följa (så ROI inte är gissningar)

Följ några indikatorer konsekvent:\n\n- Cycletid (idé → deploy)\n- Granskningstid (PR öppen → mergad)\n- Defektrate (buggar i produktion + buggar i QA)\n- Omarbets-% (öppnade tickets igen, churn, upprepade ändringar)\n- Teamnöjdhet (kort pulsenkät)

Använd den här checklistan på nästa projekt

Om ni publicerar lärdomar från piloten kan det också vara värt att formalisera det som intern vägledning eller en offentlig rapport — många team finner att dokumenterade "före/efter"-mått är vad som gör AI-adoption till en upprepbar praktik. (Vissa plattformar, inklusive Koder.ai, kör program där team kan tjäna krediter för att dela praktiskt innehåll eller rekommendera andra användare, vilket kan kompensera verktygskostnader under tidiga tester.)