25 juli 2025·8 min

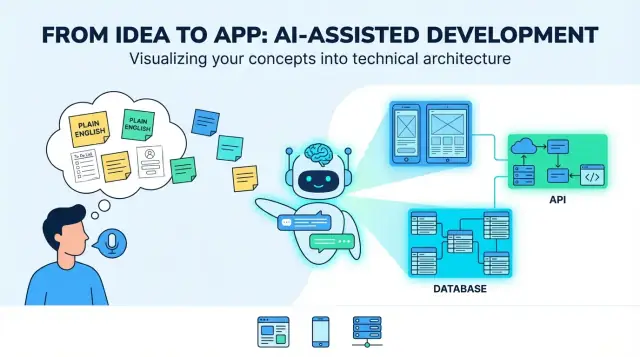

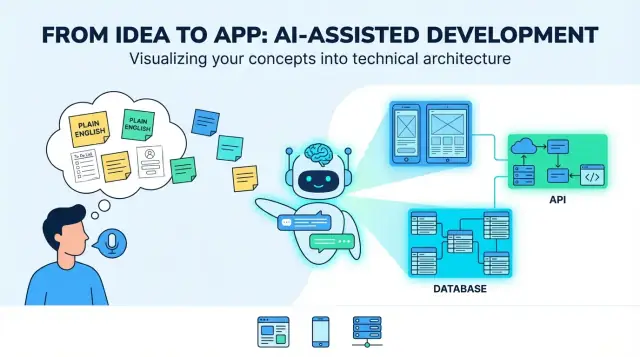

Hur LLM:er förvandlar idéer på vardaglig engelska till fullstack-appar

Hur LLM:er omvandlar enkla produktidéer på engelska till webb-, mobil- och backend-appar: krav, UI-flöden, datamodeller, API:er, tester och driftsättning.

Hur LLM:er omvandlar enkla produktidéer på engelska till webb-, mobil- och backend-appar: krav, UI-flöden, datamodeller, API:er, tester och driftsättning.

En “idé på vardaglig engelska” börjar oftast som en blandning av avsikt och hopp: vem den är för, vilket problem den löser och hur framgång ser ut. Det kan vara några meningar (“en app för att boka hundrastare”), ett grovt arbetsflöde (“kund förfrågar → rastare accepterar → betalning”), och ett par måsten (“push-notiser, betyg”). Det är tillräckligt för att prata om en idé — men inte tillräckligt för att bygga konsekvent.

När folk säger att en LLM kan “översätta” en idé till en app, är den användbara betydelsen denna: att omvandla diffusa mål till konkreta, testbara beslut. “Översättningen” är inte bara omskrivning — det är att lägga till struktur så att du kan granska, ifrågasätta och implementera.

LLM:er är bra på att producera ett första utkast av kärnbyggelementen:

Det typiska “slutresultatet” ser ut som en blueprint för en fullstack-produkt: en webb-UI (ofta för admin eller desktop-tunga uppgifter), en mobil-UI (för användare i farten), backend-tjänster (auth, affärslogik, notiser) och datalagring (databas plus fil/media-lagring).

LLM:er kan inte pålitligt välja produktens avvägningar, för de rätta svaren beror på kontext du kanske inte skrivit ner:

Behandla modellen som ett system som föreslår alternativ och standardval, inte slutgiltig sanning.

De största felmoderna är förutsägbara:

Det verkliga målet med “översättning” är att göra antaganden synliga — så att du kan bekräfta, revidera eller förkasta dem innan de hårdnar till kod.

Innan en LLM kan göra “Bygg mig en app för X” till skärmar, API:er och datamodeller behöver du en produktbrief som är tillräckligt specifik för att designa mot. Detta steg handlar om att omvandla diffus avsikt till ett gemensamt mål.

Skriv problembeskrivningen i en eller två meningar: vem som har problem, med vad, och varför det spelar roll. Lägg sedan till framgångs-mätetal som är observerbara.

Till exempel: “Minska tiden det tar för en klinik att boka uppföljningsbesök.” Mätetal kan inkludera genomsnittlig bokningstid, no-show-rate eller % av patienter som bokar via självbetjäning.

Lista primära användartyper (inte alla som kan röra systemet). Ge varje typ en huvuduppgift och ett kort scenario.

En användbar promptmall är: “Som en [roll], vill jag [göra något] så att [nytta].” Sikta på 3–7 kärnanvändningsfall som beskriver MVP:n.

Begränsningar är skillnaden mellan en ren prototyp och en levererbar produkt. Inkludera:

Var tydlig med vad som ingår i första releasen och vad som skjuts upp. En enkel regel: MVP-funktioner måste stödja primära användningsfall end-to-end utan manuella nödlösningar.

Om du vill, fånga detta som en en-sidig brief och håll den som “sanningskälla” för nästa steg (krav, UI-flöden och arkitektur).

En idé på vanlig engelska är ofta en blandning av mål (“hjälpa folk boka klasser”), antaganden (“användare loggar in”), och vag omfattning (“gör det enkelt”). En LLM är användbar här eftersom den kan omvandla rörig input till krav du kan granska, rätta och godkänna.

Börja med att skriva om varje mening som en användarberättelse. Det tvingar tydlighet kring vem som behöver vad och varför:

Om en story inte nämner en användartyp eller nytta är den förmodligen fortfarande för vag.

Gruppera sedan berättelser till funktioner, och märk varje som måste-ha eller trevligt-att-ha. Det hindrar scope creep innan design och engineering börjar.

Exempel: “push-notiser” kan vara trevligt-att-ha, medan “avboka en bokning” vanligtvis är måste-ha.

Lägg till enkla, testbara regler under varje story. Bra acceptanskriterier är specifika och observerbara:

LLM:er defaultar ofta till “happy path”, så begär explicit edge cases som:

Detta kravpaket blir sanningskällan du använder för att utvärdera senare outputs (UI-flöden, API:er och tester).

En idé blir byggbar när den blir till användarresor och skärmar kopplade via tydlig navigering. I detta steg väljer du inte färger — du definierar vad folk kan göra, i vilken ordning, och vad som räknas som lyckat.

Börja med att lista de viktigaste vägarna. För många produkter kan du strukturera dem som:

Modellen kan utarbeta dessa flöden som steg-för-steg-sekvenser. Din uppgift är att bekräfta vad som är valfritt, vad som är krav, och var användare säkert kan avsluta och återuppta.

Be om två leveranser: en skärminventarie och en navigationskarta.

En bra output namnger skärmar konsekvent (t.ex. “Order Details” vs “Order Detail”), definierar entry points och inkluderar tomtillstånd (inga resultat, inga sparade objekt).

Gör om krav till formulärfält med regler: obligatoriskt/valfritt, format, gränser och användarvänliga felmeddelanden. Exempel: lösenordsregler, adressformat för betalning, eller “datum måste vara i framtiden.” Säkerställ att validering sker både inline (medan användaren skriver) och vid submit.

Inkludera läsbara textstorlekar, tydlig kontrast, full tangentbordsstöd på webben och felmeddelanden som förklarar hur man löser problemet (inte bara “Ogiltig input”). Se också till att varje formulärfält har en label och att fokusordningen är logisk.

En “arkitektur” är appens blueprint: vilka delar finns, vad ansvarar varje del för, och hur talar de med varandra. När en LLM föreslår en arkitektur är din uppgift att säkerställa att den är enkel nog att bygga nu och tydlig nog att vidareutveckla senare.

För de flesta nya produkter är en enkel backend (en monolit) rätt startpunkt: en kodbas, en distribution, en databas. Det går snabbare att bygga, lättare att debugga och billigare att drifta.

En modular monolith är ofta sweet spot: fortfarande en deploy, men organiserad i moduler (Auth, Billing, Projects etc.) med rena gränser. Dela upp tjänster först när verkligt tryck uppstår — tung trafik, ett team som behöver oberoende deploys, eller en del som skalar annorlunda.

Om LLM:n omedelbart föreslår “microservices”, be den motivera med konkreta behov, inte hypotetiska framtidsscenarion.

En bra arkitekturoversikt namnger det väsentliga:

Modellen bör också ange var varje del lever (backend vs mobil vs webb) och definiera hur klienter interagerar med backend (vanligtvis REST eller GraphQL).

Arkitektur förblir tvetydig om du inte spikar grundläggande val: backend-ramverk, databas, hosting och mobilstrategi (native vs cross-platform). Be modellen skriva dessa som “Antaganden” så alla vet vad som designas mot.

I stället för stora omskrivningar, föredra små “escape hatches”: cache för heta läsningar, en kö för bakgrundsjobb och statelösa appservrar så du kan lägga till fler instanser senare. De bästa förslagen förklarar dessa alternativ men håller v1 rak och enkel.

En produktidé är full av substantiv: “users”, “projects”, “tasks”, “payments”, “messages”. Datamodellering är steget där en LLM förvandlar dessa substantiv till en gemensam bild av vad appen måste spara — och hur saker hänger ihop.

Börja med att lista nyckelentiteterna och fråga: vad tillhör vad?

Till exempel:

Definiera sedan relationer och begränsningar: kan en task existera utan ett project, kan kommentarer redigeras, kan projekt arkiveras, och vad händer med tasks när ett projekt raderas.

Nästa steg är att modellen föreslår ett första schema (SQL-tabeller eller NoSQL-collections). Håll det enkelt och fokuserat på beslut som påverkar beteende.

Ett typiskt utkast kan inkludera:

Viktigt: få med “status”-fält, tidsstämplar och unika begränsningar tidigt (som unik e-post). Dessa detaljer driver UI-filter, notifieringar och rapportering senare.

De flesta riktiga appar behöver klara regler för vem som ser vad. En LLM bör göra ägarskap explicit (owner_user_id) och modellera åtkomst (memberskap/roller). För multi-tenant-produkter (många företag i samma system) införa en tenant/organization-entitet och fäst tenant_id till allt som måste isoleras.

Definiera också hur behörigheter upprätthålls: via roller (admin/medlem/visare), via ägarskap eller båda.

Slutligen: bestäm vad som måste loggas och vad som måste raderas. Exempel:

Dessa val förhindrar obehagliga överraskningar när compliance, support eller faktureringsfrågor dyker upp senare.

Backend-API:er är där appens löften blir verkliga handlingar: “spara min profil”, “visa mina ordrar”, “sök listor”. En bra output utgår från användaråtgärder och gör dem till en liten uppsättning tydliga endpoints.

Lista de huvudsakliga sakerna användare interagerar med (t.ex. Projects, Tasks, Messages). För varje sak definiera vad användaren kan göra:

Det mappas ofta till endpoints som:

POST /api/v1/tasks (create)GET /api/v1/tasks?status=open&q=invoice (list/search)GET /api/v1/tasks/{taskId} (read)PATCH /api/v1/tasks/{taskId} (update)DELETE /api/v1/tasks/{taskId} (delete)Skapa en task: användaren skickar titel och förfallodatum.

POST /api/v1/tasks

{

"title": "Send invoice",

"dueDate": "2026-01-15"

}

Responsen returnerar den sparade posten (inklusive servergenererade fält):

201 Created

{

"id": "tsk_123",

"title": "Send invoice",

"dueDate": "2026-01-15",

"status": "open",

"createdAt": "2025-12-26T10:00:00Z"

}

(Behåll dessa JSON-exempel oförändrade i koden.)

Låt modellen producera konsekventa fel:

För retries, föredra idempotens-nycklar på POST och ge tydlig vägledning som “försök igen efter 5 sekunder.”

Mobilklienter uppdateras långsamt. Använd en versionerad basväg (/api/v1/...) och undvik breaking changes:

GET /api/version)Säkerhet är inte en “sen” uppgift. När en LLM omvandlar din idé till app-specar vill du att säkra standarder ska vara explicita — så att den första genererade versionen inte av misstag är öppen för missbruk.

Be modellen rekommendera en primär inloggningsmetod och en fallback, samt vad som händer när något går fel (förlorad åtkomst, misstänkt inloggning osv.). Vanliga val inkluderar:

Låt den specificera sessionshantering (korta access tokens, refresh tokens, device logout) och om ni stödjer multifaktorautentisering.

Autentisering identifierar användaren; auktorisation begränsar åtkomst. Uppmuntra modellen att välja ett tydligt mönster:

project:edit, invoice:export) för flexibla produkterEn bra output inkluderar exempelregler som: “Endast projektägare kan radera ett projekt; medarbetare kan redigera; visare kan kommentera.”

Be modellen lista konkreta skydd, inte generiska löften:

Begär också en baslinje hotchecklista: CSRF/XSS-skydd, säkra cookies och säkra filuppladdningar om det behövs.

Standardisera minimal datainsamling: bara det funktionerna verkligen behöver, under så kort tid som möjligt.

Be LLM:n utarbeta textsammanfattningar på vanligt språk för:

Om du lägger till analytics, insistera på en opt-out (eller opt-in där nödvändigt) och dokumentera det tydligt i inställningar och policy-sidor.

En bra LLM kan omvandla dina krav till en testplan som är överraskande användbar — om du tvingar den att förankra allt i acceptanskriterier, inte generiska “borde fungera”-påståenden.

Börja med att ge modellen din funktionslista och acceptanskriterier, och be den sedan generera tester per kriterium. En solid output inkluderar:

Om ett test inte kan peka tillbaka på ett specifikt kriterium är det troligen brus.

LLM:er kan också föreslå fixtures som speglar hur människor faktiskt använder appen: röriga namn, saknade fält, tidszoner, lång text och “nästan-dubbletter”.

Be om:

Be modellen lägga till en dedikerad mobil-checklista:

LLM:er är bra på att skissa test-skelett, men du bör granska:

Behandla modellen som en snabb testförfattare, inte den slutgiltiga QA-godkännaren.

En modell kan generera mycket kod, men användare drar nytta först när det är levererat säkert och du kan se vad som händer efter lansering. Detta steg handlar om repeterbara releaser: samma steg varje gång, med så få överraskningar som möjligt.

Sätt upp en enkel CI-pipeline som körs på varje pull request och vid merge till huvudgrenen:

Även om LLM:n skrev koden är CI det som berättar om den fortfarande fungerar efter en ändring.

Använd tre miljöer med tydliga syften:

Konfiguration bör hanteras via miljövariabler och hemligheter (inte hårdkodat). En bra regel: om ett värde kräver kodändring för att ändras, är det troligen felkonfigurerat.

För en typisk fullstack-app:

Planera för tre signaler:

Detta är där AI-assisterad utveckling blir operationell: du genererar inte bara kod — du driver en produkt.

LLM:er kan göra en vag idé till något som ser ut som en full plan — men polerad prosa kan dölja luckor. De vanligaste felen är förutsägbara, och du kan förebygga dem med några repeterbara vanor.

De flesta svaga outputs spårar tillbaka till fyra problem:

Ge modellen konkreta material att jobba med:

Be om checklistor per leverabel. Till exempel: krav är inte “klara” förrän de innehåller acceptanskriterier, fel-tillstånd, roller/behörigheter och mätbara framgångsindikatorer.

LLM-output driver isär när spec, API-anteckningar och UI-idéer lever i separata trådar. Håll ett levande dokument (även enkel markdown) som länkar:

När du promptar igen, klistra in det senaste utdraget och säg: “Uppdatera endast avsnitt X och Y; behåll allt annat oförändrat.”

Om du implementerar medan du går hjälper det också att använda ett arbetsflöde som stöder snabb iteration utan att tappa spårbarhet. Till exempel passar Koder.ai:s “planning mode” naturligt här: du kan låsa specen (antaganden, öppna frågor, acceptanskriterier), generera webb/mobil/backend-scaffolding från en enda chat-tråd, och förlita dig på snapshots/rollback om en förändring introducerar regressioner. Export av källkod är särskilt användbart när du vill hålla genererad arkitektur och repo i synk.

Här är hur “LLM-översättning” kan se ut end-to-end — plus kontrollpunkter där en människa bör sakta ner och fatta verkliga beslut.

Vardaglig idé: “En marknadsplats för husdjurspassning där ägare postar förfrågningar, passare ansöker, och betalningar frigörs efter jobbet.”

En LLM kan göra det till ett första utkast som:

POST /requests, GET /requests/{id}, POST /requests/{id}/apply, GET /requests/{id}/applications, POST /messages, POST /checkout/session, POST /jobs/{id}/complete, POST /reviews.Det är användbart — men det är inte “klart”. Det är ett strukturerat förslag som behöver validering.

Produktbeslut: Vad gör en “ansökan” giltig? Kan en ägare bjuda in en passare direkt? När anses en förfrågan “fylld”? Dessa regler påverkar varje skärm och API.

Säkerhet & integritet: Bekräfta rollbaserad åtkomst (ägare kan inte läsa andra ägares chattar), skydda betalningar och definiera datalagring (t.ex. ta bort chatt efter X månader). Lägg till missbrukskontroller: rate limits, spam-förebyggande, auditloggar.

Prestandaavvägningar: Bestäm vad som måste vara snabbt och skalbart (sök/filtrera förfrågningar, chatt). Det påverkar caching, paginering, indexering och bakgrundsjobb.

Efter en pilot kan användare be om “upprepa en förfrågan” eller “avboka med delvis återbetalning.” Mata tillbaka det som uppdaterade krav, regenerera eller patcha berörda flöden, och kör tester samt säkerhetskontroller igen.

Fånga “varför”, inte bara “vad”: nyckelaffärsregler, behörighetsmatris, API-kontrakt, felkoder, databas-migrationer och en kort runbook för releaser och incidenthantering. Det är detta som gör genererad kod begriplig om sex månader.

I det här sammanhanget betyder “translation” att omvandla en otydlig idé till specifika, testbara beslut: roller, resor, krav, data, API:er och framgångskriterier.

Det handlar inte bara om att parafrasera — det handlar om att göra antaganden synliga så att du kan bekräfta eller förkasta dem innan du börjar bygga.

En praktisk första leverans brukar innehålla:

Behandla det som en utkast-blueprint du granskar, inte ett slutgiltigt specifikationsdokument.

Eftersom en LLM inte pålitligt känner till dina verkliga begränsningar och prioriteringar krävs fortfarande mänskliga beslut för:

Använd modellen för att föreslå alternativ, och välj sedan medvetet.

Ge modellen tillräckligt med kontext för att designa mot:

Om du inte kan ge detta till en kollega och få samma tolkning är briefen inte redo.

Fokusera på att omvandla mål till användarberättelser + acceptanskriterier.

Ett starkt paket brukar innehålla:

Detta blir din “källa till sanning” för UI, API:er och tester.

Be om två leverabler:

Verifiera sedan:

Börja med standardvalet: monolit eller modular monolit för de flesta v1-produkter.

Säg emot modellen om den genast föreslår microservices — be om konkreta skäl (trafik, behov av oberoende deploys, olika skalningsmönster). Föredra istället “escape hatches”:

Håll v1 enkel att leverera och felsöka.

Be modellen att specificera:

Databetydande beslut påverkar UI-filter, notifieringar, rapportering och säkerhet.

Insistera på konsekvens och mobilvänligt beteende:

/api/v1/...)POST-förfrågningarUndvik breaking changes; lägg till valfria fält och ge en deprecationsperiod.

Använd modellen för att skissa en plan, och granska den mot acceptanskriterierna:

Kräv även realistiska fixtures: tidszoner, lång text, nästan-dubbletter, fladdriga nätverk. Behandla genererade tester som en startpunkt, inte slutgiltig QA.

Du designar beteende, inte utseende.