05 juni 2025·8 min

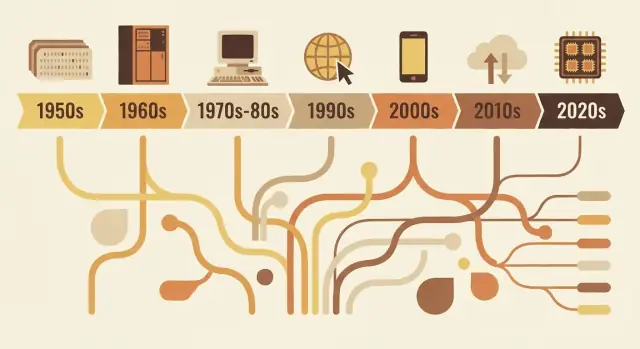

Hur programspråk speglar sin eras behov

Från FORTRAN till Rust bär programspråk med sig tidens prioriteringar: hårdvarubegränsningar, säkerhet, webben och teamarbete. Se hur designval speglar verkliga problem.

Varför språk ser ut som de gör

Programs språk är inte bara "bättre" eller "sämre" versioner av varandra. De är designlösningar för de problem människor behövde lösa vid en viss tidpunkt i databehandlingens utveckling.

Vad "språksdesign" faktiskt innefattar

När vi talar om språksdesign handlar det om mer än hur koden ser ut på sidan. Ett språk är en samling beslut, till exempel:

- Syntax: hur du uttrycker idéer (nyckelord, skiljetecken, läsbarhet)

- Typsystem: om värden har deklarerade typer (och hur strikt språket kontrollerar dem)

- Minnesmodell: vem som hanterar minnet och vilka säkerhetsgarantier som finns

- Exekveringsmodell: kompilerat vs tolkad, runtime-beteende, prestandaavvägningar

- Standardbibliotek + verktyg: paket, byggsystem, debuggers, formatterare och hur team levererar mjukvara

Dessa val klustrar ofta runt tidens begränsningar: begränsad hårdvara, dyr beräkningstid, saknade operativsystemsfunktioner eller (senare) stora team, globala nätverk och säkerhetshot.

Kärn idén

Språk speglar sin tid. Tidiga språk prioriterade att pressa ut värde ur knappa maskiner. Senare prioriterades portabilitet när mjukvara skulle köras på många system. När projekt växte lutade språk mot struktur, abstraktion och verktyg för att hålla stora kodbaser begripliga. På senare tid har samtidighet, molndrift och säkerhet drivit nya avvägningar.

Denna artikel fokuserar på representativa exempel—inte en komplett år-för-år-tidslinje. Du får se hur några inflytelserika språk förkroppsligar behoven i sin period och hur idéer återanvänds och förfinas.

Varför detta spelar roll när du väljer verktyg i dag

Att förstå "varför" bakom ett språk hjälper dig att förutse dess styrkor och blinda fläckar. Det förtydligar frågor som: Är språket optimerat för strikt prestanda, snabb iteration, underhåll i stora team eller säkerhet? När du väljer vad du ska lära dig eller använda i ett projekt är det sammanhanget som är lika praktiskt som en funktionslista.

De tidiga datorernas begränsningar som formade allt

Tidiga programspråk formades mer av fysik och budget än av smak. Maskiner hade mycket lite minne, lagring var knapp och CPU:er var långsamma jämfört med idag. Det tvingade fram ständiga avvägningar: varje extra funktion, varje längre instruktion och varje abstraheringslager hade en verklig kostnad.

Litet minne, dyra cykler

Om du bara har plats för ett litet program och en liten datamängd, designar du språk och verktyg som håller program kompakta och förutsägbara. Tidiga system pressade programmerare mot enkel kontrollflöde och minimalt runtime-stöd. Även "trevliga" funktioner—som rika strängar, dynamisk minneshantering eller högre datatyper—kunde vara opraktiska eftersom de krävde extra kod och bokföring.

Batchkörning och långa återkopplingsslingor

Många tidiga program kördes i batcher. Du förberedde ett jobb (ofta med hålkort), skickade in det och väntade. Om något gick fel kunde du få veta först mycket senare—efter att jobbet körts eller misslyckats.

Den långa återkopplingsslingan förändrade vad som spelade roll:

- Program behövde fungera rätt första gången, eftersom omkörningar var dyra.

- Felsökning var långsammare, så utvecklare förlitade sig på noggrann planering och konventioner.

- Verktyg och interaktiv utforskning var inte standardupplevelsen.

Varför läsbarhet och felmeddelanden inte prioriterades

När maskintid var dyr och gränssnitt begränsade, optimerade språk inte för vänliga diagnoser eller nybörjarvänlighet. Felmeddelanden behövde ofta vara korta, ibland kryptiska, och fokuserade på att hjälpa en operatör lokalisera ett problem i en kortlek eller en tryckt utskrift.

Vetenskap och matematik drev tidiga funktioner

Stora delar av den tidiga efterfrågan kom från vetenskap och teknik: beräkningar, simuleringar och numeriska metoder. Därför centrerade tidiga språk funktioner kring effektiv aritmetik, arrayer och att uttrycka formler på ett sätt som stämde överens med hårdvaran—och med hur forskare redan arbetade på papper.

FORTRAN, COBOL och språk byggda för specifika uppgifter

Vissa tidiga programspråk försökte inte vara universella. De byggdes för att lösa en smal klass av problem extremt bra—eftersom datorer var dyra, tid var knapp och "bra nog för allt" ofta betydde "utmärkt på inget".

FORTRAN: numeriska beräkningar, hastighet och forskarens arbetsflöde

FORTRAN (FORmula TRANslation) riktade sig direkt mot ingenjörs- och vetenskapsberäkningar. Löftet var praktiskt: låt folk skriva matematiktunga program utan att handkoda varje detalj i maskinkod.

Det formade designen: språket lutade mot numeriska operationer och array-bearbetning och satsade hårt på prestanda. Den verkliga innovationen var inte bara syntaxen—utan idén att en kompilator kunde generera maskinkod tillräckligt effektivt för att forskare skulle lita på den. När ditt huvudjobb är simuleringar eller fysikberäkningar är varje spart nanosekund skillnaden mellan resultat idag eller nästa vecka.

COBOL: affärsregister, läsbarhet och rapportering

COBOL riktade sig mot en annan värld: myndigheter, banker, försäkring, löner och lagerhantering. Det är "register- och rapportproblem"—strukturerade data, förutsägbara arbetsflöden och mycket revision.

Därför föredrog COBOL en engelskliknande, verbos stil som gjorde program enklare att granska och underhålla i stora organisationer. Data-definitioner var förstklassiga, eftersom affärsmjukvara lever och dör på hur väl den modellerar formulär, konton och transaktioner.

Vad "nära domänen" egentligen betyder

Båda språken visar en designprincip som fortfarande är relevant: vokabulären bör spegla arbetet.

FORTRAN talar i matematiska termer. COBOL talar i termer av register och procedurer. Deras popularitet avslöjar tidens prioriteringar: inte abstrakt experimenterande, utan att få verkliga arbetslaster gjorda effektivt—antingen snabbare numerisk beräkning eller tydligare hantering av affärsdata och rapporter.

Systemeran: portabilitet och kontroll (C, Unix)

I slutet av 1960- och 1970-talen blev datorer billigare och vanligare—men de var fortfarande mycket olika varandra. Programvara skriven för en maskin krävde ofta omfattande omskrivning för att köras på en annan.

Assemblerplågan drev språk upp en nivå

Mycket viktig mjukvara skrevs i assembler, vilket gav maximal prestanda och kontroll, men till ett högt pris: varje CPU hade sin egen instruktsuppsättning, koden var svår att läsa och små ändringar kunde kräva dagar av noggranna redigeringar. Det skapade efterfrågan på ett språk som kändes "nära maskinen" men inte låste dig till en processor.

C:s kärnmål: bärbar systemkod

C uppstod som ett praktiskt kompromiss. Det designades för att skriva operativsystem och verktyg—särskilt Unix—och ändå vara portabelt över olika hårdvaror. C gav programmerare:

- Ett enkelt, litet funktionsset som kunde kompileras på många maskiner

- Direkt åtkomst till minne via pekare

- Möjligheten att skriva låg nivå-kod utan att ständigt återgå till assembler

Att Unix skrev om sig själv i C är ett berömt bevis: operativsystemet kunde flyttas till ny hårdvara mycket lättare än ett system som bara fanns i assembler.

Varför manuell minneshantering var acceptabelt

C förväntade sig att du hanterade minnet själv (allokera, frigöra, undvika misstag). Det låter riskabelt nu, men det matchade tidens prioriteringar. Maskiner hade begränsade resurser, operativsystem behövde förutsägbar prestanda och programmerare arbetade ofta nära hårdvaran—ibland med exakt minneslayout i åtanke.

Den varaktiga avvägningen

C optimerade för hastighet och kontroll, och den levererade. Priset var säkerhet och enkelhet: buffertöverflöden, krascher och subtila buggar blev vanliga risker. I den eran betraktades dessa risker ofta som acceptabla kostnader för portabilitet och prestanda.

Att göra stora program underhållbara: struktur och typer

När program växte från små, ändamålsspecifika verktyg till produkter som drev företag uppstod ett nytt problem: inte bara "fungerar det?" utan "kan vi hålla det fungerande i åratal?" Tidig kod utvecklades ofta genom lappande och hopp med goto, vilket skapade "spaghettikod" som var svår att läsa, testa eller ändra säkert.

Vad strukturerad programmering försökte åtgärda

Strukturerad programmering förespråkade en enkel idé: kod bör ha en tydlig form. Istället för att hoppa till godtyckliga rader använde utvecklare väl definierade byggstenar—if/else, while, for och switch—för att göra kontrollflödet förutsägbart.

Den förutsägbarheten var viktig eftersom felsökning till stor del handlar om att svara på "hur hamnade exekveringen här?" När flödet är synligt i strukturen gömt färre buggar sig i skrymslen.

Teamens uppkomst och långlivade kodbaser

När mjukvara blev ett teamarbete blev underhållbarhet lika mycket ett socialt problem som ett tekniskt. Nya kollegor behövde förstå kod de inte skrivit. Chefer behövde uppskattningar för ändringar. Företag behövde förtroende för att uppdateringar inte skulle krascha allt.

Språk svarade genom att uppmuntra konventioner som skalar bortom en persons minne: konsekventa funktionsgränser, tydligare variabellivslängder och sätt att organisera kod i separata filer och bibliotek.

Varför typer, moduler och scope blev värdefulla

Typer började spela större roll eftersom de fungerar som "inbyggd dokumentation" och tidig felupptäckt. Om en funktion förväntar sig ett tal men får text kan ett starkt typsystem fånga det innan det når användarna.

Moduler och scopes hjälpte till att begränsa förändringars spridning. Genom att hålla detaljer privata och exponera stabila gränssnitt kunde teamen refaktorera internt utan att skriva om hela programmet.

Designdrag som stödde komposition

Vanliga förbättringar inkluderade:

- Mindre, väl namngivna funktioner som gör en sak

- Lexikalt scope för att undvika oavsiktliga interaktioner mellan variabler

- Bättre kompositionsmönster (passera funktioner/data rent istället för att förlita sig på globalt tillstånd)

Tillsammans flyttade dessa förändringar språken mot kod som är lättare att läsa, granska och säkert vidareutveckla.

Objekt och företagsvärlden: varför OOP blev mainstream

Iterera utan rädsla

Spara framsteg med snapshots och återställ säkert när du experimenterar.

Objektorienterad programmering (OOP) "vann" inte för att det var den enda bra idén—det vann eftersom det matchade vad många team försökte bygga: långlivade affärssystem underhållna av många människor.

Vad OOP lovade

OOP erbjöd en enkel berättelse för komplexitet: representera programmet som en uppsättning "objekt" med tydliga ansvar.

Inkapsling (att dölja interna detaljer) lät praktiskt för att förhindra oavsiktliga fel. Arv och polymorfism lovade återanvändning: skriv en generell version en gång, specialisera senare och plugga in olika implementationer i samma gränssnitt.

Varför GUI:er och affärsappar drev det framåt

När skrivbordsprogram och grafiska gränssnitt växte behövde utvecklare sätt att hantera många interagerande komponenter: fönster, knappar, dokument, menyer och händelser. Att tänka i objekt och meddelanden passade väl för dessa interaktiva delar.

Samtidigt växte företagsystem kring domäner som bank, försäkring, lager och HR. Dessa miljöer värdesatte konsekvens, lagarbete och kodbaser som kunde utvecklas i åratal. OOP passade ett organisatoriskt behov: dela upp arbetet i moduler som olika team ansvarade för, upprätthålla gränser och standardisera hur funktioner lades till.

När det hjälpte—och när det blev rörigt

OOP fungerar bra när det skapar stabila gränser och återanvändbara komponenter. Det blir problematiskt när utvecklare övermodellar allt, skapar djupa klasshierarkier, "god objects" eller mönster som används mest för att de är trendiga. För många lager kan få enkla ändringar att kännas som byråkrati.

Bestående påverkan

Även språk som inte är "rena OOP" lånade dess standarder: klassliknande strukturer, interfaces, åtkomstmodifierare och designmönster. Mycket av modern mainstream-syntax återspeglar denna eras fokus på att organisera stora team runt stora kodbaser.

Javas era: portabilitet, säkerhet och företagsnivå

Java växte fram tillsammans med en specifik typ av mjukvaruboom: stora, långlivade affärssystem som spreds över en brokig blandning av servrar, operativsystem och leverantörshårdvara. Företag ville ha förutsägbara driftsätt, färre krascher och team som kunde växa utan att behöva skriva om allt vartannat år.

Vad JVM löste: portabilitet med en hanterad runtime

Istället för att kompilera direkt till en viss maskins instruktioner kompilera Java till bytekod som körs på Java Virtual Machine (JVM). JVM blev den "standardlager" företag kunde bygga på: leverera samma applikationsartefakt och köra den på Windows, Linux eller större Unix-boxar med minimala ändringar.

Detta är kärnan i "write once, run anywhere": inte en garanti för noll plattformsquarks, men ett praktiskt sätt att minska kostnaden och risken för att stödja många miljöer.

Säkerhetsdefault som minskade produktionsfel

Java gjorde säkerhet till en primär funktion snarare än en valfri disciplin.

Garbage collection minskade en hel kategori minnesbuggar (hängande pekare, dubbelfrigörelse) som var vanliga i ohanterade miljöer. Gränskontroller för arrayer hjälpte till att förhindra läsning eller skrivning utanför en datastruktur. Kombinerat med ett striktare typsystem syftade dessa val till att göra katastrofala fel till förutsägbara undantag—lättare att reproducera, logga och fixa.

Varför det passade företagsverkligheten

Företag värdesatte stabilitet, verktyg och styrning: standardiserade byggprocesser, kraftigt IDE-stöd, ett omfattande bibliotek och en runtime som kunde övervakas och hanteras. JVM möjliggjorde också ett rikt ekosystem av applikationsservrar och ramverk som gjorde utveckling i stora team mer konsekvent.

Avvägningarna: overhead, justering och komplexitet

Javas fördelar var inte gratis. En hanterad runtime lägger till uppstartstid och minnesöverhuvud, och garbage collection kan skapa latensspikar om den inte ställs in. Med tiden ackumulerades också komplexitet i ekosystemet—lager av ramverk, konfiguration och driftsmodeller som krävde specialkunskap.

Trots detta var affären värd det för många organisationer: färre låg-nivåfel, enklare plattformsdrift och en delad runtime som skalade med företagets storlek och kodbas.

Scriptspråk och produktivitetsfokus

Skeppa fullstack snabbare

Skapa webb-, backend- eller mobilappar med Koder.ai på ett ställe.

I slutet av 1990-talet och 2000-talet skrev många team inte operativsystem—de kopplade ihop databaser, byggde webbplatser och automatiserade interna arbetsflöden. Flaskhalsen flyttade från rå CPU-effektivitet till utvecklartid. Snabbare återkoppling och kortare releasecykler gjorde "hur snabbt kan vi ändra detta?" till ett primärt krav.

Varför snabb iteration blev prioritet

Webbappar utvecklades på dagar, inte år. Företag ville ha nya sidor, rapporter och integrationer snabbt utan en fullständig kompilera–länka–driftsätt-pipeline. Scriptspråk passade rytmen: ändra en fil, kör den, se resultatet.

Det förändrade också vem som kunde bygga mjukvara. Systemadministratörer, analytiker och små team kunde leverera användbara verktyg utan djup kunskap om minneshantering eller byggsystem.

Dynamisk typning och batteries-included-ekosystem

Språk som Python och Ruby lutade sig mot dynamisk typning: du kan uttrycka en idé med färre deklarationer och mindre ceremoni. Kombinerat med starka standardbibliotek gjorde de vardagliga uppgifter ofta "en import bort":

- textbearbetning och filhantering

- HTTP, e-post och grundläggande nätverk

- databasåtkomst och dataformat (CSV, JSON, XML)

Denna "batteries-included"-inställning belönade experimenterande och gjorde att automatiseringsskript naturligt kunde växa till riktiga applikationer.

Python, Ruby och PHP som praktiska svar

Python blev ett förstahandsval för automation och allmänt bruk, Ruby accelererade webb utveckling (särskilt genom ramverk) och PHP dominerade tidig serverside-webb tack vare att det var enkelt att bädda in direkt i sidor och distribuera nästan varsomhelst.

Avvägningarna: hastighet, runtime-fel, skalningspraxis

Samma egenskaper som gjorde scriptspråk produktiva introducerade också kostnader:

- långsammare körning jämfört med kompilerade språk

- fler fel upptäcks vid runtime

- skalning krävde disciplin: testning, kodgranskning, linters och konventioner

Med andra ord optimerade scriptspråk för förändring. Team lärde sig att "köpa tillbaka" tillförlitlighet med verktyg och arbetssätt—vilket banade väg för moderna ekosystem där både utvecklarhastighet och mjukvarukvalitet förväntas.

JavaScript och webbläsarens mjukvaruboost

Webbläsaren blev en överraskande "dator" som levererades till miljontals människor. Men det var inte ett blankt blad: det var en sandlåda, det kördes på oförutsägbar hårdvara och det måste hålla sig responsivt medan det ritade skärmar och väntade på nätverk. Den miljön formade JavaScripts roll mer än någon abstrakt idé om ett perfekt språk.

En plattform med ovanliga begränsningar

Webbläsare krävde att kod levererades direkt, kördes säkert bredvid otrustat innehåll och höll sidan interaktiv. Det pressade JavaScript mot snabb uppstart, dynamiskt beteende och API:er tätt knutna till sidan: klick, input, timers och senare nätverksförfrågningar.

Varför "överallt" slog "perfekt"

JavaScript vann huvudsakligen eftersom det redan fanns på plats. Om du ville ha beteende i en webbläsare var JavaScript standardalternativet—ingen installationssteg, inga behörigheter, ingen separat runtime att få användare att ladda ner. Konkurrerande idéer kunde se renare ut på papper, men kunde inte matcha distributionsfördelen "det körs på varje sajt."

Händelsestyrt av nödvändighet

Webbläsaren är grundläggande reaktiv: användare klickar, sidor rullar, förfrågningar returnerar när de returnerar. JavaScripts händelsestyrda stil (callbacks, events, promises) speglar den verkligheten. Istället för ett program som körs från början till slut är mycket webbkod "vänta på något, reagera sedan", vilket passar UI- och nätverksarbete naturligt.

Långsiktiga effekter: ekosystem och kompatibilitet

Framgång skapade en gravitationsbrunn. Stora ekosystem formades kring ramverk och bibliotek, och byggpipelines blev en produktkategori: transpilers, bundlers, minifiers och paketförvaltare. Samtidigt innebar webben löftet om bakåtkompatibilitet att gamla beslut höll i sig—så modern JavaScript känns ofta som lager av nya verktyg byggda för att leva med gårdagens begränsningar.

Samtidighet och flerkärnornas verklighet

Länge betydde snabbare datorer mestadels att ditt program blev snabbare utan att ändra en rad kod. Den affären bröts när chips nådde värme- och effektgränser och började lägga till kärnor istället för att öka klockfrekvensen. Plötsligt krävdes det att göra mer än en sak samtidigt för att få mer prestanda.

Varför flerkärnigt gjorde samtidighet oundvikligt

Moderna appar utför sällan en enda isolerad uppgift. De hanterar många förfrågningar, pratar med databaser, renderar UI, bearbetar filer och väntar på nätverk—samtidigt som användare förväntar sig omedelbar respons. Flerkärnig hårdvara gjorde det möjligt att köra arbete parallellt, men gjorde det också smärtsamt när ett språk eller runtime antog "en huvudtråd, ett flöde."

Vad språk lade till för att hjälpa

Tidig samtidighet förlitade sig på OS-trådar och lås. Många språk exponerade detta direkt, vilket fungerade—men lade kompliciteten på vardagsutvecklaren.

Nyare designer försöker göra vanliga mönster enklare:

- Trådar med säkrare primitiva: bättre mutexar, trådpooler och tydligare minnesmodeller.

- async/await: ett sätt att skriva icke-blockerande kod som ändå läses som steg-för-steg-logik.

- Kanaler och meddelandeöverföring: "dela data genom att kommunicera" (CSP-stil) för att minska delat tillståndsbuggar.

Servrar och distribuerade system ändrade standarderna

När mjukvara flyttade till always-on-tjänster blev den "normala" applikationen en server som hanterar tusentals samtidiga förfrågningar. Språk började optimera för I/O-tunga arbetslaster, avbokning/tidsgränser och förutsägbar prestanda under belastning.

Fallgropar som språk försöker förhindra

Samtidighetsfel är ofta sällsynta och svåra att reproducera. Språksdesign siktar nu alltmer på att förhindra:

- Race conditions (två uppgifter uppdaterar samma data oförutsägbart)

- Deadlocks (uppgifter väntar på varandra för alltid)

- Starvation (vissa uppgifter får aldrig CPU-tid)

Den stora förändringen: samtidighet slutade vara ett avancerat ämne och blev en grundförväntning.

Moderna prioriteringar: säkerhet, enkelhet och verktyg (Go, Rust)

Prototypa i en session

Testa en ny produktidé snabbt, och finslipa den sedan i chatten.

På 2010-talet kämpade många team inte för att uttrycka algoritmer—de kämpade för att behålla tjänster säkra, stabila och enkla att ändra under ständig driftsättning. Två problem stack ut: säkerhetsbuggar orsakade av minnesfel och ingenjörshinder orsakade av överkomplexa stackar och inkonsekventa verktyg.

Åtgärda buggar som upprepas

En stor del av högprioriterade sårbarheter spåras fortfarande till minnessäkerhetsproblem: buffertöverflöden, use-after-free och subtilt odefinierat beteende som bara dyker upp i vissa byggen eller maskiner. Modern språkutveckling behandlar dessa i högre grad som oacceptabla "benpipor" snarare än bara programmerarmisstag.

Rust är det tydligaste svaret. Dess ägande- och låneregler är i praktiken ett avtal: du skriver kod som klarar strikta kompilatortester, och i gengäld får du starka garantier om minnessäkerhet utan en garbage collector. Det gör Rust attraktivt för systemkod som historiskt levt i C/C++—nätverkstjänster, inbäddade komponenter och prestandakritiska bibliotek—där både säkerhet och hastighet spelar roll.

Enkelhet och tjänster som standardarbetslast

Go tar nästan motsatt angreppssätt: begränsa språkfunktioner för att hålla kodbaser läsbara och förutsägbara i stora team. Dess design speglar en värld av långkörande tjänster, API:er och molninfrastruktur.

Gos standardbibliotek och inbyggda samtidighetsprimitiv (goroutines, kanaler) stödjer tjänsteutveckling direkt, medan dess snabba kompilator och enkla beroendehantering minskar friktionen i vardagsarbetet.

Utvecklarupplevelsen blir en funktion

Verktyg gick från "valfria tillbehör" till en del av språkets löfte. Go normaliserade denna syn med gofmt och en kultur kring standardformatering. Rust följde med rustfmt, clippy och ett starkt integrerat byggverktyg (cargo).

I dagens "continous delivery"-miljö sträcker sig detta verktygstänk ofta bortom kompilatorer och linters till högre nivåer: planering, scaffoldning och snabbare iterationsloopar. Plattformar som Koder.ai reflekterar den förändringen genom att låta team bygga webb, backend och mobil via ett chattgränssnitt—exportera sedan källkod, driftsätta och återställa med snapshots vid behov. Det är ännu ett exempel på ett historiskt mönster: de verktyg som sprids snabbast gör tidens vanliga arbete billigare och mindre felbenäget.

När formaterare, linters och byggsystem är förstklassiga spenderar team mindre tid på stildebatter eller inkonsekventa miljöer—och mer tid på att leverera tillförlitlig mjukvara.

Vad dagens problem antyder om morgondagens språk

Programs språk "vinner" inte för att de är perfekta. De vinner när de gör det vanliga arbetet i sin era billigare, säkrare eller snabbare—särskilt i kombination med rätt bibliotek och driftsättningsvanor.

AI, dataarbete och ekosystemens kraft

En stark drivkraft bakom dagens språkpopularitet är var arbetet finns: datapipelines, analys, maskininlärning och automation. Därför växer Python fortfarande—inte bara för syntaxen, utan för dess ekosystem: NumPy/Pandas för data, PyTorch/TensorFlow för ML, notebooks för utforskning och en stor community som skapar återanvändbara byggstenar.

SQL är ett tystare exempel på samma effekt. Det är inte trendigt, men fortfarande standardgränssnittet mot affärsdata eftersom det passar uppgiften: deklarativa frågor, förutsägbara optimizer och bred kompatibilitet över verktyg och leverantörer. Nya språk integrerar ofta SQL snarare än ersätter det.

Samtidigt driver prestandakrävande AI fram GPU-orienterade verktyg. Vi ser mer fokus på vektorisering, batching och hårdvaruacceleration—antingen via CUDA-ekosystemet, MLIR och kompilatorstackar eller språk som gör det enklare att binda till dessa runtime.

Vad som kan forma framtida språkdesigner

Flera påfrestningar kommer sannolikt att påverka "nästa eras" språk och stora uppdateringar:

- Verifikation och korrekthet: starkare typsystem, säkrare samtidighet och verktyg som bevisar egenskaper snarare än bara testar.

- Integritet och policy: bättre stöd för datastyrning, granskbarhet och begränsningar kring känslig data.

- Energianvändning och effektivitet: språk och runtimes som gör det enklare att skriva snabb kod utan manuell mikromanagement.

Praktiskt slutsats

När du väljer språk, matcha det mot dina begränsningar: teamets erfarenhet, rekryteringspoolen, bibliotek du behöver, driftsmål och krav på tillförlitlighet. Ett "bra" språk är ofta det som gör dina vanligaste uppgifter tråkiga—och dina fel lättare att förebygga och diagnostisera.

Om du behöver ett ramverksdrivet ekosystem, välj för ekosystemet; om du behöver korrekthet och kontroll, välj för säkerhet och prestanda. För en djupare beslutschecklista, se blogginlägget om hur man väljer ett programspråk.