14 maj 2025·8 min

Intel, x86‑dominans och varför plattformsbyten är så svåra

En tydlig genomgång av hur Intel x86 byggde upp decennier av kompatibilitet, varför ekosystem låser sig och varför plattformsbyten är så svåra för industrin.

En tydlig genomgång av hur Intel x86 byggde upp decennier av kompatibilitet, varför ekosystem låser sig och varför plattformsbyten är så svåra för industrin.

När folk säger ”x86” menar de oftast en familj instruktioner som började med Intels 8086‑chip och utvecklats över decennier. Dessa instruktioner är de grundläggande verb en processor förstår—addera, jämför, flytta data och så vidare. Den här uppsättningen kallas en ISA (instruktionsuppsättning). Du kan tänka på ISA som det ”språk” som mjukvara i slutänden måste tala för att köras på en viss typ av CPU.

x86: Den vanligaste ISA:n i persondatorer under stora delar av de senaste 40 åren, genomförd främst av Intel och även av AMD.

Bakåtkompatibilitet: Förmågan för nyare datorer att fortsätta köra äldre mjukvara (ibland flera decennier gammal) utan omfattande omskrivningar. Det är inte perfekt i varje enskilt fall, men det är ett vägledande löfte i PC‑världen: ”Dina grejer ska fortfarande fungera.”

”Dominans” här är inte bara ett påstående om prestanda. Det är en praktisk, sammanvävd fördel över flera dimensioner:

Den kombinationen spelar roll eftersom varje lager förstärker de andra. Fler maskiner uppmuntrar mer mjukvara; mer mjukvara uppmuntrar fler maskiner.

Att byta bort en dominerande ISA är inte som att byta ut en komponent mot en annan. Det kan bryta—eller åtminstone komplicera—appar, drivrutiner (för skrivare, GPU:er, ljudenheter, nischperiferier), utvecklingsverktyg, och till och med vardagliga vanor (image‑processer, IT‑skript, säkerhetsagenter, deployments). Många av dessa beroenden förblir osynliga tills något går fel.

Det här inlägget fokuserar främst på PC‑er och servrar, där x86 varit standard länge. Vi kommer också att referera till nyare skiften—särskilt ARM‑övergångar—eftersom de ger moderna, lättjämförliga lektioner om vad som ändras smidigt, vad som inte gör det, och varför ”bara kompilera om” sällan täcker hela sanningen.

Den tidiga PC‑marknaden började inte med någon storslagen arkitekturplan—den började med praktiska begränsningar. Företag ville ha maskiner som var prisvärda, fanns i volym och var lätta att serva. Det drev leverantörer mot CPU:er och komponenter som gick att få tag på pålitligt, kombinerat med standardperiferiutrustning, och att bygga system utan specialanpassad ingenjörsinsats.

IBMs ursprungliga PC‑design lutade tungt mot standarddelar och en relativt billig Intel 8088‑klass processor. Det valet gjorde att ”PC:n” kändes mindre som en unik produkt och mer som ett recept: en CPU‑familj, en uppsättning expansionsplatser, ett tangentbord/skärm‑angreppssätt och en mjukvarustack som kunde reproduceras.

När IBM PC visade att det fanns efterfrågan expanderade marknaden genom kloning. Företag som Compaq visade att man kunde bygga kompatibla maskiner som körde samma mjukvara—och sälja dem till olika prisnivåer.

Lika viktigt var second‑source‑tillverkning: flera leverantörer kunde erbjuda kompatibla processorer eller komponenter. För köpare minskade det risken att satsa på en enda leverantör. För OEM:er ökade det tillgång och konkurrens, vilket snabbar på adoption.

I den miljön blev kompatibilitet den funktion folk förstod och värderade. Köpare behövde inte veta vad en instruktionsuppsättning var; de behövde bara veta om Lotus 1‑2‑3 (och senare Windows‑appar) skulle köras.

Mjukvarutillgänglighet blev snabbt en enkel heuristik för köp: om den kör samma program som andra PC:er är det ett säkert val.

Hårdvaru‑ och firmware‑konventioner gjorde mycket osynligt jobb. Gemensamma bussar och expansionsmetoder—tillsammans med BIOS/firmware‑förväntningar och delade systembeteenden—gjorde det enklare för hårdvarutillverkare och utvecklare att rikta in sig på ”PC:n” som en stabil plattform.

Den stabiliteten hjälpte till att cementera x86 som den standardmässiga grunden under ett växande ekosystem.

x86 vann inte bara genom klockfrekvenser eller smarta chip. Det vann eftersom mjukvaran följde användarna, och användarna följde mjukvaran—en ekonomisk ”nätverkseffekt” som vuxit över tid.

När en plattform får ett tidigt försprång ser utvecklare en större publik och en tydligare väg till intäkter. Det ger fler applikationer, bättre stöd och fler tredjepartstillägg. Dessa förbättringar gör plattformen ännu mer attraktiv för nästa våg köpare.

Upprepa den loopen under år så blir den ”default” plattformen svår att ersätta—även om alternativ är tekniskt lockande.

Det är därför plattformsövergångar inte bara handlar om att bygga en CPU. Det handlar om att återskapa ett helt ekosystem: appar, installationsprogram, uppdateringskanaler, kringutrustning, IT‑processer och den kollektiva kunskapen hos miljoner användare.

Företag behåller ofta kritiska appar länge: egna databaser, interna verktyg, ERP‑tillägg, branschspecifik mjukvara och arbetsflödesmakron som ingen vill röra eftersom de ”bara fungerar”. En stabil x86‑målplattform betydde:

Även om en ny plattform lovade lägre kostnad eller bättre prestanda vägde risken att bryta ett intäktsgenererande arbetsflöde ofta tyngre än fördelarna.

Utvecklare optimerar sällan för den ”bästa” plattformen i ett vakuum. De optimerar för den plattform som minimerar supportbördan och maximerar räckvidden.

Om 90% av dina kunder är på x86 Windows är det där du testar först, levererar först och fixar buggar snabbast. Att stödja en andra arkitektur kan innebära fler byggpipelines, fler QA‑matriser, mer ”det funkar på min maskin”‑debuggning och fler kundsupportskript.

Resultatet är ett självförstärkande glapp: ledarplattformen får bättre mjukvara snabbare.

Tänk dig en liten verksamhet. Deras redovisningspaket är x86‑endast, integrerat med årtionden av mallar och ett löneplugin. De är också beroende av en specifik etikettsskrivare och en dokumentskanner med kinkiga drivrutiner.

Nu föreslår du ett plattformsbyte. Även om kärnappen finns kan kantdelarna avgöra: skrivardrivrutinen, skannerhjälpmedlet, PDF‑pluginet, bankimportmodulen. Dessa ”tråkiga” beroenden blir måste‑komponenter—och när de saknas eller är opålitliga stannar hela migreringen.

Det är svänghjulet i praktiken: den vinnande plattformen ackumulerar en lång svans av kompatibilitet som alla tyst förlitar sig på.

Bakåtkompatibilitet var inte bara en trevlig bieffekt av x86—det blev en avsiktlig produktstrategi. Intel höll x86 ISA tillräckligt stabil för att mjukvara skriven många år tidigare fortfarande skulle kunna köras, samtidigt som nästan allt annat under huven förändrades.

Nyckeldistinktionen är vad som hålls kompatibelt. ISA definierar maskininstruktionerna program litar på; mikroarkitektur är hur ett chip utför dem.

Intel kunde gå från enklare pipelines till out‑of‑order‑exekvering, lägga till större cacheminnen, förbättra branch prediction eller införa nya tillverkningsprocesser—utan att be utvecklare skriva om sina appar.

Den stabiliteten skapade en kraftfull förväntan: nya PC:er ska köra gammal mjukvara från dag ett.

x86 ackumulerade nya möjligheter i lager. Instruktionsuppsättningsförlängningar som MMX, SSE, AVX och senare funktioner var additiva: gamla binärer fungerade fortfarande, och nyare appar kunde upptäcka och använda nya instruktioner när de fanns.

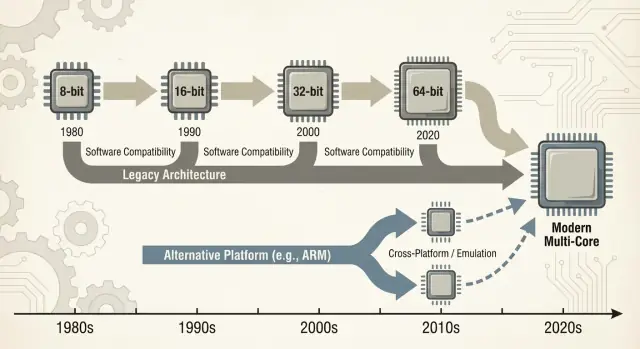

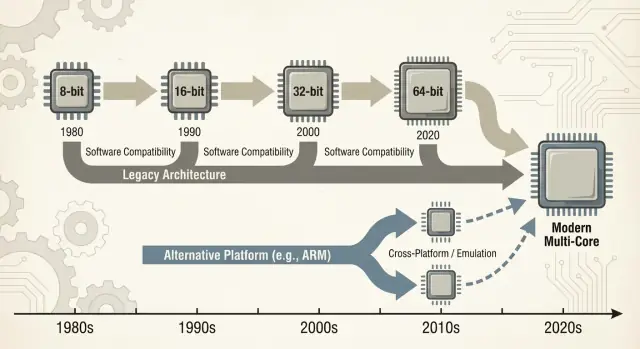

Även större övergångar jämnades ut av kompatibilitetsmekanismer:

Nackdelen är komplexitet. Att stödja decennier av beteenden betyder fler CPU‑lägen, fler kantfall och en tyngre valideringsbörda. Varje ny generation måste bevisa att den fortfarande kör gårdagens affärsapp, drivrutin eller installationsprogram.

Med tiden slutar ”bryt inte befintliga appar” vara en riktlinje och blir en strategisk begränsning: det skyddar den installerade basen, men gör radikala plattformsförändringar—nya ISA:er, nya systemdesigner, nya antaganden—mycket svårare att motivera.

”Wintel” var inte bara ett fyndigt begrepp för Windows och Intel‑chip. Det beskrev en självförstärkande loop där varje del av PC‑industrin gynnades av att hålla sig till samma standardmål: Windows på x86.

För de flesta konsument‑ och företagsleverantörer var den praktiska frågan inte ”vilken arkitektur är bäst?” utan ”var finns kunderna, och hur kommer supportfallen att se ut?”

Windows‑PC:er var utbredda i hem, kontor och skolor, och de var till stor del x86‑baserade. Att leverera för den kombinationen gav maximal räckvidd samtidigt som överraskningar minimerades.

När en kritisk massa appar utgick från Windows + x86 fick nya köpare ytterligare en anledning att välja det: deras viktigaste program fungerade redan där. Det gjorde i sin tur plattformen ännu mer attraktiv för nästa generation utvecklare.

PC‑tillverkare (OEM:er) lyckas när de kan bygga många modeller snabbt, köpa komponenter från flera leverantörer och skicka maskiner som ”bara fungerar”. En gemensam Windows + x86‑baseline förenklade det.

Periferiutrustningsföretag följde volymen. Om de flesta köpare använde Windows‑PC:er prioriterade skrivare, skannrar, ljudgränssnitt, Wi‑Fi‑chip och andra enheter drivrutiner för Windows först. Bättre drivrutinstillgänglighet förbättrade upplevelsen på Windows‑PC:n, vilket hjälpte OEM:erna att sälja fler enheter, vilket höll volymerna höga.

Företags‑ och myndighetsinköp premierar ofta förutsägbarhet: kompatibilitet med befintliga appar, hanterbara supportkostnader, leverantörsgarantier och beprövade utrullningsverktyg.

Även när alternativ är lockande vinner ofta det lägsta risken eftersom det minskar utbildning, undviker kantfel och passar befintliga IT‑processer.

Resultatet var mindre en konspiration och mer en uppsättning samordnade incitament—varje aktör valde den väg som minskade friktion—vilket skapade momentum som gjorde plattformsbyten ovanligt svåra.

Ett ”plattformsbyte” är inte bara att byta CPU. Det är en paketförflyttning: CPU‑ISA, operativsystem, kompilator/toolchain som bygger appar, och drivrutinsstacken som får hårdvara att fungera. Byt någon av dessa och du rör ofta vid de andra.

De flesta fel är inte dramatiska ”appen startar inte”‑fel. Det är tusen små problem:

Även om kärnappen har en ny build kanske inte dess omgivande ”lim” gör det.

Skrivare, skannrar, etikettmaskiner, specialiserade PCIe/USB‑kort, medicinsk utrustning, kassasystem och USB‑donglar lever och dör med drivrutiner. Om leverantören är borta—eller ointresserad—finns det kanske ingen drivrutin för det nya OS:et eller arkitekturen.

I många företag kan en enkronas enhet värd 200 USD frysa en fleet av PC:er värda 2 000 USD.

Det största hindret är ofta ”små” interna verktyg: en Access‑databas, en Excel‑makroarbetsbok, en VB‑app från 2009, ett nischat tillverkningsverktyg som tre personer använder.

De här finns inte på någon road‑map men är affärskritiska. Plattformsbyten misslyckas när den långa svansen inte migreras, testas och ägs av någon.

Ett plattformsbyte bedöms inte bara på benchmarkpoäng. Det bedöms efter om den totala kostnaden—pengar, tid, risk och förlorad momentum—är lägre än den upplevda nyttan. För de flesta individer och organisationer är den räkningen högre än den ser ut utifrån.

För användare börjar kostnader med det uppenbara (ny hårdvara, nya periferienheter, nya garantier) och glider snabbt över i det röriga: träna om muskelminnet, konfigurera om arbetsflöden och validera verktyg som används dagligen.

Även när en app ”körs” kan detaljer förändras: ett plugin laddas inte, en skrivardrivrutin saknas, ett makro beter sig annorlunda, ett anti‑cheat‑system flaggar något, eller en nischad accessoar slutar fungera. Var och en är liten; tillsammans kan de sudda ut uppgraderings‑värdet.

Leverantörer betalar för plattformsbyten genom en växande testmatris. Det handlar inte bara om ”startar den?” utan om:

Varje extra kombination lägger till QA‑tid, mer dokumentation och fler supportärenden. En övergång kan förvandla en förutsägbar releasetakt till en permanent incident‑response‑cykel.

Utvecklare absorberar kostnaden för portar av bibliotek, omskrivningar av prestandakritisk kod (ofta handoptimerad för en ISA) och återuppbyggnad av automatiserade tester. Det svåraste är att återfå förtroendet: bevisa att den nya bygget är korrekt, tillräckligt snabb och stabil i verkliga arbetslaster.

Migreringsarbete konkurrerar direkt med nya funktioner. Om ett team spenderar två kvartal på att få saker att ”fungera igen”, är det två kvartal de inte förbättrar produkten. Många organisationer byter bara när den gamla plattformen blockerar dem—eller när den nya är så övertygande att den rättfärdigar kostnaden.

När en ny CPU‑arkitektur anländer frågar användare inte om instruktionsuppsättningar—de frågar om deras appar fortfarande öppnas. Därför spelar ”broar” roll: de låter nya maskiner köra gammal mjukvara tills ekosystemet hunnit ikapp.

Emulering imiterar en hel CPU i mjukvara. Det är mest kompatibelt men vanligtvis långsammare eftersom varje instruktion ”ageras ut” i stället för att köras nativt.

Binär översättning (ofta dynamisk) skriver om bitar av x86‑kod till den nya CPU:ns native‑instruktioner medan programmet körs. Så fungerar många moderna övergångar: installera dina befintliga appar och ett kompatibilitetslager översätter tyst.

Värdet är enkelt: du kan köpa ny hårdvara utan att vänta på att varje leverantör ska kompilera om.

Kompatibilitetslager fungerar bäst för mainstream‑appar och kämpar i kanten:

Hårdvarustöd är ofta den verkliga blockeraren.

Virtualisering hjälper när du behöver en hel legacy‑miljö (en specifik Windows‑version, en gammal Java‑stack, en affärsapplikation). Det är operativt rent—snapshots, isolering, enkel rollback—men beror på vad du virtualiserar.

VM:er med samma arkitektur kan vara nära nativa; tvärarkitektur‑VM:er faller ofta tillbaka på emulering och blir långsamma.

En bro är vanligtvis tillräcklig för kontorsappar, webbläsare och vardaglig produktivitet—där ”tillräckligt snabbt” vinner. Den är mer riskfylld för:

I praktiken köper broar tid—men undanröjer sällan allt migreringsarbete.

Argument om CPU:er låter ofta som en enda resultattavla: ”snabbare vinner.” I verkligheten vinner plattformar när de matchar begränsningarna för enheter och de arbetslaster människor faktiskt kör. x86 blev standard för PC:er delvis eftersom det gav stark topprestanda på nätström och eftersom industrin byggde allt annat runt det antagandet.

Stationära och bärbara köpare har historiskt premierat rapp interaktiv prestanda: öppna appar, kompilera kod, spela spel, tunga kalkylblad. Det skapar tryck mot höga boost‑klockor, breda kärnor och aggressiv turbo—bra när du kan konsumera watt fritt.

Energieffektivitet är en annan spelplan. Om din produkt är begränsad av batteri, värme, fläktljud eller tunn design är den bästa CPU:n den som gör ”tillräckligt” arbete per watt, konsekvent, utan att termik sänker prestandan efter en minut.

Effektivitet handlar inte bara om att spara energi; det handlar om att hålla sig inom termiska gränser så att prestandan inte kollapsar.

Telefoner och surfplattor lever i snäva energienveloppar och har alltid varit kostnadskänsliga i massiv volym. Den miljön belönade designer optimerade för effektivitet, integrerade komponenter och förutsägbart termiskt beteende.

Det skapade också ett ekosystem där operativsystem, appar och kisel utvecklades tillsammans under mobil‑första‑antaganden.

I datacenter är ett CPU‑val sällan bara ett benchmarkbeslut. Operatörer bryr sig om tillförlitlighetsfunktioner, långa supportfönster, stabil firmware, övervakning och ett moget ekosystem av drivrutiner, hypervisorer och management‑verktyg.

Även när en ny arkitektur ser attraktiv ut i perf/watt kan risken för operativa överraskningar väga tyngre än vinsten.

Moderna serverarbetsbelastningar är mångsidiga: webbservering gynnar genomströmning och effektiv skalning; databaser premierar minnesbandbredd, latenskonsistens och beprövad tuning; AI flyttar i ökande grad värde till acceleratorer och mjukvarustackar.

När mixen förändras kan den vinnande plattformen också skifta—men endast om det omgivande ekosystemet hänger med.

En ny CPU‑arkitektur kan vara tekniskt utmärkt och ändå misslyckas om vardagsverktygen inte gör det lätt att bygga, leverera och supporta mjukvara. För de flesta team är ”plattform” inte bara instruktionsuppsättningen—det är hela leveranspipen.

Kompilatorer, debuggers, profilerare och kärnbibliotek formar tyst utvecklarbeteenden. Om de bästa kompilatorflaggorna, stacktraces, sanitizers eller prestandaverktyg kommer sent (eller beter sig annorlunda) tvekar team att satsa.

Även små luckor spelar roll: ett saknat bibliotek, en ostabil debugger‑plugin eller en långsammare CI‑build kan förvandla ”vi kan porta detta” till ”vi skjuter upp det till nästa kvartal.” När x86‑toolchainen är default i IDE:er, byggsystem och CI‑mallar dras utvecklare tillbaka mot den enkla vägen.

Mjukvara når användare genom paketeringskonventioner: installationsprogram, uppdaterare, repos, app‑stores, containrar och signerade binärer. Ett plattformsbyte ställer obekväma frågor:

Om distribution blir rörig ökar supportkostnaderna—och många leverantörer undviker det.

Företag köper plattformar de kan hantera i skala: imaging, enhetsregistrering, policyer, endpoint‑security, EDR‑agenter, VPN‑klienter och compliance‑rapportering. Om någon av dessa verktyg halkar efter på en ny arkitektur stannar pilotprojekten.

”Fungerar på min maskin” är irrelevant om IT inte kan rulla ut och säkra den.

Utvecklare och IT konvergerar på en praktisk fråga: hur snabbt kan vi leverera och supporta? Verktyg och distribution svarar ofta mer avgörande än råa benchmarks.

Ett praktiskt sätt att minska migrationsfriktion är att förkorta tiden mellan idé och testbar build—särskilt när man validerar samma applikation över olika miljöer (x86 vs ARM, olika OS‑bilder eller distributionsmål).

Plattformar som Koder.ai passar in i detta arbetsflöde genom att låta team generera och iterera verkliga applikationer via en chattgränssnitt—vanligtvis React‑baserade webb‑frontend, Go‑backends och PostgreSQL‑databaser (plus Flutter för mobil). För plattforms‑övergångsarbete är två funktioner särskilt relevanta:

Eftersom Koder.ai stödjer export av källkod kan det också fungera som en bro mellan experiment och en konventionell ingenjörspipeline—nyttigt när du behöver gå fort men ändå lämna hållbar kod i ditt eget repo.

ARMs framfart i laptops och desktops är en nyttig verklighetskontroll av hur svåra plattformsövergångar verkligen är. På papperet är budskapet enkelt: bättre prestanda per watt, tystare maskiner, längre batteritid.

I praktiken avgörs framgång mindre av CPU‑kärnan och mer av allt runt omkring—appar, drivrutiner, distribution och vem som har makten att samordna incitament.

Apples övergång från Intel till Apple Silicon fungerade främst därför att Apple kontrollerar hela stacken: hårdvara, firmware, operativsystem, utvecklarverktyg och primära app‑kanaler.

Den kontrollen lät företaget göra en ren brytning utan att vänta på att dussintals oberoende parter skulle röra sig i takt.

Det möjliggjorde också en koordinerad ”bro”‑period: utvecklare fick tydliga mål, användare fick kompatibilitetsvägar, och Apple kunde sätta press på nyckelleverantörer att leverera natíva byggen. Även när vissa appar inte var natíva förblev användarupplevelsen ofta acceptabel eftersom övergångsplanen designades som en produkt, inte bara ett processorbyte.

Windows‑on‑ARM visar andra sidan. Microsoft kontrollerar inte hårdvaru‑ekosystemet fullt ut, och Windows‑PC:er är beroende av OEM‑val och en lång svans av drivrutiner.

Det skapar vanliga blockeringspunkter:

ARMs framsteg stärker en kärnlektion: att kontrollera mer av stacken gör övergångar snabbare och mindre fragmenterade.

När du förlitar dig på partners behöver du ovanligt stark samordning, tydliga uppgraderingsvägar och ett skäl för varje aktör—chipleverantör, OEM, utvecklare och IT‑köpare—att prioritera flytten samtidigt.

Plattformsbyten misslyckas av tråkiga skäl: den gamla plattformen fungerar fortfarande, alla har redan betalat för den (i pengar och vanor), och kantfallen är där riktiga affärer lever.

En ny plattform vinner oftast bara när tre saker sammanfaller:

Först: nyttan måste vara uppenbar för vanliga köpare—not bara ingenjörer: bättre batteritid, avsevärt lägre kostnader, nya formfaktorer eller ett steg‑byte i prestanda för vanliga uppgifter.

Andra: det måste finnas en trovärdig kompatibilitetsplan: bra emulering/översättning, enkla ”universal”‑byggen och tydliga vägar för drivrutiner, kringutrustning och företagsverktyg.

Tredje: incitamenten måste samlas över kedjan: OS‑leverantör, chipleverantör, OEM:er och apputvecklare måste alla se fördelar och ha skäl att prioritera migreringen.

Framgångsrika övergångar liknar mer kontrollerad överlappning än en strömbrytare. Faserade utrullningar (pilotgrupper först), dubbla byggen (gammalt + nytt) och telemetri (kraschfrekvenser, prestanda, funktionsanvändning) låter team fånga problem tidigt.

Lika viktigt: publicerat supportfönster för den gamla plattformen, tydliga interna deadlines och en plan för användare som ”inte kan flytta än”.

x86 har fortfarande enormt momentum: decennier av kompatibilitet, inarbetade företagsarbetsflöden och ett brett utbud av hårdvarualternativ.

Men press byggs upp från nya behov—energieffektivitet, tätare integrering, AI‑fokuserad beräkning och enklare enhetsflottor. De svåraste striderna handlar inte om rå hastighet; de handlar om att få bytet att kännas säkert, förutsägbart och värt kostnaden.

x86 är en CPU‑instruktionsuppsättning (ISA): mängden maskinkodsinstruktioner som mjukvara i slutänden kör.

”Dominans” i det här inlägget betyder den sammanlagda fördelen av höga försäljningsvolymer, det största programkataloget och standard‑mindsetet—inte bara ledning i benchmark‑tester.

En ISA är det ”språk” en CPU förstår.

Om en app är kompilerad för x86 körs den natívt på x86‑processorer. Om du byter till en annan ISA (som ARM) behöver du i regel en natív omkompilering, eller så förlitar du dig på översättning/emulering för att köra den gamla binären.

Bakåtkompatibilitet gör att nyare maskiner kan fortsätta köra äldre mjukvara med små ändringar.

I PC‑världen är det en produktförväntning: uppgraderingar ska inte tvinga dig att skriva om appar, byta arbetsflöden eller överge ”det där gamla verktyget” som ändå behövs.

De kan ändra hur en chip exekverar instruktioner (mikroarkitektur) samtidigt som de behåller själva instruktionerna (ISA) stabila.

Därför kan du få stora förbättringar i prestanda, cache och energibeteende utan att gamla binärer går sönder.

Vanliga brytpunkter inkluderar:

Ofta fungerar huvudappen, men runtomkringliggande ”limmet” gör det svårt att byta.

Ofta är det saknade drivrutiner eller osupporterade enheter som stoppar bytet.

En kompatibilitetslager kan översätta en applikation, men det kan inte frambringa en stabil kärndrivrutin för en nischad scanner, kassahårdvara eller USB‑säkerhetsnyckel om leverantören aldrig levererat en sådan.

Det avgörs av installationsbasen.

Om majoriteten av kunderna använder Windows x86 prioriterar leverantörer den bygget, testmatrisen och supporten. Att stödja en annan arkitektur innebär fler CI‑byggen, fler QA‑kombinationer, mer dokumentation och högre supportbörda, vilket många team väntar med tills efterfrågan är uppenbar.

Inte pålitligt.

Omkoppling (rekompilering) är bara en del. Du kan också behöva:

Det svåraste är oftast att bevisa att den nya bygget är korrekt och stödbar i verkliga miljöer.

De är bryggor, inte botemedel:

De ger tid för ekosystemet att hinna ikapp, men drivrutiner och lågnivåkomponenter förblir hårda gränser.

Gör det som ett checklist‑styrt pilotprojekt:

Behandla bytet som en kontrollerad utrullning med rollback‑möjligheter, inte ett ”stort-bang”-skifte.