02 okt. 2025·8 min

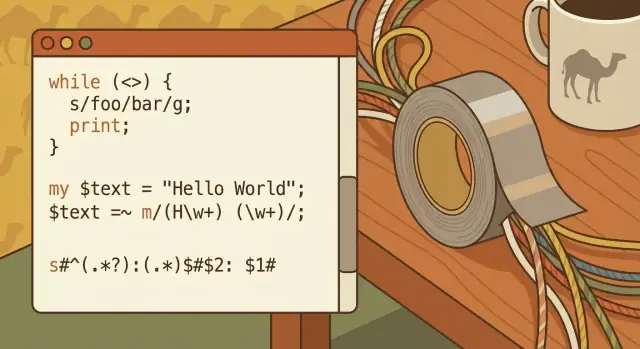

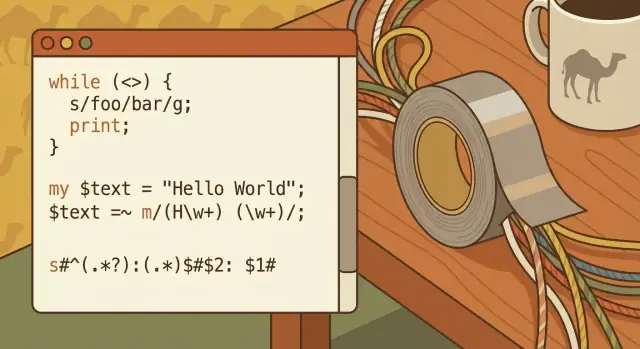

Larry Wall, Perl och tejp‑mentaliteten för textarbete

Hur Larry Walls "duct tape"‑filosofi gjorde Perl till en arbetshäst för webbautomation — och vad den fortfarande lär oss om praktisk textbearbetning idag.

Hur Larry Walls "duct tape"‑filosofi gjorde Perl till en arbetshäst för webbautomation — och vad den fortfarande lär oss om praktisk textbearbetning idag.

"Duct tape‑programmering" är idén att det bästa verktyget ofta är det som löser ditt verkliga problem snabbt—även om lösningen inte är vacker, inte permanent och inte designad som ett stort system.

Det handlar inte om att göra slarvigt arbete. Det handlar om att värdera tempo när du står inför rörig indata, ofullständiga specifikationer och en deadline som inte bryr sig om hur elegant din arkitekturdiagram är.

Tejp‑mentaliteten börjar med en enkel fråga: Vad är den minsta ändringen som får smärtan att försvinna? Det kan vara ett kort skript för att byta namn på 10 000 filer, ett snabbt filter för att extrahera felrader ur loggar, eller en engångstransformering som gör en kaotisk export läsbar i ett kalkylblad.

Den här artikeln använder Larry Wall och Perl som en historisk berättelse om den attityden i praktiken—men poängen är inte nostalgi. Den är att dra ut praktiska lärdomar som fortfarande gäller när du jobbar med text, loggar, CSV, HTML‑bitar eller "data" som egentligen bara är en hög inkonsekventa strängar.

Om du inte är en professionell utvecklare men regelbundet jobbar med:

…så är du precis målgruppen.

I slutet bör du ha fyra tydliga insikter:

Larry Wall satte inte upp för att uppfinna ett "smartspråk". Han var ingenjör och systemadministratör som tillbringade dagarna med att hantera trotsig text: loggfiler, rapporter, konfigurationsbitar, e‑posthuvuden och ad‑hoc‑datadumpar som aldrig riktigt matchade formatet i manualen.

I mitten av 1980‑talet hade Unix redan utmärkta verktyg—sh, grep, sed, awk, pipes och filter. Men verkliga jobb sällan passar i ett enda prydligt kommando. Du börjar med en pipeline och upptäcker att du behöver ett litet tillståndsautomaton, bättre stränghantering, ett återanvändbart skript och ett sätt att hålla det tillräckligt läsbart så att du kan fixa det nästa vecka.

Larrys motivation var praktisk: minska friktionen i det som kallas "limarbete", det osexiga men ständiga arbetet med att koppla ihop verktyg och transformera text tills något användbart dyker upp.

Perls ursprungliga mål var inte att ersätta Unix‑verktygen—det var att göra dem enklare att orkestrera när en one‑liner‑pipeline växte till ett mini‑program. Istället för att hoppa mellan flera verktyg (var och ett med sina egna quoting‑regler och kantfall) erbjöd Perl ett ställe att:

Det är tejp‑mentaliteten: inte perfektion, utan en snabb, hållbar lösning som håller ihop saker.

Perl‑kulturen omfamnade värden som matchade vardagsverkligheten: pragmatism framför renlärighet, uttrycksfullhet framför ceremonier, och det berömda "There’s more than one way to do it." Dessa var inte slogans för syns skull—de gav tillåtelse att lösa problemet framför dig med minsta möjliga smärta.

Perls tidiga popularitet kan låta mystisk i efterhand. Det var den inte. Det matchade helt enkelt vad team behövde då: ett språk som kunde överleva rörig indata, integrera med befintliga system och låta en trött människa skicka ett fungerande skript innan nästa larmsignal.

Tidiga webbplatser var inte drivna av ramverk och managed services. Många var en webbserver plus en katalog med CGI‑skript, några platta filer och kanske en enkel databas som ännu inte kändes "central" för allt.

Driften var loggtung: accessloggar, errorloggar, uppladdningsmappar, e‑postinkorgar som tog emot formulärsvar, och textfiler som tyst blev databaser. När något gick sönder diagnosticerade man ofta genom att greppa igenom gårdagens loggar och justera ett skript.

Automation var helt enkelt: en uppgift som körs upprepade gånger utan att någon gör den manuellt varje gång.

Den uppgiften kunde triggas av en webbförfrågan (någon skickar ett formulär, klickar "sök", laddar ner en rapport), eller av en schemalagd körning (cron kör varje timme för att rotera loggar, återbygga sidor, skicka sammanfattningar).

Även små sajter behövde:

Att göra detta manuellt slösade inte bara tid—det introducerade fel och fördröjningar.

Perl passade snyggt mellan det som redan fanns:

grep, sed, awk, sort) som var bra på enkla stegPerl kunde läsa en begäran, köra systemkommandon, transformera rörig text och skriva HTML eller uppdatera en fil—alltsammans i ett skript. Den rollen som "limspråk" gjorde tidig webbautomation praktisk: det kopplade ihop delar som var användbara var för sig men krångliga att kedja ihop säkert och upprepningsbart.

Perl fick sitt "tejp"‑rykte för att det kunde sitta mellan klassiska Unix‑kommandoradsverktyg och den nya världen av webbscripting. Om din data började som loggfiler, mejl, CSV‑exporter eller HTML‑bitar kunde Perl hämta det, forma om det och lämna vidare—utan att tvinga dig att anta en helt ny miljö.

Direkt ur lådan gjorde Perl textmanipulation ovanligt direkt:

split, join, replace) som motsvarar verkliga städuppgifterDenna kombination innebar att du inte behövde en lång verktygskedja för vardaglig parsing och redigering.

Unix uppmuntrar små, fokuserade program som kopplas ihop. Perl kunde vara en sådan del: läsa från standardinmatning, transformera texten och skriva resultatet för nästa verktyg i kedjan.

En vanlig mental modell var:

read → transform → write

Till exempel: läs serverloggar, normalisera ett datumformat, ta bort brus och skriv en rensad fil—kanske pipad in i sort, uniq eller grep före eller efter. Perl ersatte inte Unix‑verktyg; det limmade ihop dem när "awk + sed + shell"‑kombon började bli besvärlig.

Samma skript‑först‑tänk följde med in i tidig webbutveckling. Ett Perl‑skript kunde acceptera formulärdata, behandla det som vilken annan textström som helst och skriva ut HTML som svar—vilket gjorde det till en praktisk bro mellan systemverktyg och webbsidor.

Eftersom Perl kördes på många Unix‑lika system kunde team ofta flytta samma skript mellan maskiner med minimala förändringar—värdefullt när driftsättningar var enkla, manuella och frekventa.

Reguljära uttryck (regex) är ett sätt att beskriva textmönster—som ett "sök och ersätt"‑verktyg, men med regler istället för exakta ord. Istället för att söka efter den bokstavliga strängen [email protected] kan regex säga "hitta allt som ser ut som en e‑postadress." Denna förskjutning—från exakt matchning till mönstermatchning—är vad som gjorde mycket tidig automation möjlig.

Tänk på regex som ett mini‑språk för att svara på frågor som:

Om du någonsin klistrat in text i ett kalkylblad och önskat att den magiskt skulle dela sig i kolumner, då ville du ha regex.

Tidiga webbscripts levde på rörig indata: formulärfält skrivna av människor, loggar från servrar och filer hopfogade från olika system. Regex gjorde det praktiskt att snabbt göra tre högt värderade jobb:

Validera indata (t.ex. "det här ser ut som en URL", "det här ser ut som ett datum").

Extrahera fält (t.ex. plocka ut statuskod och sökväg ur en loggrad).

Skriva om innehåll (t.ex. normalisera telefonnummer, ersätta gamla länkar, sanera användarinmatning innan sparande).

Perls regex‑stöd fanns inte bara där—det var designat för ständig användning. Det passade perfekt med tejp‑mentaliteten: ta inkonsekvent text, applicera några riktade regler och få något tillräckligt stabilt för att släppas.

Regex lyser på den slags "nästan strukturerade" text folk dagligen möter:

12/26/25 till 2025‑12‑26 eller känna igen flera datumformat.Regex är så kraftfullt att det blir kryptiskt. Ett kort, smart mönster kan vara svårt att granska, svårt att debugga och lätt att bryta när inputformatet ändras.

Ett underhållbart tillvägagångssätt är att hålla mönstren små, lägga till kommentarer (där språket stödjer det) och föredra två tydliga steg framför ett "geniuttryck" när någon annan behöver röra det nästa månad.

Perl one‑liners är bäst att tänka på som pytteskript: små, enkelriktade kommandon du kan köra direkt i terminalen för att transformera text. De glänser när du behöver en snabb städning, en engångsmigrering eller en snabb kontroll innan du bestämmer dig för att skriva ett fullständigt program.

En one‑liner läser vanligtvis från standardinmatning, gör en ändring och skriver ut resultatet. Till exempel, ta bort tomma rader från en fil:

perl -ne 'print if /\\S/' input.txt \u003e output.txt

Eller extrahera specifika "kolumner" från blankstegsseparerad text:

perl -lane 'print \"$F[0]\\t$F[2]\"' data.txt

Och för batch‑namngivning kan Perl styra filoperationer med lite mer kontroll än ett grundläggande rename‑verktyg:

perl -e 'for (@ARGV){(my $n=$_)=~s/\\s+/_/g; rename $_,$n}' *

(Det sista byter ut mellanslag mot understreck.)

One‑liners är lämpliga när:

Skriv ett riktigt skript när:

"Snabbt" borde inte betyda "ospårbart." Spara din shell‑historia (eller klistra in kommandot i en anteckning i repo:t), inkludera ett före/efter‑exempel och notera vad som ändrades och varför.

Om du kör samma one‑liner två gånger är det en signal att packa in den i ett litet skript med ett filnamn, kommentarer och en förutsägbar in/ut‑väg.

CPAN (Comprehensive Perl Archive Network) är, enkelt uttryckt, en gemensam modulhylla för Perl: en publik samling återanvändbara moduler som vem som helst kan ladda ner och använda.

Istället för att skriva allt från början kunde små team plocka en vältestad modul och fokusera på sitt verkliga problem—att skicka ett skript som fungerade idag.

Många vardagliga webbuppgifter blev plötsligt möjliga för en enskild utvecklare eftersom CPAN erbjöd byggstenar som annars skulle ta dagar eller veckor att återskapa. Vanliga exempel:

Det spelade roll eftersom tidig webbautomation ofta var "ett skript till" i ett redan upptaget system. CPAN gjorde att skriptet kunde sättas ihop snabbt—och ofta säkrare—genom att luta sig mot kod som redan använts i verkligheten.

Avvägningen är verklig: beroenden är en form av åtagande.

Att dra in moduler kan spara tid omedelbart, men det betyder också att du måste tänka på versionskompatibilitet, säkerhetsuppdateringar och vad som händer om en modul blir ounderhållen. En snabb vinst idag kan bli en förvirrande uppgradering imorgon.

Innan du litar på en CPAN‑modul, välj moduler som tydligt underhålls:

När CPAN används med eftertanke är det ett av de bästa uttrycken för tejp‑mentaliteten: återanvänd det som fungerar, håll tempot uppe och bygg inte infrastruktur du inte behöver.

CGI (Common Gateway Interface) var "kör ett program"‑fasen av webben. En begäran nådde servern, servern startade ditt Perl‑skript, skriptet läste indata (ofta från miljövariabler och STDIN) och skrev sedan en respons—vanligtvis en HTTP‑header och en blob HTML.

I sin enklaste form gjorde skriptet:

name=Sam\u0026age=42)Content‑Type: text/html) och sedan HTMLDen modellen gjorde det enkelt att snabbt leverera något användbart. Den gjorde det också enkelt att snabbt leverera något riskfyllt.

Perl CGI blev genvägen för praktisk webbautomation:

Det var ofta små teamvinster: ett skript, en URL, omedelbart värde.

Eftersom CGI‑skript körs per förfrågan multiplicerades små misstag:

Hastighet är en fördel—men bara med gränser. Även snabba skript behöver klar validering, noggrann quoting och förutsägbara utdataregler—vanor som fortfarande lönar sig oavsett om du skriver ett litet adminverktyg eller en modern web‑endpoint.

Perl fick rykte om att vara svårt att läsa eftersom det gjorde listiga lösningar enkla. Tät, interpunktionstung syntax, mycket kontextberoende beteende och kulturen "det finns flera sätt att göra det" uppmuntrade kort, imponerande kod. Det är toppen för en snabb fix vid 02:00—men sex månader senare kan inte ens originalförfattaren minnas vad en one‑liner egentligen gjorde.

Underhållsproblemet är inte att Perl är unikt oläsbart—det är att Perl låter dig komprimera avsikt tills den försvinner. Vanliga bovar är tätt packade regex utan kommentarer, tung användning av implicita variabler som $_ och smarta trick (side‑effects, inbäddade ternärer, magiska default) som sparar rader men kostar förståelse.

Ett par vanor förbättrar läsbarheten drastiskt utan att sakta ner dig:

Perl‑gemenskapen normaliserade enkla räcken som många språk senare antog: aktivera use strict; och use warnings;, skriv grundläggande tester (även några sanity‑checks) och dokumentera antaganden med inline‑kommentarer eller POD.

Dessa praktiker gör inte koden "enterprise"—de gör den överlevbar.

Den bredare lärdomen gäller för alla språk: skriv för ditt framtida jag och för dina kollegor. Det snabbaste skriptet är det som kan ändras säkert när kraven ofrånkomligen skiftar.

Textarbete har inte blivit renare—det har bara flyttat runt. Du kanske inte underhåller CGI‑skript längre, men du hanterar fortfarande CSV‑exporter, SaaS‑webhooks, loggfiler och "tillfälliga" integrationsflöden som blir permanenta. Samma praktiska färdigheter som gjorde Perl användbart sparar fortfarande tid (och förhindrar tyst datakorruption).

De flesta problem är inte "svår parsing", utan inkonsekvent indata:

1,234 vs 1.234, datum som 03/04/05, månadsnamn på olika språk.Behandla all indata som otrustad, även om den kommer från "vårt system." Normalisera tidigt: välj en kodning (vanligtvis UTF‑8), standardisera radslut, trimma uppenbart brus och konvertera till ett konsekvent schema.

Validera sedan antaganden uttryckligen: "denna fil har 7 kolumner", "ID:n är numeriska", "tidsstämplar är ISO‑8601." När något går sönder—faila högljutt och spela in vad du såg (provrad, radnummer, källfil).

När du kan, föredra tydliga format och riktiga parsers framför smart splittrande. Får du JSON—parsa JSON. Får du CSV—använd en CSV‑parser som förstår citat. Att gissa fungerar tills ett kantfall (som ett kommatecken i ett namn) tyst korruptar ditt resultat.

Dessa färdigheter lönar sig i vardagliga uppgifter: filtrera applikationsloggar under incidenter, rensa finansexporter, transformera CRM‑importer, bygga broar för API‑integrationer och göra engångs datamigreringar där "nästan rätt" fortfarande är fel.

Perls "tejp"‑rykte handlade inte om slarv—det handlade om användbarhet. Det arvet syns varje gång ett team behöver ett litet skript för att stämma av exporter, normalisera loggar eller omforma en hög semistrukturerad text till något ett kalkylblad eller en databas kan äta.

Idag faller ofta valet på Python, Ruby eller JavaScript (Node.js). Deras roller överlappar: snabb automation, integration med andra system och limkod mellan verktyg.

Perls klassiska styrkor var (och är) direkt åtkomst till operativsystemet, uttrycksfull textmanipulation och en kultur av "få jobbet gjort." Python betonar läsbarhet och ett brett standardbibliotek; Ruby har ofta bättre ergonomi för utvecklare och webbcentrerade konventioner; JavaScript ger allestädes närvaro och lätt distribution där Node körs.

Mycket av dagens arbete formas av ramverk, stabila API:er, molntjänster och bättre verktyg. Uppgifter som förr krävde egna skript har nu managed services, hostade köer och färdiga connectors.

Distribution ser också annorlunda ut: containers, CI‑pipelines och versionspinnande är förväntat, inte valfritt.

Verklighetens text är fortfarande rörig. Loggar innehåller överraskningar, exporter innehåller "kreativ" formatering och data måste fortfarande transformeras noggrant för att bli pålitlig.

Det är den bestående lärdomen Perl gav: de osexiga 80 % av automationen är parsing, städning, validering och att producera förutsägbart utdata.

Det bästa valet är vanligtvis det som ditt team kan underhålla: vana vid språket, ett starkt ekosystem och realistiska driftsättningsbegränsningar (vad som är installerat, vad säkerhet tillåter, vad ops kan stödja). Perls arv är inte "använd alltid Perl"—det är "välj verktyget som passar röran du faktiskt har."

Det är också värt att notera att "tejp"‑instinkten återkommer i moderna AI‑stödda arbetsflöden. Till exempel kan en vibe‑coding‑plattform som Koder.ai vara användbar när du behöver ett snabbt internt verktyg (en loggvisare, en CSV‑normaliserare eller ett litet admin‑UI) och du föredrar att iterera via chatt istället för att bygga allt från grunden. Samma försiktighet gäller: skicka snabbt, men håll resultatet läsbart, testbart och lätt att rulla tillbaka om dagens "tillfälliga" fix blir morgondagens kritiska väg.

Det är ett pragmatiskt förhållningssätt: använd den minsta effektiva ändringen som snabbt löser det verkliga problemet, särskilt när indatan är rörig och specifikationen ofullständig.

Det är inte en ursäkt för slarv. ”Tejp‑delen” handlar om att nå ett fungerande resultat och sedan lägga till precis tillräcklig säkerhet (tester, backup, anteckningar) så att fixen inte blir en fälla senare.

Använd regeln "en gång till": om du gör samma manuella städning två gånger, automatisera den.

Bra kandidater är:

Om uppgiften påverkar produktionsdata, lägg på skydd (dry run, backup, validering) innan du kör.

Se en‑linjare som ett litet skript:

Om kommandot blir långt, behöver felhantering eller återanvändas — gör om det till ett riktigt skript med argument och tydliga in/ut‑vägar.

Regex är bäst när texten är "nästan strukturerad" (loggar, mejl, ID:n, ojämna separatorer) och du behöver validera, extrahera eller skriva om mönster.

För att hålla dem läsbara:

En snabb fix blir "för alltid" när den används upprepade gånger, andra börjar bero på den, eller den byggs in i ett arbetsflöde (cron, pipelines, dokumentation).

Tecken på att du bör hårdna upp den:

Då ska du lägga till validering, loggning, tester och en tydlig README som beskriver antaganden.

CPAN kan spara dagar, men varje beroende är ett åtagande.

Praktisk urvalschecklista:

Planera också distribution: pinna versioner, dokumentera installsteg och följ säkerhetsuppdateringar.

Den största CGI‑eran‑lärdomen är: snabbhet utan gränser skapar sårbarheter.

Om du tar emot data från användare eller andra system:

Dessa vanor gäller fortfarande för moderna skript, serverless‑funktioner och web‑endpoints.

Vanliga fallgropar:

Normalisera tidigt (kodning, radslut), validera antaganden (kolumnantal, obligatoriska fält) och faila högljutt med ett prov på den felande raden.

Tummen‑regeln: om det är ett verkligt format, använd en riktig parser.

Regex och ad‑hoc‑splitting är bra för mönsterutvinning och lättare städning—tills ett kantfall (t.ex. ett kommatecken i ett namn) tyst korruptar dina data.

Välj det verktyg ditt team kan köra och underhålla inom de faktiska begränsningarna:

Perls arv här är en princip: välj verktyget som passar röran du faktiskt har, inte arkitekturen du önskar att du hade.