15 nov. 2025·8 min

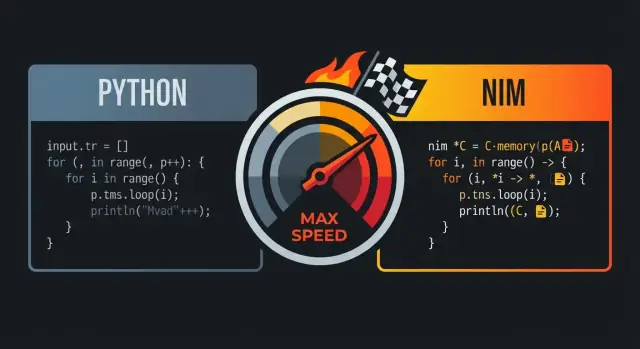

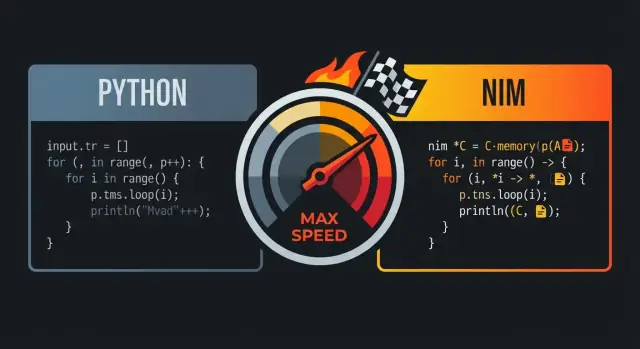

Hur Nim känns som Python men kör nära C-hastighet

Lär dig hur Nim behåller läsbar, Python-lik kod samtidigt som den kompilerar till snabba native-binaries. Se vilka funktioner som i praktiken möjliggör C-lik hastighet.

Lär dig hur Nim behåller läsbar, Python-lik kod samtidigt som den kompilerar till snabba native-binaries. Se vilka funktioner som i praktiken möjliggör C-lik hastighet.

Nim jämförs ofta med Python och C eftersom det söker den gyllene mittpunkten: kod som läses som ett högnivå-skriptsspråk, men som kompileras till snabba, native-exekverbara filer.

Vid första anblick känns Nim ofta ”Pythoniskt”: ren indentering, okomplicerat kontrollflöde och ett uttrycksfullt standardbibliotek som uppmuntrar tydlig, kompakt kod. Nyckelskillnaden är vad som händer efter att du skrivit koden—Nim är designat för att kompileras till effektiv maskinkod istället för att köras på ett tungt runtime.

För många team är den kombinationen poängen: du kan skriva kod som liknar det du skulle prototypa i Python, men leverera det som en enda native-binary.

Denna jämförelse talar mest till:

”C-nivå prestanda” betyder inte att varje Nim-program automatiskt matchar handtweakad C. Det betyder att Nim kan generera kod som är konkurrenskraftig med C för många arbetsbelastningar—särskilt där overhead spelar roll: numeriska loopar, parsing, algoritmer och tjänster som behöver förutsägbar latens.

Du ser vanligtvis de största vinsterna när du tar bort tolkningsöverhuvud, minimerar allokeringar och håller heta kodvägar enkla.

Nim räddar inte en ineffektiv algoritm, och du kan fortfarande skriva långsam kod om du allokerar för mycket, kopierar stora datastrukturer eller ignorerar profilering. Löftet är att språket ger en väg från läsbar kod till snabb kod utan att skriva om allt i ett annat ekosystem.

Resultatet: ett språk som känns vänligt som Python, men som är villigt att vara ”nära metallen” när prestanda verkligen betyder något.

Nim beskrivs ofta som ”Python-lik” eftersom koden ser ut och flyter på ett bekant sätt: indenteringsbaserade block, minimal interpunktion och en preferens för läsbara, högnivå-konstruktioner. Skillnaden är att Nim är statiskt typat och kompilerat—så du får den rena ytan utan att betala en runtime-skatt för det.

Precis som Python använder Nim indentering för att definiera block, vilket gör kontrollflödet lätt att skumma i code reviews och diffs. Du behöver inte klamrar överallt, och du sällan parenteser om de inte ökar tydligheten.

let limit = 10

for i in 0..<limit:

if i mod 2 == 0:

echo i

Den visuella enkelheten spelar roll när du skriver prestandakritisk kod: du lägger mindre tid på att kämpa med syntax och mer tid på att uttrycka avsikten.

Många vardagskonstruktioner ligger nära vad Python-användare förväntar sig.

for-loopar över intervall och samlingar känns naturliga.let nums = @[10, 20, 30, 40, 50]

let middle = nums[1..3] # slice: @[20, 30, 40]

let s = "hello nim"

echo s[0..4] # "hello"

Skillnaden mot Python är vad som händer under huven: dessa konstruktioner kompileras till effektiv native-kod istället för att tolkas av en VM.

Nim är starkt statiskt typat, men förlitar sig mycket på type inference, så du slipper skriva verbösa typdeklarationer för att få jobbet gjort.

var total = 0 # inferred as int

let name = "Nim" # inferred as string

När du vill ha explicita typer (för publika API:er, tydlighet eller prestandakänsliga gränser) stödjer Nim det på ett rent sätt—utan att tvinga det överallt.

En stor del av ”läsbar kod” är att kunna underhålla den säkert. Nims kompilator är strikt på användbara sätt: den visar typmissmatchningar, oanvända variabler och tveksamma konverteringar tidigt, ofta med handfasta meddelanden. Den feedback-loopen hjälper dig hålla koden Python-enkel samtidigt som du får fördelarna av kompileringstidens korrekthetskontroller.

Om du gillar Pythons läsbarhet kommer Nims syntax kännas hemma. Skillnaden är att Nims kompilator kan validera antaganden och sedan producera snabba, förutsägbara native-binaries—utan att förvandla din kod till boilerplate.

Nim är ett kompilerat språk: du skriver .nim-filer och kompilatorn gör om dem till en native-exekverbar fil som du kan köra direkt på din maskin. Den vanligaste vägen går via Nims C-backend (och den kan också rikta mot C++ eller Objective-C), där Nim-kod översätts till backend-källkod och sedan kompileras av en systemkompilator som GCC eller Clang.

En native-binary körs utan en språkvirtuel maskin och utan en tolk som stegar genom din kod rad för rad. Det är en stor anledning till att Nim kan kännas högnivå men ändå undvika många av runtime-kostnaderna som associeras med bytecode-VM:er eller tolkar: uppstartstid är typiskt snabb, funktionsanrop är direkta och heta loopar kan köras nära hårdvaran.

Eftersom Nim kompileras i förväg kan verktygskedjan optimera över hela programmet. I praktiken kan det möjliggöra bättre inlining, borttagning av dödkod och link-time-optimisering (beroende på flaggor och din C/C++-kompilator). Resultatet är ofta mindre, snabbare exekverbara filer—särskilt jämfört med att leverera ett runtime plus källkod.

Under utveckling itererar du vanligtvis med kommandon som nim c -r yourfile.nim (kompilera och kör) eller använder olika bygglägen för debug vs release. När det är dags att leverera distribuerar du den producerade exekverbara filen (och eventuella behövda dynamiska bibliotek om du länkar mot dem). Det finns inget separat ”deployera tolken”-steg—din output är redan ett program som OS:et kan köra.

En av Nims största hastighetsfördelar är att den kan göra visst arbete vid kompilerings-tid (ibland kallat CTFE: compile-time function execution). I enkla termer: istället för att räkna ut något varje gång programmet körs, ber du kompilatorn räkna ut det en gång vid byggandet och baka in resultatet i den slutliga binären.

Runtime-prestanda äts ofta upp av ”setupkostnader”: bygga tabeller, parsa kända format, kontrollera invarians eller förberäkna värden som aldrig ändras. Om resultaten är förutsägbara från konstanter kan Nim flytta den ansträngningen till kompileringen.

Det innebär:

Generera uppslagstabeller. Om du behöver en tabell för snabb mappning (t.ex. ASCII-teckenklasser eller en liten hashkarta av kända strängar) kan du generera tabellen vid kompilerings-tid och lagra den som en konstant array. Programmet gör då O(1)-uppslag utan uppstartskostnad.

Validera konstanter tidigt. Om en konstant ligger utanför tillåtet område (en portnummer, en fast buffertstorlek, en protokollversion) kan du få bygget att misslyckas istället för att skicka en binär som upptäcker felet senare.

Förberäkna härledda konstanter. Masker, bitmönster eller normaliserade konfigurationsvärden kan beräknas en gång och återanvändas överallt.

Kompilerings-tidslogik är kraftfull, men det är fortfarande kod som någon måste förstå. Föredra små, välnamngivna hjälpfunktioner; lägg till kommentarer som förklarar ”varför nu” (kompileringstid) vs ”varför senare” (runtime). Testa också CTFE-hjälpare på samma sätt som vanliga funktioner—så optimeringar inte blir svåra att felsöka byggfel.

Nims makron förstås bäst som ”kod som skriver kod” under kompileringen. Istället för att köra reflektiv logik vid runtime (och betala för det vid varje exekvering) kan du generera specialiserad, typmedveten Nim-kod en gång och sedan skicka den resulterande snabba binären.

Ett vanligt användningsområde är att ersätta repetitiva mönster som annars skulle blåsa upp kodbasen eller lägga till per-anrop-overhead. Du kan till exempel:

if-satser utspridda i programmetEftersom makrot expanderar till vanlig Nim-kod kan kompilatorn fortfarande inlinea, optimera och ta bort döda grenar—så abstraktionen försvinner ofta i den slutliga exekverbara filen.

Makron möjliggör också lättviktig domänspecifik syntax. Team använder detta för att uttrycka avsikt tydligt:

Görs väl kan detta få call-siten att läsa som Python—ren och direkt—samtidigt som det kompileras ner till effektiva loopar och pekarsäkra operationer.

Metaprogrammering kan bli rörig om den förvandlas till ett dolt programspråk i projektet. Några tumregler:

Nims standard-minneshantering är en stor anledning till att det kan kännas ”Pythoniskt” samtidigt som det beter sig som ett systemspråk. Istället för en klassisk spårande garbage collector som periodvis går igenom minne för att hitta oåtkomliga objekt, använder Nim vanligtvis ARC (Automatic Reference Counting) eller ORC (Optimized Reference Counting).

En spårande GC arbetar i stötar: den pausar normalt arbete för att gå igenom objekt och avgöra vad som kan frigöras. Den modellen kan vara bra för utvecklarergonomi, men pauserna kan vara svåra att förutsäga.

Med ARC/ORC frigörs det mesta minnet när sista referensen försvinner. I praktiken ger det ofta mer konsekvent latens och gör det lättare att resonera kring när resurser frigörs (minne, filhandtag, sockets).

Förutsägbar minnesbeteende minskar ”överraskande” inbromsningar. Om allokeringar och frigöringar sker kontinuerligt och lokalt—istället för i tillfälliga globala städcykler—är programmets timing lättare att kontrollera. Det spelar roll för spel, servrar, CLI-verktyg och allt som behöver vara lyhört.

Det hjälper också kompilatorn att optimera: när livstider är tydligare kan kompilatorn ibland hålla data i register eller på stacken och undvika extra bokföring.

Som förenkling:

Nim låter dig skriva högnivåkod samtidigt som du bryr dig om livstider. Var uppmärksam på om du kopierar stora strukturer (duplicerar data) eller flyttar dem (överför ägarskap utan kopiering). Undvik oavsiktliga kopior i tighta loopar.

Om du vill ha ”C-lik hastighet” är den snabbaste allokeringen den du inte gör:

Dessa vanor passar bra med ARC/ORC: färre heap-objekt betyder mindre referensräkningstrafik och mer tid åt det som faktiskt gör nytta.

Nim kan kännas högnivå, men dess prestanda beror ofta på ett låg-nivåsdetalj: vad som allokeras, var det lever och hur det ligger i minnet. Om du väljer rätt former för din data får du snabbhet ”gratis”, utan att skriva oläsbar kod.

ref: var allokering skerDe flesta Nim-typer är värdetyper som standard: int, float, bool, enum och även vanliga object-värden. Värdetyper lever typiskt inline (ofta på stacken eller inbäddade i andra strukturer), vilket håller minnesåtkomst tät och förutsägbar.

När du använder ref (t.ex. ref object) ber du om en extra nivå av indirection: värdet lever vanligtvis på heapen och du manipulerar en pekare till det. Det kan vara användbart för delad, långlivad eller valfri data, men det kan lägga overhead i heta loopar eftersom CPU:n måste följa pekare.

Tumregeln: föredra vanliga object-värden för prestandakritisk data; använd ref när du verkligen behöver referenssemantik.

seq och string: bekvämt, men känn kostnadernaseq[T] och string är dynamiska, resizbara containrar. De är utmärkta för vardagsprogrammering, men de kan allokera och realokera när de växer. Kostnadsmönstret att bevaka:

seq eller strängar kan skapa många separata heap-blockOm du vet storlekar i förväg, förallokera (newSeq, setLen) och återanvänd buffertar för att minska churn.

CPU:er är snabbast när de läser kontinuerligt minne. En seq[MyObj] där MyObj är ett vanligt värdeobjekt är typiskt cachevänligt: elementen ligger intill varandra.

Men en seq[ref MyObj] är en lista med pekare spridda över heapen; att iterera den innebär hoppa runt i minnet, vilket är långsammare.

För tighta loopar och prestandakritisk kod:

array (fast storlek) eller seq av värdeobjektobjectref i ref) om det inte är nödvändigtDessa val håller data kompakt och lokal—precis vad moderna CPU:er gillar.

En anledning till att Nim kan kännas högnivå utan att betala mycket i runtime-kostnad är att många ”trevliga” språkliga funktioner är designade att kompileras till rak maskinkod. Du skriver uttrycksfull kod; kompilatorn sänker den till tighta loopar och direkta anrop.

En nollkostnadsabstraktion är en funktion som gör koden lättare att läsa eller återanvända, men inte lägger till extra arbete vid runtime jämfört med att skriva låg-nivå-versionen för hand.

Ett intuitivt exempel är att använda ett iterator-API för att filtrera värden, samtidigt som du i slutbina får en enkel loop i den slutliga binären.

proc sumPositives(a: openArray[int]): int =

for x in a:

if x > 0:

result += x

Trots att openArray ser flexibelt och ”högnivå” ut kompileras detta typiskt till en grundläggande indexerad genomgång av minnet (ingen Python-lik overhead). API:et är trevligt, men den genererade koden liknar ofta en motsvarande C-loop.

Nim inlinear aggressivt små procedurer när det hjälper, vilket betyder att anropet kan försvinna och kroppen klistras in i anroparen.

Med generics kan du skriva en funktion som fungerar för flera typer. Kompilatorn specialiserar den: skapar en skräddarsydd version för varje konkret typ du faktiskt använder. Det ger ofta kod som är lika effektiv som handskriven, typ-specifik kod—utan duplicerat arbete.

Mönster som små hjälpprocedurer (mapIt, filterIt-stil), distinct-typer och intervallkontroller kan optimeras bort när kompilatorn kan se igenom dem. Slutresultatet kan bli en enda loop med minimal branching.

Abstraktioner slutar vara ”gratis” när de skapar heap-allokeringar eller dolda kopior. Att returnera nya sekvenser upprepade gånger, bygga temporära strängar i innerloopar eller fånga stora closures kan introducera overhead.

Tumregel: om en abstraktion allokerar per iteration kan den dominera körtiden. Föredra stack-vänlig data, återanvänd buffertar och håll utkik efter API:er som tyst skapar nya seq eller string i heta vägar.

En praktisk anledning till att Nim kan kännas högnivå samtidigt som det är snabbt är att det kan anropa C direkt. Istället för att skriva om ett beprövat C-bibliotek i Nim kan du importera dess headerdeklarationer, länka det kompilerade biblioteket och kalla funktionerna nästan som om de vore inbyggda Nim-procedurer.

Nims foreign function interface (FFI) bygger på att beskriva de C-funktioner och typer du vill använda. I många fall:

importc (pekar på det exakta C-namnet), ellerEfter det länkar Nim-kompilatorn allt till samma native-binary, så anropskostnaden blir minimal.

Detta ger omedelbar tillgång till mogna ekosystem: kompression (zlib), kryptoprimitiver, bild-/ljud-codecs, databas-klienter, OS-API:er och prestandakritiska verktyg. Du behåller Nims läsbara, Python-lika struktur för applogiken samtidigt som du lutar dig mot battle-tested C för tung lyftning.

FFI-buggar kommer ofta av mismatchade förväntningar:

cstring är lätt, men du måste säkra null-terminering och livstid. För binär data, föredra explicita ptr uint8/längd-par.Ett bra mönster är att skriva ett litet Nim-wrapperlager som:

defer, destructors) när det är lämpligt.Det gör det mycket lättare att enhetstesta och minskar risken att låg-nivå-detaljer läcker in i resten av kodbasen.

Nim kan kännas snabbt “ur lådan”, men de sista 20–50% brukar bero på hur du bygger och hur du mäter. Goda nyheter: Nims kompilator exponerar prestandakontroller på ett tillgängligt sätt, även om du inte är systemexpert.

För riktiga prestandasiffror, undvik benchmark av debug-byggnader. Börja med en release-build och lägg bara till extra kontroller när du jagar buggar.

# Solid default för prestandatestning

nim c -d:release --opt:speed myapp.nim

# Mer aggressivt (färre runtime-kontroller; använd med försiktighet)

nim c -d:danger --opt:speed myapp.nim

# CPU-specifik tuning (bra för single-machine deployment)

nim c -d:release --opt:speed --passC:-march=native myapp.nim

En enkel regel: använd -d:release för benchmark och produktion, och reservera -d:danger när du redan byggt förtroende med tester.

Ett praktiskt flöde ser ofta ut så här:

hyperfine eller vanliga time räcker ofta.--profiler:on) och fungerar bra med externa profilerare (Linux perf, macOS Instruments, Windows-verktyg) eftersom du producerar native-binaries.När du använder externa profilerare, kompilera med debug-info för att få läsbara stacktraces och symboler under analys:

nim c -d:release --opt:speed --debuginfo myapp.nim

Det är frestande att tweaka smådetaljer (manuell loop-unrolling, rearrangera uttryck, ”kluriga” tricks) innan du har data. I Nim kommer större vinster oftast från:

Prestandaregressioner är lättast att fixa när de fångas tidigt. Ett lättviktigt tillvägagångssätt är att lägga till ett litet benchmarksuite (ofta via en Nimble-task som nimble bench) och köra det i CI på en stabil runner. Spara baslinjer (även som enkel JSON-output) och låt bygget misslyckas när nyckelmetrik rör sig utanför en tillåten gräns. Det håller "snabbt idag" från att bli "långsamt nästa månad" utan att någon märker det.

Nim är ett starkt val när du vill ha kod som läser som ett högnivåspråk men levererar som en snabb, enda körbar fil. Det belönar team som bryr sig om prestanda, enkel distribution och att hålla beroenden under kontroll.

Många team hittar Nim användbart i produktlika sammanhang—saker du kompilerar, testar och distribuerar.

Nim kan vara mindre idealiskt när framgången beror mer på runtime-dynamik än kompilerad prestanda.

Nim är tillgängligt, men det finns fortfarande en inlärningskurva.

Välj ett litet, mätbart projekt—som att skriva om ett långsamt CLI-steg eller ett nätverksverktyg. Definiera framgångsmetrik (körtid, minne, byggtid, deploystorlek), leverera till en liten intern publik och avgör baserat på resultat, inte hype.

Om ditt Nim-arbete behöver en omgivande produktyta—en admin-dashboard, en benchmark-runner UI eller en API-gateway—kan verktyg som Koder.ai hjälpa dig att skissa de bitarna snabbt. Du kan vibe-codea ett React-frontend och en Go + PostgreSQL-backend, och integrera din Nim-binary som en tjänst via HTTP, så att det prestandakritiska kärnet ligger i Nim medan du snabbare bygger allt runt omkring.

Nim tjänar sitt rykte ”Python-lik men snabb” genom att kombinera läsbar syntax med en optimerande native-kompilator, förutsägbar minneshantering (ARC/ORC) och en kultur som bryr sig om datalayout och allokationer. Vill du ha prestandafördelarna utan att kodbasen blir låg-nivås-sill, följ denna checklista som ett upprepningsbart arbetsflöde.

-d:release och överväg --opt:speed.--passC:-flto --passL:-flto).seq[T] är bra, men tighta loopar vinner ofta på arrays, openArray och att undvika onödig resizing.newSeqOfCap och undvik att bygga temporära strängar i loopar.Om du fortfarande står i valet mellan språk kan /blog/nim-vs-python hjälpa dig att rama in avvägningarna. För team som utvärderar verktyg eller supportalternativ kan du också kolla /pricing.

För att Nim siktar på Python-lik läsbarhet (indentering, ren kontrollflöde, ett uttrycksfullt standardbibliotek) samtidigt som det producerar nativer körbara filer med prestanda som ofta kan konkurrera med C för många arbetsbelastningar.

Det är en vanlig ”bäst av båda”-jämförelse: kodstruktur som fungerar för prototyper, men utan en tolk i den heta vägen.

Inte automatiskt. ”C-nivå prestanda” betyder oftast att Nim kan generera konkurrenskraftig maskinkod när du:

Du kan fortfarande skriva långsam Nim om du skapar många temporära objekt eller väljer ineffektiva datastrukturer.

Nim kompilerar dina .nim-filer till en nativer körbar fil, vanligtvis genom att översätta till C (eller C++/Objective-C) och sedan köra en systemkompilator som GCC eller Clang.

I praktiken förbättrar detta ofta uppstartstid och prestanda i heta loopar eftersom det inte finns någon tolk som kör koden rad för rad vid körning.

Det gör att kompilatorn kan göra arbete under kompilerings tiden och bädda in resultatet i den körbara filen, vilket minskar runtime-överhuvud.

Vanliga användningar:

Håll CTFE-hjälpare små och väl dokumenterade så att byggtiden förblir begriplig.

Makron genererar Nim-kod under kompileringen (”kod som skriver kod”). Använda på rätt sätt tar de bort boilerplate och undviker runtime-reflektion.

Bra användningsområden:

Tips för underhållbarhet:

Nim använder ofta ARC/ORC (referensräkning) istället för en klassisk spårande GC. Minnet frigörs oftast när sista referensen försvinner, vilket ger bättre förutsägbar latens.

Praktisk effekt:

Du vill fortfarande minska allokationer i heta vägar för att minimera referensräkningstrafik.

Föredra kontinuerliga, värdebaserade representationer i prestandakritisk kod:

object-värden istället för ref object i heta datastrukturerseq[T] med värdeobjekt ger cachevänlig iterationseq[ref T] när du inte behöver delade referenssemantikMånga Nim-funktioner är designade för att kompilera till enkla loopar och anrop:

openArray kompileras ofta till enkel indexerad iterationHuvudcaveat: abstraktioner slutar vara ”gratis” när de allokerar (temporära seq/string, per-iteration-clojures, upprepad konkatenation i loopar).

Du kan anropa C-funktioner direkt via Nims FFI (importc-deklarationer eller genererade bindings). Det ger tillgång till mogna C-bibliotek med minimal anropskostnad.

Se upp för:

string vs cstring)Använd release-byggnader för seriösa mätningar, och profilera därefter.

Vanliga kommandon:

nim c -d:release --opt:speed myapp.nimnim c -d:danger --opt:speed myapp.nim (endast när du har god testtäckning)nim c -d:release --opt:speed --debuginfo myapp.nim (vänligt för profilering)Arbetsflöde:

Om du vet storlekar i förväg, förallokera (newSeqOfCap, setLen) och återanvänd buffertar för att minska omallokeringar.

Ett bra mönster är ett litet Nim-wrapperlager som centraliserar konverteringar och felhantering.