05 nov. 2025·8 min

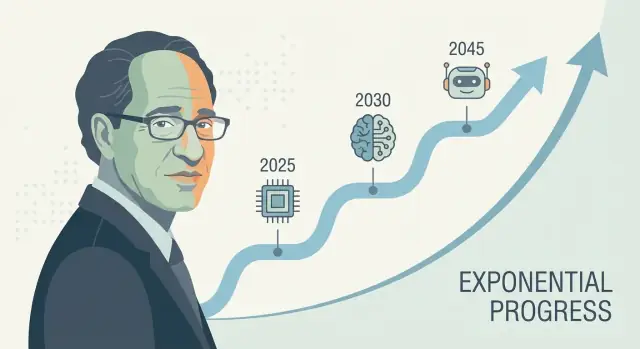

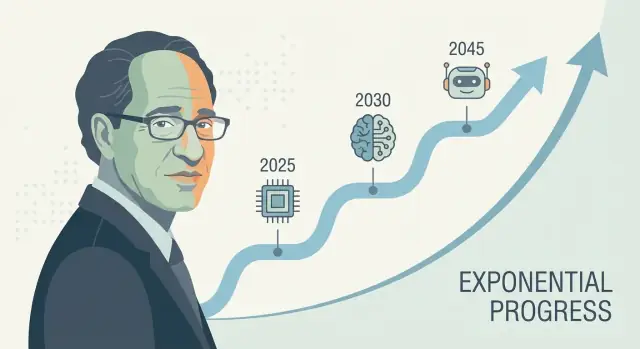

Ray Kurzweils AGI-tidslinje: Så förutsäger han decennier framåt

Utforska Ray Kurzweils långsiktiga AGI-förutsägelser: hans tidslinjer, prognosmetod, träffar och missar, kritik och vilka signaler du bör följa härnäst.

Utforska Ray Kurzweils långsiktiga AGI-förutsägelser: hans tidslinjer, prognosmetod, träffar och missar, kritik och vilka signaler du bör följa härnäst.

Ray Kurzweil är en av de mest igenkännliga rösterna när det gäller långsiktig teknikprognos—särskilt kring artificiell intelligens och den teknologiska singulariteten. När han gör en konkret AGI-förutsägelse (ofta formulerad som ett datum, inte ett vagt “någon gång”) sprider den sig ofta: investerare hänvisar till den, journalister debatterar den och forskare får frågor om att bemöta den.

Kurzweils inflytande handlar inte bara om optimism. Det handlar om att erbjuda en upprepat användbar berättelse om varför framsteg bör accelerera—ofta knuten till exponentiell tillväxt i datorkraft och idén att varje generation verktyg hjälper till att bygga nästa. Oavsett om du håller med eller inte ger han ett strukturerat sätt att diskutera en tidslinje för artificiell generell intelligens istället för att behandla det som ren science fiction.

En prognos för decennier framåt handlar mindre om att pricka ett kalenderdatum och mer om att föra fram en bunt trender: beräkning, kostnad, data, algoritmer och den praktiska förmågan att bygga system som generaliserar. Vad man hoppas på är att dessa kurvor fortsätter röra sig—och att dagens “saknade bitar” är lösbara ingenjörsproblem som krymper i takt med bättre insatsfaktorer.

Den här texten bryter ner:

Även bland seriösa experter varierar AGI-tidslinjer kraftigt eftersom de beror på antaganden: vad “AGI” betyder, vilka flaskhalsar som betyder mest, och hur snabbt genombrott omsätts i tillförlitliga produkter. Kurzweils tidslinjer är inflytelserika inte för att de är garanterade, utan för att de är tillräckligt specifika för att testas—och svåra att ignorera.

Ray Kurzweil är en amerikansk uppfinnare, författare och futurist, känd för att göra långsiktiga teknikprognoser—och för att backa upp dem med diagram, historiska data och djärva deadlines.

Kurzweil blev först allmänt känd genom praktiska uppfinningar, särskilt inom tal- och textteknik. Han byggde företag fokuserade på optisk teckenigenkänning (OCR), text-till-tal och musikinstrument, och han har tillbringat årtionden nära verkliga produktbegränsningar: datakvalitet, hårdvarukostnader och vad användare faktiskt kommer att adoptera. Denna byggarmentalitet formar hans prognoser—han tenderar att betrakta framsteg som något som kan ingenjöras och skalas.

Han har också arbetat inom stora teknikorganisationer (inklusive Google), vilket förstärkte hans syn att stora språng ofta kommer från ihållande investering, bättre verktyg och kumulativa förbättringar—inte bara isolerade genombrott.

Kurzweils AGI-tidslinje diskuteras ofta genom hans populära böcker, särskilt The Age of Spiritual Machines (1999) och The Singularity Is Near (2005). Dessa verk hävdar att informationstekniker förbättras i accelererande, kumulativa sätt—och att denna acceleration så småningom kommer att producera maskiner med mänskliga (och därefter övermänskliga) förmågor.

Oavsett om du håller med eller inte hjälpte hans skrivande att sätta villkoren för offentlig konversation: AI-framsteg som mätbart, trenddrivet och (åtminstone i princip) prognostiserbart.

AGI (Artificial General Intelligence): ett AI-system som kan lära sig och utföra ett brett spektrum uppgifter på ungefär mänsklig nivå och anpassa sig till nya problem utan att vara snävt specialiserat.

Singularitet: Kurzweils term för en period då teknologisk utveckling blir så snabb (och AI så kapabel) att det förändrar samhället på oförutsägbara, svårmodellerade sätt.

Tidslinje: en prognos med datum och milstolpar (t.ex. “mänsklig-nivå AI år X”), inte bara ett generellt påstående att framsteg fortsätter.

Kurzweil har upprepade gånger hävdat att mänsklig nivå av AGI sannolikt kommer inom första halvan av 2000-talets andra decennium—mest känt klustret kring slutet av 2020-talet till 2030-talet i offentliga tal och böcker. Han är inte alltid rigid kring ett enskilt år, men den centrala tesen är konsekvent: när datorkraft, data och algoritmer korsar vissa trösklar kommer system att matcha människans bredd och anpassningsförmåga.

I Kurzweils ram är AGI inte mållinjen—det är utlösaren. När maskiner når (och därefter överstiger) mänsklig generell intelligens komponerar framstegen: smartare system hjälper till att designa ännu smartare system, vilket accelererar vetenskapliga upptäckter, automatisering och människa–maskin-integration. Denna komponerande dynamik är vad han knyter till den bredare idén om en teknologisk “singularitet”: en period där förändring blir så snabb att vardaglig intuition slutar vara en pålitlig vägledning.

En viktig nyans i hans tidslinjepåståenden är definitionen av AGI. Dagens ledande modeller kan vara imponerande över många uppgifter, men de tenderar fortfarande att vara:

Kurzweils “AGI” innebär ett system som kan överföra lärande mellan domäner, bilda och driva mål i nya situationer och hantera den öppna variationen i verkliga världen—inte bara briljera i benchmarks.

Ett kalenderdatum är lätt att debattera och svårt att använda. Milstolpar är mer praktiska: ihållande autonomt lärande, pålitlig verktygsanvändning och planering, stark prestation i röriga verkliga miljöer och tydlig ekonomisk substitution över många jobbtyper. Även om du inte håller med om hans exakta tidpunkt gör dessa checkpoints prognosen testbar—och mer användbar än att satsa på ett enda rubrikår.

Kurzweil beskrivs ofta som en “serial predictor”, och det ryktet bidrar till varför hans AGI-tidslinje får uppmärksamhet. Men hans meritlista är blandad på ett sätt som är nyttigt för att förstå prognostisering: vissa uttalanden var specifika och mätbara, andra var riktningstreffsäkra men vaga, och några underskattade viktiga begränsningar.

Över böcker och tal förknippas han med prognoser som:

Klara, kontrollerbara prognoser är knutna till ett datum och ett mätbart utfall: “år X når teknik Y prestanda Z”, eller “majoriteten av enheter kommer att ha funktion F.” Dessa kan testas mot offentliga benchmarkar (noggrannhet, försäljnings-/adoptionsdata, beräkningskostnad).

Vaga prognoser låter rimliga men är svåra att vederläggas, till exempel “datorer kommer finnas överallt”, “AI kommer förändra samhället” eller “människor kommer slå samman med tekniken”. Dessa känns ofta sanna även om detaljer, tidpunkt eller mekanism skiljer sig.

Ett praktiskt sätt att utvärdera en prognostisör är att separera riktning, tidpunkt och specificitet.

Poängen är inte att etiketter som “bra” eller “dålig” är slutgiltiga, utan att notera hur självsäkra, datadrivna prognoser ändå kan vila på dolda antaganden—särskilt när social adoption spelar större roll än bara bättre hårdvara eller algoritmer.

Kurzweils “Law of Accelerating Returns” är idén att när en teknik förbättras gör dessa förbättringar det ofta enklare att förbättra den igen. Det skapar en återkopplingsslinga där framsteg accelererar över tid.

En rät linje (linjär) trend är som att lägga till samma mängd varje år: 1, 2, 3, 4.

En exponentiell trend är som att multiplicera: 1, 2, 4, 8. I början ser det långsamt ut—så småningom känns det som om allt händer på en gång. Kurzweil hävdar att många tekniker (särskilt informationstekniker) följer detta mönster eftersom varje generation av verktyg hjälper till att bygga nästa.

Kurzweil frågar inte bara “Kan vi göra X?” Han frågar “Hur billigt kan vi göra X?” Ett vanligt mönster inom datorteknik är: prestanda ökar samtidigt som kostnaden sjunker. När kostnaden för att köra en användbar modell sjunker kan fler experimentera, driftsätta produkter och finansiera nästa våg—vilket snabbar upp framstegen.

Därför tittar han på långsiktiga kurvor som “beräkningar per krona/dollar”, inte bara uppmärksammade demoer.

Moores lag är det klassiska exemplet: i årtionden fördubblades ungefär antalet transistorer på chip enligt ett regelbundet schema, vilket drev datorer att bli snabbare och billigare.

Kurzweils argument är inte “Moores lag fortsätter för evigt.” Det är bredare: även om en hårdvaruansats saktar ner kan andra metoder (bättre chip, GPUs/TPUs, parallellism, nya arkitekturer, mjukvarueffektivitet) hålla den övergripande kostnad/prestanda-trenden uppåt.

Folk brukar förutsäga framtiden genom att fortsätta den senaste förändringen i samma takt. Det missar kompoundering. Det kan få tidiga framsteg att se obetydliga ut—och senare framsteg att kännas “plötsliga”, när de kanske byggts förutsägbart på en kurva i åratal.

Prognoser som Kurzweils börjar ofta med mätbara trender—saker du kan rita på ett diagram. Det är en styrka: du kan debattera ingångarna istället för att diskutera enbart intuition. Det är också där de största begränsningarna syns.

Teknikprognostiker följer ofta:

Dessa kurvor kan vara övertygande eftersom de löper länge och uppdateras ofta. Om din syn på AGI är “tillräcklig hårdvara plus rätt mjukvara” kan dessa dataset kännas som stabil grund.

Huvudgapet: mer hårdvara skapar inte automatiskt smartare system. AI-kapacitet beror på algoritmer, datakvalitet, träningsrecept, verktyg och mänsklig feedback—inte bara FLOPs.

Ett användbart sätt att tänka är: hårdvara är en budget, kapacitet är resultatet. Sambandet mellan dem är verkligt, men inte konstant. Ibland låser en liten algoritmisk förändring upp stora vinster; ibland når scaling avtagande nytta.

För att koppla “insatser” (beräkning, pengar) till “utfall” (vad modeller faktiskt kan göra) behöver prognostiker:

Benchmarkar kan manipuleras, så de mest övertygande signalerna kombinerar testpoäng med bevis på hållbar nytta.

Två frekventa misstag är cherry-picking av kurvor (välja tidsfönster som ser mest exponentiella ut) och att ignorera flaskhalsar som energibegränsningar, datalimiteringar, latens, reglering eller svårigheten att omvandla smal kompetens till generell kompetens. Dessa slutar inte med prognoser—men de vidgar felmarginalerna.

Långsiktiga AGI-tidslinjer—inklusive Kurzweils—förtro sig mindre på ett enda “genombrottsögonblick” och mer på en stapel av antaganden som alla behöver hålla. Om något lager försvagas kan datumet skjutas även om framsteg fortsätter.

De flesta decennie-långa prognoser antar att tre kurvor stiger tillsammans:

Ett viktigt dolt antagande: dessa tre drivare ersätter inte varandra perfekt. Om datakvaliteten planar ut kan “lägg till bara mer beräkning” ge mindre avkastning.

Prognoser behandlar ofta beräkning som en jämn kurva, men verkligheten går genom fabriker och elnät.

Energikostnader, chipproduktionens kapacitet, exportkontroller, minnesbandbredd, nätverksutrustning och leveranskedjechocker kan alla begränsa hur snabbt träning och driftsättning skalar. Även om teorin säger “10× mer beräkning” kan vägen dit vara skumpig och dyr.

Decennie-långa prognoser antar också att samhället inte bromsar adoption för mycket:

Reglering, ansvar, offentligt förtroende, arbetsplatsintegration och avkastning på investeringar påverkar om avancerade system tränas och används brett—or hålls i snäva, högfriktionsmiljöer.

Kanske det största antagandet är att kapacitetsförbättringar från scaling naturligt konvergerar mot generell intelligens.

"Mer beräkning" kan ge modeller som är mer flytande och användbara, men inte automatiskt mer generella i meningen att de överför mellan domäner pålitligt, har långsiktigt autonomi eller stabila mål. Långa tidslinjer antar ofta att dessa gap är ingenjörsproblem—inte fundamentala hinder.

Även om datorkraft och modellstorlekar fortsätter att stiga kan AGI ändå dröja av skäl som inte enbart handlar om rå hastighet. Flera flaskhalsar rör vad vi bygger och hur vi vet att det fungerar.

“AGI” är inte en enskild funktion du kan slå på. En användbar definition brukar innebära en agent som kan lära nya uppgifter snabbt, överföra färdigheter mellan domäner, planera över långa horisonter, och hantera röriga, föränderliga mål med hög tillförlitlighet.

Om målet hela tiden skiftar—pratglad assistent vs autonom arbetare vs forskarnivå-resonerare—kan framsteg se imponerande ut samtidigt som viktiga förmågor saknas, som långtidsminne, orsakssamband eller konsekvent beslutsfattande.

Benchmarkar kan manipuleras, överanpassas eller bli föråldrade. Skeptiker vill typiskt se bevis på att en AI klarar otestade uppgifter, under nya begränsningar, med låga felnivåer och reproducerbara resultat.

Om fältet inte kan enas om tester som tydligt separerar “utmärkt mönsterkomplettering” från “generell kompetens”, blir tidslinjer gissningar—och försiktighet kan sakta ner deployment.

Kapacitet kan öka snabbare än möjligheten att styra system. Om system blir mer agentlika höjs ribban för att förhindra bedrägeri, måldrifts och skadliga sidoeffekter.

Reglering, revisioner och säkerhetsingenjörskap kan lägga tid även om underliggande modeller förbättras snabbt—särskilt för höginsatsanvändningar.

Många definitioner av AGI förutsätter kompetens i den fysiska världen: manipulera objekt, genomföra experiment, använda verktyg och anpassa sig till realtidsfeedback.

Om verkligt lärande visar sig vara datakrävande, långsamt eller riskfyllt kan AGI fastna på “briljant skärmprestation”—medan praktisk generalitet väntar på bättre robotik, simuleringar och säkra träningsmetoder.

Kurzweils prognoser är inflytelserika delvis för att de är tydliga och kvantitativa—men samma klarhet inbjuder också skarp kritik.

En vanlig invändning är att Kurzweil lutar sig kraftigt mot att förlänga historiska kurvor (beräkning, lagring, bandbredd) framåt. Kritiker menar att teknik inte alltid skalar jämnt: chipframsteg kan sakta, energikostnader kan bita och ekonomiska incitament kan skifta. Även om den långsiktiga riktningen är uppåt kan takten förändras på sätt som gör specifika datum opålitliga.

AGI handlar inte bara om snabbare hårdvara. Det är ett komplexitetssystemproblem som innefattar algoritmer, data, träningsmetoder, utvärdering, säkerhetsbegränsningar och mänsklig adoption. Genombrott kan blockeras av en enda saknad idé—något du inte pålitligt kan sätta i en kalender. Skeptiker pekar på att vetenskap ofta rör sig genom ojämna steg: långa platåer följda av plötsliga språng.

En annan invändning är psykologisk: vi minns dramatiska korrekta utsagor mer än de tystare missarna eller nära-missarna. Om någon gör många starka prognoser kan ett par minnesvärda träffar dominera den allmänna uppfattningen. Det betyder inte att prognosen är “fel”, men det kan blåsa upp förtroendet för tidslinjernas exakthet.

Även experter som accepterar snabb AI-utveckling skiljer sig i vad som “räknas” som AGI, vilka förmågor som måste generaliseras och hur man mäter dem. Små definitionsskillnader (uppgiftsbredd, autonomi, tillförlitlighet, verklig inlärning) kan flytta prognoser med årtionden—utan att någon ändrar sin grundläggande syn på nuvarande framsteg.

Kurzweil är en röst, men AGI-tidslinjer är ett trångt debattfält. Ett användbart sätt att kartlägga är närstående lägret (AGI inom några år till ett par decennier) kontra långsiktiga lägret (flera decennier eller “inte under detta sekel”). De tittar ofta på samma trender men är oense om vad som saknas: närstående prognostiker betonar snabb scaling och uppkommande egenskaper, medan långsiktiga prognostiker betonar olösta problem som pålitligt resonerande, autonomi och verklig robusthet.

Expertundersökningar samlar åsikter från forskare och praktiker (t.ex. om när det finns 50% chans för “mänsklig-nivå AI”). De kan visa skiftande sentiment över tid, men reflekterar också vem som tillfrågats och hur frågorna ställts.

Scenarioanalys undviker att peka ut ett enda datum. I stället skisserar den flera rimliga framtider (snabb utveckling, långsam utveckling, regulatoriska flaskhalsar, hårdvarubegränsningar) och frågar vilka signaler som skulle peka mot varje spår.

Benchmark- och kapacitetsbaserad prognostisering följer konkreta milstolpar (kodningsuppgifter, vetenskapligt resonerande, agenttillförlitlighet) och uppskattar vilken förbättringstakt som krävs för att nå bredare kompetens.

“AGI” kan betyda att klara en bred testsvit, göra de flesta jobb, fungera som en autonom agent eller matcha människor över domäner med minimal övervakning. En striktare definition skjuter oftast tidslinjer senare, och oenighet här förklarar mycket av spridningen.

Både optimistiska och skeptiska experter tenderar att vara överens om en sak: tidslinjer är mycket osäkra, och prognoser bör behandlas som spann med antaganden—inte som kalenderlöften.

Prognoser om AGI kan kännas abstrakta, så det hjälper att följa konkreta signaler som bör röra sig innan något “stort ögonblick”. Om Kurzweil-typernas tidslinjer är riktiga bör nästa decennium visa stadiga vinster inom kapacitet, tillförlitlighet, ekonomi och styrning.

Håll utkik efter modeller som pålitligt planerar över många steg, anpassar sig när planer misslyckas och använder verktyg (kod, webbläsare, data-appar) utan konstant handpåläggning. Det mest meningsfulla tecknet är inte en flashig demo—det är autonomi med tydliga gränser: agenter som kan slutföra flera timmars uppgifter, ställa klargörande frågor och lämna över arbete säkert när de är osäkra.

Framsteg kommer se ut som lägre felnivåer i realistiska arbetsflöden, inte bara högre benchmarkpoäng. Följ om “hallucinationer” minskar när system krävs att ange källor, göra kontroller eller själverifiera. En viktig milstolpe: stark prestation under granskningsförhållanden—samma uppgift, flera körningar, konsekventa resultat.

Sök efter mätbara produktivitetshöjningar i specifika roller (support, analys, mjukvara, drift), tillsammans med nya jobbkategorier kring att övervaka och integrera AI. Kostnader spelar också roll: om högkvalitativ output blir billigare (per uppgift, per timme) ökar adoptionen—särskilt för små team.

Om kapaciteten stiger bör styrningen gå från principer till praktik: standarder, tredjepartsrevisioner, incidentrapportering och reglering som klargör ansvar. Observera också övervakning av beräkningsanvändning och rapporteringsregler—tecken på att regeringar och industri behandlar scaling som en spårbar, kontrollerbar hävstång.

Om du vill använda dessa signaler utan att överreagera på rubriker, se /blog/ai-progress-indicators.

AGI-tidslinjer är bäst att betrakta som väderprognoser för ett avlägset datum: användbara för planering, opålitliga som löften. Kurzweil-typens förutsägelser kan hjälpa dig att uppmärksamma långsiktiga trender och pröva beslut, men de bör inte vara enda grunden i din strategi.

Använd prognoser för att utforska spann och scenarier, inte ett enda år. Om någon säger “AGI till 203X”, översätt det till: “Vilka förändringar måste ske för att detta ska vara sant—och vad om de inte sker?” Planera för flera utfall.

För individer: bygg hållbara färdigheter (probleminramning, domänexpertis, kommunikation) och håll en vana att prova nya verktyg.

För företag: investera i AI-läskunnighet, datakvalitet och pilotprojekt med tydlig ROI—samtidigt som ni har en “no regrets”-plan som fungerar även om AGI kommer senare.

Ett pragmatiskt sätt att operationalisera “följ signalerna och iterera” är att korta byggcykler: prototypa arbetsflöden, testa tillförlitlighet och kvantifiera produktivitetsvinster innan ni gör stora satsningar. Plattformar som Koder.ai passar denna ansats genom att låta team skapa webb-, backend- och mobilappar via en chattgränssnitt (med planeringsläge, snapshots och rollback), så att ni kan prova agentstött arbete snabbt, exportera källkod vid behov och undvika att låsa strategin till en enda prognos.

En balanserad slutsats: tidslinjer kan vägleda förberedelser, men inte ge säkerhet. Använd dem för att prioritera experiment och minska blinda fläckar—och återbesök dina antaganden regelbundet när ny evidens dyker upp.

Kurzweils prognoser spelar roll eftersom de är tillräckligt specifika för att testas och ofta citeras, vilket påverkar hur folk pratar om AGI-tidslinjer.

I praktiken påverkar de:

Även om datumen är fel kan de milstolpar och antaganden han lyfter fram vara användbara som planeringsinput.

I den här kontexten betyder AGI en AI som kan lära sig och utföra ett brett spektrum uppgifter på ungefär mänsklig nivå, inklusive att anpassa sig till nya problem utan att vara smalt specialiserad.

En praktisk checklista som artikeln antyder inkluderar:

Kurzweils mest citerade offentliga ståndpunkt placerar mänsklig nivå av AGI i slutet av 2020-talet till 2030-talet, formulerat som ett sannolikt fönster snarare än ett garanterat enskilt år.

Det mest handfasta sättet att använda detta är att behandla det som ett scenariospann och följa om de förutsättande trenderna (beräkningskostnad, algoritmer, distribution) fortsätter i rätt riktning.

Han menar att framstegen accelererar eftersom förbättringar i en teknik ofta gör det enklare att förbättra samma teknik igen—vilket skapar en kompenserande återkopplingsslinga.

I praktiken pekar han på trender som:

Kärnpoängen är inte att en enda lag förklarar allt, utan att kompoundering kan få tidig, långsam utveckling att övergå i snabb förändring senare.

Beräkningskraft är en viktig insats, men artikeln betonar att hårdvaruframsteg ≠ kapacitetsframsteg.

Mer beräkning hjälper när den kombineras med:

Ett bra tankesätt är: hårdvara är ; kapacitet är —kopplingen mellan dem kan förändras över tid.

Stödjande data inkluderar långsiktiga, mätbara kurvor:

Viktiga begränsningar:

Stora antaganden som artikeln pekar ut inkluderar:

Om någon av dessa lager försvagas kan datumet skjutas fram även om framsteg fortsätter.

Flera saker kan fördröja AGI även om beräkning och modeller fortsätter förbättras:

Dessa kan sakta ner tidslinjer även om modeller förbättras på papperet.

Artikeln lyfter fram kritikpunkter som:

Praktisk slutsats: betrakta precisa datum som , inte som löften.

Följ signaler som rör sig innan något “AGI-ögonblick” inträffar, särskilt:

Att följa sådana signaler hjälper dig att uppdatera din bedömning utan att överreagera på spektakulära demoer.