10 nov. 2025·8 min

Schemaändringar och migrationer i AI-byggda system: en guide

Lär dig hur AI-byggda system hanterar schemaändringar säkert: versionshantering, bakåtkompatibla utrullningar, datamigrationer, testning, observability och rollback-strategier.

Vad “schema” betyder i AI-byggda system

Ett schema är helt enkelt den gemensamma överenskommelsen om datas struktur och vad varje fält betyder. I AI-byggda system syns den överenskommelsen på fler ställen än bara databastabeller — och den ändras oftare än teamen räknar med.

Schema är inte bara en databasgrej

Du stöter på scheman i minst fyra vanliga lager:

- Databaser: tabell-/kolumnnamn, datatyper, constraints, index och relationer.

- API:er: request/response JSON-struktur, obligatoriska vs. frivilliga fält, enums, errorformat, paginering.

- Events och meddelanden: payloads som skickas via streams, köer och webhooks (ofta implicit versionsstyrda via konsumenterna).

- Konfigurationer och kontrakt: feature-flags, miljövariabler, YAML/JSON-konfigar och “gömda kontrakt” som filformat och namngivningskonventioner.

Om två delar av systemet utbyter data finns det ett schema — även om ingen skrev ner det.

Varför schema ändras oftare i AI-byggda system

AI-genererad kod kan avsevärt snabba upp utvecklingen, men den ökar också churn:

- Genererad kod speglar den senaste prompten och kontexten, så små promptjusteringar kan ändra fältnamn, nästling, standardvärden eller valideringar.

- Krav utvecklas snabbare när det är billigt att skicka en ny endpoint eller ett nytt pipeline-steg.

- Inkonsekventa konventioner (snake_case vs. camelCase,

idvs.userId) dyker upp när flera generationer eller refaktorer sker över team.

Resultatet blir oftare “contract drift” mellan producenter och konsumenter.

Om du använder ett vibe-coding-flöde (t.ex. generera handlers, DB-accesslager och integrationer via chatt) är det värt att baka in schemadisciplin i det arbetsflödet från dag ett. Plattformar som Koder.ai hjälper team att röra sig snabbt genom att generera React/Go/PostgreSQL och Flutter-appar från en chattgränssnitt — men ju snabbare du kan skicka, desto viktigare blir det att versionsstyra gränssnitt, validera payloads och rulla ut ändringar med eftertanke.

Målet med den här guiden

Det här inlägget fokuserar på praktiska sätt att hålla produktion stabil samtidigt som ni itererar snabbt: bibehålla bakåtkompatibilitet, rulla ut ändringar säkert och migrera data utan överraskningar.

Vad vi inte täcker

Vi dyker inte djupt i teori-tung modellering, formella metoder eller leverantörsspecifika funktioner. Tonvikten ligger på mönster du kan tillämpa över stackar — oavsett om ditt system är handkodad, AI-assisterad eller mestadels AI-genererad.

Varför schemaändringar sker oftare med AI-genererad kod

AI-genererad kod får schemaändringar att kännas "normala" — inte för att team är slarviga, utan för att input till systemet förändras oftare. När din applikationsbeteende delvis drivs av prompts, modellversioner och genererad lim-kod, är det mer sannolikt att datas form driver bort över tid.

Vanliga triggers i praktiken

Flera mönster orsakar återkommande schemachurn:

- Nya produktfunktioner: lägga till ett nytt fält (t.ex.

risk_score,explanation,source_url) eller dela upp ett begrepp i flera (t.ex.addressistreet,city,postal_code). - Modelloutputförändringar: en nyare modell kan producera mer detaljerade strukturer, olika enumvärden eller något annorlunda namngivning ("confidence" vs. "score").

- Promptuppdateringar: promptändringar för att förbättra kvaliteten kan oavsiktligt ändra format, obligatoriska fält eller nästling.

Riskfyllda mönster som gör AI-system bräckliga

AI-genererad kod fungerar ofta snabbt, men kan koda in sköra antaganden:

- Implicitta antaganden: koden antar tyst att ett fält alltid finns, alltid är numeriskt eller alltid inom ett visst intervall.

- Dold koppling: en tjänst förlitar sig på en annan tjänsts interna fältnamn eller ordning istället för ett definierat gränssnitt.

- Odokumenterade fält: modellen börjar emittera en ny egenskap och downstream-kod börjar lita på den utan att någon uttryckligen godkänt att det är en del av kontraktet.

Varför AI förstärker förändringsfrekvensen

Kodgenerering uppmuntrar snabb iteration: du regenererar handlers, parsers och databasaccesslager när krav utvecklas. Den snabbheten är användbar, men gör det också enkelt att skicka små gränssnittsändringar upprepade gånger — ibland utan att märka det.

Ett säkrare mindset är att behandla varje schema som ett kontrakt: databastabeller, API-payloads, events och till och med strukturerade LLM-svar. Om en konsument är beroende av det, versionsstyr det, validera det och ändra det avsiktligt.

Typer av schemaändringar: additivt vs. brytande

Schemaändringar är inte alla lika. Den mest användbara första frågan är: kommer befintliga konsumenter fortsätta fungera utan ändringar? Om ja är det vanligtvis additivt. Om nej är det brytande — och kräver en koordinerad utrullningsplan.

Additiva ändringar (oftast säkra)

Additiva ändringar utökar det som redan finns utan att ändra befintlig betydelse.

Vanliga databasexempel:

- Lägg till en kolumn med ett default eller tillåt NULL (t.ex.

preferred_language). - Lägg till en ny tabell eller index.

- Lägg till ett valfritt fält i en JSON-bubbla som lagras i en kolumn.

Icke-databasexempel:

- Lägg till en ny egenskap i ett API-svar (klienter som ignorerar okända fält fortsätter att fungera).

- Lägg till ett nytt eventfält i en stream/kö-meddelande.

- Lägg till ett nytt värde i en feature-flag men behåll befintligt beteende som standard.

Additivt är bara "säkert" om äldre konsumenter är toleranta: de måste ignorera okända fält och inte kräva nya.

Brytande ändringar (riskabelt)

Brytande ändringar ändrar eller tar bort något som konsumenter redan är beroende av.

Typiska databasbrytande ändringar:

- Ändra en kolumntyp (string → integer, tidsstämpelprecision ändras).

- Byta namn på ett fält/kolumn (allt som läser det gamla namnet misslyckas).

- Ta bort en kolumn/tabell som fortfarande frågas.

Icke-databas brytande ändringar:

- Byta namn/ta bort JSON-fält i request/response.

- Ändra eventsemantik (samma fältnamn, annan betydelse).

- Modifiera webhook-payloadstruktur utan versionshöjning.

Skriv alltid ner konsumentpåverkan

Innan merge, dokumentera:

- Vem konsumerar det (tjänster, dashboards, datapipelines, partners).

- Kompatibilitet (bakåt/framåt, och hur länge).

- Felmode (parserfel, tyst data-korrumpering, fel affärslogik).

Denna korta "påverkansanteckning" tvingar fram klarhet — särskilt när AI-genererad kod introducerar schemaändringar implicit.

Versionsstrategier för scheman och gränssnitt

Versionshantering talar om för andra system (och framtida du) "det här förändrades, och så här riskabelt är det." Målet är inte pappersarbete — det är att förhindra tyst fel när klienter, tjänster eller datapipelines uppdaterar i olika takt.

Ett vardagligt semantiskt versionssätt

Tänk i termerna major / minor / patch, även om du inte bokstavligen publicerar 1.2.3:

- Major: brytande ändring. Gamla konsumenter kan faila eller bete sig felaktigt utan ändringar.

- Minor: säker tillägg. Gamla konsumenter fungerar fortfarande; nya konsumenter kan använda nya möjligheter.

- Patch: buggfix eller förtydligande som inte ändrar betydelse.

En enkel regel som sparar team: ändra aldrig betydelsen av ett befintligt fält tyst. Om status="active" brukade betyda "betalande kund", använd det inte om för att betyda "konto finns". Lägg till ett nytt fält eller en ny version.

Versionsstyrda endpoints vs. versionsstyrda fält

Du har vanligtvis två praktiska alternativ:

1) Versionsstyrda endpoints (t.ex. /api/v1/orders och /api/v2/orders):

Bra när ändringar är verkligen brytande eller omfattande. Det är tydligt, men kan skapa duplicering och långlivat underhåll om du håller flera versioner.

2) Versionsstyrda fält / additiv evolution (t.ex. lägg till new_field, behåll old_field):

Bra när du kan göra ändringar additivt. Äldre klienter ignorerar vad de inte förstår; nyare klienter läser det nya fältet. Med tiden depreciera och ta bort det gamla fältet med en tydlig plan.

Event-scheman och registrets betydelse

För streams, köer och webhooks är konsumenterna ofta utanför din deploymentskontroll. Ett schema-register (eller någon central katalog med kompatibilitetskontroller) hjälper till att upprätthålla regler som "endast additiva ändringar tillåtna" och gör det tydligt vilka producenter och konsumenter som är beroende av vilka versioner.

Säkra utrullningar: Expand/Contract (det mest tillförlitliga mönstret)

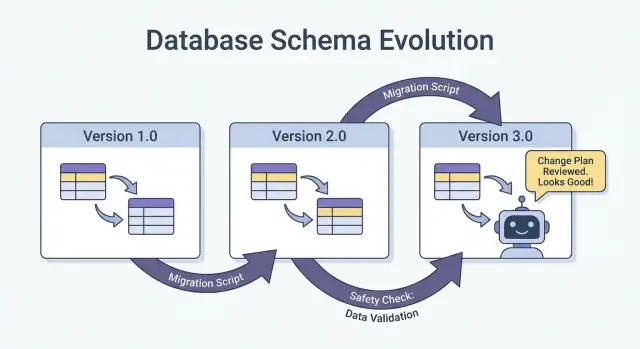

Det säkraste sättet att skicka schemaändringar — särskilt när du har flera tjänster, jobb och AI-genererade komponenter — är expand → backfill → switch → contract-mönstret. Det minimerar driftstopp och undviker "allt-eller-inget"-deployment där en efterbliven konsument bryter produktion.

De fyra stegen (och varför de fungerar)

1) Expand: Introducera det nya schemat på ett bakåtkompatibelt sätt. Befintliga läsare och skrivare ska fortsätta fungera oförändrat.

2) Backfill: Fyll nya fält för historisk data (eller processa om meddelanden) så att systemet blir konsistent.

3) Switch: Uppdatera skrivare och läsare att använda det nya fältet/formatet. Detta kan göras gradvis (canary, procentuell utrullning) eftersom schemat stödjer båda.

4) Contract: Ta bort det gamla fältet/formatet först när du är säker på att inget längre är beroende av det.

Tvåfas (expand → switch) och trefas (expand → backfill → switch) utrullningar minskar driftstopp eftersom de undviker hård koppling: skrivare kan flytta först, läsare senare, och vice versa.

Exempel: lägg till en kolumn, backfilla, gör den sedan obligatorisk

Anta att du vill lägga till customer_tier.

- Expand: Lägg till

customer_tiersom nullable med defaultNULL. - Backfill: Kör ett jobb för att beräkna tier för befintliga rader.

- Switch: Uppdatera appen och pipelines att alltid skriva

customer_tier, och uppdatera läsare att föredra det. - Contract: Efter övervakning, gör det NOT NULL (och plocka eventuellt bort legacy-logik).

Koordination: skrivare och läsare måste vara överens

Behandla varje schema som ett kontrakt mellan producenter (skrivare) och konsumenter (läsare). I AI-byggda system är detta lätt att missa eftersom nya kodvägar dyker upp snabbt. Gör utrullningar explicita: dokumentera vilken version som skriver vad, vilka tjänster som kan läsa båda, och det exakta "kontraktsdatumet" när gamla fält kan tas bort.

Databasmigrationer: hur ändra data utan att bryta produktion

Gör kontrakt till kod

Generera API:er och DB-lager, och iterera säkert med versionsstyrda gränssnitt.

Databasmigrationer är "instruktionsboken" för att flytta produktionsdata och struktur från ett säkert tillstånd till nästa. I AI-byggda system är de ännu viktigare eftersom genererad kod kan anta att en kolumn finns, byta namn inkonsekvent eller ändra constraints utan att tänka på befintliga rader.

Migrationsfiler vs. auto-migrations

Migrationsfiler (inkluderas i source control) är explicita steg som "lägg till kolumn X", "skapa index Y" eller "kopiera data från A till B". De är granskbara, kan återges och kan köras i staging/produktion.

Auto-migrations (genererade av ett ORM/ramverk) är bekväma för tidig utveckling och prototypning, men kan producera riskfyllda operationer (ta bort kolumner, återskapa tabeller) eller ändra ordning på ändringar på sätt du inte avsett.

En praktisk regel: använd auto-migrations för att skissa ändringar, konvertera dem sedan till granskade migrationsfiler för allt som rör produktion.

Idempotens och ordning

Gör migrationer idempotenta där det är möjligt: att köra dem flera gånger bör inte korrupta data eller misslyckas halvvägs. Föredra "create if not exists", lägg till nya kolumner som nullable först och skydda datatransformer med kontroller.

Säkerställ också en tydlig ordning. Varje miljö (lokal, CI, staging, prod) bör tillämpa samma migrationssekvens. "Fix" inte produktion med manuell SQL om du inte fångar det i en migration efteråt.

Långkörande migrationer utan att låsa tabellen

Vissa schemaändringar kan blockera skrivningar (eller till och med läsningar) om de låser stora tabeller. Hög-nivå-sätt att minska risk:

- Använd online-/lås-minimerande operationer som din databas stödjer (t.ex. concurrent index builds).

- Dela upp ändringar i steg: lägg till nya strukturer först, backfilla i batcher, och byt sedan appen.

- Schemalägg tunga operationer under lågtrafikfönster, med timeouts och övervakning.

Multi-tenant och sharded-setuppar

För multi-tenant databaser, kör migrationer i en kontrollerad loop per tenant, med progress-spårning och säkra retries. För shards, behandla varje shard som ett separat produktionssystem: rulla migrationer shard-för-shard, verifiera hälsa, och fortsätt. Det begränsar blast radius och gör rollback genomförbar.

Backfills och reprocessning: uppdatera befintlig data

En backfill är när du fyller nya fält (eller korrigerade värden) för befintliga poster. Reprocessning är när du kör historisk data genom en pipeline igen — typiskt för att affärsregler ändrats, en bugg fixats eller modell/output-format uppdaterats.

Båda är vanliga efter schemaändringar: det är lätt att börja skriva den nya formen för "ny data", men produktionssystem beror också på att gårdagens data är konsekvent.

Vanliga tillvägagångssätt

Online backfill (i produktion, gradvis). Kör ett kontrollerat jobb som uppdaterar poster i små batcher medan systemet är live. Detta är säkrare för kritiska tjänster eftersom du kan throttla, pausa och återuppta.

Batch backfill (offline eller schemalagda jobb). Processa stora bitar under lågtrafikfönster. Det är enklare operationellt, men kan skapa spikar i databasbelastning och ta längre tid att återhämta sig från misstag.

Lazy backfill vid läsning. När en gammal post läses räknar/aplikationen ut/ifyller fälten och skriver tillbaka. Detta sprider kostnaden över tid och undviker ett stort jobb, men gör första läsningen långsammare och kan lämna "gammal" data o konverterad länge.

I praktiken kombinerar team ofta dessa: lazy backfill för long-tail-poster, plus ett online-jobb för mest frekvent åtkommen data.

Hur man validerar en backfill

Validering ska vara explicit och mätbar:

- Räkningar: hur många rader/events borde uppdateras vs. hur många uppdaterades.

- Checksummor/aggregat: jämför totalsummor (t.ex. sum av belopp, distinkta ID:n) före/efter.

- Sampling: spot-checka ett statistiskt meningsfullt urval, inklusive edge-cases.

Validera också downstream-effekter: dashboards, sökindex, caches och eventuella exporter som förlitar sig på de uppdaterade fälten.

Kostnad, tid och acceptanskriterier

Backfills väger hastighet (bli klar snabbt) mot risk och kostnad (belastning, compute och operationellt arbete). Sätt acceptanskriterier i förväg: vad "klart" betyder, förväntad runtime, maximal tillåten felrate och vad ni gör om validering misslyckas (pausa, retry eller rollback).

Event- och meddelandeschema-evolution (streams, köer, webhooks)

Utveckla eventschema noggrant

Designa event-payloads för att tolerera okända fält och undvika att bryta konsumenter.

Scheman lever inte bara i databaser. Varje gång ett system skickar data till ett annat — Kafka topics, SQS/RabbitMQ-köer, webhook-payloads, till och med "events" skrivna till objektlagring — har du skapat ett kontrakt. Producenter och konsumenter rör sig oberoende, så dessa kontrakt tenderar att brytas oftare än en enda apps interna tabeller.

Det säkraste default: utveckla events bakåtkompatibelt

För event-streams och webhook-payloads, föredra ändringar som gamla konsumenter kan ignorera och nya konsumenter kan adoptera.

En praktisk regel: lägg till fält, ta inte bort eller byt namn. Om du måste depreciera något, fortsätt skicka det en tid och dokumentera det som deprecated.

Exempel: utöka ett OrderCreated-event genom att lägga till valfria fält.

{

"event_type": "OrderCreated",

"order_id": "o_123",

"created_at": "2025-12-01T10:00:00Z",

"currency": "USD",

"discount_code": "WELCOME10"

}

Äldre konsumenter läser order_id och created_at och ignorerar resten.

Konsumentdrivna kontrakt (i klartext)

Istället för att producenten gissar vad som kan bryta andra, publicerar konsumenterna vad de är beroende av (fält, typer, obligatoriskt/valfritt). Producenten validerar sedan ändringar mot dessa förväntningar innan de skickas. Detta är särskilt användbart i AI-genererade kodbaser där en modell kan "hjälpsamt" byta namn på ett fält eller ändra typ.

Hantera "okända fält" säkert

Gör parsers toleranta:

- Ignorera okända fält som standard (faila inte bara för att en ny nyckel dyker upp).

- Behandla nya fält som valfria tills du verkligen behöver dem.

- Logga oväntade fält på en låg nivå så du kan upptäcka adoption utan att få paginering.

När du behöver en brytande ändring, använd en ny event-typ eller versionsnamn (t.ex. OrderCreated.v2) och kör båda parallellt tills alla konsumenter migrerat.

AI-utdata som ett schema: prompts, modeller och strukturerade svar

När du lägger till en LLM i ett system blir dess output snabbt ett de facto-schema — även om ingen skrev en formell spec. Downstream-kod börjar anta "det kommer finnas ett summary-fält", "första raden är titeln" eller "bullets separeras med streck". Dessa antaganden hårdnar över tid, och en liten modellförändring kan bryta dem precis som ett kolumnbyte.

Föredra explicit struktur (och validera den)

Istället för att parsa "pretty text", be om strukturerade outputs (typiskt JSON) och validera dem innan de går in i resten av systemet. Tänk på detta som att gå från "bäst ansträngning" till ett kontrakt.

Ett praktiskt tillvägagångssätt:

- Definiera ett JSON-schema (eller ett typat gränssnitt) för modellens respons.

- Avvisa eller karantänsätt ogiltiga svar (tvinga inte tyst konvertering).

- Logga valideringsfel så du kan se vad som förändras.

Detta är särskilt viktigt när LLM-svar matar datapipelines, automationer eller användarvisat innehåll.

Planera för model drift

Även med samma prompt kan outputs skifta över tid: fält kan utelämnas, extra nycklar kan dyka upp och typer kan ändras ("42" vs 42, arrayer vs strängar). Behandla dessa som schema-evolution.

Åtgärder som fungerar bra:

- Gör fält valfria där rimligt och sätt explicita standarder.

- Tillåt okända nycklar men ignorera dem säkert (om du inte är strikt av compliance-skäl).

- Lägg till "guardrails"-kontroller (t.ex. obligatoriska fält, max-längder, enumvärden).

Behandla promptändringar som API-ändringar

En prompt är ett gränssnitt. Om du redigerar den, versionsstyr den. Behåll prompt_v1, prompt_v2 och rulla ut gradvis (feature-flags, canaries eller per-tenant toggles). Testa med en fixad evalueringsuppsättning innan du promoverar ändringar, och behåll äldre versioner körande tills downstream-konsumenter anpassat sig. För mer om säkra utrullningsmekanismer, relatera din metod till expand–contract-mönstret.

Testning och validering för schemaändringar

Schemaändringar brukar misslyckas på tråkiga, kostsamma sätt: en ny kolumn saknas i en miljö, en konsument förväntar sig fortfarande ett gammalt fält, eller en migration kör fint på tom data men timear ut i produktion. Testning är hur du förvandlar dessa "överraskningar" till förutsägbart, åtgärdbart arbete.

Tre testnivåer (och vad varje fångar)

Unit tests skyddar lokal logik: mapping-funktioner, serializers/deserializers, validators och query-builders. Om ett fält byter namn eller en typ ändras, ska unittester misslyckas nära koden som behöver uppdateras.

Integrationstester säkerställer att din app fortfarande fungerar med riktiga beroenden: den faktiska databasmotorn, ett verkligt migrationsverktyg och riktiga meddelandeformat. Här fångar du problem som "ORM-modellen ändrades men migrationen gjorde det inte" eller "det nya indexnamnet konflikte".

End-to-end-tester simulerar användar- eller workflowresultat över tjänster: skapa data, migrera den, läs tillbaka via API:er och verifiera att downstream-konsumenter fortfarande beter sig korrekt.

Kontraktstester för producenter och konsumenter

Schemaevolution bryter ofta vid gränser: service-till-service API:er, streams, köer och webhooks. Lägg till kontraktstester som körs på båda sidor:

- Producenter bevisar att de kan emitera events/responser som matchar ett avtal.

- Konsumenter bevisar att de kan parsa både gamla och nya versioner under en utrullning.

Migrationstesting: applicera och rulla tillbaka i rena miljöer

Testa migrationer som du deployar dem:

- Starta från en ren databassnapshot.

- Applicera alla migrationer i ordning.

- Verifiera att appen kan läsa/skriva.

- Kör en rollback (om stödd) eller en "down"-migration och bekräfta att det återgår till ett fungerande tillstånd.

Fixtures för gamla och nya schemaversioner

Behåll ett litet set fixtures som representerar:

- Data skriven under tidigare schema (legacy-rader/events).

- Data skriven under nya schema.

Dessa fixtures gör regressioner uppenbara, särskilt när AI-genererad kod subtilt ändrar fältnamn, optionalitet eller format.

Observability: upptäck fel tidigt

Versionsstyr dina API-former

Generera endpoints som utvecklas additivt och validera payloads innan produktion.

Schemaändringar misslyckas sällan högljutt vid deployment. Oftare visar sig fel som en långsam ökning av parserfel, konstiga "okända fält"-varningar, saknad data eller bakgrundsjobb som hamnar efter. Bra observability förvandlar dessa svaga signaler till åtgärdbara insikter medan du fortfarande kan pausa utrullningen.

Vad att övervaka under en utrullning

Börja med grunderna (app-hälsa), lägg sedan till schema-specifika signaler:

- Fel: toppar i 4xx/5xx, men också "mjuka" fel som JSON-parserfel, misslyckad deserialisering och retries.

- Latens: p95/p99-responstider och köbearbetningstid. Schemaändringar kan lägga till joins, större payloads eller extra validering.

- Data-kvalitetssignaler: ökning av null-rate i viktiga kolumner, plötsliga dropp i event-volym, nya defaultvärden som dyker upp för ofta eller mismatch mellan gamla och nya representationer.

- Pipeline-lagg: konsumentlagg i streams/queues, webhook-leveransbacklog och migrationsjobbs genomströmning.

Nyckeln är att jämföra före vs. efter och att skära data efter klientversion, schemaversion och trafiksegment (canary vs. stabil).

Dashboards som faktiskt hjälper

Skapa två dashboardvyer:

-

Applikationsbeteende-dashboard

- Request-rate, error-rate, latens (RED)

- Topp-exceptions (grupperade efter meddelande)

- Validerings-/parserfelräkning och procent

- Payload-storleksfördelning (för att fånga oväntat stora meddelanden)

-

Migration och bakgrundsjobbs-dashboard

- Migrationsjobbs progress (% klart), rader/sek, ETA

- Felrate och retry-count

- Kö-depth / konsumentlagg

- Dead-letter-kö-volym (om tillämpligt)

Om du kör en expand/contract-utrullning, inkludera en panel som visar läsningar/skrivningar uppdelat per gammalt vs. nytt schema så du kan se när det är säkert att gå vidare till nästa fas.

Alerts för schema-specifika fel

Pagea vid problem som indikerar att data tappas eller misstolkas:

- Schema-valideringsfelränta över en låg tröskel (ofta <0.1% är redan meningsfullt)

- Parser-/deserialiseringsfel (särskilt om koncentrerat till en producent/konsument)

- Oväntat fält / saknat obligatoriskt fält-varningar som ökar

- Migrationsjobb står still (ingen progress på N minuter) eller lagg växer snabbare än genomströmning

Undvik bullriga alerts på rena 500s utan kontext; knyt alerts till schema-utrullningen med taggar som schemaversion och endpoint.

Logga versioner så du kan debugga snabbt

Under övergången inkludera och logga:

- Schemaversion (t.ex.

X-Schema-Versionheader, meddelandemetadatafält) - Producent- och konsumentappversion

- Modelversion / promptversion när AI-genererade outputs matar strukturerad data

Den detaljen gör frågan "varför misslyckades den här payloaden?" besvarbar på minuter istället för dagar — särskilt när olika tjänster (eller olika AI-modellversioner) är live samtidigt.

Rollback, återställning och förändringshantering

Schemaändringar misslyckas på två sätt: själva ändringen är felaktig, eller systemet runt den beter sig annorlunda än väntat (särskilt när AI-genererad kod introducerar subtila antaganden). I båda fallen behöver varje migration en rollback-berättelse innan den skickas — även om den berättelsen uttryckligen är "ingen rollback".

Att välja "ingen rollback" kan vara giltigt när ändringen är irreversibel (t.ex. ta bort kolumner, skriva om identifierare eller deduplicera poster destruktivt). Men "ingen rollback" är inte avsaknad av plan; det är ett beslut som flyttar planen mot framåtlösningar, återställningar och innehållsförmåga.

Praktiska rollback-alternativ som faktiskt fungerar

Feature flags / konfiggrindar: Wrappa nya läsare, skrivare och API-fält bakom en flagga så du kan stänga av nytt beteende utan att redeploya. Detta är särskilt användbart när AI-genererad kod kan vara syntaktiskt korrekt men semantiskt fel.

Inaktivera dual-write: Om du skriver till gamla och nya scheman under en expand/contract-utrullning, ha en kill-switch. Att stänga av den nya skrivvägen stoppar vidare divergens medan du undersöker.

Revertera läsare (inte bara skrivare): Många incidenter händer för att konsumenter börjar läsa nya fält eller tabeller för tidigt. Gör det enkelt att peka tjänster tillbaka på tidigare schemaversion, eller att ignorera nya fält.

Känn begränsningarna i reversibilitet

Vissa migrationer kan inte återställas rent:

- Destruktiva transformationer (t.ex. hashing, förlustig normalisering).

- Drops/renames utan bevarad kopia.

- Backfills som skriver över "source of truth"-värden.

För dessa, planera för restore-from-backup, replay från events eller recompute från råa inputs — och verifiera att du fortfarande har de inputsen.

Pre-flight-checklista (innan du skickar)

- Rollback-beslut dokumenterat ("revert", "forward fix" eller "ingen rollback + restore path").

- Tydlig stopknapp: flags och/eller dual-write-disable-switch.

- Backups/snapshots verifierade; restore testad minst en gång.

- Migrationen är idempotent; omkörningar kommer inte korrupta data.

- Övervakning och alerts för felrater, schema-valideringsfel och lagg.

- Ägarskap: vem godkänner, vem kör, vem är on-call under utrullningen.

Bra förändringshantering gör rollbacks sällsynta — och gör återställning tråkig när de väl inträffar.

Om ditt team itererar snabbt med AI-assisterad utveckling hjälper det att para ihop dessa praxis med verktyg som stöder säker experimentering. Exempelvis inkluderar Koder.ai ett planeringsläge för upfront-ändringsdesign och snapshots/rollback för snabb återhämtning när en genererad förändring av misstag flyttar ett kontrakt. Använd tillsammans kan snabb kodgenerering och disciplinerad schemaevolution låta dig röra dig snabbare utan att behandla produktion som en testmiljö.