18 maj 2025·8 min

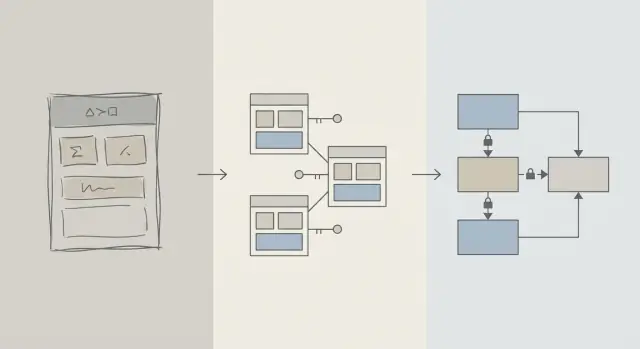

Schemadesign först: snabbare appar än tidig frågeoptimering

Tidiga prestandavinster kommer ofta från bättre schemadesign: rätt tabeller, nycklar och begränsningar förhindrar långsamma frågor och kostsamma omskrivningar senare.

Schema kontra frågeoptimering: vad vi menar

När en app känns långsam är första instinkten ofta att ”fixa SQL:en”. Den impulsen är begriplig: en enskild fråga syns, kan mätas och är lätt att peka på. Du kan köra EXPLAIN, lägga till ett index, justera en JOIN och ibland se en omedelbar förbättring.

Men tidigt i en produkts liv är prestandaproblem lika ofta en följd av dataform som av den specifika frågetexten. Om schemat tvingar dig att kämpa mot databasen blir frågeoptimering ett evigt spel av whack-a-mole.

Schema design (enkelt språk)

Schemadesign är hur du organiserar dina data: tabeller, kolumner, relationer och regler. Det innefattar beslut som:

- Vilka ”saker” förtjänar en egen tabell (users, orders, events)

- Hur tabeller relaterar (one-to-many, many-to-many)

- Vad som måste vara unikt eller obligatoriskt (constraints)

- Hur du representerar tillstånd och historik (timestamps, statusfält, audit-poster)

Bra schemadesign gör att det naturliga sättet att ställa frågor också blir det snabba sättet.

Frågeoptimering (enkelt språk)

Frågeoptimering handlar om att förbättra hur du hämtar eller uppdaterar data: skriva om frågor, lägga till index, minska onödigt arbete och undvika mönster som orsakar stora skanningar.

Båda är viktiga—tidsordningen är viktigare

Det här är inte "schema bra, frågor dåliga". Det handlar om arbetsordning: få grunderna i databasschemat rätt först, och tunna sedan de frågor som verkligen behöver det.

Du får lära dig varför schemabeslut dominerar tidig prestanda, hur du känner igen när schemat är den verkliga flaskhalsen och hur du utvecklar det säkert allteftersom appen växer. Texten riktar sig till produktteam, grundare och utvecklare som bygger verkliga appar—inte till databasspecialister.

Varför schemadesign driver mest tidig prestanda

Tidiga prestandaproblem handlar oftast inte om fiffig SQL—det handlar om hur mycket data databasen tvingas röra vid.

Struktur avgör hur mycket du skannar

En fråga kan bara vara så selektiv som datamodellen tillåter. Om du lagrar "status", "typ" eller "ägare" i löst strukturerade fält (eller spritt över inkonsekventa tabeller) måste databasen ofta skanna många fler rader för att ta reda på vad som matchar.

Ett bra schema smalnar naturligt av sökutrymmet: tydliga kolumner, konsekventa datatyper och välavgränsade tabeller gör att frågor filtrerar tidigare och läser färre sidor från disk eller minne.

Saknade nycklar skapar dyrt arbete

När primära nycklar och främmande nycklar saknas (eller inte upprätthålls) blir relationer gissningar. Det flyttar arbete till frågelagret:

- Joins blir större eftersom det inte finns någon pålitlig, indexerad join-väg.

- Filter blir mer komplexa eftersom du kompenserar för dubbletter, nulls och "nästan matchande" värden.

Utan constraints samlas dåliga data—så frågorna blir långsammare i takt med att du lägger till fler rader.

Index följer schemat (och kan inte lösa allt)

Index är mest användbara när de matchar förutsägbara åtkomstvägar: join via foreign keys, filtrering på väldefinierade kolumner, sortering på vanliga fält. Om schemat lagrar viktiga attribut i fel tabell, blandar betydelser i en kolumn eller förlitar sig på textparsing, kan inte index rädda situationen—du skannar och transformerar fortfarande för mycket.

Snabbt som standard

Med rena relationer, stabila identifierare och vettiga tabellgränser blir många vardagsfrågor "snabba som standard" eftersom de rör mindre data och använder enkla, indexvänliga predikat. Frågeoptimering blir då en avslutande åtgärd—inte en ständig brandkårsinsats.

Tidig fas: förändring är konstant

Tidiga produkter har sällan "stabila krav"—de har experiment. Funktioner släpps, skrivs om eller försvinner. Ett litet team jonglerar roadmap-press, support och infrastruktur med begränsad tid att återbesöka gamla beslut.

Vad ändras oftast

Det är sällan själva SQL-texten som ändras först. Det är datans betydelse: nya tillstånd, nya relationer, nya "åh, vi måste också spåra…"-fält och hela arbetsflöden som inte fanns vid lansering. Denna churn är normal—och det är precis därför schemaval spelar så stor roll tidigt.

Varför det är svårare att fixa schema senare än en fråga

Att skriva om en fråga är oftast reversibelt och lokalt: du kan skicka en förbättring, mäta den och rulla tillbaka vid behov.

Att skriva om ett schema är annorlunda. När du väl har lagrat verkliga kunddata blir varje strukturell ändring ett projekt:

- Migrationer som låser tabeller eller saktar ner skrivningar vid topptider

- Backfills för att fylla nya kolumner eller återskapa härledda data

- Dual-write eller shadow-tabeller för att hålla appen igång under en övergång

- Risk för driftstopp om ändringen inte kan ske online

Även med bra verktyg medför schemaändringar koordineringskostnader: appkoduppdateringar, deploymentssekvenser och datavalidering.

Hur tidiga beslut förstärks

När databasen är liten kan ett klumpigt schema verka "fint". När rader växer från tusentals till miljoner skapar samma design större skanningar, tyngre index och dyrare joins—och varje ny funktion byggs ovanpå den grunden.

Målet i tidig fas är inte perfektion. Det är att välja ett schema som kan absorbera förändring utan att tvinga fram riskfyllda migrationer varje gång produkten lär sig något nytt.

Designprinciper som förebygger långsamma frågor

De flesta "långsamma fråga"-problem i början handlar inte om SQL-tricks—de handlar om tvetydighet i datamodellen. Om schemat gör det oklart vad en rad representerar eller hur rader relaterar, blir varje fråga dyrare att skriva, köra och underhålla.

Börja med ett litet set kärn-entities

Börja med att namnge de få saker din produkt inte kan fungera utan: users, accounts, orders, subscriptions, events, invoices—vad som än är riktigt centralt. Definiera sedan relationer uttryckligen: one-to-many, many-to-many (vanligtvis med en join-tabell) och ägarskap (vem "äger" vad).

Ett praktiskt test: för varje tabell ska du kunna avsluta meningen "En rad i den här tabellen representerar ___." Om du inte kan det blandar tabellen sannolikt begrepp, vilket senare tvingar fram komplexa filter och joins.

Gör namngivning och ägarskap tråkigt konsekventa

Konsekvens förhindrar oavsiktliga joins och förvirrande API-beteende. Välj konventioner (snake_case vs camelCase, *_id, created_at/updated_at) och håll dig till dem.

Bestäm också vem som äger ett fält. Till exempel: hör "billing_address" till en order (snapshot i tiden) eller till en user (aktuell standard)? Båda kan vara giltiga—men att blanda dem utan tydlig avsikt skapar långsamma, felbenägna frågor för att "ta reda på sanningen".

Välj datatyper som matchar verkligheten

Använd typer som undviker runtime-konverteringar:

- Använd timestamps med tidszonsregler du förstår.

- Använd decimals för pengar (inte floats).

- Använd enums/referenstabeller för kända kategorier.

När typer är fel kan databaser inte jämföra effektivt, index blir mindre användbara och frågor behöver ofta casting.

Duplicera inte fakta utan en plan

Att lagra samma fakta på flera ställen (t.ex. order_total och sum(line_items)) skapar drift. Om du cachar ett härlett värde, dokumentera det, definiera sanningskällan och säkerställ uppdateringar konsekvent (ofta via applikationslogik plus constraints).

Nycklar och begränsningar: snabbhet börjar med dataintegritet

En snabb databas är oftast en förutsägbar databas. Nycklar och constraints gör dina data förutsägbara genom att förhindra "omöjliga" tillstånd—saknade relationer, dubbletter eller värden som inte betyder det appen tror. Den renheten påverkar prestanda direkt eftersom databasen kan göra bättre antaganden vid planering av frågor.

Primära nycklar: varje tabell behöver en stabil identifierare

Varje tabell bör ha en primärnyckel (PK): en kolumn (eller liten uppsättning kolumner) som unikt identifierar en rad och aldrig ändras. Det här är inte bara en teoretisk databasregel—det låter dig också göra effektiva joins, cache:a säkert och referera poster utan gissningar.

En stabil PK undviker också dyra workaround. Om en tabell saknar en riktig identifierare börjar applikationer "identifiera" rader via e-post, namn, tidsstämplar eller en bunt kolumner—vilket leder till bredare index, långsammare joins och kantfall när de värdena ändras.

Främmande nycklar: integritet som hjälper optimeraren

Foreign keys (FKs) upprätthåller relationer: en orders.user_id måste peka på en befintlig users.id. Utan FKs kryper ogiltiga referenser in (orders för borttagna users, kommentarer för saknade inlägg), och då måste varje fråga defensivt filtrera, left-join:a och hantera nulls.

Med FKs på plats kan fråga-planeraren ofta optimera joins mer självsäkert eftersom relationen är explicit och garanterad. Du samlar också mindre sannolikt på dig föräldralösa rader som gör tabeller och index större över tid.

Constraints som bortre väggar för rena, snabba data

Constraints är inte byråkrati—de är bortre väggar:

- UNIQUE förhindrar dubbletter som tvingar appen att göra extra uppslag och städning. Exempel: en kanonisk

users.email. - NOT NULL undviker tri-state-logik och överraskande null-hanteringsgrenar i frågor.

- CHECK håller värden inom en känd mängd (t.ex.

status IN ('pending','paid','canceled')).

Renare data betyder enklare frågor, färre fallback-villkor och färre "bara för säkerhets skull"-joins.

Vanliga antipatterns som bromsar dig

- Inga foreign keys: du får städuppgifter senare och komplicerad frågelogik.

- Duplicerade "email"-fält (t.ex.

users.emailochcustomers.email): du får konfliktande identiteter och duplikatindex. - Friforms status-strängar: stavfel som "Cancelled" vs "canceled" skapar dolda segment som bryter filter och rapportering.

Om du vill ha tidig snabbhet, gör det svårt att lagra dåliga data. Databasen belönar dig med enklare planer, mindre index och färre prestandaöverraskningar.

Normalisering vs denormalisering: en praktisk balans

Återställ riskfyllda databasändringar

Ta en snapshot före migrationer och rulla tillbaka snabbt vid behov.

Normalisering är en enkel idé: lagra varje "fakta" på ett ställe så att du inte duplicerar data över hela databasen. När samma värde kopieras till flera tabeller eller kolumner blir uppdateringar riskfyllda—en kopia ändras, en annan inte, och din app börjar visa motstridiga svar.

Normalisering (standard): en faktum, ett hem

I praktiken betyder normalisering att skilja på entiteter så att uppdateringar blir rena och förutsägbara. Till exempel hör en produkts namn och pris i products-tabellen, inte upprepade inne i varje order-rad. Ett kategorinamn hör hemma i categories, refererat via ett ID.

Detta minskar:

- duplicerade data (mindre lagring, färre inkonsekvenser)

- uppdateringsfel (ändra en gång, reflekteras överallt)

- förvirrande "vilket värde är korrekt?"-buggar

När över-normalisering gör ont

Normalisering kan gå för långt när du delar upp data i många små tabeller som måste joinas konstant för vanliga vyer. Databasen kan fortfarande leverera korrekta resultat, men vanliga läsningar blir långsammare och mer komplexa eftersom varje förfrågan behöver flera joins.

Ett typiskt tidigt symptom: en "enkel" sida (som orderhistorik) kräver join av 6–10 tabeller, och prestandan varierar beroende på trafik och cache-värme.

En praktisk strategi: normalisera kärnfakta, denormalisera var det behövs

En vettig balans är:

- Normalisera kärnfakta och ägarskap (sanningskällan). Ha produktattribut i

products, kategorinamn icategoriesoch relationer via foreign keys. - Denormalisera försiktigt för de hetaste läsningarna—men bara när du kan förklara fördelen och hur det hålls korrekt.

Denormalisering betyder att avsiktligt duplicera en liten bit data för att göra en frekvent fråga billigare (färre joins, snabbare listor). Nyckelordet är försiktigt: varje duplicerat fält behöver en plan för hur det hålls uppdaterat.

Exempel: produkter, kategorier och order_items

Ett normaliserat upplägg kan se ut så här:

products(id, name, price, category_id)categories(id, name)orders(id, customer_id, created_at)order_items(id, order_id, product_id, quantity, unit_price_at_purchase)

Notera den subtila vinsten: order_items lagrar unit_price_at_purchase (en form av denormalisering) eftersom du behöver historisk noggrannhet även om produktpriset ändras senare. Den dupliceringen är avsiktlig och stabil.

Om din vanligaste vy är "orders med artikelsammanfattningar" kanske du också denormaliserar product_name in i order_items för att slippa join med products vid varje lista—men bara om du är beredd att hålla det synkat (eller acceptera att det är ett snapshot vid köp).

Indexstrategi följer schemat, inte tvärtom

Index behandlas ofta som en magisk "snabbknapp", men de fungerar bara bra när den underliggande tabellstrukturen är vettig. Om du fortfarande byter namn på kolumner, delar tabeller eller ändrar hur poster relaterar, kommer dina index att förändras också. Index fungerar bäst när kolumner (och hur appen filtrerar/sorterar på dem) är tillräckligt stabila så att du inte bygger om dem varje vecka.

Börja med de frågor din app ställer mest

Du behöver inte perfekt förutsägelse, men du behöver en kort lista över de viktigaste frågorna:

- "Hitta en user via email."

- "Visa senaste orders för en kund."

- "Lista invoices efter status, nyast först."

Dessa uttalanden översätts direkt till vilka kolumner som förtjänar ett index. Om du inte kan säga dem högt är det oftast ett schemaklarhetsproblem—inte ett indexproblem.

Sammansatta index, enkelt förklarat

Ett sammansatt index täcker mer än en kolumn. Kolumnordningen spelar roll eftersom databasen kan använda indexet effektivt från vänster till höger.

Till exempel, om du ofta filtrerar på customer_id och sedan sorterar på created_at, är ett index på (customer_id, created_at) typiskt användbart. Det omvända (created_at, customer_id) hjälper kanske inte samma fråga lika mycket.

Indexera inte allt

Varje extra index har en kostnad:

- Saktare skrivningar: inserts/updates måste uppdatera varje index också.

- Mer lagring: index kan bli en stor del av din databasstorlek.

- Mer komplexitet: extra index gör underhåll och tuning svårare.

Ett rent, konsekvent schema smalnar ner de "rätta" indexen till en liten uppsättning som matchar verkliga åtkomstmönster—utan att du betalar en konstant skriv- och lagringskostnad.

Skrivprestanda: den dolda kostnaden för ett rörigt schema

Planera migrationer innan lansering

Använd planeringsläge för att kartlägga migrationssteg innan du ändrar produktionsdata.

Långsamma appar beror inte alltid på läsningar. Många tidiga prestandaproblem visar sig vid inserts och updates—användarregistreringar, kassa-flöden, bakgrundsjobb—eftersom ett rörigt schema gör att varje skrivning gör extra arbete.

Varför skrivningar blir dyra

Några schemaval multiplicerar tyst kostnaden för varje ändring:

- Breda rader: att stoppa dussintals (eller hundratals) kolumner i en tabell ger ofta större rader, mer I/O och mer cache-churn—även om de flesta kolumner sällan används.

- För många index: index snabbar upp läsningar, men varje insert/update måste också uppdatera varje index.

- Triggers och kaskader: triggers kan dölja arbete (extra inserts/updates) bakom en enkel

INSERT. Kaskaderande foreign keys kan vara korrekta och hjälpsamma, men de lägger också till skrivtid som växer med relaterad data.

Read-heavy vs write-heavy: välj din smärta med avsikt

Om din belastning är read-heavy (feeds, söksidor) kan du ha fler index och ibland selektiv denormalisering. Om den är write-heavy (event-ingestion, telemetri, högvolymsorders) prioritera ett schema som håller skrivningar enkla och förutsägbara, och lägg till läsoptimeringar där de behövs.

Vanliga tidiga mönster som skadar skrivningar

- Audit logs: bra för efterlevnad, men undvik att logga stora snapshots vid varje update.

- Event-tabeller: append-only tabeller skalar väl, men kan bli uppblåsta om du lagrar redundanta payloads.

- Soft deletes: bekvämt, men ökar indexstorlek och kan sakta ned uppdateringar och frågor om det inte planeras.

Håll skrivningar enkla och bevara historik

En praktisk metod:

- Spara "aktuellt tillstånd" i en tabell, och historiken i en separat append-only-tabell.

- Håll historikrader smala (endast det du verkligen behöver: vem/när/vad ändrades).

- Lägg till index på historik baserat på verkliga åtkomstmönster (vanligtvis

entity_id,created_at). - Undvik triggers för auditing i början; föredra explicita applikationsskrivningar så kostnaden är synlig och testbar.

Rena skrivvägar ger dig utrymme—och gör senare frågeoptimering mycket enklare.

Hur ORM:er och API:er förstärker schema-beslut

ORM:er gör databasarbete bekvämt: definiera modeller, kalla metoder och data dyker upp. Fällan är att en ORM också kan dölja dyra SQL-mönster tills det verkligen börjar göra ont.

ORM:er: bekvämlighet som kan maskera långsamma mönster

Två vanliga fallgropar:

- Ineffektiva joins: en till synes enkel

.include()eller nästlad serializer kan bli till breda joins, duplicerade rader eller stora sorteringar—särskilt om relationer inte är tydligt definierade. - N+1-frågor: du hämtar 50 poster, och ORM:en kör tyst 50 fler frågor för att ladda relaterad data. Det fungerar ofta i utveckling men kollapsar under verklig trafik.

Ett väl designat schema minskar chansen att dessa mönster uppstår och gör dem enklare att upptäcka när de gör det.

Tydliga relationer gör ORM-användning säkrare

När tabeller har uttryckliga foreign keys, unique constraints och not-null-regler kan ORM:en generera säkrare frågor och din kod kan lita på konsekventa antaganden.

Till exempel, att kräva att orders.user_id finns (FK) och att users.email är unik förhindrar hela klasser av kantfall som annars blir applikationsnivåkontroller och extra frågearbete.

API:er förvandlar schemaval till produktbeteende

Din API-design är nedströms av ditt schema:

- Stabilt ID-format (och konsekventa nyckeltyper) gör URL:er, cache och klienttillstånd enklare.

- Paginering fungerar bäst när du kan ordna efter en indexerad, monotont växande kolumn (ofta

created_at+id). - Filtrering blir förutsägbar när kolumner representerar riktiga attribut (inte överbelastade strängar eller JSON-blobs) och constraints håller värden rena.

Gör det till ett arbetsflöde, inte en räddningsaktion

Behandla schemabeslut som förstklassig ingenjörskonst:

- Använd migrationer för varje ändring, granskade som kod (t.ex. /blog/migrations).

- Lägg till lätta "schema reviews" för nya endpoints: vilka tabeller, vilka nycklar, vilka constraints, och vilken frågeform.

- I staging, logga ORM-frågor och flagga N+1-mönster innan produktion (/blog/orm-performance-checks).

Om du bygger snabbt med ett chattdrivet arbetsflöde (till exempel att generera en React-app plus en Go/PostgreSQL-backend i Koder.ai) hjälper det att göra "schema review" till en del av konversationen tidigt. Du kan iterera snabbt, men du vill ändå ha constraints, nycklar och en migrationsplan uttänkt—särskilt innan trafiken kommer.

Tidiga varningssignaler att schemat är flaskhalsen

Vissa prestandaproblem är inte "dålig SQL" utan snarare att databasen kämpar med datans form. Om du ser samma problem över många endpoints och rapporter är det ofta en schemasignal, inte en fråga-tuning-möjlighet.

Vanliga symtom att bevaka

Långsamma filter är ett klassiskt tecken. Om enkla villkor som "hitta orders per kund" eller "filtrera efter created date" konsekvent är tröga kan problemet vara saknade relationer, fel matchade typer eller kolumner som inte kan indexeras effektivt.

En annan varningsflagg är att antalet joins exploderar: en fråga som borde join:a 2–3 tabeller slutade i 6–10 tabeller för att svara på en grundläggande fråga (ofta p.g.a. över-normaliserade uppslag, polymorfa mönster eller "allt i en tabell").

Kolla också efter inkonsekventa värden i kolumner som beter sig som enums—särskilt statusfält ("active", "ACTIVE", "enabled", "on"). Inkonsekvens tvingar defensiva frågor (LOWER(), COALESCE(), OR-kedjor) som förblir långsamma oavsett tuning.

Snabb schema-checklista (enkelt att verifiera)

- Saknade index på foreign keys (joins blir fulla skanningar när tabeller växer).

- Fel datatyper (t.ex. IDs som strings, datum som text, pengar som floats).

- EAV-tabeller (Entity–Attribute–Value) för kärndata: flexibla först, men filter/sortering blir många joins och svåra att indexera.

Enkla, verktygsoberoende diagnoser

Börja med verklighetskontroller: radantal per tabell och kardinalitet för nyckelkolumner (hur många distinkta värden). Om en "status"-kolumn förväntas ha 4 värden men du hittar 40, läcker schemat redan komplexitet.

Titta sedan på frågeplaner för dina långsamma endpoints. Om du ofta ser sekventiella skanningar på join-kolumner eller stora mellanresultat är schema och index troliga orsaker.

Slutligen, slå på och granska slow query-loggar. När många olika frågor är långsamma på liknande sätt (samma tabeller, samma predikat) är det oftast ett strukturellt problem värt att åtgärda på modellnivå.

Utveckla schemat säkert i takt med att du växer

Bygg React och Go snabbt

Skapa en React-app med en Go- och PostgreSQL-backend från en konversation.

Tidiga schemaval överlever sällan första kontakten med verkliga användare. Målet är inte att "få det perfekt"—det är att kunna ändra det utan att bryta produktion, förlora data eller frysa teamet en vecka.

Ett lättviktigt, upprepbart förändringsflöde

Ett praktiskt arbetsflöde som skalar från enpersonapp till större team:

- Modellera: Skriv ner den nya formen (tabeller/kolumner, relationer och vad som blir sanningskällan). Inkludera exempelposter och kantfall.

- Migrera: Lägg till nya strukturer på ett bakåtkompatibelt sätt (nya kolumner/tabeller först; undvik att ta bort eller byta namn direkt).

- Backfill: Populera nya fält från befintliga data i batcher. Spåra framsteg så du kan återuppta.

- Validera: Lägg till constraints först efter att datan är ren (t.ex. NOT NULL, foreign keys). Kör kontroller som jämför gammalt mot nytt utdata.

Feature flags och dual writes (använd sparsamt)

De flesta schemaändringar kräver inte komplexa rollout-mönster. Föredra "expand-and-contract": skriv kod som kan läsa både gammalt och nytt, och byt sedan skrivsätt när du är säker.

Använd feature flags eller dual writes endast när du verkligen behöver gradvis övergång (hög trafik, långa backfills eller flera tjänster). Om du dual-writer, lägg till övervakning för att upptäcka drift och definiera vilken sida som vinner vid konflikt.

Rollbacks och migrations-testning som speglar verkligheten

Säkra rollbacks börjar med migrationer som är reversibla. Öva på "undo"-vägen: ta bort en ny kolumn är lätt; återställa överskrivna data är det inte.

Testa migrationer på verklighetstrogna datavolymer. En migration som tar 2 sekunder på en laptop kan låsa tabeller i flera minuter i produktion. Använd produktionsliknande radantal och index, och mät körningstid.

Här kan plattformsverktyg minska risken: pålitliga deploys plus snapshots/rollback (och möjligheten att exportera kod) gör det säkrare att iterera på schema och applikationslogik tillsammans. Om du använder Koder.ai, lita på snapshots och planeringsläge när du ska införa migrationer som kan kräva noggrann sekvensering.

Dokumentera beslut för nästa person (inklusive framtida du)

Behåll en kort schema-logg: vad ändrades, varför och vilka trade-offs som accepterades. Länka den från /docs eller din repo README. Inkludera anteckningar som "denna kolumn är avsiktligt denormaliserad" eller "foreign key lades till efter backfill 2025-01-10" så att framtida ändringar inte upprepar gamla misstag.

När ska du optimera frågor (och en rimlig ordning)

Frågeoptimering spelar roll—men den lönar sig mest när schemat inte kämpar emot dig. Om tabeller saknar tydliga nycklar, relationer är inkonsekventa eller "en rad per sak" bryts kan du lägga timmar på att tunna frågor som ändå kommer skrivas om nästa vecka.

En praktisk prioriteringsordning

-

Fixa schema-blockerare först. Åtgärda allt som gör korrekt frågning svårt: saknade primära nycklar, inkonsekventa foreign keys, kolumner som blandar flera betydelser, duplicerad sanningskälla eller typer som inte matchar verkligheten (t.ex. datum som strängar).

-

Stabilisera åtkomstmönstren. När datamodellen speglar hur appen beter sig (och sannolikt kommer göra under de kommande sprintarna) blir frågetuning hållbar.

-

Optimera toppfrågorna—inte alla frågor. Använd loggar/APM för att identifiera de långsammaste och mest frekventa frågorna. En endpoint med 10 000 träffar/dag slår oftast en sällsynt adminrapport.

80/20 för tidig frågetuning

De flesta tidiga vinster kommer från några få åtgärder:

- Lägg till rätt index för dina vanligaste filter och joins (och verifiera att det används).

- Returnera färre kolumner (undvik

SELECT *, särskilt på breda tabeller). - Undvik onödiga joins—ibland finns en join bara för att schemat tvingar dig att "upptäcka" grundläggande attribut.

Sätt förväntningar: det är pågående, men grunderna först

Prestandaarbete tar aldrig slut, men målet är att göra det förutsägbart. Med ett rent schema lägger varje ny funktion till en inkrementell belastning; med ett rörigt schema adderar varje funktion sammansatt förvirring.

Checklista för den här veckan

- Lista de 5 långsammaste och 5 mest frekventa frågorna.

- För varje: bekräfta att primärnyckel finns, joins är key-to-key, och att typerna är korrekta.

- Lägg till ett index som matchar det dominerande filtret/order.

- Byt ut

SELECT *i en het väg. - Mät igen och skriv en enkel "före/efter"-anteckning för nästa sprint.