Ersätt, Förstärk, Orört: Ett enkelt ramverk

Samtal om vad “AI kommer att göra med utvecklare” blir snabbt röriga eftersom vi ofta blandar ihop verktyg med ansvar. Ett verktyg kan generera kod, sammanfatta ett ärende eller föreslå tester. Ett ansvar är vad teamet fortfarande hålls ansvarigt för när förslaget är felaktigt.

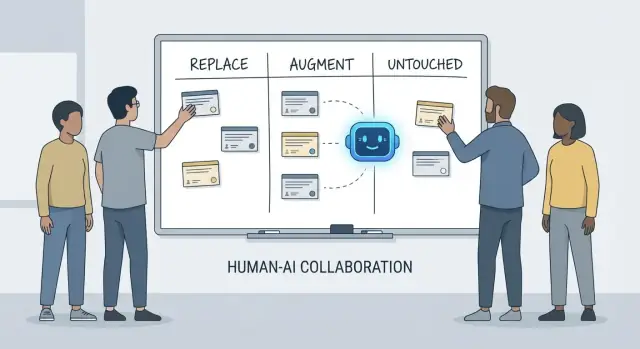

Denna artikel använder ett enkelt ramverk—ersätt, förstärk, orört—för att beskriva vardagligt arbete i verkliga team med tidsfrister, legacy-kod, produktionsincidenter och intressenter som förväntar sig pålitliga resultat.

Vad “ersätt” betyder (och vad det inte betyder)

Ersätt betyder att AI kan slutföra uppgiften från början till slut för det mesta med tydliga styrregler, och den mänskliga rollen skiftar till övervakning och stickprovskontroller.

Exempel är ofta avgränsat arbete: generera boilerplate, översätta kod mellan språk, skriva repetitiva testfall eller producera första utkast av dokumentation.

Ersätt betyder inte “ingen mänsklig ansvarighet.” Om utdata bryter produktion, läcker data eller bryter mot standarder ligger ansvaret fortfarande på teamet.

Vad “förstärk” betyder

Förstärk betyder att AI gör en utvecklare snabbare eller mer noggrann, men det avslutar inte jobbet pålitligt utan mänskligt omdöme.

Detta är det vanliga fallet i professionell ingenjörskonst: du får användbara utkast, alternativa angreppssätt, snabba förklaringar eller en kortlista över sannolika buggar—men en utvecklare bestämmer fortfarande vad som är korrekt, säkert och lämpligt för produkten.

Vad som förblir “orört”

Orört betyder att kärnansvaret förblir mänskligt eftersom det kräver kontext, avvägningar och ansvar som inte enkelt komprimeras till prompts.

Tänk: förhandla krav, välja systemnivåbegränsningar, hantera incidenter, sätta kvalitetsnivåer och fatta beslut där det inte finns ett enda “rätt” svar.

Varför ansvar är analysenheten

Verktyg förändras snabbt. Ansvar förändras långsamt.

Så istället för att fråga “Kan en AI skriva denna kod?”, fråga “Vem äger resultatet?” Den vinkeln håller förväntningarna förankrade i noggrannhet, pålitlighet och ansvar—saker som betyder mer än imponerande demoar.

Vad vi menar med “utvecklaransvar”

När folk frågar vad AI “ersätter” i utveckling menar de ofta uppgifter: skriv en funktion, generera tester, utarbeta dokumentation. Team levererar dock inte uppgifter—de levererar resultat. Därför spelar utvecklaransvar roll.

Det vanliga ansvarspaketet

En utvecklares jobb sträcker sig ofta längre än kodningstid:

- Leverans: förvandla en vag idé till fungerande mjukvara som levereras i tid.

- Kvalitet: korrekthet, underhållbarhet och förebyggande av regressioner.

- Säkerhet & integritet: säkra standardinställningar, datahantering och hotmedvetenhet.

- Drift: hålla tjänster igång, förstå felmoder och svara på incidenter.

- Kommunikation: samordning med produkt, design, support och andra ingenjörer.

Dessa ansvar sitter över hela livscykeln—från “vad ska vi bygga?” till “är det säkert?” till “vad händer klockan 03:00 när det går sönder?”

Varför det är mer än en checklista

Varje ansvar är egentligen många små beslut: vilka kantfall spelar roll, vilka mätvärden visar hälsa, när ska man kapa scope, om en fix är säker att släppa, hur man förklarar en avvägning för intressenter. AI kan hjälpa till att utföra delar av detta arbete (skriva kodutkast, föreslå tester, sammanfatta loggar), men ansvar handlar om att äga resultatet.

Var handoffs misslyckas

Brott uppstår ofta i överlämningsgränser:

- “QA fångar det” (men ingen definierade vad kvalitet betyder).

- “Säkerhet granskar” (men designen låste redan in riskfyllda val).

- “Drift hanterar det” (men tjänsten byggdes inte för att vara opererbar).

När ägande är oklart faller arbetet i glappen.

Beslutsrätt: vem beslutar vs vem utför

Ett användbart sätt att prata om ansvar är beslutsrätt:

- Vem beslutar krav, avvägningar och acceptabel risk?

- Vem utför implementering och verifiering?

AI kan snabba upp utförandet. Beslutsrätten—och ansvar för resultat—behöver fortfarande ett mänskligt namn vid sidan av.

Arbete AI ofta kan ersätta (med styrregler)

AI-kodassistenter är verkligen användbara när arbetet är förutsägbart, lågriskigt och lätt att verifiera. Tänk på dem som en snabb juniorkollega: bra på att producera ett första utkast, men behöver fortfarande tydliga instruktioner och noggrann kontroll.

I praktiken använder vissa team alltmer “vibe-coding”-plattformar (like Koder.ai) för att snabba upp dessa ersättbara bitar: generera scaffolds, koppla ihop CRUD-flöden och producera initiala utkast av UI- och backendkod från chatt. Nyckeln är densamma: styrregler, granskning och tydligt ägandeskap.

Lågrisk-boilerplate

Mycket utvecklartid går åt till att skapa projektstomme och koppla ihop delar. AI kan ofta generera:

- startfiler och mappar (controllers, routes, DTOs)

- repetitiv “glue code” mellan lager

- enkla CRUD-endpoints som följer ett etablerat mönster

Styrregeln här är konsistens: säkerställ att det matchar era befintliga konventioner och inte hittar på nya mönster eller beroenden.

Mekaniska refaktorer och migreringar

När en ändring mest är mekanisk—byta namn på en symbol över kodbasen, omformatera eller uppdatera enkel API-användning—kan AI snabba upp monotont arbete.

Behandla det ändå som en bulkändring: kör hela testsviten, granska diffar för oavsiktliga beteendeförändringar och undvik att låta AI “förbättra” saker utöver den begärda refaktorn.

Dokumentationsutkast (kräver granskning)

AI kan utarbeta README-filer, inline-kommentarer och changelogs baserat på kod och commit-meddelanden. Det kan öka tydlighet, men också skapa självsäkra felaktigheter.

Bästa praxis: använd AI för struktur och formulering, sedan verifiera varje påstående—särskilt installationssteg, konfigurationsdefaults och kantfall.

Grundläggande testgenerering som utgångspunkt

För väl specificerade, rena funktioner kan AI-genererade enhetstester ge initial täckning och påminna om kantfall. Styrregeln är ägande: du väljer fortfarande vad som är viktigt, lägger till assertioner som speglar verkliga krav och säkerställer att tester fallerar av rätt anledning.

Sammanfattningar av trådar och loggar

När du har långa Slack-trådar, ärenden eller incidentloggar kan AI konvertera dem till koncisa anteckningar och åtgärdspunkter. Håll det grundat genom att tillhandahålla full kontext och verifiera nyckelfakta, tidsstämplar och beslut innan du delar.

Arbete AI mestadels förstärker: snabbare, inte färdigt

AI-kodassistenter är som bäst när du redan vet vad du vill och behöver hjälp att komma vidare snabbare. De kan minska tiden för “skrivarbete” och ge relevant kontext, men de tar inte bort behovet av ägandeskap, verifiering och omdöme.

Snabba upp implementering (starkt första utkast)

Givet en klar spec—inputs, outputs, kantfall och begränsningar—kan AI skissa en rimlig startimplementation: boilerplate, datamappning, API-handlers, migreringar eller en enkel refaktor. Vinsten är momentum: något körbart snabbt.

Men första utkastet missar ofta subtila krav (felsemantik, prestandabegränsningar, bakåtkompatibilitet). Behandla det som en interns utkast: användbart, men inte auktoritativt.

Föreslå alternativ—med avvägningar du måste validera

När du väljer mellan angreppssätt (t.ex. caching vs batching, optimistisk vs pessimistisk låsning) kan AI föreslå alternativ och lista avvägningar. Det är värdefullt för idéarbete, men avvägningarna måste kontrolleras mot ditt systems verklighet: trafikmönster, datakonsistensbehov, driftbegränsningar och teamkonventioner.

Kodförståelse och navigering i kodbasen

AI är också bra på att förklara okänd kod, peka ut mönster och översätta “vad gör det här?” till vanligt språk. Tillsammans med sökverktyg kan det hjälpa svara på “Var används X?” och generera en påverkningslista över sannolika call sites, konfigarationer och tester att granska.

Utvecklarergonomi: bättre återkopplingsloopar

Räkna med praktiska förbättringar: tydligare felmeddelanden, små exempel och färdig-inkopierbara snippets. Dessa minskar friktion, men de ersätter inte noggrann granskning, lokala körningar och riktade tester—särskilt för ändringar som påverkar användare eller produktionssystem.

Produktförståelse och krav: fortfarande människostyrt

AI kan hjälpa dig skriva och förfina krav, men det kan inte pålitligt avgöra vad du bör bygga eller varför det spelar roll. Produktförståelse vilar i kontext: affärsmål, användarproblem, organisationsbegränsningar, kantfall och kostnaden för fel. Dessa inputs finns i samtal, historia och ansvar—saker en modell kan sammanfatta, men inte verkligen äga.

Göra fuzzy mål byggbara

Tidiga förfrågningar låter ofta som “Gör onboarding smidigare” eller “Minska supportärenden.” En utvecklares jobb är att översätta det till klara krav och acceptanskriterier.

Den översättningen är mestadels mänskligt arbete eftersom den kräver följdfrågor och omdömen:

- Vilken användargrupp optimerar vi för, och vilket beteende ska förändras?

- Vad räknas som “klart” och hur mäter vi det?

- Vilka begränsningar är icke-förhandlingsbara (integritet, prestanda, deadlines)?

AI kan föreslå mätvärden eller utarbeta acceptanskriterier, men det vet inte vilka begränsningar som är verkliga om ingen anger dem—och det kommer inte säga ifrån när en förfrågan är självkontradiktorisk.

Avvägningar och förväntningsstyrning

Kravarbete är där obekväma avvägningar träder fram: tid vs kvalitet, hastighet vs underhållbarhet, nya funktioner vs stabilitet. Team behöver en person som gör risker explicita, föreslår alternativ och får intressenter att förstå konsekvenserna.

Ett bra spec är inte bara text; det är en beslutshistorik. Det ska vara testbart och implementerbart, med skarpa definitioner (inputs, outputs, kantfall och felmoder). AI kan hjälpa strukturera dokumentet, men ansvar för korrekthet—och för att säga “det här är otydligt, vi behöver ett beslut”—stannar hos människorna.

Systemdesign och arkitekturbeslut

Systemdesign är där “vad ska vi bygga?” blir “vad ska vi bygga det på, och hur beter det sig när saker går fel?” AI kan hjälpa utforska alternativ, men det kan inte bära konsekvenserna.

Välja en arkitektur som passar verkligheten

Att välja mellan monolit, modular monolith, microservices, serverless eller hanterade plattformar är ingen quiz med ett rätt svar. Det är en frågeställning om passform: förväntad skala, budget, time-to-market och teamets kompetens.

En assistent kan sammanfatta mönster och föreslå referensarkitekturer, men den vet inte att ditt team roterar on-call varje vecka, att rekrytering går långsamt eller att ert databaskontrakt förnyas nästa kvartal. Sådana detaljer avgör ofta om en arkitektur lyckas.

Göra avvägningar explicita

Bra arkitektur handlar mest om avvägningar: enkelhet vs flexibilitet, prestanda vs kostnad, snabbhet idag vs underhållbarhet senare. AI kan snabbt producera för- och nackdelslistor, vilket är användbart—särskilt för dokumentation av beslut.

Vad det inte kan göra är att prioritera när avvägningar skadar. Till exempel: “Vi accepterar något långsammare svarstider för att hålla systemet enklare och lättare att drifta” är ett affärsval, inte en ren teknisk fråga.

Gränser, dataägarskap och felmoder

Att definiera servicegränser, vem som äger vilken data och vad som händer vid partiella avbrott kräver djup produkt- och driftkontext. AI kan brainstorma felmoder (“Vad händer om betalningsleverantören är nere?”), men människor måste bestämma förväntat beteende, kundmeddelanden och rollback-plan.

API:er som förblir användbara

Att designa API:er är att designa ett kontrakt. AI kan hjälpa generera exempel och peka ut inkonsekvenser, men du måste besluta om versionering, bakåtkompatibilitet och vad ni är villiga att stödja på lång sikt.

Att besluta när man inte ska bygga (eller när man ska ta bort)

Kanske det viktigaste arkitekturbeslutet är att säga “nej”—eller att ta bort en funktion. AI kan inte mäta alternativkostnad eller politisk risk. Team kan och bör göra det.

Felsökning och rotorsaksanalys i praktiken

Felsökning är där AI ofta ser imponerande ut—och där det tyst kan slösa mest tid. En assistent kan skanna loggar, peka på misstänkta kodvägar eller föreslå en fix som “verkar rimlig.” Men rotorsaksanalys är inte bara att generera förklaringar; det är att bevisa en förklaring.

AI kan föreslå; du bekräftar rotorsaken

Behandla AI-utdata som hypoteser, inte slutsatser. Många buggar har flera rimliga orsaker, och AI har särskilt stor benägenhet att plocka en prydlig historia som matchar kodsnutten du klistrade in, inte den verkliga körande miljön.

Ett praktiskt arbetsflöde är:

- Be AI om möjliga orsaker och vilken evidens som skulle skilja dem åt.

- Reproducera problemet och samla den evidensen.

- Acceptera först en fix när den verkligen tar bort det fel som observerats och verifiera att det inte återkommer.

Reproduktion och evidensinsamling är fortfarande människostyrt

Pålitlig reproduktion är ett felsökningssuperkraft eftersom det förvandlar ett mysterium till ett test. AI kan hjälpa dig skriva ett minimalt reproduktionsfall, ett diagnostiskt skript eller föreslå extra logging, men du bestämmer vilka signaler som spelar roll: request IDs, timing, miljöskillnader, feature flags, datashape eller samtidighet.

När användare rapporterar symptom (“appen hängde sig”) måste du fortfarande översätta det till systembeteende: vilken endpoint hängde, vilka timeouter slog till, vilka error-budget-signaler förändrades. Det kräver kontext: hur produkten används och vad som är “normalt”.

Undvik “troligt men felaktigt” förklaringar

Om ett förslag inte kan valideras, anta att det är fel tills motsatsen är bevisad. Föredra förklaringar som ger en testbar förutsägelse (t.ex. “detta händer bara på stora payloads” eller “endast efter cache warm-up”).

Patcha, revert eller redesigna?

Även efter att orsaken hittats återstår det svåra beslutet. AI kan skissera avvägningar, men människor väljer respons:

- Patcha snabbt för att stoppa blödningen.

- Revertera för att återställa känt fungerande beteende.

- Redesigna om felet avslöjar en djupare mismatch (prestanda, datamodell eller antaganden).

Rotorsaksanalys är i slutändan ansvarstagande: äg förklaringen, fixen och säkerheten att det inte kommer tillbaka.

Kodgranskning: omdöme och standarder automatiseras inte

Kodgranskning är inte bara en checklista för stilfrågor. Det är stunden ett team bestämmer vad det är villigt att underhålla, stödja och stå till svars för. AI kan hjälpa dig se mer, men det kan inte avgöra vad som spelar roll, vad som passar produktens intention eller vilka avvägningar ditt team accepterar.

Vad AI är bra på vid granskningar

AI-kodassistenter kan agera som ett outtröttligt andra öga. De kan snabbt:

- Flagga sannolika buggar, misstänkta mönster, saknade null-kontroller eller osäker stränghantering.

- Föslå klarare namngivning, refaktorer eller enklare kontrollflöden.

- Peka ut inkonsekvent formattering eller uppenbar duplication.

- Generera granskningsfrågor (“Vad händer om detta API returnerar en tom lista?”).

Använt så här förkortar AI tiden mellan “öppnade PR” och “upptäckta risker.”

Vad som fortfarande kräver mänskligt omdöme

Att granska korrekthet handlar inte bara om att koden kompilerar. Människor kopplar förändringar till verkligt användarbeteende, produktionsbegränsningar och långsiktig underhållbarhet.

En granskare måste fortfarande besluta:

- Vad som ska släppas: AI kan lista problem, men kan inte välja vilka som är releasestor-blockerande.

- Läsbarhet och underhåll: “Tekniskt korrekt” kod kan fortfarande vara förvirrande, bräcklig eller svår att bygga vidare på.

- Kantfall och miljögap: Många fel är “fungerar på min maskin”—konfiguration, datakvibbar, samtidighet eller deployment-timing. AI kan inte pålitligt härleda er runtime-verklighet.

- Standarder och intention: Endast teamet känner sina konventioner, risktolerans och produktmål. En ändring kan vara ren kod men fortfarande fel beteende.

Ett praktiskt arbetsflöde: AI som medgranskare

Behandla AI som en andra granskare, inte slutgiltig godkännare. Be om en riktad genomgång (säkerhet, kantfall, bakåtkompatibilitet), och gör sedan ett mänskligt beslut om scope, prioritet och om ändringen stämmer med teamets standarder och produktintention.