29 aug. 2025·8 min

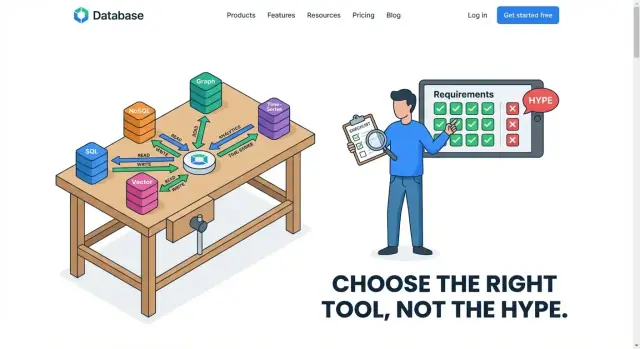

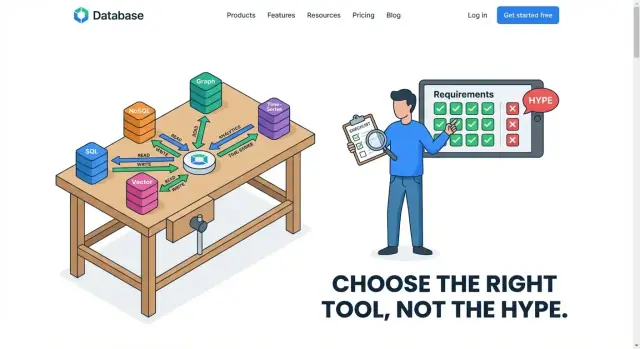

Välj databaser efter åtkomstmönster, inte trender

En praktisk guide för att välja databas utifrån läs-/skrivvägar, latens, konsistens och tillväxtbehov — så att trender inte skapar undvikbar teknisk skuld.

En praktisk guide för att välja databas utifrån läs-/skrivvägar, latens, konsistens och tillväxtbehov — så att trender inte skapar undvikbar teknisk skuld.

Att välja en databas för att den är “populär” är som att köpa ett fordon för att alla pratar om det—utan att kolla om du behöver en scooter, en pickup eller en buss. Trender speglar vad som fungerade för någon annans produkt, teamstorlek, budget och risktolerans. Din databas måste passa din arbetsbelastning: vad din applikation faktiskt gör hela dagarna.

En arbetsbelastning är det faktiska beteendet i din produktionsmiljö:

Dessa beteenden är dina åtkomstmönster—de upprepbara sätten din app rör data. Om du kan beskriva åtkomstmönstren tydligt blir valet av databas mycket mindre mystiskt.

En lösning passar sällan alla. Många framgångsrika system använder en hybrid ansats: en databas optimerad för transaktioner, en annan för analys och ibland en dedikerad sökmotor eller cache. Det är inte “onödig komplexitet”—det är att erkänna att olika åtkomstmönster gynnas av olika lagrings- och frågemotorer.

Innan du jämför “SQL vs NoSQL” eller jagar det som är hett, skriv ner dina topp 5–10 läs- och skrivmönster. Börja där; allt annat är detaljer.

Ett åtkomstmönster är den praktiska beskrivningen av hur din applikation rör data dag till dag: vad den läser, vad den skriver, hur ofta, hur snabbt och i vilka former. Det handlar mindre om vad din data är (“orders” eller “users”) och mer om vad du gör med den (“hämta en order per ID 10 000 gånger per minut” eller “skanna alla ordrar från förra månaden för en rapport”).

Majoriteten av lästrafik hamnar i några igenkännliga kategorier:

Ett socialt flöde är ett bra exempel på blandade läsformer: punktuppslag för profiler, områdesläsningar för “senaste inläggen” och aggregeringar för räkningar.

Skrivmönster spelar lika stor roll:

Loggar är ofta “skrivintensiva och append-only” (många inserts, få uppdateringar). Ordrar är vanligtvis “skriv-och-sen-uppdatera” (skapa, sedan ändras status).

Många produkter vill ha allt på en gång: snabba punktuppslag för appen, komplexa frågor för kundsupport och stora skanningar för analys. En databas kan hantera vissa blandningar väl, men vissa kombinationer strider mot varandra—t.ex. tunga analyskörningar kan sakta ner de små, latenskänsliga läsningar som driver checkout eller ett flöde.

När du tydligt kan namnge dina åtkomstmönster kan du utvärdera databaser utifrån verkligt beteende istället för popularitet.

Innan du jämför databasmärken, namnge arbetsbelastningen du faktiskt servar. De flesta produkter är inte “en enda arbetsbelastning”—de är några olika arbetsbelastningar som sitter sida vid sida (och ibland konkurrerar). Rätt klassificering tidigt hindrar dig från att tvinga in en databas i ett jobb den aldrig var optimerad för.

OLTP är vardagspulsen i de flesta appar: många små läs- och skrivoperationer, många samtidiga användare och förfrågningar som måste slutföras snabbt.

Tänk: “uppdatera varukorg”, “skapa en order”, “ändra adress”, “kolla lager”. Dessa operationer är korta, riktade och korrekthetskänsliga. Om en betalning genomförs får den inte försvinna; om en plats reserveras ska inte två personer få samma plats.

OLTP tenderar att peka mot system som klarar hög samtidighet väl och ger tydliga garantier för transaktioner och dataintegritet.

Analys vänder formen på arbetet: färre frågor, men varje fråga berör mycket mer data.

Tänk: “intäkt per region för förra kvartalet”, “konvertering per kanal”, “toppprodukter per kategori”, “dagliga aktiva användare över tid”. Dessa frågor skannar ofta många rader, grupperar, aggregerar och sorterar. Latensförväntningar kan vara mer eftergivna (sekunder är ofta okej), men kostnaden för tunga skanningar spelar roll—särskilt om dashboards körs hela dagen.

Om du försöker köra OLAP-stil skanningar i samma system som hanterar checkout kommer du ofta att se att en av dem lider.

Tidsserier och loggar är vanligtvis append-intensiva: nya händelser anländer kontinuerligt och du frågar oftast på tidsintervall.

Tänk: metrics, klickström, enhetstelemetri, revisionsloggar. Vanliga behov inkluderar retention (ta bort/utlöpa gammal data), rollups (spara råhändelser i 7 dagar, aggregeringar i 12 månader) och snabba skrivningar under spikar.

Denna arbetsbelastning handlar mindre om komplexa joins och mer om effektiv ingestion av tidsstämplade poster och förutsägbar lagring över tid.

Sök är inte bara “hitta rader”. Det är textmatchning, relevansrankning, partiella träffar och användarvänlig filtrering.

Tänk: söka produkter efter nyckelord, hitta ärenden efter fraser, filtrera efter facets (märke, prisklass, färg) och sortera efter “bäst träff”. Dessa funktioner kräver ofta specialiserade index och frågekapaciteter som allmänna databaser kan approximera—men sällan briljera i.

Om sök är en kärnfunktion i produkten, behandla det som en egen arbetsbelastning från start, inte något “vi lägger till senare”.

Prestanda är inte ett enda tal. Två databaser kan båda vara “snabba”, men kännas helt olika för användare och operatörer. För att välja rätt, separera vad människor uppfattar (latens) från vad systemet måste klara (genomströmning), och testa dina antaganden med spikar.

Latens är hur lång tid en enskild förfrågan tar—“tryck på knappen, få resultat.” Användare upplever latens direkt.

Genomströmning är hur många förfrågningar du kan behandla per sekund—hur mycket trafik systemet klarar totalt.

En databas kan leverera hög genomströmning genom att batcha arbete effektivt, men ändå ha märkbar per-förfrågningsfördröjning. En annan kan optimera för snabba punktläsningar men få problem när många skrivningar anländer samtidigt.

Genomsnittlig latens döljer smärta. Om 99 förfrågningar blir klara på 50 ms och 1 tar 2 sekunder ser medelvärdet okej ut—men den där 1 %-en blir “appen är långsam”-ögonblicket.

Det är vad P99-latens betyder: tiden för de långsammaste 1 % av förfrågningarna. För användarorienterade funktioner (checkout, inloggning, sökresultat) är P99 ofta metrisken som avgör om din databasdesign känns pålitlig.

De flesta system kraschar inte vid genomsnittstrafik; de kraschar under toppar: ett marknadsföringsmail, ett breaking-news-ögonblick, löneutbetalning, månadsslutrapportering.

Spikar ändrar databasdiskussionen:

Caching kan få lästunga arbetsbelastningar att se mindre ut—tills en cache-miss eller rensning inträffar.

Om majoriteten av läsningar träffar en cache, kan din databas främst hantera skrivningar och tillfälliga dyra läsningar. Det favoriserar andra val än ett system där varje läsning går till databasen. Planera för “kalla cache”-händelser och tail-latens för missar, inte bara den lyckliga vägen.

Att välja databas handlar inte bara om hastighet. Det handlar också om vad som får gå fel, hur mycket driftstopp du tål och var dina användare finns.

Börja med att namnge den data som måste vara korrekt varje gång. Betalningar, kontosaldon och lagersaldon är klassiska exempel. Om en kund debiteras två gånger eller du säljer för mycket, är kostnaden inte bara en långsammare app—det är återbetalningar, supportärenden och förlorat förtroende.

För dessa delar vill du oftast ha starka garantier: skrivningar bör bekräftas innan de räknas som klara och läsare ska inte se halvfärdiga uppdateringar. Trade-offen är att starkare korrekthet ofta minskar flexibiliteten: vissa skalningsstrategier blir svårare och skrivningar över regioner kan bli långsammare.

Bestäm vad som händer om databasen är otillgänglig i 5 minuter.

Om driftstopp betyder “ordrar stoppas och intäkter upphör” behöver du högre tillgänglighet: automatisk failover, bra backups och en plan för underhåll utan nedtid. Om driftstopp betyder “interna dashboards fördröjs” kan du acceptera enklare uppsättningar.

Högre tillgänglighet ökar ofta kostnad och driftkomplexitet (fler repliker, mer övervakning, noggrannare uppgraderingar). Nyckeln är att matcha investeringen med affärspåverkan.

Om dina användare mestadels finns i en region kan det vara billigare och snabbare att hålla data på ett ställe. Om du har användare över kontinenter eller regler kring var data får lagras kan du behöva replikering över flera regioner.

Multi-region-design förbättrar upplevelse och motståndskraft, men tvingar svåra val: tillåter du något föråldrade läsningar, eller accepterar du långsammare skrivningar för att hålla allt strikt synkat? Rätt svar beror på vad din arbetsbelastning tolererar.

De flesta “databasdebatter” är i grunden argument om frågeform. Om du vet vilka frågor din app måste kunna ställa—joins, aggregeringar, filter, tidsfönster—kan du ofta snabbt begränsa databasalternativen.

En relationsmodell lyser när du behöver flexibel filtrering och join mellan flera entiteter (kunder → ordrar → artiklar), särskilt när krav utvecklas. Om du behöver ad-hoc-rapportering (“visa alla kunder som köpte X och också returnerade Y”) är SQL och joins ofta enklare över tid.

Om dina frågor är förutsägbara och mestadels sker via primärnyckel (“hämta profil via user_id”), kan ett dokument- eller key-value-format fungera bra—ofta genom att lagra data redan grupperad som du läser den. Trade-offen är att du kan duplicera data för att undvika joins, vilket flyttar komplexitet till skrivningar och uppdateringar.

Index är hur du talar om för en databas “detta är mina åtkomstmönster.” En fråga som ser okej ut i en prototyp kan bli långsam om den filtrerar eller sorterar på icke-indexerade fält.

En bra tumregel: varje frekvent filter, sortering eller join-nyckel bör ha en indexplan. Men index är inte gratis: de tar lagringsutrymme och gör skrivningar tyngre.

Påståenden om “snabba skrivningar” ignorerar ofta write amplification—extra arbete som sekundära index, kompaktering, replikation eller uppdatering av flera kopior av denormaliserad data orsakar. En design som optimerar läs genom fler index eller duplicering kan tyst förvandla en högskrivbelastning till en flaskhals.

Schemalöst betyder inte strukturlöst. Flexibla scheman snabbar upp tidig iteration, men utan konventioner skapar de inkonsekventa fält, svåra att debugga frågor och dyra migrationer senare. När du förväntar många team, många funktioner eller lång retention, minskar ofta ett striktare schema och tydliga begränsningar den totala kostnaden—även om det känns långsammare i början.

Att välja en databas för att den är populär slår ofta tillbaka i de osexiga delarna av ägandet: att hålla den igång, hålla den säker och betala räkningen månad efter månad. Två databaser kan möta samma funktionella krav men skilja sig enormt i driftinsats och total kostnad.

Fråga tidigt vem som kommer driva systemet klockan 02:00. Backups, punkt-i-tid-återställning, uppgraderingar, patchning, failover-övningar och övervakning är inte “saker för senare”—de formar din risk och bemanning.

Hanterade tjänster minskar slit, men eliminerar det inte. Vissa system kräver regelbunden kompaktering, noggrann tuning eller djup expertis för att undvika nedgångar. Andra gör schemaändringar smärtsamma eller kräver speciella migrationsrutiner. Om ditt team är litet kan en databas som är enklare att drifta slå en “perfekt” papperslösning.

Databaskostnader kommer oftast från:

Ett åtkomstmönster tungt på skrivningar och sekundära index kan multiplicera I/O och lagring även när datasetet är litet.

Proprietära frågespråk, unika konsistensegenskaper eller serverless-“magi” kan snabba leverans—men begränsa framtida flytt. Överväg om du kan exportera data, köra lokalt för test eller byta leverantör utan att skriva om appen.

Som minimum: bekräfta kryptering i transit/at-rest, nyckelhanteringsalternativ, auditing, åtkomstkontroller och retentionpolicies. Compliance-krav avgör ofta vad som är “fungerande” kontra “acceptabelt”, oavsett trendfaktor.

När du beskrivit dina åtkomstmönster (vad du läser, vad du skriver, hur ofta och under vilka spikar) blir databasfamiljen ofta tydlig. Målet är inte att välja det mest populära verktyget—utan det enklaste systemet som håller korrekt under din arbetsbelastning.

Välj relationsdatabas när du behöver stark konsistens, tydliga relationer och pålitliga transaktioner—ordrar, betalningar, lager, behörigheter, schemaläggning. Om du ofta frågar över entiteter (“kunder med öppna fakturor de senaste 30 dagarna”) eller måste upprätthålla constraints (unika e-postadresser, foreign keys) tenderar SQL att minska komplexiteten i applikationen.

En vanlig tumregel: om ditt team håller på att återimplementera joins, constraints och transaktioner i kod, vill ni troligen en relationsdatabas.

En dokumentdatabas passar bäst när du mest läser/skriv hela objekt som kan variera i struktur, såsom användarprofiler, innehållssidor, produktkataloger med valfria fält eller inställningar. Om din typiska fråga är “hämta profil via user_id” och uppdatera delar av den, kan dokument hålla det du använder tillsammans.

Var försiktig när dina frågor blir mycket relationella (många cross-document-frågor) eller när du behöver transaktionella garantier över flera entiteter.

Key-value-system passar caching, sessions, rate limits, feature flags och kortlivat state där åtkomstmönstret är “get/set via key” och latens spelar roll. De är ofta ett komplement, inte ett primärt register.

Om du lagrar varaktiga affärsdata, fundera på vad som händer vid eviction, omstarter eller replikationsfördröjningar.

För analys—dashboards, kohort-analys, intäktsrollups, “group by”-frågor över lång historik—vinner kolumnorienterade/warehouse-system eftersom de är optimerade för att skanna och aggregera många rader effektivt.

Ett praktiskt upplägg: behåll OLTP-skrivningar i din primära databas och mata ett warehouse för rapportering. Det undviker att sänka kundorienterade frågor med BI-arbete.

Många framgångsrika produkter “väljer inte en databas”. De mappar varje större åtkomstmönster till den enklaste lagringen som tjänar det väl, även om det innebär två eller tre databaser sida vid sida.

En nätbutik har ofta tre väldigt olika arbetsbelastningar:

Produkten känns enhetlig, men lagringen är specialiserad per åtkomstmönster.

Ett B2B SaaS-verktyg kan lagra kärnentiteter (projekt, fakturor, ärenden) i en transaktionell databas, men ändå behöva:

IoT-plattformar tar emot burstar av telemetri och läser sedan tillbaka det för tidsfönsterbaserade dashboards.

Ett vanligt upplägg är: en snabb ingestbutik för färsk data, billigare långtidslagring för retention och en analysmotor för aggregeringar.

Huvudpoängen: olika komponenter kan—och ofta bör—använda olika databaser när åtkomstmönstren skiljer sig.

En felmatchning visar sig ofta som en växande hög av “små” lösningar. Om ditt team spenderar mer tid på att slåss med databasen än att bygga produktfunktioner, var uppmärksam—det är ofta åtkomstmönster, inte tuning.

Flera varningssignaler återkommer:

Om databasen kräver heroiska insatser för att stödja normala affärsoperationer matchar troligen arbetsbelastningen och databasfamiljen inte.

Att välja databas för att den är populär kan binda dig till långsiktiga kostnader:

Räkningen kommer när du växer eller kraven ändras, och den realistiska lösningen är ofta en smärtsam omläggning.

Du behöver inte perfekt observabilitet, men några signaler:

Skriv ner topp åtkomstmönster (läs/skriv, nyckelfrågor, topphastigheter), antaganden om datavolymer och “icke-förhandlingsbara” krav (konsistens, tillgänglighet, regionsbegränsningar). Lägg till referenser till dashboards och exempel på de värsta frågorna. Denna korta sammanställning gör framtida beslut snabbare—och visar när en databas inte längre passar verkligheten.

Att välja databas blir enklare om du behandlar det som kravinsamling, inte en popularitetsstävling. Använd denna checklista för att omvandla fuzzy “vi behöver något skalbart” till konkreta ingångar du kan jämföra.

Svara på dessa i enkelt språk först, lägg sedan till siffror där du kan:

Gör en enkelsidig tabell med kriterier i vänsterkolumn och kandidater överst. Markera varje kriterium som måste-ha eller bra-att-ha, och poängsätt varje databas (till exempel 0–2).

Inkludera åtminstone: frågepassform, skalningssätt, konsistensbehov, driftinsats, ekosystem/tooling och kostnadspålitlighet.

Testa med representativ data och verkliga frågor, inte leksaksexempel. Återskapa “toppfrågorna” och ett realistiskt skrivmönster (inklusive spikar).

Om du itererar snabbt på produktidéer kan en vibe-coding-miljö som Koder.ai hjälpa dig att snabbt snurra upp en fungerande app och validera åtkomstmönster tidigt: generera en React-front med en Go + PostgreSQL-backend, modellera några riktiga endpoints och mät hur dina “topp 5-frågor” beter sig innan du binder dig till en långsiktig arkitektur. Möjligheten att exportera källkod och behålla kontroll över schema och migrationer hjälper dig också att undvika att måla in dig i ett hörn.

Skriv ner vad “godkänt” betyder i förväg: latensmål, acceptabla felnivåer, driftsteg som krävs (backup, schemaändringar) och en uppskattad månadskostnad vid förväntad användning. Om en kandidat inte kan uppfylla ett måste i PoC, eliminera den snabbt.

Framtidssäkring handlar inte om att välja den “mest skalbara” databasen från dag ett. Det handlar om genomtänkta val som håller dig rörlig när åtkomstmönster förändras.

Om din arbetsbelastning mestadels är transaktionell läs-/skriv med okomplicerade frågor är en relationsdatabas ofta snabbaste vägen till en pålitlig produkt. Målet är att skicka med förtroende: förutsägbar prestanda, tydliga korrekthetsgarantier och verktyg ditt team redan förstår.

“Framtidssäkra” här innebär att undvika irreversibla åtaganden tidigt—som att adoptera en specialiserad butik innan du bevisat att du behöver dess trade-offs.

Bygg ett tydligt dataåtkomstlager (eller servicegräns) så resten av appen inte beror på databas-specifika quirks. Centralisera frågelogik, definiera kontrakt (in/ut) och behandla schemaändringar som en vanlig del av utvecklingen.

Några praktiska vanor som hjälper vid senare migrationer:

Många produkter behöver så småningom två vägar: OLTP för dagliga transaktioner och analys för rapportering, experiment och tunga aggregeringar. Dela när analysfrågor börjar skada produktionens latens eller när du behöver olika retention/partitionering.

För att hålla dem synkade, standardisera event/data-definitioner, automatisera pipelines och avstäm totalsummor (t.ex. daglig försäljning) mellan systemen så att “sanningen” inte fragmenteras.

Om du vill ha ett konkret nästa steg, bygg en lättviktig migrationsplanmall ditt team kan återanvända.

Ett åtkomstmönster är det upprepade sätt ditt app rör data i produktion: vad som läses/skrivs, hur ofta, hur snabbt och i vilka frågeformer (punktuppslag, intervallläsningar, joins, aggregeringar, tidsfönster osv.). Det är mer handlingsbart än “vi har användare och ordrar” eftersom det kopplar direkt till index, schema-val och vilken databas som passar.

Eftersom “populär” speglar andras begränsningar, inte dina. Samma databas kan fungera utmärkt för en arbetsbelastning (t.ex. OLTP) och vara plågsam för en annan (t.ex. tunga analyskörningar). Börja med att lista dina topp 5–10 läsningar och skrivningar, och utvärdera databaser mot de beteendena istället för efter varumärkes- eller trendmomentum.

Skriv ner:

Detta blir ditt kravdokument för att jämföra alternativ.

OLTP är många små, samtidiga, korrekthetskänsliga operationer (checkout, lageruppdateringar, kontoförändringar) där transaktioner och constraints spelar roll.

OLAP/analys är färre frågor som berör mycket data (scans, group-bys, dashboards) där sekundnivåer ofta är acceptabla men tunga läsningar kan bli kostsamma.

Att köra båda på samma system gör ofta att analyskörningar påverkar användarorienterad latens negativt.

Titta på p95/p99-latens, inte bara medelvärden. Om de långsammaste 1 % av förfrågningarna tar flera sekunder uppfattas appen som opålitlig även om genomsnittet ser bra ut.

Praktisk tips: följ p95/p99 separat för kritiska endpoints (inloggning, checkout, sök) och korrelera topparna med databas-metriker (låskonflikter, replikationsfördröjning, I/O-belastning).

De har ofta konkurrerande behov:

Att använda specialiserade lagringssystem kan vara enklare totalt sett än att tvinga en databas att göra allt via hackar.

Caching kan göra en lästung arbetsbelastning mindre synlig—tills det blir cache-miss eller cache-rensning.

Det förändrar vad som är viktigt:

En cache kan dölja problem tillfälligt men också skapa kraftiga felomgångar om missar överbelastar databasen.

Stark korrekthet betyder att du behöver garantier för transaktioner och synlighet av uppdateringar (inga “halvskrivna” tillstånd). Det är särskilt viktigt för betalningar, saldon, lager och reservationer.

Trade-offs kan inkludera:

Definiera vad som är “får aldrig vara fel” kontra vad som kan tolerera viss fördröjning.

Indexering är prestandakontraktet mellan ditt arbetsmönster och databasen. Planera index för frekventa:

Men index kostar: de tar plats och gör skrivningar tyngre (write amplification). Målet är att indexera det du faktiskt gör ofta, inte allt.

Behandla en PoC som en liten produktionsrepetition:

Om en kandidat inte klarar ett måste i PoC, kasta den tidigt.