08 sep. 2025·8 min

Varför inbyggda ramverk fortfarande betyder något för högpresterande appar

Inbyggda ramverk vinner fortfarande för låg latens, mjuk UI, batteri‑effektivitet och djup hårdvaruåtkomst. Lär dig när native slår cross‑platform.

Inbyggda ramverk vinner fortfarande för låg latens, mjuk UI, batteri‑effektivitet och djup hårdvaruåtkomst. Lär dig när native slår cross‑platform.

”Prestandakritiskt” betyder inte “trevligt att ha snabbt”. Det betyder att upplevelsen faller sönder när appen är ens lite långsam, inkonsekvent eller fördröjd. Användare märker inte bara fördröjningen — de tappar förtroende, missar ett ögonblick eller gör misstag.

Några vanliga app‑typer gör detta tydligt:

I alla dessa är prestanda inte en dold teknisk mätare. Den är synlig, kännbar och döms inom sekunder.

När vi säger inbyggda ramverk menar vi att bygga med verktyg som är förstklassiga på varje plattform:

Native betyder inte automatiskt “bättre ingenjörskonst”. Det betyder att din app talar plattformens språk direkt — särskilt viktigt när du pressar hårt på enheten.

Cross‑platform‑ramverk kan vara ett utmärkt val för många produkter, särskilt när utvecklingshastighet och delad kod väger tyngre än att skära ner varje millisekund.

Den här artikeln säger inte ”native alltid”. Den säger att när en app verkligen är prestandakritisk, tar inbyggda ramverk ofta bort hela kategorier av overhead och begränsningar.

Vi utvärderar prestandakritiska behov över några praktiska dimensioner:

Det här är områden där användare känner skillnad — och där inbyggda ramverk ofta glänser.

Cross‑platform‑ramverk kan kännas “tillräckligt nära” native när du bygger typiska skärmar, formulär och nätverksdrivna flöden. Skillnaden visar sig oftast när en app är känslig för små förseningar, behöver konsekvent bildrutepacing eller måste pressa enheten hårt under långa perioder.

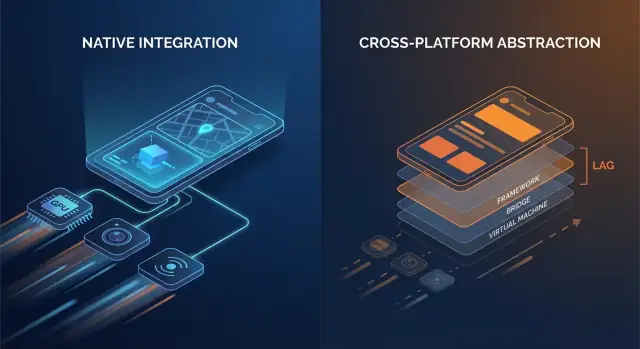

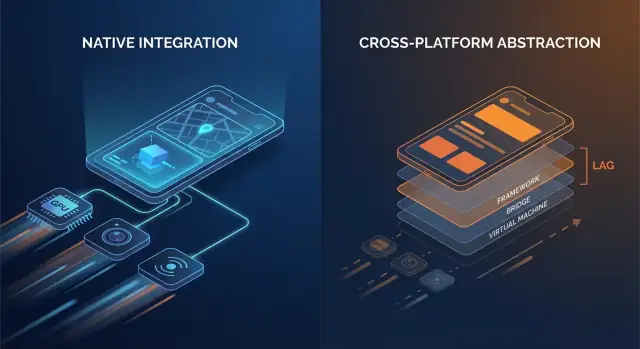

Native‑kod pratar vanligtvis direkt med OS‑API:er. Många cross‑platform‑stackar lägger till ett eller flera översättningslager mellan din affärslogik och vad telefonen slutligen renderar.

Vanliga overhead‑punkter inkluderar:

Ingen av dessa kostnader är enorma var för sig. Problemet är upprepning: de kan inträffa vid varje gest, varje animationsteg och varje listobjekt.

Overhead handlar inte bara om rå hastighet; det handlar också om när arbete sker.

Native‑appar kan också träffa dessa problem — men det finns färre rörliga delar, vilket betyder färre ställen där överraskningar kan gömma sig.

Tänk: färre lager = färre överraskningar. Varje lagt lager kan vara väl engineeringat, men det introducerar ändå mer schemaläggningskomplexitet, mer minnespress och mer översättningsarbete.

För många appar är overheaden acceptabel och produktivitetsvinsten verklig. Men för prestandakritiska appar — snabbscrollande feeds, tunga animationer, realtidssamarbete, ljud/video‑bearbetning eller allt som är latens‑känsligt — kan dessa ”små” kostnader snabbt bli synliga för användaren.

Mjuk UI är inte bara något trevligt att ha — det är en direkt kvalitetsindikator. På en 60 Hz‑skärm har din app ungefär 16,7 ms på sig att producera varje bildruta. På 120 Hz sjunker budgeten till 8,3 ms. När du missar fönstret uppfattar användaren det som stutter (jank): scroll som ”haknar”, övergångar som hoppar eller en gest som känns efter fingret.

Människor räknar inte medvetet rutor, men de märker inkonsekvens. En enstaka missad ruta under en långsam övertoning kan vara acceptabel; några missade rutor under en snabb scroll är omedelbart tydligt. Skärmar med hög uppdateringsfrekvens höjer också förväntningarna — när användare väl upplevt 120 Hz, känns ojämn rendering värre än på 60 Hz.

De flesta UI‑ramverk förlitar sig fortfarande på en primär/UI‑tråd för att samordna inputhantering, layout och teckning. Jank uppstår ofta när den tråden gör för mycket arbete inom en bildruta:

Native‑ramverk tenderar att ha väloptimerade pipelines och tydligare bästa praxis för att hålla arbete utanför main‑tråden, minimera layoutinvalidiseringar och använda GPU‑vänliga animationer.

En viktig skillnad är renderingsvägen:

Komplexa listor är klassiska stresstester: snabb scroll + bildladdning + dynamiska cellhöjder kan skapa layoutkaos och GC/minnespress.

Övergångar kan avslöja pipeline‑ineffektivitet: shared‑element animationer, suddiga bakgrunder och lagerade skuggor är visuellt rika men kan spika GPU‑kostnad och överdraw.

Gest‑tunga skärmar (dra‑för‑att‑ordna, swipe‑kort, scrubbers) är skoningslösa eftersom UI måste svara kontinuerligt. När bildrutorna kommer sent slutar UI kännas ”fäst” vid användarens finger — vilket är precis vad prestandakritiska appar undviker.

Latens är tiden mellan en användaråtgärd och appens respons. Inte generell “hastighet”, utan det gap du känner när du trycker en knapp, skriver en karaktär, drar en slider, ritar en linje eller spelar en ton.

Användbara tumregler:

Prestandakritiska appar — meddelanden, anteckningar, trading, navigation, kreativa verktyg — lever och dör på dessa gap.

De flesta ramverk hanterar input på en tråd, kör app‑logik någon annanstans och ber sedan UI uppdatera. När den vägen är lång eller inkonsekvent, spikear latensen.

Cross‑platform‑lager kan lägga till extra steg:

Varje handoff (ett “tråd‑hopp”) lägger på overhead och framför allt jitter — responstiden varierar, vilket ofta känns värre än en jämn fördröjning.

Native‑ramverk har ofta en kortare, mer förutsägbar väg från touch → UI‑uppdatering eftersom de ligger nära OS‑schemaläggaren, input‑systemet och renderings‑pipen.

Vissa scenarier har hårda gränser:

Native‑först‑implementeringar gör det lättare att hålla den ”kritiska vägen” kort — prioritera input och rendering över bakgrundsarbete så realtidsinteraktioner förblir tajta och förtroendeingivande.

Prestanda handlar inte bara om CPU‑hastighet eller bildfrekvens. För många appar avgörs ögonblicken vid gränserna — där din kod rör kameran, sensorerna, radion och OS‑nivåtjänster. Dessa kapabiliteter designas och släpps som native‑API:er först, och det formar vad som är möjligt (och hur stabilt det är) i cross‑platform‑stackar.

Funktioner som kamerapipelines, AR, BLE, NFC och rörelsesensorer kräver ofta tät integration med enhetsspecifika ramverk. Cross‑platform‑wrappar kan täcka vanliga fall, men avancerade scenarier visar ofta luckor.

Exempel där native‑API:er spelar roll:

När iOS eller Android skickar nya funktioner finns officiella API:er omedelbart i native‑SDK:erna. Cross‑platform‑lager kan behöva veckor (eller längre) för att lägga till bindingar, uppdatera plugins och hantera kantfallen.

Den fördröjningen är inte bara besvärlig — den kan skapa tillförlitlighetsrisk. Om en wrapper inte uppdaterats för en ny OS‑release kan du se:

För prestandakritiska appar minskar native‑ramverk problemet med att behöva vänta på wrappern och låter team ta i bruk nya OS‑möjligheter direkt — ofta skillnaden mellan att lansera en funktion i det här kvartalet eller nästa.

Hastighet i en snabb demo är bara halva historien. Den prestanda användare kommer ihåg är den som håller efter 20 minuters användning — när telefonen är varm, batteriet sjunker och appen varit i bakgrunden några gånger.

De flesta ”mystiska” batteridriften är självförvållade:

Native‑ramverk erbjuder ofta tydligare, mer förutsägbara verktyg för att schemalägga arbete effektivt (bakgrundsuppgifter, jobbschemaläggning, OS‑hanterade uppdateringar), så du kan göra mindre arbete totalt — och göra det vid bättre tidpunkter.

Minne påverkar inte bara om en app kraschar — det påverkar smidigheten.

Många cross‑platform‑stackar förlitar sig på en managed runtime med garbage collection (GC). När minnet växer kan GC pausa appen kort för att rensa oanvända objekt. Du behöver inte förstå detaljerna för att märka det: tillfälliga mikro‑frysningar under scroll, inmatning eller övergångar.

Native‑appar följer ofta plattforms‑mönster (som ARC‑style automatic reference counting på Apple‑plattformar), vilket sprider ut städningen mer jämnt. Resultatet kan bli färre överraskande pauser — särskilt under hårda minnesvillkor.

Värme är prestanda. När enheter blir varma kan OS throttla CPU/GPU‑hastigheter för att skydda hårdvaran, och bildfrekvenser sjunker. Detta är vanligt i uthålliga arbetsbelastningar som spel, navigation, kamera + filter eller realtidsljud.

Native‑kod kan vara mer energieffektiv i dessa scenarier eftersom den kan använda hårdvaruaccelererade, OS‑tunade API:er för tunga uppgifter — t.ex. native video‑pipelines, effektiv sensorprovtagning och plattforms‑media‑codecs — vilket minskar onödigt arbete som blir värme.

När “snabbt” också betyder “svalt och stadigt” har native‑ramverk ofta en fördel.

Prestandaarbete lyckas eller misslyckas beroende på synlighet. Native‑ramverk levereras oftast med de djupaste krokarna in i operativsystemet, runtime och renderings‑pipeline — eftersom de byggs av samma leverantörer som definierar dessa lager.

Native‑appar kan fästa profilers där fördröjningar introduceras: main‑tråden, render‑tråden, systemkompositorn, ljudstacken och nätverk/lagring. När du jagar en stutter som händer en gång var 30:e sekund, eller ett batteridrag som bara syns på vissa enheter, är dessa ”under ramverket” spår ofta det enda sättet att få ett definitivt svar.

Du behöver inte memorera verktygen för att dra nytta av dem, men det är bra att veta vad som finns:

Dessa verktyg svarar på konkreta frågor: “Vilken funktion är het?”, “Vilket objekt blir aldrig frigjort?”, “Vilken bildruta missade sin deadline, och varför?”

De svåraste prestandaproblemen gömmer sig ofta i kantfallen: en sällsynt synkroniserings‑deadlock, en långsam JSON‑parse på main‑tråden, en enskild vy som triggar dyr layout eller en minnesläcka som bara syns efter 20 minuter.

Native‑profilering låter dig korrelera symptom (en frysning eller jank) med orsaker (en specifik call stack, allokeringsmönster eller GPU‑spik) istället för att förlita dig på trial‑and‑error‑ändringar.

Bättre insyn kortar tiden till fix eftersom det förvandlar debatter till bevis. Team kan fånga ett spår, dela det och snabbt enas om flaskhalsen — ofta förvandla dagar av ”kanske är det nätverket” till en fokuserad patch och ett mätbart före/efter‑resultat.

Prestanda är inte det enda som kan gå sönder när du skickar till miljoner telefoner — konsistensen gör det. Samma app kan bete sig annorlunda över OS‑versioner, OEM‑anpassningar och till och med GPU‑drivrutiner. Tillförlitlighet i skala är förmågan att hålla appen förutsägbar när ekosystemet inte är det.

På Android kan OEM‑skal påverka bakgrundsbegränsningar, notiser, filväljare och energihantering. Två enheter på samma Android‑version kan skilja sig eftersom leverantörer levererar olika systemkomponenter och patchar.

GPU:er lägger till en annan variabel. Vendor‑drivrutiner (Adreno, Mali, PowerVR) kan skilja sig i shaderprecision, texture‑format och hur aggressivt de optimerar. En rendering som ser bra ut på en GPU kan visa flimmer, bandning eller sällsynta krascher på en annan — särskilt kring video, kamera och custom grafik.

iOS är tajtare, men OS‑uppdateringar kan ändå ändra beteende: behörighetsflöden, tangentbords/autofyll‑quirks, audio session‑regler och bakgrundsuppgifts‑policyer kan förändras subtilt mellan mindre versioner.

Native‑plattformar exponerar de ”riktiga” API:erna först. När OS förändras speglar native SDK:er och dokumentation vanligtvis dessa förändringar omedelbart, och plattformsverktyg (Xcode/Android Studio, systemloggar, crash‑symboler) stämmer överens med vad som körs på enheterna.

Cross‑platform‑stackar lägger till ytterligare ett översättningslager: ramverket, dess runtime och plugins. När ett kantfall uppstår debuggar du både din app och bron.

Ramverksuppgraderingar kan introducera runtime‑ändringar (trådning, rendering, textinmatning, gesture‑hantering) som bara fallerar på vissa enheter. Plugins kan vara värre: vissa är tunna wrappers; andra bäddar in tung native‑kod med ojämn underhållning.

I skala handlar tillförlitlighet sällan om en bugg — det handlar om att minska antalet lager där överraskningar kan gömma sig.

Vissa arbetsbelastningar straffar även små mängder overhead. Om din app behöver uthålligt hög FPS, tung GPU‑jobbning eller tajt kontroll över avkodning och buffrar, vinner native ofta eftersom den kan driva plattformens snabbaste vägar direkt.

Native är ett klart val för 3D‑scener, AR‑upplevelser, high‑FPS‑spel, videoredigering och kamera‑först‑appar med realtidsfilter. Dessa use‑cases är inte bara “compute‑tunga” — de är pipeline‑tunga: du flyttar stora textures och ramar mellan CPU, GPU, kamera och encoders dussintals gånger per sekund.

Extra kopior, sena ramar eller mismatcher i synk visar sig omedelbart som tappade ramar, överhettning eller sladdriga kontroller.

På iOS kan native‑kod prata med Metal och systemets mediestack utan mellanlager. På Android kan den nå Vulkan/OpenGL plus plattforms‑codecs och hårdvaruacceleration via NDK och media‑API:er.

Det spelar roll eftersom GPU‑kommando‑submission, shaderkompilering och texture‑hantering är känsliga för hur appen schemalägger arbete.

En typisk realtids‑pipeline är: fånga eller ladda frames → konvertera format → ladda upp textures → köra GPU‑shaders → composita UI → presentera.

Native‑kod kan minska overhead genom att behålla data i GPU‑vänliga format längre, batcha draw‑calls och undvika upprepade texture‑uploads. Även en onödig konvertering (t.ex. RGBA ↔ YUV) per bildruta kan lägga på nog kostnad för att bryta jämn uppspelning.

On‑device ML beror ofta på delegates/backends (Neural Engine, GPU, DSP/NPU). Native‑integration tenderar att exponera dessa snabbare och med fler tuning‑möjligheter — viktigt när du bryr dig om inference‑latens och batteri.

Du behöver inte alltid en helt native‑app. Många team behåller en cross‑platform‑UI för de flesta skärmar och lägger in native‑moduler för hotspots: kamerapipelines, custom renderers, audio‑engines eller ML‑inference.

Detta kan leverera nästan‑native‑prestanda där det räknas, utan att skriva om allt annat.

Att välja ramverk handlar mindre om ideologi och mer om att matcha användarförväntningar med vad enheten måste göra. Om din app känns omedelbar, håller sig sval och förblir mjuk under stress, frågar användare sällan vad den är byggd med.

Använd dessa frågor för att snabba upp valet:

Om du prototypar flera riktningar kan det vara hjälpsamt att validera produktflöden snabbt innan du investerar i djup native‑optimering. Exempelvis använder team ibland Koder.ai för att snabbt snurra upp en fungerande webbapp (React + Go + PostgreSQL) via chat, press‑testa UX och datamodell, och sedan satsa på en native eller hybrid mobilbyggnad när de prestandakritiska skärmarna är definierade.

Hybrid behöver inte betyda “webb inuti en app”. För prestandakritiska produkter innebär hybrid oftast:

Denna strategi begränsar risken: du kan optimera de hetaste stigar utan att skriva om allt.

Innan du binder dig, bygg en liten prototyp av den svåraste skärmen (t.ex. live‑feed, redigerings‑timeline, karta + overlays). Benchmarka bildstabilitet, input‑latens, minne och batteri över en 10–15 minuters session. Använd dessa data — inte gissningar — för att välja.

Om du använder ett AI‑assisterat byggverktyg som Koder.ai för tidiga iterationer, behandla det som en hastighetsmultiplikator för att utforska arkitektur och UX — inte som en ersättning för device‑nivå profilering. När du siktar på en prestandakritisk upplevelse gäller samma regel: mät på riktiga enheter, sätt prestandabudgetar och håll kritiska vägar (rendering, input, media) så nära native som dina krav kräver.

Börja med att göra appen korrekt och observerbar (grundläggande profilering, loggning och prestandabudgetar). Optimera endast när du kan peka på en flaskhals som användare faktiskt kommer känna. Det hindrar team från att spendera veckor på att fila bort millisekunder i kod som inte ligger på den kritiska vägen.

Det betyder att användarupplevelsen går sönder när appen är ens lite långsam eller inkonsekvent. Små förseningar kan göra att du missar ett ögonblick (kamera), fattar fel beslut (trading) eller tappar förtroende (navigation), eftersom prestanda är direkt synligt i kärninteraktionen.

För att de pratar direkt med plattformens API:er och renderings‑pipeline, utan extra översättningslager. Det innebär vanligtvis:

Vanliga källor inkluderar:

Var för sig små kostnader kan adderas när de inträffar varje bildruta eller gest.

Smidighet handlar om att konsekvent träffa bildrute‑deadlinen. Vid 60 Hz har du ~16,7 ms per bildruta; vid 120 Hz ~8,3 ms. Missar du det, ser användaren stutter under scroll, animationer eller gester—ofta mer märkbar än en något längre laddtid.

UI/main‑tråden koordinerar ofta input, layout och rendering. Jank uppstår när du gör för mycket där, till exempel:

Att hålla main‑tråden förutsägbar är ofta den största vinsten för smidighet.

Latens är det upplevda gapet mellan handling och respons. Användbara tumregler:

Prestandakritiska appar optimerar hela vägen från input → logik → render för att hålla svaren snabba och med låg jitter.

Många hårdvarufunktioner är native‑first och utvecklas snabbt: avancerad kamerakontroll, AR, BLE‑bakgrundsbeteende, NFC, hälso‑API:er och bakgrundsexekvering. Cross‑platform‑wrapperar kan täcka grundfallen, men avancerade eller kantfall kräver ofta direkta native‑API:er för att vara tillförlitliga och uppdaterade.

När OS släpper nya API:er finns de omedelbart i native SDK:er, medan cross‑platform‑bindingar/pluggar kan dröja. Den skillnaden kan leda till:

Native minskar risken att “vänta på wrappern” för kritiska funktioner.

Uthållig prestanda handlar om effektivitet över tid:

Native API:er låter dig schemalägga arbete på ett mer förutsägbart sätt och använda OS‑acceleration som slösar mindre energi.

Ja. Många team använder en hybrid strategi:

Det riktar native‑insatsen dit den gör mest nytta utan att skriva om allt.