Vad JavaScript-runtimes är och varför de spelar roll

JavaScript är språket. En JavaScript-runtime är miljön som gör språket användbart utanför en webbläsare: den bäddar in en JavaScript-motor (som V8) och omger den med de systemfunktioner riktiga appar behöver—filåtkomst, nätverk, timers, processhantering och API:er för kryptografi, streams och mer.

Om motorn är “hjärnan” som förstår JavaScript, är runtimen hela “kroppen” som kan prata med operativsystemet och internet.

Var runtimes dyker upp

Moderna runtimes är inte bara för webbservrar. De driver:

- Servrar och API:er (traditionella backend-appar)

- CLI-verktyg (formatterare, byggverktyg, automationsskript)

- Edge-funktioner (kod som körs nära användarna, ofta med hårdare begränsningar)

- Skrivbordsappar (ofta via ramverk som paketerar en runtime)

Samma språk kan köras på alla dessa platser, men varje miljö har olika begränsningar—uppstartstid, minnesgränser, säkerhetsgränser och tillgängliga API:er.

Varför flera runtimes finns (och fortsätter förändras)

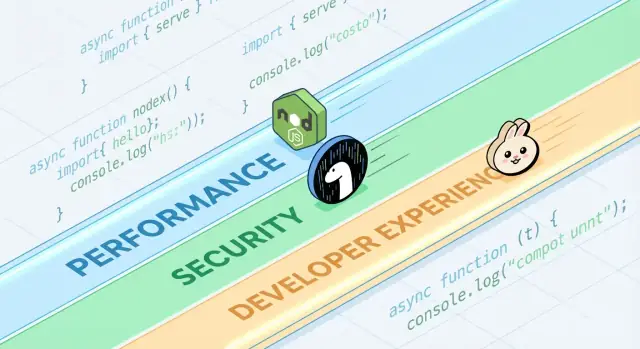

Runtimes utvecklas eftersom utvecklare vill ha olika avvägningar. Vissa prioriterar maximal kompatibilitet med det befintliga Node.js-ekosystemet. Andra siktar på striktare säkerhetsstandarder, bättre TypeScript-ergonomi eller snabbare cold starts för verktyg.

Även när två runtimes delar samma motor kan de skilja sig dramatiskt i:

- Inbyggda API:er och stöd för standarder

- Tillvägagångssätt för paket-hantering

- Behörighets- och sandbox-modell

- Verktygsupplevelse (testning, formatering, bundling)

Vad “konkurrerar” egentligen betyder

Konkurrens handlar inte bara om hastighet. Runtimes tävlar om adoption (community och uppmärksamhet), kompatibilitet (hur mycket befintlig kod “bara fungerar”) och förtroende (säkerhetsställning, stabilitet, långsiktigt underhåll). Dessa faktorer avgör om en runtime blir ett standardval eller ett nischverktyg du bara använder i specifika projekt.

En snabb tur bland populära runtimes

När folk säger “JavaScript-runtime” menar de oftast “miljön som kör JS utanför (eller inuti) en webbläsare, plus de API:er du använder för att faktiskt bygga saker.” Runtimen du väljer formar hur du läser filer, startar servrar, installerar paket, hanterar behörigheter och felsöker i produktion.

Vanliga exempel du hör om

Node.js är den länge etablerade standarden för server-side JavaScript. Det har det bredaste ekosystemet, mogna verktyg och stor community-dragkraft.

Deno designades med moderna standarder: förstklassigt TypeScript-stöd, starkare säkerhetsinställningar som standard och en mer “batterier inkluderade”-standardbibliotekstankegång.

Bun fokuserar mycket på hastighet och utvecklarkomfort, och paketerar en snabb runtime med ett integrerat verktygskedja (som paketinstallation och testning) för att minska setup-arbetet.

Webbläsarruntimes (Chrome, Firefox, Safari) är fortfarande de vanligaste JS-runtimes totalt sett. De är optimerade för UI-arbete och levererar Web API:er som DOM, fetch och storage—men de ger inte direkt filsystemåtkomst på samma sätt som server-runtimes.

Vad som delas mellan runtimes

De flesta runtimes parar ihop en JavaScript-motor (ofta V8) med en event-loop och en uppsättning API:er för nätverk, timers, streams och mer. Motorn exekverar koden; event-loopen koordinerar asynkront arbete; API:erna är det du faktiskt anropar i vardagen.

Vad som skiljer (och varför det betyder något i praktiken)

Skillnader syns i inbyggna funktioner (som inbyggd TypeScript-hantering), standardverktyg (formatterare, linter, testrunner), kompatibilitet med Nodes API:er och säkerhetsmodeller (t.ex. om fil-/nätverksåtkomst är obehindrad eller behörighetsstyrd). Därför är “runtime-val” inte abstrakt—det påverkar hur snabbt du kan starta ett projekt, hur säkert du kan köra skript och hur smärtfri distribution och felsökning blir.

Prestanda: de mätvärden runtimes tävlar om

“Snabb” är inte ett enda tal. JavaScript-runtimes kan se fantastiska ut i ett diagram och ordinära i ett annat, eftersom de optimerar för olika definitioner av hastighet.

Latens vs genomströmning

Latens är hur snabbt en enskild förfrågan blir klar; genomströmning är hur många förfrågningar du kan klara per sekund. En runtime tuned för låg uppstartstid och snabba svar kan offra maximal genomströmning vid hög samtidighet, och vice versa.

Till exempel bryr sig ett API som levererar användarprofiluppslagningar om tail-latens (p95/p99). Ett batchjobb som bearbetar tusentals events per sekund bryr sig mer om genomströmning och jämn effektivitet i steady-state.

Cold start-tid (serverless och CLI)

Cold start är tiden från “inget körs” till “redo att göra arbete”. Det spelar stor roll för serverless-funktioner som skalar till noll och för CLI-verktyg användare kör ofta.

Cold starts påverkas av modul-inläsning, eventuell TypeScript-transpilering, initiering av inbyggda API:er och hur mycket arbete runtimen gör innan din kod exekveras. En runtime kan vara mycket snabb när den väl är varm, men kännas seg om den tar extra tid att starta.

I/O-prestanda: nätverk, filsystem, streams

Det mesta av server-side JavaScript är I/O-bundet: HTTP-förfrågningar, databas-anrop, läsning av filer, streaming av data. Här handlar prestanda ofta om effektiviteten i event-loopen, kvaliteten på asynkrona I/O-bindningar, stream-implementationer och hur väl backpressure hanteras.

Små skillnader—som hur snabbt runtimen parser headers, schemalägger timers eller skriver ut buffrar—kan ge konkreta vinster i webbservrar och proxyer.

CPU-bundet arbete: motorstyrkor och begränsningar

CPU-tunga uppgifter (parsing, kompression, bildbehandling, crypto, analytics) belastar JavaScript-motorn och JIT-kompilatorn. Motorer kan optimera varma kodvägar, men JavaScript har fortfarande begränsningar för utdragna numeriska arbetsbelastningar.

Om CPU-bundet arbete dominerar kan den “snabbaste runtimen” vara den som gör det enklast att flytta heta slingor till native-kod eller använda worker-threads utan komplexitet.

Benchmarking: verklighet och vanliga fällor

Benchmarking kan vara användbart, men är lätt att missförstå—särskilt när det behandlas som en universell resultattavla. En runtime som “vinner” ett diagram kan ändå vara långsammare för ditt API, din byggpipelin eller ditt datapipelines-jobb.

Mikrobenchmarks vs riktiga applikationer

Mikrobenchmarks testar ofta en liten operation (som JSON-parsning, regex eller hashing) i en tight loop. Det är bra för att mäta en ingrediens, inte hela måltiden.

Riktiga appar spenderar tid på saker mikrobenchmarks ignorerar: nätverksväntan, databas-anrop, fil-I/O, ramverks-överhead, loggning och minnespress. Om din arbetsbelastning mestadels är I/O-bunden kommer en 20% snabbare CPU-loop kanske inte påverka din end-to-end-latens alls.

Resultat ändras med arbetsbelastning, OS och versioner

Små miljöskillnader kan vända resultat:

- Arbetsbelastningens form: många små förfrågningar vs färre stora; streaming vs buffring.

- OS och hårdvara: Linux vs macOS; olika CPU:er; container-begränsningar.

- Runtime- och beroendeversioner: motoruppdateringar, libc-differenser och bibliotekskartor kan dominera.

När du ser en benchmark-bild, fråga vilka versioner och flaggor som användes—och om de matchar din produktionsmiljö.

Warm-up (JIT) och caching-effekter

JavaScript-motorer använder JIT-kompilering: kod kan köra långsammare i början och sedan snabba upp när motorn “lär sig” varma vägar. Om en benchmark bara mäter de första sekunderna kan den belöna fel saker.

Caching spelar också roll: diskcache, DNS-cache, HTTP keep-alive och applikationscache kan göra senare körningar mycket bättre. Det kan vara verkligt, men måste kontrolleras.

Designa rättvisa, reproducerbara tester

Sikta på benchmarkar som svarar på din fråga, inte någon annans:

- Mät end-to-end: inkludera ramverk + typisk middleware + verkliga payload-storlekar.

- Separera cold vs warm: spela in uppstart, första förfrågan och steady-state.

- Kör flera försök: rapportera median och variation, inte bara bästa körning.

- Lås miljön: peka versioner, isolera CPU och dokumentera kommandon.

Om du behöver en praktisk mall, fånga din test-harness i ett repo och hänvisa till det från interna dokument (eller texten /blog/runtime-benchmarking-notes) så att resultat kan reproduceras senare.

Under huven: motorer, API:er och exekveringsmodeller

Gör checklistan handlingsbar

Gör din runtime-beslutschecklista konkret som ett pilotprojekt du kan köra.

När folk jämför Node.js, Deno och Bun pratar de ofta om funktioner och benchmarkar. Under ytan formas “känslan” av en runtime av fyra stora delar: JavaScript-motorn, inbyggda API:er, exekveringsmodellen (event-loop + schemaläggare) och hur native-kod kopplas in.

Motorer: V8, JavaScriptCore och varför de spelar roll

Motorn är den del som parser och kör JavaScript. V8 (används av Node.js och Deno) och JavaScriptCore (används av Bun) gör avancerade optimeringar som JIT-kompilering och garbage collection.

I praktiken kan motorval påverka:

- Uppstartstid och minnesbeteende (hur snabbt en process blir användbar)

- Prestanda för “varm” kod efter optimering

- Vilka lågnivåfunktioner som kommer först (vissa motorer levererar nya JS-funktioner tidigare än andra)

Inbyggda API:er: mer än “kan jag fetch:a?”

Moderna runtimes tävlar på hur komplett deras standardbibliotek känns. Att ha inbyggt stöd för fetch, Web Streams, URL-verktyg, fil-API:er och crypto kan minska beroende-spridning och göra kod mer portabel mellan server och webbläsare.

Problemet: samma API-namn innebär inte alltid identiskt beteende. Skillnader i streaming, timeouts eller filövervakning kan påverka riktiga appar mer än rå prestanda.

Exekveringsmodeller: event-loop, schemaläggare och native-bindningar

JavaScript är enkeltrådat på hög nivå, men runtimes koordinerar bakgrundsarbete (nätverk, fil-I/O, timers) via en event-loop och interna schemaläggare. Vissa runtimes lutar tungt mot native-bindningar (kompilerad kod) för I/O och prestandakritiska uppgifter, medan andra betonar web-standard-gränssnitt.

WebAssembly: när det hjälper

WebAssembly (Wasm) är användbart när du behöver snabb, förutsägbar beräkning (parsing, bildbehandling, kompression) eller vill återanvända kod från Rust/C/C++. Det kommer inte magiskt göra I/O-tunga webbservrar snabbare, men kan vara ett starkt verktyg för CPU-bundna moduler.

Säkerhet: standarder, behörigheter och supply-chain-verklighet

"Säkert som standard" i en JavaScript-runtime betyder oftast att runtimen antar att kod är otrustad tills du uttryckligen ger åtkomst. Det vänder den traditionella server-side-modellen (där skript ofta kan läsa filer, anropa nätverket och inspektera miljövariabler som standard) till en mer försiktig inställning.

Samtidigt startar många verkliga incidenter innan din kod ens körs—inne i dina beroenden och installationsprocessen—så runtime-säkerhet bör ses som ett lager, inte hela strategin.

Behörighetsuppmaningar och allowlists

Vissa runtimes kan styra känsliga kapabiliteter bakom behörigheter. Den praktiska formen av detta är en allowlist:

- Filsystem: tillåt läs/skriv endast till specifika sökvägar (t.ex. en konfigkatalog)

- Nätverk: tillåt utgående förfrågningar endast till godkända hosts/portar

- Miljövariabler: exponera endast specifika nycklar istället för hela processenv

Detta kan minska oavsiktliga dataläckor (som att skicka hemligheter till en oväntad endpoint) och begränsa skadeomfånget när du kör tredjepartsskript—särskilt i CLI:er, byggverktyg och automation.

Sandboxing har begränsningar

Behörigheter är ingen magisk sköld. Om du ger nätverksåtkomst till “api.mycompany.com” kan en komprometterad beroende fortfarande exfiltrera data till den hosten. Och om du tillåter läsning av en katalog litar du på allt i den katalogen. Modellen hjälper dig uttrycka avsikt, men du behöver fortfarande granskning av beroenden, lockfiles och noggrann genomgång av vad du tillåter.

Säkra standarder i vanliga API:er

Säkerhet finns också i små standarder:

- TLS/HTTPS: förnuftig certifikatvalidering och moderna protokollsinställningar som standard

- HTTP: säkert redirect-beteende och tydlig kontroll över headers/cookies

- Crypto-API:er: moderna primitiva med svåranvända gränssnitt

Avvägningen är friktion: striktare standarder kan bryta legacy-skript eller lägga till flaggor du måste underhålla. Bästa valet beror på om du värdesätter bekvämlighet för betrodda system eller skyddsräcken för blandade förtroenden.

Supply-chain-risker du inte kan ignorera

Supply-chain-attacker utnyttjar ofta hur paket upptäcks och installeras:

- Typosquatting: ett skadligt paket med ett namn som skiljer sig med en tecken från ett populärt paket (t.ex.

expresss).

- Dependency confusion: ett publikt paket publiceras med samma namn som ett internt, och installeraren drar in det publika.

- Komprometterade underhållare: en kapad account levererar en “legitim” uppdatering med injicerad kod.

Dessa risker påverkar alla runtimes som hämtar från ett publikt register—så hygien är lika viktig som runtime-funktioner.

Lockfiles, integritetskontroller och proveniens

Lockfiles fixerar exakta versioner (inklusive transitiva beroenden), vilket gör installationer reproducerbara och minskar överraskande uppdateringar. Integritetskontroller (hashar som sparas i lockfilen eller metadata) hjälper till att upptäcka manipulation vid nedladdning.

Proveniens är nästa steg: att kunna svara på “vem byggde detta artefakt, från vilken källa, och med vilken workflow?” Även om du inte antar fullständig proveniens-verktyg ännu kan du approximera genom att:

- föredra väl underhållna paket med transparenta release-praktiker,

- undvika opinnade Git-beroenden för produktionsbyggen,

- kräva tags/releaser snarare än att installera från slumpmässiga commits.

Audit- och uppdateringsflöden som fungerar

Behandla beroendearbete som rutinunderhåll:

- kör automatiska revisioner i CI på varje pull request,

- schemalägg regelbundna uppdateringsfönster (veckovis/varannan vecka) för att undvika stora uppgraderingar,

- granska changelogs för större hopp och säkerhetsreleaser.

Teamregler som inte bromsar leverans

Lättviktiga regler räcker långt:

- blockera nya beroenden om det inte finns ett tydligt behov och ansvarig,

- begränsa install-skript där det är möjligt (de är en vanlig exekveringsväg),

- använd ett privat registry eller scope:ade paket för interna namn för att minska förvirring.

God hygien handlar mindre om perfektion och mer om konsekventa, tråkiga vanor.

Kompatibilitet och ekosystem som konkurrensfördelar

Prestanda och säkerhet får rubriker, men kompatibilitet och ekosystem avgör ofta vad som faktiskt levereras. En runtime som kör din befintliga kod, stödjer dina beroenden och beter sig lika över miljöer minskar risk mer än någon enskild funktion.

Kompatibilitet påverkar säkerhet och underhåll

Kompatibilitet är inte bara bekvämlighet. Färre omskrivningar betyder färre chanser att introducera subtila buggar och färre särlösningar du glömmer uppdatera. Mogna ekosystem har ofta bättre kända felmönster: vanliga bibliotek har granskats mer, problem är dokumenterade och mitigeringar är lättare att hitta.

Å andra sidan kan “kompatibilitet till varje pris” hålla legacy-mönster vid liv (som alltför bred fil-/nätverksåtkomst), så team behöver fortfarande tydliga gränser och god beroendehygien.

Node-kompatibilitetslager vs web-standard API:er

Runtimes som strävar efter drop-in-kompatibilitet med Node.js kan köra mest server-side JavaScript omedelbart—det är en stor praktisk fördel. Kompatibilitetslager kan jämna ut skillnader, men de kan också dölja runtime-specifikt beteende—särskilt kring filsystem, nätverk och modulupplösning—vilket gör felsökning svårare när något beter sig annorlunda i produktion.

Web-standard API:er (som fetch, URL och Web Streams) driver kod mot portabilitet mellan runtimes och till och med edge-miljöer. Avvägningen: vissa Node-specifika paket antar Node-internals och fungerar inte utan shims.

NPM-ekosystemet: styrkor och avvägningar

NPM:s största styrka är enkel: det har nästan allt. Denna bredd snabbar upp leverans, men ökar också exponeringen för supply-chain-risk och beroendebloat. Även ett “populärt” paket kan ha transitiva beroenden som förvånar dig.

När “fungerar överallt” slår nya funktioner

Om din prioritet är förutsägbara deployment, enklare rekrytering och färre integrationsöverraskningar, vinner ofta “fungerar överallt”. Nya runtime-funktioner är spännande—men portabilitet och ett beprövat ekosystem kan spara veckor över ett projekts livstid.

Utvecklarupplevelse: verktyg, typer och felsökning

Dela en live runtime-pilot

Publicera din prototyp online med hosting och egna domäner för snabb feedback från intressenter.

Utvecklarupplevelse är där runtimes tyst vinner eller förlorar. Två runtimes kan köra samma kod men kännas helt olika när du sätter upp ett projekt, jagar en bugg eller försöker leverera en liten tjänst snabbt.

TypeScript-stöd: inbyggt vs “ta med eget”

TypeScript är ett bra DX-lakmustecken. Vissa runtimes behandlar det som en förstaklassig input (du kan köra .ts-filer med minimal ceremoni), medan andra förväntar sig ett traditionellt verktygskedja (tsc, en bundler eller en loader) som du konfigurerar själv.

Ingen lösning är universellt “bättre”:

- Inbyggt stöd minskar setup och kan standardisera default-inställningar i ett team.

- Konfigurerat verktyg ger finare kontroll över tsconfig, emit-targets och byggutdata—nyttigt för bibliotek och stora monorepon.

Nyckelfrågan är om din runtimes TypeScript-berättelse matchar hur teamet faktiskt levererar kod: direkt exekvering i dev, kompilerade byggen i CI, eller båda.

Bundling, transpiling och teststandarder

Moderna runtimes levererar allt oftare opinionerade verktyg: bundlers, transpilers, linters och testrunners som fungerar direkt. Det kan eliminera “välj din egen stack”-skatten för mindre projekt.

Men defaults är bara DX-positiva när de är förutsägbara:

- Kan du enkelt ändra output-format (ESM/CJS), targets och externa beroenden?

- Integrerar testrunnern bra med coverage och CI?

- Är konfigurationen minimal och stabil över versioner?

Om du ofta startar nya tjänster kan en runtime med solida inbyggda verktyg + bra docs spara timmar per projekt.

Felsökning: stacktraces, sourcemaps och inspektorer

Felsökning är där runtime-polering blir uppenbar. Högkvalitativa stacktraces, korrekt sourcemap-hantering och en inspektor som “bara fungerar” bestämmer hur snabbt du förstår fel.

Sök efter:

- Tydliga fel som pekar på din källa (inte genererad kod)

- Pålitliga asynkrona stacktraces

- Bra integration med editors och Chrome DevTools-liknande inspektorer

Mallar och scaffolding som tar bort friktion

Projektgeneratorer kan vara underskattade: en ren mall för ett API, CLI eller worker sätter ofta tonen för en kodbas. Föredra scaffolds som skapar en minimal, produktionsformad struktur (loggning, env-hantering, tester) utan att låsa dig i ett tungt ramverk.

Om du behöver inspiration, se relaterade guider i /blog.

Som en praktisk arbetsflöde använder team ibland Koder.ai för att prototypa en liten tjänst eller CLI i olika “runtime-stilar” (Node-first vs web-standard API:er), och exporterar sedan den genererade källkoden för en riktig benchmarkpass. Det ersätter inte produktionstestning, men kan korta tiden från idé → körbar jämförelse när ni utvärderar avvägningar.

Paket-hantering är där “utvecklarupplevelse” blir konkret: installhastighet, lockfile-beteende, workspace-stöd och hur pålitligt CI reproducerar ett bygge. Runtimes tar allt oftare detta som en förstaklassig funktion, inte en eftertanke.

Runtime-native paket-managers och prestandamål

Node.js förlitade sig historiskt på externa verktyg (npm, Yarn, pnpm), vilket är både en styrka (valfrihet) och en källa till inkonsekvens. Nyare runtimes levererar opinioner: Deno integrerar beroendehantering via deno.json (och stöder npm-paket), medan Bun paketerar en snabb installerare och lockfile.

Dessa runtime-native verktyg optimerar ofta för färre nätverksrundor, aggressiv caching och tätare integration med runtimens modul-laddare—bra för cold starts i CI och för att onboarda nya kollegor.

Monorepon, workspaces och caching-grunder

De flesta team behöver så småningom workspaces: delade interna paket, konsekventa beroende-versioner och förutsägbara hoisting-regler. npm, Yarn och pnpm stödjer workspaces, men beter sig olika när det gäller diskbruk, node_modules-layout och deduplicering. Det påverkar installtid, editor-upplösning och “fungerar på min maskin”-buggar.

Caching är lika viktigt. En bra baseline är att cache:a paketmanagerns store (eller nedladdningscache) plus lockfile-baserade installsteg, och hålla scripts deterministiska. Dokumentera en enkel startpunkt i /docs.

Publicering och konsumtion: vad team behöver veta

Intern pakethantering (eller konsumtion av privata registries) tvingar dig att standardisera auth, registry-URL:er och versionsregler. Säkerställ att din runtime/verktyg stödjer samma .npmrc-konventioner, integritetskontroller och proveniensförväntningar.

Migreringsbekymmer: lockfile-ändringar och CI-justeringar

Att byta paketmanager eller anta en runtime-bundlad installerare ändrar ofta lockfiles och install-kommandon. Planera för PR-churn, uppdatera CI-images och enas om en “single source of truth” lockfile—annars felsöker du beroende-drift istället för att leverera funktioner.

Välja runtime efter användningsfall (inte efter hype)

Testa ett CLI cold start

Skissa snabbt ett CLI-verktyg och jämför cold start och paketeringsavvägningar.

Att välja en JavaScript-runtime handlar mindre om “vem vinner på ett diagram” och mer om formen på ditt arbete: hur ni deployar, vad som måste integreras och hur mycket risk teamet kan ta. Ett bra val är det som minskar friktionen för era specifika begränsningar.

Serverless och edge-arbetsbelastningar

Här spelar cold-start och samtidighetsbeteende lika stor roll som rå genomströmning. Titta efter:

- Uppstartstid (hur snabbt en funktion börjar hantera förfrågningar)

- Isoleringsmodell (processer vs isolates/worker-stil exekvering)

- API-tillgänglighet (Web API:er, fetch, streams, crypto) i målplattformen

Node.js stöds brett hos leverantörer; Denos web-standard API:er och behörighetsmodell kan vara lockande när de finns; Buns snabbhet kan hjälpa, men kontrollera plattformsstöd och edge-kompatibilitet innan du bindar dig.

CLI-verktyg och automation

För kommandoradsverktyg kan distribution dominera beslutet. Prioritera:

- Enkeldistribuerade binärer och förutsägbara installationer

- Tvärplattformbeteende (macOS, Windows, Linux)

- Snabb uppstart och bra utvecklarergonomi

Denos inbyggda verktyg och enkla distribution är starka för CLI:er. Node.js är stabilt när du behöver npm:s bredd. Bun kan vara bra för snabba skript, men validera paketering och Windows-stöd för din målgrupp.

Containers och långkörande tjänster

I containers väger stabilitet, minnesbeteende och observability ofta tyngre än rubrikbenchmarks. Utvärdera steady-state minnesanvändning, GC-beteende under belastning och mognad i felsöknings-/profilverktyg. Node.js tenderar att vara det “säkra standardvalet” för långlivade produktionsservrar tack vare ekosystemmognad och operativ vanhet.

Teambegränsningar slår nyhet

Välj runtimen som matchar teamets befintliga kompetenser, bibliotek och drift (CI, övervakning, incidenthantering). Om en runtime tvingar omskrivningar, nya felsökningsflöden eller oklara beroendepraxis kan varje prestandavinst äventyras av leveransrisk.

Om målet är att leverera produktfunktioner snabbare (inte bara diskutera runtimes), fundera på var JavaScript faktiskt sitter i er stack. Till exempel fokuserar Koder.ai på att bygga fulla applikationer via chat—webb-frontends i React, backends i Go med PostgreSQL och mobilappar i Flutter—så team ofta reserverar “runtime-beslut” för de platser där Node/Deno/Bun verkligen spelar roll (verktyg, edge-skript eller befintliga JS-tjänster), samtidigt som de rör sig snabbt med en produktionsnära baseline.

Besluts-checklista och nästa steg

Att välja en runtime handlar mindre om att välja en “vinnare” och mer om att minska risk samtidigt som ni förbättrar teamets och produktens resultat.

En kort checklista

- Prestandatester: Vet ni era topp 3 flaskhalsar (uppstartstid, request-genomströmning, CPU-tungt arbete, I/O-latens)? Kan ni reproducera dem lokalt och i CI?

- Säkerhetsbehov: Behöver ni en behörighetsmodell (fil/nätverk/env-åtkomst), tätare sandboxing eller compliance-kontroller?

- DX-prioriteringar: Vilken friktion kostar er mest idag—TypeScript-setup, felsökning, hot reload, testverktyg eller paketering för distribution?

Frågor att ställa innan ni byter runtime

- Vilket problem löser vi: kostnad, latens, utvecklarhastighet eller säkerhet?

- Vilka delar av vårt system är runtime-känsliga (edge-funktioner, CLI:er, API:er, bakgrundsjobb)?

- Är vi bundna till ett specifikt paket-ekosystembeteende (native addons, postinstall-skript, CommonJS/ESM-förväntningar)?

- Vad är vår rollback-plan om ett beroende eller plattformsintegration beter sig annorlunda?

- Vem äger runtime-uppgraderingar och att följa breaking changes?

En praktisk pilotplan

Börja litet och mätbart:

- Välj en enkel tjänst eller internt verktyg med tydliga input/output (t.ex. en webhook-handler, ett CLI eller en liten worker).

- Definiera framgångsmått: p95-latens, minne, CPU, byggtid, cold start och utvecklarnas tid till fix.

- Kör pilot i två miljöer: staging och en produktions-canary (om möjligt).

- Jämför resultat, dokumentera överraskningar, och iterera (tunera konfigurationer, beroendeval) innan ni överväger bredare migration.

Om ni vill snabba på feedback-loopen kan ni utforma pilot-tjänsten och benchmark-harnessen snabbt i Koder.ai, använda Planning Mode för att skissa experimentet (mätvärden, endpoints, payloads), och sedan exportera källkoden så de slutliga mätningarna körs i exakt den miljö ni kontrollerar.

Var du kan lära dig mer

Använd primärkällor och följande signaler:

- Officiell dokumentation och kompatibilitetsnotiser för Node.js, Deno och Bun

- Release notes och changelogs (håll utkik efter säkerhetsfixar och breaking changes)

- Säkerhetsråd och CVE-flöden relevanta för era beroenden

- Community-issue trackers för att upptäcka verkliga edge-fall

Om du vill ha en djupare guide om hur man mäter runtimes rätt, se /blog/benchmarking-javascript-runtimes.