Vad “prompting” betyder i verkligt ingenjörsarbete

Prompting i ingenjörsarbete är inte “att chatta med en AI.” Det är handlingen att ge granskningsbara indata som styr en assistent mot ett specifikt, kontrollerbart resultat—likt när du skriver en ticket, ett spec eller en testplan.

En bra prompt är ofta ett litet paket som innehåller:

- Mål: vad som ska byggas eller beslutas

- Begränsningar: språk, ramverk, prestandabudgetar, tillgänglighetsregler, API‑kontrakt, plattformsbegränsningar

- Kontext: befintliga kodmönster, namngivningskonventioner, arkitekturgränser

- Exempel: exempel på indata/utdata, kantfall, UI‑skärmdumpar beskrivna i text, befintliga endpoints

- Acceptanskriterier: hur du verifierar att det fungerade (tester, lintregler, förväntat beteende)

Prompting är “spec‑skrivande”, bara tajtare

I verkliga projekt ber du inte om “en inloggningssida.” Du specificerar “ett inloggningsformulär som matchar våra design‑tokens, validerar e‑postformat, visar fel inline och har enhetstester för validering och submit‑tillstånd.” Prompten blir ett konkret artefakt som någon annan kan granska, redigera och återanvända—ofta checkat in i repot tillsammans med koden.

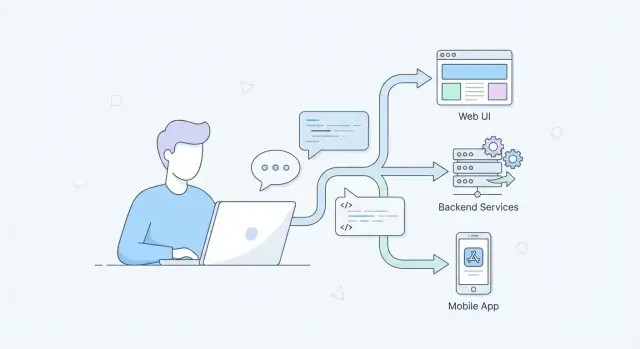

Varför det spelar roll över hela stacken

- UI / UX / frontend: prompts kan koda in tillgänglighetskrav, responsivt beteende, mikrocopy och komponent‑API‑regler så att output inte glider från designsystemet.

- APIs / backend: prompts kan låsa request/response‑former, felsemantik, idempotens, paginering och databasbegränsningar—vilket minskar “ser rätt ut”‑kod som går sönder under belastning.

- Mobil: prompts kan ta hänsyn till offline‑läge, batteri, nätverksvariation, behörighetsflöden, enhetsspecifika UI‑begränsningar och app‑store‑regler.

Vad detta inlägg täcker (och undviker)

Detta inlägg fokuserar på upprepbara metoder: promptmönster, arbetsflöden, testning av prompts och teamets granskningsvanor.

Det undviker hype och “magiska resultat.” AI‑assistans är användbart, men bara när prompten gör förväntningarna explicita—och när ingenjörer verifierar output på samma sätt som de verifierar människoskriven kod.

Varför prompting blir en kärnkompetens nu

Prompting går från att vara “trevligt att ha” till en daglig ingenjörskompetens eftersom det ändrar hur snabbt team kan gå från idé till något granskningsbart.

Snabbare iteration utan att slarva

AI‑assisterade verktyg kan skissa UI‑varianter, föreslå API‑former, generera testfall eller sammanfatta loggar på sekunder. Hastigheten är verklig—men bara om dina prompts är tillräckligt specifika för att ge utdata du faktiskt kan utvärdera. Ingenjörer som kan omvandla diffus avsikt till klara instruktioner får fler användbara iterationer per timme, och det räknas upp över sprintar.

Naturligt språk ersätter vissa tickets—men kräver fortfarande precision

Mer arbete flyttas in i naturligt språk: arkitekturnoteringar, acceptanskriterier, migreringsplaner, release‑checklistor och incidentrapporter. Dessa är fortfarande “specs”, även när de inte ser ut som traditionella specs. Prompting är konsten att skriva de specs så att de är entydiga och testbara: begränsningar, kantfall, framgångskriterier och explicita antaganden.

En bra prompt läser ofta som en mini‑designbrief:

- Vad du bygger och för vem

- Indata/utdata och begränsningar (prestanda, tillgänglighet, enhetsbegränsningar)

- Icke‑mål och avvägningar

- Exempel och motexempel

AI kommer in i IDE, CI och dokumentflödet

När AI‑funktioner integreras i IDE:er, pull‑requests, CI‑kontroller och dokumentationspipelines slutar prompting vara en tillfällig chatt och blir en del av vardagligt ingenjörsarbete. Du ber om kod, sedan tester, sedan en riskgranskning—varje steg gynnas av konsekvent, återanvändbar promptstruktur.

Tvärfunktionella team använder samma gränssnitt

Design, produkt, QA och engineering samarbetar i allt större utsträckning genom delade AI‑verktyg. En tydlig prompt blir ett boundary‑objekt: alla kan läsa den, kritisera den och enas om vad “klart” betyder. Denna delade tydlighet minskar omarbete och gör granskningar snabbare och lugnare.

Från vaga förfrågningar till klara, testbara prompts

En vag begäran som “bygg en inloggningssida” tvingar modellen att gissa vad du menar. En testbar prompt läser mer som en mini‑spec: den anger indata, förväntade utdata, kantfall och hur du vet att det är rätt.

Gör om förfrågningar till krav

Börja med att skriva vad systemet tar emot och vad det måste producera.

- Indata: användaråtgärder, API‑payloads, enhetsbegränsningar

- Utdata: UI‑tillstånd, svar, loggar/metrics

- Kantfall: ogiltiga data, timeouts, tomma tillstånd, partiella fel

Till exempel, byt ut “få formuläret att fungera” mot: “När e‑posten är ogiltig, visa ett inline‑felmeddelande och inaktivera submit; när API:n returnerar 409, visa ‘Account already exists’ och behåll ifyllda värden.”

Lägg till begränsningar som förhindrar “fint men fel”‑svar

Begränsningar håller output i linje med din verklighet.

Inkludera specifika uppgifter som:

- Teknikstack (t.ex. React + TypeScript, Node + Express)

- Prestandamål (t.ex. rendera under 100ms, undvik N+1‑frågor)

- Tillgänglighet (WCAG‑nivå, tangentbordsnavigering, ARIA‑förväntningar)

- Felhantering (retry‑policy, användarmeddelanden, loggning)

Be om avvägningar och resonemang

I stället för att bara begära kod, be modellen förklara beslut och alternativ. Det gör granskningar enklare och synliggör dolda antaganden.

Exempel: “Föreslå två angreppssätt, jämför för/‑nackdelar för underhållbarhet och prestanda, och implementera det rekommenderade alternativet.”

Använd exempel och icke‑exempel

Exempel minskar tvetydighet; icke‑exempel förhindrar feltolkning.

Svag prompt: “Skapa en endpoint för att uppdatera en användare.”

Starkare prompt: “Designa PATCH /users/{id}. Acceptera JSON { displayName?: string, phone?: string }. Avvisa okända fält (400). Om användaren inte finns (404). Validera telefonnummer enligt E.164. Returnera uppdaterad user JSON. Inkludera tester för ogiltigt telefonnummer, tom payload och obehörig åtkomst. Ändra inte e‑post.”

En användbar tumregel: om du inte kan skriva några testfall från prompten är den inte tillräckligt specifik.

Webbutveckling: Prompts för UI, UX och frontend‑kvalitet

Webbprompting fungerar bäst när du behandlar modellen som en junior kollega: den behöver kontext, begränsningar och en definition av “klart.” För UI‑arbete innebär det att specificera designregler, tillstånd, tillgänglighet och hur komponenten ska verifieras.

Komponentgenerering med verkliga designbegränsningar

I stället för “Bygg ett inloggningsformulär”, inkludera designsystemet och kantfallen:

- Layout: responsiva breakpoints, spacing‑skala, max‑bredder

- Tillstånd: default, loading, disabled, error, success

- A11y: labels, fokusordning, tangentbordsinteraktioner, ARIA

Exempelprompt: “Generera en React LoginForm med våra Button/Input‑komponenter. Inkludera loading‑tillstånd vid submit, inline‑validering och tillgängliga felmeddelanden. Ge Storybook‑stories för alla tillstånd.”

Refaktorera UI‑kod säkert

Refaktoreringar går smidigare när du sätter vaktposter:

“Refaktorera denna komponent för att extrahera UserCardHeader och UserCardActions. Behåll befintligt props‑API stabilt, bevara CSS‑klassnamn och ändra inte visuellt utseende. Om du måste döpa om, leverera en migrationsanvisning.”

Det minskar oavsiktliga brytningar och hjälper till att hålla namngivning och styling konsekvent.

Innehålls‑ och UI‑konsistens

Be uttryckligen om mikrocopy och tillståndstexter, inte bara markup:

“Föreslå mikrocopy för empty state, nätverksfel och permission denied. Håll tonen neutral och koncis. Returnera copy + var den visas i UI:t.”

Felsökning med reproduktionssteg och loggar

För frontend‑buggar bör prompts paketera bevis:

“Givet dessa reproduktionssteg, console‑loggar och stacktrace, föreslå troliga orsaker och rangordna fixes efter säkerhet. Inkludera hur man verifierar i webbläsaren och i ett enhetstest.”

När prompts innehåller begränsningar och verifiering får du UI‑output som är mer konsekvent, tillgänglig och granskningsbar.

Backendutveckling: Prompts för API:er, data och tillförlitlighet

Backend‑arbete är fullt av kantfall: partiella fel, tvetydiga data, retries och prestandaöverraskningar. Bra prompts hjälper dig spika beslut som är enkla att vifta bort i en chatt men smärtsamma att fixa i produktion.

API‑designprompts (vägar, scheman, statuskoder)

I stället för att be “bygga en API”, pressa modellen att producera ett kontrakt du kan granska.

Be om:

- Vägar och HTTP‑verb, med tydlig resursnamngivning

- Request/response‑schema (inklusive required vs optional fält)

- Statuskoder för framgång och fel

- Paginering (cursor vs offset) och sortering

- Idempotensregler för skrivningar (speciellt POST)

Exempelprompt:

Design a REST API for managing subscriptions.

Return:

1) Endpoints with method + path

2) JSON schemas for request/response

3) Status codes per endpoint (include 400/401/403/404/409/422/429)

4) Pagination and filtering rules

5) Idempotency approach for create/cancel

Assume multi-tenant, and include tenant scoping in every query.

(Obs: kodblocket ovan lämnas oförändrat.)

Datavalidering och felhantering

Prompt för konsekvent validering och ett stabilt “fel‑format” så klienter kan hantera problem förutsägbart.

Goda begränsningar:

- Validera vid gränsytan (DTO/input), och igen vid persistens vid behov

- Använd typade felkoder (inte bara strängar)

- Mappa domänfel till HTTP‑status (t.ex. 409 för konflikter, 422 för semantisk validering)

- Inkludera korrelations‑ID:n i svar och loggar

Prestanda: caching, batching, query planning

Modeller genererar ofta korrekt‑men‑långsam kod om du inte uttryckligen ber om prestanda‑val. Prompt för förväntad trafik, latensmål och datastorlek, och be sedan om avvägningar.

Bra tillägg:

- “Anta 1k RPS och 50ms p95‑mål”

- “Undvik N+1‑frågor; visa query‑plan eller indexförslag”

- “Föreslå cachinglager (in‑memory vs Redis) och invalidationsstrategi”

- “Batcha externa anrop; lägg till timeouts och circuit breakers”

Observability: loggar, metrics, traces, alerts

Behandla observability som en del av feature‑leveransen. Prompt för vad du ska mäta och vad som triggar åtgärd.

Be modellen att outputta:

- Strukturera loggar (event‑namn + nyckelfält, inga känsliga data)

- Metrics (RPS, felrate, latens p50/p95/p99, ködjup)

- Trace‑spans kring DB och externa anrop

- Alertregler som är handlingsbara (symptom + troliga orsaker + runbook‑tips)

Mobilutveckling: Prompts för begränsningar och verkliga enheter

Plan before you generate

Använd planning mode för att sätta scope, begränsningar och acceptanskontroller innan du genererar kod.

Mobilappar går sönder inte bara av “dålig kod”. De går sönder för att verkliga enheter är stökiga: nätverk droppar, batterier avlastas, bakgrundsexekvering begränsas och små UI‑misstag blir tillgänglighetsblockerare. Bra prompting för mobil betyder att be modellen designa för begränsningar, inte bara funktioner.

Prompts för offline‑beteende, batteri och nätverksvariation

I stället för “Lägg till offline‑läge”, be om en plan som gör avvägningarna explicita:

- “Designa en offline‑first‑approach för denna skärm. Specificera vilken data som cachas, cache‑invalidation och vad UI visar för ‘stale but usable’ data.”

- “Givet intermittent uppkoppling (2G–5G, captive portals), föreslå retry/backoff‑regler och användarmeddelanden. Inkludera kantfall som appen som bakgrundas mitt i en förfrågan.”

- “Föreslå sätt att minska batteripåverkan för denna funktion. Tänk bakgrundsuppgifter, positionsanvändning, polling‑intervall och när arbete ska stoppas.”

Dessa prompts tvingar modellen bortom happy‑path och fram till beslut som går att granska.

State‑hantering och navigationsflöden

Mobilbuggar kommer ofta från state som är “nästan rätt” tills användaren trycker tillbaka, roterar enheten eller återvänder från en deep link.

Använd prompts som beskriver flöden:

“Här är skärmarna och händelserna (login → onboarding → home → details). Föreslå en statemodell och navigationsregler. Inkludera hur man återställer state efter process‑död, och hur man hanterar dubbla tryck och snabb back‑navigation.”

Om du klistrar in ett förenklat flödesschema eller en lista rutter kan modellen producera en checklist över övergångar och fel‑lägen att testa.

Be om plattforms‑specifik granskning, inte generisk UI‑rådgivning:

“Granska denna skärm mot iOS Human Interface Guidelines / Material Design och mobil tillgänglighet. Lista konkreta problem: touch‑målstorlekar, kontrast, dynamisk text/skalning, skärmläsaretiketter, tangentbords‑navigering och haptics‑användning.”

Crash‑triage med stacktraces + enhetskontext

Krascher blir handlingsbara när du parar stacktrace med kontext:

“Givet denna stacktrace och enhetsinfo (OS‑version, modell, app‑version, minnespress, reproduktionssteg), föreslå troligaste rotorsaker, vilka loggar/metrics som ska läggas till, och en säker fix med rollout‑plan.”

Den strukturen förvandlar “Vad hände?” till “Vad gör vi härnäst?”—där prompting ger mest värde på mobil.

Promptmönster som fungerar över webb, backend och mobil

Bra prompts är återanvändbara. De bästa läser som ett litet spec: tydlig avsikt, tillräcklig kontext för att agera och en verifierbar output. Dessa mönster funkar oavsett om du förbättrar UI, formar ett API eller felsöker en mobilkrasch.

“Spec Prompt”‑strukturen

En pålitlig struktur är:

- Roll: vem modellen ska agera som (t.ex. “senior frontend‑engineer”)\n- Mål: vad framgång är\n- Kontext: relevanta filer, plattform, begränsningar, nuvarande beteende\n- Begränsningar: prestanda, tillgänglighet, bakåtkompatibilitet, bibliotek, OS‑versioner\n- Exempel: in/ut, kantfall, “gör/inte”‑exempel\n- Outputformat: vad som ska returneras (punkter, patch, JSON)

Det minskar tvetydighet över domäner: webb (a11y + browser‑support), backend (konsistens + felkontrakt), mobil (batteri + enhetsbegränsningar).

Steg‑för‑steg vs direkt output

Använd direkt output när du redan vet vad du behöver: “Generera en TypeScript‑typ + exempelpayload.” Det är snabbare och undviker långa förklaringar.

Be om trade‑offs och kort resonemang när beslut spelar roll: välja pagineringsstrategi, bestämma caching‑gränser eller diagnostisera ett flakigt mobiltest. En praktisk kompromiss är: “Förklara kort centrala antaganden och avvägningar, och ge sedan slutligt svar.”

Prompt‑“kontrakt” (lintbara outputs)

Behandla prompts som mini‑kontrakt genom att kräva strukturerad output:

{

"changes": [{"file": "", "summary": "", "patch": ""}],

"assumptions": [],

"risks": [],

"tests": []

}

Det gör resultaten granskbara, diff‑vänliga och enklare att validera med schema‑kontroller.

Minska hallucinationer

Lägg in vaktposter:\n

- Kräv att modellen listar antaganden och ställ frågor om viktiga inputs saknas.\n- Be den signalera osäkerhet: “Om du är osäker, säg det och erbjud alternativ.”\n- Begär verifieringssteg: kommandon, testfall eller var i koden man ska titta.\n- När externa fakta refereras, be den uppge källor (eller uttryckligen säga “inga källor användes”).

Ingenjörsarbetsflöde: prompts som förstaklass‑artefakter

Get credits for sharing

Dela vad du bygger eller värva andra och tjäna krediter till ditt Koder.ai‑konto.

Om ert team använder AI regelbundet slutar prompts vara “chattmeddelanden” och börjar bete sig som ingenjörsresurser. Det snabbaste sättet att förbättra kvalitet är att behandla prompts på samma sätt som kod: tydlig avsikt, konsekvent struktur och spårbarhet.

Behandla prompts som kod

Tilldela ägarskap och håll prompts i versionskontroll. När en prompt ändras ska du kunna svara: varför, vad förbättrades och vad gick sönder. Ett lättsamt tillvägagångssätt är en /prompts‑mapp i varje repo, med en fil per workflow (t.ex. pr-review.md, api-design.md). Granska promptändringar i pull requests, precis som andra bidrag.

Även om ni använder en chattbaserad plattform som Koder.ai gäller samma princip: insatser som genererar produktionskod bör versioneras (eller åtminstone fångas som återanvändbara mallar), så team kan reproducera resultat över sprintar.

Använd mallar för upprepbart arbete

De flesta team upprepar samma AI‑stödjande uppgifter: PR‑granskningar, incident‑sammanfattningar, datamigreringar, release‑noteringar. Skapa promptmallar som standardiserar indata (kontext, begränsningar, definition av klart) och output (format, checklistor, acceptanskriterier). Det minskar variation mellan ingenjörer och gör resultaten enklare att verifiera.

En bra mall brukar innehålla:\n

- Mål (vilket resultat du behöver)\n- Begränsningar (språk, ramverk, tid/minnesgränser)\n- Projektkontext (referenser till filer, arkitekturnoteringar)\n- Outputformat (tabeller, diffs, steg‑för‑steg‑plan)

Gör godkännanden explicita

Dokumentera var människor måste godkänna output—särskilt säkerhetskänsliga områden, kravuppfyllelse, produktionsdatabasändringar och allt som rör auth eller betalningar. Placera dessa regler bredvid prompten (eller i /docs/ai-usage.md) så ingen förlitar sig på minne.

När ert verktyg stöder det, fånga “safe iteration”‑mekanik direkt i arbetsflödet. Plattformar som Koder.ai stödjer till exempel snapshots och rollback, vilket gör det enklare att experimentera med genererade förändringar, granska diffs och återställa om en prompt producerar en osäker refaktor.

När prompts blir förstaklass‑artefakter får ni upprepbarhet, spårbarhet och säkrare AI‑leverans—utan att sakta ner teamet.

Testning och utvärdering av promptkvalitet

Behandla prompts som andra ingenjörsresurser: om du inte kan utvärdera dem kan du inte förbättra dem. “Verkar fungera” är skört—särskilt när samma prompt kommer att återanvändas av ett team, köras i CI eller appliceras på nya kodbaser.

Bygg golden‑testfall

Skapa en liten uppsättning “kända indata → förväntad output” för dina prompts. Nyckeln är att göra output verifierbar:

- Föredra strukturerade outputs (JSON, tabeller, explicita rubriker) framför fri text.\n- Inkludera kantfall (tomma inputs, långa strängar, ovanliga lokaler, felvägar).\n- Versionera prompten och de golden‑fallen tillsammans så ändringar är avsiktliga.

Exempel: en prompt som genererar ett API‑felkontrakt ska alltid producera samma fält, med konsekventa namn och statuskoder.

Använd diff‑baserad utvärdering

När du uppdaterar en prompt, jämför den nya outputen med tidigare output och ställ frågan: vad ändrades och varför? Diffs gör regressioner uppenbara (saknade fält, annan ton, ändrad ordning) och hjälper granskare fokusera på beteende i stället för stil.

Automatisera kontroller i pipeline

Prompts kan testas med samma disciplin som kod:

- Schema‑validering för JSON‑outputs\n- Enhetstester som assertar nyckelkrav (t.ex. innehåller paginering, hanterar nulls)\n- Statisk analys för genererad kod\n- “Bygg och kör?”‑kontroller för att fånga syntax‑ och beroendeproblem

Om du genererar hela applikationer via ett plattformsarbete—som Koder.ai:s chattdrivna byggprocess—blir dessa kontroller ännu viktigare, eftersom du snabbt kan producera större förändringssatser. Hastigheten ska öka granskningskapaciteten, inte minska rigor.

Mät verkliga utfall

Slutligen, följ upp om prompts verkligen förbättrar leverans:

- Tid sparad per uppgift (baseline vs AI‑assisterad)\n- Felrate (buggar upptäckta i QA/produktion)\n- Omarbetningsfrekvens (hur ofta outputs måste göras om manuellt)

Om en prompt sparar minuter men ökar omarbetning är den inte “bra”—den är bara snabb.

Säkerhet, sekretess och riskkontroller för AI‑assisterat arbete

Att använda en LLM i ingenjörsarbete ändrar vad “safe by default” betyder. Modellen kan inte avgöra vilka detaljer som är konfidentiella, och den kan generera kod som ser rimlig ut samtidigt som den tyst inför sårbarheter. Behandla AI‑assistans som ett verktyg som behöver vaktposter—precis som CI, beroende‑skanning eller kodgranskning.

Läck inte hemligheter (inte ens av misstag)

Anta att allt du klistrar in i en chatt kan lagras, loggas eller granskas. Klistra aldrig in API‑nycklar, access‑tokens, privata certifikat, kunddata eller interna URL:er. Använd i stället platshållare och minimala, syntetiska exempel.

Om du behöver hjälp att felsöka, dela:

- Minsta reproducerbara snippet med falska värden\n- Ett redigerat loggutdrag (ta bort IDs, e‑post, tokens)\n- En klar uppdelning av vad som är offentligt vs konfidentiellt

Skapa ett teamredigeringsflöde (mallar och checklistor) så folk inte uppfinner egna regler när det brådskar.

AI‑genererad kod kan introducera klassiska problem: injektionsrisker, osäkra default, saknade auktoriseringskontroller, osäkra beroenden och bräcklig kryptografi.

En praktisk promptvana är att be modellen kritisera sin egen output:\n

- “Lista möjliga säkerhetsrisker i denna kod, rangordna efter påverkan.”\n- “Vilka inputs kan kontrolleras av en attackerare?”\n- “Vad bör valideras server‑side, och hur?”

Kräv säkerhetsgranskning för känsliga områden

För autentisering, kryptografi, behörighetskontroller och åtkomststyrning, gör “säkerhetsgranskning” till en del av definition of done. Para dem med mänsklig granskning och automatiska kontroller (SAST, dependency scanning). Om ni har interna riktlinjer, referera dem i prompten (t.ex. “Följ våra auth‑riktlinjer i /docs/security/auth”).

Målet är inte att förbjuda AI—målet är att göra säkra beteenden till det enklaste beteendet.

Teamskicklighet: samarbete, granskning och träning

Start a Flutter prototype

Gör ett flödesfokuserat prompt till en Flutter‑appbas för vidare iteration.

Prompting skalar bäst när det behandlas som en teamskicklighet, inte ett personligt knep. Målet är inte “bättre prompts” i abstrakt mening—det är färre missförstånd, snabbare granskningar och mer förutsägbara resultat från AI‑assisterat arbete.

Definiera vad “bra” innebär

Innan någon skriver prompts, enas om en gemensam definition av klart. Förvandla “gör det bättre” till mätbara förväntningar: acceptanskriterier, kodstandarder, namngivningskonventioner, tillgänglighetskrav, prestandabudgetar och loggning/observability‑behov.

Ett praktiskt tillvägagångssätt är att inkludera ett litet “output‑kontrakt” i prompts:

- Vad ändringen måste göra (acceptanskriterier)\n- Vad den inte får göra (icke‑mål, begränsningar)\n- Hur den ska levereras (filer att redigera, kodstil, tester krävs)

När team konsekvent gör detta blir promptkvalitet granskbar—precis som kod.

Pair prompting: skriv + pröva

Pair prompting speglar parprogrammering: en person skriver prompten, den andra granskar och aktivt prövar antaganden. Granskarens jobb är att ställa frågor som:\n

- Vilka indata, kantfall och fel‑tillstånd antyds men nämns inte?\n- Vilka beroenden eller produktregler kan brytas?\n- Vilka tester bevisar att detta är korrekt?\n

Det fångar oklarheter tidigt och förhindrar att AI trycker fram fel lösningar med hög självsäkerhet.

Träna med en gemensam playbook

Skapa en lättviktig prompt‑playbook med exempel från er kodbas: “API‑endpoint‑mall”, “frontend‑komponent‑refaktor‑mall”, “mobil‑prestanda‑mall” osv. Spara den där ingenjörer redan arbetar (wiki eller repo) och länka den i PR‑mallar.

Om er organisation använder en gemensam plattform för tvärfunktionellt byggande (produkt + design + engineering), fånga mallarna där också. Till exempel standardiserar Koder.ai‑team ofta prompts kring planning mode (först enas om scope och acceptanskriterier), och sedan generera implementeringssteg och tester.

Bygg feedback‑loopar från verkliga incidenter

När en bugg eller incident spåras till en oklar prompt, uppdatera inte bara koden—uppdatera promptmallen. Med tiden blir era bästa prompts institutionellt minne, vilket minskar upprepade fel och onboarding‑tid.

En praktisk adoptionsplan för ert ingenjörsteam

Att införa AI‑prompting fungerar bäst som en liten ingenjörsförändring, inte ett stort “AI‑initiativ.” Behandla det som vilken annan produktivitetsmetod som helst: börja smalt, mät effekt, och expandera.

Vecka 1: Välj några hög‑värde‑use‑cases

Välj 3–5 use‑cases per team som är frekventa, låg‑risk och lätta att utvärdera. Exempel:\n

- API‑scaffold‑generering (handlers, routing, OpenAPI‑snippets)\n- Testgenerering (unittester, kantfall, regressionskontroller)\n- UI‑komponentvarianter (tillstånd, tillgänglighetsanmärkningar)\n- Migreringshjälpare (SQL‑migreringar, datavalideringsskript)\n

Skriv ner vad “bra” innebär (tidsbesparing, färre buggar, tydligare dokumentation) så teamet har ett gemensamt mål.

Veckor 2–3: Skapa en liten malluppsättning

Bygg ett litet bibliotek med promptmallar (5–10) och iterera veckovis. Håll varje mall fokuserad och strukturerad: kontext, begränsningar, förväntad output och en kort definition av klart. Spara mallarna där ingenjörer redan arbetar (repo‑mapp, intern wiki eller ticket‑system).

Om ni utvärderar en plattformsapproach, se om den stöder hela livscykeln: generera appkod, köra tester, deploya och exportera källkod. Till exempel kan Koder.ai skapa webb, backend och Flutter‑appar från chatt, stödja export av källkod och erbjuda deploy/hosting—nyttigt när man vill att prompts går från snippets till reproducerbara byggen.

Löpande: Lägg till lättviktig styrning

Håll styrningen enkel så den inte bromsar leverans:\n

- Tilldela en tydlig ägare för varje mall\n- Kräv snabb kollegagranskning för ändringar (som kodgranskning)\n- Håll en kort ändringslogg (vad ändrades, varför, observerad påverkan)

Månad 2: Expandera med träning och gemensamma mått

Håll 30‑minuters interna sessioner där team demoar en prompt som mätbart hjälpte. Följ ett par mätetal (cykeltidsminskning, färre granskningskommentarer, förbättrad testtäckning) och pensionera mallar som inte levererar.

För fler mönster och exempel, utforska /blog. Om ni utvärderar verktyg för att stödja team i skala, se /pricing.