Vad Khosla menade med "AI kommer att ersätta läkare"

När Vinod Khosla säger "AI kommer att ersätta läkare" beskriver han oftast inte ett sci‑fi‑sjukhus utan människor. Han gör ett mer precist, operativt påstående: många uppgifter som idag tar en läkares tid—särskilt informationsintensivt arbete—kan utföras av programvara som är snabbare, billigare och alltmer korrekt.

Omfattningen: ersättning av uppgifter, inte av medkänsla

I Khoslas formulering betyder "ersätta" ofta substituera en stor del av det läkare gör dagligen, inte utplåna yrket. Tänk på de repetitiva delarna av vården: samla symtom, kontrollera riktlinjer, rangordna sannolika diagnoser, rekommendera nästa tester, övervaka kroniska tillstånd och tidigt flagga risker.

Därför är idén mer "pro‑automation" än "anti‑läkare." Grundinsatsen är att vården är full av mönster—och mönsterigenkänning i stor skala är där AI ofta är starkast.

Vad denna artikel syftar till

Texten behandlar påståendet som en hypotes att utvärdera, inte en slogan att heja på eller avfärda. Vi ser på resonemangen bakom det, vilka typer av vårdprodukter som ligger i linje med det, och de verkliga begränsningarna: reglering, säkerhet, ansvar och den mänskliga sidan av medicin.

Nyckelbegrepp vi använder

- Ersätta: AI utför en uppgift från början till slut med minimal klinikersinblandning.

- Augmentera: AI assisterar, men en kliniker förblir beslutsfattare.

- Kliniker: En legitimerad professionell (läkare, sjuksköterska, nurse practitioner, physician assistant) som ger patientvård.

- Diagnos: Inte bara att namnge en sjukdom, utan att forma en sannolikhetsviktad förklaring och välja nästa åtgärder (tester, behandling, uppföljning).

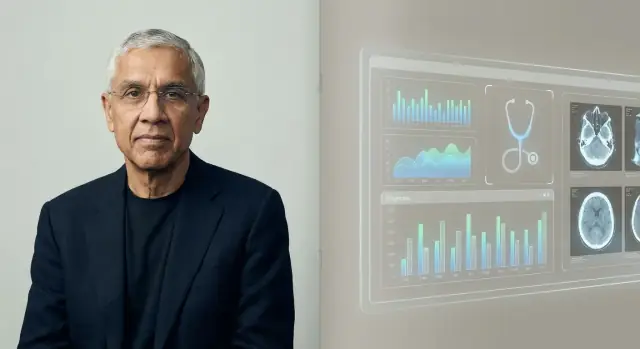

Vem är Vinod Khosla, och varför hans synpunkt spelar roll

Kort, faktabakgrund

Vinod Khosla är en Silicon Valley‑entreprenör och investerare mest känd för att ha grundat Sun Microsystems på 1980‑talet och senare byggt en lång karriär inom riskkapital. Efter tid på Kleiner Perkins grundade han Khosla Ventures 2004.

Denna kombination—operatörserfarenhet plus årtionden som investerare—hjälper förklara varför hans uttalanden om AI och vård sprids långt utanför teknikkretsar.

Khosla Ventures "stil" i klara termer

Khosla Ventures har rykte om sig att satsa på stora, högkonvikta idéer som först kan verka orimliga. Företaget lutar ofta mot:

- konträra teser (idéer som många experter avfärdar tidigt)

- plattformsförskjutningar (teknologier som omformar flera industrier)

- lång tidshorisont (vilja att vänta på reglering, adoption eller infrastruktur)

Detta spelar roll eftersom förutsägelser som "AI kommer att ersätta läkare" inte bara är retorik—de kan forma vilka startups som får pengar, vilka produkter som byggs och vilka narrativ ledningar tar på allvar.

Varför vården blev ett större mål för AI‑satsningar

Vården är en av de största och dyraste delarna av ekonomin, och den är också fylld av signaler som AI potentiellt kan lära sig från: bilder, labbresultat, anteckningar, sensordata och utfall. Även måttliga förbättringar i noggrannhet, hastighet eller kostnad kan ge betydande besparingar och ökad tillgång.

Khosla och hans fond har upprepade gånger argumenterat för att medicin är mogen för programvarudriven förändring—särskilt inom triage, diagnostikstöd och arbetsflödesautomation. Oavsett om du håller med om "ersättnings"‑formuleringen spelar hans syn roll eftersom den speglar hur en betydande del av riskkapitalet värderar medicinens framtid—och var kapitalet sannolikt hamnar.

Logiken bakom förutsägelsen

Khoslas förutsägelse vilar på ett enkelt påstående: en stor del av medicinen—särskilt primärvård och tidig triage—är mönsterigenkänning under osäkerhet. Om diagnos och behandlingsval i många fall är "matcha detta presentation med det mest sannolika", då bör programvara som kan lära sig från miljontals exempel så småningom överträffa enskilda kliniker som lär sig från tusentals.

Mönsterigenkänning i stor skala

Människor är bra på att se mönster, men vi begränsas av minne, uppmärksamhet och erfarenhet. Ett AI‑system kan ta in långt fler fall, riktlinjer och utfall än någon enskild läkare hinner under en karriär, och sedan tillämpa den inlärda mönstermatchningen konsekvent. I Khoslas resonemang, när systemets felkvot sjunker under genomsnittsklinikerns, är det rationellt för patienter och betalare att låta rutindecisioner gå genom maskinen.

Kostnad, tillgång och konsekvens

Ekonomi är en annan drivkraft. Primärvård begränsas av tid, geografi och personalbrist; besök kan vara dyra, korta och ojämna i kvalitet. En AI‑tjänst kan vara tillgänglig dygnet runt, skala till underbetjänade områden och leverera mer enhetlig beslutsfattning—minska problemet "det beror på vem du träffade".

Varför det blev möjligt

Tidigare expertsystem kämpade eftersom de förlitade sig på handkodade regler och snäva dataset. Genomförbarheten förbättrades när medicinska data digitaliserades (EHR, bilddiagnostik, laboratorier, wearables) och beräkningskraft gjorde det praktiskt att träna modeller på massiva korpusar och uppdatera dem kontinuerligt.

Automation vs mänsklig vård

Även i denna logik dras "ersättnings"‑linjen oftast kring rutinmässig diagnos och protokollstyrd behandling—inte de delar av medicin som handlar om förtroende, komplexa avvägningar och att stödja patienter genom rädsla, osäkerhet eller livsavgörande beslut.

Viktiga argument och citat (med rätt kontext)

Khoslas "AI kommer att ersätta läkare" levereras ofta som en provokativ prognos, inte ett bokstavligt löfte om att sjukhus blir läkarlösa. Den genomgående tematiken i hans tal och intervjuer är att mycket av medicinen—särskilt diagnos och rutinbeslut—följer mönster som programvara kan lära sig, mäta och förbättra.

Argument 1: Mönsterigenkänning skalar snabbare än mänsklig utbildning

Han beskriver ofta kliniskt resonerande som en form av mönstermatchning över symtom, anamneser, bilder, laboratorier och utfall. Kärnpåståendet är att när en AI‑modell uppnår en viss kvalitetsnivå kan den rullas ut brett och uppdateras kontinuerligt—medan klinikerutbildning är långsam, dyr och ojämn mellan regioner.

Argument 2: Bättre genomsnittlig prestanda, färre "dåliga dagar"

En nyans i hans formulering är variabilitet: kliniker kan vara utmärkta men inkonsekventa på grund av trötthet, arbetsbörda eller begränsad exponering för sällsynta fall. AI kan erbjuda stadig prestanda och potentiellt lägre felnivåer när det testas, övervakas och retränas ordentligt.

Argument 3: Andra åsikter blir standard

Istället för att föreställa sig AI som en enda slutgiltig "ersättning", är hans starkare version mer som: de flesta patienter kommer att rådfråga en AI först, och mänskliga kliniker kommer i högre grad att fungera som granskare för komplexa fall, edge‑situationer och högriskbeslut.

Viktig kontext: en omdebatterad prognos, inte etablerad sanning

Förespråkare ser hans ståndpunkt som ett tryck mot mätbara resultat och ökad tillgång. Kritiker noterar att verklig medicin inkluderar tvetydighet, etik och ansvar—och att "ersättning" beror lika mycket på reglering, arbetsflöde och förtroende som på modellens noggrannhet.

De vårdsatsningar som ligger i linje med tesen

Khoslas "AI kommer att ersätta läkare" kartläggs lätt mot de typer av vårdstartups som VCs gillar: företag som kan skala snabbt, standardisera rörigt kliniskt arbete och förvandla expertomdömen till programvara.

De stora investeringskategorierna

Många satsningar som passar denna tes grupperas i några återkommande teman:

- Diagnostik och tidig upptäckt: verktyg som upptäcker sjukdom tidigare än rutinvård, ofta genom att kombinera labb, symtom, anamnes och tidigare journaler till en riskpoäng.

- Triage och routing: AI‑"entréer" som avgör vem som behöver akutsjukvård, vem som kan egenvårda och vilken specialist som bör ses.

- Bilddiagnostik och signaltolkning: radiologi, patologi, dermatologibilder, EKG—områden där mönsterigenkänning är centralt och prestanda kan mätas.

- Arbetsflödesautomation: sammanfattning av journaler, dokumentation, prior‑auth‑stöd, kodning och inkorgshantering—mindre rubrikerna men direkt kopplat till klinikernas tid.

Varför dessa satsningar passar VC‑incitament

Att ersätta (eller minska) behovet av kliniker är ett mycket stort pris: vårdkostnader är enorma och arbetskraft är en huvudkostnad. Det skapar incitament att formulera tidslinjer djärvt—eftersom finansiering belönar en tydlig högrisk‑höghypotes‑story, även när klinisk adoption och reglering går långsammare än programvara.

En punktlösning gör en sak väldigt väl (t.ex. läsa en lungröntgen). En plattform syftar till att ligga över många arbetsflöden—triage, diagnosstöd, uppföljning, fakturering—med delade datakanaler och modeller.

"Ersätta läkare"‑narrativet hänger mer på plattformar: om AI bara vinner i en snäv uppgift anpassar sig läkarna; om den koordinerar många uppgifter end‑to‑end kan klinikerrollen skifta mot övervakning, undantagshantering och ansvar.

För grundare som utforskar dessa plattformsidéer spelar snabbhet roll tidigt: du behöver ofta fungerande prototyper för intake‑flöden, kliniker‑dashboards och revisionsspår innan du ens kan testa ett arbetsflöde. Verktyg som Koder.ai kan hjälpa team att bygga interna webbappar (vanligtvis React i frontend, Go + PostgreSQL i backend) från en chattgränssnitt, exportera källkod och iterera snabbt. För allt som påverkar kliniska beslut behövs fortfarande ordentlig validering, säkerhetsgranskning och en regulatorisk strategi—men snabb prototypning kan förkorta vägen till en realistisk pilot.

Var AI realistiskt kan matcha eller slå kliniker

Bygg mobila incheckningar

Skapa Flutter-appar för uppföljningar och fjärrenkäter från chattpromptar.

AI slår redan människor i specifika, snäva delar av kliniskt arbete—särskilt när jobbet handlar om mönsterigenkänning, hastighet och konsekvens. Det betyder inte "AI‑läkare" i full bemärkelse. Det betyder att AI kan vara en mycket stark komponent i vården.

Uppgifterna där AI är genuint starkt

AI utmärker sig där det finns mycket repetitiv information och tydliga återkopplingsslingor:

- Sammanfattning: omvandla långa journaler till en ren tidslinje (medicin, labb, tidigare diagnoser) eller utkast till besöksanteckningar från transkriptioner.

- Triage: sortera symtom och riskfaktorer i brådskande kategorier (egenvård vs samma dag‑besök vs akuten), särskilt i högvolymsmiljöer.

- Mönsterdetektion: hitta subtila signaler i bilder och vågformer (radiologi, dermatologi, EKG) och se kombinationer av labbtrender som människor kan missa när de är trötta eller stressade.

Här innebär "bättre" ofta färre missade fynd, mer standardiserade beslut och snabbare svar.

Kliniskt beslutsstöd vs autonom diagnos

De flesta verkliga vinster idag kommer från clinical decision support (CDS): AI föreslår sannolika tillstånd, flaggar farliga alternativ, rekommenderar nästa tester eller kontrollerar följsamhet mot riktlinjer—medan en kliniker förblir ansvarig.

Autonom diagnos (AI tar beslut end‑to‑end) är möjlig i begränsade, väldefinierade kontexter—som screeningflöden med strikta protokoll—men det är inte standard för komplexa patienter med flera sjukdomar.

Haken: datakvalitet och representativitet

AI:s noggrannhet beror starkt på träningsdata som matchar patientpopulationen och vårdmiljön. Modeller kan drifta när:

- sjukhuset använder annan utrustning eller dokumentationsstil,

- patientmixen skiljer sig (ålder, etnicitet, komorbiditeter), eller

- "ground truth"‑etiketterna var inkonsekventa.

Varför mänsklig tillsyn fortfarande är viktig

I högriskmiljöer är tillsyn inte valfri—det är säkerhetslagret för edge‑fall, ovanliga presentationer och värdebaserade bedömningar (vad en patient är villig att göra, tolerera eller prioritera). AI kan vara utmärkt på att se, men kliniker måste fortfarande avgöra vad det innebär för den här personen, idag.

Där AI fortfarande brister

AI kan imponera på mönstermatchning, journal‑sammanfattning och förslag till troliga diagnoser. Men medicin är inte bara ett prediktionsproblem. Många av de svåraste delarna uppstår när det "rätta" svaret är oklart, patientens mål krockar med riktlinjer, eller systemet runt vården är rörigt.

Förtroende, sängkantssamtal och delade beslut

Människor vill inte bara ha ett resultat—de vill känna sig hörda, trodda och trygga. En kliniker kan märka rädsla, skam, förvirring eller risk i hemmiljön och anpassa samtal och plan därefter. Shared decision‑making kräver också att förhandla om avvägningar (biverkningar, kostnad, livsstil, familjestöd) på ett sätt som bygger förtroende över tid.

Tvetydighet, multi‑morbiditet och sällsynta fall

Riktiga patienter har ofta flera samtidiga tillstånd, ofullständiga historier och symtom som inte passar en ren mall. Sällsynta sjukdomar och atypiska presentationer kan låta som vanliga problem—tills de inte gör det. AI kan generera rimliga förslag, men "rimligt" är inte samma sak som "kliniskt bevisat", särskilt när subtil kontext spelar roll (ny resa, nya mediciner, sociala faktorer, "något känns fel").

Ansvar när AI har fel

Även en mycket noggrann modell kommer ibland att misslyckas. Den svåra frågan är vem som bär ansvaret: klinikern som följde verktyget, sjukhuset som satte upp det, eller leverantören som byggde det? Tydligt ansvar påverkar hur försiktiga team måste vara—och hur patienter kan söka upprättelse.

Operativ verklighet: passa in i kliniker och EHR

Vård sker inom arbetsflöden. Om ett AI‑verktyg inte integrerar smidigt med EHR, beställningssystem, dokumentation och fakturering—eller om det lägger till klick och osäkerhet—kommer upptagna team inte att förlita sig på det, oavsett hur bra demon ser ut.

Reglering, etik och säkerhet i medicinsk AI

Behåll kontroll över din kod

Exportera källkoden när som helst så att ditt team kan validera, säkra och bygga vidare.

Medicinsk AI är inte bara ett tekniskt problem—det är ett säkerhetsproblem. När programvara påverkar diagnos eller behandling behandlas den ofta mer som en medicinteknisk produkt än som en vanlig app.

FDA och CE‑granskning: det grundläggande

I USA reglerar FDA många "Software as a Medical Device"‑verktyg, särskilt de som diagnostiserar, rekommenderar behandling eller direkt påverkar vårdbeslut. I EU spelar CE‑märkning under MDR en liknande roll.

Dessa ramverk kräver bevis för att verktyget är säkert och effektivt, tydlighet om avsedd användning och kontinuerlig övervakning efter distribution. Reglerna spelar roll eftersom en modell som ser imponerande ut i en demo ändå kan misslyckas i verkliga kliniker, med verkliga patienter.

Bias och ojämn prestanda

En stor etisk risk är ojämn noggrannhet över populationer (t.ex. olika åldersgrupper, hudtoner, språk eller komorbiditeter). Om träningsdatan underrepresenterar vissa grupper kan systemet systematiskt missa diagnoser eller överrekommendera interventioner för dem. Fairness‑tester, subgruppsrapportering och noggrann datasetdesign är inte tillval—de är grundläggande säkerhet.

Integritet, samtycke och patientdata

Att träna och förbättra modeller kräver ofta stora mängder känslig hälsodata. Det väcker frågor om samtycke, sekundär användning, begränsningar i avidentifiering och vem som tjänar ekonomiskt. God styrning innefattar tydliga patientmeddelanden, strikt åtkomstkontroll och policyer för datalagring och modelluppdateringar.

"Human‑in‑the‑loop" som säkerhetsmönster

Många kliniska AI‑verktyg är designade för att assistera, inte ersätta, genom att hålla en människa ansvarig för slutgiltigt beslut. Detta "human‑in‑the‑loop"‑sätt kan fånga fel, ge kontext som modellen saknar och skapa ansvar—men det fungerar bara om arbetsflöden och incitament hindrar blind automation.

Vad detta betyder för läkare och jobb inom vården

Khoslas påstående hörs ofta som "läkare blir överflödiga." En mer användbar läsning är att skilja ersättning (AI utför en uppgift end‑to‑end med minimal mänsklig input) från omfördelning (människor fortfarande äger utfallen, men arbetet skiftar mot övervakning, empati och samordning).

Ersättning vs omfördelning

I många miljöer kommer AI sannolikt att ersätta delar av kliniskt arbete först: utkast till anteckningar, lyftning av differentialdiagnoser, kontroll av riktlinjer och sammanfattning av patienthistorik. Klinikerrollen skiftar från att generera svar till att granska, kontextualisera och kommunicera dem.

Vilka roller förändras först

Primärvården kan märka förändringen i form av förbättrad "front door"‑triage: symtomkontroller och ambient dokumentation minskar rutinbesökstid, medan komplexa fall och relationsbaserad vård förblir människoledda.

Radiologi och patologi kan se mer direkt uppgiftsersättning eftersom arbetet redan är digitalt och mönsterbaserat. Det betyder inte färre specialister över natt—snarare högre genomströmning, nya kvalitetsarbetsflöden och press på ersättning.

Sjuksköterskeyrken handlar mindre om diagnos och mer om kontinuerlig bedömning, utbildning och samordning. AI kan minska administrativ börda, men vård vid sängen och eskaleringsbeslut förblir människocentrerade.

Nya jobb som uppstår

Räkna med tillväxt i roller som AI‑övervakare (övervakar modellprestanda), klinisk informatik (arbetsflöde + datastyrning) och care coordinator (stänger luckor som modellen flaggar). Dessa roller kan hamna inom befintliga team snarare än som separata titlar.

Utbildning och legitimation

Medicinsk utbildning kan lägga till AI‑litteracitet: hur man validerar utdata, dokumenterar beroende och upptäcker felmodi. Legitimering kan utvecklas mot "human‑in‑the‑loop"‑standarder—vem får använda vilka verktyg, under vilken övervakning och hur ansvar fördelas när AI har fel.

De starkaste motargumenten mot Khoslas syn

Khoslas påstående är provokativt eftersom det behandlar "läkare" mest som en diagnostisk motor. Den starkaste motvikten hävdar att även om AI matchar kliniker i mönsterigenkänning är att ersätta läkare ett helt annat jobb.

Medicin är mer än diagnos

Stor del av det kliniska värdet ligger i att rama in problemet, inte bara lösa det. Läkare översätter röriga berättelser till användbara alternativ, förhandlar avvägningar (risk, kostnad, tid, värden) och samordnar vård över specialister. De hanterar också samtycke, osäkerhet och "watchful waiting"—områden där förtroende och ansvar är lika viktiga som noggrannhet.

Bevisgap: prövningar, utfall och generalisering

Många AI‑system ser imponerande ut i retrospektiva studier, men det är inte samma sak som att förbättra verkliga utfall. Det svåraste beviset är prospektiv: minskar AI missade diagnoser, komplikationer eller onödig testning över olika sjukhus, patientgrupper och arbetsflöden?

Generalisering är en annan svag punkt. Modeller kan degraderas när populationen ändras, när utrustning skiljer sig eller när dokumentationsvanor skiftar. Ett system som fungerar bra på ett ställe kan snubbla på ett annat—särskilt för ovanligare tillstånd.

Automationsbias och överberoende

Även starka verktyg kan skapa nya felkällor. Kliniker kan lita på modellen när den har fel (automationsbias) eller sluta ställa den andra frågan som fångar edge‑fall. Med tiden kan färdigheter förtvina om människor blir "gummistämpel", vilket gör det svårare att ingripa när AI är osäker eller felaktig.

Adoption kan släpa efter även när tekniken fungerar

Vården är inte en ren teknologimarknad. Ansvar, ersättning, upphandlingscykler, integration med EHR och klinikerträning bromsar ofta införande. Patienter och reglerare kan också kräva en mänsklig beslutsfattare för högriskbeslut—vilket betyder att "AI överallt" fortfarande kan se ut som "AI övervakad av läkare" under lång tid.

Praktiska slutsatser för patienter

Tjäna krediter medan du lär dig

Få krediter genom att dela din byggnad eller rekommendera kollegor till Koder.ai.

AI syns redan i vården på diskreta sätt—riskpoäng i din journal, automatiska bedömningar av röntgen, symtomkontroller och verktyg som prioriterar vem som blir sedd. För patienter är målet inte att "lita på AI" eller "avvisa AI", utan att veta vad man kan förvänta sig och hur man behåller kontrollen.

Vad du kan förvänta dig (bra och inte lika bra)

Du kommer sannolikt att se mer screening (meddelanden, frågeformulär, wearables) och snabbare triage—särskilt i upptagna kliniker och akutmottagningar. Det kan ge snabbare svar för vanliga problem och tidig upptäckt för vissa tillstånd.

Kvaliteten blir blandad. Vissa verktyg är utmärkta i snäva uppgifter; andra kan vara inkonsekventa över ålder, hudton, sällsynta sjukdomar eller röriga verkliga data. Se AI som en hjälpare, inte en slutgiltig dom.

Frågor att ställa när AI är involverat

Om ett AI‑verktyg påverkar din vård, fråga:

- Användes AI för diagnos, bildtolkning, triage eller behandlingsrekommendationer?

- Vilka data användes (min historik, labb, bilder, wearables)?

- Har det validerats på patienter som jag (ålder, kön, etnicitet, tillstånd)?

- Vem är ansvarig för slutgiltigt beslut—min kliniker eller programvaran?

- Kan jag se resonemanget eller bevisen bakom rekommendationen?

Hur tolka AI‑utdata

Många AI‑utdata är sannolikheter ("20 % risk") snarare än säkerheter. Fråga vad siffran betyder för dig: vad händer vid olika risknivåer, och vad är falsklarmfrekvensen?

Om rekommendationen är högrisk (operation, cytostatika, att sluta ett läkemedel) be om en andra åsikt—mänsklig och/eller annat verktyg. Det är rimligt att fråga: "Vad skulle du göra om detta AI‑resultat inte fanns?"

Du bör få veta när programvara väsentligt formar beslut. Om du är obekväm, fråga om alternativ, hur dina data lagras och om att välja bort påverkar tillgång till vård.

Praktiska slutsatser för kliniker och vårdteam

AI är enklast att införa när du behandlar det som något annat kliniskt verktyg: definiera användningsfallet, testa det, övervaka det och gör ansvar tydligt.

Börja där risken är låg och volymen hög

Innan ni använder AI för diagnos, använd det för att ta bort vardagsfriktion. De säkraste tidiga vinsterna är arbetsflöden som förbättrar genomströmning utan att fatta medicinska beslut:

- stöd för dokumentation (besöksanteckningar, efterbesöksummering)

- schemaläggning, remisser, prior‑auth‑utkast

- triage och routing av patientmeddelanden

Dessa områden ger ofta mätbara tidsvinster och hjälper team att bygga förtroende för förändring. Om ditt team behöver lätta interna verktyg för att stödja dessa arbetsflöden—intakeformulär, routingdashboards, auditloggar—kan snabb app‑bygge vara lika värdefullt som modellkvalitet. Plattformar som Koder.ai är designade för team som vill "vibe‑koda": du beskriver appen i chatt, itererar snabbt och exporterar källkod när ni är redo att hårdställa den för produktion. För kliniska kontexter bör detta ses som ett sätt att snabba upp operationsmjukvara och piloter, samtidigt som ni gör nödvändig säkerhet, efterlevnad och validering.