04 nov. 2025·8 min

Vint Cerf, TCP/IP och valen som byggde Internet

Utforska hur Vint Cerfs beslut kring TCP/IP möjliggjorde interoperabla nätverk och senare globala mjukvaruplattformar—från e‑post och webben till molntjänster.

Utforska hur Vint Cerfs beslut kring TCP/IP möjliggjorde interoperabla nätverk och senare globala mjukvaruplattformar—från e‑post och webben till molntjänster.

De flesta upplever Internet genom produkter: en webbplats som laddar snabbt, ett videosamtal som (för det mesta) fungerar, en betalning som klareras på några sekunder. Under dessa upplevelser ligger protokoll—delade regler som låter olika system utbyta meddelanden tillräckligt pålitligt för att vara användbara.

Ett protokoll är som att komma överens om ett gemensamt språk och etikett för kommunikation: hur ett meddelande ser ut, hur du börjar och avslutar ett samtal, vad du gör när något saknas och hur du vet vem ett meddelande är till. Utan delade regler blir varje förbindelse en engångsförhandling, och nätverk skalar inte bortom små kretsar.

Vint Cerf krediteras ofta som en av ”Internet‑fäderna”, men det är mer korrekt (och mer användbart) att se hans roll som en del av ett team som gjorde pragmatiska designval—särskilt kring TCP/IP—som förvandlade ”nätverk” till ett internetwork. De valen var inte oundvikliga. De reflekterade kompromisser: enkelhet kontra funktioner, flexibilitet kontra kontroll och snabb adoption kontra perfekta garantier.

Dagens globala plattformar—webbappar, mobiltjänster, molninfrastruktur och API:er mellan företag—lever eller dör fortfarande av samma idé: om du standardiserar rätt gränser kan du låta miljontals oberoende aktörer bygga ovanpå utan att be om tillstånd. Din telefon kan prata med servrar på andra sidan jordklotet inte bara för att hårdvaran blev snabbare, utan för att trafikreglerna var tillräckligt stabila för att innovation skulle kunna hopa upp sig.

Det här förhållningssättet spelar roll även när du ”bara bygger mjukvara”. Till exempel lyckas snabba byggplattformar som Koder.ai när de erbjuder en liten uppsättning stabila primitiv (projekt, deployment, miljöer, integrationer) samtidigt som team kan iterera snabbt i kanterna—oavsett om de genererar ett React‑frontend, en Go + PostgreSQL‑backend eller en Flutter‑mobilapp.

Vi kommer kort att beröra historien, men fokus ligger på designval och deras konsekvenser: hur lagerbyggnad möjliggjorde tillväxt, där ”tillräckligt bra” leverans låste upp nya applikationer, och vilka tidiga antaganden som slog fel kring trängsel och säkerhet. Målet är praktiskt: ta protokolltänk—tydliga gränssnitt, interoperabilitet och explicita avvägningar—och applicera det på modern plattformsdesign.

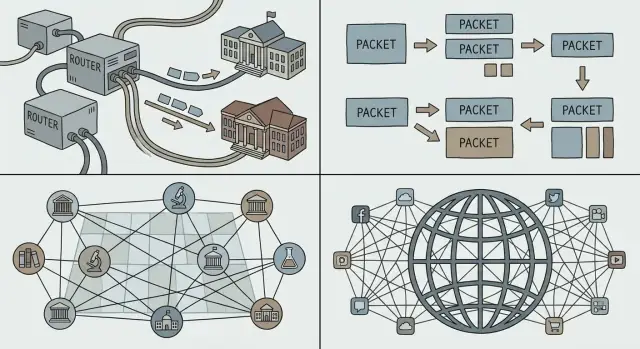

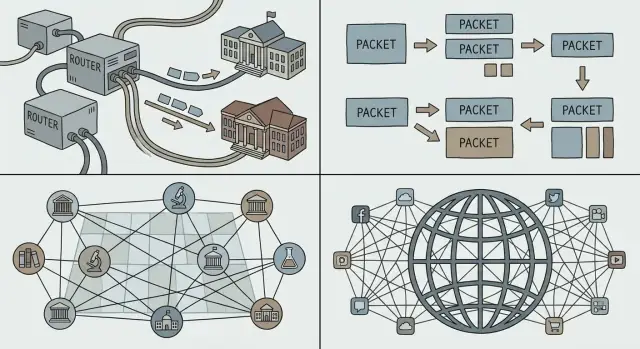

Innan ”Internet” blev ett begrepp fanns det många nät—bara inte ett nät som alla kunde dela. Universitet, statliga laboratorier och företag byggde egna system för lokala behov. Varje nät fungerade, men de fungerade sällan tillsammans.

Flera nät existerade av praktiska skäl, inte för att folk uppskattade fragmentering. Operatörer hade olika mål (forskning, militär tillförlitlighet, kommersiell service), olika budgetar och olika tekniska begränsningar. Hårdvaruleverantörer sålde inkompatibla system. Några nät var optimerade för långdistanslänkar, andra för campusmiljöer och andra för specialtjänster.

Resultatet blev många ”öar” av uppkoppling.

Om du ville att två nät skulle prata med varandra var brutallösningen att bygga om ena sidan för att matcha den andra. Det händer sällan i verkligheten: det är dyrt, långsamt och politiskt känsligt.

Det som behövdes var en gemensam limning—ett sätt för oberoende nät att interkonektera samtidigt som de behöll sina interna val. Det betydde:

Den utmaningen lade grunden för de internetworking‑idéer Cerf och andra förespråkade: koppla nät i ett delat lager, så kan innovation ske ovanpå och mångfald fortsätta nedanför.

Om du någonsin ringt ett telefonsamtal har du upplevt intuitionen bakom kretskoppling: en dedikerad ”linje” reserveras i praktiken för dig under samtalets längd. Det fungerar bra för jämn, realtidsröst, men det är slösaktigt när samtalet mest består av tystnad.

Paketväxling vänder på modellen. En vardagsanalog är posttjänsten: istället för att reservera en privat motorväg från ditt hus till en vän lägger du ditt meddelande i kuvert. Varje kuvert (paket) märks, routas genom delade vägar och sätts ihop i destinationen.

Majoriteten av datatrafik är ryckig. Ett mejl, en filhämtning eller en webbsida är inte en kontinuerlig ström—det är ett snabbt utbrott av data, sedan tystnad, sedan ett nytt utbrott. Paketväxling låter många dela samma nätlänkar effektivt, eftersom nätet transporterar paket för den som har något att skicka just nu.

Detta är en viktig anledning till att Internet kunde stödja nya applikationer utan att förhandla om hur underliggande nät fungerade: du kan skicka ett litet meddelande eller en stor video med samma grundmetod—bryt ner till paket och skicka.

Paket skalar också socialt, inte bara tekniskt. Olika nät (drivna av universitet, företag eller myndigheter) kan interkonekteras så länge de kommer överens om hur paket ska vidarebefordras. Ingen operatör behöver ”äga” hela vägen; varje domän kan bära trafik till nästa.

Eftersom paket delar länkar kan du få köfördröjning, jitter eller till och med förlust när nät är upptagna. Dessa nackdelar skapade behov av kontrollmekanismer—retransmissioner, ordning och trängselkontroll—så paketväxling förblir snabb och rättvis även under tung belastning.

Målet Cerf och kollegor jagade var inte att ”bygga ett nätverk”. Det var att interkonektera många nät—universitets-, statliga och kommersiella—samtidigt som varje nät fick behålla sin teknik, sina operatörer och sina regler.

TCP/IP beskrivs ofta som en ”svit”, men det avgörande designsteget är separationen av ansvar:

Denna uppdelning lät ”internettet” agera som ett gemensamt leveranslager, medan tillförlitlighet blev en valfri tjänst ovanpå.

Lager gör system lättare att utveckla eftersom du kan uppgradera ett lager utan att förhandla om allt ovanpå det. Nya fysiska länkar (fiber, Wi‑Fi, mobil), routningsstrategier och säkerhetsmekanismer kan dyka upp över tid—ändå talar applikationer TCP/IP och fortsätter fungera.

Det är samma mönster som plattforms‑team förlitar sig på: stabila gränssnitt, utbytbara internals.

IP lovar inte perfektion; det erbjuder enkla, universella primitiv: ”här är ett paket” och ”här är en adress.” Denna återhållsamhet möjliggjorde oväntade applikationer—mejl, webben, streaming, realtidschatt—eftersom innovatörer kunde bygga vad de behövde i kanterna utan att be nätet om tillstånd.

Om du designar en plattform är detta ett användbart test: erbjuder du några pålitliga byggstenar, eller överanpassar du systemet till dagens populära användningsfall?

”Best‑effort” leverans är en enkel idé: IP försöker flytta dina paket mot destinationen, men lovar inte att de kommer fram, kommer i rätt ordning eller kommer i tid. Paket kan tappas när länkar är upptagna, fördröjas av trängsel eller ta olika vägar.

Den enkelheten var en funktion, inte en defekt. Olika organisationer kunde koppla ihop mycket olika nät—kostsamma, högkvalitativa länkar på vissa ställen; bullriga, lågbandbredds‑länkar på andra—utan att kräva att alla uppgraderade till samma premiuminfrastruktur.

Best‑effort IP sänkte "inträdesspärren" för att delta. Universitet, myndigheter, startups och så småningom hushåll kunde ansluta med den connectivity de hade råd med. Om kärnprotokollet krävde strikta garantier från varje nät längs vägen skulle adoption ha stannat: den svagaste länken skulle blockera hela kedjan.

Istället för att bygga en perfekt pålitlig kärna flyttade Internet pålitligheten ut till hosts (enheterna i varje ände). Om en applikation behöver korrekthet—som filöverföringar, betalningar eller att ladda en webbsida—kan den använda protokoll och logik i kanterna för att upptäcka förlust och återställa:

TCP är det klassiska exemplet: det gör en opålitlig paketservice till en pålitlig ström genom att göra det tunga jobbet i ändpunkterna.

För plattforms‑team skapade best‑effort IP en förutsägbar grund: överallt i världen kan du anta samma grundläggande tjänst—skicka paket till en adress och de kommer oftast fram. Denna konsistens gjorde det möjligt att bygga globala mjukvaruplattformar som beter sig likartat över länder, operatörer och hårdvara.

End‑to‑end‑principen är en förenklat idé: håll nätets ”kärna” så minimal som möjligt och placera intelligensen i kanterna—på enheterna och i applikationerna.

För mjukvarubyggare var denna separation en gåva. Om nätet inte behövde förstå din applikation kunde du skicka nya idéer utan att förhandla ändringar med varje nätoperatör.

Denna flexibilitet är en stor anledning till att globala plattformar kunde iterera snabbt: mejl, webben, röst/video‑samtal och senare mobilappar körde alla ovanpå samma underliggande rörledning.

En enkel kärna innebär också att kärnan inte ”skyddar” dig per automatik. Om nätet mest vidarebefordrar paket är det lättare för angripare och missbrukare att utnyttja samma öppenhet för spam, scanning, denial‑of‑service‑attacker och bedrägeri. Endast vidare i nätet finns inget som verifierar vem du är. E‑post (SMTP) krävde till exempel inte tidigt bevis på att du ägde avsändaradressen. Routrar var aldrig tänkta att döma avsikt.

Kvalitet‑på‑tjänst är en annan spänning. Användare förväntar sig jämna videosamtal och snabba svar, men best‑effort‑leverans kan ge jitter, trängsel och inkonsekvent prestanda. End‑to‑end‑tillvägagångssättet flyttar många lösningar uppåt: retry‑logik, buffring, rate‑adaptation och prioritering på applikationsnivå.

Mycket av det som folk idag tänker på som "internet" är extra struktur lagrad ovanpå den minimala kärnan: CDN:er som flyttar innehåll närmare användarna, kryptering (TLS) för integritet och sekretess, samt streamingprotokoll som anpassar kvalitet efter aktuella förhållanden. Även "nätverksliknande" kapabiliteter—som bot‑skydd, DDoS‑mildring och prestandaaccelerering—levereras ofta som plattformstjänster i kanten snarare än inbyggt i IP självt.

Ett nät kan bara bli "globalt" när varje enhet kan nås tillräckligt pålitligt, utan att varje deltagare behöver känna till varje annan deltagare. Det är adressers, routings och DNS uppgift: tre idéer som förvandlar en hög av sammankopplade nät till något människor (och mjukvara) faktiskt kan använda.

En adress är en identifierare som talar om var något är. Med IP uttrycks det ”var” i en strukturerad numerisk form.

Routing är processen att bestämma hur paket ska föras mot den adressen. Routrar behöver inte en fullständig karta över varje maskin på jorden; de behöver bara tillräckligt med information för att vidarebefordra trafik steg för steg i rätt riktning.

Nyckeln är att vidarebefordringsbeslut kan vara lokala och snabba, medan helheten ändå uppträder som global nåbarhet.

Om varje enskild enhetsadress måste listas överallt skulle Internet kollapsa under sin egen bokföring. Hierarkisk adressering tillåter adresser att grupperas (till exempel per nät eller leverantör), så routrar kan hålla aggregerade rutter—en post som representerar många destinationer.

Detta är den otrendigiga hemligheten bakom tillväxt: mindre routingtabeller, färre uppdateringar och enklare samordning mellan organisationer. Aggregering är också varför IP‑adresspolicyer och tilldelningar är viktiga för operatörer: de påverkar direkt hur dyrt det är att hålla det globala systemet koherent.

Människor vill inte skriva nummer och tjänster vill inte vara permanent bundna till en maskin. DNS (Domain Name System) är namnlager som kopplar läsbara namn (som api.example.com) till IP‑adresser.

För plattforms‑team är DNS mer än bekvämlighet:

Med andra ord: adressering och routing gör Internet nåbart; DNS gör det användbart—och operationellt anpassningsbart—i plattforms‑skala.

Ett protokoll blir bara "Internet" när många oberoende nät och produkter kan använda det utan att be om tillstånd. Ett av de smartaste valen kring TCP/IP var inte bara tekniskt—det var socialt: publicera specifikationerna, bjud in kritik och låt vem som helst implementera dem.

Request for Comments (RFC)‑serien förvandlade nätverksidéer till delade, citerbara dokument. Istället för en svart låda standard kontrollerad av en leverantör gjorde RFCs reglerna synliga: vad varje fält betyder, vad man gör i kantfall och hur man håller kompatibilitet.

Denna öppenhet gjorde två saker. För det första minskade den risken för de som skulle anta tekniken: universitet, myndigheter och företag kunde utvärdera designen och bygga mot den. För det andra skapade den en gemensam referenspunkt så meningsskiljaktigheter kunde lösas med uppdateringar i texten istället för privata förhandlingar.

Interoperabilitet är vad som gör "multi‑vendor" verkligt. När olika routrar, operativsystem och applikationer kan utbyta trafik förutsägbart sitter köparna inte fast. Konkurrensen förskjuts från "vems nät kan du ansluta till?" till "vilkens produkt är bättre?"—vilket snabbar på förbättring och sänker kostnader.

Kompatibilitet skapar också nätverkseffekter: varje ny TCP/IP‑implementation gör hela nätet mer värdefullt, eftersom den kan prata med allt annat. Fler användare lockar fler tjänster; fler tjänster lockar fler användare.

Öppna standarder tar inte bort friktion—de omfördelar den. RFCs innebär debatt, samordning och ibland långsam förändring, särskilt när miljarder enheter redan är beroende av dagens beteende. Fördelen är att förändring, när den sker, är begriplig och brett implementerbar—vilket bevarar huvudnyttan: alla kan fortfarande koppla upp sig.

När folk säger "plattform" menar de ofta en produkt där andra bygger ovanpå: tredjepartsappar, integrationer och tjänster som körs på gemensamma räls. På internet är dessa räls inte ett enskilt företags privata nät—det är gemensamma protokoll som vem som helst kan implementera.

TCP/IP skapade inte webben, molnet eller app‑butikerna på egen hand. Det gav en stabil, universell grund där dessa saker kunde spridas pålitligt.

När nät kunde interkonekteras via IP och applikationer kunde lita på TCP för leverans blev det praktiskt att standardisera högre nivåers byggstenar:

TCP/IP:s gåva till plattforms‑ekonomi var förutsägbarhet: du kunde bygga en gång och nå många nät, länder och enhetstyper utan att förhandla skräddarsydd connectivity varje gång.

En plattform växer snabbare när användare och utvecklare känner att de kan lämna—eller åtminstone inte är fastlåsta. Öppna, brett implementerade protokoll sänker byteskostnader eftersom:

Denna ”tillståndslösa” interoperabilitet är varför globala mjukvarumarknader kunde formas kring delade standarder snarare än kring en enda nätägares kontroll.

Dessa ligger ovanpå TCP/IP, men de beror på samma idé: om reglerna är stabila och publika kan plattformar tävla på produkt—utan att bryta förmågan att koppla upp sig.

Internets magi är att det fungerar över hav, mobilnät, Wi‑Fi‑hotspots och överbelastade kontorsroutrar. Mindre magiska sanningen: det opererar alltid under begränsningar. Bandbredd är begränsad, latens varierar, paket går förlorade eller kommer omkastade och trängsel kan uppstå plötsligt när många delar samma väg.

Även om din tjänst är "molnbaserad" upplever användaren den genom den smalaste delen av vägen till dem. Ett videosamtal över fiber och samma samtal på ett överfullt tåg är olika produkter, eftersom latens (fördröjning), jitter (variation) och förlust formar vad användaren uppfattar.

När för mycket trafik träffar samma länkar byggs köer upp och paket tappas. Om varje sändare reagerar genom att skicka mer (eller återförsöka för aggressivt) kan nätet gå in i congestion collapse—mycket trafik, lite nyttig leverans.

Trängselkontroll är de beteenden som håller delningen rättvis och stabil: prova kapacitet, sakta ner när förlust/latens signalerar överbelastning och ök försiktigt igen. TCP populariserade denna "backa av, återhämta"‑rytm så nätet kunde förbli enkelt medan ändpunkter anpassar sig.

Eftersom nät är ofullkomliga gör framgångsrika applikationer tyst extra arbete:

Designa som om nätet kommer att falla ur gång, ofta och kort:

Resiliens är inte en tilläggsfunktion—det är priset för att operera i Internet‑skala.

TCP/IP lyckades eftersom det gjorde det enkelt för vilket nät som helst att koppla upp sig mot vilket annat som helst. Den dolda kostnaden med den öppenheten är att vem som helst också kan skicka dig trafik—bra eller dålig.

Tidiga internet‑designer antog en relativt liten, forskningsinriktad gemenskap. När nätet blev publikt möjliggjorde samma "vidarebefordra paket"‑filosofi spam, bedrägerier, malware‑leverans, DDoS‑attacker och förfalskning. IP verifierar inte vem du är. E‑post (SMTP) krävde ursprungligen inte bevis på att du ägde avsändaradressen. Routrar var aldrig tänkta att bedöma avsikt.

När Internet blev kritisk infrastruktur slutade säkerhet vara en möjlighet att lägga till i efterhand och blev ett krav i hur system byggs: identitet, konfidentialitet, integritet och tillgänglighet behövde explicita mekanismer. Nätet förblev mestadels best‑effort och neutralt, men applikationer och plattformar var tvungna att anta att länken var otillförlitlig.

Vi ”fixade” inte IP genom att låta det poliskontrollera varje paket. Istället är modern säkerhet lagerbyggd ovanpå den:

Behandla nätet som fientligt som standard. Använd minsta privilegium överallt: smala scopes, kortlivade autentiseringsuppgifter och starka standardinställningar. Verifiera identiteter och inputs vid varje gräns, kryptera i transit och designa för missbruksscenarier—inte bara för lyckliga vägar.

Internet ”vann” inte för att varje nät kom överens om samma hårdvara, leverantör eller perfekta funktionsuppsättning. Det bestod för att nyckelprotokollsval gjorde det lätt för oberoende system att koppla ihop, förbättra sig och fortsätta fungera även när delar fallerade.

Lager med tydliga sömmar. TCP/IP separerade "flytta paket" från "göra applikationer tillförlitliga." Den gränsen lät nätet förbli mångsidigt medan appar utvecklades snabbt.

Enkelhet i kärnan. Best‑effort‑leverans betydde att nätet inte behövde förstå varje applikations behov. Innovation hände i kanterna, där nya produkter kunde skickas utan att förhandla med en central auktoritet.

Interoperabilitet först. Öppna specifikationer och förutsägbart beteende gjorde det möjligt för olika organisationer att bygga kompatibla implementationer—och skapade en självförstärkande adoptionsspira.

Om du bygger en plattform, behandla sammankoppling som en funktion, inte en bieffekt. Föredra en liten uppsättning primitiv som många team kan komponera framför en stor mängd "smarta" funktioner som låser användare i en väg.

Designa för evolution: anta att klienter kommer vara gamla, servrar nya och att vissa beroenden delvis kan ligga nere. Din plattform bör degradera graciöst och fortfarande vara användbar.

Om du använder en snabbtbyggande miljö som Koder.ai visar sig samma principer i produktkapabiliteter: ett tydligt planeringssteg (så gränssnitt blir explicita), säker iteration med snapshots/rollback och förutsägbart deployments‑/hostingbeteende som låter flera team röra sig snabbt utan att bryta konsumenter.

Ett protokoll är en gemensam uppsättning regler för hur system formaterar meddelanden, startar och avslutar utbyten, hanterar saknad data och identifierar mottagare. Plattformar förlitar sig på protokoll eftersom de gör interoperabilitet förutsägbar, så oberoende team och leverantörer kan integrera utan skräddarsydda, enstaka överenskommelser.

Internetworking handlar om att koppla ihop flera oberoende nät så att paket kan färdas över dem som en enda end‑to‑end‑resa. Den viktiga frågan var att göra detta utan att tvinga något nät att skriva om sina interna lösningar, vilket är anledningen till att ett gemensamt lager (IP) blev så viktigt.

Paketväxling delar upp data i paket som delar nätlänkar med annan trafik—det är effektivt för den ryckiga trafik som datorer genererar. Kretskoppling reserverar en dedikerad bana slut‑till‑slut, vilket kan vara slösaktigt när trafiken är intermittent (som för de flesta webb-/app‑flöden).

IP hanterar adressering och routing (att flytta paket hop‑för‑hop). TCP ligger ovanpå IP och erbjuder tillförlitlighet när det behövs (ordning, retransmission, flödes-/anslutningskontroll). Denna separation låter nätet förbli allmänt syftande medan applikationer väljer vilka leveransgarantier de behöver.

“Best‑effort” betyder att IP försöker leverera paket men garanterar inte att de kommer fram, kommer i ordning eller kommer i tid. Denna enkelhet sänkte tröskeln för att gå med i nätverket (inga strikta garantier krävdes överallt), vilket påskyndade adoptionen och gjorde global uppkoppling möjlig även över ofullkomliga länkar.

Idén är att nätets kärna ska göra så lite som möjligt, och att ändpunkter/applikationer ska implementera “klokheten” (tillförlitlighet, säkerhet, återhämtning) vid behov. Vinsten är snabbare innovation vid kanterna; kostnaden är att appar måste hantera fel, överbelastning och variabilitet uttryckligen.

Adresser identifierar destinationer; routing bestämmer nästa hopp mot dessa destinationer. Hierarkisk adressering möjliggör aggregering av rutter, vilket håller routingtabeller hanterbara i global skala. Dålig aggregering ökar driftkomplexiteten och kan belasta routingsystemet.

DNS mappar människovänliga namn (som api.example.com) till IP‑adresser och kan ändra dessa mappningar utan att klienter behöver ändras. Plattformar använder DNS för trafikstyrning, multi‑region‑distribution och failover—namnet förblir stabilt medan infrastrukturen underliggande kan ändras.

RFC‑serien publicerade protokollbeteenden öppet så att vem som helst kunde implementera och testa kompatibilitet. Denna öppenhet minskar leverantörslåsning, ökar multi‑leverantörsinteroperabilitet och skapar nätverkseffekter: varje ytterligare kompatibel implementation ökar värdet för hela ekosystemet.

Bygg som om nätet kommer att vara opålitligt:

Se även: Versionering och bakåtkompatibilitet samt Mönster för graciös degradering.