17 thg 6, 2025·8 phút

AI Thay Thế Điều Gì Trong Công Việc Lập Trình (và Điều Gì Không)

Phân tích thực tế về công việc lập trình viên mà AI có thể thay thế, nơi nó hỗ trợ con người, và những nhiệm vụ vẫn cần con người chịu trách nhiệm trong đội hình thực tế.

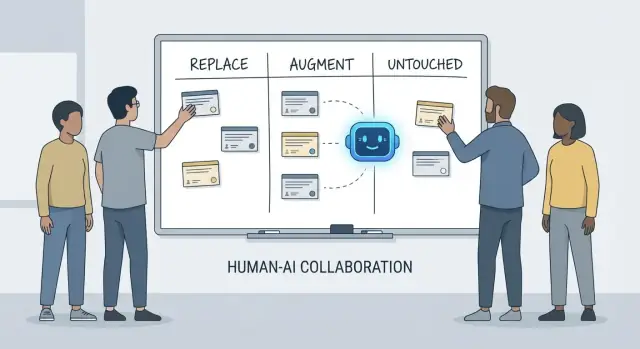

Thay thế, Hỗ trợ, Không Chạm: Một Khung Đơn Giản

Các cuộc tranh luận về “AI sẽ làm gì với lập trình viên” nhanh chóng rối vì ta thường nhầm lẫn công cụ với trách nhiệm. Một công cụ có thể sinh mã, tóm tắt ticket, hay gợi ý test. Một trách nhiệm là những gì đội vẫn phải chịu trách nhiệm khi gợi ý đó sai.

Bài viết này dùng một khung đơn giản—replace, augment, untouched—để mô tả công việc hàng ngày trong các đội thực sự có deadline, code cũ, sự cố production, và các bên liên quan mong đợi kết quả đáng tin cậy.

"Replace" nghĩa là gì (và không nghĩa là gì)

Replace nghĩa là AI có thể hoàn thành nhiệm vụ đầu-cuối hầu hết thời gian với các ràng buộc rõ ràng, và vai trò con người chuyển sang giám sát và kiểm tra chỗ.

Ví dụ thường là công việc có giới hạn: sinh boilerplate, dịch mã giữa ngôn ngữ, soạn các test lặp đi lặp lại, hoặc tạo tài liệu lần đầu.

Replace không có nghĩa là “không có trách nhiệm con người.” Nếu đầu ra làm vỡ production, rò rỉ dữ liệu, hoặc vi phạm tiêu chuẩn, thì đội vẫn chịu trách nhiệm.

"Augment" nghĩa là gì

Augment nghĩa là AI làm cho lập trình viên nhanh hơn hoặc kỹ lưỡng hơn, nhưng nó không hoàn thành công việc một cách đáng tin cậy mà không có phán đoán của con người.

Đây là trường hợp phổ biến trong kỹ thuật chuyên nghiệp: bạn sẽ nhận được bản nháp hữu ích, phương án thay thế, giải thích nhanh, hoặc danh sách các lỗi có khả năng xảy ra—nhưng lập trình viên vẫn quyết định điều gì đúng, an toàn và phù hợp với sản phẩm.

Những gì vẫn "untouched"

Untouched nghĩa là trách nhiệm cốt lõi vẫn do con người lãnh đạo vì nó đòi hỏi ngữ cảnh, đánh đổi và trách nhiệm mà không thể nén vào prompt.

Ví dụ: thương lượng yêu cầu, chọn ràng buộc cấp hệ thống, xử lý sự cố, đặt tiêu chuẩn chất lượng, và đưa ra quyết định khi không có “đáp án đúng” duy nhất.

Tại sao trách nhiệm là đơn vị phân tích

Công cụ thay đổi nhanh. Trách nhiệm thay đổi chậm.

Vì vậy thay vì hỏi “AI có viết được mã này không?”, hãy hỏi “Ai chịu trách nhiệm kết quả?” Cách đặt câu này giữ kỳ vọng gắn với độ chính xác, độ tin cậy và trách nhiệm—những thứ quan trọng hơn các demo ấn tượng.

Ý chúng tôi về "Trách nhiệm của Lập trình viên"

Khi người ta hỏi AI “thay thế” gì trong phát triển, họ thường nói về nhiệm vụ: viết hàm, sinh test, soạn docs. Tuy nhiên đội không phát hành nhiệm vụ—họ phát hành kết quả. Đó là nơi trách nhiệm của lập trình viên có ý nghĩa.

Gói trách nhiệm thường gặp

Công việc lập trình viên thường trải rộng hơn thời gian viết mã:

- Giao hàng: biến ý tưởng mơ hồ thành phần mềm chạy được và phát hành đúng hạn.

- Chất lượng: đúng, dễ bảo trì, và ngăn ngừa hồi quy.

- Bảo mật & quyền riêng tư: mặc định an toàn, xử lý dữ liệu, và nhận biết mối đe doạ.

- Vận hành: giữ dịch vụ hoạt động, hiểu chế độ lỗi và phản ứng sự cố.

- Giao tiếp: đồng bộ với product, design, support và các kỹ sư khác.

Những trách nhiệm này nằm xuyên suốt vòng đời—từ “chúng ta nên xây gì?” đến “nó có an toàn không?” đến “3 giờ sáng nếu nó hỏng thì sao?”.

Tại sao không chỉ là checklist

Mỗi trách nhiệm thực ra là nhiều quyết định nhỏ: các trường hợp biên nào quan trọng, metric nào cho thấy hệ khỏe, khi nào cắt scope, sửa này có an toàn để ship không, cách giải thích trade-off với các bên liên quan. AI có thể giúp thực thi phần việc (soạn mã, đề xuất test, tóm tắt log), nhưng trách nhiệm là sở hữu kết quả.

Nơi bàn giao thất bại

Sự đứt gãy thường xảy ra ở ranh giới bàn giao:

- “QA sẽ phát hiện” (nhưng không ai định nghĩa chất lượng là gì).\n- “Security sẽ review” (nhưng thiết kế đã khoá các lựa chọn rủi ro).\n- “Ops sẽ xử lý” (nhưng dịch vụ không được xây để dễ vận hành).

Khi ownership không rõ, công việc rơi vào các khoảng trống.

Quyền quyết định: ai quyết định vs ai thực thi

Một cách hữu ích để nói về trách nhiệm là quyền quyết định:

- Ai quyết định yêu cầu, trade-off, và rủi ro chấp nhận được?\n- Ai thực thi triển khai và xác minh?\n AI có thể tăng tốc thực thi. Quyền quyết định—và trách nhiệm cho kết quả—vẫn cần một tên con người kèm theo.

Công việc AI thường có thể thay thế (có ràng buộc)

Trợ lý lập trình AI thực sự hữu ích khi công việc dự đoán được, rủi ro thấp và dễ kiểm chứng. Hãy coi chúng như đồng đội junior nhanh: giỏi tạo bản nháp đầu tiên, nhưng vẫn cần hướng dẫn rõ và kiểm tra cẩn thận.

Trên thực tế, một số đội ngày càng dùng nền tảng “vibe-coding” (như Koder.ai) để tăng tốc các đoạn có thể thay thế: sinh scaffold, nối CRUD flow, và tạo nháp UI/backend từ chat. Chìa khoá vẫn là: ràng buộc, review và ownership rõ ràng.

Boilerplate rủi ro thấp

Nhiều thời gian của lập trình viên đi vào khởi tạo dự án và kết nối các phần. AI thường có thể sinh:

- file và thư mục khởi đầu (controller, route, DTO)\n- “glue code” lặp đi lặp lại giữa các lớp\n- endpoint CRUD đơn giản theo pattern đã được thiết lập

Ràng buộc ở đây là tính nhất quán: đảm bảo nó khớp convention hiện có và không phát minh pattern hay dependency mới.

Refactor và migration cơ học

Khi thay đổi chủ yếu cơ học—đổi tên symbol xuyên codebase, định dạng lại, hoặc cập nhật cách dùng API đơn giản—AI có thể tăng tốc công việc lặp.\n Dù vậy, hãy coi nó như sửa hàng loạt: chạy toàn bộ test suite, quét diff để tìm thay đổi hành vi không mong muốn, và tránh để nó “cải tiến” vượt quá phạm vi refactor yêu cầu.

Bản nháp tài liệu (cần review)

AI có thể soạn README, comment inline và mục changelog dựa trên code và commit. Điều này giúp rõ ràng nhanh, nhưng cũng có thể tạo ra những tuyên bố nghe có vẻ chắc chắn nhưng không đúng.\n Thực hành tốt: dùng AI cho cấu trúc và chỉnh câu, rồi xác minh mọi khẳng định—đặc biệt bước cài đặt, mặc định cấu hình và các trường hợp biên.

Sinh test cơ bản như điểm khởi đầu

Với các hàm tinh khiết được xác định rõ, unit test do AI sinh có thể cung cấp độ phủ ban đầu và nhắc bạn về các trường hợp biên. Ràng buộc là ownership: bạn vẫn chọn gì quan trọng, thêm assertion phản ánh yêu cầu thực tế, và đảm bảo test thất bại vì đúng lý do.

Tóm tắt thread và log

Khi có thread Slack dài, ticket hay log sự cố, AI có thể chuyển thành ghi chú ngắn gọn và action item. Giữ nó thực tế bằng cách cung cấp đầy đủ ngữ cảnh rồi xác minh các sự kiện, timestamp và quyết định trước khi chia sẻ.

Công việc AI chủ yếu hỗ trợ: nhanh hơn, nhưng chưa hoàn tất

Trợ lý lập trình AI mạnh nhất khi bạn đã biết mình muốn gì và cần giúp triển khai nhanh. Chúng giảm thời gian “gõ tay” và nổi bật bối cảnh hữu ích, nhưng không loại bỏ nhu cầu sở hữu, xác minh và phán đoán.

Tăng tốc triển khai (bản nháp mạnh)

Với spec rõ—inputs, outputs, các trường hợp biên và ràng buộc—AI có thể phác thảo triển khai khởi đầu: boilerplate, map dữ liệu, handler API, migration, hoặc refactor đơn giản. Lợi ích là đà: có thứ chạy được nhanh.\n Nhưng code lần đầu thường thiếu yêu cầu tinh vi (ngữ nghĩa lỗi, giới hạn hiệu năng, tương thích ngược). Hãy coi nó như bản nháp của thực tập sinh: hữu ích nhưng không phải quyền uy.

Đề xuất phương án—những trade-off bạn phải kiểm chứng

Khi chọn giữa các cách (vd. caching vs batching, optimistic vs pessimistic locking), AI có thể đưa ra phương án và liệt kê trade-off. Điều đó hữu ích cho brainstorming, nhưng bạn phải kiểm chứng trade-off theo thực tế hệ thống: hình dạng traffic, nhu cầu nhất quán dữ liệu, ràng buộc vận hành và convention của đội.

Hiểu mã và điều hướng codebase

AI cũng mạnh ở việc giải thích code lạ, chỉ ra pattern, và dịch “cái này làm gì?” sang ngôn ngữ dễ hiểu. Kết hợp với công cụ tìm kiếm, nó giúp trả lời “X được dùng ở đâu?” và tạo danh sách các call site, config và test cần xem lại.

Ergonomics cho lập trình viên: vòng phản hồi tốt hơn

Mong chờ cải thiện thực tế: thông báo lỗi rõ hơn, ví dụ nhỏ, và snippet ready-to-paste. Những thứ này giảm ma sát, nhưng không thay thế review cẩn thận, chạy local và test mục tiêu—đặc biệt với thay đổi ảnh hưởng người dùng hoặc production.

Hiểu sản phẩm và yêu cầu: Vẫn do con người lãnh đạo

AI giúp viết và tinh chỉnh yêu cầu, nhưng không thể đáng tin cậy quyết định ta nên xây gì hay tại sao lại quan trọng. Hiểu sản phẩm bắt nguồn từ ngữ cảnh: mục tiêu kinh doanh, nỗi đau người dùng, ràng buộc tổ chức, các trường hợp biên, và chi phí nếu sai. Những input đó sống trong cuộc trò chuyện, lịch sử và trách nhiệm—những thứ mô hình có thể tóm tắt nhưng không thể sở hữu.

Biến mục tiêu mơ hồ thành thứ có thể xây

Yêu cầu ban đầu thường như “làm onboarding mượt hơn” hoặc “giảm ticket support”. Công việc của dev là chuyển thành yêu cầu rõ ràng và tiêu chí chấp nhận.\n Việc chuyển này chủ yếu do con người bởi vì cần đặt câu hỏi và phán đoán:\n

- Tối ưu cho phân khúc người dùng nào, và hành vi nào nên thay đổi?\n- Hoàn thành nghĩa là gì, và đo bằng gì?\n- Ràng buộc nào là bất khả thi (quyền riêng tư, hiệu năng, deadline)?\n AI có thể gợi ý metric hoặc soạn tiêu chí, nhưng nó không biết ràng buộc thật sự trừ khi ai đó cung cấp—và nó sẽ không phản bác khi yêu cầu tự mâu thuẫn.

Trade-off và quản lý kỳ vọng

Công việc yêu cầu là nơi các trade-off khó chịu xuất hiện: thời gian vs chất lượng, nhanh vs bảo trì, tính năng mới vs ổn định. Đội cần người để làm rõ rủi ro, đề xuất lựa chọn, và đồng bộ các bên liên quan về hậu quả.\n Một spec tốt không chỉ là văn bản; nó là bản ghi quyết định. Nó nên có thể kiểm thử và triển khai, với định nghĩa rõ (inputs, outputs, các trường hợp biên và chế độ lỗi). AI giúp cấu trúc tài liệu, nhưng trách nhiệm về độ chính xác—và nói “mục này mơ hồ, cần quyết định”—vẫn thuộc về con người.

Thiết kế hệ thống và quyết định kiến trúc

Bắt Đầu từ Chế Độ Lập Kế Hoạch

Dùng Chế Độ Lập Kế Hoạch để làm rõ yêu cầu và quyền quyết định trước khi sinh mã.

Thiết kế hệ thống là nơi “nên xây gì?” chuyển thành “nên xây trên nền tảng nào, và nó sẽ hành xử ra sao khi có lỗi?”. AI giúp khám phá phương án, nhưng không thể chịu trách nhiệm hậu quả.

Chọn kiến trúc phù hợp với thực tế

Chọn monolith, modular monolith, microservices, serverless hay nền tảng quản lý không phải bài trắc nghiệm có một đáp án đúng. Là bài toán “phù hợp”: quy mô kỳ vọng, ngân sách, thời gian ra thị trường, và kỹ năng đội.\n Trợ lý có thể tóm tắt pattern và gợi ý kiến trúc tham khảo, nhưng nó không biết đội bạn trực on-call hàng tuần, tuyển chậm, hay hợp đồng DB gia hạn quý tới—những chi tiết thường quyết định kiến trúc có thành công hay không.

Làm rõ trade-off

Kiến trúc tốt chủ yếu là trade-off: đơn giản vs linh hoạt, hiệu năng vs chi phí, nhanh hôm nay vs bảo trì sau này. AI có thể nhanh chóng tạo bảng pros/cons, hữu ích—đặc biệt để ghi nhận quyết định.\n Nhưng nó không thể ưu tiên khi trade-off làm tổn hại. Ví dụ, “chấp nhận phản hồi chậm hơn để giữ hệ đơn giản và dễ vận hành” là lựa chọn kinh doanh chứ không thuần kỹ thuật.

Ranh giới, quyền sở hữu dữ liệu và chế độ lỗi

Xác định ranh giới service, ai sở hữu dữ liệu, và điều gì xảy ra khi chỉ một phần hệ thống lỗi đòi hỏi bối cảnh sản phẩm và vận hành sâu. AI giúp brainstorm failure mode (“nếu nhà cung cấp thanh toán sập thì sao?”), nhưng con người vẫn phải quyết định hành vi mong muốn, thông điệp tới khách hàng, và kế hoạch rollback.

API mà người dùng vẫn muốn dùng

Thiết kế API là thiết kế hợp đồng. AI giúp sinh ví dụ và phát hiện mâu thuẫn, nhưng bạn phải quyết định versioning, tương thích ngược, và cam kết hỗ trợ lâu dài.

Quyết định không xây (hoặc xoá)

Một quyết định kiến trúc quan trọng là nói “không”—hoặc xóa tính năng. AI không đo chi phí cơ hội hay rủi ro chính trị. Đội phải làm việc đó.

Debugging và phân tích nguyên nhân gốc rễ trong thực tế

Debugging thường là nơi AI trông ấn tượng—và cũng là nơi nó có thể lặng lẽ lãng phí thời gian nhất. Trợ lý có thể quét log, chỉ ra đường dẫn mã đáng ngờ, hoặc gợi một bản sửa “có vẻ đúng”. Nhưng phân tích nguyên nhân gốc rễ không chỉ là sinh lời giải; là chứng minh một lời giải.

AI gợi ý; bạn xác nhận nguyên nhân

Hãy coi output của AI như giả thuyết, không phải kết luận. Nhiều bug có nhiều nguyên nhân khả dĩ, và AI thường chọn câu chuyện gọn gàng khớp với đoạn mã bạn dán, không phải thực tế hệ chạy.\n Một quy trình thực dụng:\n

- Yêu cầu AI liệt kê nguyên nhân khả dĩ và bằng chứng để phân biệt chúng.\n- Tái hiện lỗi và thu thập bằng chứng đó.\n- Chỉ khi đó chấp nhận sửa (và xác minh nó thực sự loại bỏ điều kiện lỗi).

Tái hiện và thu thập bằng chứng vẫn do con người dẫn dắt

Tái hiện đáng tin là siêu năng lực debug vì nó biến bí ẩn thành test. AI giúp viết repro tối giản, script chẩn đoán, hoặc gợi ý logging thêm, nhưng bạn quyết định tín hiệu nào quan trọng: request ID, timing, khác biệt môi trường, feature flag, dạng dữ liệu hay cạnh tranh.\n Khi người dùng báo triệu chứng (“app bị đứng”), bạn vẫn phải dịch thành hành vi hệ thống: endpoint nào chậm, timeout nào bật, metric nào thay đổi. Điều đó cần ngữ cảnh: cách dùng sản phẩm và thế nào là “bình thường”.

Tránh các giải thích “có vẻ hợp lý nhưng sai”

Nếu gợi ý không thể kiểm chứng, giả sử nó sai cho đến khi có bằng chứng. Ưu tiên giải thích có dự đoán có thể kiểm tra (ví dụ: “chỉ xảy ra với payload lớn” hoặc “chỉ sau khi cache warm-up”).

Vá, revert hay redesign?

Ngay cả sau khi tìm ra nguyên nhân, quyết định khó vẫn còn. AI có thể phác thảo trade-off, nhưng con người chọn phản ứng:\n

- Vá nhanh để ngăn chảy máu.\n- Revert để khôi phục hành vi biết chắc.\n- Thiết kế lại nếu lỗi chỉ ra sai lệch sâu (hiệu năng, mô hình dữ liệu, hay giả định).

Phân tích gốc rễ cuối cùng là trách nhiệm: sở hữu lời giải, bản vá, và niềm tin rằng nó sẽ không quay lại.

Code Review: Phán đoán và tiêu chuẩn không tự động hóa được

Thực Hành Vibe Coding An Toàn

Thực hiện một thay đổi nhỏ, có thể kiểm tra và dùng AI cho bản nháp chứ không cho quyết định cuối.

Code review không chỉ là checklist cho style. Là khoảnh khắc đội quyết định điều gì họ sẵn sàng duy trì, hỗ trợ và chịu trách nhiệm. AI giúp bạn thấy nhiều hơn, nhưng không thể quyết định điều gì quan trọng, phù hợp ý định sản phẩm hay các trade-off đội chấp nhận.

AI tốt ở điểm nào trong review

Trợ lý có thể là cặp mắt thứ hai vô hạn. Nó nhanh chóng:\n

- Đánh dấu bug có khả năng, pattern đáng ngờ, thiếu null check, hoặc xử lý chuỗi không an toàn.\n- Gợi ý đặt tên rõ ràng hơn, refactor hoặc luồng điều khiển đơn giản hơn.\n- Chỉ ra format không nhất quán hoặc trùng lặp rõ ràng.\n- Sinh câu hỏi review (“Nếu API này trả về danh sách rỗng thì sao?”).

Dùng như vậy, AI rút ngắn thời gian từ “mở PR” đến “phát hiện rủi ro”.

Cái gì vẫn cần phán đoán con người

Review đúng không chỉ là code còn compile. Con người nối thay đổi với hành vi người dùng thực, ràng buộc production và bảo trì dài hạn.\n Reviewer vẫn phải quyết định:\n

- Cái gì được phát hành: AI liệt kê vấn đề, nhưng không thể chọn vấn đề nào chặn phát hành.\n- Độ đọc hiểu và duy trì: "Về mặt kỹ thuật đúng" vẫn có thể khó hiểu, giòn hoặc khó mở rộng.\n- Các trường hợp biên và khoảng trống môi trường: Nhiều lỗi là “chạy được trên máy tôi”—config, dữ liệu, cạnh tranh, thời điểm deploy. AI không suy ra runtime của bạn.\n- Tiêu chuẩn và ý định: Chỉ đội biết convention, độ chịu rủi ro, và mục tiêu sản phẩm. Một thay đổi có thể là code sạch nhưng hành vi sai.

Quy trình thực tế: AI như đồng-reviewer

Hãy coi AI là reviewer thứ hai, không phải phê duyệt cuối cùng. Yêu cầu nó làm lượt có mục tiêu (kiểm tra bảo mật, các trường hợp biên, tương thích ngược), rồi con người quyết định phạm vi, ưu tiên, và xem thay đổi có phù hợp tiêu chuẩn đội và ý định sản phẩm hay không.

Chiến lược test và sở hữu chất lượng

AI có thể sinh test nhanh, nhưng nó không sở hữu chất lượng. Test suite là tập cược về gì có thể hỏng, gì không được phép hỏng, và những gì bạn chấp nhận phát hành mà không chứng minh mọi trường hợp biên. Những cược đó là quyết định sản phẩm và kỹ thuật—vẫn do con người đưa ra.

AI sinh test; con người đặt mục tiêu

Trợ lý giỏi ở scaffolding unit test, mocking dependency, và che phủ “happy path” từ hiện thực. Điều nó không làm tốt là quyết định coverage nào quan trọng.\n Con người quyết định:\n

- Module nào cần độ phủ sâu vì an toàn hay thay đổi thường xuyên.\n- "Hoàn thành" nghĩa là gì cho refactor rủi ro cao vs bug nhỏ.\n- Khi nào đầu tư vào regression test vs monitoring và kế hoạch rollback.

Chọn hỗn hợp test phù hợp

Hầu hết đội cần chiến lược nhiều lớp, không phải “nhiều test hơn”. AI giúp viết nhiều trong số này, nhưng lựa chọn và ranh giới do con người lãnh đạo:\n

- Unit tests cho luật nghiệp vụ và các trường hợp biên khó.\n- Integration tests cho tương tác DB/queue/service.\n- End-to-end tests cho hành trình người dùng quan trọng (ít, ổn định, giá trị cao).\n- Contract tests để giữ API tương thích giữa đội/dịch vụ.\n- Performance tests để bảo vệ độ trễ và chi phí dưới tải.

Tránh flaky test và tự tin giả tạo

Test do AI sinh thường lặp lại cấu trúc code, tạo assertion giòn hoặc mock quá tay khiến test pass ngay cả khi hành vi thực thất bại. Devs ngăn điều này bằng cách:\n

- Test hành vi quan sát được, không phải chi tiết nội bộ.\n- Giữ dữ liệu xác định và kiểm soát thời gian, randomness, và cuộc gọi mạng.\n- Review thất bại để quyết định: bug thật, test bug hay vấn đề môi trường.

Đồng bộ chiến lược với rủi ro và nhịp phát hành

Chiến lược tốt khớp với cách bạn phát hành. Phát hành nhanh cần kiểm tra tự động mạnh hơn và đường lui rõ ràng; phát hành chậm có thể chấp nhận kiểm tra nặng hơn trước merge. Chủ sở hữu chất lượng là đội, không phải công cụ.

Đo lường kết quả quan trọng

Chất lượng không phải phần trăm coverage. Theo dõi xem test có cải thiện kết quả không: ít sự cố production hơn, khôi phục nhanh hơn, và thay đổi an toàn hơn (ít revert, deploy tự tin). AI tăng tốc công việc, nhưng trách nhiệm vẫn ở lập trình viên.

Bảo mật, Quyền riêng tư và Tuân thủ

Công việc bảo mật ít liên quan đến sinh mã hơn là đưa ra các đánh đổi trong ràng buộc thực tế. AI giúp nêu checklist và lỗi phổ biến, nhưng quyết định rủi ro thuộc về đội.

Threat modeling cần ngữ cảnh

Threat modeling không phải bài generic—cái gì quan trọng phụ thuộc vào ưu tiên kinh doanh, người dùng và chế độ lỗi. Trợ lý gợi ý mối đe doạ điển hình (injection, broken auth, mặc định không an toàn), nhưng nó không biết tài sản nào thực sự có giá trị cho sản phẩm của bạn: chiếm đoạt tài khoản vs rò rỉ dữ liệu vs gián đoạn dịch vụ, hay tài sản nào pháp lý nhạy cảm.

Rủi ro cụ thể app không giống pattern

AI giỏi nhận anti-patterns đã biết, nhưng nhiều sự cố phát sinh từ chi tiết cụ thể app: edge case quyền, endpoint admin “tạm thời”, hoặc workflow vô tình bỏ qua phê duyệt. Những rủi ro đó cần đọc ý định hệ thống, không chỉ code.

Bí mật, quyền hạn và lưu giữ là lựa chọn có chủ đích

Công cụ nhắc bạn không hardcode key, nhưng không làm chủ chính sách đầy đủ:\n

- Bí mật nằm đâu (vault, CI, runtime) và cách xoay vòng.\n- Quy tắc least-privilege và rà soát quyền truy cập.\n- Lưu giữ dữ liệu: lưu gì, bao lâu, ai có thể xuất.

Rủi ro phụ thuộc và chuỗi cung ứng

AI có thể báo flag thư viện cũ, nhưng đội vẫn cần thực hành: khoá phiên bản, xác minh nguồn gốc, review dependency transitive, và quyết định khi nào chấp nhận rủi ro vs đầu tư sửa chữa.

Tuân thủ và kiểm toán cần bằng chứng

Tuân thủ không chỉ là “thêm mã hóa.” Là kiểm soát, tài liệu và trách nhiệm: log truy cập, luồng phê duyệt, quy trình sự cố, và bằng chứng bạn đã làm theo. AI soạn template, nhưng con người phải xác thực bằng chứng và ký xác nhận—vì đó là thứ auditor (và khách hàng) dựa vào.

Vận hành, Độ tin cậy và Ứng phó sự cố

Làm Cho Rủi Ro Dễ Hoàn Tác

Dùng snapshot và rollback để giữ thay đổi nhỏ, có thể đảo ngược và dễ review.

AI làm ops nhanh hơn, nhưng không thay ownership. Độ tin cậy là chuỗi quyết định trong bất định, và chi phí một quyết định sai thường cao hơn chi phí chậm.

Nơi AI hỗ trợ hàng ngày

AI hữu ích cho soạn và duy trì artifacts vận hành—runbook, checklist, playbook “nếu X thì thử Y”. Nó cũng tóm tắt log, nhóm alert tương tự, và đề xuất giả thuyết ban đầu.\n Với độ tin cậy, điều này dịch thành lặp nhanh hơn trên:\n

- dashboard monitoring và mô tả cảnh báo\n- ghi chú dung lượng và heuristics scale\n- template báo cáo error budget

Đây là những gia tốc tuyệt vời, nhưng không phải là công việc chính.

Những phần vẫn do con người giữ

Sự cố hiếm khi theo kịch bản. Kỹ sư on-call xử lý tín hiệu không rõ, lỗi từng phần, và các đánh đổi lộn xộn khi đồng hồ đang chạy. AI gợi ý nguyên nhân khả dĩ, nhưng không thể quyết định gọi team khác, tắt tính năng, hay chấp nhận ảnh hưởng khách hàng ngắn hạn để giữ toàn vẹn dữ liệu.\n An toàn khi triển khai là trách nhiệm con người. Công cụ gợi ý rollback, feature flag hay staged release, nhưng đội vẫn chọn con đường an toàn nhất dựa trên bối cảnh kinh doanh và blast radius.

Postmortem: mục tiêu là học hỏi

AI soạn timeline và kéo các sự kiện chính từ chat, ticket và monitoring. Con người vẫn làm phần quan trọng: quyết định “tốt” là gì, ưu tiên sửa, và thay đổi ngăn sự lặp lại (không chỉ triệu chứng).\n Nếu bạn coi AI như đồng-pilot cho giấy tờ ops và tìm pattern—không phải chỉ huy sự cố—bạn sẽ có tốc độ mà không đánh mất trách nhiệm.

Giao tiếp đội, mentoring và quyền sở hữu

AI có thể giải thích khái niệm rõ ràng theo yêu cầu: “CQRS là gì?”, “Tại sao deadlock xảy ra?”, “Tóm tắt PR này.” Điều đó giúp đội chạy nhanh hơn. Nhưng giao tiếp tại nơi làm việc không chỉ truyền thông tin—là xây dựng tin tưởng, thói quen chung, và đưa ra cam kết để người khác dựa vào.

Onboarding: hơn cả tài liệu

Dev mới không chỉ cần câu trả lời; họ cần ngữ cảnh và mối quan hệ. AI tóm tắt module, gợi ý lộ trình đọc và dịch biệt ngữ. Con người vẫn dạy cái quan trọng ở đây: trade-off đội ưu tiên, chuẩn “tốt” trong codebase, và ai nói chuyện khi thấy điều gì sai.

Đồng bộ giữa vai trò

Hầu hết friction dự án xuất hiện giữa vai trò: product, design, QA, security, support. AI soạn biên bản họp, đề xuất tiêu chí chấp nhận, hoặc diễn đạt feedback trung tính hơn. Con người vẫn phải đàm phán ưu tiên, giải quyết mơ hồ, và nhận ra khi một bên “đồng ý” nhưng thực sự không đồng ý.

Định nghĩa hoàn thành và ranh giới sở hữu

Đội thất bại khi trách nhiệm mơ hồ. AI sinh checklist, nhưng không thể cưỡng chế trách nhiệm. Con người phải định nghĩa “done” (test? docs? rollout plan? monitoring?), và ai sở hữu gì sau merge—đặc biệt khi mã do AI sinh che khuất độ phức tạp.

Checklist: AI có trách nhiệm trong quy trình đội

- Thông báo khi dùng AI nếu ảnh hưởng đến quyết định, ước lượng hoặc mã do bạn tạo.\n- Xác minh sự thật: link, API, khẳng định bảo mật và “best practices” trước khi chia sẻ.\n- Giữ prompt không chứa bí mật (key, dữ liệu khách, chi tiết sự cố).\n- Xử lý output của AI như bản nháp; gán một chủ sở hữu con người cho mọi quyết định.\n- Ghi lại quy ước đội: khi nào được dùng AI, khi nào không, và rà soát kỳ vọng.\n- Ưu tiên thay đổi nhỏ, có thể review—tránh refactor lớn bằng AI một lần.

Câu hỏi thường gặp

Khung “replace / augment / untouched” thực tế nghĩa là gì?

Nó phân tách các nhiệm vụ (những việc công cụ có thể giúp thực thi) khỏi trách nhiệm (kết quả mà đội bạn phải chịu trách nhiệm).

- Replace: AI có thể hoàn thành nhiệm vụ đầu-cuối hầu hết thời gian nếu có ràng buộc; con người giám sát.

- Augment: AI tăng tốc cho bạn, nhưng bạn vẫn quyết định điều gì là đúng và an toàn.

- Untouched: Trách nhiệm vẫn thuộc về con người vì phụ thuộc vào ngữ cảnh, đánh đổi và trách nhiệm.

Tại sao lại tập trung vào trách nhiệm thay vì nhiệm vụ?

Bởi vì đội không giao thứ gọi là “nhiệm vụ” ra thị trường—họ giao kết quả.

Ngay cả khi trợ lý soạn mã hay test, đội của bạn vẫn chịu trách nhiệm về:

- độ đúng và các hồi quy

- bảo mật và quyền riêng tư

- khả năng vận hành và ảnh hưởng khi có sự cố

- đáp ứng yêu cầu thực tế (không chỉ prompt)

Những công việc lập trình nào AI thường có thể thay thế an toàn?

"Replace" nghĩa là công việc giới hạn, có thể kiểm chứng, rủi ro thấp—nơi lỗi dễ phát hiện.

Ứng viên tốt bao gồm:

- mã boilerplate và glue code theo pattern đã có

- refactor cơ học (đổi tên, di cư API đơn giản)

- bản nháp tài liệu hoặc changelog (cần review)

- unit test khởi đầu cho hàm tinh khiết, được xác định rõ

Những rào cản nào làm cho “replace” hoạt động đáng tin trên đội thực?

Dùng các ràng buộc để làm lỗi hiển nhiên và rẻ để sửa:

- giới hạn yêu cầu: phạm vi chính xác, file, convention, dependency

- yêu cầu test và chạy chúng (kèm lint/kiểm tra kiểu)

- review diff như một sửa đổi hàng loạt—chú ý các “cải tiến thừa”

- xác minh bất cứ phát ngôn thực tế trong docs (các bước cài đặt, mặc định, các trường hợp biên)

- giữ thay đổi nhỏ và có thể đảo ngược

Tại sao AI thường là “augment” hơn là “replace” trong công việc kỹ thuật chuyên nghiệp?

Bởi vì công việc chuyên nghiệp thường chứa các ràng buộc ẩn mà mô hình không suy ra được đáng tin cậy:

- kỳ vọng tương thích ngược

- ngân sách hiệu năng và độ trễ

- thực tế vận hành (triển khai, on-call, feature flags)

- ý định sản phẩm và ngữ nghĩa các trường hợp biên

Hãy coi output của AI như một bản nháp bạn sửa cho phù hợp hệ thống của mình, không phải giải pháp chính thức.

Tôi nên dùng AI để debug thế nào để không bị đánh lừa?

Dùng nó để sinh giả thuyết và kế hoạch bằng chứng, không phải kết luận.

Vòng lặp thực dụng:

- yêu cầu AI liệt kê các nguyên nhân khả dĩ và chứng cứ để phân biệt chúng

- tái hiện lỗi và thu thập chứng cứ đó (log, trace, config, dạng dữ liệu)

- chỉ chấp nhận sửa khi nó thay đổi điều kiện lỗi quan sát được và ngăn không cho lỗi quay lại

Nếu không thể xác minh gợi ý, giả sử nó sai cho đến khi chứng minh được.

AI đóng vai trò gì trong code review?

AI giúp bạn nhìn thấy nhiều vấn đề hơn nhanh chóng, nhưng con người quyết định điều gì chấp nhận được để phát hành.

Một số prompt review hữu ích:

- “Liệt kê các trường hợp biên và chế độ lỗi có thể.”

- “Kiểm tra rủi ro bảo mật/quyền riêng tư và mặc định không an toàn.”

- “Chỉ ra lo ngại về tương thích ngược.”

Rồi hãy thực hiện một lượt review bằng con người về ý định, khả năng bảo trì và rủi ro phát hành (cái nào là chặn phát hành vs theo dõi sau).

AI có thể thay thế việc kiểm thử và chịu trách nhiệm chất lượng không?

AI có thể soạn rất nhiều test, nhưng không thể chọn ra coverage thực sự quan trọng.

Hãy để con người chịu trách nhiệm cho:

- quyết định phối hợp test (unit/integration/e2e/contract/performance)

- ngăn flaky tests (kiểm soát thời gian, randomness, mạng)

- test hành vi thay vì chi tiết cài đặt

- điều chỉnh nỗ lực theo rủi ro và nhịp phát hành

Dùng AI cho scaffolding và gợi ý các trường hợp biên, không phải làm chủ chất lượng.

Tại sao yêu cầu và thiết kế hệ thống được coi là trách nhiệm “untouched"?

Không đáng tin cậy vì những quyết định này phụ thuộc vào bối cảnh kinh doanh và trách nhiệm dài hạn.

AI có thể:

- đề xuất kiến trúc và các phương án đánh đổi

- lên kịch bản chế độ lỗi và phát hiện bất nhất API

- soạn tài liệu quyết định

Con người vẫn phải quyết định:

Làm sao dùng AI an toàn với hạn chế bảo mật, quyền riêng tư và tuân thủ?

Không bao giờ paste bí mật hay dữ liệu khách/chi tiết sự cố vào prompt.

Các quy tắc thực tế:

- che các key, token, credential và endpoint độc quyền

- tránh identifier khách hàng và timeline sự cố nhạy cảm

- giữ prompt tập trung vào repro tối giản và log đã được làm sạch

- có quy ước đội: công bố khi dùng AI nếu nó ảnh hưởng đến quyết định, ước lượng hoặc mã do bạn tác giả