Tại sao Patterson và RISC vẫn quan trọng

David Patterson thường được gọi là “một trong những người tiên phong RISC,” nhưng ảnh hưởng lâu dài của ông rộng hơn bất kỳ thiết kế CPU đơn lẻ nào. Ông giúp phổ biến một cách suy nghĩ thực dụng về máy tính: xem hiệu năng như thứ có thể đo được, đơn giản hóa và cải thiện từ đầu đến cuối — từ các lệnh mà chip hiểu đến các công cụ phần mềm tạo ra những lệnh đó.

“Tư duy RISC” nói ngắn gọn

RISC (Reduced Instruction Set Computing) là ý tưởng rằng một bộ xử lý có thể chạy nhanh và dự đoán được hơn khi nó tập trung vào một tập lệnh nhỏ hơn gồm các lệnh đơn giản. Thay vì đưa một thực đơn lớn các phép toán phức tạp vào phần cứng, bạn làm cho các phép toán hay dùng trở nên nhanh, đều đặn và dễ đưa vào pipeline. Lợi ích không phải là “ít khả năng hơn” — mà là các khối xây dựng đơn giản thực thi hiệu quả thường thắng trong khối lượng công việc thực tế.

Thiết kế đồng bộ: phần cứng và mã cùng cải thiện nhau

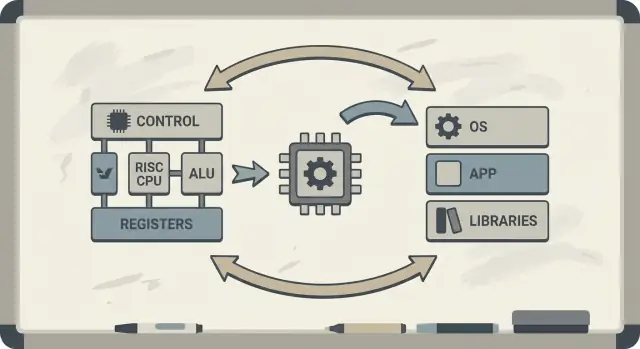

Patterson cũng ủng hộ thiết kế đồng bộ phần cứng–phần mềm: một vòng phản hồi nơi các kiến trúc sư chip, người viết trình biên dịch và nhà thiết kế hệ thống lặp lại cùng nhau.

Nếu một bộ xử lý được thiết kế để thực thi tốt các mẫu đơn giản, trình biên dịch có thể sinh ra các mẫu đó một cách đáng tin cậy. Nếu trình biên dịch cho thấy chương trình thực tế tiêu tốn thời gian ở một số thao tác (ví dụ truy cập bộ nhớ), phần cứng có thể được điều chỉnh để xử lý tốt hơn các trường hợp đó. Đó là lý do tại sao thảo luận về một instruction set architecture (ISA) tự nhiên liên quan đến tối ưu trình biên dịch, cache và pipeline.

Bạn sẽ nhận được gì từ bài viết này

Bạn sẽ hiểu vì sao ý tưởng RISC liên quan đến hiệu năng trên mỗi watt (không chỉ tốc độ thuần túy), cách “tính dự đoán” giúp CPU hiện đại và chip di động tiết kiệm năng lượng hơn, và cách những nguyên tắc này xuất hiện trong thiết bị ngày nay — từ laptop đến máy chủ đám mây.

Nếu bạn muốn một bản đồ khái niệm chính trước khi đi sâu, xem blog/key-takeaways-and-next-steps.

Vấn đề mà RISC đáp lại

Các bộ vi xử lý sớm được xây dựng trong điều kiện giới hạn: chip có diện tích mạch hạn chế, bộ nhớ đắt tiền và lưu trữ chậm. Các nhà thiết kế cố gắng giao máy tính vừa túi tiền vừa “đủ nhanh,” thường với cache nhỏ (hoặc không có), tần số đồng hồ khiêm tốn và bộ nhớ chính rất hạn chế so với nhu cầu phần mềm.

Cược cũ: lệnh phức tạp = chương trình nhanh hơn

Một ý tưởng phổ biến thời đó là nếu CPU cung cấp nhiều lệnh cấp cao mạnh mẽ — những lệnh có thể thực hiện nhiều bước cùng lúc — chương trình sẽ chạy nhanh hơn và dễ viết hơn. Nếu một lệnh có thể “làm công việc của nhiều lệnh,” người ta nghĩ rằng tổng số lệnh cần thiết sẽ ít hơn, tiết kiệm thời gian và bộ nhớ.

Đó là trực giác đứng sau nhiều thiết kế CISC (complex instruction set computing): cung cấp cho lập trình viên và trình biên dịch một bộ dụng cụ lớn gồm các thao tác cầu kỳ.

Sự không khớp: CPU cung cấp gì so với điều thực tế dùng

Vấn đề là chương trình thực tế (và trình biên dịch dịch chúng) không tận dụng nhất quán được độ phức tạp đó. Nhiều lệnh tinh vi nhất hiếm khi được sử dụng, trong khi một tập nhỏ các thao tác đơn giản — load dữ liệu, store dữ liệu, cộng, so sánh, nhánh — xuất hiện thường xuyên.

Trong khi đó, hỗ trợ một thực đơn lớn các lệnh phức tạp khiến CPU khó xây dựng hơn và chậm tối ưu hơn. Độ phức tạp chiếm diện tích chip và công sức thiết kế đáng lẽ có thể dùng để làm cho các thao tác phổ biến chạy nhanh và dự đoán được.

RISC là câu trả lời cho khoảng trống đó: tập trung CPU vào những gì phần mềm thực sự làm phần lớn thời gian, làm cho các đường dẫn đó nhanh — rồi để trình biên dịch đảm nhiệm nhiều công việc “điều phối” hơn theo cách hệ thống.

RISC vs CISC: ý tưởng nói dễ hiểu

Một cách đơn giản để nghĩ về CISC vs RISC là so sánh bộ dụng cụ.

CISC (Complex Instruction Set Computing) giống một xưởng đầy các công cụ chuyên dụng và cầu kỳ — mỗi công cụ có thể làm nhiều việc trong một bước. Một “lệnh” có thể load dữ liệu từ bộ nhớ, tính toán và lưu kết quả, tất cả gói lại.

RISC (Reduced Instruction Set Computing) giống việc mang theo bộ dụng cụ nhỏ hơn, đáng tin cậy mà bạn dùng liên tục — búa, tua vít, thước — và xây dựng mọi thứ từ các bước lặp lại. Mỗi lệnh thường thực hiện một nhiệm vụ nhỏ, rõ ràng.

Tại sao “đơn giản hơn” có thể nhanh hơn

Khi các lệnh đơn giản và đồng đều, CPU có thể thực hiện chúng bằng một dây chuyền sạch hơn (một pipeline). Dây chuyền này dễ thiết kế hơn, dễ chạy ở tần số cao hơn và dễ giữ bận rộn.

Với các lệnh kiểu CISC “làm nhiều việc,” CPU thường phải giải mã và phân rã lệnh phức tạp thành các bước nội bộ nhỏ hơn. Điều đó có thể thêm độ phức tạp và khiến pipeline khó duy trì trơn tru.

Tính dự đoán quan trọng

RISC hướng tới thời gian thực thi lệnh dự đoán — nhiều lệnh mất khoảng thời gian tương đương. Tính dự đoán giúp CPU lên lịch công việc hiệu quả và giúp trình biên dịch sinh mã giữ pipeline luôn có việc thay vì bị chùn.

Các đánh đổi (và tại sao thường đáng)

RISC thường cần nhiều lệnh hơn để làm cùng một tác vụ. Điều đó có thể dẫn tới:

- Kích thước chương trình hơi lớn hơn (nhiều byte mã hơn)

- Nhiều lần fetch lệnh từ bộ nhớ hơn

Nhưng điều đó vẫn có lợi nếu mỗi lệnh nhanh, pipeline mượt, và thiết kế tổng thể đơn giản. Trong thực tế, trình biên dịch tối ưu và cache tốt có thể bù lại nhược điểm “nhiều lệnh” — và CPU có thể dành nhiều thời gian hơn cho công việc hữu ích thay vì giải mã các lệnh phức tạp.

Berkeley RISC và tư duy “đo rồi thiết kế”

Berkeley RISC không chỉ là một tập lệnh mới. Đó là thái độ nghiên cứu: đừng bắt đầu từ thứ trông có vẻ đẹp trên giấy — hãy bắt đầu từ những gì chương trình thực sự làm, rồi định hình CPU theo thực tế đó.

Nhân nhỏ, nhanh + trình biên dịch thông minh

Ở mức khái niệm, nhóm Berkeley nhắm đến một nhân CPU đủ đơn giản để chạy rất nhanh và dự đoán được. Thay vì nhồi phần cứng với nhiều “mánh lệnh” phức tạp, họ dựa vào trình biên dịch để làm nhiều việc hơn: chọn lệnh thẳng thắn, lập lịch hợp lý và giữ dữ liệu trong thanh ghi càng lâu càng tốt.

Phân chia công việc này quan trọng. Một nhân nhỏ, sạch sẽ dễ đưa vào pipeline hiệu quả hơn, dễ suy nghĩ và thường nhanh hơn trên mỗi transistor. Trình biên dịch, nhìn thấy toàn chương trình, có thể lập kế hoạch trước theo những cách mà phần cứng khó làm ngay lập tức.

Đo workloads thực tế, không giả định

David Patterson nhấn mạnh đo lường vì thiết kế máy tính đầy những huyền thoại hấp dẫn — những tính năng nghe có vẻ hữu ích nhưng hiếm khi xuất hiện trong mã thực. Berkeley RISC thúc đẩy việc dùng benchmark và truy vết workloads để tìm các đường nóng: các vòng lặp, lời gọi hàm và truy cập bộ nhớ chiếm phần lớn thời gian chạy.

Điều này gắn liền với nguyên tắc “làm cho trường hợp phổ biến nhanh.” Nếu hầu hết các lệnh là thao tác đơn giản và load/store, thì tối ưu các trường hợp hay gặp sẽ đem lại lợi nhiều hơn là tăng tốc các lệnh phức tạp hiếm gặp.

RISC như một cách suy nghĩ

Bài học tồn tại là RISC vừa là một kiến trúc vừa là một tư duy: đơn giản hóa những gì thường xuyên, xác thực bằng dữ liệu, và coi phần cứng cùng phần mềm là một hệ thống có thể tinh chỉnh cùng nhau.

Thiết kế đồng bộ phần cứng–phần mềm nghĩa là gì

Thiết kế đồng bộ phần cứng–phần mềm là ý tưởng rằng bạn không thiết kế CPU một mình. Bạn thiết kế chip và trình biên dịch (và đôi khi hệ điều hành) với nhau, để các chương trình thực tế chạy nhanh và hiệu quả — không chỉ các chuỗi lệnh tổng hợp “tốt nhất”.

Một vòng phản hồi đơn giản

Co-design hoạt động như một vòng kỹ thuật:

-

Lựa chọn ISA: ISA quyết định những gì CPU biểu đạt dễ dàng (ví dụ, mô hình load/store, nhiều thanh ghi, chế độ địa chỉ đơn giản).

-

Chiến lược trình biên dịch: trình biên dịch thích nghi — giữ biến nóng trong thanh ghi, sắp xếp lệnh để tránh stalls và chọn quy ước gọi hàm giảm chi phí.

-

Kết quả workload: bạn đo các chương trình thực tế (trình biên dịch, cơ sở dữ liệu, đồ họa, mã hệ điều hành) và xem thời gian và năng lượng đi đâu.

-

Thiết kế tiếp theo: bạn tinh chỉnh ISA và vi kiến trúc (độ sâu pipeline, số thanh ghi, kích thước cache) dựa trên các phép đo đó.

Đây là một vòng lặp nhỏ (C) minh họa mối quan hệ:

for (int i = 0; i < n; i++)

sum += a[i];

Trên ISA kiểu RISC, trình biên dịch thường giữ sum và i trong thanh ghi, dùng các lệnh load đơn giản cho a[i], và thực hiện lập lịch lệnh sao cho CPU vẫn bận trong khi một load đang chờ.

Tại sao bỏ qua trình biên dịch lãng phí silicon và năng lượng

Nếu một chip thêm lệnh phức tạp hoặc phần cứng đặc biệt mà trình biên dịch hiếm khi dùng, phần diện tích đó vẫn tiêu thụ năng lượng và công sức thiết kế. Trong khi đó, những thứ “chán” mà trình biên dịch dựa vào — đủ thanh ghi, pipeline dự đoán được, quy ước gọi hàm hiệu quả — có thể bị bỏ qua.

Tư duy RISC của Patterson nhấn mạnh chi tiêu silicon vào nơi phần mềm thực sự thu lợi.

Pipeline, tính dự đoán và sự trợ giúp của trình biên dịch

Own the code you build

Keep full control by exporting source code whenever you want.

Một ý tưởng chính của RISC là làm cho “dây chuyền” của CPU dễ giữ bận. Dây chuyền đó là pipeline: thay vì hoàn thành hẳn một lệnh rồi mới bắt đầu lệnh tiếp theo, bộ xử lý phân chia công việc thành các giai đoạn (fetch, decode, execute, write-back) và chồng chéo chúng. Khi mọi thứ thông suốt, bạn hoàn thành gần một lệnh mỗi chu kỳ — giống như ô tô chạy qua các trạm trong một nhà máy nhiều trạm.

Tại sao lệnh đơn giản giữ dây chuyền chạy

Pipeline hoạt động tốt nhất khi mỗi mục trên dây chuyền tương tự nhau. Lệnh RISC được thiết kế tương đối đồng đều và dự đoán được (thường có độ dài cố định, với địa chỉ đơn giản). Điều đó giảm các “trường hợp đặc biệt” khiến một lệnh cần thêm thời gian hoặc tài nguyên khác thường.

Khi pipeline phải tạm dừng: hazards và stalls

Chương trình thực tế không hoàn hảo. Đôi khi một lệnh phụ thuộc vào kết quả của lệnh trước (không thể dùng giá trị trước khi nó được tính). Lúc khác, CPU phải chờ dữ liệu từ bộ nhớ, hoặc nó chưa biết nhánh sẽ đi hướng nào.

Những tình huống này gây ra stalls — tạm dừng ngắn khi một phần pipeline không làm việc được. Trực giác đơn giản: stalls xảy ra khi giai đoạn tiếp theo không thể làm việc hữu ích vì đang chờ thứ cần thiết.

Trình biên dịch như người điều phối giao thông

Đây là nơi thiết kế đồng bộ phần cứng–phần mềm thể hiện rõ. Nếu phần cứng dự đoán được, trình biên dịch có thể giúp bằng cách sắp xếp lại thứ tự lệnh (không đổi nghĩa chương trình) để lấp các “khoảng trống.” Ví dụ, trong khi chờ một giá trị được sản xuất, trình biên dịch có thể lập lịch một lệnh độc lập không phụ thuộc vào giá trị đó.

Lợi ích là trách nhiệm chia sẻ: CPU giữ đơn giản và nhanh trên trường hợp phổ biến, trong khi trình biên dịch lập kế hoạch nhiều hơn. Cùng nhau, chúng giảm stalls và tăng thông lượng — thường cải thiện hiệu năng thực tế mà không cần ISA phức tạp hơn.

Cache và bức tường bộ nhớ: nơi co-design có giá trị

CPU có thể thực hiện phép toán đơn giản trong vài chu kỳ, nhưng fetch dữ liệu từ bộ nhớ chính (DRAM) có thể mất hàng trăm chu kỳ. Khoảng cách đó tồn tại vì DRAM ở xa hơn về mặt vật lý, tối ưu cho dung lượng và chi phí, và bị giới hạn bởi độ trễ (latency) và băng thông.

Khi CPU nhanh hơn, bộ nhớ không tăng kịp cùng tốc độ — khoảng cách này thường gọi là memory wall.

Cache và tính cục bộ

Cache là bộ nhớ nhỏ, nhanh đặt gần CPU để tránh trả phí DRAM cho mỗi truy cập. Chúng hoạt động vì chương trình thực tế có tính cục bộ:

- Temporal locality: nếu bạn đã dùng một giá trị hoặc lệnh gần đây, có khả năng sẽ dùng lại sớm.

- Spatial locality: nếu bạn truy cập một địa chỉ, nhiều khả năng sẽ truy cập các địa chỉ gần đó tiếp theo.

Chip hiện đại xếp nhiều tầng cache (L1, L2, L3), cố gắng giữ “working set” của mã và dữ liệu gần nhân xử lý.

Nơi ISA và trình biên dịch ảnh hưởng hành vi cache

Đây là nơi thiết kế đồng bộ phần cứng–phần mềm tỏ ra hữu ích. ISA và trình biên dịch cùng định hình áp lực lên cache mà chương trình tạo ra.

- Kích thước mã quan trọng. Binary lớn và chuỗi lệnh nặng có thể làm tràn instruction cache, gây stalls. Lựa chọn ISA cải thiện mật độ mã (ví dụ, instruction nén tùy chọn) có thể tăng hit rate instruction-cache.

- Mẫu truy cập quan trọng. Thiết kế kiểu RISC “load/store” làm cho truy cập bộ nhớ rõ ràng. Trình biên dịch có thể lập lịch các load sớm hơn, giữ các giá trị nóng trong thanh ghi lâu hơn và giảm lưu lượng bộ nhớ không cần thiết.

- Bố cục và blocking. Tối ưu trình biên dịch như loop tiling (blocking), sắp xếp lại cấu trúc dữ liệu và gợi ý prefetch đều nhằm biến các chuyến đi DRAM ngẫu nhiên thành các cache hit dự đoán được.

Memory wall ảnh hưởng hiệu năng thực tế

Nói đơn giản, memory wall giải thích vì sao CPU có xung nhịp cao vẫn có thể cảm thấy chậm: mở app lớn, chạy truy vấn cơ sở dữ liệu, cuộn feed hoặc xử lý dataset lớn thường bị nghẽn do cache miss và băng thông bộ nhớ — chứ không phải do tốc độ tính toán thuần túy.

Hiệu quả: hiệu năng trên mỗi watt, không chỉ tốc độ thô

Ship a backend you can test

Spin up a Go backend with PostgreSQL from a simple prompt, then refine with measurements.

Lâu nay, thảo luận về CPU giống như một cuộc đua: chip nào xong nhiệm vụ nhanh hơn thì “thắng.” Nhưng máy tính thực sống trong giới hạn vật lý — pin, nhiệt, tiếng ồn quạt và hóa đơn tiền điện.

Đó là lý do mà performance per watt trở thành chỉ số cốt lõi: bạn nhận được bao nhiêu công việc hữu ích cho năng lượng tiêu thụ.

Hãy nghĩ đó là hiệu suất, không phải sức mạnh đỉnh. Hai bộ vi xử lý có thể cảm giác tương tự trong sử dụng hàng ngày, nhưng một cái có thể làm được trong khi tiêu thụ ít điện hơn, mát hơn và chạy lâu hơn trên cùng một pin.

Trên laptop và điện thoại, điều này ảnh hưởng trực tiếp tới thời lượng pin và cảm giác người dùng. Ở trung tâm dữ liệu, nó ảnh hưởng chi phí cung cấp và làm mát hàng nghìn máy, cộng cách bạn dày đặc máy chủ mà không quá nóng.

Tại sao nhân đơn giản thường tiêu thụ ít năng lượng hơn

Tư duy RISC hướng thiết kế CPU theo hướng làm ít thứ trong phần cứng hơn, nhưng dự đoán được. Một nhân đơn giản giảm năng lượng theo vài cách:

- Logic điều khiển ít phức tạp hơn nghĩa là ít phần tử nội bộ bật tắt mỗi chu kỳ.

- Thực thi dự đoán hơn giúp dễ giữ pipeline bận mà không cần khôi phục tốn kém.

- Thiết kế thuận trình biên dịch cho phép phần mềm lập lịch hiệu quả, tránh phần cứng phải đoán mò.

Ý chính không phải “đơn giản luôn tốt hơn.” Mà là độ phức tạp có chi phí năng lượng, và một ISA cùng vi kiến trúc được chọn tốt có thể đánh đổi chút tinh xảo lấy nhiều hiệu quả.

Di động và máy chủ hướng tới cùng mục tiêu

Điện thoại quan tâm pin và nhiệt; máy chủ quan tâm cung cấp điện và làm mát. Môi trường khác nhau, bài học giống nhau: chip nhanh nhất không luôn là máy tính tốt nhất. Người thắng thường là thiết kế cung cấp throughput ổn định trong khi giữ tiêu thụ năng lượng trong giới hạn.

RISC đúng điều gì — và những phức tạp hơn

RISC thường được tóm tắt là “lệnh đơn giản thắng,” nhưng bài học bền vững tinh tế hơn: ISA quan trọng, nhưng nhiều lợi ích thực tế đến từ cách chip được triển khai, không chỉ từ cách ISA trông trên giấy.

Tranh luận “ISA quan trọng”

Các lập luận RISC ban đầu ngụ ý rằng một ISA sạch, nhỏ sẽ tự động làm máy tính nhanh hơn. Trên thực tế, những cải tiến lớn thường đến từ các lựa chọn triển khai mà RISC làm cho dễ hơn: giải mã đơn giản hơn, pipeline sâu hơn, xung cao hơn và trình biên dịch có thể lập lịch công việc dự đoán hơn.

Đó là lý do hai CPU với ISA khác nhau có thể có hiệu năng tương đương nếu vi kiến trúc, kích thước cache, dự đoán nhánh và quy trình sản xuất khác nhau. ISA đặt ra luật; vi kiến trúc chơi theo luật đó.

Đo lường tốt hơn checklist tính năng

Một chuyển dịch quan trọng thời Patterson là thiết kế dựa trên dữ liệu, không phải giả định. Thay vì thêm lệnh vì nghe có vẻ hữu ích, các nhóm đo chương trình thực tế rồi tối ưu cho trường hợp phổ biến.

Tư duy này thường vượt trội so với thiết kế “theo tính năng,” nơi độ phức tạp tăng nhanh hơn lợi ích. Nó cũng làm rõ các đánh đổi: một lệnh tiết kiệm vài dòng mã có thể tiêu tốn chu kỳ, công suất hoặc diện tích chip — và những chi phí đó lan tỏa khắp nơi.

Không phải câu chuyện thắng-thua tuyệt đối

Tư duy RISC không chỉ định hình “chip RISC.” Theo thời gian, nhiều CPU CISC áp dụng các kỹ thuật nội bộ giống RISC trong khi vẫn giữ ISA tương thích. Kết quả không phải “RISC thắng CISC” mà là tiến hoá tới các thiết kế đánh giá đo lường, tính dự đoán và phối hợp phần cứng–phần mềm — bất kể logo ISA.

Từ MIPS đến RISC-V: một sợi chỉ xuyên suốt

RISC không ở mãi trong phòng thí nghiệm. Một trong những chuỗi kết nối rõ ràng từ nghiên cứu đến thực tế chạy từ MIPS đến RISC-V — hai ISA làm cho sự đơn giản và rõ ràng thành tính năng, không phải hạn chế.

MIPS: ISA sạch để xây và học

MIPS được nhớ đến như một ISA dùng để giảng dạy, và có lý do: luật rõ ràng, định dạng lệnh nhất quán, và mô hình load/store không làm phiền trình biên dịch.

Sự sạch sẽ đó không chỉ là học thuật. Bộ xử lý MIPS được bán ra sản phẩm thực tế nhiều năm (từ workstation tới hệ nhúng), phần vì ISA đơn giản giúp xây pipeline nhanh, compiler predictable và toolchain hiệu quả. Khi hành vi phần cứng đều, phần mềm có thể lên kế hoạch xung quanh nó.

RISC-V: mở, thực dụng và thân thiện với co-design

RISC-V khuấy lại sự quan tâm tới tư duy RISC bằng một bước then chốt MIPS không làm: đó là một ISA mở. Điều này thay đổi động lực. Các đại học, startup và công ty lớn có thể thử nghiệm, xuất silicon và chia sẻ tooling mà không cần đàm phán quyền truy cập ISA.

Với co-design, tính mở đó quan trọng vì phía phần mềm (trình biên dịch, OS, runtime) có thể tiến hóa công khai cùng phần cứng, với ít rào cản nhân tạo hơn.

Extension theo mô-đun: thêm khi cần

Một lý do nữa RISC-V hợp với co-design là cách tiếp cận mô-đun. Bạn bắt đầu với một ISA cơ sở nhỏ, rồi thêm extension cho nhu cầu cụ thể — như toán vector, hạn chế cho nhúng, hoặc tính năng bảo mật.

Điều này khuyến khích đánh đổi lành mạnh hơn: thay vì nhồi mọi tính năng vào một thiết kế đơn khối, các nhóm có thể đồng bộ hóa tính năng phần cứng với phần mềm họ thực tế chạy.

Nếu bạn muốn primer sâu hơn, xem blog/what-is-risc-v.

Co-design xuất hiện thế nào trong điện toán hiện đại

Prototype the co-design loop

Turn co-design ideas into a working prototype by building your app through chat in Koder.ai.

Co-design không phải là ký ức lịch sử của thời RISC — đó là cách máy tính hiện đại tiếp tục nhanh hơn và hiệu quả hơn. Ý tưởng cốt lõi vẫn theo kiểu Patterson: bạn không “thắng” bằng phần cứng riêng hay phần mềm riêng. Bạn thắng khi hai bên phù hợp với thế mạnh và giới hạn của nhau.

Tư duy RISC trong thiết bị bạn dùng hàng ngày

Smartphone và nhiều thiết bị nhúng dựa nặng vào nguyên tắc RISC (thường là ARM): lệnh đơn giản, thực thi dự đoán và nhấn mạnh tiết kiệm năng lượng.

Tính dự đoán đó giúp trình biên dịch sinh mã hiệu quả và giúp nhà thiết kế xây nhân tiêu thụ ít khi bạn cuộn màn hình, nhưng vẫn bộc phát hiệu năng cho pipeline camera hoặc game.

Laptop và máy chủ cũng ngày càng theo đuổi mục tiêu tương tự — đặc biệt là hiệu năng trên mỗi watt. Ngay cả khi ISA không truyền thống là “RISC,” nhiều lựa chọn thiết kế nội bộ vẫn hướng tới hiệu quả kiểu RISC: pipeline sâu, thực thi rộng và quản lý năng lượng tích cực dựa trên hành vi phần mềm thực tế.

Accelerator là co-design trong thực tế

GPU, accelerator AI (TPU/NPUs) và bộ xử lý media là dạng co-design thực tiễn: thay vì ép mọi việc qua CPU chung, nền tảng cung cấp phần cứng phù hợp với các mẫu tính toán phổ biến.

Điều làm cho đó là co-design (không chỉ “thêm phần cứng”) là stack phần mềm xung quanh:

- GPU nhanh nhờ mô hình lập trình như CUDA và API như Vulkan/Metal.

- Accelerator AI phụ thuộc trình biên dịch và tối ưu đồ thị biến mô hình thành các thao tác chip ưa thích.

- Bộ mã/giải mã video hiệu quả vì OS, trình duyệt và app được viết để dùng chúng.

Nếu phần mềm không nhắm tới accelerator, tốc độ lý thuyết sẽ mãi là lý thuyết.

Stack phần mềm là một phần của hiệu năng

Hai nền tảng có thông số tương tự có thể cho cảm giác khác nhau vì “sản phẩm thực” bao gồm trình biên dịch, thư viện và framework. Một thư viện toán tối ưu (BLAS), một JIT tốt hay trình biên dịch thông minh có thể mang lại lợi lớn mà không thay chip.

Đó là lý do thiết kế CPU hiện đại thường hướng theo benchmark: nhóm phần cứng xem trình biên dịch và workloads làm gì, rồi điều chỉnh tính năng (cache, dự đoán nhánh, lệnh vector, prefetching) để làm cho trường hợp phổ biến nhanh hơn.

Một danh sách kiểm nhanh: nên chú ý gì

Khi đánh giá một nền tảng (điện thoại, laptop, máy chủ hoặc board nhúng), tìm dấu hiệu co-design:

- Phù hợp với workload: app của bạn bị CPU-bound, GPU-bound, memory-bound hay phù hợp accelerator?

- Khả năng accelerator: có NPU/GPU/bộ xử lý media — và công cụ của bạn thực sự dùng chúng không?

- Độ chín toolchain: có build tối ưu, công cụ profiling tốt và hỗ trợ tích cực không?

- Hệ sinh thái thư viện: thư viện cốt lõi (toán, thị giác, crypto) có được tinh chỉnh cho phần cứng đó không?

- Hành vi điện năng: bạn có hiệu năng bền vững trong giới hạn nhiệt/điện không?

Tiến bộ điện toán hiện nay ít liên quan đến một “CPU nhanh hơn” duy nhất mà nhiều hơn đến toàn bộ hệ thống phần cứng-cộng-phần mềm được tạo hình — đo rồi thiết kế — quanh workloads thực tế.

Những điểm chính và bước tiếp theo thực tế

Tư duy RISC và thông điệp rộng hơn của Patterson tóm gọn vào vài bài học bền: đơn giản hóa những gì phải nhanh, đo những gì thực sự xảy ra, và coi phần cứng cùng phần mềm là một hệ thống — vì người dùng trải nghiệm toàn bộ chứ không phải các thành phần riêng lẻ.

Những bài học đáng giữ

Thứ nhất, đơn giản là một chiến lược, không chỉ là thẩm mỹ. ISA sạch và thực thi dự đoán giúp trình biên dịch sinh mã tốt và CPU chạy mã đó hiệu quả.

Thứ hai, đo lường hơn trực giác. Dùng workloads đại diện, thu dữ liệu profiling và để những cổ chai thực sự hướng quyết định thiết kế — dù bạn đang tinh chỉnh tối ưu trình biên dịch, chọn SKU CPU hay thiết kế lại đường nóng quan trọng.

Thứ ba, co-design là nơi các lợi ích cộng dồn. Mã thân pipeline, cấu trúc dữ liệu biết cache và mục tiêu performance-per-watt thực tế thường đem lại tốc độ hữu dụng hơn là chạy theo throughput lý thuyết đỉnh.

Bước tiếp theo thực tế cho đội sản phẩm

Nếu bạn đang chọn nền tảng (x86, ARM hay RISC-V), đánh giá theo cách người dùng của bạn sẽ dùng:

- Benchmark kịch bản end-to-end (thời gian khởi động, throughput ổn định, tail latency), đừng chỉ chạy microbenchmarks.

- Theo dõi chỉ số hiệu quả (watt, nhiệt, ảnh hưởng pin) cùng với hiệu năng.

- Lặp nhanh: profile → thay đổi một điều → đo lại. Những bước nhỏ, được xác thực sẽ cộng dồn.

Nếu một phần công việc của bạn là biến các phép đo này thành phần mềm giao hàng, hãy rút ngắn vòng lặp build–measure. Ví dụ, các đội dùng Koder.ai để prototype và phát triển ứng dụng thực qua workflow chat (web, backend, mobile), rồi chạy lại cùng benchmark end-to-end sau mỗi thay đổi. Các tính năng như planning mode, snapshots và rollback hỗ trợ kỷ luật “đo rồi thiết kế” mà Patterson đề xuất — áp dụng cho phát triển sản phẩm hiện đại.

Nếu bạn muốn primer sâu hơn về hiệu quả, xem blog/performance-per-watt-basics. Nếu đang so sánh môi trường và cần cách đơn giản ước lượng đánh đổi chi phí/hiệu năng, xem pricing.

Bài học còn mãi: đơn giản, đo lường và co-design tiếp tục mang lại giá trị khi triển khai tiến hóa từ pipeline thời MIPS tới các nhân dị hetero hiện đại và ISA mới như RISC-V.