Tại sao mã do AI viết và kiểm thử sinh tự động nên đi cùng nhau

Logic ứng dụng do AI viết là các phần “hoạt động” của codebase được soạn thảo với sự trợ giúp của trợ lý: hàm mới, tính năng nhỏ, refactor, xử lý các trường hợp biên, và thậm chí là viết lại những module hiện có. Bạn vẫn quyết định xây gì, nhưng phiên bản đầu tiên của phần hiện thực thường đến nhanh hơn—và đôi khi kèm theo những giả định mà bạn chỉ nhận ra sau này.

Việc tạo kiểm thử tự động là năng lực tương ứng ở phía xác minh. Thay vì viết từng kiểm thử bằng tay, các công cụ có thể đề xuất các trường hợp kiểm thử và assert dựa trên mã, spec, hoặc các mẫu học được từ lỗi trước. Trong thực tế, điều này có thể trông như:

- “Với chữ ký hàm và các nhánh này, đây là các kiểm thử bao phủ input điển hình, biên, và đường lỗi.”

- “Đây là các kiểm thử hồi quy tái tạo lỗi crash mà ta đã thấy ở production.”

Kỳ vọng then chốt: kiểm thử sinh không tự động là “tốt”

Một kiểm thử được sinh có thể gây hiểu lầm: nó có thể assert hành vi hiện tại ngay cả khi hành vi đó sai, hoặc bỏ qua các quy tắc sản phẩm nằm trong đầu mọi người và comment ticket. Đó là lý do cần có review của con người. Cần có người xác nhận tên test, phần chuẩn bị, và các assert phản ánh ý định thực sự—không chỉ là mã đang làm gì hôm nay.

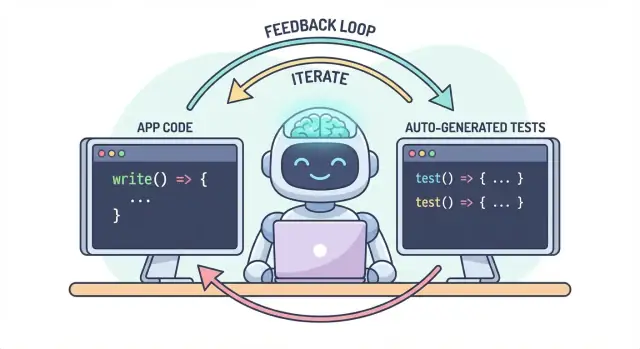

Một luồng công việc, hai đầu ra

Ý tưởng cốt lõi đơn giản: mã và kiểm thử nên tiến hóa cùng nhau như một luồng công việc. Nếu AI giúp bạn thay đổi logic nhanh, thì kiểm thử sinh tự động giúp bạn cố định hành vi mong muốn nhanh tương tự—để thay đổi tiếp theo (bằng tay hoặc AI) có một định nghĩa rõ ràng, có thể thực thi về "vẫn đúng".

Trong thực hành, cách tiếp cận “đầu ra ghép đôi” này dễ bảo trì hơn khi luồng dev của bạn đã quen với chat-driven. Ví dụ, trong Koder.ai (một nền tảng vibe-coding để xây web, backend và mobile qua chat), việc coi “tính năng + kiểm thử” như một deliverable duy nhất là tự nhiên: bạn mô tả hành vi, sinh implementation, rồi sinh và review kiểm thử trong cùng vòng hội thoại trước khi deploy.

Vấn đề: mã nhanh hơn có thể dẫn đến lỗi nhanh hơn

Mã do AI viết có thể cảm giác như siêu năng lực: tính năng xuất hiện nhanh, boilerplate biến mất, và những refactor từng mất cả giờ có thể xong trước khi cốc cà phê của bạn nguội. Rủi ro là tốc độ thay đổi hình dạng của rủi ro. Khi việc tạo mã dễ hơn, việc ship sai sót cũng dễ hơn—đôi khi là những lỗi tinh vi.

Các chế độ lỗi phổ biến của logic do AI viết

Trợ lý AI giỏi tạo các implementation “hợp lý”, nhưng hợp lý không đồng nghĩa đúng cho domain cụ thể của bạn.

Các trường hợp biên thường là nạn nhân đầu tiên. Logic do AI sinh thường xử lý happy path tốt, rồi vấp ở các điều kiện biên: input rỗng, vấn đề timezone, làm tròn, giá trị null, hành vi retry, hoặc trạng thái “điều này không nên xảy ra” mà lại xảy ra ở production.

Giả định sai là vấn đề thường gặp khác. Trợ lý có thể suy ra yêu cầu chưa được nêu rõ (“người dùng luôn được xác thực”, “ID là số”, “trường này luôn tồn tại”), hoặc nó áp một pattern quen thuộc mà không phù hợp với hệ thống của bạn.

Hồi quy im lặng thường tốn kém nhất. Bạn yêu cầu thay đổi nhỏ, trợ lý viết lại một đoạn logic, và điều gì đó không liên quan bị hỏng—không có lỗi rõ ràng. Mã vẫn biên dịch, UI vẫn load, nhưng một quy tắc giá, kiểm tra quyền, hoặc chuyển đổi dữ liệu hơi sai.

Tại sao kiểm tra thủ công không mở rộng theo tốc độ mã

Khi thay đổi mã tăng tốc, test thủ công trở thành nút thắt và một canh bạc. Bạn hoặc dành nhiều thời gian nhấp chuột (làm chậm giao hàng) hoặc test ít hơn (tăng rủi ro). Ngay cả đội QA kỷ luật cũng không thể bằng tay che phủ mọi biến thể khi thay đổi thường xuyên và rộng.

Tệ hơn, kiểm tra thủ công khó lặp lại nhất quán. Chúng sống trong đầu ai đó hoặc checklist, và dễ bị bỏ qua khi deadline siết—chính lúc rủi ro cao nhất.

Kiểm thử như lưới an toàn và công cụ giao tiếp

Kiểm thử tự động tạo ra một lưới an toàn bền vững: chúng làm cho kỳ vọng trở nên có thể thực thi. Một kiểm thử tốt nói: “Với các input và ngữ cảnh này, đây là kết quả chúng ta dựa vào.” Đó không chỉ là xác minh; đó là giao tiếp cho bạn tương lai, đồng đội, và thậm chí cả trợ lý AI.

Khi có kiểm thử, thay đổi bớt đáng sợ vì phản hồi là ngay lập tức. Thay vì phát hiện vấn đề sau code review, trong staging, hoặc từ khách hàng, bạn tìm ra trong vài phút sau khi thay đổi.

Bắt lỗi sớm để giảm làm lại

Càng phát hiện bug sớm, chi phí sửa càng thấp. Kiểm thử rút ngắn vòng phản hồi: chúng phơi bày các giả định không khớp và các biên bị bỏ sót khi ý định còn tươi. Điều đó giảm làm lại, tránh các patch “fix-forward”, và giữ cho tốc độ của AI không biến thành vòng lặp sửa lỗi liên tục do AI gây ra.

Cách kiểm thử tạo vòng phản hồi cho logic do AI viết

Mã do AI viết nhanh nhất khi bạn coi nó là một cuộc hội thoại, không phải một deliverable một lần. Kiểm thử làm cho cuộc hội thoại đó có thể đo lường được.

Vòng “spec → code → tests” (bằng tiếng thường)

-

Spec: Bạn mô tả nên xảy ra gì (input, output, các biên).

-

Code: AI viết implementation tự nhận khớp với mô tả.

-

Tests: Bạn (hoặc AI) sinh các kiểm tra chứng minh hành vi thực sự đúng.

Lặp lại vòng này và bạn không chỉ tạo nhiều mã hơn—bạn liên tục thắt chặt định nghĩa của “hoàn thành.”

Kiểm thử buộc yêu cầu và giao diện rõ ràng hơn

Một yêu cầu mơ hồ như “xử lý người dùng không hợp lệ một cách tử tế” dễ bị bỏ qua trong mã. Một kiểm thử không thể mơ hồ. Nó buộc cụ thể hóa:

- "Không hợp lệ" là gì? Thiếu ID, trạng thái bị cấm, email sai định dạng?

- "Tử tế" nghĩa là gì? Thông báo lỗi, mã trạng thái, giá trị fallback?

- Giao diện ra sao? Chữ ký hàm, cấu trúc trả về, exception?

Ngay khi bạn cố gắng diễn đạt những chi tiết đó trong kiểm thử, phần mơ hồ hiện ra ngay. Rõ ràng đó cải thiện prompt bạn gửi AI và thường dẫn đến giao diện đơn giản hơn, ổn định hơn.

Kiểm thử sinh xác thực những gì mã tuyên bố

Mã do AI viết có thể trông đúng trong khi ẩn các giả định. Kiểm thử sinh là cách thực tế để xác minh các tuyên bố mã:

- “Hàm này là pure” → test đảm bảo không có side effect ngoại bộ.

- “Xử lý biên” → test null, danh sách rỗng, các giá trị biên.

- “Tương thích ngược” → test input cũ và output mong đợi.

Mục tiêu không phải tin tưởng kiểm thử sinh một cách mù quáng—mà dùng chúng như hoài nghi có cấu trúc và nhanh.

Test fail trở thành prompt tiếp theo

Một test thất bại là phản hồi có thể hành động: nó chỉ ra mismatch cụ thể giữa spec và implementation. Thay vì hỏi AI “sửa nó”, bạn có thể dán lỗi và nói: “Cập nhật mã để test này pass mà không thay đổi API công khai.” Điều đó biến debugging thành một vòng lặp tập trung thay vì trò đoán mò.

Vị trí của tạo kiểm thử tự động trong kim tự tháp kiểm thử

Tạo kiểm thử tự động hữu ích nhất khi nó hỗ trợ chiến lược kiểm thử hiện có—đặc biệt là kim tự tháp kiểm thử cổ điển. Kim tự tháp không phải quy tắc cứng nhắc; nó giúp giữ phản hồi nhanh và đáng tin cậy trong khi vẫn bắt được lỗi thực tế.

AI có thể giúp tạo kiểm thử ở mọi tầng, nhưng bạn sẽ nhận kết quả tốt nhất khi tạo nhiều kiểm thử rẻ (đáy kim tự tháp) và ít kiểm thử tốn kém (đỉnh). Cân bằng đó giữ pipeline CI nhanh mà vẫn bảo vệ trải nghiệm người dùng.

Kiểm thử đơn vị: nhanh, tập trung, và dễ sinh

Kiểm thử đơn vị là các kiểm tra nhỏ cho hàm, phương thức, hoặc module. Chúng chạy nhanh, không cần hệ thống ngoài, và lý tưởng cho việc tạo phủ các trường hợp biên bằng AI.

Một số cách dùng hữu ích:

- Thử input validation và các giá trị biên “kỳ lạ”

- Xác thực quy tắc nghiệp vụ (giảm giá, quyền, chuyển trạng thái)

- Khóa các bug fix bằng kiểm thử hồi quy để khó quên

Vì kiểm thử đơn vị scope hẹp, chúng dễ review và ít flaky hơn.

Kiểm thử tích hợp: ít hơn, nhưng giá trị cao

Kiểm thử tích hợp xác thực cách các phần hoạt động cùng nhau: API với DB, service gọi service khác, xử lý queue, xác thực, v.v.

Kiểm thử tích hợp do AI sinh có thể hữu ích, nhưng cần nhiều kỷ luật hơn:

- Setup/teardown rõ ràng để test không rò dữ liệu

- Môi trường test ổn định (containers, DB test, mock khi phù hợp)

- Assert tập trung vào kết quả, không phải chi tiết hiện thực

Hãy coi chúng như những “kiểm tra hợp đồng” chứng minh các mối nối vẫn nguyên vẹn.

End-to-end: sinh thận trọng

E2E kiểm tra các luồng người dùng chính. Chúng cũng tốn nhất: chạy chậm, dễ vỡ, và khó debug.

Tạo E2E tự động có thể giúp phác thảo kịch bản, nhưng nên tuyển chọn mạnh. Giữ một tập nhỏ các đường dẫn quan trọng (signup, checkout, luồng cốt lõi) và tránh sinh E2E cho mọi tính năng.

Khuyến nghị thực tế: sinh một hỗn hợp cân bằng

Đừng cố sinh mọi thứ. Thay vào đó:

- Sinh nhiều kiểm thử đơn vị để giữ cho logic do AI viết trung thực ở mức hàm

- Thêm kiểm thử tích hợp mục tiêu để bảo vệ các mối nối rủi ro cao (DB, auth, thanh toán)

- Duy trì một bộ E2E tối thiểu cho vài luồng người dùng quan trọng

Cách này giữ kim tự tháp nguyên vẹn—và biến tạo kiểm thử tự động thành lực nhân đôi thay vì nguồn gây ồn.

Những gì có thể sinh: từ mã, spec, và lỗi thực tế

Tạo kiểm thử tự động không chỉ giới hạn ở “viết unit test cho hàm này.” Công cụ hữu dụng nhất kéo từ ba nguồn: mã hiện có, ý định đằng sau nó, và các lỗi bạn đã thấy.

1) Từ cấu trúc mã: thử hành vi, không chỉ dòng

Với một hàm hoặc module, công cụ có thể suy ra các test case từ input/output, các nhánh, và đường lỗi. Điều này thường gồm:

- Input “happy path” cho kết quả mong đợi

- Giá trị biên (chuỗi rỗng, 0, độ dài tối đa)

- Bao phủ nhánh (if/else)

- Xử lý lỗi (input không hợp lệ, thiếu trường, timeout)

Phong cách này tốt để nhanh chóng bao quanh logic do AI viết bằng các kiểm tra xác nhận nó đang làm gì hôm nay.

2) Từ yêu cầu: biến ý định thành ví dụ có thể chạy

Nếu bạn có tiêu chí chấp nhận, user story hoặc bảng ví dụ, các bộ sinh có thể chuyển chúng thành kiểm thử đọc như spec. Điều này thường giá trị hơn test lấy từ mã vì nó khóa “nên xảy ra” chứ không phải “hiện đang xảy ra”.

Mẫu thực tế: cung cấp vài ví dụ cụ thể (input + kết quả mong đợi) và yêu cầu generator thêm các trường hợp biên phù hợp với những quy tắc đó.

3) Từ báo cáo lỗi: tái tạo trước, rồi ngăn chặn

Sinh dựa trên bug là cách nhanh nhất để xây suite hồi quy ý nghĩa. Cho bước tái tạo (hoặc logs và payload tối thiểu) và sinh:

- một test fail trên hành vi lỗi hiện tại, rồi

- cùng test pass khi sửa—luôn bảo vệ chống tái xuất hiện lỗi.

Snapshot/golden tests: hữu ích, nhưng lưu ý

Snapshot có thể hiệu quả cho output ổn định (UI render, response serialized). Dùng cẩn thận: snapshot lớn có thể “phê duyệt” những sai lệch nhỏ. Ưu tiên snapshot nhỏ, tập trung và kèm assert trên các trường then chốt phải đúng.

Chọn test trước (không cố che biển)

Tạo kiểm thử tự động hiệu quả nhất khi bạn cho nó ưu tiên rõ ràng. Nếu bạn chỉ trỏ toàn bộ codebase và yêu cầu “tất cả kiểm thử,” bạn sẽ nhận nhiều nhiễu: nhiều kiểm tra ít giá trị, trùng lặp phủ, và test dễ vỡ làm chậm giao hàng.

Bắt đầu nơi doanh nghiệp sẽ thấy đau

Bắt đầu với luồng mà gây thiệt hại lớn nhất khi bị vỡ—về tài chính, pháp lý, hoặc uy tín. Lọc theo rủi ro giữ scope thực tế mà vẫn cải thiện chất lượng nhanh.

Tập trung trước vào:

- Các đường kinh doanh cốt lõi (signup, checkout, luồng cốt lõi) và các vùng thay đổi thường xuyên (tính năng hoạt động, refactor, tích hợp mới).

- Các domain rủi ro cao: thanh toán, xác thực, toàn vẹn dữ liệu, quyền/truy cập, và bất cứ thứ gì ảnh hưởng đến những gì người dùng thấy hoặc làm.

Với mỗi luồng chọn, sinh test theo lớp: vài unit test nhanh cho logic rắc rối, cộng một hai integration test xác nhận toàn bộ đường đi.

“Happy path + các biên trên đầu” tốt hơn kết hợp tỉ mỉ

Yêu cầu phủ phù hợp với lỗi thực tế, không phải mọi hoán vị lý thuyết. Bộ khởi đầu tốt là:

- Một test happy path chứng minh hành vi mong đợi.

- Các biên hàng đầu bạn thực sự lo: input thiếu/không hợp lệ, token hết hạn, quyền không đủ, xung đột đồng thời, và trạng thái dữ liệu rỗng.

Bạn luôn có thể mở rộng sau dựa trên bug, báo cáo sự cố, hoặc phản hồi người dùng.

Định nghĩa “done” để nó thực sự xong

Thiết lập quy tắc rõ: một tính năng chưa hoàn tất nếu chưa có test. Định nghĩa done đó càng quan trọng với mã do AI viết, vì nó ngăn “ship nhanh” lặng lẽ biến thành “regression nhanh.”

Nếu muốn duy trì, nối quy tắc vào workflow (ví dụ, yêu cầu test liên quan trước merge trong CI) và ghi mong đợi trong tài liệu nhóm.

Mẫu prompting cho test tốt hơn

AI sinh test nhanh, nhưng chất lượng phụ thuộc nhiều vào cách bạn hỏi. Mục tiêu là dẫn model đến test bảo vệ hành vi—không chỉ test chạy mã.

Đặt tiêu chuẩn code/test trực tiếp trong prompt

Bắt đầu bằng việc cố định “hình dạng” của test để kết quả phù hợp repo.

Bao gồm:

- Ngôn ngữ + framework test (ví dụ TypeScript + Jest, Python + pytest)

- Quy tắc đặt tên

- Vị trí file và cấu trúc

- Bất kỳ convention nào (fixtures, factory helpers, thư viện mock)

Điều này ngăn model phát minh pattern nhóm bạn không dùng.

Cung cấp 1–2 ví dụ test thật để bắt chước

Dán một file test hiện có (hoặc đoạn ngắn) và nói rõ: “Match this style.” Điều này neo quyết định như cách sắp xếp dữ liệu test, cách đặt tên biến, và ưu tiên table-driven tests.

Nếu dự án có helper (ví dụ buildUser() hoặc makeRequest()), include chúng để test sinh dùng lại thay vì viết lại.

Yêu cầu assert có ý nghĩa (không chỉ “chạy được”)

Rõ ràng về “tốt”:

- Assert output và thay đổi trạng thái

- Xác minh side effects (ghi DB, event phát ra)

- Assert loại/error message khi phù hợp

Dòng hữu ích: “Each test must contain at least one assertion about business behavior (not only ‘no exception thrown’).”

Yêu cầu test âm và biên

Phần lớn test do AI sinh nghiêng về happy path. Cân bằng bằng cách yêu cầu:

- Input không hợp lệ và thất bại mong đợi

- Giá trị biên (chuỗi rỗng, 0, độ dài tối đa)

- Thất bại quyền/authorization

- Thiếu dependency (ví dụ null responses, timeouts)

Mẫu prompt thực tế

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Review thủ công: đảm bảo test sinh thực sự hữu ích

AI có thể phác thảo nhiều test nhanh, nhưng nó không thể là thẩm phán cuối cùng xem các test đó có biểu diễn ý định của bạn hay không. Một lượt review của con người biến “test chạy” thành “test bảo vệ chúng ta.” Mục tiêu không phải soi kiểu dáng—mà xác nhận suite sẽ bắt regressions có ý nghĩa mà không thành gánh nặng bảo trì.

Review cho đúng và liên quan

Bắt đầu bằng hai câu hỏi:

- Kiểm thử này assert hành vi mà sản phẩm thực sự cần không?

- Bạn có vui nếu test này fail trong tương lai—bởi vì nó cảnh báo một vấn đề thực sự?

Test sinh đôi khi khóa hành vi tình cờ (chi tiết hiện thực) thay vì quy tắc mong muốn. Nếu test đọc như bản sao của mã thay vì mô tả kết quả mong đợi, hướng nó về các assert cấp cao hơn.

Cẩn trọng với độ giòn (kẻ phá năng suất thầm lặng)

Nguồn flaky thường gặp: mock quá nhiều, timestamp cứng, và giá trị random. Ưu tiên input xác định và assert ổn định (ví dụ assert trên date đã parse hoặc một khoảng, hơn là chuỗi Date.now()). Nếu một test cần quá nhiều mock để pass, có thể nó đang test wiring thay vì hành vi.

Đảm bảo fail vì lý do đúng

Một test “pass” vẫn có thể vô dụng nếu nó pass ngay cả khi feature hỏng (false positive). Tránh assert yếu như “không throw” hoặc chỉ kiểm tra một hàm được gọi. Mạnh hóa bằng assert trên output, thay đổi trạng thái, error trả về, hoặc dữ liệu đã persist.

Checklist review nhẹ nhàng

Một checklist đơn giản giữ review nhất quán:

- Đọc được: tên rõ ràng, setup tối giản, ý định hiển nhiên

- Phủ intent: bao gồm biên chính và đường lỗi

- Dễ bảo trì: tránh quy định quá chi tiết nội bộ; mock tối thiểu

- Chất lượng tín hiệu: sẽ fail khi có regression thực, không chỉ vì refactor vô hại

Xử lý test sinh như code khác: merge chỉ khi bạn sẵn sàng chịu trách nhiệm trong sáu tháng tới.

Giữ nó sống: các check CI giữ mã do AI trung thực

AI giúp viết mã nhanh, nhưng thắng lợi thực sự là giữ mã đó đúng theo thời gian. Cách đơn giản nhất để “khóa” chất lượng là chạy test và check tự động trên mọi thay đổi—để regressions bị bắt trước khi ship.

Luồng thực tế hiệu quả

Một workflow nhẹ mà nhiều đội áp dụng:

- Sinh hoặc chỉnh feature (AI trợ giúp hoặc không).

- Sinh test cho hành vi mới (và cho bug vừa sửa).

- Chạy mọi thứ cục bộ để confirm xanh.

- Commit code + test cùng nhau.

Bước cuối quan trọng: mã do AI viết không kèm test dễ drift. Có test tức là bạn đang ghi hành vi mong muốn theo cách CI có thể áp dụng.

CI như lưới an toàn không thể thương lượng

Cấu hình pipeline CI chạy trên mọi pull request (và lý tưởng trên merge vào main). Ít nhất nó nên:

- Cài phụ thuộc trong môi trường sạch

- Chạy unit/integration tests

- Fail build nếu test fail

Điều này ngăn “chạy được trên máy tôi” và bắt break khi teammate (hoặc prompt AI sau này) thay đổi mã chỗ khác.

Thêm vài cổng chất lượng (giữ nhẹ)

Test là cần thiết, nhưng không bắt mọi thứ. Thêm các gate nhanh, bổ sung:

- Linting (style + lỗi phổ biến)

- Type checks (nếu có)

- Formatting checks (để diff dễ đọc)

Giữ các check này nhanh—nếu CI chậm hoặc ồn, người ta tìm cách né.

Kế hoạch chi phí và năng lực

Nếu bạn tăng chạy CI vì sinh nhiều test, đảm bảo ngân sách khớp nhịp độ. Nếu theo dõi phút CI, đáng xem lại giới hạn và lựa chọn.

Dùng test fail để hướng bước AI tiếp theo

Cách hiệu quả là coi test fail như "prompt tiếp theo." Thay vì yêu cầu model “cải thiện feature,” bạn đưa nó một failure cụ thể và để failure đó giới hạn thay đổi.

Luồng: failure → prompt → fix → lặp

- Chạy suite (hoặc CI) và chụp một failure. Sao chép tên test fail và thông báo assert/stack trace liên quan.

- Yêu cầu AI xử lý đúng failure đó. Cung cấp ngữ cảnh mã tối thiểu (test fail và function/module liên quan), cộng thêm quy tắc nghiệp vụ nếu cần.

- Yêu cầu một regression test trước khi sửa nếu failure xuất phát từ bug production.

- Áp thay đổi nhỏ nhất để test pass. Chạy lại test ngay.

- Sang failure tiếp theo. Một failure tại một thời điểm giữ vòng lặp ngắn và dễ hiểu.

Mẫu prompt: giữ nhỏ và có thể kiểm chứng

Thay vì:

- “Fix the login logic and update tests.”

Dùng:

- “This test fails:

shouldRejectExpiredToken. Đây là output lỗi và code liên quan. Update implementation để test này pass không thay đổi behavior công khai. Nếu cần, thêm regression test mô tả bug.”

Tại sao giảm vòng lặp

Test fail loại bỏ đoán mò. Chúng định nghĩa “đúng” theo dạng có thể thực thi, nên bạn không phải thương lượng yêu cầu trong chat. Bạn cũng tránh sửa đổi lan man: mỗi prompt giới hạn vào một kết quả đo được, giúp review nhanh và dễ phát hiện khi AI “vá” triệu chứng nhưng phá vỡ chỗ khác.

Đây cũng là nơi workflow agent-style có thể có ích: một agent tập trung vào thay đổi tối thiểu, agent khác đề xuất chỉnh test nhỏ, và bạn review diff. Nền tảng như Koder.ai xây xung quanh kiểu phát triển lặp, chat-first—khiến “tests as the next prompt” như chế độ mặc định chứ không phải kỹ thuật đặc biệt.

Đo lường thành công mà không theo các chỉ số phù phiêu

Tạo kiểm thử tự động có thể làm suite test to lên qua đêm—nhưng “to” không bằng “tốt.” Mục tiêu là niềm tin: bắt regressions sớm, giảm lỗi production, và giữ nhịp đội.

Chỉ số phản ánh chất lượng

Bắt đầu với tín hiệu liên kết tới kết quả bạn quan tâm:

- Tỷ lệ build pass (trên main): nếu merge thường xuyên phá, test sinh có thể quá giòn hoặc prompt tạo giả định sai.

- Tỷ lệ test flaky: theo dõi test thất thường. Tăng flaky là thuế lên lòng tin dev.

- Thời gian phát hiện regressions: từ lúc introduce bug đến khi CI báo. Test sinh nên rút ngắn cửa sổ này.

Xem coverage như gợi ý, không phải số mục tiêu

Coverage hữu ích để phát hiện path chưa test—nhưng dễ bị đánh lừa. Test sinh có thể tăng coverage mà assert ít hoặc sai. Ưu tiên chỉ số như:

- Số assert trung bình trên test (chỉ để kiểm tra nhanh)

- Kết quả mutation testing (nếu dùng)

- Test fail khi bạn cố tình phá behavior

Tập trung vào “lỗi bắt trước release”

Nếu chỉ theo dõi số test hay coverage, bạn sẽ tối ưu cho khối lượng. Theo dõi lỗi bị bắt trước release: bug tìm thấy trong CI, QA, hoặc staging mà lẽ ra đến user. Khi tạo kiểm thử tự động hoạt động, con số này tăng lên (bắt nhiều bug) trong khi incidents production giảm.

Lên lịch dọn dẹp để giữ lợi ích

Suite sinh cần bảo trì. Đặt task định kỳ để:

- Xóa test trùng hoặc không thêm giá trị

- Ổn định hoặc xoá test flaky

- Gộp các case chồng chéo thành test rõ ràng, thể hiện ý định

Thành công là CI bình tĩnh hơn, phản hồi nhanh hơn, và ít bất ngờ—not một dashboard hoành tráng.

Những bẫy phổ biến và kế hoạch triển khai thực tế

Tạo kiểm thử tự động có thể tăng chất lượng nhanh—nhưng chỉ khi bạn coi nó là trợ thủ, không phải thẩm phán. Các lỗi lớn thường lặp lại giữa các đội, và có thể tránh được.

Bẫy phổ biến

Tin quá mức vào công cụ là cái bẫy kinh điển: test sinh tạo ảo giác an toàn trong khi bỏ sót rủi ro thật. Nếu mọi người ngừng suy nghĩ (“công cụ viết test, thế là đủ”), bạn sẽ ship lỗi nhanh hơn—chỉ khác là có nhiều dấu tích xanh hơn.

Vấn đề khác là test kiểm tra chi tiết nội bộ thay vì hành vi. Công cụ AI thường bám vào tên hàm hiện tại, helper nội bộ, hoặc thông báo lỗi chính xác. Những test này dễ vỡ: refactor phá chúng dù feature còn tốt. Ưu tiên test mô tả điều gì phải xảy ra, không phải cách xảy ra.

Bảo mật và riêng tư: đừng lộ thứ không nên chia sẻ

Tạo test thường sao chép mã, stack trace, logs, hoặc spec vào prompt. Điều đó có thể lộ secrets (API key), dữ liệu khách hàng, hoặc logic độc quyền.

Giữ prompt và fixtures không chứa thông tin nhạy cảm:

- Lọc token, credentials, và URL nội bộ.

- Tránh dán logs production chứa dữ liệu cá nhân.

- Dùng ví dụ tổng hợp (fake accounts, fake IDs) cho data test.

- Nếu phải chia case thật, ẩn danh tối đa.

Nếu dùng nền tảng AI hosted, vẫn giữ kỷ luật này. Ngay cả khi nền tảng hỗ trợ triển khai theo vùng, prompt và fixtures vẫn là phần của posture bảo mật.

Kế hoạch triển khai thực tế (đội thực sự theo được)

Bắt đầu nhỏ và biến nó thành thói quen:

- Chọn một service hoặc module thay đổi thường xuyên.

- Sinh unit test cho các path rủi ro cao (chuyển tiền, quyền, biến đổi dữ liệu).

- Thêm rule CI đơn giản: feature mới do AI viết phải kèm test.

- Yêu cầu checklist review nhanh: “Test này assert hành vi chứ? Nó fail vì lý do đúng không?”

- Theo dõi các regressions bị ngăn (không chỉ coverage), rồi mở rộng sang integration khi unit test ổn định.

Mục tiêu không phải tối đa test—mà feedback đáng tin giúp mã do AI viết giữ trung thực.