Tại sao các quyết định sớm của Joe Beda về Kubernetes vẫn quan trọng

Joe Beda là một trong những người then chốt đằng sau thiết kế ban đầu của Kubernetes—cùng với các nhà sáng lập khác mang bài học từ hệ thống nội bộ của Google ra một nền tảng mở. Ảnh hưởng của ông không phải là chạy theo tính năng thời thượng; mà là chọn các nguyên thủy đơn giản có thể chịu nổi sự hỗn loạn trong môi trường production và vẫn dễ hiểu cho các nhóm hàng ngày.

Những quyết định ban đầu đó là lý do Kubernetes trở thành hơn một “công cụ container”. Nó biến thành một nhân (kernel) có thể tái sử dụng cho nền tảng ứng dụng hiện đại.

Điều phối container, nói một cách đơn giản

“Điều phối container” là tập hợp quy tắc và tự động hóa giữ cho ứng dụng của bạn chạy khi máy hỏng, lưu lượng tăng đột biến, hoặc khi bạn triển khai phiên bản mới. Thay vì một người trực máy chủ, hệ thống sẽ lên lịch container lên máy, khởi động lại khi crash, phân tán để tăng khả năng chịu lỗi và thiết lập mạng để người dùng có thể truy cập.

Sự lộn xộn trước Kubernetes

Trước khi Kubernetes phổ biến, các nhóm thường khâu vá các script và công cụ tùy biến để trả lời những câu hỏi cơ bản:

- Container này nên chạy ở đâu ngay bây giờ?

- Nếu một node chết lúc 2 giờ sáng thì sao?

- Làm sao deploy an toàn mà không downtime?

- Các service tìm nhau thế nào khi IP liên tục thay đổi?

Những hệ thống DIY đó hoạt động—cho đến khi không còn hoạt động nữa. Mỗi app hoặc nhóm mới thêm logic một lần, và nhất quán vận hành rất khó đạt được.

Bài viết này đề cập gì

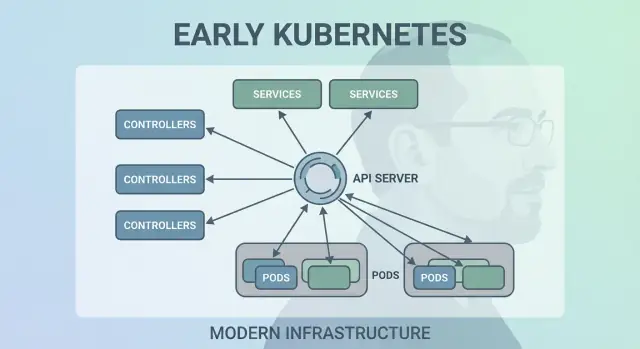

Bài viết đi qua các lựa chọn thiết kế sớm của Kubernetes ("hình dạng" của Kubernetes) và lý do chúng vẫn ảnh hưởng đến nền tảng hiện đại: mô hình khai báo, controllers, Pods, labels, Services, một API mạnh, trạng thái cluster nhất quán, lập lịch có thể cắm được và khả năng mở rộng. Ngay cả khi bạn không chạy Kubernetes trực tiếp, nhiều khả năng bạn đang dùng một nền tảng xây trên những ý tưởng này—hoặc đang vật lộn với cùng vấn đề.

Vấn đề Kubernetes nhắm tới

Trước Kubernetes, “chạy container” thường nghĩa là chạy vài container. Các nhóm ghép các bash script, cron job, golden image và vài công cụ tạm thời để deploy. Khi có sự cố, cách sửa thường nằm trong đầu ai đó—hoặc trong một README không ai tin tưởng. Vận hành là chuỗi các can thiệp một lần: khởi lại process, đổi cấu hình load balancer, dọn disk, và đoán máy nào an toàn để chạm vào.

Container ở quy mô lớn tạo ra chế độ lỗi mới

Container làm việc đóng gói dễ hơn, nhưng không xóa đi phần lộn xộn của production. Ở quy mô, hệ thống thất bại theo nhiều cách hơn và thường xuyên hơn: node biến mất, mạng phân đoạn, image triển khai không đồng đều, và workload lệch so với những gì bạn nghĩ đang chạy. Một deploy “đơn giản” có thể biến thành một chuỗi sự cố—một số instance được cập nhật, một số không, một vài bị kẹt, một vài khỏe nhưng không truy cập được.

Vấn đề thực sự không phải là khởi chạy container. Mà là giữ đúng container chạy, ở đúng hình dạng, bất chấp sự đổi thay liên tục.

Một mô hình nhất quán trên hạ tầng

Các nhóm cũng đang xoay giữa nhiều môi trường: phần cứng on‑prem, VM, nhà cung cấp cloud sơ khai, và các thiết lập mạng/lưu trữ khác nhau. Mỗi nền tảng có ngôn ngữ và kiểu lỗi riêng. Thiếu một mô hình chung, mỗi lần di chuyển lại phải viết lại công cụ vận hành và đào tạo lại người.

Kubernetes hướng tới cung cấp một cách duy nhất, nhất quán để mô tả ứng dụng và nhu cầu vận hành, bất kể máy nằm ở đâu.

Kỳ vọng về “nền tảng” trông như thế nào

Developer muốn self‑service: deploy không cần ticket, scale không cần xin tài nguyên, rollback không kịch tính. Ops muốn tính dự đoán: health check chuẩn, deploy lặp lại được, và một nguồn chân lý rõ ràng về những gì nên chạy.

Kubernetes không cố gắng làm một scheduler hoa mỹ. Nó muốn là nền tảng cho một hệ ứng dụng đáng tin cậy—biến thực tế lộn xộn thành một hệ thống bạn có thể lý giải.

Quyết định 1: Mô hình khai báo, trạng thái mong muốn

Một trong những lựa chọn ảnh hưởng nhất là làm cho Kubernetes khai báo: bạn mô tả những gì bạn muốn, và hệ thống làm cho thực tế khớp với mô tả đó.

Trạng thái mong muốn, giải thích như bộ điều nhiệt

Bộ điều nhiệt là ví dụ hàng ngày hữu ích. Bạn không bật tắt máy sưởi liên tục. Bạn đặt nhiệt độ mong muốn—ví dụ 21°C—và bộ điều nhiệt liên tục kiểm tra phòng và điều chỉnh máy sưởi để giữ gần mục tiêu đó.

Kubernetes cũng vậy. Thay vì nói với cluster từng bước “khởi chạy container này trên máy kia, rồi khởi động lại khi nó fail,” bạn khai báo kết quả: “Tôi muốn 3 bản sao của app này chạy.” Kubernetes liên tục kiểm tra những gì thực sự chạy và chỉnh sửa sai lệch.

Ít bước thủ công, ít bất ngờ hơn

Cấu hình khai báo làm giảm danh sách các bước vận hành ẩn thường nằm trong đầu ai đó hoặc trong runbook cũ nửa vời. Bạn áp dụng cấu hình, và Kubernetes xử lý cơ học—đặt chỗ, khởi động lại, và hòa giải thay đổi.

Nó cũng làm cho việc xem xét thay đổi dễ hơn. Một thay đổi hiển thị dưới dạng diff trong cấu hình, không phải một loạt lệnh ad‑hoc.

Lặp lại giữa các môi trường

Bởi vì trạng thái mong muốn được viết ra, bạn có thể tái sử dụng cách tiếp cận trong dev, staging và production. Môi trường có thể khác, nhưng ý định giữ nhất quán, khiến việc deploy dự đoán được và dễ kiểm toán.

Những đánh đổi

Hệ thống khai báo có đường cong học tập: bạn phải nghĩ theo “cái gì nên đúng” thay vì “tiếp theo tôi làm gì.” Chúng cũng phụ thuộc nhiều vào mặc định tốt và quy ước rõ—nếu không, các nhóm có thể tạo ra cấu hình kỹ thuật đúng nhưng khó hiểu và bảo trì.

Quyết định 2: Control loops (controllers) làm động cơ

Kubernetes không thành công vì chỉ chạy container một lần—mà vì nó giữ chúng chạy đúng theo thời gian. Bước thiết kế lớn là biến “control loops” (controllers) thành động cơ lõi của hệ thống.

Controller là gì

Một controller là vòng lặp đơn giản:

- Nhìn trạng thái hiện tại (những gì đang chạy)

- So sánh với trạng thái mong muốn (những gì bạn yêu cầu)

- Thực hiện hành động cho đến khi hai bên khớp

Nó giống autopilot hơn là một nhiệm vụ một lần. Bạn không “trông nom” workload; bạn khai báo ý định, và controllers lái cluster trở lại kết quả đó.

Xử lý crash, mất node và drift

Mẫu này là lý do Kubernetes bền bỉ khi mọi thứ đời thực gặp sự cố:

- Container crash: controller thấy số instance ít hơn mong muốn và khởi tạo thay thế.

- Node mất: khi một node biến mất, controllers lập lịch lại pods chỗ khác để khôi phục số lượng mong muốn.

- Configuration drift: nếu ai đó thay đổi hoặc xóa tài nguyên, controllers hòa giải khác biệt và sửa lại.

Thay vì coi lỗi là trường hợp đặc biệt, controllers coi đó là “mismatch trạng thái” và sửa theo cùng một cách mỗi lần.

Tại sao nó scale tốt hơn script

Script tự động truyền thống thường giả định môi trường ổn định: thực thi bước A rồi B rồi C. Trong hệ phân tán, giả định đó thường vỡ. Controllers scale tốt hơn vì chúng idempotent (an toàn chạy lặp lại) và eventually consistent (liên tục cố cho đến khi đạt mục tiêu).

Ví dụ thường gặp: Deployments và ReplicaSets

Nếu bạn dùng Deployment, bạn đã dựa vào control loops. Ở dưới, Kubernetes dùng controller ReplicaSet để đảm bảo số pod theo yêu cầu tồn tại—và một controller Deployment để quản lý rolling update và rollback có thể dự đoán được.

Quyết định 3: Pods là đơn vị lập lịch nguyên tử

Kubernetes có thể chỉ lên lịch “container thôi”, nhưng đội của Joe Beda đã giới thiệu Pods để biểu diễn đơn vị deploy nhỏ nhất mà cluster đặt trên một máy. Ý chính: nhiều ứng dụng thực sự không chỉ là một tiến trình đơn. Chúng là một nhóm nhỏ các tiến trình gắn chặt cần sống cùng nhau.

Tại sao Pods thay vì container đơn lẻ?

Pod là một bọc quanh một hoặc nhiều container cùng chia sẻ số phận: chúng khởi động cùng nhau, chạy trên cùng một node, và scale cùng nhau. Điều này làm cho các mẫu như sidecars trở nên tự nhiên—ví dụ log shipper, proxy, config reloader hay agent bảo mật luôn song hành với app chính.

Thay vì dạy mọi app tích hợp các trợ thủ đó, Kubernetes cho phép bạn đóng gói chúng như các container riêng nhưng vẫn hành xử như một đơn vị.

Pods giúp gì cho mạng và lưu trữ

Pods làm hai giả định quan trọng trở nên thực tế:

- Mạng: các container trong một Pod chia sẻ danh tính mạng (một IP và không gian port). App chính có thể nói chuyện với sidecar qua

localhost, đơn giản và nhanh.

- Lưu trữ: các container trong Pod có thể chia sẻ volumes. Một helper có thể ghi file mà app chính đọc (hoặc ngược lại), không cần trung gian phức tạp.

Những lựa chọn này giảm nhu cầu code glue tùy biến, trong khi vẫn giữ container biệt lập ở mức tiến trình.

Nơi Pods làm người mới bối rối

Người mới thường nghĩ “một container = một app”, rồi bị vấp bởi khái niệm ở mức Pod: restart, IP và scale. Nhiều nền tảng làm mượt điều này bằng cách cung cấp template có quan điểm sẵn (ví dụ “web service”, “worker”, hoặc “job”) tạo Pod phía sau—nhờ đó các nhóm hưởng lợi từ sidecars và tài nguyên chia sẻ mà không phải nghĩ về cơ chế Pod hàng ngày.

Quyết định 4: Labels và Selectors để ràng buộc lỏng

Giữ quyền sở hữu mã nguồn đầy đủ

Lấy bản xuất mã nguồn khi bạn muốn tùy chỉnh sâu hơn hoặc dùng pipeline riêng.

Một lựa chọn sớm nhưng mạnh mẽ là coi labels như metadata hạng nhất và selectors là cách chính để “tìm” các thứ. Thay vì gắn quan hệ cứng (như “ba máy này chạy app của tôi”), Kubernetes khuyến khích mô tả nhóm bằng thuộc tính chung.

Labels: tag linh hoạt cho mọi thứ

Label là cặp key/value đơn giản bạn gắn cho tài nguyên—Pods, Deployments, Nodes, Namespaces, và hơn thế nữa. Chúng hoạt như những “tag” nhẹ và có thể truy vấn:

app=checkoutenv=prodtier=frontend

Bởi vì labels nhẹ và do người dùng định nghĩa, bạn có thể mô hình hóa thực tế tổ chức: team, trung tâm chi phí, vùng tuân thủ, kênh phát hành, hoặc bất cứ gì quan trọng cho vận hành.

Selectors: quan hệ không phụ thuộc chặt

Selectors là truy vấn trên labels (ví dụ “tất cả Pods nơi app=checkout và env=prod”). Điều này tốt hơn danh sách host cố định vì hệ thống tự thích nghi khi Pods được reschedule, scale lên/xuống, hoặc thay thế trong rollout. Cấu hình của bạn giữ ổn định ngay cả khi các instance bên dưới thay đổi liên tục.

Gom nhóm động ở quy mô

Thiết kế này giúp vận hành ở quy mô: bạn không quản lý hàng nghìn danh tính instance—bạn quản lý vài bộ label có ý nghĩa. Đó là tinh thần của loose coupling: các thành phần kết nối tới nhóm có thể thay đổi thành viên một cách an toàn.

Labels còn làm được nhiều hơn nhóm

Khi labels tồn tại, chúng trở thành ngôn ngữ chung trên nền tảng. Chúng dùng cho định tuyến lưu lượng (Services), ranh giới chính sách (NetworkPolicy), lọc observability (metrics/logs), và thậm chí theo dõi chi phí. Một ý tưởng đơn giản—gắn tag nhất quán—mở ra cả hệ sinh thái tự động hóa.

Quyết định 5: Services cho mạng ổn định

Kubernetes cần một cách để làm cho mạng trở nên dự đoán được mặc dù các container thay đổi liên tục. Pods bị thay thế, reschedule, và scale—vì vậy IP và máy cụ thể sẽ thay đổi. Ý tưởng lõi của Service là đơn giản: cung cấp “cửa trước” ổn định cho một tập Pods dịch chuyển.

Truy cập ổn định tới Pods thay đổi

Service cung cấp một IP ảo và tên DNS ổn định (như payments). Đằng sau tên đó, Kubernetes liên tục theo dõi Pods nào khớp selector của Service và định tuyến lưu lượng tương ứng. Nếu một Pod chết và một Pod mới xuất hiện, Service vẫn trỏ đúng mà không cần bạn chạm vào cấu hình ứng dụng.

Khám phá dịch vụ làm đơn giản cấu hình

Cách tiếp cận này loại bỏ nhiều nối dây thủ công. Thay vì gắn IP vào file config, ứng dụng có thể dựa vào tên. Bạn deploy app, deploy Service, và các thành phần khác tìm nó qua DNS—không cần registry custom, không endpoint hard‑code.

Cân bằng tải tích hợp cho độ tin cậy

Service cũng đưa hành vi cân bằng tải mặc định giữa các endpoint khỏe mạnh. Điều đó nghĩa là các nhóm không cần tự xây (hoặc dựng lại) load balancer cho mỗi microservice nội bộ. Phân phối lưu lượng giảm bán kính thiệt hại khi một Pod lỗi và làm cho rolling update ít rủi ro hơn.

Giới hạn—và Ingress/Gateway mở rộng thế nào

Service tốt cho tầng L4 (TCP/UDP), nhưng không mô hình hóa quy tắc HTTP, TLS termination, hay chính sách edge. Đó là nơi Ingress và ngày càng nhiều Gateway API xuất hiện: chúng dựa trên Services để xử lý hostname, path và điểm vào ngoài tinh tế hơn.

Quyết định 6: API như bề mặt sản phẩm

Một trong những lựa chọn sớm lặng lẽ nhưng mang tính cách mạng là coi Kubernetes như một API để xây dựng lên—không phải một công cụ đơn khối để “dùng”. Tư duy API‑first khiến Kubernetes giống nền tảng mà bạn có thể mở rộng, script và quản lý.

Tại sao API‑first thay đổi việc xây nền tảng

Khi API là bề mặt, các đội nền tảng có thể chuẩn hóa cách mô tả và quản lý ứng dụng, bất kể UI, pipeline hay portal nội bộ nào đứng trên. “Deploy một app” trở thành “submit và cập nhật các đối tượng API” (như Deployments, Services, ConfigMaps), điều này là một hợp đồng sạch giữa đội app và nền tảng.

Vì mọi thứ đi qua cùng một API, công cụ mới không cần backdoor đặc quyền. Dashboard, GitOps controllers, engine policy và hệ thống CI/CD đều có thể hoạt động như client API bình thường với quyền giới hạn.

Sự đối xứng này quan trọng: cùng luật, auth, audit và admission control áp dụng cho mọi yêu cầu dù đến từ người, script hay UI nền tảng.

Phiên bản và tương thích cho cluster tồn tại lâu

Versioning API cho phép Kubernetes tiến hóa mà không phá mọi cluster hoặc mọi công cụ ngay lập tức. Có thể dàn trải deprecation; tương thích có thể kiểm thử; upgrade có thể lên kế hoạch. Với tổ chức chạy cluster nhiều năm, đó là khác biệt giữa “chúng ta có thể nâng cấp” và “chúng ta kẹt.”

kubectl thực sự đại diện cho gì

kubectl không phải là Kubernetes—nó là một client. Mô hình tư duy này đẩy các đội nghĩ theo workflow API: bạn có thể thay kubectl bằng automation, web UI hoặc portal tùy chỉnh, và hệ thống vẫn nhất quán vì hợp đồng là API.

Quyết định 7: Trạng thái cluster tập trung (etcd) và tính nhất quán

Làm giống sản phẩm thực sự

Đặt ứng dụng của bạn lên tên miền tùy chỉnh khi đã sẵn sàng cho đồng đội hoặc người dùng.

Kubernetes cần một “nguồn sự thật” duy nhất cho trạng thái hiện tại của cluster: Pod nào tồn tại, node nào khỏe, Service trỏ tới đâu, và những đối tượng nào đang được cập nhật. Đó là vai trò của etcd.

etcd làm gì (nói đơn giản)

etcd là cơ sở dữ liệu cho control plane. Khi bạn tạo Deployment, scale ReplicaSet, hay cập nhật Service, cấu hình mong muốn được ghi vào etcd. Controllers và các thành phần control‑plane khác theo dõi trạng thái lưu trữ đó và làm cho thực tế khớp.

Tại sao nhất quán quan trọng khi mọi thứ hành động cùng lúc

Cluster Kubernetes đầy các phần di chuyển: scheduler, controllers, kubelet, autoscaler và admission checks đều có thể phản ứng đồng thời. Nếu họ đọc các phiên bản “sự thật” khác nhau, bạn sẽ gặp race—như hai thành phần đưa ra quyết định mâu thuẫn về cùng một Pod.

Tính nhất quán mạnh của etcd đảm bảo rằng khi control plane nói “đây là trạng thái hiện tại,” mọi người đều cùng đồng bộ. Sự đồng bộ đó khiến các control loops dự đoán được thay vì rối loạn.

Ảnh hưởng tới backup, upgrade và phục hồi thảm họa

Vì etcd giữ cấu hình và lịch sử thay đổi của cluster, nó cũng là thứ bạn bảo vệ khi:

- Backup: không có snapshot etcd, bạn không thể khôi phục đối tượng cluster đáng tin cậy.

- Upgrade: chăm sóc sức khỏe etcd và snapshot giảm rủi ro khi nâng cấp.

- Disaster recovery: phục hồi etcd thường là con đường nhanh nhất để đưa control plane trở lại với cùng ý định.

Hướng dẫn thực tế

Đối xử trạng thái control‑plane như dữ liệu quan trọng. Chụp etcd snapshots định kỳ, thử phục hồi, và lưu backup ra ngoài cluster. Nếu dùng managed Kubernetes, tìm hiểu cái nhà cung cấp sao lưu—và phần bạn vẫn phải tự sao lưu (ví dụ persistent volumes và dữ liệu ứng dụng).

Quyết định 8: Lập lịch có thể cắm được và nhận biết tài nguyên

Kubernetes không xem “workload chạy ở đâu” là chuyện phụ. Ngay từ đầu, scheduler là một thành phần riêng với nhiệm vụ rõ ràng: khớp Pods với node có khả năng chạy chúng, dựa trên trạng thái cluster hiện tại và yêu cầu của Pod.

Scheduler khớp workload tới node như thế nào

Ở mức cao, lập lịch gồm hai bước:

- Filter: loại bỏ node không thỏa điều kiện cứng (không đủ CPU/memory, thiếu label cần thiết, taint không tương thích, port đã bị chiếm, v.v.).

- Score: xếp hạng node còn lại theo ưu tiên (phân tán giữa các zone, gom cho hiệu quả, tránh hàng xóm ồn ào, tôn trọng affinity).

Cấu trúc này cho phép phát triển scheduling mà không cần viết lại mọi thứ.

Tách biệt trách nhiệm: scheduler vs runtime vs networking

Một lựa chọn thiết kế then chốt là giữ trách nhiệm rõ ràng:

- Scheduler quyết định vị trí đặt.

- Container runtime (và kubelet) thực thi trên node đã chọn.

- Lớp mạng cung cấp kết nối sau khi mọi thứ chạy.

Vì các trách nhiệm tách biệt, cải tiến ở lĩnh vực này (ví dụ plugin CNI mới) không buộc phải đổi mô hình scheduling.

Ràng buộc và ưu tiên phát triển tự nhiên

Nhận biết tài nguyên bắt đầu với requests và limits, cung cấp tín hiệu thực cho scheduler thay vì đoán mò. Từ đó, Kubernetes bổ sung các điều khiển phong phú hơn—node affinity/anti-affinity, pod affinity, priorities và preemption, taints and tolerations, và phân phối theo topology—đều xây trên nền tảng đó.

Tác động hiện đại: đa tenant và đặt chỗ hiệu quả chi phí

Cách tiếp cận này cho phép cluster chia sẻ ngày nay: các đội có thể cô lập dịch vụ quan trọng bằng priorities và taints, trong khi mọi người đều hưởng lợi từ tận dụng cao hơn. Với bin‑packing và control topology tốt hơn, nền tảng có thể đặt workload hiệu quả về chi phí mà không hy sinh độ tin cậy.

Quyết định 9: Khả năng mở rộng thay vì “một cách duy nhất tích hợp sẵn”

Kéo dài ngân sách xây dựng của bạn

Kiếm credits bằng cách chia sẻ thứ bạn xây trên Koder.ai hoặc giới thiệu đồng đội.

Kubernetes có thể đã ra với trải nghiệm PaaS đầy đủ—buildpacks, quy tắc định tuyến app, công việc nền, quy ước config và hơn thế. Thay vào đó, Joe Beda và đội sớm giữ lõi tập trung vào lời hứa nhỏ hơn: chạy và phục hồi workload đáng tin cậy, expose chúng và cung cấp API nhất quán để tự động hóa.

Tại sao Kubernetes không cố trở thành PaaS hoàn chỉnh

Một “PaaS hoàn chỉnh” sẽ ép một workflow và tập đánh đổi duy nhất lên mọi người. Kubernetes nhắm tới một nền tảng cơ sở rộng hơn có thể hỗ trợ nhiều phong cách nền tảng—từ Heroku‑like đơn giản cho developer, quản trị doanh nghiệp, pipeline batch + ML, đến điều khiển hạ tầng cơ bản—mà không khóa chặt triết lý sản phẩm.

Cách mở rộng cho phép nền tảng thêm tính năng an toàn

Cơ chế mở rộng của Kubernetes tạo ra cách có kiểm soát để phát triển khả năng:

- CRDs (CustomResourceDefinitions) thêm loại API mới (ví dụ

Certificate hoặc Database) trông như bản địa.

- Controllers/operators hòa giải các tài nguyên mới đó theo cùng mẫu desired‑state.

- Admission controllers/webhooks thi hành chính sách (bảo mật, đặt tên, quota) và gán mặc định tại ranh API.

Điều này nghĩa là đội nội bộ và vendor có thể đóng gói tính năng như add‑on, vẫn dùng primitives Kubernetes như RBAC, namespaces và audit logs.

Lợi ích—và rủi ro chính

Với vendor, nó cho phép sản phẩm phân hóa mà không fork Kubernetes. Với nội bộ, nó cho phép “nền tảng trên Kubernetes” phù hợp tổ chức.

Đánh đổi là sự bành trướng hệ sinh thái: quá nhiều CRDs, công cụ chồng chéo, và quy ước không nhất quán. Quản trị—tiêu chuẩn, ownership, versioning và quy tắc deprecation—trở thành phần công việc của nền tảng.

Những quyết định này định hình nền tảng ứng dụng hiện đại như thế nào

Các lựa chọn sớm của Kubernetes không chỉ tạo ra một scheduler container—mà tạo ra một nhân nền tảng có thể tái sử dụng. Đó là lý do nhiều nền tảng developer nội bộ (IDP) ngày nay cơ bản là “Kubernetes cộng với workflow có quan điểm”. Mô hình khai báo, controllers và API nhất quán cho phép xây các sản phẩm cao hơn—mà không phải tái phát minh việc deploy, reconcile và service discovery mỗi lần.

Kubernetes như control plane chia sẻ

Vì API là bề mặt sản phẩm, vendor và đội nền tảng có thể chuẩn hóa trên một control plane và xây trải nghiệm khác nhau trên đó: GitOps, quản lý multi‑cluster, policy, service catalog và tự động deploy. Đây là lý do lớn khiến Kubernetes trở thành mẫu số chung cho nền tảng cloud native: tích hợp nhắm vào API, không phải một UI cụ thể.

Những gì vẫn khó (thực tế Day‑2)

Dù có trừu tượng, công việc khó nhất vẫn là vận hành:

- Bảo mật: định danh, network policy, secrets và chuỗi cung ứng tin cậy

- Nâng cấp: phiên bản Kubernetes, CRDs và add‑ons chạy với tốc độ khác nhau

- Độ tin cậy: debug controllers, cấu hình sai và hàng xóm ồn ào

Cách đánh giá một nền tảng dựa trên Kubernetes

Hỏi những câu làm sáng tỏ mức độ trưởng thành vận hành:

- Làm sao xử lý upgrade, và câu chuyện rollback như thế nào?

- Phần nào là Kubernetes chuẩn vs extension độc quyền?

- Những guardrail (chính sách, mặc định, template) nào ngăn bắn vào chân?

- Hệ quan sát (events, logs, audit) ra sao, và ai chịu incidents?

Một nền tảng tốt giảm tải nhận thức mà không che mờ control plane hoặc làm cho đường thoát trở nên khó chịu.

Một lăng kính thực tế: nền tảng có giúp đội chuyển từ “ý tưởng → dịch vụ chạy được” mà không bắt mọi người phải thành chuyên gia Kubernetes ngay ngày đầu không? Các công cụ trong nhóm “vibe‑coding”—như Koder.ai—đi theo hướng này bằng cách cho phép tạo ứng dụng thật từ chat (web React, backend Go với PostgreSQL, mobile Flutter) rồi lặp nhanh với các tính năng như planning mode, snapshots và rollback. Dù bạn dùng thứ tương tự hay tự xây cổng riêng, mục tiêu giống nhau: giữ các primitive mạnh của Kubernetes trong khi giảm overhead workflow xung quanh chúng.

Kết luận và bài học thực dụng

Kubernetes có thể trông phức tạp, nhưng hầu hết “kỳ quặc” của nó là có chủ đích: đó là tập các nguyên thủy nhỏ thiết kế để ghép vào nhiều loại nền tảng.

Làm rõ hai hiểu lầm phổ biến

Thứ nhất: “Kubernetes chỉ là điều phối Docker.” Kubernetes không chủ yếu về khởi chạy container. Nó là liên tục hòa giải trạng thái mong muốn (cái bạn muốn chạy) với trạng thái thực (cái thực sự đang xảy ra), qua lỗi, rollout và thay đổi nhu cầu.

Thứ hai: “Dùng Kubernetes là bắt buộc phải microservices.” Kubernetes hỗ trợ microservices, nhưng cũng hỗ trợ monolith, job batch và nền tảng nội bộ. Các đơn vị (Pods, Services, labels, controllers, API) là trung lập; kiến trúc là lựa chọn của bạn.

Nơi độ phức tạp thực sự đến từ

Phần khó thường không phải YAML hay Pods—mà là mạng, bảo mật và sử dụng đa đội: định danh và truy cập, quản lý secrets, policy, ingress, observability, kiểm soát chuỗi cung ứng, và tạo guardrail để các đội có thể ship an toàn mà không vướng chân nhau.

Bài học ở mức quyết định bạn có thể dùng

Khi lập kế hoạch, nghĩ theo các cược thiết kế ban đầu:

- Thiết kế workflow khai báo và tự động hóa có thể hòa giải drift.

- Dùng labels/selectors để giữ coupling thấp giữa đội và thành phần.

- Đối xử API như sản phẩm: versioning, quy ước và ownership quan trọng.

Bước thực tế kế tiếp

Map yêu cầu thực tế của bạn tới các primitive Kubernetes và lớp nền tảng:

-

Workloads → Pods/Deployments/Jobs

-

Kết nối → Services/Ingress

-

Vận hành → controllers, policy và observability

Nếu bạn đánh giá hoặc chuẩn hóa, viết bản đồ này ra và thảo luận với các bên liên quan—rồi xây nền tảng tăng dần quanh các khoảng trống, không phải theo xu hướng.

Nếu bạn cũng muốn đẩy nhanh phần “xây” (không chỉ “chạy”), cân nhắc cách workflow delivery chuyển ý định thành dịch vụ có thể deploy. Với một số đội đó là tập template được quản lý; với đội khác là workflow hỗ trợ AI như Koder.ai, có thể tạo dịch vụ ban đầu nhanh rồi xuất mã nguồn để tùy chỉnh sâu hơn—trong khi nền tảng vẫn hưởng lợi từ các quyết định thiết kế lõi của Kubernetes bên dưới.