Ứng dụng web này cần giải quyết điều gì

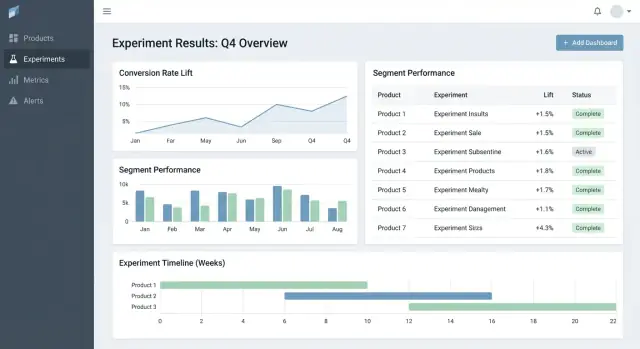

Hầu hết các đội không thất bại vì thiếu ý tưởng—mà vì kết quả bị phân tán. Một sản phẩm có biểu đồ trong công cụ phân tích, sản phẩm khác có bảng tính, sản phẩm thứ ba có slide với ảnh chụp màn hình. Vài tháng sau, chẳng ai trả lời được các câu hỏi đơn giản như “Chúng ta đã thử cái này chưa?” hoặc “Phiên bản nào thắng, dùng định nghĩa chỉ số nào?”

Vấn đề chính: kết quả phân mảnh và sự thật không nhất quán

Một ứng dụng theo dõi thử nghiệm nên tập trung hóa những gì đã được thử, tại sao, cách đo lường, và kết quả ra sao—trên nhiều sản phẩm và nhóm. Nếu không có điều này, đội sẽ lãng phí thời gian dựng lại báo cáo, tranh cãi số liệu và chạy lại các test cũ vì bài học không thể tìm kiếm được.

Dành cho ai (và mỗi nhóm cần gì)

Đây không chỉ là công cụ dành cho analyst.

- Product managers cần cách nhanh để xem kết quả, độ tin cậy và trạng thái quyết định.

- Analysts cần nơi đáng tin cậy để ghi assumptions, định nghĩa chỉ số và caveats.

- Engineers cần rõ ràng về feature flags, các biến thể và điều kiện rollout trong phạm vi.

- Lãnh đạo cần góc nhìn nhất quán về tác động giữa các sản phẩm, không cần các slide tùy biến.

Kết quả cần tối ưu

Một tracker tốt tạo giá trị kinh doanh bằng cách giúp:

- Quyết định nhanh hơn (ít mất thời gian truy tìm link và phê duyệt)

- Ít lỗi báo cáo hơn (một nguồn sự thật cho “số cuối cùng”)

- Chia sẻ học hỏi (lịch sử có thể tìm kiếm về thắng/thua/không rõ)

Ranh giới phạm vi rõ ràng

Rõ ràng: app này chủ yếu phục vụ theo dõi và báo cáo kết quả thử nghiệm—không phải chạy thử nghiệm end-to-end. Nó có thể liên kết ra các công cụ hiện có (feature flagging, analytics, kho dữ liệu) trong khi giữ bản ghi có cấu trúc của thử nghiệm và cách hiểu cuối cùng đã được thỏa thuận.

Yêu cầu: tracker thử nghiệm tối thiểu khả thi

Một tracker thử nghiệm tối thiểu nên trả lời hai câu hỏi mà không cần mò trong tài liệu hay bảng tính: chúng ta đang thử gì và chúng ta học được gì. Bắt đầu với một bộ thực thể và trường nhỏ dùng chung cho nhiều sản phẩm, rồi mở rộng khi đội thực sự cảm thấy cần.

Thực thể lõi cần hỗ trợ

Giữ mô hình dữ liệu đủ đơn giản để mọi đội dùng cùng cách:

- Product: phạm vi (app/site/API) nơi thay đổi được triển khai.

- Experiment: một giả thuyết và một quyết định.

- Variant: control và một hay nhiều treatment.

- Metric: một phép đo có tên với owner và định nghĩa.

- Segment: lát khán giả tuỳ chọn (người dùng mới, người trả phí, vùng) dùng cho báo cáo.

Các loại thử nghiệm (bắt đầu nhỏ, giữ linh hoạt)

Hỗ trợ các mô hình phổ biến ngay từ đầu:

- A/B tests (control vs treatment)

- Multivariate tests (nhiều biến thể)

- Feature flag rollouts (phân bổ theo phần trăm)

Ngay cả khi rollouts chưa dùng thống kê chính thức lúc đầu, theo dõi chúng cùng với các thử nghiệm giúp đội tránh lặp lại các “test” mà không có ghi chép.

Các trường tối thiểu mỗi thử nghiệm cần

Khi tạo, yêu cầu chỉ những gì cần để chạy và diễn giải test sau này:

- Hypothesis (thay đổi gì, cho ai, và vì sao)

- Owner (một người chịu trách nhiệm)

- Start/end dates (kế hoạch và thực tế)

- Targeting (luật eligibility) và allocation (phân chia traffic)

- Links tới rollout/flag, ticket, hay spec (URL tương đối như /projects/123)

Tiêu chí thành công và trạng thái quyết định

Làm cho kết quả có thể so sánh bằng cách bắt buộc cấu trúc:

- Primary metric (đo lường thành công chính)

- Guardrails (chỉ số không được xấu đi)

- Decision status: proposed → running → analyzed → shipped/rolled back → archived

Nếu bạn chỉ xây dựng đến đây, đội có thể tìm thử nghiệm, hiểu cấu hình và ghi kết quả đáng tin cậy—ngay cả trước khi thêm phân tích nâng cao hay tự động hoá.

Mô hình dữ liệu phù hợp cho nhiều sản phẩm

Một tracker thử nghiệm xuyên sản phẩm thành công hay thất bại dựa vào mô hình dữ liệu. Nếu ID trùng, chỉ số dao động, hoặc segment không nhất quán, dashboard có thể trông “đúng” trong khi kể chuyện sai.

Chọn định danh ổn định (và tuân thủ)

Bắt đầu với chiến lược định danh rõ ràng:

- product_id: ổn định khi đổi tên (đừng dùng display name làm key)

- experiment_key: slug thân thiện với người dùng (ví dụ

checkout_free_shipping_banner) cùng một experiment_id bất biến

- variant_key: nhãn ổn định như

control, treatment_a

Điều này cho phép so sánh kết quả giữa sản phẩm mà không phải đoán xem “Web Checkout” và “Checkout Web” có phải là cùng một thứ hay không.

Các bảng/collection lõi

Giữ các thực thể lõi nhỏ và rõ ràng:

- experiments: product_id, hypothesis, primary_metric_def_id, start/end, status

- variants: experiment_id, variant_key, traffic_split

- assignments: experiment_id, user_id (hoặc anonymous_id), variant_key, assigned_at

- metric_defs: tên metric, logic tử số/mẫu số, unit (user/session/order), owner

- results: experiment_id, metric_def_id, time_window_id, segment_id, computed_at, effect, uncertainty

Ngay cả khi phép tính diễn ra ở nơi khác, lưu kết quả cho phép dashboard tải nhanh và giữ lịch sử đáng tin cậy.

Cửa sổ thời gian và phiên bản hóa

Metric và thử nghiệm không tĩnh. Mô hình hoá:

- time windows (ví dụ “7 ngày đầu sau khi gán”, “tuần theo lịch”)

- versioned metric definitions: khi công thức metric thay đổi, tạo phiên bản mới thay vì chỉnh sửa cũ

Điều này ngăn thử nghiệm tháng trước thay đổi khi ai đó cập nhật logic KPI.

Segments và dấu vết kiểm toán

Lên kế hoạch cho các segment nhất quán giữa sản phẩm: quốc gia, thiết bị, gói, new vs returning.

Cuối cùng, thêm audit trail ghi ai thay đổi gì và khi nào (thay đổi trạng thái, phân chia traffic, cập nhật định nghĩa metric). Điều này thiết yếu cho niềm tin, review và quản trị.

Định nghĩa chỉ số và tính toán nhất quán

Nếu tracker tính metric sai (hoặc không nhất quán giữa các sản phẩm), “kết quả” chỉ là ý kiến có biểu đồ. Cách nhanh nhất để tránh điều này là xem metric như tài sản chia sẻ chứ không phải snippet truy vấn rời rạc.

Xây một danh mục metric chuẩn

Tạo danh mục metric là nguồn sự thật duy nhất cho định nghĩa, logic tính toán và quyền sở hữu. Mỗi mục metric nên gồm:

- Định nghĩa bằng tiếng thường (hỗ trợ quyết định gì)

- Owner (người/đội chịu trách nhiệm thay đổi)

- Công thức chính xác và các event/trường cần thiết

- Quy tắc loại trừ/bao gồm (ví dụ internal users, bots, đơn hoàn trả)

- Các mức tổng hợp hợp lệ và sản phẩm hỗ trợ

Giữ catalog gần nơi người ta làm việc (ví dụ: liên kết từ luồng tạo thử nghiệm) và phiên bản hóa để bạn có thể giải thích kết quả lịch sử.

Chuẩn hoá mức tổng hợp

Quyết định trước đơn vị phân tích mỗi metric dùng: theo user, session, account hay order. Conversion rate “theo user” có thể khác với “theo session” dù cả hai đều đúng.

Để giảm nhầm lẫn, lưu lựa chọn aggregation với định nghĩa metric và yêu cầu khi thiết lập thử nghiệm. Đừng để mỗi đội chọn unit tuỳ ý.

Xử lý chuyển đổi trễ và attribution

Nhiều sản phẩm có cửa sổ chuyển đổi (ví dụ: đăng ký hôm nay, mua hàng trong 14 ngày). Định nghĩa quy tắc attribution nhất quán:

- Khi nào bắt đầu tính giờ (thời điểm phơi nhiễm, lần truy cập đầu, thời điểm gán)?

- Khi người dùng bị phơi nhiễm nhiều lần thì tính conversion thế nào?

- Làm sao xử lý hành trình đa thiết bị hoặc đa sản phẩm?

Hiển thị các quy tắc này trong dashboard để người xem biết đang nhìn gì.

Lưu cả đếm thô và thống kê đã tính toán

Để dashboard nhanh và có thể kiểm toán, lưu cả:

- Đếm thô (exposures, converters, tổng doanh thu, inputs cho variance)

- Thống kê đã tính (lift, khoảng tin cậy, p-values)

Điều này cho phép render nhanh trong khi vẫn có thể tính lại khi định nghĩa thay đổi.

Quy ước đặt tên ngăn metric lan tràn

Áp dụng chuẩn đặt tên mã hóa ý nghĩa (ví dụ activation_rate_user_7d, revenue_per_account_30d). Yêu cầu ID duy nhất, cho phép bí danh và cảnh báo gần trùng khi tạo metric để giữ catalog sạch.

Thu thập dữ liệu: event, pipeline và kiểm tra chất lượng

Tracker chỉ đáng tin khi dữ liệu đưa vào đáng tin. Mục tiêu là trả lời chắc chắn hai câu cho mỗi sản phẩm: ai được phơi nhiễm variant nào, và họ làm gì sau đó? Mọi thứ khác—chỉ số, thống kê, dashboard—dựa trên nền tảng này.

Chọn phương pháp ingest

Hầu hết đội chọn một trong các mẫu:

- Event stream (gần thời gian thực): Tốt để đọc nhanh và debug nhanh. Cần maturity kỹ thuật hơn để giữ ổn định.

- Batch hàng ngày: Đơn giản hơn vận hành và rẻ hơn. Tốt khi quyết định không cần theo giờ.

- Hybrid: Stream các exposure và event quan trọng (để xác thực gán nhanh), batch phần còn lại để đầy đủ và kiểm soát chi phí.

Dù chọn gì, chuẩn hoá tập event tối thiểu across products: exposure/assignment, event chuyển đổi chính, và đủ ngữ cảnh để join (user ID/device ID, timestamp, experiment ID, variant).

Map event sản phẩm tới các chỉ số (và xác thực độ đầy đủ)

Định nghĩa mapping rõ ràng từ event thô tới metric tracker báo (ví dụ purchase_completed → Revenue, signup_completed → Activation). Duy trì mapping theo sản phẩm, nhưng giữ tên nhất quán để dashboard A/B test so sánh đúng.

Xác thực độ đầy đủ sớm:

- Xác nhận mọi exposure có experiment ID và variant.

- Đảm bảo event chuyển đổi có cùng trường định danh dùng để join exposure.

- Theo dõi sự mất mát event giữa client, server và warehouse (mobile SDK thường hay gây vấn đề).

Kiểm tra chất lượng dữ liệu nên tự động

Xây các kiểm tra chạy trên mỗi lần nạp và báo lỗi lớn:

- Thiếu event exposure: conversion không có exposure trước đó (thường do thiếu instrumentation hoặc mismatch identity).

- Phân bổ lệch: variant nhận 70/30 khi mong đợi 50/50 (có thể do bug targeting).

- Tính hợp lý timestamp: exposure sau conversion, hoặc trễ lớn gợi ý lỗi đồng hồ.

Hiển thị các cảnh báo này trong app như cảnh báo gắn với thử nghiệm, không giấu trong log.

Backfills và reprocessing

Pipeline thay đổi. Khi sửa bug instrumentation hay logic dedupe, bạn sẽ cần xử lý lại dữ liệu lịch sử để giữ metric nhất quán.

Lên kế hoạch cho:

- Transformations có phiên bản (biết logic nào tạo ra kết quả nào).

- Backfill an toàn (giới hạn theo ngày/sản phẩm/thử nghiệm).

- Dấu vết kiểm toán của việc tính lại.

Tài liệu các tích hợp

Đối xử tích hợp như tính năng sản phẩm: ghi rõ SDK hỗ trợ, schema event và bước xử lý sự cố. Nếu có khu vực docs, liên kết nó dưới dạng đường dẫn tương đối như /docs/integrations.

Thống kê và tính toán kết quả đáng tin

Phát hành bảng điều khiển sẵn quyết định

Xây dựng trang danh sách thử nghiệm, chi tiết và tổng quan sản phẩm mà không cần boilerplate thủ công.

Nếu người ta không tin số liệu, họ sẽ không dùng tracker. Mục tiêu không phải gây ấn tượng bằng toán học—mà là làm cho quyết định lặp lại được và có thể bảo vệ được xuyên sản phẩm.

Chọn một “phong cách” thống kê và duy trì

Quyết định trước app sẽ báo frequentist (p-values, confidence intervals) hay Bayesian (xác suất cải thiện, credible intervals). Cả hai đều ổn, nhưng trộn lẫn giữa các sản phẩm gây nhầm lẫn.

Một quy tắc thực tế: chọn cách tổ chức đã quen, rồi chuẩn hoá thuật ngữ, mặc định và ngưỡng.

Xác định chính xác UI hiển thị gì

Ít nhất, view kết quả nên làm rõ:

- Lift (tuyệt đối và/hoặc tương đối) so với control

- Interval (confidence interval hoặc credible interval) hiển thị như một khoảng, không chỉ điểm

- Độ mạnh bằng chứng (p-value cho frequentist, hay xác suất vượt control cho Bayesian)

Cũng hiển thị analysis window, đơn vị tính (users, sessions, orders) và phiên bản định nghĩa metric được sử dụng. Những “chi tiết” này phân biệt báo cáo nhất quán và tranh luận.

So sánh nhiều biến và chính sách “peeking”

Nếu đội test nhiều biến, nhiều metric, hoặc kiểm tra kết quả hàng ngày, false positives dễ xảy ra. App nên mã hoá một chính sách thay vì để đội tự quyết:

- Multiple comparisons: quyết định điều chỉnh (ví dụ kiểm soát false discovery rate) hoặc gắn nhãn rõ là “unadjusted exploratory”.

- Repeated peeking: hoặc (1) hạn chế bằng ngày kết thúc cố định và trạng thái “finalized”, hoặc (2) hỗ trợ phương pháp tuần tự và hiển thị gợi ý “safe-to-stop”.

Guardrails bắt lỗi phổ biến

Thêm cờ tự động hiển thị cạnh kết quả, không giấu trong log:

- Sample Ratio Mismatch (SRM): cảnh báo khi phân bổ lệch so với mong đợi.

- Phát hiện bất thường: gắn cờ giảm/nhảy đột ngột trong traffic, conversion hoặc doanh thu có thể do tracking hỏng, gián đoạn hoặc bot.

Giải thích bằng ngôn ngữ đơn giản

Bên cạnh số, thêm một giải thích ngắn cho người không chuyên có thể tin tưởng, ví dụ: “Ước lượng tốt nhất là +2.1% lift, nhưng hiệu ứng thực tế có thể nằm giữa -0.4% và +4.6%. Chúng ta chưa có bằng chứng mạnh để gọi là người thắng.”

UX và dashboard để ra quyết định nhanh

Công cụ thử nghiệm tốt giúp người dùng trả lời hai câu nhanh: Tiếp theo tôi nên xem gì? và Chúng ta nên làm gì? Giao diện nên giảm tối đa việc tìm bối cảnh và làm trạng thái quyết định rõ ràng.

Trang chính để neo workflow

Bắt đầu với ba trang bao phủ hầu hết nhu cầu:

- Experiments list: hàng đợi có thể sắp xếp cho cả tổ chức (hoặc theo sản phẩm).

- Experiment detail: nguồn sự thật duy nhất cho cấu hình, kết quả và quyết định.

- Product overview: tổng hợp các test đang chạy, quyết định gần đây, và sức khỏe chỉ số cho một sản phẩm.

Trên trang danh sách và product, làm bộ lọc nhanh và giữ trạng thái lọc: product, owner, date range, status, primary metric, segment. Người dùng nên lọc được nhanh như “Checkout experiments, owner = Maya, chạy tháng này, primary metric = conversion, segment = new users”.

Trạng thái quyết định đáng tin

Xử lý status như từ vựng có kiểm soát, không phải text tự do:

Draft → Running → Stopped → Shipped / Rolled back

Hiển thị status ở mọi nơi (danh sách, header chi tiết, và link chia sẻ) và ghi lại ai thay đổi và vì sao. Điều này ngăn “quiet launches” và kết quả mập mờ.

Bảng kết quả giúp đưa ra quyết định rõ

Trong view chi tiết thử nghiệm, dẫn đầu bằng bảng kết quả gọn cho mỗi metric:

- Baseline

- Variant

- Lift

- Uncertainty (confidence interval hoặc credible interval)

- Notes (ví dụ: caveats instrumentation, quirk segment)

Giữ đồ thị nâng cao sau phần “Chi tiết thêm” để người ra quyết định không bị quá tải.

Chia sẻ và xuất không mất kiểm soát

Thêm CSV export cho analysts và shareable links cho stakeholders, nhưng thực thi quyền truy cập: link phải tôn trọng vai trò và quyền sản phẩm. Một nút “Copy link” và hành động “Export CSV” đáp ứng hầu hết nhu cầu cộng tác.

Quyền, quyền riêng tư và quản trị

Lên kế hoạch xây dựng theo bước

Phác thảo mô hình dữ liệu, API và workflow trạng thái trước khi tạo app.

Nếu tracker phủ nhiều sản phẩm, kiểm soát truy cập và khả năng kiểm toán là bắt buộc. Đó là lý do công cụ an toàn để dùng rộng rãi và đáng tin khi review.

Kiểm soát truy cập theo vai trò (RBAC)

Bắt đầu với tập vai trò đơn giản và nhất quán:

- Viewer: chỉ đọc experiments, results và dashboards.

- Editor: tạo/chỉnh sửa thử nghiệm, tải tài liệu hỗ trợ, đặt trạng thái (draft → running → concluded).

- Admin: quản lý người dùng, quyền, định nghĩa metric, chính sách retention và tích hợp.

Giữ quyết định RBAC tập trung (một lớp policy), để UI và API cùng thực thi quy tắc.

Quyền theo sản phẩm và theo hàng

Nhiều tổ chức cần phạm vi theo sản phẩm: Team A thấy Product A nhưng không thấy Product B. Mô hình hoá điều này rõ (ví dụ user ↔ product memberships), và đảm bảo mọi truy vấn được lọc theo product.

Với trường hợp nhạy cảm (dữ liệu đối tác, segments được điều chỉnh), thêm row-level restrictions trên phạm vi sản phẩm. Cách thực tế là gắn tag nhạy cảm cho thử nghiệm (hoặc lát kết quả) và yêu cầu quyền bổ sung để xem.

Dấu vết kiểm toán: truy cập + lịch sử thay đổi

Ghi hai thứ riêng biệt:

- Change logs: ai chỉnh thử nghiệm, định nghĩa metric, hay quyết định—thay đổi gì và khi nào.

- Access logs: ai xem hoặc xuất kết quả (đặc biệt thử nghiệm nhạy cảm).

Hiển thị lịch sử thay đổi trong UI để minh bạch, và giữ log chi tiết hơn cho điều tra.

Chính sách lưu trữ và xoá

Định nghĩa retention cho:

- Metadata thử nghiệm (hypothesis, owner, dates, ghi chú quyết định)

- Kết quả đã tính (effect sizes, confidence intervals, cờ significance)

Cho phép cấu hình retention theo sản phẩm và độ nhạy. Khi dữ liệu phải bị xoá, giữ một bản tombstone tối thiểu (ID, thời gian xoá, lý do) để bảo toàn tính toàn vẹn báo cáo mà không giữ nội dung nhạy cảm.

Tính năng workflow: từ ý tưởng đến thư viện học hỏi

Tracker thật sự có ích khi bao phủ cả lifecycle thử nghiệm, không chỉ p-value cuối cùng. Tính năng workflow biến tài liệu rời rạc, ticket và đồ thị thành quy trình lặp lại giúp nâng chất lượng và dễ tái sử dụng.

Workflow lifecycle: idea → review → run → post‑mortem

Mô hình thử nghiệm như các trạng thái (Draft, In Review, Approved, Running, Ended, Readout Published, Archived). Mỗi trạng thái nên có “điều kiện kết thúc” rõ ràng để thử nghiệm không đi live thiếu essentials như hypothesis, primary metric và guardrails.

Phê duyệt không cần nặng nề. Một bước reviewer đơn giản (ví dụ product + data) và dấu vết ai phê duyệt khi nào có thể ngăn lỗi dễ tránh. Sau khi kết thúc, yêu cầu post‑mortem ngắn trước khi đánh dấu “Published” để chắc kết quả và bối cảnh được ghi lại.

Templates chuẩn hoá tư duy

Thêm mẫu cho:

- Experiment brief (mục tiêu, giả thuyết, đối tượng, metric thành công, guardrails, kế hoạch rollout)

- Analysis notes (nguồn dữ liệu, loại trừ, kiểm tra sanity, diễn giải, rủi ro)

Templates giảm ma sát “trang trắng” và giúp reviews nhanh hơn vì mọi người biết tìm gì. Giữ chúng có thể sửa theo sản phẩm nhưng preserve phần lõi chung.

Học hỏi: liên kết mọi thứ, tìm kiếm dễ dàng

Thí nghiệm hiếm khi đứng một mình—mọi người cần bối cảnh xung quanh. Cho phép attach link tới ticket/spec và writeup liên quan (ví dụ: /blog/how-we-define-guardrails, /blog/experiment-analysis-checklist). Lưu các trường “Learning” có cấu trúc như:

- Điều gì đã thay đổi (quyết định)

- Chúng ta học được gì (insight)

- Việc tiếp theo nên làm (follow-up)

Cảnh báo cho guardrails và thay đổi kết quả

Hỗ trợ thông báo khi guardrails suy giảm (ví dụ error rate, cancellations) hoặc khi kết quả thay đổi đáng kể sau dữ liệu muộn hay tính lại chỉ số. Làm cảnh báo có thể hành động: hiển thị metric, ngưỡng, khung thời gian và owner để xác nhận hoặc chuyển escalade.

View thư viện để tái sử dụng

Cung cấp thư viện lọc theo sản phẩm, khu vực tính năng, đối tượng, metric, kết quả và tag (ví dụ “pricing,” “onboarding,” “mobile”). Thêm đề xuất “thử nghiệm tương tự” dựa trên tag/metric chung để đội tránh chạy lại cùng một test và thay vào đó xây trên học hỏi trước.

Kiến trúc và lựa chọn stack kỹ thuật

Bạn không cần stack “hoàn hảo” để xây tracker—nhưng cần ranh giới rõ: dữ liệu nằm đâu, phép tính chạy ở đâu, và đội truy cập kết quả thế nào nhất quán.

Stack cơ bản thực tế

Với nhiều đội, setup đơn giản và dễ mở rộng là:

- Frontend: React (hoặc Vue) cho dashboard và workflow

- Backend API: Node.js/Express, Python/FastAPI, hoặc Java/Spring—chọn theo khả năng bảo trì của đội

- Database: Postgres cho app data (experiments, định nghĩa metric, quyền)

- Analytics warehouse: BigQuery/Snowflake/Redshift cho event data và tổng hợp nặng

Phân tách này giữ workflow giao dịch nhanh đồng thời warehouse xử lý tính toán quy mô lớn.

Nếu muốn prototype UI nhanh (experiments list → detail → readout) trước khi đầu tư full engineering, nền tảng vibe‑coding như Koder.ai có thể giúp tạo nền React + backend từ spec chat. Hữu ích để nhanh có entities, form, RBAC scaffolding và CRUD audit‑friendly, rồi lặp trên hợp đồng dữ liệu với đội analytics.

Nên để phép tính metric ở đâu?

Thường có ba lựa chọn:

- Warehouse-first: SQL models tính metric và bảng kết quả. App chủ yếu đọc.

- Backend jobs: Worker tính kết quả theo lịch hoặc khi thử nghiệm thay đổi.

- Hybrid: Tổng hợp canonical trong warehouse, backend post-processing (định dạng, guardrails, cache).

Warehouse-first thường đơn giản nếu đội dữ liệu đã quản lý SQL tin cậy. Backend-heavy phù hợp khi cần cập nhật độ trễ thấp hoặc logic tuỳ chỉnh, nhưng làm tăng độ phức tạp ứng dụng.

Hiệu năng: cache và tiền tính

Dashboard thử nghiệm lặp lại nhiều truy vấn giống nhau. Lên kế hoạch:

- Precompute rollups (aggregate hàng ngày theo experiment/variant/segment)

- Cache truy vấn nặng ở lớp API (ví dụ Redis) với quy tắc invalidation rõ

- Dùng materialized views hoặc bảng theo lịch trong warehouse cho dashboard phổ biến

Multi-tenant vs single-tenant

Nếu hỗ trợ nhiều sản phẩm/đơn vị, quyết định sớm:

- Single-tenant (schema chia sẻ): Dễ vận hành, nhưng cần lọc permission nghiêm ngặt.

- Multi-tenant: Schema/project riêng cho mỗi sản phẩm để cô lập mạnh hơn, tốn công hơn.

Giải pháp thường gặp là hạ tầng chia sẻ với model tenant_id mạnh và enforce row-level access.

Định nghĩa core APIs

Giữ bề mặt API nhỏ và rõ ràng. Hầu hết hệ thống cần endpoints cho experiments, metrics, results, segments, và permissions (cộng các read thân thiện audit). Điều này giúp thêm sản phẩm mới mà không viết lại plumbing.

Kiểm thử, giám sát và vận hành đáng tin

Thiết lập danh mục chỉ số

Tạo định nghĩa chỉ số có phiên bản để kết quả dễ so sánh theo thời gian.

Tracker chỉ hữu dụng khi người ta tin nó. Niềm tin đến từ kiểm thử kỷ luật, giám sát rõ ràng và vận hành dự đoán được—đặc biệt khi nhiều sản phẩm và pipeline cung cấp dữ liệu chung.

Observability phù hợp cách người dùng dùng app

Bắt đầu với logging có cấu trúc cho mọi bước quan trọng: ingest event, assignment, rollup metric, tính kết quả. Bao gồm identifier như product, experiment_id, metric_id, pipeline run_id để support truy tìm một kết quả về input.

Thêm metrics hệ thống (API latency, runtime job, queue depth) và metrics dữ liệu (events processed, % late events, % dropped by validation). Kết hợp tracing giữa dịch vụ để trả lời câu “Tại sao thử nghiệm này thiếu dữ liệu hôm qua?”.

Kiểm tra độ mới của dữ liệu là cách nhanh nhất ngăn lỗi im lặng. Nếu SLA là “hằng ngày trước 9am”, giám sát độ mới theo sản phẩm và nguồn, và cảnh báo khi:

- partition mới nhất thiếu

- volume event lệch mạnh so baseline

- job rollup chạy nhưng cho ra 0 rows

Kiểm thử tự động: bảo vệ dữ liệu và toán học

Tạo test ở ba mức:

- Schema và ràng buộc: trường bắt buộc, unique (ví dụ một assignment mỗi user mỗi experiment), foreign keys, range ngày hợp lệ.

- Quyền: test RBAC (viewer/editor/admin), và phạm vi sản phẩm để đội chỉ thấy những gì họ nên.

- Toán kết quả: unit tests cho lift, confidence intervals, cờ significance và các edge case (mẫu nhỏ, mẫu số bằng 0, nhiều biến).

Giữ một “golden dataset” nhỏ với output biết trước để bắt regressions trước khi deploy.

Triển khai, migration và an toàn lịch sử

Xử lý migration như phần của vận hành: phiên bản hoá định nghĩa metric và logic tính kết quả, tránh viết lại thử nghiệm lịch sử trừ khi thực sự cần. Khi phải thay đổi, cung cấp đường backfill có kiểm soát và ghi rõ gì đã thay đổi trong audit trail.

Công cụ admin cho incident và reprocessing

Cung cấp view admin để chạy lại pipeline cho một thử nghiệm/khoảng ngày cụ thể, kiểm tra lỗi validate, và gắn nhãn incident với trạng thái. Liên kết ghi chú incident trực tiếp từ thử nghiệm bị ảnh hưởng để người dùng hiểu trì hoãn và không ra quyết định trên dữ liệu không hoàn chỉnh.

Kế hoạch rollout và cạm bẫy thường gặp

Triển khai tracker xuyên sản phẩm không phải là “ngày ra mắt” mà là giảm dần sự mơ hồ: cái gì được theo dõi, ai sở hữu, và số có khớp thực tế không.

Trình tự rollout thực tế

Bắt đầu với một sản phẩm và tập chỉ số nhỏ, đáng tin (ví dụ: conversion, activation, revenue). Mục tiêu là xác thực end-to-end workflow—tạo thử nghiệm, capture exposure và outcomes, tính kết quả, và ghi quyết định—trước khi mở rộng.

Khi sản phẩm đầu ổn, mở rộng theo từng product với cadence onboarding dự đoán được. Mỗi sản phẩm mới nên là setup lặp lại, không phải dự án tuỳ biến.

Nếu tổ chức hay mắc kẹt ở vòng “xây nền tảng lâu”, cân nhắc cách hai luồng: xây durable data contracts (events, IDs, định nghĩa metric) đồng thời với lớp ứng dụng mỏng. Đội đôi khi dùng Koder.ai để dựng lớp mỏng nhanh—forms, dashboard, permission, export—rồi hoàn thiện khi tăng adoption (bao gồm xuất mã nguồn và rollback iterative qua snapshots khi yêu cầu thay đổi).

Checklist rollout cho mỗi sản phẩm mới

Dùng checklist nhẹ để onboard sản phẩm và schema event nhất quán:

- Xác nhận taxonomy event và quy ước đặt tên (và ai có quyền thay đổi)

- Kiểm tra exposure events tồn tại và gán được cho user duy nhất

- Map các metric tới schema event của sản phẩm (bao gồm edge case như refunds, cancellations)

- Chạy backfill hoặc parallel-run để so sánh với analytics hiện có

- Gán ownership cho thiết lập thử nghiệm, xác thực dữ liệu, và ghi chú quyết định cuối

Khi cần thúc đẩy adoption, liên kết “next steps” từ kết quả thử nghiệm tới khu vực sản phẩm liên quan (ví dụ, thử nghiệm giá liên kết tới /pricing). Giữ link mang tính thông tin và trung lập—không ngụ ý kết quả.

Theo dõi adoption để sửa friction sớm

Đo xem công cụ có trở thành nơi quyết định mặc định không:

- Weekly active users theo vai trò (PM, analyst, engineer)

- Experiments được tạo và hoàn thành

- Tỷ lệ có ghi chú quyết định (không chỉ xem kết quả)

- Thời gian từ kết thúc thử nghiệm → ghi nhận quyết định

Cạm bẫy phổ biến cần tránh

Thực tế, nhiều rollout vấp phải vài vấn đề lặp lại:

- Định nghĩa chỉ số không nhất quán giữa sản phẩm (cùng tên, khác công thức)

- Thiếu hoặc sai tracking exposure, dẫn đến kết quả bias

- Ownership không rõ cho validate và sign-off, tạo thử nghiệm “zombie”

- Thay đổi schema lặng lẽ làm vỡ xu hướng mà không ai biết

- Mở rộng quá nhanh sang nhiều chỉ số trước khi workflow lõi được tin dùng