Ziele definieren und die Bedeutung von Automatisierungsabdeckung klären

Bevor Sie irgendetwas bauen, schreiben Sie auf, was „Automatisierungsabdeckung“ in Ihrer Organisation bedeutet. Ansonsten wird das Dashboard zu einer Sammlung unzusammenhängender Zahlen, die verschiedene Teams unterschiedlich interpretieren.

Was zählt als Automatisierungsabdeckung?

Beginnen Sie damit, die Einheiten zu wählen, die Sie messen. Gängige Optionen sind:

- Geschäfts‑ oder Betriebsprozesse (z. B. „Neukunden‑Onboarding“): Abdeckung bedeutet „automatisierte vs. manuelle Schritte“.

- Tests (Unit/Integration/E2E): Abdeckung bedeutet „welche kritischen Flows automatisch verifiziert werden“.

- Jobs und Runbooks (geplante Tasks, Incident Playbooks): Abdeckung bedeutet „wie viel Arbeit unbeaufsichtigt laufen kann“.

- Skripte und Bots (One‑Off‑Skripte, RPA, interne Tools): Abdeckung bedeutet „wiederholbare Aufgaben mit minimaler menschlicher Intervention“.

Wählen Sie für v1 eine primäre Definition und notieren Sie sekundäre Typen für spätere Erweiterungen. Seien Sie explizit bei Randfällen, wie „teilweise automatisierte“ Schritte, die noch Genehmigungen benötigen.

Wer nutzt die App und welche Fragen müssen beantwortet werden?

Unterschiedliche Zielgruppen stellen unterschiedliche Fragen:

- Engineering / QA: Welche Bereiche sind unterautomatisiert? Was hat sich diese Woche geändert? Wo sind flaky Automationen?

- Ops / Support: Welche Workflows hängen noch von Menschen ab? Was bricht am häufigsten?

- Führung: Reduzieren wir Risiko und manuellen Aufwand über die Zeit? Welche Teams brauchen Investitionen?

Formulieren Sie 5–10 „Top‑Fragen“ und behandeln Sie sie als Produktanforderungen.

Outcomes, Umfang und Erfolgskriterien

Definieren Sie die primären Outcomes: Sichtbarkeit (was existiert), Priorisierung (was als Nächstes automatisiert werden soll), Verantwortlichkeit (wer ist zuständig) und Trendverfolgung (verbessert sich der Zustand?).

Setzen Sie klare Grenzen für v1. Beispiele: „Wir bewerten die Qualität noch nicht“, „Wir messen nicht die eingesparte Zeit“ oder „Wir schließen nur CI‑basierte Tests ein, keine lokalen Skripte.“

Bestimmen Sie, wie Erfolg aussieht: konstante Nutzung (wöchentliche aktive Nutzer), hohe Datenfrische (z. B. Updates innerhalb von 24 Stunden), weniger blinde Flecken (Abdeckung für alle kritischen Systeme) und messbare Nachverfolgung (Eigentümer zugewiesen, Lücken schrumpfen monatlich).

Datenquellen und Ingest‑Optionen kartieren

Bevor Sie Abdeckung messen können, müssen Sie wissen, wo „Automatisierungs‑Beweise“ tatsächlich liegen. In den meisten Organisationen ist Automatisierung über verschiedene Tools verstreut, die von Teams zu unterschiedlichen Zeiten übernommen wurden.

Inventarisieren Sie Ihre Automatisierungsquellen

Starten Sie mit einer pragmatischen Inventarliste, die beantwortet: Welche Signale beweisen, dass eine Aktivität automatisiert ist, und wo können wir sie abrufen?

Typische Quellen: CI‑Pipelines (Build/Test‑Jobs), Test‑Frameworks (Unit/Integration/E2E‑Ergebnisse), Workflow‑Tools (Genehmigungen, Deploys, Ticket‑Transitions), Runbooks (Skripte und dokumentierte Verfahren) und RPA‑Plattformen. Erfassen Sie für jede Quelle Identifier, mit denen Sie später joinen können (Repo, Service‑Name, Environment, Team) und den „Beweis“, den Sie speichern (Job‑Lauf, Test‑Suite‑Report, Automatisierungsregel, Skript‑Ausführung).

Systeme of Record identifizieren

Listen Sie die Systeme of Record auf, die definieren, was „existieren sollte“: Repo‑Hosting, Issue‑Tracker und CMDB/Servicekatalog. Diese Quellen liefern normalerweise die autoritative Liste von Services, Eigentümern und Kritikalität—wichtig, um Abdeckung zu berechnen statt nur Aktivität zu zählen.

Ingest‑Methoden wählen

Passen Sie jede Quelle an die am wenigsten fragilen Ingest‑Methode an:

- API‑Polling für Tools mit guten APIs, aber begrenzter Webhook‑Unterstützung.

- Webhooks wenn Sie Near‑Realtime brauchen (z. B. Pipeline‑Fertigstellungsereignisse).

- Geplante Importe für CSV‑Exporte oder Data‑Warehouse.

- Manuelle Eingabe um Lücken zu schließen (mit klarer Kennzeichnung), besonders für Runbooks oder Legacy‑Automatisierung.

Einschränkungen und Vertrauen dokumentieren

Protokollieren Sie Rate‑Limits, Authentifizierungsarten (PAT, OAuth, Service‑Accounts), Aufbewahrungsfenster und bekannte Datenqualitätsprobleme (umbenannte Services, inkonsistente Namensgebung, fehlende Eigentümer).

Planen Sie abschließend eine Quellen‑Zuverlässigkeitsbewertung pro Connector (und optional pro Metrik), damit Nutzer sehen, ob eine Zahl „hoch vertrauenswürdig“ oder „Best‑Effort“ ist. Das verhindert falsche Präzision und hilft, Connector‑Verbesserungen zu priorisieren.

Datenmodell für Abdeckung, Evidence und Ownership entwerfen

Ein nützliches Coverage‑Dashboard trennt, was Sie automatisieren wollen, von dem, was tatsächlich kürzlich gelaufen ist. Wenn Sie das mischen, sehen Ihre Zahlen gut aus, obwohl die Automatisierung veraltet ist.

Kerndatenobjekte (wenige, aber explizit)

Beginnen Sie mit diesen Bausteinen:

- Application/Service: der Produktbereich, über den Sie berichten (oft ein Repo oder Servicekatalog‑Eintrag).

- Process: der Geschäfts‑ oder Engineering‑Workflow, den Sie automatisieren wollen (z. B. „Deploy to staging“, „Invoice reconciliation“).

- Requirement: ein Ziel, das abgedeckt sein sollte (Prozessschritt, Kontrollpunkt, Testfall oder Checklistenpunkt).

- Automation Asset: das Objekt, das Abdeckung beansprucht (CI‑Workflow, Skript, Bot, Test‑Suite).

- Run (Evidence): eine einzelne Ausführung mit Status, Logs/URL und Environment.

- Owner: Person/Team, verantwortlich für das Requirement oder Asset.

Granularität früh festlegen

Wählen Sie ein primäres Reporting‑Level und bleiben Sie dabei:

- pro Service (gut für Leadership‑Rollups)

- pro Process oder Process‑Step (am besten für operative Wahrheit)

- pro Test‑Suite (funktioniert in QA‑getriebenen Organisationen)

- pro Environment (prod vs staging verändert oft die Geschichte)

Mehrere Sichten sind später möglich, aber die erste Version sollte ein „Source of Truth“‑Level haben.

Stabile Identifier (Umbenennungen nicht die Historie brechen lassen)

Verwenden Sie IDs, die Refactorings überleben:

- repo + Dateipfad (für Workflows/Skripte)

- CI‑Job/Workflow‑ID (falls stabil)

- benutzerdefinierte IDs, die in einem Manifest gespeichert sind (am besten, wenn Tools variieren)

Behandeln Sie Anzeigenamen als editierbar, nicht als Identifier.

Beziehungen modellieren: Ziele, Ansprüche und Beweise

Ein praktisches Pattern:

- Requirement ist das Ziel.

- CoverageClaim verknüpft Requirement ↔ Automation Asset (die Behauptung der Abdeckung).

- Run verknüpft sich mit einem Automation Asset (der Beweis).

Damit können Sie beantworten: „Was sollte abgedeckt sein?“, „Was beansprucht die Abdeckung?“ und „Was ist tatsächlich gelaufen?“

Frische‑Zeitstempel, die Vertrauen schaffen

Erfassen Sie:

last_seen_at (Asset existiert noch)last_run_at, last_failure_atlast_reviewed_at (eine Person hat den Anspruch bestätigt)

Frische‑Felder machen es einfach, „abgedeckte, aber veraltete“ Items hervorzuheben, ohne lange Diskussionen.

Abdeckungsmetriken und Scoring‑Regeln definieren

Wenn Ihre Abdeckungsmetrik unscharf ist, wird jedes Diagramm zur Streitfrage. Wählen Sie zuerst eine primäre Metrik für Executive‑Summaries, und fügen Sie unterstützende Aufschlüsselungen für Teams hinzu.

Wählen Sie die Metrik, die Sie optimieren wollen

Die meisten Organisationen wählen eine von diesen:

- % automatisiert nach Anzahl: am einfachsten zu erklären (z. B. „120 von 200 Tasks“). Gut, wenn Tasks ähnlich sind.

- % automatisiert nach gewichteter Arbeit: besser, wenn einige Items wesentlich größer sind. Gewichtung nach geschätzten Stunden oder Komplexität.

- % automatisiert nach Risiko: lenkt Aufmerksamkeit auf das, was wehtun kann (Kundenimpact, Compliance, Ausfälle).

Sie können alle drei anzeigen, aber machen Sie deutlich, welche die „Headline“ ist.

Definieren Sie, was „automatisiert“ bedeutet

Formulieren Sie explizite Regeln, damit Teams Items einheitlich bewerten:

- Automatisiert: läuft Ende‑zu‑Ende ohne manuelle Schritte und erzeugt ein verifizierbares Ergebnis.

- Teilweise automatisiert: Automatisierung existiert, erfordert aber noch manuelle Genehmigung, Datenvorbereitung oder häufige manuelle Fixes.

- Manuell: keine Automatisierung oder Skripte existieren, sind aber nicht zuverlässig ausführbar.

Halten Sie Regeln messbar. Wenn zwei Personen dasselbe Item unterschiedlich bewerten würden, verfeinern Sie die Definition.

Einfache Gewichtungen (Skalen kurz halten)

Verwenden Sie kleine Ganzzahlskalen (1–5) für Inputs wie Risiko, Business‑Impact, Run‑Frequenz und Zeitersparnis. Beispiel: weight = risk + impact + frequency.

Gaming verhindern durch Evidenzanforderungen

Zählen Sie ein Item nicht als „automatisiert“, es sei denn, es gibt Evidence, z. B.:

- mindestens N erfolgreiche Läufe in den letzten 30 Tagen

- ein verknüpfter CI‑Job, Lauf‑Log oder Ticket, das die Ausführung beweist

So wird Abdeckung von einer Selbstmeldung zu einem beobachtbaren Signal.

Annahmen dokumentieren

Stellen Sie die Scoring‑Regeln und Beispiele auf einer gemeinsamen Seite bereit (verlinken Sie sie aus dem Dashboard). Konsistente Interpretation macht Trends vertrauenswürdig.

Architektur wählen, die zur internen Nutzung passt

Eine interne Coverage‑App sollte im besten Sinne „langweilig“ sein: einfach zu betreiben, leicht änderbar und klar darüber, wo Zahlen herkommen. Eine einfache „API + DB + Dashboard“‑Architektur schlägt oft ein verteiltes System, bis Sie es wirklich brauchen.

Mit einem pragmatischen Stack starten

Wählen Sie einen Stack, den Ihr Team bereits unterstützt. Ein übliches Baseline‑Setup ist:

- Backend: eine einzelne Web‑API (z. B. Node/Express, Python/FastAPI, Ruby on Rails)

- Datenbank: Postgres für Kerndaten

- Frontend: ein leichtgewichtiges Dashboard (React/Vue), das die API konsumiert

Wenn Sie beim ersten internen Release schneller sein wollen, kann ein „vibe‑coding“‑Ansatz helfen: z. B. Koder.ai kann ein React‑Dashboard plus ein Go + PostgreSQL‑Backend aus einer strukturierten Spez generieren, sodass Ihr Team per Chat iteriert, während der gesamte Quellcode exportierbar bleibt.

Kernkomponenten, die Sie wirklich brauchen

Selbst in einem „einfachen“ System trennen Sie Verantwortlichkeiten:

- Ingestion Workers: ziehen Daten aus CI, Ticketing, Repos oder Test‑Tools und schreiben normalisierte Records

- API: liefert Coverage‑Metriken, Drill‑Down‑Listen und Ownership‑Sichten

- UI: Dashboards, Filter und Detailseiten für Teams/Services

- Auth: SSO + rollenbasierter Zugriff für Ansicht/Änderung von Mappings

- Background Jobs: geplante Neuberechnung, Deduplizierung, Backfills

- Notifications: Alerts, Wochen‑Digests und „Action needed“‑Meldungen

Datenbankwahl: relational + Trends

Nutzen Sie relationale Tabellen für kanonische Entitäten (Teams, Services, Automationen, Evidence, Owner). Für Trends (Runs über Zeit, Coverage‑Verlauf) behalten Sie entweder:

- eine dedizierte Time‑Series‑Tabelle in Postgres (nach Datum partitioniert), oder

- ein separates Time‑Series‑Store nur, wenn das Abfragevolumen es verlangt

Multi‑Team‑Trennung planen

Wenn mehrere Teams die App teilen, fügen Sie früh org_id/team_id‑Felder hinzu. Das ermöglicht Berechtigungen und vermeidet schmerzhafte Migrationen, wenn die Führung „ein Dashboard, aber segmentiert“ verlangt.

Führen Sie dev/staging/prod und definieren Sie, wie Daten gefördert werden:

- Verwenden Sie prod‑ähnliche Schemata überall

- In Staging ingestieren Sie mit begrenztem Scope oder synthetischen Datensätzen

- Fördern Sie Code via CI; vermeiden Sie manuelle Änderungen an Production‑Mappings (bevorzugen Sie auditable Änderungen via UI)

Für mehr zur UI‑Ergonomie siehe /blog/design-dashboard-ux.

Authentifizierung, Rollen und Sicherheitsgrundlagen

Volle Versionskontrolle behalten

Exportiere den vollständigen Quellcode, damit du Reviews, Audits und CI wie gewohnt durchführen kannst.

Ein Coverage‑Dashboard wird schnell zur Quelle der Wahrheit, daher sind Zugriffskontrolle und Datenhandhabung genauso wichtig wie Charts. Starten Sie einfach, aber so, dass Sicherheit später strenger werden kann ohne große Rewrites.

Anmeldung: SSO zuerst, Proxy für schnellen Start

Wenn Ihre Firma SSO hat, integrieren Sie es von Tag 1 (OIDC ist oft am einfachsten; SAML ist in größeren Firmen verbreitet). Für einen schnellen internen Start kann ein interner Auth‑Proxy, der Identitätsheader injiziert, ausreichen; später tauschen Sie auf native SSO um.

Normalisieren Sie Identität auf einen stabilen Nutzer‑Key (E‑Mail kann sich ändern). Speichern Sie ein minimales Nutzerprofil und holen Sie Gruppen/Team‑Membership auf Abruf, wenn möglich.

Rollen und Berechtigungen passend zur Arbeitsweise

Definieren Sie wenige Rollen und halten Sie Autorisierung über UI und API konsistent:

- Viewer: kann Dashboards und Evidence einsehen.

- Editor: kann Metadatenänderungen vorschlagen/ausführen (Ownership, Tags) und Korrekturen einreichen.

- Admin: verwaltet Integrationen, Scoring‑Regeln und globale Einstellungen.

- Service Owner (bereichsbasiert): kann Claims und Workflows nur für eigene Services ändern.

Bevorzugen Sie bereichsbasierte Berechtigungen (Team/Service) gegenüber „Super‑Usern“. Das reduziert Risiko und verhindert Bottlenecks.

Sensible Evidence sorgsam behandeln

Proofs enthalten oft Links zu CI‑Logs, Incident‑Tickets oder internen Docs. Beschränken Sie den Zugriff auf diese URLs und Roh‑Logs. Speichern Sie nur das Nötigste zur Verifikation (z. B. Build‑ID, Zeitstempel, kurze Statuszusammenfassung) statt komplette Logs zu kopieren.

Auditierung und Aufbewahrung

Jede manuelle Änderung an Coverage‑Claims oder Metadaten sollte ein Audit‑Record erzeugen: wer hat was wann und warum geändert (Freitext‑Grund). Legen Sie außerdem eine Aufbewahrungsrichtlinie für Laufhistorie und Evidence fest—definieren Sie, wie lange Daten aufbewahrt werden und implementieren Sie sicheres Löschen, sodass alte Records ohne Bruch der aktuellen Berechnungen entfernt werden können.

Dashboard‑UX für Klarheit und Drill‑Down gestalten

Ein Coverage‑Dashboard ist erfolgreich, wenn jemand drei Fragen in unter einer Minute beantworten kann: Wie stehen wir da? Was ändert sich? Was sollten wir als Nächstes beheben? Gestalten Sie die UX um diese Entscheidungen herum, nicht um die Datenquellen.

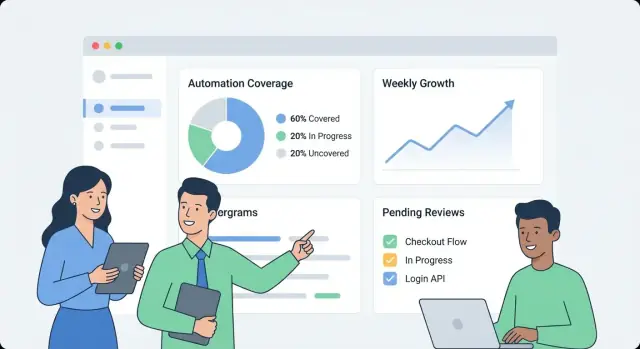

Mit einem Top‑Level „Status Board“ starten

Der erste Bildschirm sollte eine einfache Übersicht bieten:

- Gesamte Automatisierungsabdeckung (eine Headline‑Zahl) mit kurzer Tooltip‑Definition („% der Prozesse mit mindestens einem verifizierten Lauf in den letzten X Tagen“).

- Trend über Zeit (letzte 30/90 Tage), damit Teams sehen, ob Abdeckung besser oder schlechter wird.

- Frische (wie kürzlich Evidence beobachtet wurde). Ein veraltetes Signal sollte visuell unterscheidbar von einem fehlgeschlagenen Lauf sein.

- Top‑Gaps: eine Kurzliste der größten un‑ oder veralteten Bereiche, nach Impact (z. B. Kritikalität × Volumen) sortiert.

Klare Sprache verwenden („Kürzlich automatisiert“ besser als „Evidence Recency“) und technische Status nicht unnötig voraussetzen.

Drill‑Down wie eine Geschichte gestalten

Vom Überblick aus sollen Nutzer auf Service/Process‑Seiten klicken können, die „was“ und „womit“ beantworten:

- Was ist automatisiert (welche Schritte/Fähigkeiten) und was nicht.

- Durch welches Asset (Skript, Workflow, CI‑Job, RPA‑Bot), inkl. letzter Laufzeit und letztem Ergebnis.

- Eine kompakte Timeline oder Laufhistorie, die zeigt, ob Fehler Einzelfälle oder wiederkehrend sind.

Jede Zeile/Karte sollte das „Warum hinter der Zahl“ zeigen: Evidence‑Link, Owner, letzter Laufstatus und eine klare nächste Aktion („Job neu starten“, „Owner zuweisen“, „fehlende Evidence hinzufügen").

Filter, die echten Fragen entsprechen

Bieten Sie Filter an, die zur Arbeitsweise der Organisation passen:

- Team, Environment (prod/staging), Kritikalität, Datumsbereich und Quellsystem.

Halten Sie den Filter‑Status sichtbar und teilbar (URL‑Parameter), damit jemand z. B. „Prod + Tier‑1 + letzte 14 Tage“ per Link teilen kann.

Nicht‑technische Leser unterstützen ohne Unübersichtlichkeit

Nutzen Sie Inline‑Definitionen statt langer Dokus:

- Tooltips für Metriken und kurze Hinweise wie „Abdeckung schließt manuelle Checks aus.“

- Konsistente Farbsemantik (z. B. grün = verifiziert, gelb = veraltet, rot = fehlgeschlagen) mit Icons/Text für Barrierefreiheit.

- Ein „Learn what this means“‑Link zu einer internen Erläuterungsseite wie /docs/coverage-metrics.

Integrationen und Daten‑Normalisierung implementieren

Schnell ein Coverage-Dashboard erstellen

Mach Fragen zur Automatisierungsabdeckung aus einer Chat-Spezifikation zu einem funktionierenden internen Dashboard.

Integrationen machen die Coverage‑App real. Ziel ist nicht, jede Funktion Ihrer CI‑ oder Test‑Tools zu spiegeln, sondern ein konsistentes Set von Fakten zu extrahieren: was lief, wann lief es, was deckte es ab und wer ist Eigentümer.

Starten Sie mit Systemen, die bereits Automatisierungs‑Signale produzieren: CI (GitHub Actions, GitLab CI, Jenkins), Test‑Runner (JUnit, pytest) und Qualitäts‑Tools (Coverage‑Reports, Linter, Security‑Scans).

Ein Connector sollte die minimalen Felder liefern (oder per Webhook senden):

- Pipeline/Build‑Identifier und Status

- Test‑Suite‑Namen, einzelne Testergebnisse (optional) und Pass/Fail‑Counts

- Lauf‑Zeitstempel, Dauer und Environment (z. B. staging/prod)

- Repository, Branch und Commit‑SHA

Machen Sie Connectoren idempotent: wiederholte Pulls dürfen keine Duplikate erzeugen.

Manuellen Workflow für Ausnahmen anbieten

Einige Abdeckungs‑Lücken sind beabsichtigt (Legacy, Drittanbieter, pausierte Initiativen). Bieten Sie einen leichten „Exception“‑Record an, der setzt:

- einen Owner (Person oder Team)

- einen Grund/Kategorie (z. B. blocked, out of scope, deprecated)

- ein Review‑Datum (damit Ausnahmen verfallen, wenn sie nicht bestätigt werden)

Das verhindert permanente blinde Flecken und hält Führungsperspektiven ehrlich.

Quellen stimmen selten in Identifiern überein: ein System sagt „payments-service“, ein anderes „payments“, ein drittes nutzt einen Repo‑Slug.

Erstellen Sie Normalisierungsregeln für:

- Servicenamen

- Repo‑Namen

- Environments (prod, production, live → prod)

Tun Sie das früh; jede nachgelagerte Metrik hängt davon ab.

Duplikate und Umbenennungen mit Aliases handhaben

Führen Sie Alias‑Tabellen ein (z. B. service_aliases, repo_aliases), die viele externe Namen auf eine kanonische Entität mappen. Beim Eintreffen neuer Daten matchen Sie zuerst auf kanonische IDs, dann auf Aliasse.

Wenn ein neuer Name nicht matched, generieren Sie Merge‑Vorschläge (z. B. „payments‑api“ ähnelt „payments‑service“) zur Admin‑Freigabe.

Job für Datenfrische hinzufügen

Planen Sie einen wiederkehrenden Job, der den neuesten Lauf‑Zeitstempel pro Quelle prüft und alles markiert, was veraltet ist (z. B. keine CI‑Runs in 7 Tagen). Zeigen Sie das UI‑seitig an, damit niedrige Abdeckung nicht mit fehlenden Daten verwechselt wird.

Alerts, Berichte und Ownership‑Workflows ergänzen

Ein Dashboard ist nützlich, aber Alerts und leichte Workflows sind das, was interessante Daten in stetige Verbesserung verwandelt. Ziel: die richtigen Personen zur richtigen Zeit mit genug Kontext informieren, damit sie handeln können.

Alert‑Typen, die zu Aktion führen

Starten Sie mit einer kleinen Menge hochqualitativer Alerts:

- Coverage‑Drops (z. B. Service fällt nach einem Release von 80% auf 65%)

- Veraltete Evidence (Automatisierung existiert, Beweise/Links wurden seit N Tagen nicht aktualisiert)

- Fehlende oder wiederholt fehlerhafte Automationen

- Fehlende Eigentümer (Service oder kritischer Workflow ohne Verantwortlichen)

Jeder Alert sollte direkt auf die relevante Drill‑Down‑Ansicht verlinken (z. B. /services/payments?tab=coverage oder /teams/platform?tab=owners), damit Leute nicht suchen müssen.

Schwellenwerte pro Team/Service (Vermeiden lauter globaler Regeln)

Vermeiden Sie One‑Size‑Fits‑All. Lassen Sie Teams Regeln setzen wie:

- Mindestabdeckung für ihre Services

- „Stale“‑Fenster für Evidence (7 Tage für schnelle Systeme, 30 für stabile)

- Fehleranzahl oder Dauer bevor paging statt „notify only"

Das macht Signale sinnvoll und reduziert Alert‑Müdigkeit.

Benachrichtigungen + Wochen‑Zusammenfassungen

Senden Sie Alerts an bestehende Kanäle (E‑Mail, Slack) und fügen Sie hinzu: was sich geändert hat, warum es relevant ist und wer der Owner ist. Ergänzen Sie Echtzeit‑Alerts um eine wöchentliche Zusammenfassung mit:

- Änderungen seit letzter Woche

- Top‑Automatisierungs‑Chancen (größte Lücken nach Impact)

- Blockierte Items (fehlende Owner, gebrochene Pipelines, fehlende Evidence)

Bestätigen, zuweisen und nachfassen

Behandeln Sie Alerts wie Aufgaben: erlauben Sie Acknowledgement, Assignment und Status (open/triaged/resolved). Eine kurze Kommentarkette („fixed in PR #1234“) erhöht Glaubwürdigkeit und verhindert, dass das gleiche Problem still wiederkommt.

Ein Monitoring‑Dashboard wirkt schnell, wenn die API die Fragen beantwortet, die das UI tatsächlich stellt—ohne den Browser Dutzende Calls machen zu lassen. Starten Sie mit einer minimalen, dashboard‑orientierten API‑Oberfläche und fügen Sie Hintergrundjobs hinzu, die teure Berechnungen vorkomputen.

Mit einer minimalen API starten, die zum UI passt

Konzentrieren Sie die erste Version auf die Kernbildschirme:

- Services list:

GET /api/services (Filter wie team, language, tier)

- Coverage summary:

GET /api/services/{id}/coverage (Gesamt‑Score + wichtige Aufschlüsselungen)

- Evidence runs:

GET /api/services/{id}/evidence?status=passed&since=...

- Metadata aktualisieren (Owner, Tags, Status):

PATCH /api/services/{id}

Gestalten Sie Antworten so, dass das Dashboard sofort rendern kann: beinhalten Sie Service‑Name, Owner, letzten Evidence‑Zeitpunkt und aktuellen Score in einer Payload, statt viele zusätzliche Lookups zu erzwingen.

Listen und Drill‑Down‑Tabellen sollten immer paginiert sein (limit + cursor). Für häufig genutzte Endpunkte fügen Sie API‑Layer‑Caching (oder einen Shared Cache) hinzu, keyed nach Filtern und Scope des Aufrufers.

Für alles, was viele Evidence‑Records scannen müsste (z. B. „Coverage by team“), precompute Rollups in einem nächtlichen Job. Speichern Sie Rollups in einer separaten Tabelle (oder materialized view), damit Reads einfach und vorhersehbar sind.

Trends via tägliche Snapshots

Trends sind am einfachsten, wenn Sie tägliche Snapshots vorhalten:

- Ein geplanter Job berechnet täglich Coverage pro Service.

- Die API stellt

GET /api/services/{id}/trend?days=90 bereit.

Snapshots vermeiden wiederholte historische Berechnungen bei jedem Page‑Load und machen Frische leicht darstellbar.

Import/Export und Konsistenzprüfungen

Bulk‑Onboarding läuft einfacher mit:

POST /api/import/services (CSV‑Upload)GET /api/export/services.csv

Erzwingen Sie Validierungen bei Writes: erforderlicher Owner, erlaubte Statuswerte und sinnvolle Zeitstempel (kein zukünftiges Evidence). Das frühe Zurückweisen schlechter Daten verhindert langsame, verwirrende Korrekturen später—insbesondere wenn Rollups abhängen.

Deployment, Observability und Wartung

Metrikänderungen sicherer machen

Nutze Snapshots und Rollbacks, um Bewertungsänderungen zu testen, ohne vertrauenswürdige Berichte zu unterbrechen.

Ein Coverage‑Dashboard ist nur nützlich, wenn Leute ihm vertrauen. Behandeln Sie Deployment und Betrieb als Produktaufgabe: vorhersehbare Releases, klare Gesundheits‑Signale und einfache Wiederherstellung, wenn etwas kaputtgeht.

Internfreundliches Deployment starten

Optimieren Sie für geringen Overhead und schnelle Iteration:

- Intern deployen als Container‑Image plus managed DB (z. B. Postgres) oder PaaS, das geplante Jobs und Umgebungsvariablen unterstützt.

- Konfiguration außerhalb des Images halten (Env Vars oder Secret‑Manager), sodass derselbe Build über Environments gefördert werden kann.

Wenn Sie Plattformen wie Koder.ai nutzen, verwenden Sie Source‑Code‑Export und Deployment‑Workflows früh, sodass Ihre interne App weiterhin Standard‑Promotion, Review und Rollback‑Praktiken folgt.

Minimale Observability, die beantwortet „Funktioniert es?“

Sie brauchen keinen komplexen Stack, um verlässliche Signale zu erhalten:

- Instrumentieren Sie strukturierte Logs für Schlüsselereignisse: Ingestion Start/Finish, verarbeitete Records, Normalisierungsfehler.

- Tracken Sie Metriken, die zum Nutzervertrauen passen:

- Ingestion Lag (Datenverzögerung)

- Job Failures (Connectoren, Parser, Scoring‑Jobs)

- API Latency (p95 für Kernendpunkte)

- Exponieren Sie Health Checks (liveness/readiness) und eine kleine Admin‑Seite, die Connector‑Status, letzten erfolgreichen Sync und die neueste Fehlermeldung zeigt.

Backups und Restore: testen, nicht annehmen

Richten Sie automatisierte DB‑Backups mit geeigneter Aufbewahrung ein:

- Planen Sie Backups und verifizieren Sie, dass Sie in eine neue Instanz wiederherstellen können.

- Führen Sie eine kurze Restore‑Übung nach Schemaänderungen oder Connector‑Upgrades durch.

Runbooks für den Betrieb halten die App „langweilig"

Dokumentieren Sie Runbooks für:

- Rotieren von Secrets und API‑Tokens

- Sichere Neuanknüpfung von Imports (idempotente Jobs, Backfills)

- Incident‑Schritte: Connector deaktivieren, Rollback, und Kommunizieren der Datenfrische im Dashboard

Etwas operative Disziplin verhindert, dass „Coverage“ zu Ratespielen wird.

Rollout‑Plan, Governance und kontinuierliche Verbesserung

Ein Monitoring‑Tool hilft nur, wenn Teams es vertrauen und nutzen. Behandeln Sie den Rollout wie ein Produkt‑Launch: klein starten, klare Ownership definieren und einen Rhythmus für Updates einbauen.

Ein Team onboarden

Halten Sie Onboarding leicht und wiederholbar:

- Mapping: Services, Repos und Pipelines auflisten, die den Delivery‑Flow des Teams repräsentieren.

- Quellen verbinden: CI, Ticketing, Runbooks, Incident‑Tools, Testplattformen—was immer als Evidence dient.

- Owner zuweisen: Primärer Owner pro Service (und ein Backup). Owners sind verantwortlich für veraltete Daten und das Schließen von Lücken.

Ein gutes Ziel: „erster Dashboard‑View in 30 Minuten“, nicht eine wochenlange Konfiguration.

Review‑Rhythmus

Etablieren Sie zwei Rhythmen:

- Monatliche Coverage‑Review: jedes Team überprüft Änderungen, erklärt große Drops/Spikes und bestätigt Top‑1–3 Verbesserungen.

- Vierteljährliche Regelprüfung: Scoring‑Regeln auf Fairness und Relevanz prüfen (z. B. neuer CI‑Standard, deprecated Tools).

Governance: wer darf Definitionen ändern

Coverage‑Scores werden politisch, wenn Regeln unerwartet geändert werden. Definieren Sie eine kleine Governance‑Gruppe (oft Eng Productivity + Security/Quality), die:

- globale Definitionen (was als Evidence zählt) aktualisiert

- Scoring‑Regeln und Gewichtungen ändert

- neue Connectoren genehmigt, die viele Teams betreffen

Veröffentlichen Sie Änderungen in einem einfachen Changelog wie /docs/scoring-changelog.

Adoption messen und kontinuierlich verbessern

Messen Sie Adoption mit einfachen Kennzahlen: aktive Nutzer, getrackte Services und Frische‑Compliance (wie viele Services aktuelle Evidence haben). Nutzen Sie diese, um Iterationen zu steuern: bessere Gewichtung, reichhaltigere Evidence‑Typen und zusätzliche Connectoren—immer mit dem Ziel, manuellen Aufwand für Teams zu reduzieren.

Wenn Sie Ihre internen Learnings öffentlich teilen möchten, standardisieren Sie Build‑Notes und Templates: Teams, die Koder.ai nutzen, können z. B. Credits verdienen, indem sie Inhalte zu ihrem Entwicklungsworkflow erstellen oder andere Nutzer werben, was die Iteration interner Tools unterstützen kann.