Warum KI-generierter Code und automatisch generierte Tests zusammengehören

KI‑unterstützte Anwendungslogik bedeutet, dass die „funktionierenden“ Teile deiner Codebasis mit Hilfe einer Assistenz entworfen werden: neue Funktionen, kleine Features, Refactorings, Edge‑Case‑Behandlung und sogar Umschreibungen vorhandener Module. Du entscheidest immer noch, was gebaut wird, aber die erste Implementierungsfassung kommt oft schneller — und manchmal mit Annahmen, die du erst später bemerkst.

Automatisierte Testgenerierung ist die passende Fähigkeit auf der Verifikationsseite. Statt jeden Test von Hand zu schreiben, können Tools Testfälle und Assertions vorschlagen — basierend auf deinem Code, einer Spezifikation oder Mustern, die aus früheren Bugs gelernt wurden. In der Praxis kann das so aussehen:

- „Gegeben diese Funktionssignatur und Verzweigungen: hier sind Tests, die typische Eingaben, Grenzfälle und Fehlerpfade abdecken.“

- „Hier sind Regressionstests, die den Absturz reproduzieren, den wir in der Produktion gesehen haben.“

Die zentrale Erwartung: generierte Tests sind nicht automatisch „gut"

Ein generierter Test kann irreführend sein: Er kann das aktuelle Verhalten prüfen, selbst wenn das Verhalten falsch ist, oder Produktregeln übersehen, die in den Köpfen der Menschen und in Ticket‑Kommentaren leben. Deshalb ist menschliche Überprüfung wichtig. Jemand muss bestätigen, dass Name, Setup und Assertions des Tests die echte Absicht widerspiegeln — und nicht nur das, was der Code heute zufällig tut.

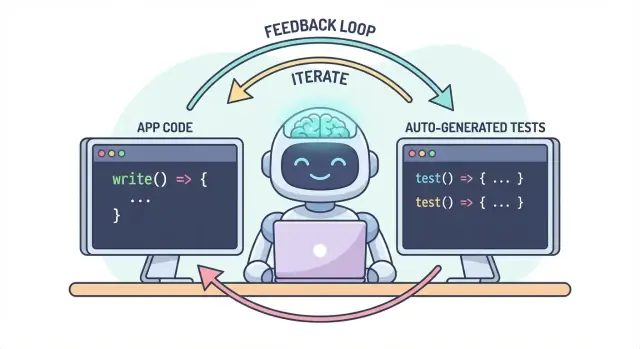

Ein Workflow, zwei Outputs

Die Kernidee ist einfach: Code und Tests sollten zusammen als ein Workflow evolvieren. Wenn KI dir hilft, Logik schnell zu ändern, hilft automatisierte Testgenerierung, das beabsichtigte Verhalten ebenso schnell festzuschreiben — sodass die nächste Änderung (menschlich oder KI) eine klare, ausführbare Definition von „immer noch korrekt" hat.

In der Praxis ist dieser „gepaarte Output“-Ansatz leichter zu pflegen, wenn dein Entwicklungsfluss bereits chatgesteuert ist. In Koder.ai (einer "vibe‑coding"‑Plattform zum Bauen von Web‑, Backend‑ und mobilen Apps via Chat) ist es zum Beispiel natürlich, „Feature + Tests“ als eine einzige Lieferung zu behandeln: Du beschreibst das Verhalten, generierst die Implementierung und erstellst dann Tests im gleichen Gespräch, die du prüfst, bevor du deployst.

Das Problem: schnellerer Code kann schnellere Bugs bedeuten

KI‑geschriebener Code kann sich wie eine Superkraft anfühlen: Features erscheinen schnell, Boilerplate verschwindet, und Refactorings, die früher Stunden dauerten, sind vor dem Kaffee fertig. Der Haken: Geschwindigkeit verändert die Risikolandschaft. Wenn Code leichter zu erstellen ist, ist es auch leichter, Fehler auszuliefern — manchmal sehr subtile.

Häufige Fehlerquellen bei KI‑generierter Logik

KI‑Assistenten sind gut darin, „vernünftige“ Implementierungen zu erzeugen, aber vernünftig ist nicht dasselbe wie korrekt für deine Domäne.

Edge Cases sind oft die ersten Opfer. KI‑generierte Logik handhabt den Happy Path häufig gut, stolpert aber bei Randbedingungen: leere Eingaben, Zeitzonen‑Eigenarten, Rundungsfehler, Null‑Werte, Retry‑Verhalten oder „das sollte nie passieren“-Zustände, die in Produktion doch auftreten.

Falsche Annahmen sind ein weiterer häufiger Fehler. Eine Assistenz kann Anforderungen inferieren, die nicht genannt wurden ("Benutzer sind immer authentifiziert", "IDs sind numerisch", "dieses Feld ist immer vorhanden"), oder sie implementiert ein vertrautes Muster, das nicht zu den Regeln deines Systems passt.

Stille Regressionen sind oft am teuersten. Du bittest um eine kleine Änderung, die Assistenz schreibt ein Stück Logik um, und etwas Unzusammenhängendes bricht — ohne offensichtliche Fehler. Der Code kompiliert noch, das UI lädt noch, aber eine Preisregel, eine Berechtigungsprüfung oder eine Datenkonvertierung ist jetzt leicht verschoben.

Warum manuelles Testen mit schnellerem Code nicht skaliert

Wenn sich Codeänderungen beschleunigen, wird manuelles Testen zum Flaschenhals und zum Glücksspiel. Entweder du verbringst mehr Zeit mit Klickarbeit (lieferst langsamer), oder du testest weniger (erhöhst Escapes). Selbst disziplinierte QA‑Teams können nicht jede Variante manuell abdecken, wenn Änderungen häufig und weitreichend sind.

Schlimmer noch: manuelle Checks sind schwer reproduzierbar. Sie leben in Erinnerungen oder Checklisten und werden leicht übersprungen, wenn Deadlines nahen—genau dann, wenn das Risiko am höchsten ist.

Tests als Sicherheitsnetz und Kommunikationsmittel

Automatisierte Tests schaffen ein dauerhaftes Sicherheitsnetz: Sie machen Erwartungen ausführbar. Ein guter Test sagt: „Gegeben diese Eingaben und diesen Kontext, ist dies das Ergebnis, auf das wir uns verlassen.“ Das ist nicht nur Verifikation; es ist Kommunikation für dein zukünftiges Ich, Teamkollegen und sogar die KI‑Assistenz.

Wenn Tests vorhanden sind, werden Änderungen weniger beängstigend, weil Feedback sofort kommt. Anstatt Probleme nach Code‑Review, in Staging oder von Kunden zu entdecken, findest du sie Minuten nach der Änderung.

Fehler früher erkennen, Nacharbeit reduzieren

Je früher ein Bug gefunden wird, desto günstiger die Behebung. Tests verkürzen die Feedback‑Schleife: Sie legen widersprüchliche Annahmen und übersehene Edge‑Cases offen, solange die Absicht noch frisch ist. Das reduziert Nacharbeit, vermeidet „fix‑forward“ Patches und verhindert, dass KI‑Geschwindigkeit zu KI‑getriebener Unruhe wird.

Wie Tests eine Feedback‑Schleife für KI‑geschriebene Logik schaffen

KI‑geschriebener Code ist am schnellsten, wenn du ihn wie ein Gespräch behandelst, nicht als einmalige Lieferung. Tests machen dieses Gespräch messbar.

Die „Spec → Code → Tests“-Schleife (in klarem Deutsch)

-

Spec: Du beschreibst, was passieren soll (Eingaben, Ausgaben, Edge Cases).

-

Code: Die KI schreibt die Implementierung, die behauptet, diese Beschreibung zu erfüllen.

-

Tests: Du (oder die KI) erzeugt Prüfungen, die beweisen, dass das Verhalten tatsächlich so ist.

Wiederhole diese Schleife und du produzierst nicht nur mehr Code — du schärfst kontinuierlich die Definition von "fertig".

Tests erzwingen klarere Anforderungen und Schnittstellen

Eine vage Anforderung wie „handle invalid users gracefully" ist einfach im Code zu übersehen. Ein Test kann nicht vage sein. Er zwingt zu Spezifikationen:

- Was zählt als „invalid“? Fehlende ID, gesperrter Status, fehlerhafte E‑Mail?

- Was heißt „gracefully“? Fehlermeldung, Statuscode, Fallback‑Wert?

- Wie ist die Schnittstelle? Funktionssignatur, Rückgabeform, Ausnahmen?

Sobald du diese Details in einem Test ausdrücken musst, treten Unklarheiten sofort zutage. Diese Klarheit verbessert den Prompt für die KI und führt oft zu einfacheren, stabileren Schnittstellen.

Generierte Tests prüfen, was der Code behauptet

KI‑Code kann korrekt aussehen und dennoch Annahmen verbergen. Generierte Tests sind ein praktischer Weg, die Ansprüche des Codes zu verifizieren:

- „Diese Funktion ist pure“ → testet, dass keine externen Seiteneffekte auftreten.

- „Behandelt Edge Cases“ → testet nulls, leere Listen, Randwerte.

- „Abwärtskompatibel“ → testet alte Eingaben und erwartete Ausgaben.

Das Ziel ist nicht, generierte Tests blind zu vertrauen — sondern sie als strukturierten Skeptizismus zu nutzen.

Fehlende Tests werden zur nächsten Eingabe für die KI

Ein fehlgeschlagener Test ist handlungsfähiges Feedback: Er zeigt eine konkrete Abweichung zwischen Spezifikation und Implementierung. Anstatt die KI allgemein zu bitten „behebe das“, kannst du den Fehler einfügen und sagen: „Aktualisiere den Code, sodass dieser Test besteht, ohne die öffentliche API zu ändern.“ Das verwandelt Debugging in eine fokussierte Iteration statt in ein Ratespiel.

Wo automatisierte Testgenerierung in deine Testpyramide passt

Automatisierte Testgenerierung ist am nützlichsten, wenn sie deine bestehende Teststrategie unterstützt — insbesondere die klassische „Testpyramide“. Die Pyramide ist kein Dogma; sie hilft, Feedback schnell und vertrauenswürdig zu halten und gleichzeitig echte Ausfälle zu entdecken.

KI kann Tests auf allen Ebenen helfen, aber die besten Ergebnisse erzielst du, wenn du mehr der günstigen Tests (unten in der Pyramide) generierst und weniger der teuren (oben). Dieses Gleichgewicht hält deine CI‑Pipeline schnell und schützt trotzdem die Nutzererfahrung.

Unit‑Tests: schnell, fokussiert und hervorragend generierbar

Unit‑Tests prüfen einzelne Funktionen, Methoden oder Module. Sie laufen schnell, brauchen keine externen Systeme und eignen sich ideal für KI‑generierte Abdeckung von Edge‑Cases.

Gute Anwendungen für automatisierte Testgenerierung hier sind:

- Eingabevalidierung und „komische“ Grenzwerte durchspielen

- Geschäftsregeln validieren (Rabatte, Berechtigungen, Zustandsübergänge)

- Bugfixes mit Regressionstests absichern, die man sonst vergisst

Da Unit‑Tests eng gefasst sind, sind sie leichter zu überprüfen und weniger anfällig für Flakiness.

Integrationstests: weniger, aber mit hohem Wert

Integrationstests prüfen, wie Komponenten zusammenarbeiten: API mit DB, ein Service, der einen anderen aufruft, Queue‑Verarbeitung, Authentifizierung usw.

KI‑generierte Integrationstests können wertvoll sein, benötigen aber Disziplin:

- Klarer Setup/Teardown, damit Tests keine Daten leaken

- Stabile Testumgebungen (Container, Testdatenbanken, ggf. Mocks)

- Assertions, die sich auf Ergebnisse konzentrieren, nicht auf interne Details

Betrachte diese als "Contract Checks", die die Nähte zwischen Komponenten sichern.

End‑to‑End‑Tests: sparsam generieren

E2E‑Tests prüfen wichtige Nutzerflüsse. Sie sind auch am teuersten: langsamer, anfälliger und schwerer zu debuggen.

Automatisierte Testgenerierung kann helfen, E2E‑Szenarien zu entwerfen, aber du solltest sie strikt kuratieren. Behalte eine kleine Menge kritischer Pfade (Signup, Checkout, Kernworkflow) und vermeide, für jede Funktion E2E‑Tests zu erzeugen.

Praktische Empfehlung: ein ausgewogenes Mix erzeugen

Ziele nicht darauf ab, alles zu generieren. Stattdessen:

- Generiere viele Unit‑Tests, um KI‑geschriebene Logik auf Funktions‑Ebene ehrlich zu halten

- Füge gezielte Integrationstests hinzu, die die risikoreichsten Schnittstellen schützen (DB, Auth, Zahlungen)

- Pflege eine minimale E2E‑Suite für die wenigen User Journeys, die du dir nicht leisten kannst, zu brechen

So bleibt die Pyramide intakt — und automatisierte Testgenerierung wird zum Multiplikator statt zur Lärmquelle.

Was generiert werden kann: aus Code, Specs und echten Bugs

Automatisierte Testgenerierung beschränkt sich nicht auf „schreibe Unit‑Tests für diese Funktion“. Die nützlichsten Generatoren schöpfen aus drei Quellen: dem vorhandenen Code, der dahinterstehenden Absicht und den Fehlern, die du bereits gesehen hast.

1) Aus der Code‑Struktur: Verhalten prüfen, nicht nur Zeilen

Gegeben eine Funktion oder ein Modul, können Tools Fälle aus Eingaben/Ausgaben, Verzweigungen und Ausnahmepfaden ableiten. Das heißt typischerweise:

- Happy‑Path‑Eingaben, die ein bekanntes Ergebnis liefern sollten

- Grenzwerte (leere Strings, 0, maximale Längen)

- Verzweigungsabdeckung (if/else‑Pfade)

- Fehlerbehandlung (ungültige Eingaben, fehlende Felder, Timeouts)

Dieser Stil ist großartig, um KI‑geschriebene Logik schnell mit Prüfungen zu umgeben, die bestätigen, was sie heute tatsächlich tut.

2) Aus Anforderungen: Intent in ausführbare Beispiele verwandeln

Wenn du Akzeptanzkriterien, User Stories oder Beispieltabellen hast, können Generatoren sie in Tests umwandeln, die wie die Spezifikation lesbar sind. Das ist oft wertvoller als code‑abgeleitete Tests, weil es „was passieren sollte“ festschreibt, nicht „was aktuell passiert".

Ein praktisches Muster: Gib ein paar konkrete Beispiele (Eingaben + erwartete Ergebnisse) und bitte den Generator, mit diesen Regeln konsistente Edge‑Cases hinzuzufügen.

3) Aus Bug‑Reports: erst reproduzieren, dann verhindern

Bug‑basierte Generierung ist der schnellste Weg, eine sinnvolle Regressionssuite aufzubauen. Füttere die Schritte zur Reproduktion (oder Logs und ein minimales Payload) und generiere:

- einen Test, der auf dem aktuellen fehlerhaften Verhalten fehlschlägt, und dann

- denselben Test, der nach dem Fix dauerhaft besteht — und so vor Wiedereinführung schützt.

Snapshot/Golden‑Tests: nützlich, mit Vorsicht

Snapshot‑Tests sind effizient für stabile Ausgaben (gerenderte UI, serialisierte Responses). Nutze sie bedacht: große Snapshots können subtile Fehler „abnicken“. Bevorzuge kleine, fokussierte Snapshots und kombiniere sie mit Assertions auf Schlüsselfelder, die korrekt sein müssen.

Priorisieren: was zuerst testen (ohne den Ozean zu kochen)

Automatisierte Testgenerierung wirkt am besten mit klaren Prioritäten. Wenn du sie auf das ganze Repo loslässt und „alle Tests“ forderst, bekommst du Lärm: viele geringwertige Prüfungen, doppelte Abdeckung und fragile Tests, die die Lieferung bremsen.

Fang dort an, wo das Business Schmerzen verspürt

Beginne mit Flows, deren Bruch am teuersten wäre — finanziell, rechtlich oder reputationsbezogen. Ein einfaches risiko‑basiertes Filter hält den Umfang realistisch und verbessert schnell die Qualität.

Konzentriere dich zuerst auf:

- Business‑kritische Pfade (Signup, Checkout, Kernworkflows) und Bereiche, die sich oft ändern (aktive Features, Refactorings, neue Integrationen).

- Hochrisiko‑Domänen: Zahlungen, Authentifizierung, Datenintegrität, Berechtigungen/Rollen und alles, was Nutzer sehen oder tun kann.

Für jeden gewählten Flow generiere Tests in Schichten: einige schnelle Unit‑Tests für die knifflige Logik plus ein oder zwei Integrationstests, die den ganzen Pfad bestätigen.

„Happy Path + Top Edge Cases" schlägt exhaustive Kombinationen

Fordere Abdeckung, die echten Fehlern entspricht, nicht theoretischen Permutationen. Ein guter Ausgang ist:

- Ein Happy‑Path‑Test, der das erwartete Verhalten belegt.

- Die Top‑Edge‑Cases, die du wirklich befürchtest: fehlende/ungültige Eingaben, abgelaufene Tokens, unzureichende Berechtigungen, Konkurrenzkonflikte und "Empty State"‑Daten.

Später kannst du basierend auf Bugs, Incident Reports oder Nutzerfeedback erweitern.

Definiere „done“, damit es auch bleibt

Mache die Regel explizit: Ein Feature ist erst fertig, wenn Tests existieren. Diese Definition von Done ist bei KI‑geschriebenem Code noch wichtiger, weil sie verhindert, dass "schnelles Ausliefern" stillschweigend zu "schnellen Regressionen" wird.

Wenn du willst, dass das bleibt, verankere es im Workflow (z. B. Tests vor Merge in CI verlangen) und verlinke die Erwartung in Team‑Dokumenten (z. B. /engineering/definition-of-done).

Prompting‑Muster, die bessere Tests erzeugen

KI kann Tests schnell generieren, aber die Qualität hängt stark davon ab, wie du fragst. Ziel ist es, das Modell zu Tests zu führen, die Verhalten schützen — nicht solche, die nur Code ausführen.

Packe deine Coding‑Standards direkt in den Prompt

Beginne damit, die Form der Tests festzulegen, damit das Ergebnis zu deinem Repo passt.

Gib an:

- Sprache + Testframework (z. B. TypeScript + Jest, Python + pytest)

- Namensregeln (z. B.

should_<behavior>_when_<condition>)

- Dateispeicherort und Struktur (z. B.

src/ und tests/ oder __tests__/)

- Konventionen (Fixtures, Factory‑Helper, Mocking‑Lib)

Das verhindert, dass das Modell Muster erfindet, die dein Team nicht nutzt.

Gib 1–2 echte Testbeispiele zum Kopieren

Füge eine bestehende Testdatei (oder ein kurzes Auszug) ein und sag explizit: „Imitiere diesen Stil.“ Das verankert Entscheidungen wie Testdaten‑Organisation, Variablenbenennung und ob table‑driven Tests bevorzugt werden.

Wenn dein Projekt Helfer hat (z. B. buildUser() oder makeRequest()), füge diese Snippets hinzu, damit die generierten Tests sie wiederverwenden statt sie neu zu implementieren.

Fordere sinnvolle Assertions (nicht nur „es läuft")

Sei explizit, was „gut" bedeutet:

- Auf Ausgaben und Zustandsänderungen asserten

- Seiteneffekte verifizieren (DB‑Schreibvorgänge, ausgesendete Events)

- Bei Bedarf Fehler‑Typen/-Nachrichten prüfen

Eine nützliche Prompt‑Zeile: „Jeder Test muss mindestens eine Assertion zum Geschäftsverhalten enthalten (nicht nur ‚keine Exception geworfen‘)."

Verlange negative und Boundary‑Tests

Die meisten KI‑generierten Suiten tendieren zum Happy Path. Gegenwirke, indem du verlangst:

- Ungültige Eingaben und erwartete Fehler

- Grenzwerte (leere Strings, 0, Max‑Länge)

- Berechtigungsfehler

- Fehlende Abhängigkeiten (z. B. null‑Responses, Timeouts)

Eine praktische Prompt‑Vorlage

Generate unit tests for <function/module>.

Standards: <language>, <framework>, name tests like <pattern>, place in <path>.

Use these existing patterns: <paste 1 short test example>.

Coverage requirements:

- Happy path

- Boundary cases

- Negative/error cases

Assertions must verify business behavior (outputs, state changes, side effects).

Return only the test file content.

Menschliche Review: sicherstellen, dass generierte Tests wirklich helfen

KI kann viele Tests schnell entwerfen, aber sie kann nicht abschließend beurteilen, ob diese Tests deine Absicht repräsentieren. Ein menschlicher Durchgang verwandelt "laufende Tests" in "Schutz‑Tests". Das Ziel ist nicht, Stil kleinzutelefonieren — es ist sicherzustellen, dass die Suite sinnvolle Regressionen abfängt, ohne Wartungslast zu werden.

Review auf Korrektheit und Relevanz

Beginne mit zwei Fragen:

- Prüft der Test Verhalten, das das Produkt wirklich braucht?

- Wäre es hilfreich, wenn dieser Test bei einer zukünftigen Änderung fehlschlägt — weil er ein echtes Problem meldet?

Generierte Tests verriegeln manchmal zufälliges Verhalten (Implementierungsdetails) statt die beabsichtigte Regel. Wenn ein Test eher wie eine Kopie des Codes wirkt als eine Beschreibung erwarteter Ergebnisse, dränge auf höher abstrahierte Assertions.

Achte auf Brittle Tests (der heimliche Produktivitätskiller)

Typische Ursachen für Flaky/fragile Tests sind Über‑Mocking, hardcodierte Timestamps und Zufallswerte. Bevorzuge deterministische Eingaben und stabile Assertions (z. B. auf geparstes Datum oder einen Bereich statt auf Date.now()‑Rohwerte). Wenn ein Test zu viel Mocking braucht, testet er vielleicht die Verdrahtung statt das Verhalten.

Stelle sicher, dass Fehlschläge aus dem richtigen Grund auftreten

Ein "passender" Test kann trotzdem nutzlos sein, wenn er auch bei gebrochenem Feature bestehen würde (False Positive). Achte auf schwache Assertions wie „wirft keine Exception“ oder nur zu prüfen, dass eine Funktion aufgerufen wurde. Stärke sie durch Assertions über Ausgaben, Zustandsänderungen, zurückgegebene Fehler oder persistente Daten.

Ein leichtes Code‑Review‑Checklist

Eine einfache Checkliste hält Reviews konsistent:

- Lesbarkeit: klare Namen, minimales Setup, offensichtliche Absicht

- Coverage der Absicht: wichtige Edge‑Cases und Fehlerpfade enthalten

- Wartbarkeit: nicht zu sehr auf Interna festgelegt; minimales Mocking

- Signalqualität: würde bei echter Regression fehlschlagen, nicht bei harmlosen Refactorings

Behandle generierte Tests wie jeden anderen Code: Merge nur, was du auch in sechs Monaten noch verantworten würdest.

Es einhalten: CI‑Checks, die KI‑Code auf Kurs halten

KI kann beim schnellen Schreiben helfen, aber der eigentliche Gewinn ist, diesen Code über die Zeit korrekt zu halten. Der einfachste Weg, Qualität zu "verriegeln", ist, Tests und Checks bei jeder Änderung automatisch laufen zu lassen — so werden Regressionen vor dem Ausliefern entdeckt.

Ein praktischer Flow, der funktioniert

Ein leichter Workflow, den viele Teams annehmen:

- Generiere oder bearbeite den Feature‑Code (KI‑assistiert oder nicht).

- Generiere Tests für das neue Verhalten (und für den Bug, den du gerade behoben hast).

- Führe alles lokal aus, um sicherzustellen, dass du grün bist.

- Committe Code + Tests zusammen.

Dieser letzte Schritt ist wichtig: KI‑geschriebener Code ohne passende Tests driftet leicht ab. Mit Tests zeichnest du das beabsichtigte Verhalten so auf, dass CI es erzwingen kann.

CI als nicht verhandelbares Sicherheitsnetz

Konfiguriere deine CI‑Pipeline so, dass sie bei jedem Pull Request (und idealerweise bei Merges in main) läuft. Mindestens sollte sie:

- Abhängigkeiten in einer sauberen Umgebung installieren

- Unit/Integrationstests ausführen

- Build bei jedem Testfehler fehlschlagen lassen

Das verhindert "auf meinem Rechner lief es"‑Überraschungen und fängt unabsichtliche Brüche ab, wenn ein Teammitglied (oder ein späterer KI‑Prompt) anderswo Code ändert.

Ergänze ein paar Qualitätsgates (leichtgewichtig)

Tests sind essenziell, aber sie fangen nicht alles ab. Füge kleine, schnelle Gates hinzu, die Testgenerierung ergänzen:

- Linting (Stil + häufige Fehler)

- Typchecks (wo anwendbar)

- Formatierungschecks (für lesbare Diffs)

Halte diese Checks schnell — wenn CI langsam oder laut wird, suchen Leute nach Wegen, ihn zu umgehen.

Kosten‑ und Kapazitätsplanung

Wenn du CI‑Runs erhöhst, weil du mehr Tests generierst, stell sicher, dass dein Budget mit dem neuen Rhythmus mithält. Wenn du CI‑Minuten trackst, lohnt sich ein Blick auf Limits und Optionen (siehe /pricing).

Mit fehlschlagenden Tests die nächste KI‑Iteration steuern

Eine überraschend effektive Arbeitsweise mit KI‑geschriebenem Code ist, fehlgeschlagene Tests als "nächsten Prompt" zu behandeln. Anstatt die Modell breit um „Feature verbessern“ zu bitten, gibst du ihm ein konkretes Scheitern und lässt dieses die Änderung einschränken.

Workflow: Failure → Prompt → Fix → Repeat

- Führe die Suite (oder CI) aus und nimm einen Fehler auf. Kopiere den fehlgeschlagenen Testnamen und die relevante Assertion‑Meldung/Stacktrace.

- Bitte die KI, nur diesen Fehler zu beheben. Gib minimalen Code‑Kontext (den fehlgeschlagenen Test und das getestete Modul) sowie die Geschäftsregel, die verletzt sein könnte.

- Fordere zuerst einen Regressions‑Test an. Wenn der Fehler aus einem Bug‑Report oder aus Produktion kommt, bitte die KI, einen Test zu ergänzen, der den Bug reproduziert, bevor die Implementierung geändert wird.

- Wende die kleinstmögliche Änderung an, die den Test grün macht. Führe die Tests sofort erneut aus.

- Gehe zum nächsten fehlschlagenden Test über. Ein Fehler nach dem anderen hält die Iteration eng und verständlich.

Prompt‑Muster: klein und verifizierbar halten

Statt:

- "Fix the login logic and update tests."

Nutze:

- "Dieser Test schlägt fehl:

shouldRejectExpiredToken. Hier die Failure‑Ausgabe und der relevante Code. Aktualisiere die Implementierung so, dass dieser Test besteht ohne nicht zusammenhängendes Verhalten zu ändern. Falls nötig, füge einen Regressions‑Test hinzu."

Warum das Hin‑ und Her reduziert

Fehlende Tests nehmen das Raten weg. Sie definieren „korrekt“ in ausführbarer Form, sodass du nicht Anforderungen im Chat neu verhandeln musst. Außerdem vermeidest du umfangreiche Änderungen: Jeder Prompt ist auf ein messbares Ergebnis begrenzt, Reviews werden schneller, und es ist leichter zu erkennen, wenn die KI nur das Symptom behebt und etwas anderes bricht.

Das ist auch ein Bereich, in dem ein Agent‑Style‑Workflow zahlt: Ein Agent macht die minimale Codeänderung, ein anderer schlägt den kleinsten Test‑Adjust vor, und du reviewst das Diff. Plattformen wie Koder.ai sind um solche iterative, chat‑first Abläufe gebaut — dadurch wirkt "Tests als nächster Prompt" wie ein normaler Modus, nicht wie eine Spezialtechnik.

Erfolg messen, ohne Vanity‑Metriken zu jagen

Automatisierte Testgenerierung kann deine Test‑Suite über Nacht wachsen lassen — aber "größer" ist nicht gleich "besser". Ziel ist Vertrauen: Regressionen früh abfangen, Produktionsfehler reduzieren und das Team in Bewegung halten.

Metriken, die wirklich Qualität widerspiegeln

Beginne mit Signalen, die auf die gewünschten Outcomes abzielen:

- Build‑Pass‑Rate (auf main): Wenn Merges häufig brechen, sind generierte Tests vielleicht zu brittle oder deine Prompts produzieren falsche Annahmen.

- Flaky‑Test‑Rate: Verfolge, wie oft Tests bei erneuten Runs unterschiedlich ausfallen. Eine steigende Flaky‑Rate ist ein Vertrauenssteuer und führt dazu, dass Teams Failures ignorieren.

- Time‑to‑detect Regressionen: Messe die Zeit zwischen Bug‑Einführung und einem fehlschlagenden CI‑Run. Generierte Tests sollten dieses Fenster verkürzen.

Coverage als Hinweis, nicht als Ziel

Coverage kann ein hilfreicher Rauchmelder sein — besonders um ungetestete kritische Pfade zu finden — aber sie ist leicht zu manipulieren. Generierte Tests können Coverage aufblasen, ohne viel zu prüfen. Bevorzuge Indikatoren wie:

- Assertions pro Test (kein KPI, aber ein Plausibilitätscheck)

- Ergebnisse von Mutationstests (falls verwendet)

- Ob Tests fehlschlagen, wenn du das Verhalten gezielt brichst

Fokus auf „Bugs, die vor Release gefunden werden"

Wenn du nur Testanzahl oder Coverage trackst, optimierst du für Menge. Messe stattdessen Fehler, die vor Release gefangen werden: Bugs, die in CI, QA oder Staging gefunden wurden und ansonsten zu Nutzern gelangt wären. Wenn automatische Testgenerierung funktioniert, sollte diese Zahl steigen, während Produktionsvorfälle sinken.

Regelmäßige Aufräumarbeit, damit die Gewinne real bleiben

Generierte Suiten brauchen Pflege. Plane wiederkehrende Aufgaben ein, um:

- Redundante Tests zu entfernen

- Flaky Tests zu stabilisieren oder zu löschen

- Überlappende Fälle zu konsolidieren und klarere, intention‑offenlegende Tests zu erstellen

Erfolg bedeutet eine ruhigere CI, schnelleres Feedback und weniger Überraschungen — nicht nur ein beeindruckendes Dashboard.

Häufige Fallstricke und ein pragmatischer Rollout‑Plan

Automatisierte Testgenerierung kann die Qualität schnell erhöhen — aber nur, wenn du sie als Helfer und nicht als Autorität behandelst. Die größten Fehler ähnlichen sich in Teams und sind vermeidbar.

Typische Fallstricke

Übermäßige Abhängigkeit ist die klassische Falle: Generierte Tests können eine Sicherheitsillusion erzeugen, während sie echte Risiken übersehen. Wenn Leute aufhören, kritisch zu denken ("Das Tool hat Tests geschrieben, also sind wir abgesichert"), wirst du schneller Bugs ausliefern — nur mit mehr grünen Häkchen.

Ein weiterer häufiger Fehler ist das Testen von Implementierungsdetails statt Verhalten. KI‑Tools greifen oft auf aktuelle Methodennamen, interne Helfer oder exakte Fehlermeldungen zurück. Solche Tests sind brittle: Refactorings brechen sie, auch wenn das Feature weiterhin funktioniert. Bevorzuge Tests, die beschreiben, was passieren soll, nicht wie es intern geschieht.

Sicherheit und Datenschutz: nicht teilen, was du nicht teilen darfst

Testgenerierung involviert oft das Kopieren von Code, Stacktraces, Logs oder Specs in einen Prompt. Das kann Geheimnisse offenbaren (API‑Keys), Kundendaten oder proprietäre Logik.

Halte Prompts und Testfixtures frei von sensiblen Informationen:

- Redaktiere Tokens und Zugangsdaten.

- Vermeide Produktionslogs mit personenbezogenen Daten.

- Nutze synthetische Beispiele (Fake‑Accounts, Fake‑IDs) für Testdaten.

- Wenn du echte Fälle teilen musst, minimiere und anonymisiere.

Wenn du eine gehostete KI‑Entwicklerplattform nutzt, gilt dasselbe Gebot. Auch bei modernen, regionenbewussten Hostings solltest du Prompts und Fixtures als Teil deiner Sicherheitslage behandeln.

Ein praktischer Rollout‑Plan (den Teams tatsächlich folgen)

Starte klein und mache es zur Routine:

- Wähle einen Service oder ein Modul mit häufigen Änderungen.

- Generiere Unit‑Tests für die risikoreichsten Pfade (Geldbewegungen, Berechtigungen, Datenumwandlungen).

- Füge eine einfache CI‑Regel hinzu: Neue KI‑geschriebene Features müssen Tests enthalten (siehe /blog/ci-checks-for-ai-code).

- Erfordere eine kurze menschliche Review‑Checkliste: „Prüft dieser Test Verhalten? Würde er aus dem richtigen Grund fehlschlagen?“

- Tracke verhinderte Regressionen (nicht nur Coverage), und erweitere dann auf Integrationstests, wenn Unit‑Tests stabil sind.

Das Ziel ist nicht maximale Testanzahl — es ist verlässliches Feedback, das KI‑geschriebene Logik ehrlich hält.