28. Aug. 2025·8 Min

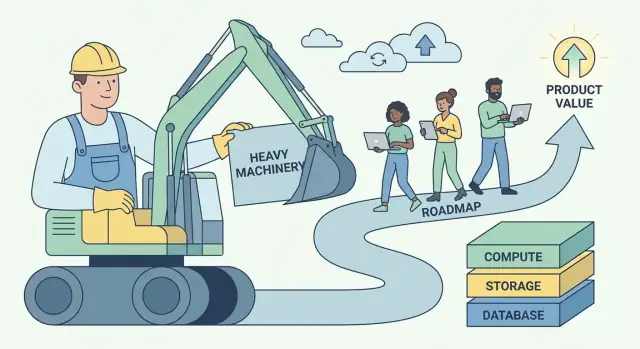

Andy Jassys AWS‑Playbook: Wie man undifferenzierte Schwerarbeit in Wert verwandelt

Wie Andy Jassy AWS um das Konzept der „undifferenzierten Schwerarbeit“ herum gestaltete und daraus ein wiederholbares Modell zum Aufbau skalierbarer Software‑Geschäfte und Plattformen machte.

Was „undifferenzierte Schwerarbeit“ eigentlich bedeutet

„Undifferenzierte Schwerarbeit“ ist eine einfache Idee mit scharfem Rand: es ist die Arbeit, die nötig ist, um Software zu betreiben, die Kunden aber nicht dazu bringt, gerade Sie zu wählen.

Dazu gehören Aufgaben wie Server bereitstellen, Datenbanken patchen, Zugangsdaten rotieren, Monitoring einrichten, Failover behandeln, Kapazität skalieren und Produktionsvorfälle verfolgen, die durch die Infrastruktur (Plumbing) und nicht durch das Produkt verursacht werden. Diese Aufgaben sind real, wichtig und oft dringend — aber sie schaffen selten ein einzigartiges Nutzererlebnis.

Definition in einfachen Worten

Wenn eine Aufgabe:

- Notwendig ist (Sie können sie nicht vermeiden, wenn Sie Zuverlässigkeit wollen)

- Wiederholbar ist (jedes Team führt eine ähnliche Version davon aus)

- Keinen Wettbewerbsvorteil bietet (Kunden zahlen nicht mehr, weil Sie es selbst gemacht haben)

…dann ist sie undifferenzierte Schwerarbeit.

Warum der Ausdruck bei Entwicklern und Führungskräften Anklang fand

Entwickler hörten Erleichterung: die Erlaubnis, operationalen Aufwand nicht länger als Ehrenzeichen zu betrachten. Wenn alle dieselben Deployment-Skripte und On-Call-Runbooks neu erfinden, ist das keine Handwerkskunst — es ist verschwendeter Fokus.

Führungskräfte sahen Hebelwirkung: diese Art von Arbeit ist teuer, skaliert schlecht mit Kopfzahl und erzeugt Risiko. Sie zu reduzieren verbessert gleichzeitig Marge, Zuverlässigkeit und Geschwindigkeit.

Das Geschäftsmodell, auf das die Idee hinweist

AWS popularisierte ein wiederholbares Playbook:

- Toil entfernen, indem fragile, teamweise betriebene Abläufe in einen Service verwandelt werden.

- Standardisieren, damit Qualität konsistent wird.

- Skalieren durch Automatisierung und geteilte Infrastruktur.

- Einsparen und reinvestieren in bessere Produkte und schnellere Auslieferung.

Das ist größer als Cloud-Infrastruktur — es ist „Plattformdenken“, angewendet auf jedes Softwaregeschäft.

Was Sie von diesem Artikel erwarten können

Wir übersetzen das Konzept in praktische Signale, die Sie in Ihrem Produkt und Team erkennen können, zeigen, wie verwaltete Dienste und interne Plattformen Betrieb als Produkt verpacken, und behandeln die realen Trade-offs (Kontrolle, Kosten, Lock-in). Sie erhalten einen Rahmen, um zu entscheiden, was gebaut vs. gekauft werden sollte — und wie sich undifferenzierte Arbeit in wachsendes Geschäftsvermögen verwandeln lässt.

Andy Jassys Kernidee: Kunden wollen bauen, nicht babysitten

Andy Jassy gehörte zu den frühen Führungskräften, die Amazons interne Infrastrukturfähigkeiten in das verwandelten, was AWS wurde. Seine Aufgabe war nicht nur „Server per Internet verkaufen“. Es ging darum, ein wiederkehrendes Kundenproblem zu erkennen und eine Lösung so zu verpacken, dass sie über Tausende von Teams hinweg skaliert.

Der eigentliche Schmerz: Betrieb stiehlt Aufmerksamkeit vom Produkt

Die meisten Softwareteams freuen sich nicht darauf, Betriebssysteme zu patchen, Kapazitäten zu provisionieren, Zugangsdaten zu rotieren oder einen defekten Datenträger zu ersetzen. Sie tun diese Dinge, weil sie müssen — sonst läuft die App nicht.

Jassys Kernidee war, dass ein Großteil dieser Arbeit notwendig, aber nicht differenzierend ist. Wenn Sie einen E‑Commerce-Shop, eine Fintech-App oder ein internes HR-Tool betreiben, schätzen Kunden Ihre Funktionen: schneller Checkout, bessere Betrugserkennung, reibungslosere Onboarding‑Erlebnisse. Sie belohnen selten das perfekt getunte Server‑Fleet‑Management.

Also wird das „Babysitten“ der Infrastruktur zu einer Steuer:

- Es bindet Zeit, die für Verbesserungen hätte genutzt werden können.

- Es zwingt Teams, Fähigkeiten einzustellen, auf die sie sich nicht spezialisieren wollen.

- Es erhöht das Risiko, weil jedes Unternehmen dieselben operationalen Lektionen neu lernen muss.

Warum das Timing passte

Diese Idee traf zu einem Zeitpunkt, an dem die Anforderungen wuchsen:

- Internet‑Scale machte Traffic unvorhersehbar; für Spitzen zu planen war teuer.

- Startups mussten schnell vorankommen, ohne ein Rechenzentrumsteam aufzubauen.

- Enterprise‑IT stand unter Druck, schneller zu liefern und gleichzeitig Sicherheit und Compliance zu managen.

Die Maxime war nicht „verschiebe alles in die Cloud“. Sie war einfacher: Entferne wiederkehrende operationelle Lasten, damit Kunden mehr Energie auf das richten können, was sie unterscheidet. Diese Rückgabe von Zeit und Aufmerksamkeit an das Bauen wurde zur Grundlage für ein Plattformgeschäft.

Undifferenzierte Schwerarbeit im eigenen Produkt und Team erkennen

Der erste Schritt ist, zwischen Basisarbeit (notwendig, um ein glaubwürdiges Produkt zu betreiben) und Differenzierung (die Gründe, warum Kunden Sie wählen) zu unterscheiden.

Basisarbeit ist nicht „unwichtig“. Sie ist oft entscheidend für Zuverlässigkeit und Vertrauen. Aber sie schafft selten allein eine Präferenz — besonders wenn Wettbewerber dasselbe Grundniveau erreichen können.

Häufige Signale für „Schwerarbeit"

Wenn Sie unsicher sind, was in den undifferenzierten Korb gehört, suchen Sie nach Arbeit, die:

- Notwendig, repetitiv und unverhandelbar ist

- Kosten verursacht, wenn sie fehlschlägt, aber meist unsichtbar ist, wenn sie funktioniert

- Auf ähnliche Weise in vielen Unternehmen gelöst wird

In Softwareteams umfasst das häufig:

- Verwaltung von Servern oder Clustern

- Sicherheits‑Patching und Abhängigkeits‑Updates

- Backups und Disaster‑Recovery‑Drills

- Auto‑Scaling und Kapazitätsplanung

- Basis‑Monitoring, Logging und Alerting

- On‑Call‑Rotationen für vorhersehbare Fehlerarten

Keine dieser Aufgaben ist „schlecht“. Die Frage ist, ob sie selbst zu erledigen Teil des Produktwerts ist — oder lediglich die Eintrittsgebühr.

Der einfachste Test: Würden Kunden dafür zahlen?

Eine praktische Regel lautet:

„Würden Kunden speziell dafür zahlen oder würden sie es nur erwarten, dass es enthalten ist?“

Wenn die Antwort „Sie wären nur sauer, wenn es fehlt“ lautet, dann haben Sie wahrscheinlich undifferenzierte Schwerarbeit vor sich.

Ein zweiter Test: Wenn Sie diese Arbeit morgen durch einen verwalteten Dienst entfernen würden, würden Ihre besten Kunden Sie immer noch für das verbleibende Produkt schätzen? Wenn ja, haben Sie einen Kandidaten zum Auslagern, Automatisieren oder Produktisieren.

„Undifferenziert“ ändert sich je nach Markt

Was in einem Unternehmen undifferenziert ist, kann in einem anderen Kern‑IP sein. Ein Datenbankanbieter kann durch Backup und Replikation differenzieren. Ein Fintech‑Produkt sollte das vermutlich nicht. Ihr Ziel ist nicht, die Grenze eines anderen zu kopieren — sondern Ihre eigene anhand dessen zu ziehen, was Ihre Kunden einzigartig belohnen.

Wenn Sie Roadmap und Betriebsarbeit durch dieses Prisma betrachten, sehen Sie, wo Zeit, Talent und Aufmerksamkeit nur dafür aufgewendet werden, um auf der Stelle zu treten.

Warum diese Idee massiven Unternehmenswert schafft

„Undifferenzierte Schwerarbeit“ ist nicht nur ein Produktivitäts‑Hack. Es ist ein Geschäftsmodell: Nimm ein Problem, das viele Unternehmen lösen müssen, aber nicht differenzieren wollen, und verwandle es in einen Service, für den Menschen gern zahlen.

Kommoditisierte Probleme sind Plattformtreibstoff

Die besten Kandidaten sind notwendige Dinge mit geringer strategischer Einzigartigkeit: Server provisionieren, Datenbanken patchen, Zugangsdaten rotieren, Warteschlangen skalieren, Backups managen. Jedes Team braucht sie, fast jedes Team baut sie lieber nicht selbst, und die „richtige“ Lösung ist branchenweit ähnlich.

Diese Kombination schafft einen vorhersagbaren Markt: hohe Nachfrage, wiederkehrende Bedürfnisse und klare Erfolgsmetriken (Uptime, Latenz, Compliance, Recovery‑Zeit). Eine Plattform kann die Lösung standardisieren und kontinuierlich verbessern.

Skaleneffekte: Fixkosten auf Kunden verteilen

Operative Exzellenz hat hohe Fixkosten — SREs, Security‑Spezialisten, On‑Call, Audits, Incident‑Tooling und 24/7‑Monitoring. Wenn jedes Unternehmen das allein baut, werden diese Kosten tausendfach dupliziert.

Eine Plattform verteilt diese Fixinvestitionen auf viele Kunden. Die Kosten pro Kunde sinken mit wachsender Adoption, während die Qualität steigen kann, weil der Anbieter tiefere Spezialisierung rechtfertigen kann.

Der Zuverlässigkeits‑Loop: Spezialisierung steigert Uptime und Sicherheit

Wenn ein Service‑Team dieselbe Komponente für viele Kunden betreibt, sieht es mehr Edge‑Cases, erkennt Muster schneller und baut bessere Automatisierung. Vorfälle werden zu Inputs: jeder Fehler härtet das System, verbessert Playbooks und stärkt Guardrails.

Sicherheit profitiert ähnlich. Dedizierte Teams können in Threat‑Modeling, kontinuierliches Patching und Compliance‑Kontrollen investieren, die für ein einzelnes Produktteam schwer zu halten wären.

Preissetzungsmacht: nutzungsbasiert + Vertrauen + Wechselkosten (vorsichtig)

Plattformen gewinnen oft durch nutzungsbasierte Preisgestaltung: Kunden zahlen proportional zum konsumierten Wert und können klein starten. Mit der Zeit wird Vertrauen zum Differenzierer — Zuverlässigkeit und Sicherheit machen den Dienst zur „default safe“ Wahl.

Wechselkosten steigen, wenn Integrationen tiefer werden, aber die gesündeste Form entsteht, wenn sie verdient ist, nicht erzwungen: bessere Performance, besseres Tooling, klarere Abrechnung und weniger Vorfälle. Das hält Kunden bei der Stange, auch wenn Alternativen existieren. Mehr zur Verpackung und Monetarisierung: siehe /pricing.

Das AWS‑Muster: Von Primitiven zu verwalteten Diensten

AWS gewann nicht, indem es „Server im Internet“ anbot. Es gewann, indem es wiederholt ein hartes operationales Problem nahm, es in kleinere Bausteine schnitt und diese Blöcke dann zu Diensten neu bündelte, bei denen AWS die Day‑2‑Arbeit für Sie übernimmt.

Die wiederholbare Leiter: Primitive → Service → Managed Service → Plattform

Denken Sie an eine Reifeleiter:

- Primitive: Rohzutaten, die Sie selbst zusammenbauen können (VMs, Disks, Netzwerke)

- Service: Eine stärker meinungsstarke API um eine Fähigkeit (Objektspeicher, Load‑Balancing)

- Managed Service: Der Anbieter betreibt Skalierung, Patching, Backups und Failover (Datenbanken, Queues)

- Plattform: Ein Portfolio, in dem Dienste sauber komponieren, mit gemeinsamer Identität, Abrechnung, Monitoring und Richtlinien

Jeder Schritt nimmt Entscheidungen, Wartung und das „Was, wenn es um 3 Uhr morgens ausfällt?“ vom Kunden weg.

AWS‑Beispiele (konzeptuelle Zuordnung)

AWS wandte das Muster in Kernkategorien an:

-

Compute: Start bei virtuellen Maschinen (EC2). Wechsel zu höherwertigem Compute, wo Deployment und Skalierung Standard sind (z. B. verwaltete Container/Serverless‑Modelle). Der Kunde fokussiert auf Code und Kapazitätsintention, nicht auf Host‑Pflege.

-

Storage: Von Volumes/Dateisystemen zu Objektspeicher (S3). Die Abstraktion verschiebt sich von „Volumes verwalten“ zu „Objekte speichern/abrufen“, während Haltbarkeit, Replikation und Skalierung AWS‑Problem werden.

-

Datenbanken: Vom „Datenbank auf VM installieren“ zu Managed Databases (RDS, DynamoDB). Backups, Patching, Read‑Replicas und Failover werden zu Konfiguration statt zu benutzerdefinierten Runbooks.

-

Messaging: Von handgefertigten Queues und Workern zu verwaltetem Messaging (SQS/SNS). Zustellsemantik, Retries und Durchsatz‑Tuning werden standardisiert, sodass Teams Workflows statt Infrastruktur bauen.

Warum Abstraktionen die kognitive Last reduzieren

Managed Services reduzieren kognitive Last auf zwei Arten:

- Weniger Teile, über die nachgedacht werden muss. Ihr Architekturdiagramm schrumpft von „Instanzen + Skripte + Cron + Alerting + Backups“ zu „Service + Einstellungen“.

- Weniger Fehlerquellen, die Sie besitzen müssen. Sie entwerfen weiterhin für Resilienz, sind aber nicht mehr verantwortlich für Patching, Clustering und Routinewiederherstellung.

Das Ergebnis: schnellere Onboarding‑Zeiten, weniger maßgeschneiderte Runbooks und konsistentere Operationen über Teams.

Checkliste zum Mitnehmen (wiederverwenden im eigenen Produkt)

- Was bauen Kunden, das notwendig, aber nicht differenzierend ist?

- Können Sie wiederkehrende Runbooks in eine einzige, stabile API verwandeln?

- Welche Aufgaben können Sie standardmäßig machen (Backups, Skalierung, Upgrades) statt optional?

- Sind die „scharfen Kanten“ hinter sinnvollen Limits und Guardrails versteckt?

- Können mehrere Teams es ohne Expertenwissen wiederverwenden?

- Lässt es sich mit dem Rest Ihres Systems komponieren (Identity, Monitoring, Billing, Policies)?

Operationen als Produkt verpacken

Backend‑Boilerplate überspringen

Starte ein Go‑Backend mit PostgreSQL und konzentriere dich auf deine Business‑Logik.

Eine nützliche Lesart von AWS ist: Es verkauft nicht nur Technologie, es verkauft Betrieb. Das „Produkt“ ist nicht nur ein API‑Endpunkt — es ist alles, was nötig ist, um diese Fähigkeit sicher, vorhersehbar und in großem Umfang zu betreiben.

APIs vs. Self‑Service vs. Full Management

Eine API liefert Bausteine. Sie können Ressourcen provisionieren, müssen aber noch Guardrails entwerfen, Fehler überwachen, Upgrades handhaben und Fragen wie „wer hat was geändert?“ beantworten.

Self‑Service fügt eine Schicht hinzu, die Kunden ohne Ticketing nutzen: Konsole, Templates, sinnvolle Defaults und automatisierte Provisionierung. Der Kunde übernimmt weiterhin den Großteil der Day‑2‑Arbeit, aber sie ist weniger manuell.

Full Management heißt, der Anbieter übernimmt die fortlaufenden Verantwortlichkeiten: Patching, Skalierung, Backups, Failover und viele Klassen der Incident‑Antwort. Kunden konzentrieren sich darauf, was sie wollen, nicht wie es am Laufen gehalten wird.

Die „langweiligen“ Features, auf die Kunden nicht verzichten können

Die Fähigkeiten, auf die sich Leute täglich verlassen, sind selten spektakulär:

- IAM und Berechtigungen: wer was darf und wie Zugriff auditiert wird

- Abrechnung und Kostenübersicht: Budgets, Rechnungen, Tags und Alerts

- Quotas und Ratenlimits: Schutz vor Unfällen — und klare Erwartungen

Das sind keine Nebenquests. Sie sind Teil des Versprechens, das Kunden kaufen.

Betrieb als erstklassiges Feature

Was einen Managed Service „echt“ wirken lässt, ist das operationelle Paket darum herum: klare Dokumentation, vorhersehbare Supportkanäle und explizite Service‑Limits. Gute Docs reduzieren Supportaufwand, aber wichtiger: sie reduzieren Kundenangst. Veröffentliche Limits und Quota‑Prozesse verwandeln Überraschungen in bekannte Einschränkungen.

Wenn Sie Betrieb als Produkt verpacken, liefern Sie nicht nur Funktionen — Sie liefern Vertrauen.

Organisationsdesign, das Plattformen funktionieren lässt

Ob eine Plattform gelingt, hängt weniger von Architekturdiagrammen ab als vom Organisationsdesign. Wenn Teams keine klaren Kunden, Anreize und Feedback‑Schleifen haben, wird die „Plattform“ zu einem Backlog voller Meinungen.

Interne Teams als erste Kunden (Dogfooding)

Der schnellste Weg, eine Plattform ehrlich zu halten, ist, interne Produktteams als erste — und lauteste — Kunden zu machen. Das bedeutet:

- Plattformteams liefern an interne Teams über dieselben Schnittstellen und Dokumente wie externe Nutzer.

- Adoption wird verdient (durch Nützlichkeit), nicht vorgeschrieben (durch Policy).

- Supporttickets, Incident‑Reviews und Roadmap‑Entscheidungen behandeln interne Teams wie echte Kunden mit klaren SLAs.

Dogfooding erzwingt Klarheit: Wenn Ihre eigenen Teams die Plattform meiden, werden externe Kunden das auch tun.

Zentrales vs. föderiertes Plattformmodell

Zwei Muster tauchen oft auf:

Zentrales Plattformteam: Ein Team besitzt die Kernbausteine (CI/CD, Identity, Observability, Runtime, Datenprimitiven). Gut für Konsistenz und Skaleneffekte, aber es droht ein Engpass zu werden.

Föderiertes Modell: Ein kleines zentrales Team setzt Standards und gemeinsame Primitiven, während Domänen‑Teams „Plattform‑Slices“ besitzen (z. B. Datenplattform, ML‑Plattform). Das erhöht Geschwindigkeit und Domänenfit, erfordert aber starke Governance, um Fragmentierung zu vermeiden.

Relevante Metriken (und Plattformfallen)

Nützliche Plattformmetriken sind Ergebnis‑orientiert, nicht Aktivitäts‑orientiert:

- Lead Time to Production (wie schnell Teams deployen können)

- Verfügbarkeit und Incident‑Rate der Plattformdienste

- Kosten pro Workload (Unit Economics, nicht nur Gesamtausgaben)

Häufige Fallen: fehlangepasste Anreize (Plattform wird an Feature‑Anzahl gemessen, nicht an Adoption), Überentwurf (für hypothetische Skalierung bauen) und Erfolg, der durch Vorgaben statt freiwillige Nutzung gemessen wird.

Der sich verstärkende Flywheel hinter Plattformwachstum

Bewahre dir die Ausstiegsoption

Erhalte den Quellcode‑Export, wenn du die volle Kontrolle über deinen Stack willst.

Plattformen wachsen anders als Einmalprodukte. Ihr Vorteil ist nicht nur „mehr Features“ — es ist eine Feedback‑Schleife, in der jeder neue Kunde die Plattform leichter betreibbar, besser verbesserbar und schwerer zu ignorieren macht.

Das Flywheel in einfachen Worten

Mehr Kunden → mehr reale Nutzungsdaten → klarere Muster, was bricht, was langsam ist, was verwirrt → bessere Defaults und Automatisierung → besserer Dienst für alle → mehr Kunden.

AWS profitierte davon, weil Managed Services operationelle Arbeit in eine geteilte, wiederholbare Fähigkeit verwandelten. Wenn dieselben Probleme bei Tausenden Teams auftreten (Monitoring, Patching, Skalierung, Backups), kann der Anbieter sie einmal beheben und die Verbesserung an alle verteilen.

Warum Standardisierung Innovation beschleunigt

Standardisierung wird oft als „weniger Flexibilität“ dargestellt, ist für Plattformen aber ein Geschwindigkeitsmultiplikator. Wenn Infrastruktur und Betrieb konsistent sind — eine API, ein Identity‑Ansatz, eine Art Systeme zu beobachten — hören Entwickler auf, das Rad neu zu erfinden.

Diese zurückgewonnene Zeit fließt in höherwertige Innovation: bessere Produkterlebnisse, schnellere Experimente und neue Fähigkeiten auf der Plattform (nicht daneben). Standardisierung reduziert außerdem kognitive Last: weniger Entscheidungen, weniger Fehlerquellen, schnelleres Onboarding.

Die langfristige Wette: Kompoundierung bei Maßstab

Kleine Verbesserungen potenzieren sich, wenn sie auf Millionen von Requests und Tausenden Kunden angewendet werden. Eine 2%ige Reduktion der Incident‑Rate, ein etwas besserer Autoscaling‑Algorithmus oder eine klarere Default‑Konfiguration hilft nicht nur einem Unternehmen — sie hebt die Plattform‑Baseline an.

Wie das Entfernen von Schwerarbeit zu schnellerem Ausliefern führt

Undifferenzierte Schwerarbeit zu entfernen spart nicht nur Stunden — es verändert das Verhalten von Teams. Wenn die „Keep‑the‑lights‑on“ Arbeit schrumpft, werden Roadmaps nicht mehr von Wartungsaufgaben (Server patchen, Schlüssel rotieren, Queues babysitten) dominiert, sondern spiegeln Produktwetten wider: neue Features, besseres UX, mehr Experimente.

Die sich kompoundierenden Sekundäreffekte

Weniger Toil löst eine Kettenreaktion aus:

- Onboarding wird leichter. Neue Ingenieure können in Tagen statt durch ein Labyrinth aus internen Runbooks produktiv werden.

- Vorfälle nehmen ab — und werden einfacher. Weniger bespoke Systeme bedeuten weniger merkwürdige Fehlerfälle und weniger 3‑Uhr‑Eskalatationen.

- Releases werden Routine. Teams können häufiger releasen, weil Deployment, Rollback und Monitoring standardisiert sind.

Geschwindigkeit vs. Chaos: Ausliefern vs. Feuerlöschen

Echte Geschwindigkeit ist ein beständiger Takt aus kleinen, vorhersehbaren Releases. Chaos ist Bewegung ohne Fortschritt: dringende Bugfixes, Notfallinfrastruktur‑Arbeit und „schnelle“ Änderungen, die mehr Schulden erzeugen.

Das Entfernen von Schwerarbeit reduziert Chaos, weil ganze Kategorien von Arbeit wegfallen, die wiederholt geplante Lieferung unterbrechen. Ein Team, das früher 40% seiner Zeit mit Reaktionen verbrachte, kann diese Kapazität in Features lenken — und dort halten.

Praktische SaaS‑Beispiele

Authentifizierung: Statt Passwortspeicherung, MFA‑Flows, Session‑Handling und Compliance‑Audits selbst zu pflegen, nutzen Sie einen verwalteten Identity‑Provider. Ergebnis: weniger Sicherheitsvorfälle, schnellere SSO‑Rollouts und weniger Zeit, die in Auth‑Bibliotheken steckt.

Zahlungen: Lagern Sie Zahlungsabwicklung, Steuer/VAT‑Handling und Betrugsprüfung an spezialisierte Anbieter aus. Ergebnis: schnellere Expansion in neue Regionen, weniger Chargeback‑Überraschungen und weniger Engineering‑Zeit in Randfällen.

Observability: Standardisieren Sie auf einen verwalteten Logging/Metriken/Tracing‑Stack statt hausgemachter Dashboards. Ergebnis: schnelleres Debugging, klarere Verantwortlichkeiten bei Vorfällen und Vertrauen, häufiger zu deployen.

Das Muster ist simpel: Wenn Betrieb ein konsumierbares Produkt wird, fließt Engineering‑Zeit zurück ins Bauen dessen, wofür Kunden tatsächlich bezahlen.

Trade‑offs: Lock‑In, Kontrolle und Kosten

Das Entfernen von undifferenzierter Schwerarbeit ist kein Freifahrtschein. AWS‑artige verwaltete Dienste tauschen tagtäglichen Aufwand gegen engere Kopplung, weniger Stellschrauben und Rechnungen, die Sie überraschen können.

Die drei großen Trade‑offs

Vendor‑Lock‑in. Je mehr Sie auf proprietäre APIs setzen (Queues, IAM‑Policies, Workflow‑Engines), desto schwieriger wird ein späterer Wechsel. Lock‑in ist nicht immer schlecht — er kann der Preis für Geschwindigkeit sein — aber Sie sollten ihn bewusst eingehen.

Kontrollverlust. Managed Services reduzieren Ihre Fähigkeit, Performance feinzujustieren, exakte Versionen zu wählen oder tief in Infrastrukturprobleme zu debuggen. Bei einem Ausfall warten Sie möglicherweise auf einen Zeitplan des Anbieters.

Kostenüberraschungen. Verbrauchsbasierte Preise belohnen effiziente Nutzung, können aber Wachstum, „chatty“ Architekturen und „Set‑and‑forget“ Defaults bestrafen. Teams entdecken Kosten oft erst nach dem Go‑Live.

Wann Bauen rational ist

Bauen oder Self‑Hosting kann sinnvoll sein, wenn Sie einzigartige Anforderungen haben (spezielle Latenzen, proprietäre Datenmodelle), massiven Maßstab, bei dem die Unit‑Economics kippen, oder Compliance/Datensouveränität, die verwaltete Dienste nicht erfüllen.

Leitplanken, die schnell halten, ohne einzusperren

Definieren Sie Servicegrenzen: kapseln Sie Anbieteraufrufe hinter eigenen Schnittstellen, damit Implementierungen tauschbar bleiben.

Pflegen Sie einen Portabilitätsplan: dokumentieren Sie, was am schwersten zu migrieren wäre, und halten Sie einen „minimalen exit‑Plan“ bereit (auch wenn er langsam ist).

Führen Sie Kostenüberwachung frühzeitig ein: Budgets, Alerts, Tagging und regelmäßige Reviews der Top‑Kostenquellen.

Übertragbare Entscheidungs‑Matrix

| Frage | Präferiert: Managed | Präferiert: Bauen/Self‑Host |

|---|---|---|

| Ist das ein Differenzierer für Kunden? | Nein | Ja |

| Können wir Anbieterlimits/opinioniertes Verhalten tolerieren? | Ja | Nein |

| Brauchen wir spezielle Compliance/Kontrolle? | Nein | Ja |

| Ist Time‑to‑Market oberste Priorität? | Ja | Nein |

| Sind Kosten bei unserem Nutzungsmuster vorhersehbar? | Ja | Nein |

Ein praktischer Rahmen, um das Muster in jedem Softwaregeschäft anzuwenden

Lass das Erstellen sich auszahlen

Verdiene Credits, indem du teilst, was du mit Koder.ai baust, oder einen Kollegen wirbst.

Sie müssen kein Hyperscaler sein, um das Playbook „undifferenzierte Schwerarbeit entfernen“ zu nutzen. Jedes Softwareteam — SaaS, interne Plattformen, Datenprodukte oder Support‑schwere Tools — hat wiederkehrende Arbeit, die teuer, fehleranfällig und kein echter Differenzierer ist.

Schritt‑für‑Schritt‑Methode (von Toil zu Produkt)

-

Wiederkehrende Toil auflisten: Schreiben Sie wiederkehrende Aufgaben auf, die Leute tun, um Systeme am Laufen zu halten — manuelle Deployments, Ticket‑Triage, Daten‑Backfills, Zugriffsanfragen, Incident‑Handoffs, fragile Skripte, „Tribal Knowledge“ Checklisten.

-

Quantifizieren: Schätzen Sie für jeden Punkt Frequenz, aufgewendete Zeit und Fehlerkosten. Eine einfache Bewertung reicht: Stunden/Woche + Schwere der Fehler + Anzahl betroffener Teams. Das macht vages Leid zu einer priorisierten Liste.

-

Workflow standardisieren: Bevor Sie automatisieren, definieren Sie den „einen besten Weg“. Erstellen Sie ein Template, einen Golden Path oder eine minimale Menge unterstützter Optionen. Variation zu reduzieren ist oft der größte Gewinn.

-

Automatisieren und verpacken: Bauen Sie self‑serve Tools (APIs, UI, Runbooks‑as‑Code) und behandeln Sie es wie ein Produkt: klare Ownership, Versionierung, Docs und ein Supportmodell.

Eine moderne Variante ist „vibe‑coding“‑Plattformen, die wiederkehrendes Scaffolding und Day‑1‑Setup in einen geführten Workflow verwandeln. Zum Beispiel erlaubt Koder.ai Teams, Web-, Backend‑ und Mobile‑Apps aus einer Chat‑Schnittstelle zu erstellen (React fürs Web, Go + PostgreSQL fürs Backend, Flutter für Mobile) und dann Quellcode zu exportieren oder zu deployen/hosten — nützlich, wenn Ihr Engpass darin liegt, von Idee zu einer zuverlässigen Basis zu kommen, ohne jedes Mal dieselbe Projektverkabelung neu zu machen.

Beginnen Sie mit einem Workflow (und beweisen Sie die Schleife)

Wählen Sie einen einzelnen, häufigen Workflow, bei dem Erfolg messbar ist — Deployments, Datenpipelines oder Support‑Tooling sind gute Kandidaten. Streben Sie einen schnellen Erfolg an: weniger Schritte, weniger Seiten, weniger Genehmigungen, schnellere Wiederherstellung.

Reihenfolge: Was zuerst zu tun ist

- Zuverlässigkeit zuerst: Machen Sie den Prozess konsistent und sicher.

- Funktionen zweitens: Fügen Sie Fähigkeiten hinzu, die Nutzer tatsächlich verlangen.

- Optimierung drittens: Feintuning von Kosten und Performance, nachdem die Nutzung stabil ist.

Wichtige Erkenntnisse und nächste Schritte

Die wiederverwendbare Lektion aus Andy Jassys AWS‑Strategie ist simpel: Sie gewinnen, indem Sie die gemeinsame Arbeit verschwinden lassen. Wenn Kunden (oder interne Teams) keine Zeit mehr mit Setup, Patching, Skalierung und Incident‑Babysitting verbringen, können sie diese Zeit in das investieren, was sie wirklich unterscheidet — Features, Erlebnisse und neue Wetten.

Zentrale Erkenntnis

„Undifferenzierte Schwerarbeit“ ist nicht nur „harte Arbeit“. Es ist Arbeit, die viele Teams wiederholen, die getan werden muss, um zuverlässig zu operieren, die aber selten einzigartige Marktbelohnung bringt. Diese Arbeit in ein Produkt — insbesondere einen verwalteten Dienst — zu verwandeln schafft doppelten Wert: Sie senken die Betriebskosten und erhöhen die Auslieferungsgeschwindigkeit.

Entfernen Sie dieses Quartal eine Sache

Starten Sie nicht mit einer großen Plattform‑Neuimplementierung. Beginnen Sie mit einem wiederkehrenden Schmerz, der in Tickets, On‑Call‑Pages oder Sprint‑Überläufen auftaucht. Gute Kandidaten:

- Environment‑Setup, das von Team zu Team variiert

- Manuelle Releases und Rollbacks

- Wiederkehrende Sicherheitsreviews für dieselben Muster

- Skalierungs‑/Monitoring‑Defaults, die jeder auf die harte Tour neu entdeckt

Wählen Sie eins, definieren Sie „Done“ in klarer Sprache (z. B. „Ein neuer Service kann in 15 Minuten sicher deployen“), und liefern Sie die kleinste Version, die die wiederkehrende Arbeit eliminiert.

Verwandte interne Lektüre

Wenn Sie mehr praktische Muster zu Plattformdenken und Build‑vs‑Buy‑Entscheidungen wollen, stöbern Sie in /blog. Wenn Sie evaluieren, was zu standardisieren ist gegen das, was als interne (oder externe) kostenpflichtige Fähigkeit angeboten werden sollte, hilft /pricing bei Packaging und Tiers.

Nächster Schritt: Ein einfacher Platform‑Backlog

Diese Woche tun Sie drei Dinge: auditieren, wo Zeit an wiederkehrende Betriebsarbeit verloren geht, priorisieren nach Frequenz × Schmerz × Risiko und bauen ein einfaches Platform‑Backlog mit 3–5 Items, die inkrementell geliefert werden können.