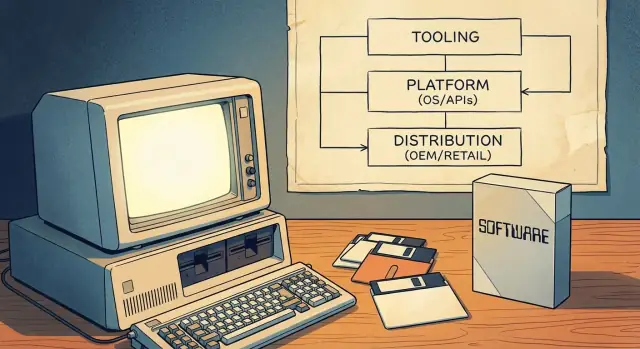

Was das „PC‑Software‑Modell“ bedeutet — und warum es wichtig war

Das „PC‑Software‑Modell“ war kein einzelnes Produkt oder ein cleverer Lizenztrick. Es war eine wiederholbare Art, wie ein ganzer Markt funktionierte: wie Entwickler Software bauten, wie sie sie an Nutzer lieferten und wie sie damit Geld verdienten.

Das klingt banal — bis man sich vor Augen führt, wie ungewöhnlich die Situation zu Beginn des Personal‑Computings war. Frühe Computer wurden oft als geschlossene Systeme mit proprietärer Hardware, individuellen Betriebssituationen und unklaren Wegen für Drittanbieter verkauft. Die PC‑Ära änderte das, indem sie Software zu etwas machte, das über eine einzelne Maschine — oder ein einzelnes Unternehmen — hinaus skaliert werden konnte.

Eine einfache Definition des „Software‑Modells"

Praktisch ist ein Software‑Modell die Menge von Annahmen, die folgende Fragen beantwortet:

- Für welches Ziel baue ich? (ein stabiler OS‑ und Hardware‑Unterbau)

- Wie baue ich effizient? (Tools, Sprachen, Dokumentation)

- Wie erreiche ich Kunden und erhalte Zahlung? (Distribution und Geschäftsbedingungen)

Wenn diese Antworten vorhersehbar sind, investieren Entwickler. Wenn nicht, zögern sie.

Die drei Säulen, die sich gegenseitig verstärkten

Das PC‑Software‑Modell funktionierte, weil es drei Säulen zu einem Flywheel verband:

- Entwicklungstools: zugängliche Sprachen, Compiler, IDEs und Beispiele, die die Einstiegskosten senkten.\

- Plattformfläche: konsistente APIs und SDKs, die Drittsoftware die Integration mit dem OS (und mit anderen Apps) erlaubten.\

- Go‑to‑Market‑Kanäle: klare Distributionswege — OEM‑Vorinstallationen, Einzelhandel und später Shareware — damit Software tatsächlich zum Geschäft werden konnte.

Zusammen machten sie den PC zu einem verlässlichen „Bauplatz“. Diese Verlässlichkeit verwandelte Personal Computing in ein mainstream‑fähiges Entwicklerökosystem — nicht nur in eine Hobbyisten‑Szene.

Vor den Mainstream‑PCs: fragmentierte Ziele und begrenzte Reichweite

Vor Mass‑Market‑PCs bedeutete „Computing“ häufig Großrechner und Minicomputer, die Regierungen, Universitäten und große Unternehmen gehörten. Der Zugang war rar, teuer und oft durch IT‑Abteilungen vermittelt. Als Entwickler schrieb man Software für eine bestimmte Organisation — nicht für einen breiten öffentlichen Markt.

Viele Maschinen, viele Inkompatibilitäten

Frühe Personal‑ und Hobbycomputer existierten zwar, bildeten aber keinen verlässlichen Markt. Die Hardware variierte stark (CPU‑Familien, Disk‑Formate, Grafik, Peripherie) und Betriebssysteme waren inkonsistent oder proprietär. Ein Programm, das auf einer Maschine lief, musste oft für eine andere neu geschrieben werden.

Diese Fragmentierung prägte die Software‑Ökonomie:

- Software wurde häufig mit Hardware gebündelt oder als Teil eines größeren Kaufs geliefert.\

- Vieles war kundenspezifisch für einen Arbeitsablauf gebaut.\

- Anbieter koppelten Apps eng an ihre Maschinen, um Hardwareverkäufe zu schützen.

Begrenzte Reichweite bedeutete begrenzte Anreize

Weil die adressierbare Zielgruppe für eine einzelne Konfiguration klein war, konnten unabhängige Entwickler kaum die Zeit und Kosten rechtfertigen, polierte, breit unterstützte Produkte zu bauen. Die Distribution war beschränkt: Datenträger per Post an Kunden schicken, auf Nutzergruppen vertrauen oder Code informell teilen. Das sah nicht nach einem skalierbaren Geschäftsmodell aus.

Was sich änderte, als PCs massentauglich wurden

Als PCs zu verbreiteten Konsum‑ und Büroprodukten wurden, verlagte sich der Wert von Einzellösungen zu wiederholbaren Softwareverkäufen. Die Schlüsselidee war ein standardisiertes Ziel: eine vorhersehbare Kombination aus Hardware‑Erwartungen, Betriebssystem‑Konventionen und Distributionswegen, auf die Entwickler setzen konnten.

Sobald eine kritische Masse von Käufern und kompatiblen Maschinen bestand, ging es beim Schreiben von Software weniger darum „Läuft das auch anderswo?“ und mehr um „Wie schnell erreichen wir alle, die diesem Standard folgen?"

Bevor Microsoft mit Betriebssystemen gleichgesetzt wurde, war das Unternehmen stark mit Programmiersprachen — insbesondere BASIC — verbunden. Diese Wahl war kein Zufall. Wenn man ein Ökosystem will, braucht man zuerst Menschen, die bauen können, und Sprachen sind die niedrigschwelligste Einstiegsmöglichkeit.

BASIC als „Starter‑Kit"

Frühe Mikrocomputer hatten oft BASIC im ROM, und Microsofts Versionen wurden zu einem vertrauten Einstieg über viele Maschinen hinweg. Für Schüler, Tüftler oder kleine Unternehmen war der Weg einfach: Maschine einschalten, Prompt, Code tippen, Ergebnis sehen. Diese Unmittelbarkeit war wichtiger als Eleganz. Sie machte Programmieren zur normalen Nutzung eines Computers und nicht zu einem spezialisierten Beruf.

Zugänglichkeit erweitert den Pool an Schöpfern

Indem Microsoft auf zugängliche Tools setzte, half das Unternehmen, den Trichter potenzieller Entwickler zu weiten. Mehr Menschen, die kleine Programme schrieben, bedeuteten mehr Experimente, mehr lokale „Apps“ und mehr Nachfrage nach besseren Werkzeugen. Das ist ein frühes Beispiel dafür, wie Entwickler‑Mindshare wie Zinseszins wirkt: Eine Generation, die auf deiner Sprache lernt, baut und kauft tendenziell weiter in diesem Ökosystem.

Konsistenz über Maschinen hinweg schafft Vertrauen

Die Mikrocomputer‑Ära war fragmentiert, aber Microsoft trug konsistente Ideen von Plattform zu Plattform: ähnliche Sprachsyntax, ähnliche Tooling‑Erwartungen und das wachsende Gefühl, dass „wenn du hier programmieren kannst, du wahrscheinlich auch dort programmieren kannst“. Diese Vorhersehbarkeit senkte das wahrgenommene Risiko, Programmieren zu lernen.

Die strategische Lehre ist klar: Plattformen beginnen nicht mit Marktplätzen oder Monetarisierung. Sie beginnen mit Tools, die Schaffen möglich machen — und verdienen Loyalität, indem sie diese Erfahrung wiederholbar machen.

MS‑DOS und die Standardisierung des PC‑Ziels

Eine große Befreiung im frühen Personal‑Computing war die Idee einer „standardisierten OS‑Schicht“: Anstatt für jede Hardware‑Kombination eine eigene Version zu schreiben, konnte man eine gemeinsame Schnittstelle anpeilen. Für Entwickler bedeutete das weniger Portierungen, weniger Support‑Anfragen und einen klareren Weg zur Auslieferung von Software, die bei vielen Kunden funktionierte.

Ein Ort, auf den man seine Software ausrichten kann

MS‑DOS schob sich zwischen Anwendungen und die chaotische Vielfalt der PC‑Hardware. Unterschiede blieben (Grafikkarten, Drucker, Diskcontroller, Speicherkonfigurationen), aber MS‑DOS bot eine gemeinsame Basis für Dateizugriff, Programmstart und grundlegende Gerätedialoge. Diese gemeinsame Schicht verwandelte „den PC“ von einer Sammlung fast‑kompatibler Maschinen in einen adressierbaren Markt.

Was „Kompatibilität“ in der Praxis bedeutete

Für Kunden bedeutete Kompatibilität Vertrauen: Wenn ein Programm angab, es laufe unter MS‑DOS (und damit auf IBM‑PC‑kompatiblen Rechnern), war es wahrscheinlicher, dass es auf ihrer Maschine lief. Für Entwickler bedeutete Kompatibilität vorhersehbares Verhalten — dokumentierte Systemaufrufe, ein stabiles Ausführungsmodell und Konventionen für Installation und Start.

Diese Vorhersehbarkeit machte es rational, in Politur, Dokumentation und fortlaufende Updates zu investieren, weil sich die Zielgruppe nicht auf die Nutzer eines einzelnen Hardware‑Anbieters beschränkte.

Der Kernkonflikt: Fortschritt vs. Bewahrung

Standardisierung schafft auch eine Einschränkung: Alte Software funktionsfähig zu halten wird zur Priorität. Dieser Druck auf Abwärtskompatibilität kann große Veränderungen verlangsamen, weil das Brechen populärer Programme Vertrauen in die Plattform zerstört. Der Vorteil ist eine wachsend kompakte Softwarebibliothek; der Nachteil ist ein engerer Korridor für radikale OS‑Innovation ohne sorgfältige Übergangspläne.

Ohne Integrationsaufwand ausliefern

Vom funktionierenden Build zur Live‑Bereitstellung, ohne Tools zusammenzufügen.

Windows setzte sich nicht einfach „auf“ MS‑DOS — es veränderte, was Entwickler über die Maschine annehmen konnten. Anstatt dass jedes Programm seinen eigenen Weg zum Zeichnen von Bildschirmen, zum Umgang mit Eingaben und zur Peripherie‑Kommunikation erfindet, bot Windows ein gemeinsames UI‑Modell plus wachsende Systemdienste.

Was Windows über DOS hinaus hinzufügte

Die auffälligste Änderung war die grafische Benutzeroberfläche: Fenster, Menüs, Dialoge und Schriftarten, die konsistent aussahen und sich konsistent verhielten. Das war wichtig, weil Konsistenz die „Neuerfindung der Basics“ reduzierte. Entwickler konnten Zeit in Funktionen investieren, die Nutzer wirklich wollten, statt in noch ein UI‑Toolkit.

Windows erweiterte auch gemeinsame Dienste, die in der DOS‑Ära mühsam waren:

- Ein standardisierter Weg, mit Dateien und Ordnern zu arbeiten\

- Drucken über gemeinsame Treiber und Druckdialoge\

- Netzwerkunterstützung, die nicht jedem Anbieter ein eigenes Vorgehen abverlangte

GUI‑Konventionen und gemeinsame Komponenten

Windows‑Konventionen — wie Standard‑Tastenkürzel, Dialoglayouts und gemeinsame Controls (Buttons, Listen, Textfelder) — reduzierten gleichzeitig Entwicklungsaufwand und Schulungsbedarf. Gemeinsame Komponenten bedeuteten weniger Eigenlösungen und weniger Überraschungen bei Hardwarewechseln.

Versionen, Kompatibilität und Planung

Mit der Entwicklung von Windows mussten Entwickler wählen: ältere Versionen zur Reichweite unterstützen oder neuere APIs für bessere Möglichkeiten nutzen. Diese Entscheidungen prägten Roadmaps, Tests und Marketing.

Im Laufe der Zeit konzentrierten sich Tools, Dokumentation, Drittbibliotheken und Anwendererwartungen auf Windows als Default‑Ziel — nicht nur als Betriebssystem, sondern als Plattform mit Normen und Momentum.

Developer Experience: IDEs, Compiler, Docs und Samples

Eine Plattform fühlt sich für Entwickler erst dann „echt“ an, wenn es einfach ist, Software darauf auszuliefern. Im PC‑Zeitalter formte diese Einfachheit weniger das Marketing als das tägliche Erlebnis beim Schreiben, Bauen, Debuggen und Verpacken von Programmen.

Compiler, Linker, Debugger und Build‑Systeme legen das Tempo eines Ökosystems fest. Wenn Compile‑Zeiten sinken, Fehlermeldungen klarer werden und Debugging verlässlich ist, können Entwickler schneller iterieren — und Iteration ist es, die eine halb fertige Idee in ein Produkt verwandelt.

Integrierte Entwicklungsumgebungen (IDEs) gingen noch weiter, indem sie Editieren, Bauen, Debuggen und Projektmanagement in einem Workflow bündelten. Eine gute IDE reduzierte die „Kleinarbeit“, die sonst Stunden frisst: Include‑Pfade setzen, Bibliotheken verwalten, Builds konsistent halten und Laufzeitabstürze finden.

Geringeres Risiko für kleine Teams

Bessere Tools sind nicht nur „nice to have“ — sie verändern die Ökonomie für kleine Teams. Wenn ein oder zwei Entwickler mit Vertrauen bauen und testen können, wagen sie Projekte, die sonst einen größeren Stamm erfordert hätten. Das senkt Kosten, verkürzt Zeitpläne und macht es weniger riskant für ein kleines ISV, ein neues Produkt zu starten.

Docs und Samples schlagen oft Features

Dokumentation und ausführbare Beispiele fungieren wie ein zweites Produkt: Sie zeigen das mentale Modell, Best Practices und verhindern typische Fehler. Viele Entwickler übernehmen eine API nicht, weil sie mächtig ist — sondern weil es ein klares Beispiel gibt, das am ersten Tag funktioniert.

Tool‑Anbieter beeinflussen, welche Programmiermodelle gewinnen, indem sie bestimmte Wege reibungslos machen. Wenn Templates, Assistenten, Bibliotheken und Debugging‑Ansichten auf einen Ansatz ausgerichtet sind, wird dieser zum Default — nicht weil er theoretisch überlegen ist, sondern weil er schneller zu lernen und sicherer auszuliefern ist.

APIs und SDKs: Drittsoftware in großem Maßstab möglich machen

Kosten beim Bauen ausgleichen

Erhalte Credits, indem du Inhalte über Koder.ai erstellst oder andere Builder empfiehlst.

Ein Betriebssystem ist nicht automatisch eine „Plattform“. Es wird dazu, wenn externe Entwickler vorhersagbar darauf bauen können. Hier spielten APIs und SDKs im PC‑Zeitalter eine zentrale Rolle.

APIs als „Menü der Funktionen"

Eine API ist im Grunde ein Menü von Funktionen, die eine App nutzen kann: ein Fenster zeichnen, ein Dokument drucken, eine Datei speichern, mit Hardware kommunizieren, Ton abspielen. Anstatt dass jeder Entwickler eigene Wege erfindet, bietet die Plattform gemeinsame Bausteine.

Ein SDK (Software Development Kit) ist das Paket, das diese Bausteine nutzbar macht: Bibliotheken, Header, Tools, Dokumentation und Beispielcode, die zeigen, wie man vom Menü bestellt.

Stabilität verwandelt Interesse in Investition

Entwicklung kostet wirklich: Zeit, Personal, Support, Marketing und laufende Updates. Stabile APIs reduzieren das Risiko, dass ein Update zentrale Funktionen kaputtmacht.

Wenn Regeln konsistent bleiben — Datei‑Dialoge funktionieren gleich, Drucken funktioniert gleich, Fenstersteuerungen folgen demselben Muster — können Drittunternehmen mehrjährige Roadmaps planen. Diese Vorhersehbarkeit ist ein wesentlicher Grund, warum das Windows‑Entwicklermodell ernsthafte ISVs anzog und nicht nur Hobbyisten.

Entwicklerprogramme schaffen Rückkopplungsschleifen

Plattformteams veröffentlichen nicht nur APIs; sie pflegen Adoption. Entwicklerprogramme, frühe Dokumentation, Betas und Preview‑Releases erlauben Softwareherstellern, Kompatibilität vor dem Launch zu testen.

Das erzeugt eine Schleife: Entwickler finden Edge‑Cases, die Plattform behebt sie, und die nächste Welle von Apps erscheint mit weniger Überraschungen. Mit der Zeit verbessert das die Qualität für Nutzer und senkt Supportkosten für alle.

Risiken: Brüche, gemischte Signale, Fragmentierung

APIs können auch zur Belastung werden. Breaking Changes zwingen zu teuren Überarbeitungen. Inkonsistente Richtlinien (unterschiedliche UI‑Konventionen in System‑Apps) lassen Drittanbieter‑Apps „falsch“ wirken, selbst wenn sie funktionieren. Fragmentierung — mehrere sich überlappende APIs für dieselbe Aufgabe — zerstreut Aufmerksamkeit und bremst Ecosystem‑Momentum.

Auf großer Skala ist die beste Plattformstrategie oft unspektakulär: klare Versprechen, vorsichtige Deprecation und aktuelle Dokumentation.

Distributionskanäle: OEM‑Deals, Ladenregale und Shareware

Eine Plattform besteht nicht nur aus APIs und Tools — sie ist auch, wie Software Menschen erreicht. Im PC‑Zeitalter entschied Distribution, welche Produkte „default“ wurden, welche Publikum fanden und welche leise verschwanden.

OEM‑Deals: die Macht des Bereits‑dort‑Seins

Wenn PC‑Hersteller Software vorinstallierten (oder im Paket lieferten), formten sie Anwendererwartungen. Wenn Tabellenkalkulationen, Textverarbeitung oder Laufzeitumgebungen mit dem Gerät kamen, wurden sie nicht nur praktisch — sie waren Ausgangspunkt. OEM‑Partnerschaften reduzierten außerdem Reibung für Käufer: kein zusätzlicher Ladenbesuch, keine Kompatibilitätsunsicherheit.

Für Entwickler boten OEM‑Beziehungen etwas Wertvolleres als Marketing: vorhersehbare Stückzahlen. Mit einer populären Hardwarelinie auszuliefern konnte stabile, planbare Umsätze bedeuten — wichtig für Teams, die Support, Updates und Dokumentation finanzieren mussten.

Ladenregale und Kataloge: Sichtbarkeit als Funktion

Retail‑Softwareboxen, Versandkataloge und später große Elektronikmärkte schufen einen „Wettbewerb um Regalfläche“. Verpackung, Markenbekanntheit und Distributionsbudgets zählten. Ein besseres Produkt konnte gegen ein sichtbarer beworbenes verlieren.

Diese Sichtbarkeit erzeugte eine Rückkopplung: starke Verkäufe rechtfertigten mehr Regalpräsenz, was weitere Verkäufe brachte. Entwickler lernten, dass der Kanal nicht neutral ist — er belohnt Produkte, die Promotion und Support skalieren können.

Shareware: ein grassroots‑Vertriebsmotor

Shareware (oft auf Disketten über Nutzergruppen, Magazine und BBS verteilt) senkte die Eintrittsbarriere für neue Anbieter. Nutzer konnten Software testen, bevor sie zahlten, und kleine Entwickler erreichten Nischen ohne Retail‑Deals.

Der gemeinsame Nenner all dieser Kanäle war Reichweite und Vorhersagbarkeit. Wenn Entwickler abschätzen können, wie Kunden Software entdecken, ausprobieren und kaufen, können sie Personalplanung, Preisgestaltung, Updates und langfristige Produktentscheidungen planen.

Die Ökonomie, die Mainstream‑Entwickler und ISVs anzog

Plattformbindung vermeiden

Behalte die volle Kontrolle durch Export des Quellcodes, wenn du ihn brauchst.

Ein großer Grund, warum das PC‑Zeitalter Mainstream‑Entwickler anzog, war nicht nur technische Möglichkeit — es waren vorhersagbare Wirtschaftlichkeit. Das „PC‑Software‑Modell“ machte es einfacher, Umsätze zu prognostizieren, fortlaufende Verbesserungen zu finanzieren und Unternehmen um Software statt Dienstleistungen herum aufzubauen.

Preisgestaltung, Lizenzen und Upgrade‑Zyklen

Verpackte Softwarepreise (und später Seat‑Lizenzen) schufen klare Umsatzerwartungen: eine Kopie verkaufen, Marge verdienen, wiederholen. Periodische bezahlte Upgrades machten „Wartung“ zu einem Geschäftsmodell — Entwickler konnten neue Versionen alle 12–24 Monate planen, Marketing mit Releases synchronisieren und Investitionen in Support und Dokumentation rechtfertigen.

Für kleine Teams war das enorm: man brauchte keinen individuellen Vertrag für jeden Kunden. Ein Produkt konnte skaliert werden.

Sobald eine Plattform eine große installierte Basis hatte, änderte das, welche Anwendungen sich lohnten. Nischen‑Vertikalsoftware (z. B. Abrechnung für Zahnärzte, Lagerverwaltung für Autowerkstätten), kleine Utilities und Spiele wurden rentabel, weil ein kleiner Prozentsatz eines großen Marktes dennoch ein Geschäft sein konnte.

Entwickler optimierten auch für distributionsfreundliche Produkte: Dinge, die sich gut demonstrieren lassen, ins Regal passen und ein konkretes Problem schnell lösen.

Kompatibilität, Supportkosten und Realität kleiner Unternehmen

Kleine Firmenkunden schätzten Stabilität mehr als Neuheit. Kompatibilität mit bestehenden Dateien, Druckern und Workflows senkte Supportanfragen — oft die größte versteckte Kostenquelle für PC‑Softwareanbieter. Plattformen, die alte Apps am Laufen hielten, senkten Risiken für Kunden und Entwickler.

Was es heißt, ein ISV zu sein

Ein ISV ist ein Unternehmen, dessen Produkt von der Plattform eines anderen abhängt. Der einfache Austausch ist: Reichweite und Distributionshebel gegen Plattformregeln, Versionsänderungen und Supporterwartungen des Ökosystems.

Netzwerkeffekte und die Rückkopplungsschleife der Adoption

Netzwerkeffekte sind simpel: Hat eine Plattform mehr Nutzer, fällt es Entwicklern leichter, dafür zu bauen. Hat sie mehr Apps, wird sie für Nutzer wertvoller. Diese Schleife verwandelt „gut genug“‑Plattformen in Default‑Optionen.

Warum Defaults entstehen (trotz Alternativen)

Im PC‑Zeitalter hing die Wahl der Bauplattform nicht nur von technischer Eleganz ab. Es ging darum, den größtmöglichen adressierbaren Markt mit der geringsten Reibung zu erreichen. Sobald MS‑DOS und später Windows zum gemeinsamen Ziel wurden, konnten Entwickler ein Produkt ausliefern und erwarten, dass es bei einem großen Anteil der Nutzer läuft.

Nutzer folgten der Software, die sie wollten — Tabellenkalkeln, Textverarbeitungen, Spielen — und Unternehmen folgten dem Talentpool. Mit der Zeit fühlte sich die Plattform mit dem tiefsten App‑Katalog sicherer an: bessere Einstellungsmöglichkeiten, mehr Trainingsmaterialien, mehr Integrationen und weniger „funktioniert das?“‑Unsicherheit.

Standards, die den Zyklus verstärkten

Netzwerkeffekte betrafen nicht nur App‑Zahlen. Standards stärkten die Schleife:

- Dateiformate, die das Teilen ohne Konvertierung erlaubten.\

- Peripherie und Treiber, die über viele Maschinen hinweg „einfach funktionierten“.\

- Gemeinsame APIs, die die Kosten für Drucker-, Grafik‑ und Netzwerkunterstützung senkten.

Jeder Standard verringerte Wechselkosten für Nutzer — und Supportkosten für Entwickler — und machte die Default‑Wahl klebriger.

Wann das Modell scheitern kann

Das Flywheel bricht, wenn Entwickler nicht erfolgreich sein können:

- Schlechte Tools, unklare Docs oder instabile APIs.\

- Schwache Distribution (Kunden finden oder installieren Apps nicht einfach).\

- Fragmentierung, die mehrere Builds für ähnliche Geräte erzwingt.

Eine Plattform kann Nutzer haben, aber ohne einen verlässlichen Pfad für Entwickler zu bauen, zu liefern und bezahlt zu werden, stagniert das App‑Ökosystem — und die Schleife dreht sich um.